Le web, c’est une vraie mine d’or de données, et en 2025, toutes les boîtes savent que la rapidité et la qualité de la collecte d’infos, c’est souvent ce qui fait la différence. Que tu bosses dans la vente, l’e-commerce, l’opérationnel ou l’analyse de marché, pouvoir extraire des données de sites web — en masse et à la demande — c’est devenu un vrai avantage pour prendre l’avantage sur la concurrence. Python s’est imposé comme la référence pour ça : près de l’utilisent pour l’extraction web, grâce à ses bibliothèques ultra-complètes et sa prise en main facile.

Mais voilà la nouveauté : si Python reste l’outil passe-partout pour extraire des données, il n’est plus tout seul sur le marché. Des solutions no-code comme permettent aujourd’hui à n’importe qui — même sans jamais avoir touché une ligne de code — de collecter, nettoyer et organiser des données web en quelques clics. Dans ce guide, je vais te montrer les deux façons de faire : la méthode classique avec Python (Requests, Beautiful Soup, Selenium, Scrapy, Pandas) et la façon dont Thunderbit peut te faire gagner un temps fou. Tu trouveras des exemples concrets, des cas d’usage métier et quelques astuces de terrain. On y va !

C’est quoi « Python pull data from website » ?

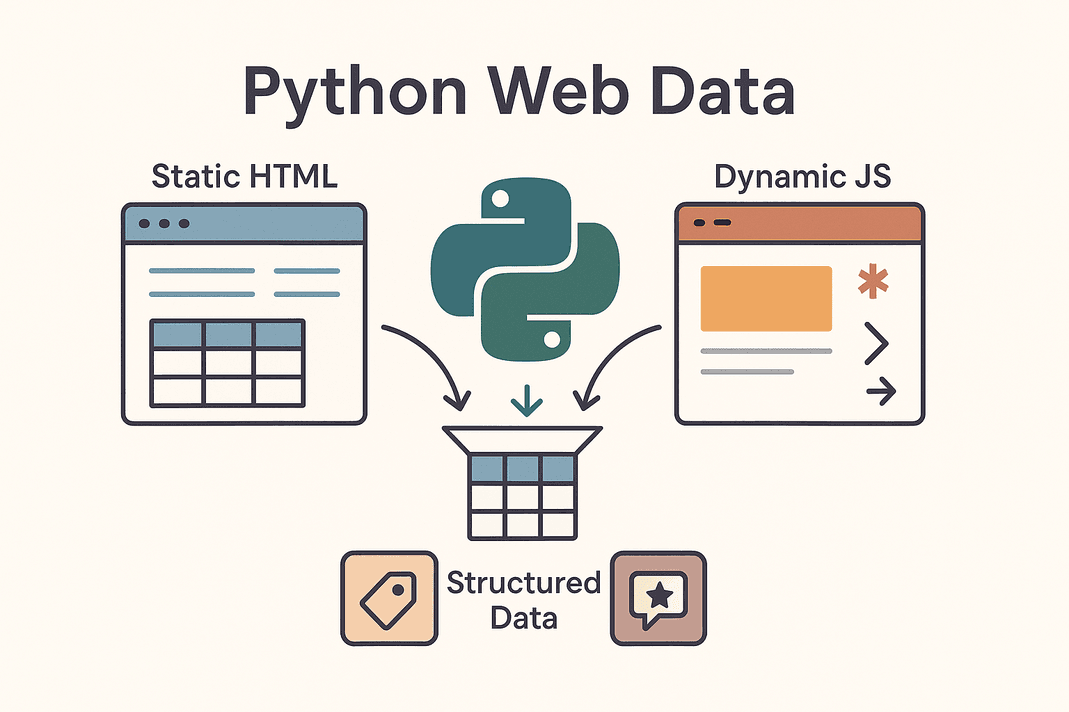

En gros, « python pull data from website », c’est utiliser des scripts Python pour aller chercher automatiquement des infos sur des pages web — et transformer un HTML en vrac en données propres et faciles à exploiter. On parle aussi d’extraction web ou de web scraping. Fini le copier-coller manuel de prix, de contacts ou d’avis : Python s’occupe de tout.

En gros, « python pull data from website », c’est utiliser des scripts Python pour aller chercher automatiquement des infos sur des pages web — et transformer un HTML en vrac en données propres et faciles à exploiter. On parle aussi d’extraction web ou de web scraping. Fini le copier-coller manuel de prix, de contacts ou d’avis : Python s’occupe de tout.

Tu vas surtout croiser deux types de sites :

- Sites statiques : Tout le contenu est déjà dans le HTML. Ce que tu vois dans « Afficher la source », c’est ce que tu peux extraire. L’extraction est simple : tu récupères et tu analyses le HTML.

- Sites dynamiques : Ces sites chargent des données via JavaScript après le chargement de la page. Ça inclut les scrolls infinis, les prix qui changent en direct ou les contenus qui s’affichent après une action. Pour ceux-là, il faut simuler un navigateur (avec Selenium, par exemple) ou trouver les API cachées qui alimentent le site ().

Les cibles classiques de l’extraction web, c’est les tableaux de produits, les listes de prospects, les prix, les avis, les images, etc. Que tu veuilles te faire une base de leads, surveiller les prix des concurrents ou analyser l’opinion du marché, Python peut transformer le web en vraie mine de données.

Pourquoi les entreprises misent sur Python pour extraire des données web

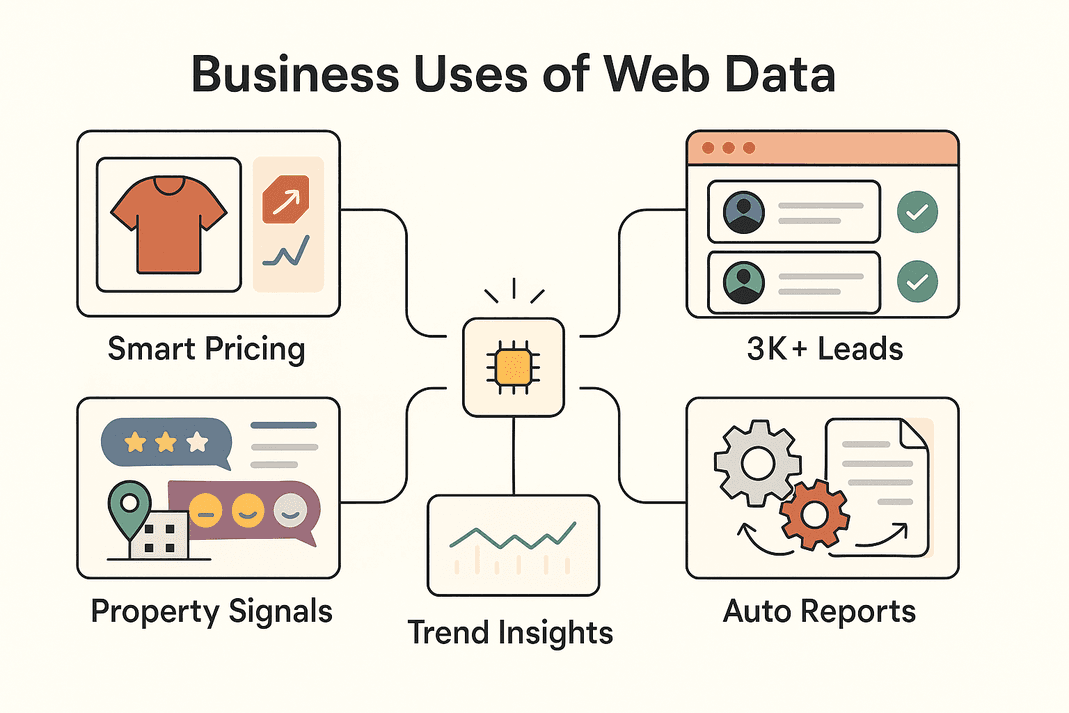

Concrètement, pourquoi l’extraction web est devenue un must pour les boîtes ? Voici quelques cas d’usage qui cartonnent et la valeur qu’ils apportent :

| Cas d’usage métier | Données extraites | ROI / Bénéfice |

|---|---|---|

| Génération de leads (Ventes) | Infos de contact depuis des annuaires, réseaux sociaux | 3 000+ leads/mois, ~8h/semaine économisées par commercial (Thunderbit)) |

| Veille tarifaire (E-commerce) | Prix produits, stocks | ~4% de ventes en plus, 30% de temps analyste économisé (blog.apify.com) |

| Études de marché | Avis, posts sociaux, forums | Ciblage amélioré ; 26% des scrapers ciblent les réseaux sociaux (Thunderbit) |

| Annonces immobilières | Données de biens, comparables, localisation | Découverte d’opportunités plus rapide, comparables à jour |

| Automatisation opérationnelle | Inventaires, rapports, données répétitives | 10–50% de temps gagné sur les tâches manuelles |

En résumé : extraire des données web avec Python (ou Thunderbit) permet aux équipes d’aller plus vite, de prendre de meilleures décisions et d’automatiser les tâches qui prennent la tête. Pas étonnant que le — et ça ne fait qu’accélérer.

Les outils Python à connaître pour l’extraction web

Si Python cartonne pour le web scraping, c’est grâce à son écosystème de dingue. Petit tour des outils les plus utilisés — et quand les sortir :

| Outil | Idéal pour | Avantages | Inconvénients |

|---|---|---|---|

| Requests | Récupérer du HTML statique ou des APIs | Simple, rapide, parfait pour débuter | Ne gère pas le JavaScript |

| Beautiful Soup | Analyser HTML/XML en données structurées | Facile à utiliser, flexible | Nécessite le HTML, pas adapté aux sites JS |

| Selenium | Sites dynamiques/JavaScript, logins, clics | Gère tout ce qu’un navigateur peut faire | Plus lent, configuration plus lourde |

| Scrapy | Crawls à grande échelle, multi-pages | Rapide, asynchrone, robuste, évolutif | Courbe d’apprentissage, pas de JS par défaut |

| Thunderbit | Sans code, utilisateurs métier | IA intégrée, gère le JS, export facile | Moins personnalisable pour des logiques complexes |

Dans la vraie vie, on mixe souvent plusieurs outils : Requests + Beautiful Soup pour les sites simples, Selenium pour les sites dynamiques, Scrapy pour les gros volumes, et Thunderbit pour aller vite et sans prise de tête.

Étape 1 : Utiliser Python Requests pour récupérer des données web

On commence par la base. Requests est l’outil incontournable pour télécharger des pages web en Python. Voilà comment faire :

-

Installer Requests :

1pip install requests -

Récupérer une page :

1import requests 2url = "https://example.com/products" 3response = requests.get(url) 4if response.status_code == 200: 5 html_content = response.text 6else: 7 print(f"Échec de la récupération : {response.status_code}")()

-

Astuces de dépannage :

- Ajouter des headers pour faire croire qu’on est un vrai navigateur :

1headers = {"User-Agent": "Mozilla/5.0"} 2response = requests.get(url, headers=headers) - Gérer les erreurs avec

response.raise_for_status() - Pour les APIs en JSON :

data = response.json()

- Ajouter des headers pour faire croire qu’on est un vrai navigateur :

Requests, c’est parfait pour les pages statiques ou les APIs. Si tu ne trouves pas les données dans la réponse, c’est sûrement du contenu chargé en JavaScript — il faudra alors passer à Selenium.

Étape 2 : Analyser le contenu web avec Beautiful Soup

Une fois le HTML récupéré, Beautiful Soup permet d’aller piocher les infos qui t’intéressent. Voici comment t’y prendre :

-

Installer Beautiful Soup :

1pip install beautifulsoup4 -

Analyser le HTML :

1from bs4 import BeautifulSoup 2soup = BeautifulSoup(html_content, 'html.parser') -

Extraire les données :

- Pour toutes les fiches produits :

1for product in soup.select('div.product-card'): 2 name = product.select_one('.product-name').text.strip() 3 price = product.select_one('.product-price').text.strip() 4 print(name, price) - Pour les tableaux :

1for row in soup.find_all('tr'): 2 cells = row.find_all('td') 3 # Extraire les données des cellules

- Pour toutes les fiches produits :

Astuces :

- Utilise les outils de dev de ton navigateur pour trouver les bons sélecteurs.

.get_text()ou.textpour choper le texte.- Gère les données manquantes avec des vérifs (

if price_elem else "N/A").

Requests + Beautiful Soup, c’est le combo gagnant pour la plupart des sites statiques.

Étape 3 : Gérer le contenu dynamique avec Selenium

Pour les sites qui chargent des données via JavaScript, il faut un outil qui simule un vrai utilisateur. C’est là que Selenium entre en jeu.

-

Installer Selenium :

1pip install seleniumTélécharge le driver adapté à ton navigateur (ex : ChromeDriver) et ajoute-le à ton PATH.

-

Automatiser le navigateur :

1from selenium import webdriver 2driver = webdriver.Chrome() 3driver.get("https://example.com/products") 4products = driver.find_elements_by_class_name("product-card") 5for prod in products: 6 print(prod.text) 7driver.quit() -

Gérer les logins et clics :

1driver.get("https://site.com/login") 2driver.find_element_by_name("username").send_keys("myuser") 3driver.find_element_by_name("password").send_keys("mypassword") 4driver.find_element_by_id("login-button").click() -

Attendre le chargement du contenu dynamique :

1from selenium.webdriver.common.by import By 2from selenium.webdriver.support.ui import WebDriverWait 3from selenium.webdriver.support import expected_conditions as EC 4WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CLASS_NAME, "data-row"))) -

Mode headless (sans fenêtre) :

1options = webdriver.ChromeOptions() 2options.add_argument("--headless") 3driver = webdriver.Chrome(options=options)

Selenium est super puissant, mais un peu lourd — à garder pour les sites qui demandent une vraie navigation automatisée.

Étape 4 : Passer à l’échelle avec Scrapy pour de gros volumes

Si tu dois parcourir des centaines ou des milliers de pages, Scrapy est l’outil qu’il te faut.

-

Installer Scrapy :

1pip install scrapy 2scrapy startproject myproject -

Créer un spider :

1import scrapy 2class ProductsSpider(scrapy.Spider): 3 name = "products" 4 start_urls = ["https://example.com/category?page=1"] 5 def parse(self, response): 6 for product in response.css("div.product-card"): 7 yield { 8 'name': product.css(".product-title::text").get().strip(), 9 'price': product.css(".price::text").get().strip(), 10 } 11 next_page = response.css("a.next-page::attr(href)").get() 12 if next_page: 13 yield response.follow(next_page, self.parse) -

Lancer le spider :

1scrapy crawl products -o products.csv

Scrapy, c’est asynchrone, rapide et taillé pour l’échelle. Parfait pour crawler des sites entiers ou gérer la pagination compliquée.

Étape 5 : Booster l’extraction de données avec Thunderbit

On passe à — l’extracteur web IA sans code qui change la donne pour les équipes métier.

- Suggestions IA de champs : Thunderbit analyse la page et te propose direct les colonnes à extraire — plus besoin de fouiller dans le HTML.

- Gère les pages dynamiques : Il voit la page comme toi, donc JavaScript, scroll infini et logins, c’est géré sans souci.

- Extraction sur sous-pages : Thunderbit peut cliquer sur chaque fiche pour enrichir automatiquement ton jeu de données.

- Modèles prêts à l’emploi : Pour les sites connus comme Amazon, Zillow ou Shopify, tu as des modèles instantanés — zéro config.

- Extracteurs en un clic : Tu veux tous les emails ou numéros de téléphone d’une page ? Thunderbit le fait en un éclair.

- Planification et extraction cloud : Programme des extractions récurrentes en langage naturel (« tous les lundis à 9h ») et laisse le cloud Thunderbit gérer jusqu’à 50 pages d’un coup.

- Export partout : Envoie tes données en un clic vers Excel, Google Sheets, Airtable, Notion, ou télécharge-les en CSV/JSON — gratos et sans limite.

Thunderbit, c’est parfait pour les équipes qui veulent des données vite, sans aucune compétence technique. Tu peux même utiliser Thunderbit pour collecter les données, puis les analyser avec Python — le meilleur des deux mondes.

Étape 6 : Nettoyer et analyser les données extraites avec Pandas

Une fois tes données collectées (avec Python ou Thunderbit), place au nettoyage et à l’analyse avec Pandas.

-

Charger tes données :

1import pandas as pd 2df = pd.read_csv("products.csv") 3print(df.head()) -

Nettoyer tes données :

- Supprimer les doublons :

1df = df.drop_duplicates() - Gérer les valeurs manquantes :

1df = df.fillna("N/A") - Standardiser les formats (ex : prix) :

1df['price'] = df['price'].str.replace('$','').str.replace(',','').astype(float)

- Supprimer les doublons :

-

Analyser :

- Obtenir des stats :

1print(df.describe()) - Grouper par catégorie :

1avg_price = df.groupby('category')['price'].mean() 2print(avg_price)

- Obtenir des stats :

Pandas, c’est l’outil de base pour transformer des données brutes en analyses qui parlent.

Étape 7 : Organiser et stocker les données extraites pour l’équipe

Tes données sont prêtes — il faut maintenant les rendre accessibles à tout le monde.

- CSV/Excel : Utilise

df.to_csv("out.csv", index=False)oudf.to_excel("out.xlsx")pour partager facilement. - Google Sheets : Utilise l’export Thunderbit ou la bibliothèque Python

gspread. - Bases de données : Pour les gros volumes, stocke avec

df.to_sql()dans une base SQL. - Automatisation : Programme des scripts ou des extractions Thunderbit pour garder tes données à jour.

- Bonnes pratiques : Ajoute toujours un horodatage, documente tes colonnes et contrôle l’accès si les données sont sensibles.

L’idée, c’est d’adapter le stockage à tes besoins : tableurs pour la rapidité, bases de données pour la montée en charge.

Thunderbit vs. Python : quelle méthode choisir pour ton équipe ?

Comparons les deux approches :

| Critère | Thunderbit (IA sans code) | Librairies Python (code) |

|---|---|---|

| Compétences requises | Aucune (interface web) | Programmation Python nécessaire |

| Temps de mise en place | Quelques minutes (suggestions IA, extraction instantanée) | Heures à jours (code, débogage, configuration) |

| Gère JS/Interactif | Oui, intégré (navigateur/cloud) | Oui, mais nécessite Selenium/Playwright |

| Maintenance | Faible — l’IA s’adapte aux changements de site | Manuelle — mise à jour du code si le site change |

| Passage à l’échelle | Modéré (rapide pour dizaines/centaines de pages via le cloud) | Élevé (Scrapy peut gérer des milliers de pages) |

| Personnalisation | Via l’interface et les prompts IA | Illimitée (toute logique, toute intégration) |

| Anti-bot/Proxies | Géré en interne | À implémenter manuellement |

| Export de données | 1 clic vers Sheets, Excel, Notion, Airtable | Code personnalisé nécessaire |

| Idéal pour | Utilisateurs non techniques, résultats rapides, maintenance minimale | Développeurs, projets complexes ou volumineux |

Le bon plan : Utilise Thunderbit pour des résultats rapides et donne de l’autonomie à tes équipes métier. Prends Python pour des besoins très spécifiques ou des projets XXL. Beaucoup d’équipes font les deux : Thunderbit pour valider et collecter vite, Python pour automatiser ou passer à l’échelle ensuite.

Exemples concrets d’utilisation de l’extraction web

Voici comment les entreprises s’en servent au quotidien :

Voici comment les entreprises s’en servent au quotidien :

- E-commerce : John Lewis a en surveillant les prix des concurrents et en ajustant les siens en temps réel.

- Ventes : Les équipes collectent plus de 3 000 leads/mois, économisant 8h/semaine par commercial ()) — fini la prospection à la main.

- Études de marché : Les marketeurs extraient des milliers d’avis ou de posts sociaux pour analyser le ressenti client et flairer les tendances avant tout le monde.

- Immobilier : Les agents collectent les annonces pour repérer les biens sous-évalués ou les nouvelles opportunités — plus vite que les mises à jour MLS.

- Automatisation des workflows : Les équipes opérations automatisent les contrôles d’inventaire, la génération de rapports ou même les FAQ en collectant des données sur des sites partenaires ou internes.

Souvent, le workflow est hybride : Thunderbit pour la collecte, Python pour le nettoyage et l’analyse, puis export vers Sheets ou une base de données pour l’équipe.

Conclusion & points clés à retenir

Extraire des données web avec Python (et Thunderbit), c’est devenu indispensable pour les équipes modernes. À retenir :

- Requests + Beautiful Soup : Parfait pour les sites statiques, rapide et simple.

- Selenium : Pour les sites dynamiques, bourrés de JavaScript ou qui demandent une connexion.

- Scrapy : Pour les crawls à grande échelle, multi-pages.

- Thunderbit : Pour une extraction sans code, boostée par l’IA — rapide, simple, parfait pour les métiers.

- Pandas : Pour nettoyer, analyser et valoriser tes données.

- Export adapté : CSV, Sheets ou bases de données — choisis selon tes besoins.

Le meilleur conseil ? Prends l’outil qui colle à ton niveau technique et à tes objectifs. Combine-les au fil de ta croissance. Et pour voir à quel point l’extraction web peut être simple, ou va faire un tour sur le pour plus de tutos.

Bonne extraction — que tes données soient toujours propres, structurées et prêtes à l’emploi !

FAQ

1. Quelle est la méthode la plus simple pour extraire des données d’un site avec Python ?

Pour les sites statiques, utilise Requests pour récupérer le HTML, puis Beautiful Soup pour extraire les données. Pour les sites dynamiques, Selenium sera souvent indispensable.

2. Quand choisir Thunderbit plutôt que le code Python ?

Thunderbit est top si tu veux des données vite, sans coder, ou si tu dois gérer des pages dynamiques, des sous-pages ou des exports instantanés vers Sheets/Excel. Parfait pour les utilisateurs métier ou les projets urgents.

3. Comment gérer les sites qui chargent les données en JavaScript ?

Utilise Selenium (ou Playwright) pour automatiser un navigateur, ou teste le mode navigateur/cloud de Thunderbit, qui gère le JS tout seul.

4. Quelle est la meilleure façon de nettoyer et d’analyser les données extraites ?

Importe tes données dans Pandas, vire les doublons, gère les valeurs manquantes, standardise les formats et utilise groupby ou describe pour des analyses rapides.

5. L’extraction web est-elle légale et sûre pour un usage pro ?

En général, extraire des données publiques est légal, mais vérifie toujours les conditions d’utilisation du site et le fichier robots.txt. N’extrais pas de données perso sans consentement et respecte les ressources des sites. Thunderbit et Python permettent tous deux une extraction éthique.

Prêt à passer à la vitesse supérieure ? ou lance-toi avec Python — dans tous les cas, tu vas collecter des données web précieuses en un rien de temps.

Pour aller plus loin