« On peut avoir des données sans information, mais on ne peut pas avoir d’information sans données. » —

Aujourd’hui, on compte plus de de sites web dans le monde, et près de 2 millions de nouveaux contenus sont publiés chaque jour. Cette quantité phénoménale de données regorge d’opportunités pour guider vos choix, mais il y a un hic : environ de ces données sont non structurées, ce qui veut dire qu’il faut les retravailler avant de pouvoir les exploiter. C’est là que les outils d’extraction web prennent tout leur sens pour celles et ceux qui veulent tirer parti de la richesse du web.

Si vous débutez dans la collecte de données, des mots comme ou peuvent sembler un peu barbares. Mais à l’ère de l’intelligence artificielle, ces barrières sont bien plus faciles à franchir. Les extracteurs web IA d’aujourd’hui vous permettent de collecter et de traiter des données en un rien de temps, sans avoir besoin de compétences techniques pointues. Plus besoin de coder : ces outils rendent l’extraction accessible à tous.

Les meilleurs outils et logiciels d’extraction web

- pour un extracteur web IA ultra simple et des résultats au top

- pour surveiller en temps réel et extraire des données en masse

- pour automatiser sans coder et connecter plein d’applications

- pour une extraction visuelle avancée, idéale pour les utilisateurs aguerris

- pour une extraction puissante sans code, capable de contourner les blocages IP et la détection des robots

- pour une API d’extraction de données avancée, boostée par l’IA et des graphes de connaissances

Testez l’IA pour l’extraction web

Faites l’essai vous-même ! Cliquez, explorez et lancez le workflow en direct.

Comment fonctionne l’extraction web ?

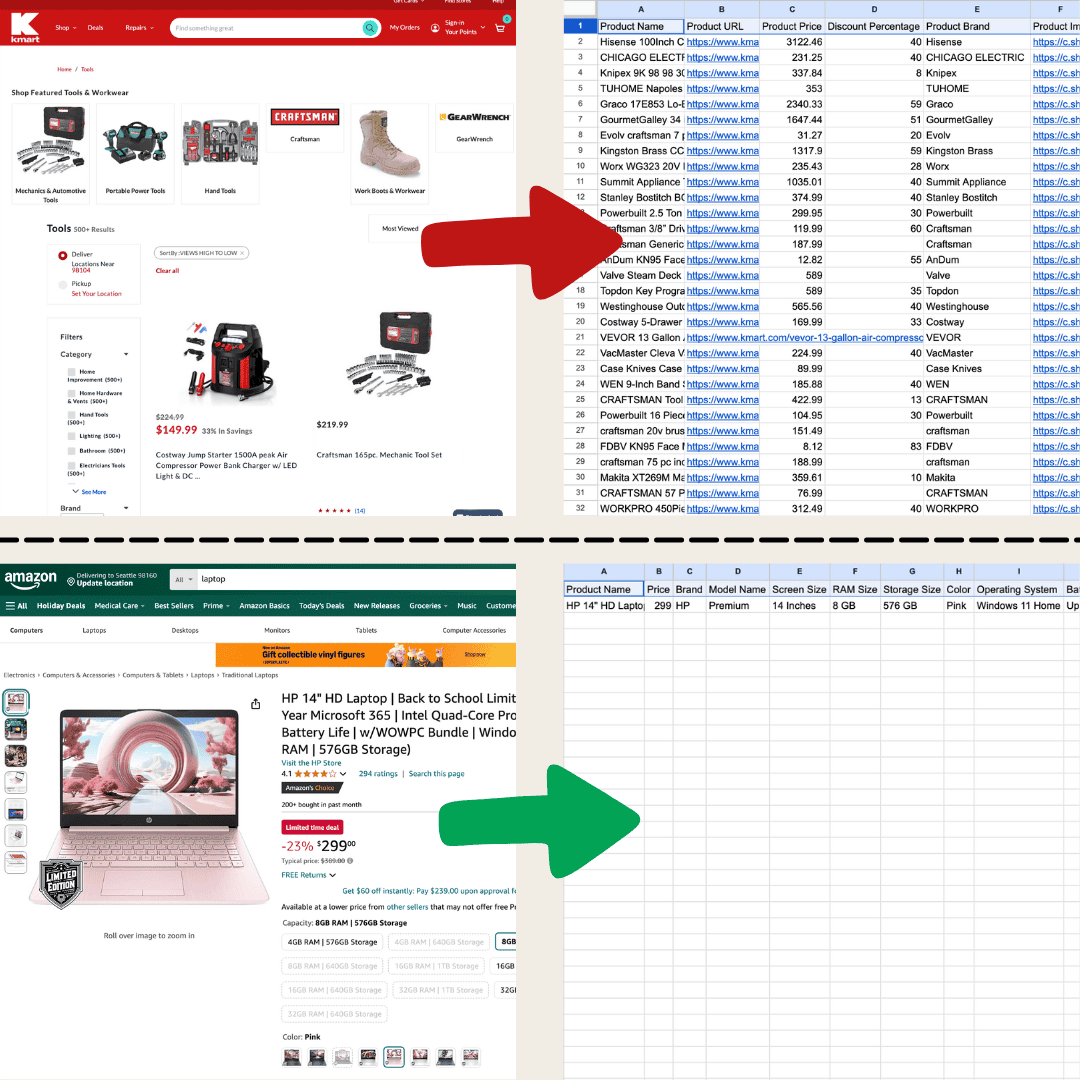

L’extraction web, c’est le fait de récupérer automatiquement des données sur des sites internet. Vous indiquez à un outil ce que vous voulez extraire, et il va chercher pour vous textes, images ou autres infos, puis les range dans un tableau. C’est super pratique pour surveiller les prix sur des sites e-commerce, collecter des données pour vos recherches, ou encore alimenter un fichier Excel ou Google Sheets.

Réalisé avec Thunderbit et l’Extracteur Web IA.

Réalisé avec Thunderbit et l’Extracteur Web IA.

Il existe plusieurs façons de faire. La plus simple, c’est de copier-coller à la main, mais dès qu’il y a beaucoup de données, ça devient vite pénible. La plupart des gens préfèrent donc l’une de ces trois solutions : extracteurs web classiques, extracteurs web IA, ou développement sur-mesure.

Les extracteurs web classiques fonctionnent en définissant des règles précises sur les éléments à extraire, en se basant sur la structure de la page. Par exemple, vous pouvez cibler les noms de produits ou les prix dans certaines balises HTML. Ils sont efficaces sur des sites stables, mais au moindre changement de mise en page, il faut tout reconfigurer.

Maîtriser un extracteur classique demande du temps, et la configuration peut vite devenir fastidieuse.

Maîtriser un extracteur classique demande du temps, et la configuration peut vite devenir fastidieuse.

Les extracteurs web IA fonctionnent autrement : c’est comme si ChatGPT lisait la page entière et en sortait les infos dont vous avez besoin. Ils peuvent extraire, traduire et résumer les données en une seule fois. Grâce au traitement du langage naturel, ils comprennent la structure du site et s’adaptent facilement aux changements. Si la page évolue, l’extracteur IA s’ajuste tout seul, sans que vous ayez à tout reparamétrer. C’est donc parfait pour les sites complexes ou qui changent souvent.

L’Extracteur Web IA est hyper simple à utiliser et fournit des données détaillées en quelques clics !

L’Extracteur Web IA est hyper simple à utiliser et fournit des données détaillées en quelques clics !

Quel outil choisir ? Tout dépend de vos besoins. Si vous êtes à l’aise avec le code ou que vous devez extraire de gros volumes sur des sites connus, les extracteurs classiques sont très efficaces. Mais pour les débutants ou ceux qui veulent un outil qui s’adapte aux changements, l’Extracteur Web IA est souvent le meilleur choix. Jetez un œil au tableau ci-dessous pour des cas d’usage concrets !

| Scénario | Meilleur choix |

|---|---|

| Extraction légère sur des pages de type annuaires, sites e-commerce ou tout site avec des listes | Extracteur Web IA |

| La page contient moins de 200 lignes de données, et la configuration d’un extracteur traditionnel prend trop de temps | Extracteur Web IA |

| Les données à extraire doivent être formatées pour être importées ailleurs (ex : contacts à importer dans HubSpot) | Extracteur Web IA |

| Extraction massive sur des sites très utilisés, comme des milliers de pages Amazon ou d’annonces immobilières Zillow | Extracteur Web traditionnel |

Panorama des meilleurs outils d’extraction web

| Outil | Tarifs | Fonctionnalités clés | Avantages | Inconvénients |

|---|---|---|---|---|

| Thunderbit | À partir de 9 $/mois, version gratuite dispo | Extracteur Web IA, détection et formatage automatiques, multi-formats, export en un clic, interface intuitive. | Sans code, IA intégrée, intégrations avec Google Sheets, etc. | Extraction massive parfois lente, options avancées payantes |

| Browse AI | À partir de 48,75 $/mois, version gratuite dispo | Interface sans code, surveillance en temps réel, extraction en masse, intégration de workflows. | Facile à utiliser, intégration Google Sheets & Zapier | Configuration supplémentaire pour pages complexes, risques de timeouts en extraction massive |

| Bardeen AI | À partir de 60 $/mois, version gratuite dispo | Automatisation sans code, intégration avec 130+ apps, MagicBox pour transformer les tâches en workflows. | Intégrations étendues, évolutif pour les entreprises | Courbe d’apprentissage pour les débutants, configuration initiale longue |

| Web Scraper | Gratuit en local, 50 $/mois pour le cloud | Création visuelle, support des sites dynamiques (AJAX/JavaScript), extraction cloud. | Efficace sur sites dynamiques | Nécessite des connaissances techniques pour une configuration optimale |

| Octoparse | À partir de 119 $/mois, version gratuite dispo | Extraction sans code, détection automatique, extraction cloud planifiée, bibliothèque de modèles. | Puissant pour sites dynamiques, gère les restrictions | Sites complexes nécessitent un apprentissage |

| Diffbot | À partir de 299 $/mois | API d’extraction, API sans règle, NLP pour texte non structuré, vaste graphe de connaissances. | Extraction IA avancée, API complète, extraction à grande échelle | Courbe d’apprentissage pour non-techniciens, temps de configuration |

Le meilleur extracteur web à l’ère de l’IA

Thunderbit est un outil d’automatisation web IA à la fois puissant et super intuitif, qui permet à tout le monde d’extraire et d’organiser des données sans coder. Avec son , l’ de Thunderbit simplifie l’extraction : quelques clics suffisent pour récupérer des données, sans avoir à manipuler la page ou à configurer un extracteur pour chaque site.

Fonctionnalités principales

- Flexibilité IA : L’Extracteur Web IA de Thunderbit détecte et formate automatiquement les données, sans sélecteurs CSS.

- Expérience ultra simple : Cliquez sur « IA suggère une colonne », puis sur « Extraire » sur la page voulue. C’est tout.

- Multi-formats : Thunderbit extrait des URLs, images, et affiche les données dans différents formats.

- Traitement automatisé : L’IA de Thunderbit reformate, résume, classe ou traduit les données à la volée.

- Export facile : Exportez en un clic vers Google Sheets, Airtable ou Notion pour une gestion simplifiée.

- Interface intuitive : Accessible à tous, peu importe le niveau technique.

Tarifs

Thunderbit propose plusieurs formules, à partir de 9 $/mois pour 5 000 crédits, jusqu’à 199 $/mois pour 240 000 crédits. En choisissant l’abonnement annuel, vous recevez tous les crédits d’avance.

Avantages :

- L’IA simplifie l’extraction et le traitement des données.

- Accessible à tous, sans code.

- Idéal pour l’extraction légère (annuaires, e-commerce, etc.).

- Intégration directe avec les applis populaires.

Inconvénients :

- L’extraction de gros volumes peut prendre un peu plus de temps pour garantir la qualité.

- Certaines fonctions avancées sont réservées aux abonnés payants.

Envie d’en savoir plus ? Commencez par , ou découvrez avec Thunderbit.

Meilleur extracteur web pour la surveillance et l’extraction en masse

Browse AI

Browse AI est un outil d’extraction de données sans code, pensé pour permettre à tout le monde de surveiller et d’extraire des données sans programmation. Il intègre quelques fonctions IA, mais n’atteint pas le niveau d’automatisation d’un extracteur IA complet. Cela dit, il est très facile à prendre en main.

Fonctionnalités principales

- Interface sans code : Créez des workflows personnalisés en quelques clics.

- Surveillance en temps réel : Des bots surveillent les changements de pages et vous alertent des nouveautés.

- Extraction en masse : Peut traiter jusqu’à 50 000 entrées en une seule opération.

- Intégration de workflows : Reliez plusieurs bots pour des traitements plus complexes.

Tarifs

À partir de 48,75 $/mois avec 2 000 crédits. Une version gratuite offre 50 crédits par mois pour tester les fonctions de base.

Avantages :

- Intégration avec Google Sheets et Zapier.

- Bots préconfigurés pour les tâches courantes.

Inconvénients :

- Configuration supplémentaire parfois nécessaire pour les pages complexes.

- La vitesse d’extraction en masse peut varier, avec parfois des interruptions.

Meilleur extracteur web pour l’intégration de workflows

Bardeen AI

Bardeen AI est un outil d’automatisation sans code qui connecte différentes applications pour fluidifier vos process. Il utilise l’IA pour créer des automatisations sur mesure, mais n’offre pas la flexibilité d’un extracteur IA dédié.

Fonctionnalités principales

- Automatisation sans code : Configurez vos workflows en quelques clics.

- MagicBox : Décrivez vos tâches en langage naturel, Bardeen AI les transforme en automatisations.

- Large choix d’intégrations : Plus de 130 applications compatibles, dont Google Sheets, Slack et LinkedIn.

Tarifs

À partir de 60 $/mois pour 1 500 crédits (environ 1 500 lignes de données). Une version gratuite propose 100 crédits par mois pour tester les fonctions de base.

Avantages :

- Intégrations variées pour répondre à tous les besoins pros.

- Flexible et évolutif pour les entreprises de toute taille.

Inconvénients :

- Les nouveaux utilisateurs devront prendre le temps de se former.

- La configuration initiale peut être longue.

Meilleur extracteur web visuel pour utilisateurs expérimentés

Web Scraper

Oui, l’outil s’appelle bien « Web Scraper ». C’est une extension très populaire pour Chrome et Firefox, qui permet d’extraire des données sans coder, via une interface visuelle. Par contre, il faudra sûrement suivre quelques tutos pour en maîtriser toutes les subtilités. Si vous cherchez la simplicité, privilégiez l’Extracteur Web IA.

Fonctionnalités principales

- Création visuelle : Configurez vos tâches d’extraction en cliquant sur les éléments de la page.

- Support des sites dynamiques : Gère les requêtes AJAX et JavaScript.

- Extraction cloud : Planifiez des extractions régulières via Web Scraper Cloud.

Tarifs

Gratuit en local ; à partir de 50 $/mois pour les fonctions cloud.

Avantages :

- Efficace sur les sites dynamiques.

- Gratuit pour une utilisation locale.

Inconvénients :

- Nécessite des connaissances techniques pour une configuration optimale.

- Tests complexes à prévoir en cas de modifications du site.

Meilleur extracteur web pour éviter les blocages IP et la détection des robots

Octoparse

Octoparse est un logiciel polyvalent destiné aux utilisateurs techniques qui veulent collecter et surveiller des données web à grande échelle, sans coder. Il fonctionne sur des serveurs cloud, ce qui lui permet de contourner les blocages IP et la détection des robots sur de nombreux sites.

Fonctionnalités principales

- Sans code : Créez des tâches d’extraction sans programmation, accessible à tous les niveaux.

- Détection intelligente : Identifie automatiquement les éléments à extraire, simplifiant la configuration.

- Extraction cloud : Extraction 24/7 avec planification flexible.

- Bibliothèque de modèles : Des centaines de modèles prêts à l’emploi pour extraire rapidement des données de sites populaires.

Tarifs

À partir de 119 $/mois pour 100 tâches. Une version gratuite permet de tester jusqu’à 10 tâches par mois.

Avantages :

- Fonctionnalités puissantes pour l’extraction sur sites dynamiques.

- Solutions pour contourner les restrictions et gérer les contenus dynamiques.

Inconvénients :

- Les sites complexes nécessitent plus de temps de configuration.

- Les nouveaux utilisateurs devront se former à l’outil.

Meilleur extracteur web pour API d’extraction avancée propulsée par l’IA

Diffbot

Diffbot est un outil avancé d’extraction de données web, qui utilise l’IA pour transformer des contenus non structurés en données exploitables. Grâce à ses API puissantes et à son graphe de connaissances, Diffbot permet d’extraire, d’analyser et d’organiser l’information, quel que soit le secteur.

Fonctionnalités principales

- API d’extraction de données : Extraction automatique à partir d’une simple URL, sans avoir à définir de règles spécifiques pour chaque site.

- API de traitement du langage naturel : Extraction d’entités, de relations et d’opinions à partir de textes non structurés, pour créer vos propres graphes de connaissances.

- Graphe de connaissances : L’un des plus vastes graphes de connaissances, reliant des données sur des personnes, entreprises, etc.

Tarifs

À partir de 299 $/mois pour 250 000 crédits (environ 250 000 extractions via API).

Avantages :

- Extraction sans règle, très adaptable.

- Intégration API complète pour connecter à vos systèmes existants.

- Prise en charge de l’extraction à grande échelle, adaptée aux entreprises.

Inconvénients :

- Prise en main nécessitant un temps d’apprentissage pour les non-techniciens.

- Il faut développer un programme pour utiliser l’API.

À quoi servent les extracteurs web ?

Si vous débutez, voici quelques exemples d’utilisation courants : beaucoup s’en servent pour récupérer des fiches produits Amazon, des données immobilières sur Zillow, ou des infos d’entreprises sur Google Maps. Mais ce n’est qu’un début : avec l’ de Thunderbit, vous pouvez collecter des données sur quasiment n’importe quel site, automatiser vos tâches et gagner un temps fou au quotidien. Que ce soit pour la veille, la comparaison de prix ou la création de bases de données, l’extraction web ouvre plein de possibilités pour exploiter la richesse du web.

FAQ

-

L’extraction web est-elle légale ?

L’extraction web est en général légale, à condition de respecter les conditions d’utilisation des sites et la nature des données collectées. Pensez toujours à vérifier les règles en vigueur et à rester dans les clous.

-

Faut-il savoir programmer pour utiliser ces outils ?

La plupart des outils présentés ici ne demandent pas de savoir coder, mais des solutions comme Octoparse ou Web Scraper sont plus efficaces si vous avez quelques bases sur la structure web ou la logique de programmation.

-

Existe-t-il des outils gratuits ?

Oui, il existe des outils gratuits comme BeautifulSoup, Scrapy ou Web Scraper, et certains proposent des versions gratuites limitées.

-

Quels sont les principaux défis de l’extraction web ?

Les difficultés les plus courantes sont la gestion des contenus dynamiques, des CAPTCHAs, des blocages IP et des structures HTML complexes. Des outils avancés et des techniques spécifiques permettent de contourner ces obstacles.

Pour aller plus loin :

-

Exploitez l’IA pour travailler sans effort.