Je vais être honnête : la première fois que j’ai mis au point un extracteur web, j’ai eu l’impression d’avoir mis la main sur un super-pouvoir caché. Fini les longues heures à copier-coller des infos de sites pour dénicher des prospects ou comparer des prix. Mais soyons clairs : créer son propre extracteur web en Python, c’est un passage obligé pour tous ceux qui veulent automatiser les tâches répétitives sur le web. Et pour les pros, ça peut faire la différence entre passer son vendredi soir à galérer sur des tableurs ou profiter enfin de son temps libre.

Dans ce guide, je t’explique étape par étape comment créer un extracteur web en Python, avec des exemples de code concrets. Ensuite, je te montre pourquoi, pour la plupart des équipes métier, il existe une solution bien plus simple : utiliser un qui fait tout en deux clics, sans écrire une seule ligne de code. Que tu sois fan de Python ou que tu veuilles juste récupérer tes données sans prise de tête, tu trouveras la méthode qui te correspond.

L’extraction web avec Python, c’est quoi ?

On commence par la base. L’extraction web, c’est tout simplement le fait de récupérer automatiquement des infos sur des sites internet. Imagine un assistant robot qui fait tout le copier-coller à ta place — sans jamais râler ni demander d’augmentation.

Un extracteur web, c’est un script ou un programme qui :

- Va sur une page web (comme ton navigateur)

- Récupère des infos précises (noms de produits, prix, contacts, etc.)

- Les enregistre dans un format structuré (tableur, fichier JSON, etc.)

Python, c’est la référence pour ça : facile à lire, blindé de bibliothèques puissantes, c’est le couteau suisse des devs. D’ailleurs, .

Le schéma classique, c’est :

- Récupérer la page web (choper le HTML)

- Analyser le HTML pour trouver les infos qui t’intéressent

- Sauvegarder les résultats dans un format exploitable

C’est comme faire un gâteau : tu rassembles les ingrédients (HTML), tu sélectionnes ce qui t’intéresse (les données), puis tu sers le tout (export).

Pourquoi l’extraction web est devenue indispensable pour les entreprises

L’extraction web, ce n’est plus réservé aux devs ou aux data scientists. C’est devenu un atout incontournable pour la prospection commerciale, le marketing, l’e-commerce, l’immobilier, ou toute activité qui a besoin de données web fraîches et fiables pour prendre des décisions. , et il explose à +28% par an. Autant dire que les opportunités sont énormes.

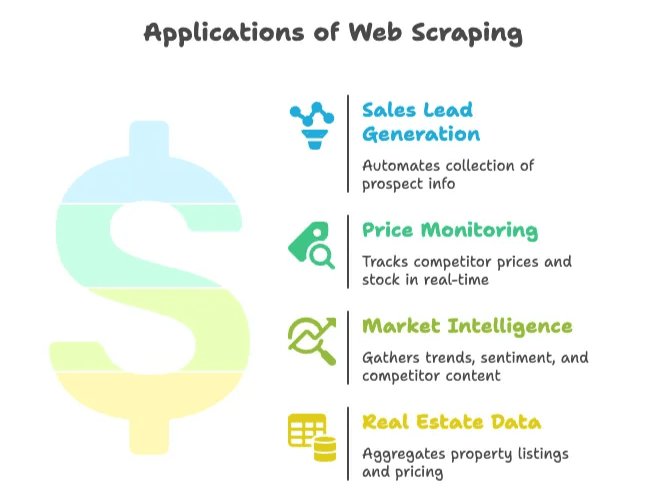

Quelques exemples concrets d’utilisation en entreprise :

| Cas d'usage | Bénéfice | Résultat concret |

|---|---|---|

| Génération de leads | Automatiser la collecte de prospects depuis des annuaires ou réseaux sociaux | Jusqu’à 8h gagnées/semaine par commercial ; 3 000 leads/mois extraits, croissance x10 en 3 mois |

| Veille tarifaire | Suivi en temps réel des prix et stocks concurrents | 30% de temps économisé sur la collecte ; +4% de ventes grâce à une tarification optimisée |

| Intelligence marché | Collecte de tendances, d’avis et de contenus concurrents | Plus de 70% des entreprises s’appuient sur des données extraites du web pour leur veille |

| Données immobilières | Agrégation d’annonces et de prix sur plusieurs sites | Les agences scrutent Zillow/Trulia pour anticiper les évolutions locales |

En résumé : l’extraction web te fait gagner un temps fou, réduit les tâches manuelles et te donne un vrai avantage sur la concurrence. Si tu copies-colles encore à la main, tes concurrents sont sûrement déjà passés à la vitesse supérieure.

Préparer son environnement : outils et compétences à avoir

Avant de te lancer dans le code, voyons ce qu’il te faut dans ta boîte à outils.

Les indispensables

- Python installé : Télécharge la dernière version () et vérifie que la commande

pythonmarche dans ton terminal. - Éditeur de code : VS Code, PyCharm ou même Notepad++ font le job. Perso, j’aime bien VS Code pour le Python.

- Environnement virtuel : Pas obligatoire, mais super utile pour isoler les dépendances de ton projet. Crée-le avec

python -m venv venv.

Les bibliothèques Python à connaître

- Requests : Pour récupérer les pages web ().

- BeautifulSoup : Pour analyser le HTML et cibler les bons éléments ().

- Selenium : Pour extraire des sites qui chargent leur contenu en JavaScript ().

Installe-les avec :

1pip install requests beautifulsoup4 lxml seleniumComprendre le HTML

Pas besoin d’être un pro du web, mais il faut savoir inspecter le code source d’une page. Clic droit, « Inspecter », et tu verras l’arborescence du DOM. C’est là que tu trouveras les balises et classes à viser pour ton extracteur ().

Tutoriel pas à pas : créer un extracteur web en Python

On passe à la pratique et on construit un extracteur simple. Exemple concret : extraire des titres d’articles ou des fiches produits. Tu pourras facilement adapter ce modèle à tes besoins.

Préparer l’environnement Python

Commence par créer un dossier de projet et un environnement virtuel :

1mkdir my-scraper

2cd my-scraper

3python -m venv venv

4# Activation de l’environnement :

5# Sous Windows :

6venv\Scripts\activate

7# Sous macOS/Linux :

8source venv/bin/activateInstalle les bibliothèques :

1pip install requests beautifulsoup4 lxmlCrée un fichier scraper.py et ouvre-le dans ton éditeur.

Récupérer et analyser une page web

On va récupérer le HTML d’un site cible. Pour l’exemple, on prend (un classique pour les démos d’extraction).

1import requests

2from bs4 import BeautifulSoup

3url = "https://news.ycombinator.com/"

4response = requests.get(url)

5if response.status_code == 200:

6 html_content = response.content

7else:

8 print(f"Request failed with status {response.status_code}")

9 exit()Analyse ensuite le HTML avec BeautifulSoup :

1soup = BeautifulSoup(html_content, "html.parser")

2print(soup.title.string) # Devrait afficher "Hacker News"Extraire les données voulues

Imaginons que tu veux récupérer tous les titres d’articles et leurs liens. En inspectant la page, tu verras que chaque titre est dans une balise <a class="storylink">.

1stories = soup.find_all('a', class_='storylink')

2data = []

3for story in stories:

4 title = story.get_text()

5 link = story['href']

6 data.append({"title": title, "url": link})

7 print(title, "->", link)Pour des produits, tu chercherais par exemple <div class="product-item"> et tu extrairais les champs à l’intérieur. Exemple générique :

1products = soup.find_all('div', class_='product-item')

2for prod in products:

3 name = prod.find('h2').get_text()

4 price = prod.find('span', class_='price').get_text()

5 url = prod.find('a')['href']

6 data.append({"name": name, "price": price, "url": url})Sauvegarder les données extraites en CSV ou JSON

Enregistre maintenant tes données pour pouvoir les exploiter.

En CSV :

1import csv

2with open("output.csv", mode="w", newline="", encoding="utf-8") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "URL"])

5 for item in data:

6 writer.writerow([item["title"], item["url"]])En JSON :

1import json

2with open("output.json", mode="w", encoding="utf-8") as f:

3 json.dump(data, f, indent=2)Ouvre ton CSV dans Excel ou le JSON dans un éditeur de texte — et voilà, tu viens d’automatiser des heures de boulot manuel.

Aller plus loin : gérer la pagination et le contenu dynamique

La plupart des sites ne tiennent pas sur une seule page. Voici comment gérer des cas plus avancés.

Pagination

Si le site utilise une pagination dans l’URL (ex : ?page=2), fais une boucle sur les numéros de page :

1base_url = "https://example.com/products?page="

2for page_num in range(1, 6):

3 url = base_url + str(page_num)

4 resp = requests.get(url)

5 if resp.status_code != 200:

6 break

7 soup = BeautifulSoup(resp.content, "html.parser")

8 # Extraction comme avant()

Si le site propose un bouton « Suivant », trouve le lien et suis-le :

1url = "https://example.com/products"

2while url:

3 resp = requests.get(url)

4 soup = BeautifulSoup(resp.content, "html.parser")

5 # Extraction des données

6 next_link = soup.find('a', class_='next-page')

7 if next_link and 'href' in next_link.attrs:

8 url = "https://example.com" + next_link['href']

9 else:

10 url = NoneContenu dynamique (généré en JavaScript)

Si les données ne sont pas dans le HTML (chargées par JavaScript), utilise Selenium :

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/complex-page")

4driver.implicitly_wait(5)

5page_html = driver.page_source

6soup = BeautifulSoup(page_html, "html.parser")

7# Extraction comme avant()

Selenium peut aussi cliquer sur des boutons « Charger plus » ou faire défiler la page. Attention : c’est plus lent et gourmand en ressources que Requests.

Les galères et pièges classiques de l’extraction web maison

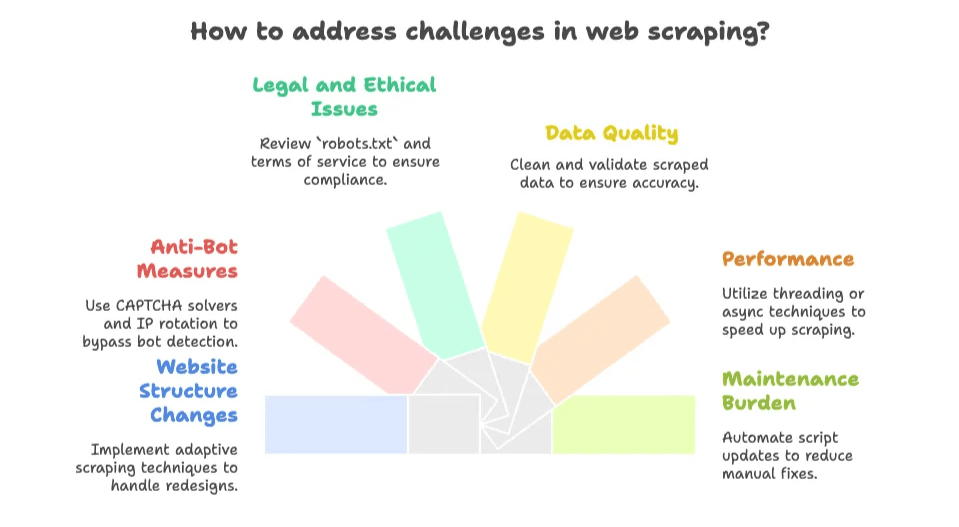

C’est là que ça se complique. Écrire un extracteur web, c’est grisant… jusqu’à ce que le site change et que ton script plante la veille d’une deadline. Voici les principaux pièges :

- Changements de structure du site : Si le site est refondu ou modifie ses classes CSS, ton script peut s’arrêter de fonctionner. La maintenance, c’est un vrai défi ().

- Anti-bots : CAPTCHAs, limitations de requêtes, blocages d’IP sont fréquents. .

- Questions légales et éthiques : Vérifie toujours le fichier

robots.txtet les conditions d’utilisation du site. Les données publiques sont généralement accessibles, mais évite de scraper du contenu privé ou protégé (). - Qualité des données : Les données extraites peuvent être en vrac. Il faudra parfois nettoyer les balises HTML, espaces ou textes bizarres.

- Performance : Extraire plein de pages, c’est lent sans techniques de threading ou d’asynchrone.

- Charge de maintenance : Chaque nouveau site ou changement implique de nouveaux scripts à corriger. C’est sans fin.

Si tu aimes les défis techniques, ça fait partie du jeu. Mais si tu veux juste les données, ça peut vite devenir lassant.

L’alternative maligne : les extracteurs web IA comme Thunderbit

C’est là que je sors ma casquette Thunderbit (dans ma tête, elle a la forme d’un éclair !). La plupart des pros ne veulent pas coder ni entretenir des scripts — ils veulent juste les données, tout de suite.

C’est pour ça qu’on a créé , une qui permet d’extraire n’importe quel site, PDF ou image en deux clics. Pas de code, pas de configuration, aucune connaissance HTML requise.

Qu’est-ce qui rend Thunderbit unique ?

- Configuration en 2 clics : Ouvre la page, clique sur « Suggestions IA », puis sur « Extraire ». C’est tout.

- Suggestions de champs par l’IA : L’IA de Thunderbit analyse la page et propose les colonnes pertinentes (nom du produit, prix, note, etc.).

- Extraction de sous-pages et pagination : Suit automatiquement les liens « Suivant » ou explore les pages de détail pour enrichir tes données.

- Export instantané : Exporte vers Excel, Google Sheets, Airtable, Notion, CSV ou JSON — gratuitement, sans prise de tête.

- Types de données variés : Extraction d’emails, numéros de téléphone, images, et même de texte depuis des PDF ou images (grâce à l’OCR intégré).

- Extraction cloud ou navigateur : Jusqu’à 50 pages extraites en parallèle dans le cloud, ou via ton navigateur pour les sites nécessitant une connexion.

- Aucune maintenance : L’IA s’adapte automatiquement aux changements de mise en page, plus besoin de réparer tes scripts.

Comparatif : Python vs Thunderbit

| Aspect | Extracteur Python | Thunderbit (Extracteur Web IA) |

|---|---|---|

| Temps de mise en place | Plusieurs heures de code et de débogage | Quelques minutes — installation, clic, c’est parti |

| Compétences requises | Élevées (Python, HTML, CSS, débogage) | Faibles (interface intuitive, aucun code) |

| Maintenance | À votre charge à chaque changement de site | L’IA de Thunderbit s’adapte automatiquement |

| Pagination/sous-pages | Boucles et logique personnalisées à coder | Intégré, il suffit d’activer l’option |

| Types de données | Basique par défaut ; codage supplémentaire pour images, PDF, emails, etc. | Extraction en un clic pour texte, images, emails, numéros, PDF, etc. |

| Échelle & rapidité | Limité par votre code et vos ressources | Extraction cloud jusqu’à 50 pages ; mode navigateur pour les sites avec connexion |

| Coût | Python gratuit, mais votre temps ne l’est pas ; serveurs et proxies à prévoir | Version gratuite disponible ; offres payantes dès ~16,5$/mois pour 30 000 crédits/an (tarifs) |

| Flexibilité & contrôle | Contrôle maximal pour la logique sur-mesure | Commodité maximale pour les usages standards |

Pour la majorité des pros, Thunderbit est le raccourci pour obtenir des données structurées sans prise de tête.

Quand coder son propre extracteur web, et quand utiliser un extracteur IA ?

Alors, quelle méthode choisir ? Voici mon avis sans filtre :

Coder ton extracteur si :

- Tu as besoin d’une logique très personnalisée (connexion 2FA, workflows complexes, intégration backend…)

- Tu maîtrises le code et tu aimes bidouiller

- Le site est stable et tu acceptes de maintenir tes scripts

- Tu dois intégrer l’extraction dans un système logiciel plus large

- Tu extrais des données derrière une connexion ou non prises en charge par les outils IA

Utiliser un extracteur IA (Thunderbit) si :

- Tu ne veux pas coder ni entretenir de scripts

- Tu as besoin des données rapidement (ponctuellement ou régulièrement)

- Le site change souvent ou a des anti-bots (Thunderbit gère ça pour toi)

- Tu veux des fonctionnalités intégrées comme l’OCR, l’extraction d’emails/téléphones, ou l’export direct vers tes outils préférés

- Tu veux passer ton temps à analyser, pas à déboguer

Petit guide de décision :

- Les données sont publiques et sans connexion complexe ? → Thunderbit est sûrement la meilleure option.

- Besoin ponctuel ou ad hoc ? → Thunderbit.

- Besoin de personnalisation ou d’intégration poussée ? → Script Python.

- Un développeur dispo et envie de coder ? → Script Python.

- Tu veux éviter la maintenance ? → Thunderbit.

Et n’oublie pas : commence avec Thunderbit pour des résultats rapides, puis passe au script sur-mesure si tes besoins évoluent.

Pour en savoir plus sur le fonctionnement des extracteurs web IA et leurs cas d’usage, jette un œil à notre .

À retenir : réussir l’extraction web pour ton entreprise

En résumé :

- L’extraction web avec Python est puissante et flexible, mais demande un peu d’apprentissage et de maintenance.

- Les extracteurs web IA comme Thunderbit rendent l’extraction accessible à tous — sans code, sans configuration, juste des résultats.

- Pour la plupart des pros, l’option la plus rapide et efficace, c’est d’utiliser un outil IA, sauf si tu as des besoins très spécifiques.

- Le web regorge de données, et la bonne méthode peut te faire gagner des heures (voire des jours) de boulot manuel.

FAQ

1. C’est quoi l’extraction web et pourquoi Python est souvent utilisé ?

L’extraction web, c’est collecter automatiquement des données sur des sites internet. Python est populaire pour ça grâce à sa simplicité, ses nombreuses bibliothèques (requests, BeautifulSoup, Selenium) et sa facilité à manipuler le HTML.

2. À quoi sert l’extraction web en entreprise ?

Les entreprises s’en servent pour la génération de leads, la veille tarifaire, l’intelligence marché ou l’agrégation de données immobilières. Ça permet d’automatiser la collecte d’infos et d’avoir des insights à jour pour décider vite.

3. Quels sont les principaux défis de l’extraction web maison ?

Les galères classiques : changements de structure des sites, protections anti-bots (CAPTCHA), questions légales, qualité des données, et la maintenance continue des scripts.

4. En quoi l’extracteur web IA de Thunderbit est différent d’un script Python classique ?

Thunderbit propose une solution sans code, avec suggestions de champs par l’IA, pagination automatique et options d’export. Il s’installe en quelques secondes, s’adapte aux changements de sites, et tout le monde peut l’utiliser, alors que les scripts Python demandent des compétences techniques et de la maintenance.

5. Quand privilégier un extracteur IA comme Thunderbit plutôt que de coder soi-même ?

Utilise Thunderbit si tu veux extraire rapidement et facilement des données publiques ou pour des besoins ponctuels. Opte pour un script Python si tu veux un contrôle total, une intégration poussée ou extraire des contenus complexes ou protégés.

Pour aller plus loin :

Si tu veux creuser le sujet, découvre nos autres guides :

Et si tu veux tester la méthode la plus simple pour extraire le web, et fais-toi ton propre avis. Tes soirées (et tes données) te diront merci !