Hast du schon mal versucht, Daten aus einer Webseite oder einer alten Software zu ziehen und dich dabei gefühlt, als würdest du ein digitales „Whack-a-Mole“ spielen? Damit bist du definitiv nicht allein. In unserer datengetriebenen Welt sind Teams aus Vertrieb, Marketing, Operations und Co. ständig auf der Jagd nach wertvollen Insights – doch viele wichtige Infos verstecken sich hinter komplizierten Oberflächen, veralteten Systemen oder schwer zugänglichen Webseiten. Während Web-Scraper heute fast schon Standard sind, gibt es eine Methode, die seit Jahrzehnten im Hintergrund für Daten sorgt: Screen Scraping. Diese Technik wirkt zwar etwas oldschool und wird oft unterschätzt, erlebt aber durch moderne KI-Tools gerade ein echtes Revival.

Lass uns gemeinsam anschauen, was Screen Scraping eigentlich ist, wie es sich vom klassischen Web-Scraping unterscheidet und warum es für Unternehmen, die schwer zugängliche Daten brauchen, zum echten Geheimtipp geworden ist. Außerdem zeige ich dir, wie moderne Tools wie Screen Scraping für alle zugänglich machen – nicht nur für Entwickler oder IT-Profis. Wenn du schon immer mal riesige Datenmengen in Sekunden „kopieren und einfügen“ wolltest (ohne wirklich zu kopieren und einzufügen), solltest du jetzt unbedingt weiterlesen.

Was ist Screen Scraping und wie unterscheidet es sich vom Web Scraping?

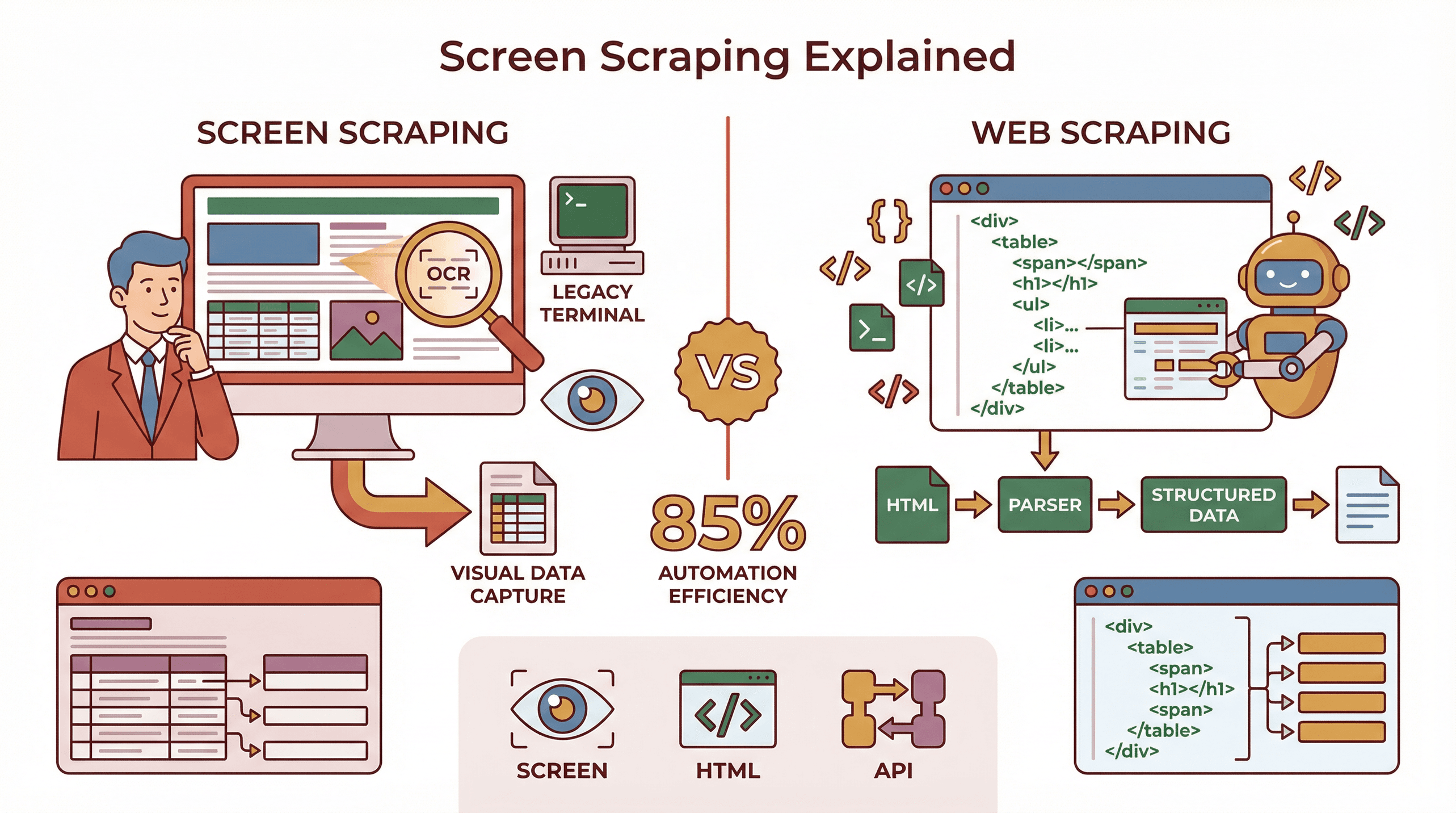

Screen Scraping ist im Grunde die digitale Variante davon, Infos auf einem Bildschirm zu lesen und sie woanders einzutragen – nur eben vollautomatisch. Dabei werden Daten aus dem sichtbaren Bereich eines Bildschirms extrahiert, egal ob von einer Webseite, einer Desktop-App oder sogar einem Terminalfenster. Im Gegensatz zum klassischen Web-Scraping, das direkt im HTML-Code nach Daten sucht, holt sich Screen Scraping die tatsächlich angezeigten Inhalte – also das, was du als Nutzer siehst, nicht nur das, was im Quelltext steht ().

Screen Scraping ist im Grunde die digitale Variante davon, Infos auf einem Bildschirm zu lesen und sie woanders einzutragen – nur eben vollautomatisch. Dabei werden Daten aus dem sichtbaren Bereich eines Bildschirms extrahiert, egal ob von einer Webseite, einer Desktop-App oder sogar einem Terminalfenster. Im Gegensatz zum klassischen Web-Scraping, das direkt im HTML-Code nach Daten sucht, holt sich Screen Scraping die tatsächlich angezeigten Inhalte – also das, was du als Nutzer siehst, nicht nur das, was im Quelltext steht ().

Seinen Ursprung hat Screen Scraping in der Zeit der alten Großrechner und grünen Terminalbildschirme – oder Banking-Apps, die noch nie was von einer API gehört haben. Damals musste man sich wie ein Nutzer einloggen, durch Menüs klicken und die angezeigten Daten „lesen“, um sie zu bekommen. Auch heute wird Screen Scraping noch für solche Altsysteme genutzt, ist aber auch ein wertvolles Werkzeug für moderne Webdaten-Extraktion – vor allem, wenn Webseiten besonders komplex sind oder klassische Scraper gezielt blockiert werden ().

Die wichtigsten Unterschiede:

- Screen Scraping: Automatisiert das, was ein Nutzer sieht – erfasst Text, Bilder oder Tabellen so, wie sie auf dem Bildschirm erscheinen. Mit OCR (Optical Character Recognition) kann sogar Text aus Bildern oder PDFs extrahiert werden.

- Web-Scraper: Arbeitet direkt mit der HTML-Struktur einer Webseite und sucht gezielt nach Tags, Klassen oder IDs, um strukturierte Daten zu gewinnen.

- API-Extraktion: Nutzt offizielle, strukturierte Datenquellen, die von der Anwendung oder Webseite bereitgestellt werden (sofern vorhanden).

Wenn du schon mal eine Tabelle auf einer Webseite markiert und in Excel eingefügt hast, hast du im Prinzip manuelles Screen Scraping gemacht. Moderne Screen-Scraper automatisieren und skalieren diesen Vorgang.

Die Rolle von Screen Scraping bei der Webdaten-Extraktion

Wo passt Screen Scraping also in die heutige Welt der Webdaten-Extraktion? Kurz gesagt: Es ist das Schweizer Taschenmesser, das immer dann zum Einsatz kommt, wenn andere Tools an ihre Grenzen stoßen.

Wann ist Screen Scraping notwendig?

- Altsysteme oder geschlossene Software: In vielen Branchen (Finanzen, Versicherungen, Gesundheitswesen) laufen noch Programme, die keine APIs oder Exportfunktionen bieten. Screen Scraping ist oft die einzige Möglichkeit, Daten für Migration oder Analyse zu gewinnen ().

- Dynamische oder visuell komplexe Webseiten: Manche Seiten laden Inhalte per JavaScript, verstecken Daten hinter Interaktionen oder stellen wichtige Infos als Bild dar, um Scraper zu blockieren. Screen Scraping „sieht“ das, was wirklich angezeigt wird, nicht nur den Code ().

- Umgehung von API-Beschränkungen: Wenn APIs eingeschränkt, teuer oder gar nicht vorhanden sind, kann Screen Scraping die Lücke füllen – und Daten direkt aus Dashboards oder Berichten holen.

- Schnelle Marktanalysen: Vertriebs- und Marketingteams brauchen oft sofort Daten, nicht erst nach wochenlangen IT-Abstimmungen. Screen Scraping ermöglicht es, das zu erfassen, was gerade sichtbar ist ().

Screen Scraping ist nicht immer die erste Wahl – es kann anfälliger und langsamer sein als Web-Scraping –, aber oft die flexibelste Lösung, wenn du Daten so erfassen musst, wie sie ein Nutzer sieht.

Screen Scraping vs. API und Web Scraping: Die wichtigsten Unterschiede

Hier ein direkter Vergleich:

| Methode | Funktionsweise | Ideal für | Vorteile | Nachteile |

|---|---|---|---|---|

| Screen Scraping | Liest sichtbare Inhalte aus UI (Bildschirm, App, Web) | Altsysteme, dynamische Oberflächen, Bilder | Kann alles extrahieren, was ein Nutzer sieht; funktioniert, wenn APIs oder HTML-Parsing scheitern | Empfindlich gegenüber UI-Änderungen; evtl. OCR nötig; langsamer |

| Web Scraping | Analysiert HTML/DOM-Struktur von Webseiten | Strukturierte Webseiten, große Datenmengen | Schnell, präzise, für große Volumen geeignet | Bricht bei HTML-Änderungen; Probleme mit dynamischen Inhalten |

| API-Extraktion | Nutzt offizielle Datenendpunkte (JSON, XML) | Unterstützte Apps/Sites, Echtzeitdaten | Am zuverlässigsten, strukturiert, rechtlich sicher, schnell | Begrenzte Abdeckung; evtl. Authentifizierung oder Kosten |

Beispiel:

- API: Holt Produktpreise direkt aus dem Backend eines Shops (sofern erlaubt).

- Web-Scraper: Findet Preise im HTML-Code.

- Screen Scraping: „Liest“ den Preis so, wie er auf der Seite angezeigt wird – auch wenn er als Bild oder hinter einem Pop-up versteckt ist.

Für einen ausführlichen Vergleich lies .

Wie Web-Scraping-Tools Screen Scraping vereinfachen

Früher bedeutete Screen Scraping: Skripte schreiben, mit Browser-Automatisierung kämpfen oder RPA-Bots bauen. Heute? Moderne Web-Scraping-Tools – vor allem mit KI – machen Screen Scraping fast so einfach wie Online-Shopping.

Wichtige Funktionen moderner Tools:

- Point-and-Click-Oberflächen: Einfach auf die gewünschten Daten klicken, der Rest läuft automatisch. Kein Code, keine komplizierten Selektoren ().

- Anweisungen in natürlicher Sprache: Beschreibe, was du brauchst („Alle Produktnamen und Preise erfassen“), und die KI richtet den Scraper für dich ein ().

- Automatische Datenstrukturierung: Die Ergebnisse kommen als saubere Tabellen, bereit für Excel, Google Sheets oder dein BI-Tool.

- Automatisierte Navigation: Das Tool klickt sich durch Seiten, scrollt, loggt sich ein – wie ein echter Nutzer.

Dank dieser Fortschritte kann heute wirklich jeder – ob Sales, Marketing oder sogar der Onkel, der noch Internet Explorer nutzt – komplexe Daten von Bildschirmen extrahieren, ganz ohne Technikkenntnisse.

Thunderbit: KI-gestütztes Screen Scraping für komplexe Webdaten

Jetzt wird’s spannend: bringt Screen Scraping auf ein neues Level (und ja, ich bin voreingenommen – wir haben es genau für diese Herausforderungen gebaut).

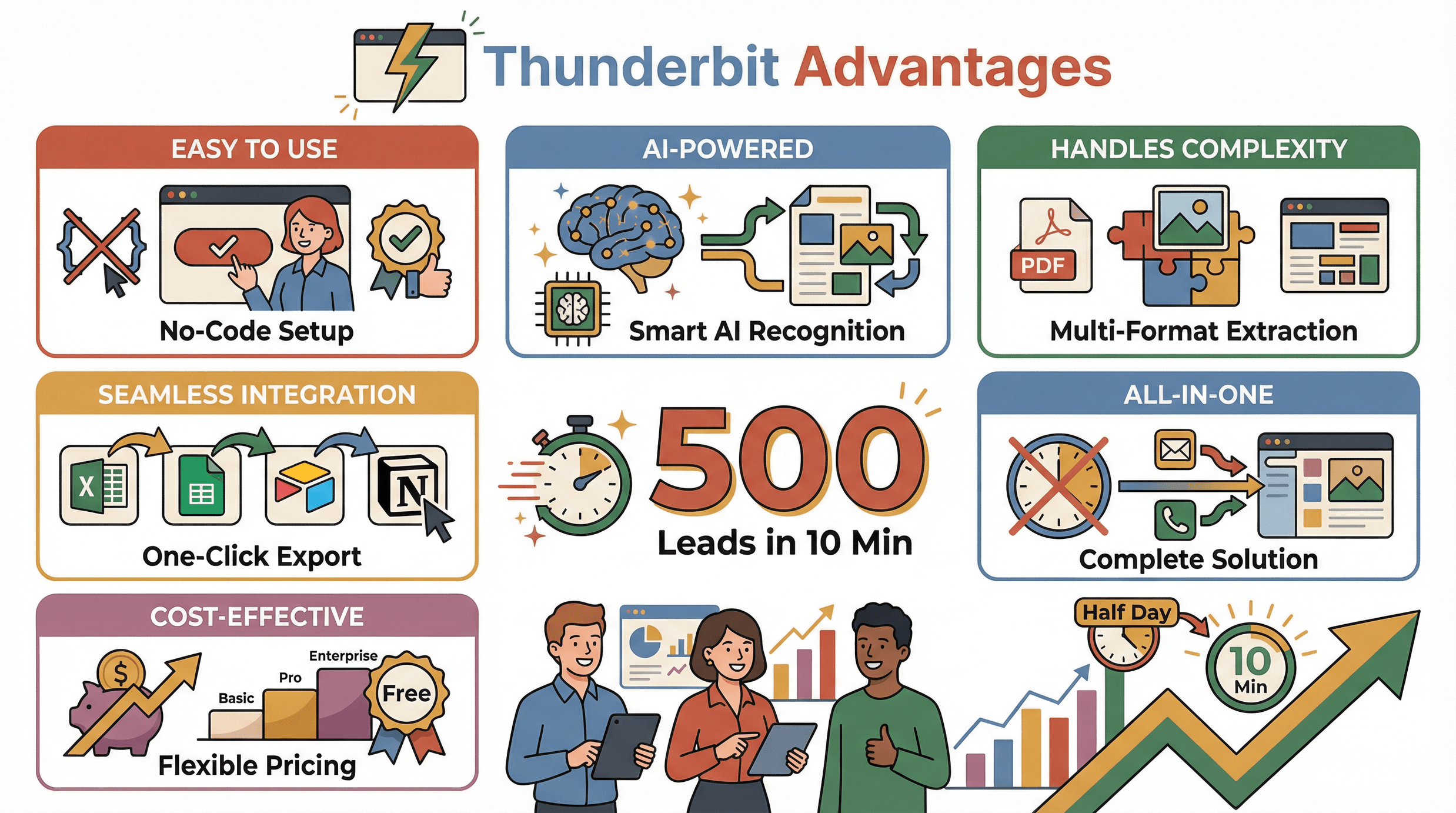

Thunderbit ist eine KI-Web-Scraper Chrome-Erweiterung, die speziell für Business-Anwender entwickelt wurde, die mit wenigen Klicks Daten aus beliebigen Webseiten extrahieren möchten. So bringt Thunderbit Screen Scraping ins Hier und Jetzt:

- KI-Feldvorschläge: Thunderbit „liest“ die Seite wie ein Mensch und schlägt automatisch die besten Spalten zur Extraktion vor – kein Rätselraten, keine Selektoren suchen ().

- 2-Klick-Scraping: Auf „KI-Feldvorschläge“ klicken, Spalten prüfen, dann auf „Scrapen“ – Thunderbit erledigt den Rest, auch bei schwierigen Layouts oder dynamischen Inhalten.

- Unterseiten-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch jede Unterseite (z. B. einzelne Produkt- oder Profilseiten), sammelt Zusatzinfos und fügt sie deiner Tabelle hinzu ().

- Vorlagen für beliebte Seiten: Für Plattformen wie Amazon, Zillow, LinkedIn, Shopify und viele mehr gibt’s fertige Templates – kein Einrichten nötig.

- Pagination & Infinite Scroll: Thunderbit kann bis zu 50 Seiten gleichzeitig in der Cloud scrapen – perfekt für große Datenmengen.

- Kostenloser Datenexport: Exportiere deine Ergebnisse direkt nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten oder Bindung ().

Das Besondere an Thunderbit ist die KI. Sie erkennt nicht nur, was auf dem Bildschirm steht, sondern versteht den Kontext, passt sich Änderungen an und kann Daten sogar direkt umformatieren, zusammenfassen oder übersetzen.

Die wichtigsten Vorteile von Thunderbit beim Screen Scraping

Deshalb ist Thunderbit mein Favorit für Screen Scraping (und warum immer mehr Teams aus Vertrieb, Marketing und Operations darauf setzen):

Deshalb ist Thunderbit mein Favorit für Screen Scraping (und warum immer mehr Teams aus Vertrieb, Marketing und Operations darauf setzen):

- Extrem einfach zu bedienen: Kein Code, keine Vorlagen, keine Einarbeitung. Wer einen Browser bedienen kann, kann auch Thunderbit nutzen ().

- KI-gestützte Genauigkeit: Thunderbits KI erkennt Felder auch bei Layout-Änderungen – weniger Wartung, weniger Ausfälle.

- Meistert Komplexität: Unterseiten, dynamische Inhalte, Bilder, PDFs – Thunderbit extrahiert alles, selbst aus unübersichtlichen oder sich ändernden Seiten.

- Nahtlose Integration: Export mit einem Klick nach Excel, Google Sheets, Airtable oder Notion. Scrapes können geplant werden, damit deine Daten immer aktuell sind.

- Kosteneffizient: Kostenlos für kleine Aufgaben, bezahlbare Tarife für größere Projekte. Keine Zusatzkosten für Exporte oder Premium-Funktionen ().

- Alles in einem Tool: Du willst E-Mails, Telefonnummern oder Bilder extrahieren? Thunderbit hat dafür eigene Extraktoren.

Für Teams, die früher stundenlang kopiert und eingefügt haben, ist Thunderbit ein echter Produktivitäts-Booster. Ein Nutzer hat mir erzählt, dass er in 10 Minuten eine Lead-Liste mit 500 Einträgen erstellt hat – früher hätte das einen halben Tag gedauert.

Typische Anwendungsfälle: Wo Screen Scraping heute echten Mehrwert bietet

| Branche/Funktion | Beispiel für Anwendungsfall |

|---|---|

| E-Commerce/Handel | Wettbewerbs-Preisüberwachung, Produktlisten von Marktplätzen extrahieren, Lagerbestände verfolgen |

| Vertrieb/Lead-Gen | Kontaktdaten aus Verzeichnissen, LinkedIn, Immobilienanzeigen oder Teilnehmerlisten gewinnen |

| Marketing | Markenmonitoring, Bewertungen oder Social Posts für Sentiment-Analysen scrapen |

| Finanzen | Echtzeit-Aktienkurse aggregieren, Kreditkonditionen der Konkurrenz scrapen, Daten aus alten Portalen ziehen |

| Versicherungen | Angebotsseiten der Konkurrenz scrapen, Daten aus alten Schadensystemen extrahieren |

| Gesundheitswesen | Patientendaten aus Altsystemen migrieren, Studienregister scrapen |

| Immobilien | Immobilienangebote aggregieren, Open-House- oder Genehmigungsdaten scrapen |

| Reisen/Gastronomie | Preise der Konkurrenz verfolgen, Bewertungen scrapen, Buchungsportale überwachen |

| Behörden/Recht | Gerichtsakten, Gesetzestexte oder öffentliche Listen scrapen |

Screen Scraping ist die „Joker-Karte“ für alle Fälle, in denen Daten zwar sichtbar, aber nicht einfach zugänglich sind.

Die Entwicklung und Zukunft von Screen Scraping

Screen Scraping entwickelt sich rasant weiter – und es geht längst nicht mehr nur um „rohe Gewalt“. Das sind die aktuellen Trends:

- KI-gesteuerte Anpassungsfähigkeit: Moderne Screen-Scraper nutzen Machine Learning, um Felder anhand des Kontexts zu erkennen, nicht nur anhand von Position oder Code. Wird das Feld „Preis“ verschoben, findet die KI es trotzdem ().

- Integration mit Automatisierung: Screen Scraping verschmilzt mit RPA (Robotic Process Automation) und Business Intelligence. Scraper liefern Daten direkt an Dashboards, lösen Alarme aus oder starten Workflows automatisch ().

- Verteiltes und Edge-Scraping: Scraper werden immer raffinierter, um Erkennung zu vermeiden – etwa durch verteilte Bots oder Edge Computing, das echte Nutzer simuliert ().

- Eingebaute Compliance: Mit strengeren Datenschutzgesetzen setzen moderne Tools auf Compliance – sie respektieren robots.txt, lassen persönliche Daten aus und führen Protokolle für die Nachvollziehbarkeit ().

- KI-gestützte Auswertung: Die nächste Generation von Screen-Scrapern sammelt nicht nur Daten, sondern analysiert, fasst zusammen und liefert direkt Insights. Zum Beispiel: Bewertungen scrapen und sofort eine Stimmungsanalyse erhalten ().

Fazit: Screen Scraping wird immer smarter, integrierter und zugänglicher. Die Zeiten fehleranfälliger Skripte sind vorbei – KI macht Screen Scraping zu einem robusten Alltagswerkzeug für Business-Anwender.

Fazit: Die richtige Methode für die Webdaten-Extraktion wählen

Screen Scraping, Web-Scraper, APIs – sie sind alle Werkzeuge im Werkzeugkasten der Datenextraktion. Die Kunst ist, zu wissen, wann welches Tool am besten passt.

- APIs nutzen, wenn möglich: Sie sind zuverlässig, strukturiert und meist zukunftssicher.

- Web-Scraper für strukturierte Seiten: Ist das HTML sauber und konsistent, ist Web Scraping schnell und effizient.

- Screen Scraping, wenn nichts anderes geht: Für Altsysteme, dynamische Seiten oder alles, was „hinter“ einer Oberfläche versteckt ist, ist Screen Scraping oft die beste Wahl.

Moderne Tools wie machen Screen Scraping für alle zugänglich – mit KI-Felderkennung, intuitiver Bedienung und nahtlosem Export. So kannst du die Daten extrahieren, die du brauchst – egal, wo sie sich verstecken.

Neugierig geworden? und erlebe, wie einfach Screen Scraping heute ist. Und wenn du tiefer in das Thema Webdaten-Extraktion einsteigen willst, findest du im viele weitere Anleitungen, Tipps und Praxisberichte aus der Welt der Datenautomatisierung.

Häufige Fragen (FAQ)

1. Was ist der Hauptunterschied zwischen Screen Scraping und Web Scraping?

Screen Scraping extrahiert Daten aus dem, was auf dem Bildschirm angezeigt wird (wie ein Nutzer es sieht), während Web-Scraper Daten direkt aus dem HTML-Code einer Webseite ziehen. Screen Scraping ist flexibler für Altsysteme oder visuell komplexe Seiten, Web Scraping dagegen meist schneller und präziser bei strukturierten Webseiten ().

2. Wann sollte ich Screen Scraping statt einer API oder Web Scraping nutzen?

Screen Scraping ist sinnvoll, wenn keine API verfügbar ist, das HTML der Webseite zu komplex oder dynamisch ist oder wenn du Daten aus Altsystemen, Bildern oder hinter Interaktionen versteckten Inhalten extrahieren musst ().

3. Wie erleichtert Thunderbit Screen Scraping für Nicht-Techniker?

Thunderbit nutzt KI, um Felder automatisch zu erkennen und vorzuschlagen, bietet eine intuitive Point-and-Click-Oberfläche und übernimmt komplexe Aufgaben wie Unterseiten-Navigation und Datenstrukturierung – ganz ohne Programmierung. Die Ergebnisse kannst du direkt nach Excel, Google Sheets, Airtable oder Notion exportieren ().

4. Welche Praxisbeispiele gibt es für Screen Scraping?

Screen Scraping wird genutzt für Preisüberwachung im E-Commerce, Lead-Generierung aus Verzeichnissen, Datenextraktion aus alten Finanz- oder Gesundheitssystemen, Wettbewerbsbeobachtung, Immobilien-Listings und vieles mehr. Besonders wertvoll ist es, wenn Daten nicht über APIs oder klassisches Web-Scraping zugänglich sind ().

5. Ist Screen Scraping legal und datenschutzkonform?

Das Scrapen öffentlicher Daten ist in vielen Ländern grundsätzlich erlaubt, trotzdem solltest du immer die Nutzungsbedingungen der jeweiligen Webseite prüfen und keine persönlichen oder sensiblen Daten ohne Einwilligung erfassen. Moderne Tools bieten zunehmend Compliance-Funktionen, um rechtliche und ethische Vorgaben einzuhalten ().

Bereit, die Daten zu erschließen, die du wirklich brauchst? Probier Thunderbit aus und erlebe, wie Screen Scraping deinen Arbeitsalltag beschleunigen kann.

Mehr erfahren