Das Internet ist heute viel chaotischer – und gleichzeitig spannender – als damals, als man noch einfach per „Rechtsklick, Speichern unter“ Inhalte sichern konnte. Moderne Webseiten sind wie ein undurchsichtiges Labyrinth: Überall dynamische Inhalte, versteckte Links, Pop-ups und verschachtelte Menüs. Wer schon mal versucht hat, alle Produktinfos aus einem aktuellen Online-Shop oder sämtliche Inserate von einem Immobilienportal zu sammeln, weiß: Mit klassischen Web-Scrapern kommt man da nicht mehr weit. Genau hier kommen Deep Crawler ins Spiel – eine neue Generation von Web-Scraping-Tools, die tiefer graben, weiter vordringen und genau die Daten liefern, die wirklich zählen.

Aber was ist eigentlich ein Deep Crawler? Warum setzen immer mehr Unternehmen – von Sales bis Marktforschung – auf diese Technologie? Und wie macht ein Tool wie Deep Crawling so einfach, dass du es mit zwei Klicks erledigen kannst – ganz ohne Programmierkenntnisse? Wir schauen uns die Basics, die Funktionsweise und den Business-Nutzen an und zeigen, warum Deep Crawler zum Geheimtipp für moderne Web-Datensammler werden.

Was ist ein Deep Crawler? Die Basics auf einen Blick

Ein Deep Crawler ist im Kern ein spezialisierter Web-Scraper, der darauf ausgelegt ist, auch komplexe, mehrschichtige und dynamische Webseiten zu durchdringen und Daten daraus zu extrahieren. Während normale Crawler meist nur die sichtbaren Inhalte der Startseite abgreifen, folgt ein Deep Crawler Links, navigiert durch verschiedene Ebenen und kommt auch mit paginierten Listen, versteckten Tabs oder ausklappbaren Bereichen klar.

Stell dir einen klassischen Crawler wie jemanden vor, der einmal durch die Bibliothek läuft und nur die Buchtitel auf den vorderen Regalen notiert. Ein Deep Crawler hingegen durchstöbert jede Ecke, schlägt jedes Buch auf, liest die Fußnoten und wirft sogar einen Blick hinter die „Nur für Mitarbeiter“-Tür (sofern sie nicht verschlossen ist).

Im Web Scraping bedeutet das, ein Deep Crawler kann:

- Mehrere Ebenen einer Website durchqueren (Kategorien, Unterkategorien, Detailseiten)

- Dynamische Inhalte extrahieren, die per JavaScript geladen oder erst nach Nutzerinteraktion sichtbar werden

- Komplexe Paginierung und Endlos-Scrolls meistern

- Interne Links verfolgen, damit keine relevanten Daten verloren gehen

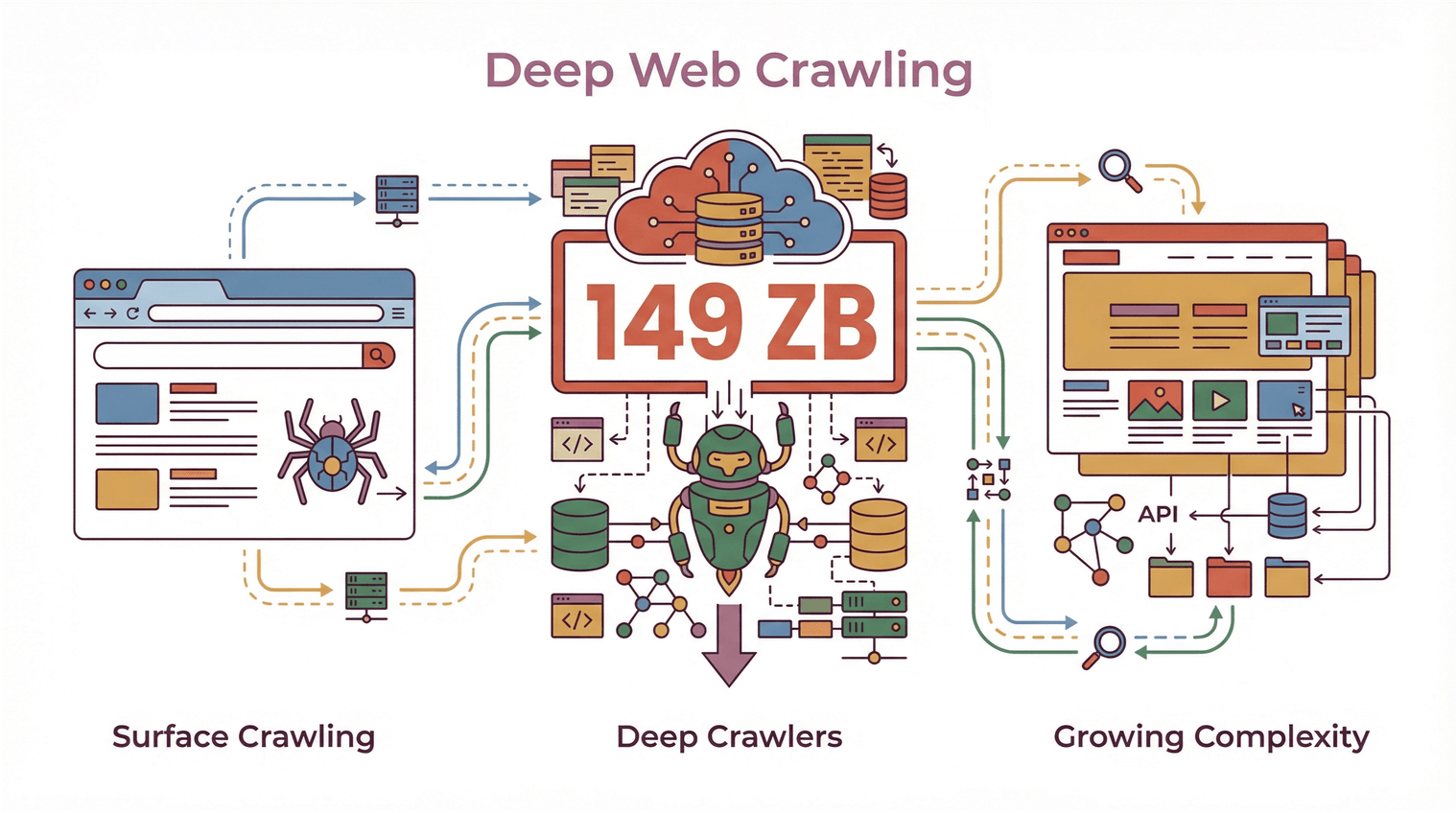

Angesichts eines weltweiten Web-Datenvolumens von und der immer komplexeren Webseiten sind Deep Crawler für alle, die mehr als nur einen oberflächlichen Scan brauchen, unverzichtbar geworden.

Angesichts eines weltweiten Web-Datenvolumens von und der immer komplexeren Webseiten sind Deep Crawler für alle, die mehr als nur einen oberflächlichen Scan brauchen, unverzichtbar geworden.

Deep Crawler vs. klassische Crawler: Wo liegt der Unterschied?

Schauen wir genauer hin: Was unterscheidet einen Deep Crawler von den „normalen“ Crawlern?

Klassische Crawler: Kratzen nur an der Oberfläche

Traditionelle Web-Crawler (oft auch „Shallow Crawler“ genannt) sind auf Geschwindigkeit und Reichweite getrimmt. Sie scannen eine Seite schnell, nehmen die sichtbaren Inhalte mit und ziehen weiter. So arbeiten auch Suchmaschinen: Sie wollen möglichst viele Seiten in kurzer Zeit indexieren, gehen aber selten in die Tiefe.

Einschränkungen klassischer Crawler:

- Übersehen oft Daten, die hinter Navigation, Tabs oder dynamischen Elementen versteckt sind

- Kommen mit JavaScript-lastigen Seiten oder nachträglich geladenen Inhalten nicht klar

- Scheitern an mehrstufiger Navigation oder komplexen Seitenstrukturen

- Liefern häufig unvollständige oder fragmentierte Datensätze

Deep Crawler: Mehr als nur das Offensichtliche

Ein Deep Crawler hingegen ist darauf ausgelegt, eine Website komplett zu erfassen – er folgt allen relevanten Links, klickt sich durch paginierte Listen und extrahiert Daten auch aus Unterseiten, Pop-ups und dynamisch geladenen Bereichen. Hier steht nicht die Geschwindigkeit, sondern die Vollständigkeit und Genauigkeit im Vordergrund.

Typische Merkmale von Deep Crawlern:

- Fortschrittliche Navigation: Kann Links rekursiv folgen, mehrstufige Strukturen durchdringen und vermeidet Sackgassen oder doppelte Seiten ().

- Dynamische Inhaltserfassung: Interagiert mit JavaScript, klappt versteckte Bereiche auf und extrahiert Daten, die erst nach Nutzeraktionen erscheinen ().

- Effizientere Datenerfassung: Konzentriert sich auf relevante Bereiche, vermeidet doppelte oder irrelevante Daten und stellt sicher, dass nichts Wichtiges fehlt ().

- Datenvollständigkeit: Erfasst alle Ebenen – von Hauptlisten über Detailseiten bis zu verknüpften Dokumenten – in einem Durchgang.

Wer schon mal versucht hat, alle Bewertungen einer Produktseite oder sämtliche Inserate inklusive Maklerdaten von einem Immobilienportal zu extrahieren, kennt die Grenzen klassischer Crawler. Genau hier spielen Deep Crawler ihre Stärken aus.

Wie Deep Crawler vollständige Daten und smarte Navigation ermöglichen

Wie funktioniert Deep Crawling in der Praxis? Das Geheimnis liegt in Link-Verfolgung, rekursiver Navigation und dem cleveren Umgang mit dynamischen Inhalten.

Unterseiten-Scraping und mehrschichtige Navigation

Ein Deep Crawler bleibt nicht auf der Startseite stehen. Er:

- Erkennt interne Links (wie „Details anzeigen“, „Nächste Seite“ oder „Mehr erfahren“)

- Folgt diesen Links zu Unterseiten, Detailansichten oder sogar Pop-ups

- Extrahiert Daten aus jeder Ebene und führt alles in einer strukturierten Tabelle zusammen

Diese Methode nennt man auch „rekursives Crawling“ oder „mehrstufiges Scraping“. Sie ist besonders praktisch, wenn Infos auf mehrere Seiten verteilt sind – zum Beispiel Produktlisten mit separaten Detailseiten oder Verzeichnisse, bei denen Kontaktdaten erst nach dem Klick erscheinen.

Umgang mit Paginierung und dynamischen Inhalten

Moderne Webseiten verstecken Daten oft hinter „Mehr laden“-Buttons, Endlos-Scrolls oder JavaScript-Tabs. Deep Crawler sind darauf ausgelegt:

- Paginierungs-Elemente zu erkennen und zu bedienen

- Durch dynamische Bereiche zu scrollen oder zu klicken

- Zu warten, bis Inhalte geladen sind, bevor Daten extrahiert werden

So bekommst du einen vollständigen Datensatz – und nicht nur das, was beim ersten Laden sichtbar war ().

Deep Link Tracking und mehrstufiges Scraping

Eine der größten Herausforderungen beim Deep Crawling ist es, versteckte oder verschachtelte Daten nicht zu übersehen. Deep Crawler nutzen Algorithmen, um:

- Besuchte Links zu verfolgen (um Duplikate oder Endlosschleifen zu vermeiden)

- Wichtige Seiten zu priorisieren (z. B. Detailansichten oder herunterladbare Dokumente)

- Sonderfälle zu meistern (wie Pop-ups, ausklappbare Bereiche oder per AJAX geladene Inhalte)

Gerade im Business-Bereich ist das entscheidend – denn fehlende Kontaktdaten oder Produktspezifikationen können zu verpassten Chancen oder lückenhaften Analysen führen ().

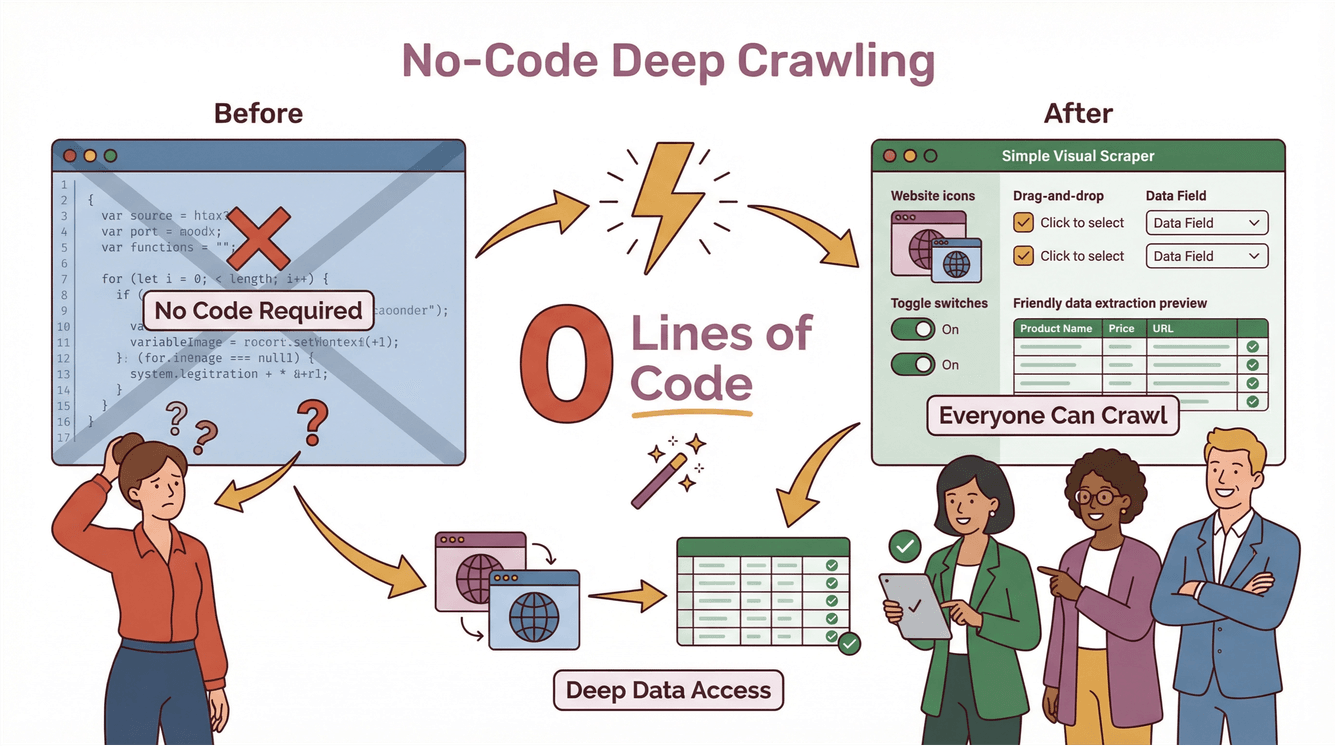

Thunderbit: Deep Crawling für alle – dank KI

Früher war Deep Crawling nur was für Entwickler und Datenprofis. Man musste eigene Skripte schreiben, Sonderfälle abdecken und bei jeder Webseitenänderung nachbessern. Mit ist das Geschichte: Deep Crawling wird für alle zugänglich – auch ohne Programmierkenntnisse.

Thunderbits Deep Crawler im Alltag

So macht Thunderbit Deep Crawling super easy:

- KI-Feldvorschläge: Ein Klick auf „KI-Felder vorschlagen“ reicht – Thunderbits KI analysiert die Seite, schlägt passende Spalten vor und erstellt sogar Prompts für jedes Feld.

- Unterseiten-Scraping: Mehr Infos nötig? Thunderbit besucht automatisch jede Unterseite (z. B. Produktdetails, Maklerprofile oder Bewertungstabs) und ergänzt deine Tabelle um zusätzliche Daten.

- Dynamische Inhalte meistern: Thunderbit interagiert mit Paginierung, Endlos-Scrolls und dynamischen Elementen – ganz ohne manuelle Konfiguration.

- No-Code, Zwei-Schritte-Prozess: Beschreibe, was du brauchst, klicke auf „Scrapen“ – Thunderbit erledigt den Rest. Exportiere deine Daten direkt nach Excel, Google Sheets, Notion oder Airtable – ohne Zusatzkosten oder Limits ().

Schritt-für-Schritt: Deep Crawling mit Thunderbit

Angenommen, du willst alle Immobilienanzeigen inklusive Maklerdaten von einer Website extrahieren:

- Öffne die Übersichtsseite in Chrome.

- Klicke auf die Thunderbit-Erweiterung.

- Nutze „KI-Felder vorschlagen“, damit Thunderbit Spalten wie „Anzeigentitel“, „Preis“, „Adresse“ und „Makler-Link“ empfiehlt.

- Klicke auf „Scrapen“. Thunderbit sammelt alle Hauptanzeigen.

- Klicke auf „Unterseiten scrapen“. Thunderbit besucht jedes Maklerprofil, extrahiert Telefonnummern, E-Mails und mehr und fügt alles in deine Haupttabelle ein.

- Exportiere die Daten nach Google Sheets oder Excel – fertig für dein Sales- oder Operationsteam.

Kein Code, keine Vorlagen, kein Stress. Und falls sich die Website ändert, passt sich Thunderbits KI automatisch an ().

Business-Vorteile: Wie Deep Crawler Vertrieb und Marketing pushen

Klingt spannend – aber was bringt das konkret fürs Business? Hier wird’s richtig interessant.

Wertvolle Insights aus E-Commerce, Immobilien und Wettbewerbsanalyse

Für Sales- und Marketingteams sind Deep Crawler ein echter Gamechanger. Sie ermöglichen es,:

- Alle Produkte, Preise und Bewertungen aus Online-Shops zu extrahieren – selbst wenn die Daten hinter mehreren Ebenen oder Tabs versteckt sind

- Immobilienanzeigen zu aggregieren (inklusive versteckter Maklerinfos oder Objektdetails)

- Wettbewerber-Websites zu überwachen – etwa auf neue Produkte, Preisänderungen oder Marktbewegungen ()

- Umfangreiche Lead-Listen zu erstellen, indem Kontaktdaten aus Verzeichnissen, Eventseiten oder Nischenportalen gesammelt werden

Mit Deep Crawling bekommst du nicht nur mehr Daten – sondern bessere, verwertbare Infos, die echten Mehrwert bringen.

Deep Scraping für Wettbewerbsanalysen

Stell dir vor, dein Vertriebsteam will gezielt Unternehmen ansprechen, die gerade ein neues Produkt gelauncht haben. Ein Deep Crawler kann:

- Wettbewerberseiten nach neuen Produktseiten durchsuchen

- Links zu Pressemitteilungen oder Investoren-Updates folgen

- Wichtige Details extrahieren (Launch-Daten, Preise, Features)

- Diese Daten direkt ins CRM oder Analyse-Tool einspeisen

Das Ergebnis: Schnellere, fundiertere Entscheidungen – und ein klarer Vorsprung gegenüber Teams, die nur an der Oberfläche kratzen.

Compliance & Best Practices: Was du beim Deep Crawling beachten solltest

Mit großer Crawling-Power kommt auch Verantwortung. Deep Crawler können auf viele Daten zugreifen – aber das heißt nicht, dass man alles bedenkenlos sammeln sollte. Das solltest du beachten:

Datenschutz und Urheberrecht

- Beachte die Nutzungsbedingungen der Website: Viele Seiten regeln in ihren AGB, was erlaubt ist. Verstöße können rechtliche Folgen haben ().

- Keine persönlichen oder vertraulichen Daten scrapen, sofern keine ausdrückliche Erlaubnis vorliegt.

- Urheberrechte respektieren: Inhalte nicht ohne Prüfung der Rechte weiterveröffentlichen oder verkaufen.

Verantwortungsvolles Crawling

- Anfragen drosseln: Überlaste Websites nicht mit zu vielen Anfragen auf einmal.

- robots.txt beachten: Auch wenn nicht rechtlich bindend, ist es guter Stil, die Crawling-Präferenzen der Seite zu respektieren.

- Rechtliche Vorgaben im Blick behalten: Gesetze wie DSGVO oder CCPA regeln, welche Daten gesammelt und wie sie genutzt werden dürfen ().

Mehr dazu im Beitrag .

So findest du die passende Deep Crawler-Lösung für dein Unternehmen

Worauf solltest du bei der Auswahl achten?

- Einfache Bedienung: Können auch Nicht-Techniker das Tool schnell nutzen? (Thunderbit: ja.)

- Skalierbarkeit: Kommt das Tool mit großen Seiten, vielen Unterseiten und dynamischen Inhalten klar?

- Compliance-Tools: Unterstützt es dich dabei, rechtlich auf der sicheren Seite zu bleiben?

- Integration: Lassen sich die Daten in bestehende Tools wie Excel, Sheets, Notion oder Airtable exportieren?

- Wartung: Passt sich das Tool automatisch an Webseitenänderungen an – oder musst du ständig nachbessern?

Thunderbit erfüllt all diese Anforderungen. Über – von Einzelgründern bis zu großen Unternehmen – vertrauen darauf. Und die Preise sind so gestaltet, dass auch kleine Firmen schon ab 15 $/Monat starten können.

Fazit: Deep Crawling als Schlüssel für moderne Datenstrategien

Kurz und knapp:

- Deep Crawler sind unverzichtbar, um vollständige und präzise Daten aus komplexen, dynamischen Webseiten zu holen.

- Sie gehen weit über klassische Crawler hinaus, indem sie mehrschichtige Navigation, dynamische Inhalte und versteckte Daten meistern.

- Business-Teams nutzen Deep Crawler, um Insights zu gewinnen, Vertrieb zu stärken, Wettbewerber zu beobachten und schneller zu entscheiden.

- Compliance ist Pflicht: Immer verantwortungsvoll scrapen, Datenschutz beachten und die Regeln einhalten.

- Thunderbit macht Deep Crawling für alle zugänglich – mit KI, No-Code-Ansatz und nahtlosem Datenexport.

Wer bereit ist, mehr als nur an der Oberfläche zu kratzen, kann mit der direkt loslegen. Weitere Tipps, Anleitungen und News rund um KI-gestütztes Web Scraping findest du im .

Häufige Fragen (FAQ)

1. Was ist ein Deep Crawler und wie unterscheidet er sich von einem klassischen Web Crawler?

Ein Deep Crawler ist ein Web-Scraping-Tool, das mehrere Ebenen einer Website durchläuft und Daten auch aus Unterseiten, dynamischen Inhalten und versteckten Bereichen extrahiert. Im Gegensatz zu klassischen Crawlern, die nur an der Oberfläche bleiben, sorgt ein Deep Crawler für eine umfassende Datenerfassung, indem er Links folgt und komplexe Strukturen bewältigt.

2. Warum brauchen Unternehmen 2025 Deep Crawler?

Webseiten sind heute komplexer denn je – viele Daten sind hinter Navigation, Tabs oder dynamischen Elementen versteckt. Deep Crawler helfen Unternehmen, vollständige Datensätze für Vertrieb, Marketing, Forschung und Wettbewerbsanalysen zu gewinnen – was mit einfachen Crawlern nicht möglich ist.

3. Wie vereinfacht Thunderbit Deep Crawling für Nicht-Techniker?

Thunderbit nutzt KI, um Felder vorzuschlagen, Unterseiten zu scrapen und dynamische Inhalte zu erfassen – alles über eine intuitive No-Code-Oberfläche. Nutzer beschreiben einfach, was sie brauchen, klicken auf „Scrapen“ und exportieren die Ergebnisse in ihre Lieblingstools.

4. Welche Compliance-Themen muss ich beim Einsatz eines Deep Crawlers beachten?

Beachte immer die Nutzungsbedingungen der Website, vermeide das Scrapen persönlicher oder vertraulicher Daten ohne Erlaubnis und halte dich an Datenschutzgesetze wie DSGVO und CCPA. Verantwortungsvolles Crawling und Datennutzung minimieren rechtliche Risiken.

5. Können Deep Crawler meinem Vertriebs- und Marketingteam bessere Ergebnisse liefern?

Definitiv. Deep Crawler erschließen wertvollere, verwertbare Daten aus E-Commerce, Immobilien- und Wettbewerberseiten – ideal für Lead-Generierung, Marktanalysen und schnelle Entscheidungen. Mit Tools wie Thunderbit können auch Nicht-Techniker die benötigten Insights einfach gewinnen.

Mehr erfahren