Hast du dich schon mal gefragt, wie manche Unternehmen immer genau wissen, was ihre Konkurrenz verlangt, neue Trends blitzschnell erkennen oder über Nacht riesige Listen mit potenziellen Kunden aufbauen? Damit bist du nicht allein. Das Geheimnis hinter diesen Erfolgen heißt Data Scraping – und in unserer datenüberfluteten Welt ist die Fähigkeit, gezielt Webdaten zu nutzen, fast schon eine Superkraft (nur eben ohne Cape und peinliche Telefonzellen).

Wir leben in einer Zeit, in der das Internet vor Daten nur so platzt – bis Ende 2025 werden weltweit unfassbare an digitalen Infos produziert worden sein. Das sind mehr Nullen, als man zählen kann – glaub mir, ich hab’s versucht. Für Unternehmen ist diese Datenflut ein echter Schatz, aber auch eine riesige Herausforderung. Die große Frage: Wie macht man aus all diesen verstreuten, unstrukturierten Webdaten wirklich brauchbare Infos? Genau hier kommt Data Scraping ins Spiel – und deshalb ist es heute für Startups genauso unverzichtbar wie für große Player.

Schauen wir uns an, was Data Scraping eigentlich ist, warum es so wichtig ist, wie es in verschiedenen Branchen genutzt wird und wie moderne KI-Tools wie den Zugang zu Webdaten für alle viel einfacher machen.

Was ist Data Scraping? Definition und Hintergrund

Im Kern bedeutet Data Scraping (oft auch Web-Scraping genannt), dass Infos automatisiert von Webseiten oder digitalen Quellen gezogen und in ein strukturiertes Format gebracht werden – zum Beispiel in Tabellen, Datenbanken oder Dashboards. Stell dir vor, du betreibst einen Online-Shop und willst die Preise deiner Konkurrenz im Blick behalten. Anstatt jede Produktseite einzeln zu checken (und dabei den Verstand zu verlieren), übernimmt ein Web-Scraper das für dich: Er besucht die Seiten, sammelt Preise, Produktnamen und Bewertungen und sortiert alles schön übersichtlich.

Kurz gesagt: Data Scraping automatisiert das lästige Kopieren von Webinhalten und macht aus unstrukturierten Daten verwertbare Infos. Es ist, als hättest du ein digitales Praktikanten-Team, das nie schläft, keine Tippfehler macht und sich nie über monotone Aufgaben beschwert ().

Warum ist Data Scraping gerade jetzt so wichtig?

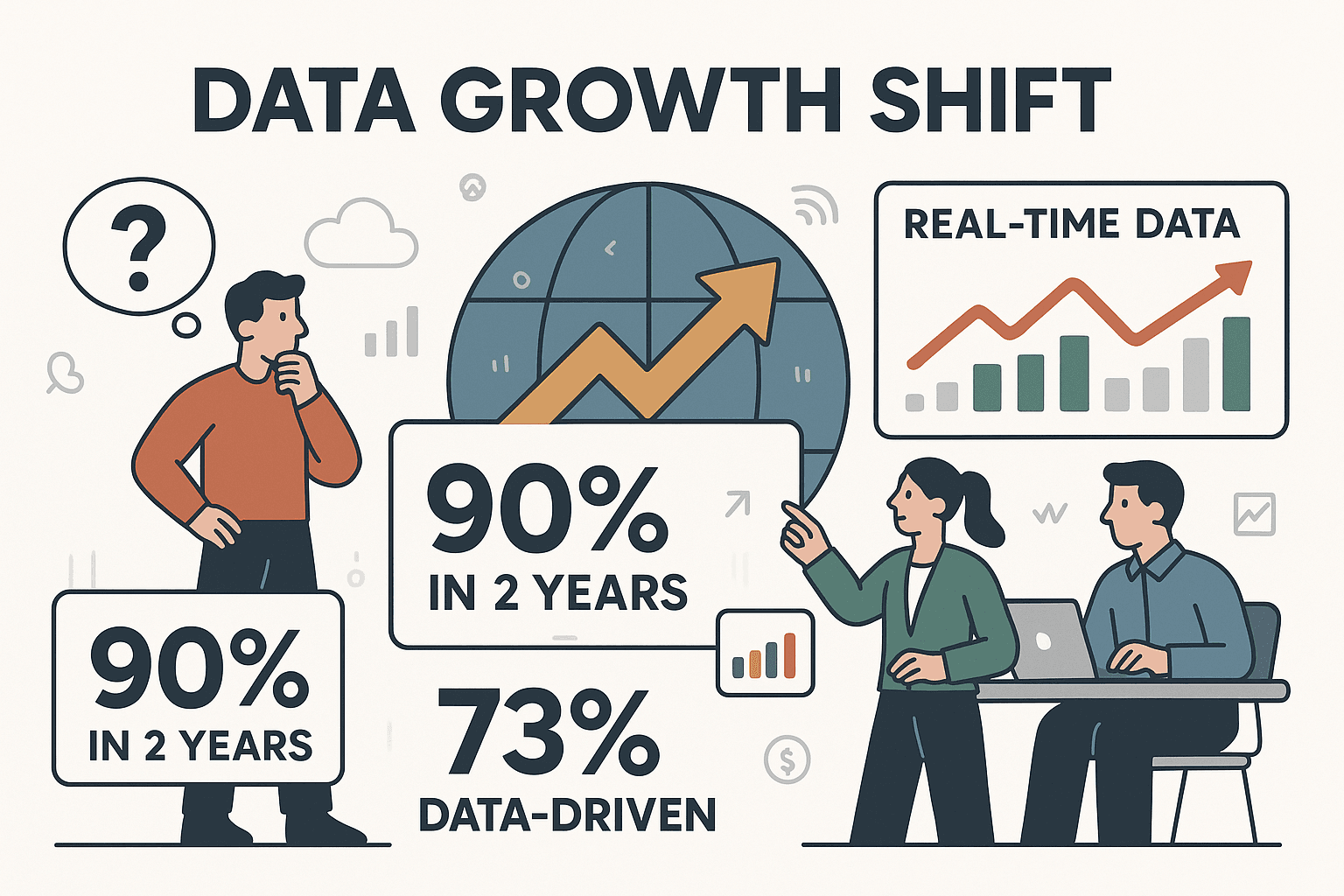

Das digitale Universum wächst rasant. Tatsächlich wurden . Unternehmen verlassen sich heute nicht mehr aufs Bauchgefühl, sondern auf Echtzeitdaten. Über treffen ihre Entscheidungen konsequent datenbasiert.

Das Problem: Die meisten wertvollen Infos liegen nicht im eigenen System, sondern draußen im Web – auf Konkurrenzseiten, in News, Social Media, Produktlisten und vielem mehr. Data Scraping baut die Brücke zwischen externen Webdaten und deinem Unternehmen und verschafft dir den entscheidenden Wissensvorsprung.

Web Scraping vs. Web Crawling: Wo liegt der Unterschied?

Die Begriffe werden oft durcheinandergebracht. Web Crawling heißt, dass ein Bot das Internet durchforstet und Webseiten kartiert (wie die Suchroboter von Google). Web-Scraping dagegen holt sich gezielt bestimmte Daten von diesen Seiten – zum Beispiel Preise, E-Mails oder Produktspezifikationen (). In der Praxis: Crawler finden die Seiten, Scraper holen die gewünschten Daten.

Praxisbeispiele: Data Scraping in verschiedenen Branchen

Data Scraping ist längst nicht mehr nur ein Thema für IT-Nerds oder Datenwissenschaftler. Es ist zum Geheimtipp für Teams in Vertrieb, E-Commerce, Marketing, Immobilien, Finanzen und vielen anderen Bereichen geworden. Hier ein Überblick, wie verschiedene Branchen Data Scraping nutzen:

| Branche | Typische Anwendung | Geschäftlicher Nutzen |

|---|---|---|

| E-Commerce | Preisüberwachung, Wettbewerbsanalyse | Dynamische Preisgestaltung, höhere Margen, schnelle Reaktion auf Marktveränderungen |

| Vertrieb & Lead-Gen | Lead-Listen aus Verzeichnissen, sozialen Netzwerken | Zielgerichtete Ansprache, gefüllte Vertriebspipelines, 5+ Stunden/Woche Zeitersparnis bei Recherche |

| Marketing | Bewertungen, Social Media, Foren für Stimmungsanalysen | Datenbasierte Kampagnenoptimierung, schnelle Reaktion auf Trends oder PR-Krisen |

| Immobilien | Immobilienangebote von verschiedenen Portalen aggregieren | Schnellere Marktanalyse, gebündeltes Inventar, bessere Investitionsentscheidungen |

| Finanzen & Investment | Aktienkurse, Finanznachrichten, Wirtschaftsdaten scrapen | Aktuelle Einblicke, fundierte Handelsentscheidungen, Wettbewerbsvorteil |

| Betrieb | Automatisierte Lieferanten-/Compliance-Datenerfassung | Automatisierte Berichte, weniger Fehler, Entlastung von Routineaufgaben |

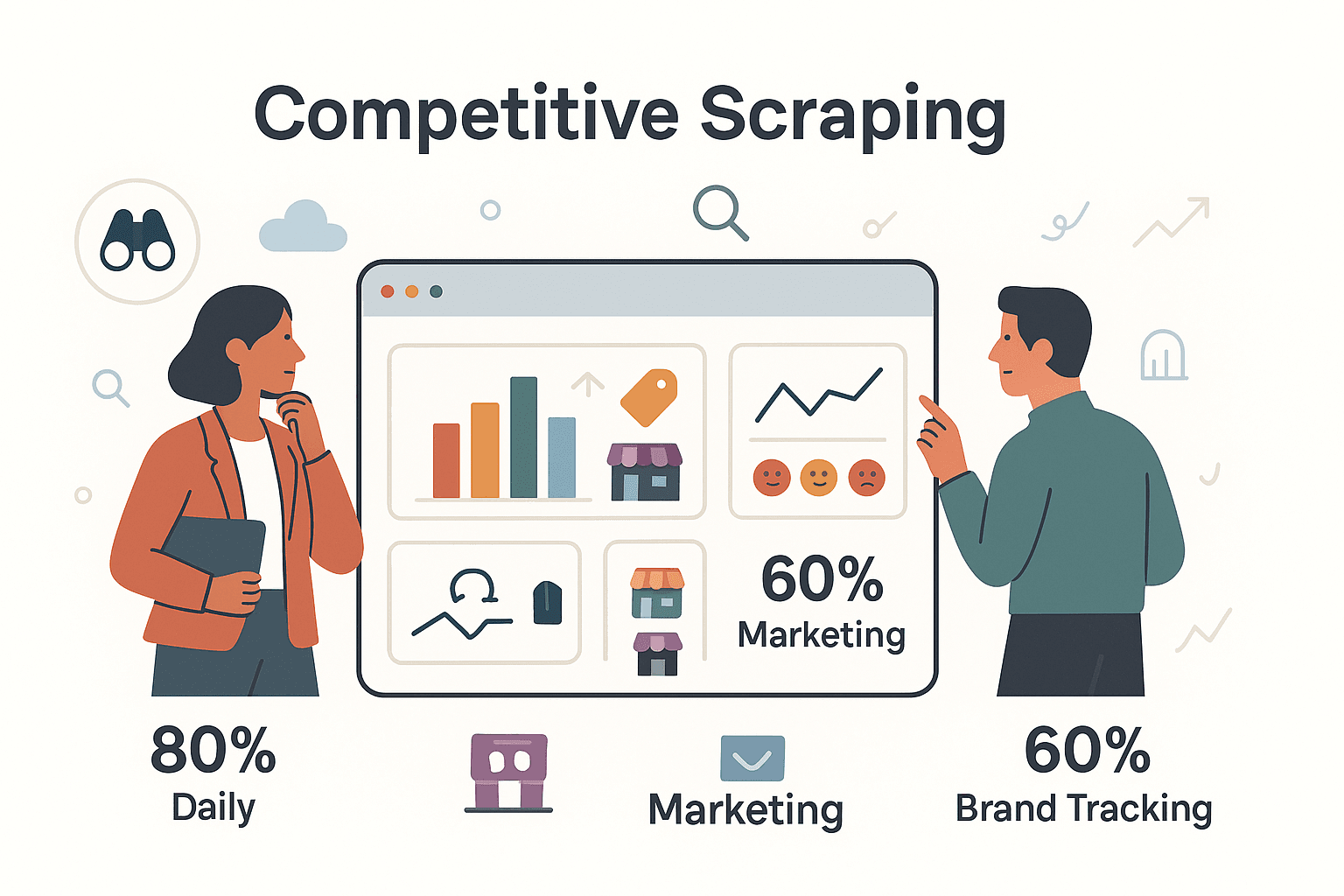

Und das sind keine Einzelfälle: Über scrapen täglich Wettbewerbsdaten, und rund nutzen Scraping, um Markenstimmung und Kampagnen der Konkurrenz zu verfolgen. Auch Hedgefonds und Immobilienfirmen setzen Scraping ein, um Marktveränderungen frühzeitig zu erkennen.

Überblick: Gängige Methoden und Tools für Data Scraping

Wie kommt man nun an die Webdaten? Es gibt verschiedene Wege – von klassisch bis hochmodern.

Klassische Methoden des Data Scraping

1. Manuelles Copy-Paste

Die Urform (und wohl schmerzhafteste): Webseite öffnen, Infos kopieren und in eine Tabelle einfügen. Für ein paar Seiten okay, bei größeren Mengen ein Garant für Überlastung und Koffein-Overload.

2. Eigene Skripte programmieren

Wer Python oder JavaScript kann, kann mit Tools wie BeautifulSoup oder Scrapy eigene Scraper schreiben. Das ist flexibel, aber wartungsintensiv – schon kleine Änderungen auf der Website können das Skript lahmlegen.

3. No-Code Web-Scraper Tools

Tools wie ParseHub, Octoparse oder die Web Scraper Chrome Extension machen es möglich, Daten visuell auszuwählen. Für Nicht-Programmierer ein echter Fortschritt, aber man muss trotzdem „Rezepte“ oder „Sitemaps“ bauen – und bei komplexen Seiten stoßen sie oft an ihre Grenzen.

4. Browser-Automatisierung

Frameworks wie Selenium oder Playwright simulieren echte Nutzer im Browser und können so auch Seiten mit viel JavaScript oder Klick-Navigation scrapen. Sehr mächtig, aber man braucht Programmierkenntnisse und Geduld.

5. OCR und Screen Scraping

Sind Daten in Bildern oder PDFs „gefangen“, hilft OCR (Optische Zeichenerkennung). Nicht immer perfekt, aber besser als stundenlanges Abtippen.

Das große Problem bei all diesen Methoden? Sie brauchen technisches Know-how, viel Einrichtung und ständige Wartung. Wer schon mal mehr Zeit mit dem Reparieren eines Scrapers als mit der Datennutzung verbracht hat, kennt das Dilemma.

KI-gestützte Data Scraping Tools

Jetzt wird’s spannend – und Tools wie machen Scraping für alle möglich, nicht nur für Entwickler.

Wie funktioniert KI-basiertes Scraping?

- Automatische Felderkennung: Die KI „liest“ die Seite und schlägt vor, welche Daten extrahiert werden können – kein mühsames Klicken oder Selektoren schreiben mehr.

- Einfache Sprachbefehle: Einfach beschreiben, was du brauchst („Alle Produktnamen und Preise erfassen“), und die KI erledigt den Rest.

- Anpassungsfähigkeit: Ändert sich die Website, findet die KI die Daten oft trotzdem – dank Kontextverständnis, nicht nur Code.

- Dynamische Inhalte: KI-Scraper können „Mehr laden“-Buttons klicken, scrollen und sich sogar einloggen, falls nötig.

- Direkte Datenaufbereitung: Übersetzen, kategorisieren oder zusammenfassen während des Scrapings? Die KI macht’s möglich.

- No-Code, benutzerfreundlich: Die meisten KI-Scraper sind für Business-Anwender gemacht – mit klaren Oberflächen und minimalem Aufwand.

Unternehmen, die auf KI-gestütztes Scraping setzen, erreichen eine Datenqualität von bis zu – selbst bei komplexen oder unübersichtlichen Webseiten.

Rechtliche und ethische Aspekte beim Data Scraping

Bevor du jetzt jede Website scrapest, solltest du die Spielregeln kennen. Data Scraping ist mächtig, bringt aber auch rechtliche und ethische Pflichten mit sich.

Wichtige rechtliche Risiken

- Nutzungsbedingungen von Websites: Viele Seiten verbieten Scraping in ihren AGB. Verstöße können zu Sperrungen oder – in seltenen Fällen – zu Klagen führen ().

- Datenschutzgesetze: Vorschriften wie DSGVO oder CCPA schützen personenbezogene Daten. Das Scrapen von Namen, E-Mails oder anderen persönlichen Infos ohne Einwilligung ist riskant ().

- Urheberrecht: Fakten (wie Preise) sind meist erlaubt, aber das Kopieren großer Text- oder Bildmengen kann Urheberrechte verletzen.

- Anti-Scraping-Maßnahmen: Das Umgehen von Logins, CAPTCHAs oder technischen Barrieren kann rechtliche Grenzen überschreiten (siehe CFAA in den USA).

Best Practices für rechtssicheres Scraping

- Nur öffentliche, nicht-personenbezogene Daten scrapen: Bleib bei offen zugänglichen und nicht sensiblen Infos.

- robots.txt respektieren: Wenn eine Seite in der robots.txt das Scraping untersagt, halte dich daran.

- Offizielle APIs nutzen: APIs sind der sicherste und sauberste Weg, an Daten zu kommen.

- Server nicht überlasten: Anfragen drosseln und keine Massenabfragen starten.

- Transparenz und Ethik: Nur notwendige Daten sammeln und diese nicht missbräuchlich verwenden.

Im Zweifel immer juristischen Rat einholen oder auf Nummer sicher gehen. Nur weil Daten öffentlich sind, heißt das nicht, dass sie beliebig genutzt werden dürfen.

Wie Thunderbit Data Scraping effizienter und präziser macht

Kommen wir zu – dem Tool, das mein Team und ich entwickelt haben, um Data Scraping für alle einfacher, schlauer und zugänglicher zu machen.

Automatisierung und intelligente Erkennung mit Thunderbit

- Scraping mit 2 Klicks: Seite öffnen, „KI-Felder vorschlagen“ anklicken – Thunderbit erkennt sofort, was extrahiert werden kann. Ein Klick auf „Scrapen“ – fertig. Kein Code, keine Vorlagen, kein Stress ().

- KI-Felderkennung: Thunderbit „liest“ die Seite wie ein Mensch und findet die gewünschten Daten auch bei Layout-Änderungen.

- Sprachsteuerung: Einfach in natürlicher Sprache beschreiben, was du brauchst – Thunderbit richtet das Scraping automatisch ein.

- Subpage-Scraping: Du brauchst Details von verlinkten Unterseiten (z. B. Produktdetails oder Profile)? Thunderbit besucht diese automatisch und ergänzt deine Tabelle ().

- Paginierung und Endlos-Scroll: Thunderbit erkennt „Weiter“-Buttons und unendliches Scrollen, damit dir keine Daten entgehen.

- Direkte Datenumwandlung: Mit individuellen Prompts kannst du Daten direkt beim Scraping zusammenfassen, kategorisieren oder übersetzen – ohne Zusatzaufwand.

- Sofort-Vorlagen: Für beliebte Seiten wie Amazon, Zillow oder LinkedIn gibt’s fertige Vorlagen für das Scraping mit nur einem Klick ().

- Vielfältige Exportoptionen: Exportiere deine Daten nach Excel, CSV, Google Sheets, Airtable, Notion oder als JSON – kostenlos und unbegrenzt.

- Cloud-Scraping und Zeitplanung: Bis zu 50 Seiten gleichzeitig in der Cloud scrapen oder wiederkehrende Scrapes per Sprachbefehl planen.

Praxisbeispiel: Wettbewerberpreise scrapen

Angenommen, du bist im E-Commerce und willst Preise von 100 Konkurrenz-Produkten überwachen. Mit Thunderbit:

- Öffne die Produktübersichtsseite des Wettbewerbers.

- Klick auf „KI-Felder vorschlagen“. Thunderbit schlägt Spalten wie Produktname, Preis und Verfügbarkeit vor.

- Klick auf „Scrapen“. Thunderbit sammelt alle Daten von allen Produkten auf der Seite.

- Mehr Details nötig? Mit „Subpages scrapen“ holst du dir Spezifikationen oder Verkäuferinfos von den Detailseiten.

- Exportiere nach Excel oder Google Sheets – und schon kannst du deine Preise analysieren oder anpassen.

Was früher Stunden (oder einen Entwickler) gebraucht hat, dauert jetzt nur noch Minuten – ganz ohne Programmierkenntnisse.

Thunderbits Stärken bei komplexen Webseiten

Thunderbit ist nicht nur für einfache Seiten gemacht. Gerade bei kniffligen Fällen spielt es seine Stärken aus:

- Dynamische, JavaScript-lastige Seiten: Thunderbit lädt Seiten wie ein echter Browser und kann so auch Inhalte erfassen, die erst nach Klicks oder Scrollen erscheinen.

- Paginierung und mehrstufige Navigation: Thunderbit erkennt und folgt „Weiter“-Buttons oder Endlos-Scroll und scrapt hunderte oder tausende Einträge ohne manuelle Einrichtung.

- Anti-Bot-Umgehung: Als Chrome-Erweiterung verhält sich Thunderbit wie ein echter Nutzer und wird seltener blockiert.

- Gemischte Datentypen: Thunderbit kann Bilder, PDFs und sogar OCR für gescannte Dokumente in einem Workflow extrahieren.

- Browser- vs. Cloud-Modus: Browsermodus für Seiten mit Login, Cloudmodus für Geschwindigkeit und Skalierung.

- Mehrsprachigkeit: Thunderbit unterstützt 34 Sprachen und kann gescrapte Daten direkt übersetzen.

Kurz: Thunderbit bringt die Power professioneller Scraping-Lösungen in die Hände aller, die einen Browser und Bedarf an Webdaten haben.

Zukunftstrends im Data Scraping

Data Scraping entwickelt sich rasant weiter – das erwartet uns in den nächsten Jahren:

- Intelligentere KI-Agenten: Scraper werden Webseiten noch besser verstehen, sich an Änderungen anpassen und Daten direkt analysieren oder zusammenfassen.

- Sprach- und Sprachsteuerung: Bald kannst du deinem Scraper einfach sagen: „Finde alle neuen Stellenanzeigen für Softwareentwickler in Berlin“ – und bekommst die Ergebnisse in Minuten.

- Tiefere Integration mit Analytics: Gescrapte Daten fließen direkt in Dashboards, BI-Tools oder lösen automatisierte Workflows aus.

- Cloud- und Edge-Skalierung: Scraping wird schneller und robuster, mit Cloud-Plattformen, die tausende Scrapes parallel ausführen.

- Stealth-Techniken: Da Websites Scraper immer besser erkennen, werden Scraper noch menschlicheres Verhalten simulieren.

- Eingebaute Compliance: Scraper werden Funktionen bieten, die rechtliche Risiken minimieren – etwa das automatische Auslassen personenbezogener Daten oder das Respektieren von robots.txt.

- Demokratisierung: Scraping ist nicht mehr nur für große Tech-Unternehmen. Mit Tools wie Thunderbit können auch kleine Firmen, Forscher und Einzelunternehmer auf dieselben Daten zugreifen wie die Großen.

Bis 2025 werden Webdaten-Extraktion in ihre Analytics-Stacks integriert haben. Die Zukunft ist datengetrieben – und Scraping ist der Motor dafür.

Fazit: Wie Data Scraping datengetriebene Unternehmen stärkt

Kurz gesagt: Data Scraping ist der Schlüssel, um die verborgenen Schätze des Webs zu heben. So machen Unternehmen aus dem Chaos der Online-Infos strukturierte, nutzbare Erkenntnisse. Ob Preisüberwachung, Lead-Generierung, Marktanalyse oder einfach, um der Konkurrenz einen Schritt voraus zu sein – Scraping ermöglicht schnellere und klügere Entscheidungen.

Die Zeiten von Copy-Paste oder fehleranfälligen Skripten sind vorbei. Mit KI-Tools wie kann jeder Daten scrapen – ohne Programmierung, ohne Stress, mit sofortigen Ergebnissen. Und je schlauer, ethischer und besser integriert Data Scraping wird, desto mehr profitieren Unternehmen jeder Größe.

Neugierig, was Data Scraping für dein Business leisten kann? und mach das Web zu deiner persönlichen Datenquelle. Mehr Tipps und Praxisbeispiele findest du im .

FAQs

1. Was ist Data Scraping und wie unterscheidet es sich von Web Crawling?

Data Scraping ist die automatisierte Extraktion gezielter Infos von Webseiten oder digitalen Quellen in ein strukturiertes Format (z. B. eine Tabelle). Web Crawling dient der Erfassung und Indexierung von Webseiten, während Scraping die gewünschten Daten aus diesen Seiten herauszieht ().

2. Ist Data Scraping legal?

Das Scrapen öffentlicher, nicht-sensibler Daten ist in der Regel erlaubt, aber du musst die Nutzungsbedingungen der Website, Datenschutzgesetze (wie DSGVO/CCPA) und Urheberrechte beachten. Verzichte auf das Scrapen personenbezogener Daten ohne Einwilligung und nutze offizielle APIs, wenn möglich ().

3. Welche Vorteile bietet Data Scraping für Unternehmen?

Data Scraping ermöglicht Echtzeit-Preisüberwachung, Wettbewerbsanalysen, Lead-Generierung, Marktforschung und mehr. Es automatisiert manuelle Recherche, spart Zeit und unterstützt datenbasierte Entscheidungen in Vertrieb, Marketing, Betrieb und anderen Bereichen.

4. Wie erleichtert Thunderbit Data Scraping für Nicht-Techniker?

Thunderbit nutzt KI, um Datenfelder automatisch zu erkennen, Unterseiten und Paginierung zu verarbeiten und Daten direkt beim Scraping zu transformieren. Dank 2-Klick-Workflow und Sprachbefehlen kann jeder Webdaten extrahieren – ganz ohne Programmierung oder Vorlagen ().

5. Welche Trends prägen die Zukunft des Data Scraping?

Erwarte intelligentere KI-Agenten, Sprachsteuerung, tiefere Analytics-Integration, Cloud-Skalierung, eingebaute Compliance und breitere Zugänglichkeit. Bis 2025 wird Data Scraping ein Standard-Tool für Unternehmen jeder Größe sein ().

Du willst mehr wissen oder direkt loslegen? und erlebe, wie einfach Data Scraping sein kann. Viel Erfolg beim Scrapen – und mögen deine Tabellen immer voll und deine Copy-Paste-Tage gezählt sein.