Das Internet wächst so rasant, dass man kaum noch hinterherkommt. Jeden Tag tauchen Milliarden neuer Seiten, Produkte, Bewertungen und Datensätze auf – sie sind der Treibstoff für alles, von Marktforschung über KI-Training bis hin zu deinem nächsten Amazon-Einkauf. Aus meiner Zeit im SaaS- und Automatisierungsbereich weiß ich: Wer die richtigen Daten hat, hat die Nase vorn. Aber: Das Sammeln, Aktualisieren und Auswerten dieser Webdaten wird immer komplizierter. Herkömmliche Web-Scraper stoßen schnell an ihre Grenzen, während Unternehmen nach schlaueren und schnelleren Wegen suchen, um aus dem Netz wirklich brauchbare Erkenntnisse zu ziehen. Genau hier kommt der Cloud Crawler ins Spiel – ein Tool, das die Art und Weise, wie Unternehmen Webdaten finden und nutzen, komplett auf den Kopf stellt.

Aber was ist eigentlich ein Cloud Crawler? Wie unterscheidet er sich von den Web-Scrapern, die du vielleicht schon ausprobiert hast? Und warum setzen Teams aus Vertrieb, Operations und anderen Bereichen auf diese Technologie, um im datengetriebenen Wettbewerb vorne zu bleiben? Lass uns die Begriffe entwirren und schauen, wie Cloud Crawler – vor allem die Lösung von Thunderbit – das Spielfeld für moderne Unternehmen neu gestalten.

Was ist ein Cloud Crawler? Die nächste Generation der Datenerfassung

Kurz gesagt: Ein Cloud Crawler ist viel mehr als ein Web-Scraper, der einfach nur in der Cloud läuft. Es handelt sich um eine smarte Datenmaschine – ein cloudbasiertes System, das automatisch riesige Datenmengen aus dem gesamten Internet aufspürt, extrahiert und analysiert. Während ein klassischer Web-Scraper meist nur Seite für Seite abklappert und oft auf einem einzelnen Gerät läuft, spielt ein Cloud Crawler in einer ganz anderen Liga. Er läuft in leistungsstarken Rechenzentren, kann Tausende oder sogar Millionen von Seiten gleichzeitig durchforsten und verarbeitet dabei alles – von Texten über Bilder bis hin zu PDFs, egal wie komplex oder umfangreich die Zielseite ist.

Stell dir vor: Ein Web-Scraper ist wie ein einzelner Bibliothekar, der Passagen aus einem Buch abschreibt. Ein Cloud Crawler dagegen ist ein ganzes Team aus Supercomputern, das gleichzeitig alle Bücher der Bibliothek scannt, markiert, sortiert und analysiert. Das Ergebnis? Unternehmen bekommen umfassendere, aktuellere und besser nutzbare Daten – ganz ohne die Engpässe von lokaler Hardware oder manueller Arbeit (, ).

Cloud Crawler vs. klassischer Web-Scraper: Wo liegen die Unterschiede?

Wer schon mal einen Web-Scraper genutzt hat, kennt das Prinzip: Zielseite eingeben, gewünschte Datenfelder auswählen, und los geht’s. Doch je größer und komplexer das Web wird, desto deutlicher werden die Schwächen der alten Methode. Hier ein Vergleich zwischen Cloud Crawlern und klassischen Web-Scrapern:

| Funktion/Aspekt | Klassischer Web-Scraper | Cloud Crawler |

|---|---|---|

| Bereitstellung | Läuft lokal auf deinem Gerät/Server | Läuft in der Cloud (Rechenzentren) |

| Skalierung | Begrenzung durch Hardware | Massiv parallel – Tausende Seiten gleichzeitig |

| Geschwindigkeit | Langsam, besonders bei großen Aufgaben | Hochgeschwindigkeits-Batch-Verarbeitung |

| Wartung | Häufige Updates nötig, bricht bei Website-Änderungen | Cloudbasiert, automatische Updates, robust |

| Datentypen | Meist Text, manchmal Bilder | Text, Bilder, PDFs, komplexe Layouts |

| Zugriff | An Gerät/Netzwerk gebunden | Von überall und jedem Gerät zugänglich |

| Zeitplanung | Manuell oder einfache Automatisierung | Fortgeschrittene Planung, wiederkehrende Jobs |

| Optimal für | Kleine Projekte, einfache Seiten | Große, häufige oder komplexe Datenanforderungen |

Cloud Crawler sind für das moderne Web gemacht – dort, wo Daten überall sind und Geschwindigkeit sowie Skalierbarkeit entscheidend sind (, ).

Wie Cloud Crawler die Datenerfassung auf ein neues Level bringen

Jetzt wird’s spannend: Cloud Crawler nutzen die Power der Cloud, um Tausende Webseiten gleichzeitig zu verarbeiten. So kannst du zum Beispiel komplette Produktkataloge aus Onlineshops extrahieren, Preise bei Wettbewerbern auf zig Seiten überwachen oder Immobilienangebote aus allen Portalen bündeln – und das in einem Bruchteil der Zeit, die ein klassischer Scraper brauchen würde.

Warum ist das so wichtig? In Bereichen wie E-Commerce, Finanzen oder Immobilien zählt Aktualität. Preise, Verfügbarkeiten und Trends ändern sich oft im Minutentakt. Stunden- oder tagelanges Warten auf einen lokalen Scraper ist da keine Option. Cloud Crawler sind nicht durch den Arbeitsspeicher deines Laptops oder die Büro-WLAN-Geschwindigkeit limitiert – sie skalieren flexibel, sodass auch riesige Datenmengen problemlos verarbeitet werden können (, ).

Besonders profitieren diese Branchen:

- E-Commerce: Preisüberwachung, Produktkataloge bündeln, Review-Analysen

- Immobilien: Angebotsaggregation, Markttrends, Objektvergleiche

- Finanzen: News- und Sentiment-Analysen, Monitoring von Aktien/Kryptos, regulatorische Updates

- Vertrieb & Marketing: Lead-Generierung, Wettbewerbsanalysen, Trendbeobachtung

Und das ist erst der Anfang. Wer Webdaten in großem Stil braucht, kommt an einem Cloud Crawler nicht vorbei.

Thunderbits Cloud Crawler: Schnell, flexibel und leistungsstark

Jetzt mal aus Thunderbit-Sicht: s Cloud-Scraping-Modus ist unsere Antwort auf die modernen Datenanforderungen – ein Cloud Crawler, der speziell für Business-Anwender entwickelt wurde, die Ergebnisse statt Probleme wollen.

Das macht Thunderbits Cloud Crawler besonders:

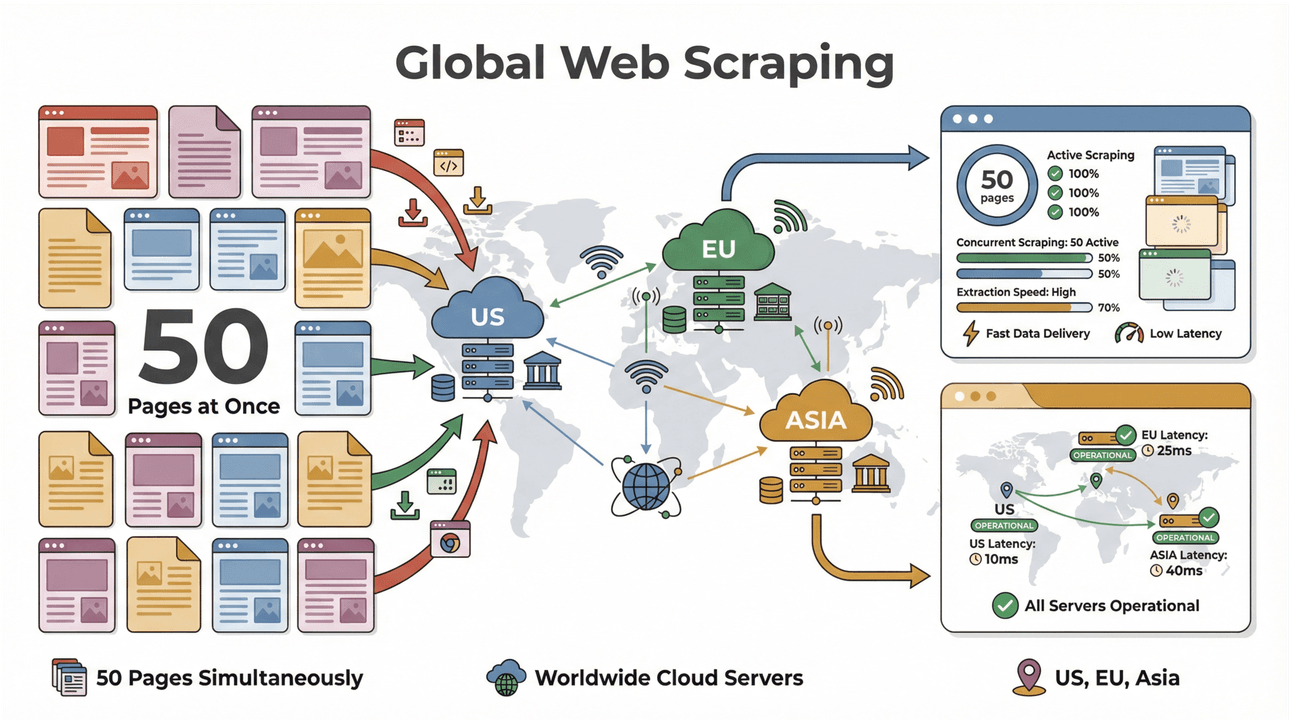

- High-Speed-Batch-Scraping: Bis zu 50 Seiten gleichzeitig extrahieren, mit Cloud-Servern in den USA, Europa und Asien für weltweite Reichweite. Schluss mit Warten auf den eigenen Laptop.

- Komplexe Seiten meistern: Thunderbits KI kommt mit dynamischen Shops, schwierigen PDFs und sogar Bilderkennung klar. Was im Web steht, kann Thunderbit meist auch extrahieren ().

- Unterseiten crawlen: Du willst Daten aus Unterseiten (z. B. Produktspezifikationen oder Autorenprofile) anreichern? Thunderbits KI besucht jede Unterseite und fügt die Infos automatisch zum Hauptdatensatz hinzu ().

- Intelligente Datenstrukturierung: Mit „KI-Feldvorschlag“ liest Thunderbit die Seite aus und schlägt passende Spalten vor – ganz ohne Programmierung oder Vorlagenbau.

- Export überallhin: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion. Oder lade die Daten als CSV/JSON herunter – ganz wie es in deinen Workflow passt ().

- Keine Wartung nötig: Thunderbits KI passt sich automatisch an Website-Änderungen an – du musst keine kaputten Scraper mehr reparieren ().

Das Beste: Du kannst alles mit einer ausprobieren – probier’s einfach aus.

Cloud Crawler-Einsatz: Cloud oder lokal – was passt zu dir?

Einer der größten Vorteile von Cloud Crawlern ist die flexible Nutzung. Mit einem klassischen (lokalen) Crawler bist du an ein bestimmtes Gerät, Netzwerk und oft an aufwendige Einrichtung gebunden. Geht dein Rechner in den Ruhezustand oder bricht die Internetverbindung ab, stoppt auch der Scrape. Skalierung bedeutet meist: mehr Hardware kaufen oder mehrere Skripte parallel laufen lassen.

Cloud Crawler drehen das Prinzip um:

- Keine Spezialhardware nötig: Die ganze Rechenleistung kommt aus der Cloud. Du kannst große Scrapes von jedem Gerät aus starten – egal ob Chromebook, Mac oder Smartphone.

- Zugriff von überall: Unterwegs oder im Homeoffice? Kein Problem – dein Cloud Crawler ist immer verfügbar.

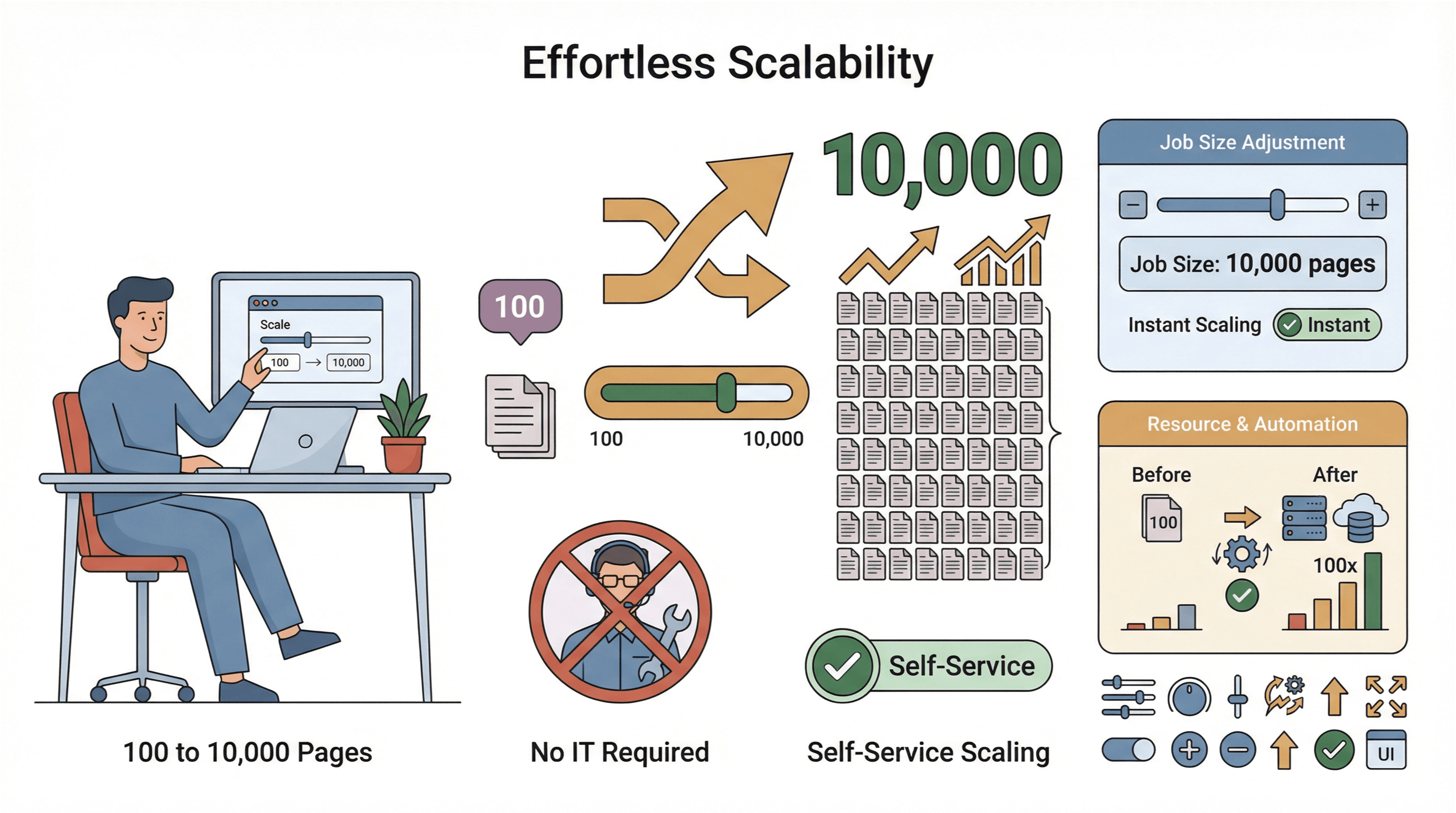

- Einfache Skalierung: Du willst statt 100 gleich 10.000 Seiten extrahieren? Einfach Jobgröße anpassen – ganz ohne IT-Support.

- Globale Datenerfassung: Dank Cloud-Servern in verschiedenen Regionen kannst du auch auf länderspezifische Inhalte zugreifen und Compliance einfacher steuern ().

Natürlich sind Sicherheit und Datenschutz immer wichtig. Die besten Cloud Crawler (Thunderbit inklusive) setzen auf verschlüsselte Verbindungen, halten sich an Website-Richtlinien und bieten Funktionen, um sensible Daten verantwortungsvoll zu verarbeiten.

Praxisbeispiele: Wie Cloud Crawler datengetriebene Strategien verändern

Schauen wir uns die Praxis an: Warum steigen Unternehmen auf Cloud Crawler um? Weil sie echte, messbare Vorteile sehen:

- Marktanalyse in Echtzeit: Händler überwachen mit Cloud Crawlern Preise und Lagerbestände der Konkurrenz live und können so schneller auf Marktveränderungen reagieren ().

- Konsumententrends erkennen: Marken analysieren Bewertungen, Social-Media-Posts und Foren, um neue Trends frühzeitig zu erkennen und Kampagnen flexibel anzupassen.

- Vertrieb & Lead-Generierung: Vertriebsteams bauen aktuelle Lead-Listen aus Verzeichnissen, Eventseiten oder sogar PDFs auf – und füttern ihr CRM mit frischen Kontakten ().

- Betrieb & Compliance: Finanzdienstleister überwachen regulatorische Änderungen, Nachrichten und Meldungen in verschiedenen Ländern – und minimieren so Risiken.

Das verbindende Element: Cloud Crawler ermöglichen es Teams, schneller zu agieren, fundiertere Entscheidungen zu treffen und der Konkurrenz einen Schritt voraus zu sein.

Worauf kommt es bei einem Cloud Crawler an?

Nicht jeder Cloud Crawler ist gleich. Wer Optionen vergleicht, sollte auf folgende Merkmale achten (und hier punktet Thunderbit besonders):

- Skalierbarkeit: Kann das Tool Tausende Seiten gleichzeitig verarbeiten? Bleibt es auch bei großen Jobs schnell?

- Benutzerfreundlichkeit: Ist die Oberfläche auch für Nicht-Techniker verständlich? Lässt sich ein Scrape mit wenigen Klicks einrichten?

- Multi-Daten-Support: Text, Bilder, PDFs, Unterseiten – werden alle Formate unterstützt?

- Integration: Gibt es Exportmöglichkeiten zu Excel, Sheets, Notion, Airtable?

- Zeitplanung: Lassen sich wiederkehrende Jobs für stets aktuelle Daten einrichten?

- KI-Unterstützung: Gibt es smarte Feldvorschläge, Datenanreicherung und automatische Anpassung an Website-Änderungen?

- Sicherheit & Compliance: Sind Daten und Zugangsdaten geschützt? Unterstützt das Tool bei der Einhaltung von Datenschutzvorgaben?

Thunderbit erfüllt all diese Anforderungen und ist damit eine Top-Wahl für Teams, die Leistung ohne Komplexität suchen.

Einstieg: So nutzt du einen Cloud Crawler für dein Unternehmen

Bereit loszulegen? So einfach startest du mit einem Cloud Crawler wie Thunderbit:

- : Schnelle Einrichtung, keine IT nötig.

- Ziel auswählen: Öffne die Website, Liste oder das Dokument, das du extrahieren möchtest.

- „KI-Feldvorschlag“ klicken: Thunderbits KI scannt die Seite und schlägt passende Spalten vor.

- Anpassen nach Bedarf: Felder hinzufügen, entfernen oder umbenennen – ganz nach Wunsch.

- Cloud-Scraping-Modus wählen: Für große oder komplexe Aufgaben auf Cloud-Modus umschalten.

- Scrape starten: Thunderbit verarbeitet bis zu 50 Seiten gleichzeitig in der Cloud.

- Ergebnisse prüfen & exportieren: Vorschau ansehen, dann nach Excel, Google Sheets, Notion oder Airtable exportieren.

- Wiederkehrende Jobs planen: Für regelmäßige Aufgaben einfach Scrapes terminieren – die Daten werden automatisch aktualisiert ().

Tipp: Starte mit einem kleinen Job, um dich mit dem Tool vertraut zu machen, und steigere dann das Volumen. Und nutze ruhig den Support oder die Dokumentation von Thunderbit – sie helfen gerne weiter.

Die Zukunft der Datenerfassung: Wohin geht die Reise mit Cloud Crawlern?

Die Cloud Crawler-Revolution steht erst am Anfang. Das sind die Trends, die ich in den nächsten Jahren sehe:

- Intelligentere KI-Extraktion: Cloud Crawler werden immer besser darin, Zusammenhänge, Kontext und sogar Stimmungen zu erkennen – und liefern dadurch noch wertvollere Daten ().

- Unterstützung neuer Datentypen: Bessere Verarbeitung von Videos, Audios und interaktiven Inhalten – nicht nur statischer Text und Bilder.

- Mehr Automatisierung: Von automatischer Zeitplanung bis zu Echtzeit-Benachrichtigungen – Cloud Crawler werden für Anwender noch komfortabler.

- Stärkere Compliance: Mit dem Wandel der Datenschutzgesetze werden Cloud Crawler mehr Tools bieten, um Teams bei der Einhaltung zu unterstützen.

- Integration mit BI- und KI-Tools: Direkte Datenpipelines von Cloud Crawlern zu Analytics, Dashboards und Machine-Learning-Plattformen.

Kurz gesagt: Cloud Crawler werden zum Rückgrat digitaler Geschäftsstrategien – von Produkteinführungen bis hin zu KI-gestützter Prognose ().

Fazit: Warum Cloud Crawler für moderne Unternehmen ein Muss sind

Fassen wir zusammen: Das Web explodiert förmlich vor Daten, und die alten Methoden zur Datenerfassung kommen nicht mehr hinterher. Cloud Crawler sind der nächste Schritt – sie bieten Geschwindigkeit, Skalierbarkeit und Intelligenz, die klassische Scraper nicht erreichen. Tools wie machen es jedem Team – egal ob technisch versiert oder nicht – möglich, das volle Potenzial von Webdaten zu nutzen und so schneller, fundierter und wettbewerbsfähiger zu agieren.

Wer keine Lust mehr auf manuelles Scraping und langsame Daten hat, sollte jetzt ausprobieren, was ein Cloud Crawler für das eigene Unternehmen leisten kann. Teste Thunderbits Cloud-Scraping-Modus und erlebe, wie einfach und leistungsstark moderne Datenerfassung sein kann. Und wenn du tiefer einsteigen willst, findest du im weitere Anleitungen, Tipps und Praxisbeispiele.

FAQs

1. Was ist ein Cloud Crawler einfach erklärt?

Ein Cloud Crawler ist ein cloudbasiertes Tool, das automatisch große Datenmengen aus dem Web findet, extrahiert und analysiert. Im Gegensatz zu klassischen Scrapern, die lokal laufen, arbeitet ein Cloud Crawler in leistungsstarken Rechenzentren und ermöglicht so enorme Geschwindigkeit und Skalierung.

2. Wie unterscheidet sich ein Cloud Crawler von einem normalen Web-Scraper?

Cloud Crawler laufen in der Cloud, verarbeiten Tausende Seiten gleichzeitig, unterstützen komplexe Datentypen (wie Bilder und PDFs) und benötigen keine Wartung oder lokale Hardware. Klassische Scraper sind durch die Leistung deines Geräts begrenzt und eignen sich eher für kleinere, einfache Aufgaben.

3. Was sind die Hauptvorteile eines Cloud Crawlers?

Cloud Crawler bieten schnelle, großflächige Datenerfassung, Unterstützung für komplexe Websites, einfachen Zugriff von überall und fortschrittliche Funktionen wie Zeitplanung und KI-gestützte Extraktion. Sie sind ideal für Unternehmen, die aktuelle, verwertbare Daten benötigen.

4. Wie funktioniert Thunderbits Cloud Crawler für Business-Anwender?

Mit Thunderbits Cloud Crawler kannst du mit wenigen Klicks einen Scrape einrichten – ganz ohne Programmierung. Du extrahierst Daten aus Websites, PDFs und Bildern, reicherst sie mit KI an und exportierst sie direkt nach Excel, Google Sheets, Notion oder Airtable. Das Tool ist für Nicht-Techniker konzipiert, die Ergebnisse statt Komplexität wollen.

5. Ist Cloud Crawling sicher und datenschutzkonform?

Ja, führende Cloud Crawler wie Thunderbit setzen auf verschlüsselte Verbindungen und Best Practices für Datensicherheit. Achte immer darauf, nur öffentlich zugängliche Daten zu extrahieren und die Nutzungsbedingungen sowie Datenschutzvorgaben der jeweiligen Website einzuhalten.

Bereit, die Möglichkeiten eines Cloud Crawlers zu entdecken? und direkt mit großflächiger, cloudbasierter Datenerfassung starten.

Mehr erfahren