Das Internet gleicht einem riesigen, ständig wuchernden Dschungel. Täglich entstehen über , und allein der Google-Suchindex umfasst . Vielleicht hast du dich schon mal gefragt, wie Suchmaschinen da überhaupt noch den Überblick behalten – oder wie Unternehmen in diesem digitalen Heuhaufen die Nadel finden. Du bist damit nicht allein! Nach Jahren im SaaS- und Automatisierungsbereich werde ich immer wieder gefragt: „Was ist eigentlich der Unterschied zwischen Web Crawling und Web Scraping? Ist das nicht das Gleiche?“ Die kurze Antwort: Nein – und wer beides in einen Topf wirft, kommt schnell ins Schleudern.

Egal, ob du im Vertrieb nach neuen Leads suchst, als E-Commerce-Manager die Preise im Blick behalten willst oder einfach beim nächsten Meeting mit Fachwissen glänzen möchtest: Lass uns gemeinsam klären, was ein Web-Crawler wirklich macht, wie er sich von einem Scraper unterscheidet und warum das richtige Tool (wie Thunderbit) dir jede Menge Stress – und vielleicht sogar dein Wochenende – retten kann.

Web-Crawler-Grundlagen: Was ist ein Web-Crawler?

Stell dir den gewissenhaftesten Bibliothekar der Welt vor: Er sortiert nicht nur Bücher, sondern läuft täglich durch alle Regale, um nach neuen Titeln Ausschau zu halten. Genau das macht ein Web-Crawler – nur eben mit Milliarden von Webseiten. Ein Web-Crawler (auch Spider oder Bot genannt) ist ein automatisiertes Programm, das systematisch das Netz durchforstet, Links folgt und alles, was es findet, katalogisiert. So bauen Suchmaschinen wie Google und Bing ihre riesigen Indizes auf und machen das Web für uns alle durchsuchbar.

Begriffe wie „Googlebot“ oder „Bingbot“ hast du bestimmt schon mal gehört – das sind bekannte Web-Crawler, die im Hintergrund arbeiten. Es gibt aber auch modernere Tools wie , mit denen Entwickler und Unternehmen ganze Websites erfassen und als strukturierte Daten für KI oder Analysen aufbereiten können.

Wichtig: Crawling bedeutet Entdecken – also Seiten finden und indexieren, nicht gezielt Daten herausziehen. Dafür ist Web Scraping zuständig (dazu gleich mehr).

Wie funktioniert Web Crawling?

Schauen wir uns an, wie ein Web-Crawler arbeitet. Stell ihn dir als digitalen Entdecker mit einem Rucksack voller „Seed-URLs“ vor – das sind die Startpunkte. So läuft der Prozess ab:

- Seed-URLs: Der Crawler startet mit einer Liste bekannter Webadressen.

- Abrufen & Analysieren: Er besucht jede URL, lädt die Seite und sucht nach weiteren Links.

- Links folgen: Jeder neue Link kommt auf die To-do-Liste (die sogenannte URL-Frontier).

- Indexierung: Der Crawler speichert Infos zu jeder Seite – manchmal den kompletten Inhalt, manchmal nur Metadaten.

- Rücksichtnahme: Er prüft die robots.txt der Website, ob Crawling erlaubt ist, und macht Pausen, um Server nicht zu überlasten.

- Ständige Aktualisierung: Da sich das Web ständig verändert, besucht der Crawler Seiten regelmäßig erneut, um den Index aktuell zu halten.

Das ist, als würdest du eine Stadt kartieren, jede Straße ablaufen, neue Gassen und Läden notieren und deine Karte bei jeder Veränderung aktualisieren.

Wichtige Komponenten eines Web-Crawlers

Auch wenn du kein Technikprofi bist, lohnt sich ein Blick unter die Haube:

- URL-Frontier (Queue): Die zentrale Aufgabenliste mit allen noch zu besuchenden URLs.

- Fetcher/Downloader: Holt die jeweilige Webseite ab.

- Parser: „Liest“ die Seite, extrahiert Links und manchmal weitere Infos.

- Duplikatprüfung & URL-Filter: Verhindert Endlosschleifen und doppelte Besuche.

- Datenspeicher/Index: Hier werden alle gefundenen Inhalte für spätere Nutzung abgelegt.

Stell dir das wie ein Fließband vor: Einer holt die Zeitung, der nächste markiert die Schlagzeilen, ein anderer archiviert die Ausschnitte und jemand behält den Überblick, welche Zeitungen als nächstes dran sind.

Wie crawlt man eine Website? Tools und Methoden

Als Business-Anwender kommt vielleicht der Gedanke, einen eigenen Crawler zu bauen. Mein Tipp: Lass es lieber. Es gibt viele Tools, die dir die Arbeit abnehmen – es sei denn, du willst die nächste Suchmaschine entwickeln.

Beliebte Web-Crawling-Tools:

- : Open Source, für Entwickler, ideal für große Projekte.

- : Für Big Data Indexierung und Forschung.

- : Das Tool des Internet Archive für Web-Archivierung.

- : Besonders beliebt bei SEOs für Website-Analysen.

- : Modern, API-basiert, ermöglicht das Crawlen und Extrahieren strukturierter Daten von ganzen Websites.

Achtung: Die meisten dieser Tools erfordern technisches Know-how. Auch „No-Code“-Lösungen haben oft eine Lernkurve – etwa beim Auswählen von HTML-Elementen, bei Website-Änderungen oder dynamischen Inhalten. Wenn du nur ein paar Seiten auslesen willst, brauchst du meist keinen vollwertigen Crawler.

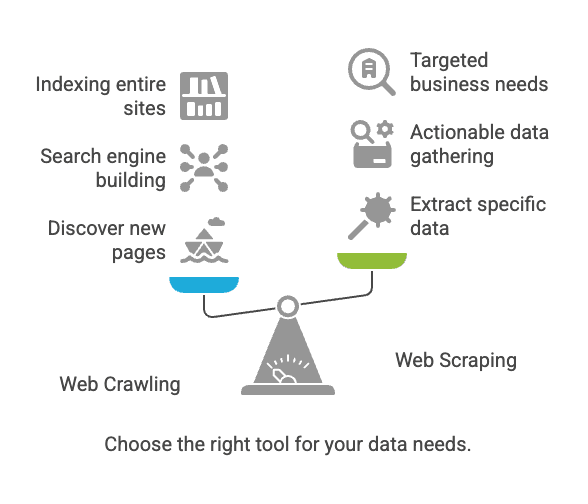

Web Crawling vs. Web Scraping: Wo liegt der Unterschied?

Hier beginnt oft die Verwirrung. Crawling und Scraping hängen zusammen, sind aber nicht dasselbe.

| Aspekt | Web Crawling | Web Scraping |

|---|---|---|

| Ziel | Webseiten entdecken und indexieren | Gezielt Daten aus Webseiten extrahieren |

| Vergleich | Bibliothekar, der jedes Buch katalogisiert | Wichtige Infos aus einzelnen Seiten kopieren |

| Ergebnis | Liste von URLs, Seiteninhalte, Sitemap | Strukturierte Daten (CSV, Excel, JSON usw.) |

| Nutzer | Suchmaschinen, SEO-Tools, Archivare | Vertrieb, E-Commerce, Analysten, Forscher |

| Typischer Umfang | Milliarden Seiten (breit angelegt) | Dutzende bis Tausende Seiten (gezielt) |

Kurz gesagt: Crawling dient dem Auffinden von Seiten, Scraping dem gezielten Sammeln von Daten ().

Typische Herausforderungen und Best Practices beim Crawling und Scraping

Herausforderungen

- Website-Änderungen: Schon kleine Designänderungen können dein Tool lahmlegen ().

- Dynamische Inhalte: Viele Seiten laden Daten per JavaScript, was einfache Crawler nicht erfassen können.

- Anti-Bot-Maßnahmen: CAPTCHAs, IP-Sperren und Logins können dich ausbremsen.

- Skalierung: Tausende Seiten zu crawlen kann deinen Rechner (oder deine IP) überfordern.

- Rechtliche/ethische Fragen: Öffentlich zugängliche Daten zu scrapen ist meist erlaubt, aber prüfe immer die Nutzungsbedingungen und Datenschutzgesetze ().

Best Practices

- Das richtige Tool wählen: Wenn du nicht programmierst, starte mit einem No-Code-Scraper.

- Datenbedarf klar definieren: Überlege genau, welche Daten du brauchst und warum.

- Website-Regeln respektieren: Prüfe immer

robots.txtund die Nutzungsbedingungen. - Server schonen: Baue Pausen zwischen Anfragen ein, um Websites nicht zu überlasten.

- Wartung einplanen: Websites ändern sich – rechne mit gelegentlichen Anpassungen.

- Daten sauber und sicher speichern: Prüfe Ergebnisse auf Duplikate und Fehler.

Typische Anwendungsfälle: Crawling vs. Scraping

Web Crawling

- Suchmaschinen-Indexierung: Googlebot und Bingbot crawlen das Web, um Suchergebnisse aktuell zu halten ().

- Web-Archivierung: Das Internet Archive crawlt Seiten für die Wayback Machine.

- SEO-Audits: Tools crawlen deine Website, um z. B. fehlerhafte Links zu finden.

Web Scraping

- Preisüberwachung: Händler scrapen Produktseiten der Konkurrenz für Preisanalysen ().

- Lead-Generierung: Vertriebsteams scrapen Verzeichnisse nach Kontaktdaten.

- Content-Aggregation: News- oder Jobportale sammeln Inhalte aus verschiedenen Quellen.

- Marktforschung: Analysten scrapen Bewertungen oder Social Media für Stimmungsanalysen.

Fun Fact: Über nutzen Web Scraping für externe Daten. Wenn du es nicht tust, macht es vermutlich deine Konkurrenz.

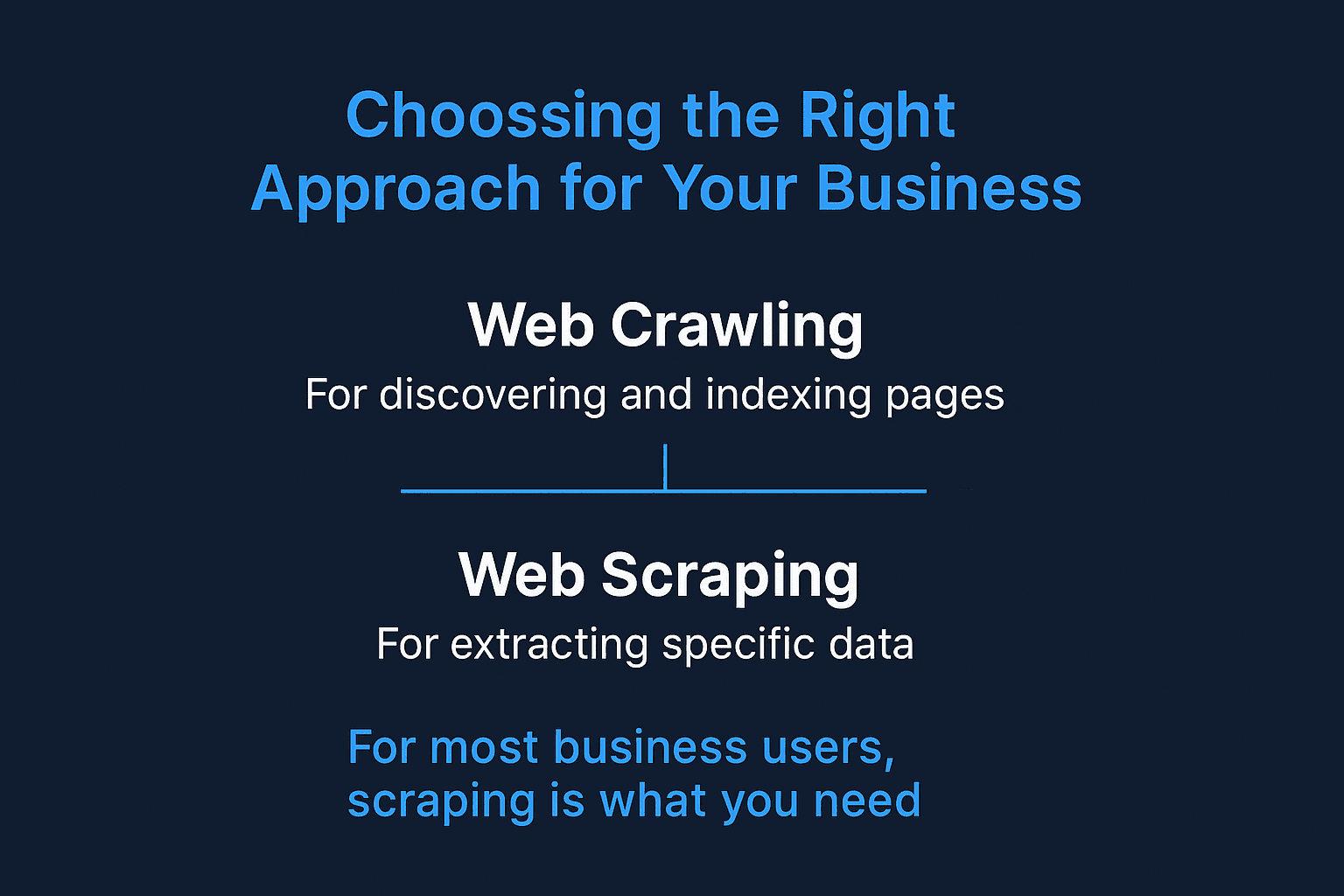

Wann solltest du Crawling oder Scraping einsetzen?

Hier eine schnelle Entscheidungshilfe:

-

Musst du neue Seiten entdecken oder eine ganze Website indexieren?

→ Setze auf Web Crawling.

-

Weißt du schon, wo deine Daten liegen (bestimmte Seiten oder Bereiche)?

→ Dann reicht Web Scraping.

-

Baust du eine Suchmaschine oder willst das Web archivieren?

→ Crawling ist gefragt.

-

Willst du gezielt Daten für Vertrieb, Preise oder Analysen sammeln?

→ Scraping ist die richtige Wahl.

-

Unsicher?

→ Starte mit Scraping. Für die meisten Business-Anwendungen reicht das völlig aus.

Für die meisten Unternehmen ist Scraping die Lösung – gezielte, strukturierte Daten, die du sofort weiterverwenden kannst.

Web Scraping für Unternehmen: Die Vorteile von Thunderbit

Warum sollten sich gerade Business-Anwender – vor allem ohne Programmierkenntnisse – auf Scraping konzentrieren? Und warum ist dafür gemacht?

Ich habe schon zu viele Teams erlebt, die Tage (oder Wochen) mit scheinbar „einfachen“ Scraping-Tools vergeudet haben. Deshalb haben wir Thunderbit entwickelt: Damit Webdaten-Extraktion so einfach wie zwei Klicks wird.

Das macht Thunderbit besonders:

- Zwei-Klick-Workflow: „KI-Felder vorschlagen“ anklicken, dann „Scrapen“. Fertig. Kein Code, kein Gefummel mit Selektoren.

- Bulk-URL- & PDF-Support: Daten aus einer Liste von URLs oder sogar aus PDFs extrahieren? Thunderbit kann beides.

- Export überallhin: Schicke deine Daten direkt zu Google Sheets, Airtable, Notion oder lade sie als CSV/JSON herunter – ohne Zusatzkosten.

- Subpage-Scraping: Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails) und ergänzt deine Datentabelle.

- KI-Autofill: Automatisiere das Ausfüllen von Formularen und wiederkehrende Webaufgaben – wie ein digitaler Assistent für Routinejobs.

- Kostenlose E-Mail- & Telefon-Extraktoren: Mit einem Klick alle Kontaktdaten einer Seite erfassen.

- Cloud- oder Browser-Scraping: Wähle, was zu dir passt – Thunderbit kann superschnell in der Cloud oder direkt im Browser (ideal für eingeloggte Seiten) scrapen.

- Keine Lernkurve: Entwickelt für Vertrieb, E-Commerce und Marketing – einfach Ergebnisse, keine IT-Abteilung nötig.

Mehr Anwendungsbeispiele findest du in unseren Guides zum , oder .

Thunderbit vs. klassischer Web-Scraper

Hier ein direkter Vergleich für Business-Anwender:

| Funktion/Bedarf | Thunderbit | Klassischer Web-Scraper (z. B. Scrapy, Nutch) |

|---|---|---|

| Einrichtung | 2 Klicks, kein Code | Technische Einrichtung, oft Scripting nötig |

| Lernkurve | Minimal | Hoch (vor allem für Nicht-Programmierer) |

| Unterseiten | KI-gesteuert, automatisch | Manuelles Scripting oder komplexe Konfiguration |

| Bulk-URLs/PDFs | Integriert | Meist nicht direkt unterstützt |

| Exportformate | Google Sheets, Airtable, Notion, CSV | CSV, JSON (oft manuelle Integration) |

| Anpassungsfähigkeit | KI passt sich Website-Änderungen an | Manuelle Updates bei Änderungen nötig |

| Business-Anwendungsfälle | Vertrieb, E-Commerce, SEO, Operations | Suchmaschinen-Indexierung, Forschung, Archivierung |

| Zeitplanung | Zeitsteuerung in natürlicher Sprache | Cronjobs oder externe Scheduler |

| Preis | Ab 15 $/Monat, kostenlose Stufe verfügbar | Kostenlos/Open Source, aber höherer Aufwand |

| Support | Nutzerorientiert, moderne Oberfläche | Community-basiert, Entwicklerfokus |

Mit Thunderbit kommst du blitzschnell von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ – ganz ohne IT-Ticket.

Fazit: Die richtige Methode für dein Unternehmen

Kurz und knapp:

- Web Crawling dient dem Entdecken und Indexieren von Seiten – ideal für Suchmaschinen und Website-Audits.

- Web Scraping extrahiert gezielt verwertbare Daten – z. B. für Leads, Preisüberwachung oder Content-Aggregation.

- Für die meisten Unternehmen ist Scraping die Lösung. Und du brauchst dafür keine Programmierkenntnisse.

Das Web wächst und wird immer komplexer. Mit der richtigen Strategie – und dem passenden Tool – kannst du aus diesem Chaos wertvolle Erkenntnisse gewinnen. Wenn du genug von komplizierten Scraping-Tools oder langen IT-Wartezeiten hast, probiere aus. Du wirst überrascht sein, wie viel du mit nur zwei Klicks erledigen kannst (und vielleicht bleibt dir endlich das Wochenende frei).

Du willst Thunderbit live erleben? Hol dir unsere oder stöbere in weiteren Tipps und Anleitungen im .

Viel Spaß beim Scrapen (und nicht beim Crawlen – es sei denn, du baust die nächste Suchmaschine)!

FAQs

1. Brauche ich für mein Unternehmen sowohl einen Web-Crawler als auch einen Scraper?

Nicht unbedingt. Wenn du schon weißt, auf welchen Seiten deine Daten liegen, reicht ein Web-Scraper wie Thunderbit völlig aus. Crawler sind vor allem dann sinnvoll, wenn du neue Seiten entdecken willst – etwa für eine komplette Website-Übersicht oder SEO-Audits.

2. Ist Web Scraping legal?

Im Allgemeinen ist das Scrapen öffentlich zugänglicher Daten erlaubt – solange du keine Logins umgehst, keine Nutzungsbedingungen verletzt oder sensible Daten sammelst. Prüfe aber immer die robots.txt und die Datenschutzrichtlinien der Website, besonders bei kommerzieller Nutzung.

3. Was unterscheidet Thunderbit von anderen Web-Scraping-Tools?

Thunderbit richtet sich an Business-Anwender ohne Programmierkenntnisse. Im Gegensatz zu klassischen Scraping-Tools, die HTML-Kenntnisse oder manuelle Einrichtung erfordern, nutzt Thunderbit KI, um Felder zu erkennen, Unterseiten zu navigieren und Daten im gewünschten Format auszugeben – alles in nur zwei Klicks.

4. Kann Thunderbit auch dynamische Websites und eingeloggte Seiten scrapen?

Ja. Thunderbit bietet Scraping direkt im Browser für eingeloggte Sitzungen und dynamische Inhalte sowie Cloud-Scraping für Geschwindigkeit und Skalierung. Du kannst je nach Datenbedarf den passenden Modus wählen.