Wer schon mal vor einer endlosen Liste von Webseiten saß und sich gewünscht hat, all diese Infos mit einem Klick in eine übersichtliche Tabelle zu bekommen, ist definitiv nicht allein. Im heutigen Geschäftsleben ist der Hunger nach Webdaten riesig. Egal ob du Preise der Konkurrenz checken, neue Leads aufbauen oder den Immobilienmarkt analysieren willst – Unternehmen wollen das Internet in echte Erkenntnisse verwandeln. Im Mittelpunkt dieses digitalen Goldrauschs steht der Python-Scrapper – ein Tool, das für alle, die Daten automatisiert sammeln möchten, zum absoluten Must-have geworden ist.

Aber während Python-Scrapper bei Entwicklern schon fast Kultstatus haben, wirken sie für viele Business-Anwender immer noch wie eine geheimnisvolle Blackbox voller Code. Genau das erlebe ich regelmäßig bei , wo wir uns auf die Fahne geschrieben haben, Webdaten-Extraktion so einfach wie eine Essensbestellung zu machen. Zeit, das Rätsel zu lösen: Was ist eigentlich ein Python-Scrapper? Warum ist er das Tool der Wahl für Webdaten-Extraktion? Und wie machen neue KI-Tools diese Technik plötzlich für alle zugänglich – selbst für Leute ohne Programmierkenntnisse?

Python-Scrapper: Was steckt dahinter und warum ist das so wichtig?

Fangen wir ganz vorne an. Ein Python-Scrapper (oft auch „Scraper“ geschrieben) ist ein Programm, das mit Python geschrieben wurde und den Prozess der Datenerfassung von Webseiten automatisiert. Stell dir einen extrem fleißigen digitalen Assistenten vor: Du gibst ihm eine Liste von Webseiten, und er besucht jede einzelne, liest die Inhalte aus und kopiert gezielt die gewünschten Daten – Namen, Preise, E-Mails, was immer du brauchst – in ein strukturiertes Format wie eine Tabelle.

Warum ist das für Unternehmen so ein Gamechanger? Weil manuelles Sammeln von Daten einfach mühsam und fehleranfällig ist. Hunderte oder gar tausende Webseiten per Copy & Paste zu bearbeiten, kostet nicht nur Zeit, sondern auch Nerven – und ist alles andere als effizient. Python-Scrapper nehmen dir diese Sisyphusarbeit ab und ermöglichen es, riesige Datenmengen in Minuten statt Tagen zu erfassen. Wie ein Leitfaden es treffend beschreibt: Ein Web-Scraper „extrahiert automatisch Informationen von Webseiten und wandelt sie in strukturierte Daten (wie eine Tabelle) um“ – Schluss mit Copy-Paste-Marathons und verpassten Chancen ().

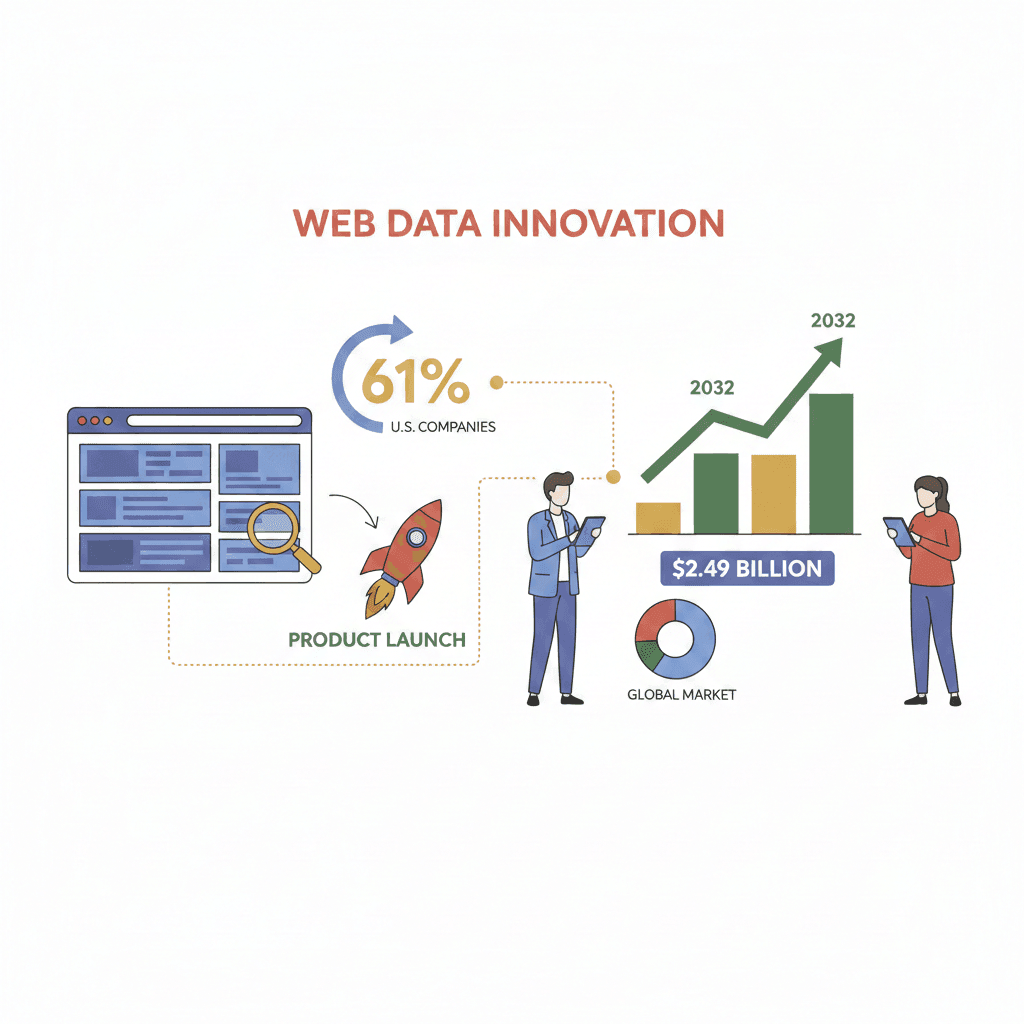

Und der Bedarf wächst weiter. Fast nutzen inzwischen externe Webdaten für neue Produkte oder Features, und der globale Markt für Web-Scraping-Software soll bis 2032 auf wachsen. Wer diese Daten nicht nutzt, riskiert, von der Konkurrenz abgehängt zu werden.

Was kann ein Python-Scrapper eigentlich?

Was leistet ein Python-Scrapper konkret? Eine ganze Menge! Hier die wichtigsten Funktionen, die ihn zum Daten-Sammelprofi machen:

- Beliebige Daten extrahieren: Egal ob Produktlisten, E-Mail-Adressen, Telefonnummern, Bilder oder sogar versteckte Metadaten – ein Python-Scrapper kann praktisch alles erfassen, was auf einer Webseite sichtbar (oder unsichtbar) ist. Du brauchst Kontaktdaten für Lead-Generierung? Kein Problem. Produktinfos, Preise oder Bewertungen? Geht easy.

- Große Datenmengen automatisiert verarbeiten: Ein Scrapper kann hunderte oder tausende Seiten in einem automatisierten Ablauf abarbeiten. Er folgt „Weiter“-Buttons, scrollt durch endlose Listen und wird dabei nie müde oder unaufmerksam.

- Links folgen und Unterseiten erfassen: Du brauchst mehr Details? Scrapper können von einer Übersichtsseite zu einzelnen Produkt- oder Profilseiten navigieren und die Daten zusammenführen.

- Mit Paginierung und dynamischen Inhalten umgehen: Viele moderne Webseiten laden Inhalte per JavaScript oder verteilen sie auf mehrere Seiten. Mit den richtigen Python-Bibliotheken kann ein Scrapper auch diese Hürden meistern und Inhalte wie ein echter Nutzer abrufen.

- Export in gängige Formate: Nach der Datenerfassung werden die Ergebnisse als CSV, Excel, JSON oder direkt in Datenbanken exportiert – bereit für Analyse, Reporting oder CRM.

Beliebte Python-Bibliotheken wie , Scrapy und Selenium machen all das möglich – allerdings braucht man dafür technisches Know-how.

Warum Python-Scrapper beim Datensammeln unschlagbar sind

Der Unterschied zwischen manueller Datenerfassung und einem Python-Scrapper ist wie der zwischen einem Löffel und einem Presslufthammer beim Tunnelbau. Warum?

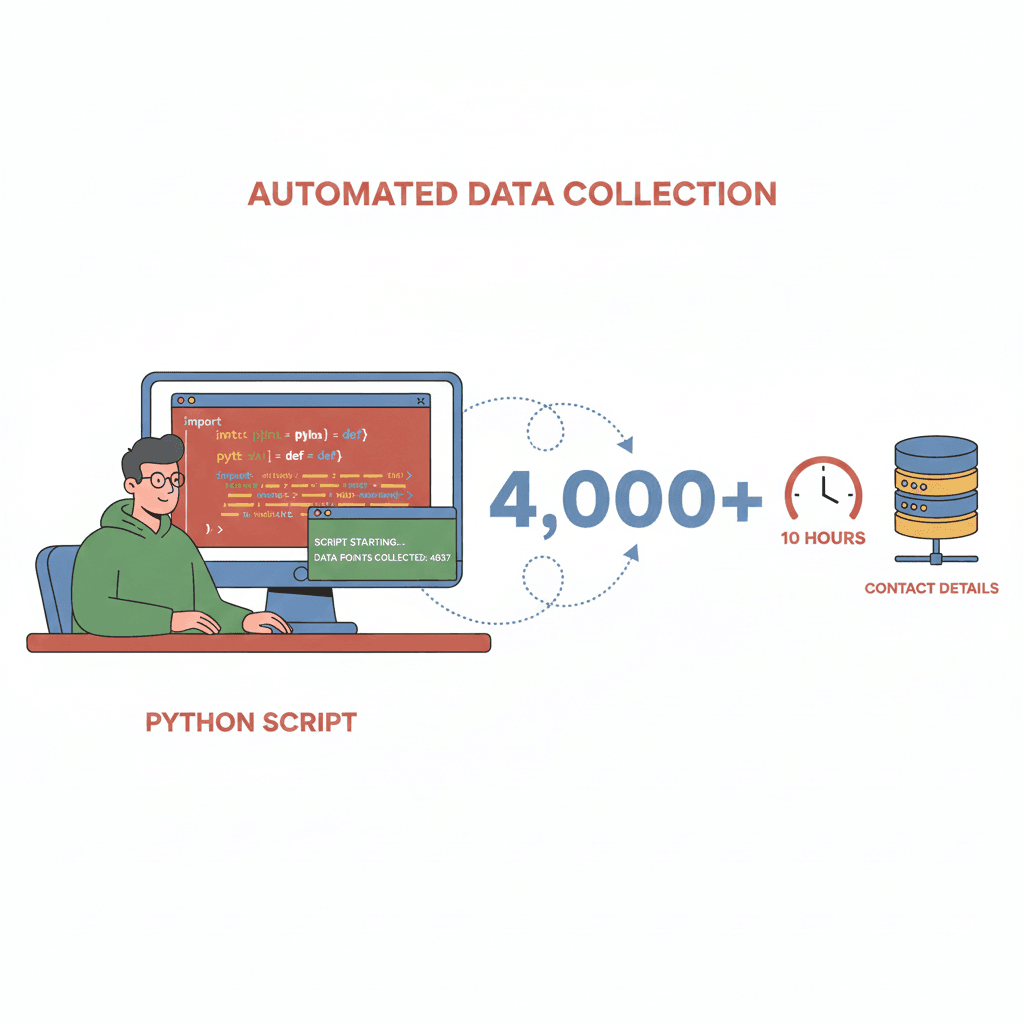

- Geschwindigkeit & Effizienz: Was manuell Tage dauert, erledigt ein Scrapper in Minuten. Ein Entwickler hat mit einem Python-Script gesammelt – eine Aufgabe, die per Hand Wochen beanspruchen würde.

- Skalierbarkeit: Du willst alle Produkte eines Konkurrenten überwachen oder tausende Bewertungen sammeln? Scrapper verarbeiten riesige Datenmengen zuverlässig und ohne Ermüdung.

- Genauigkeit & Zuverlässigkeit: Scrapper arbeiten exakt nach Vorgabe – keine Tippfehler, keine ausgelassenen Einträge, kein „mache ich morgen fertig“. Mit KI-Unterstützung liegt die Datenqualität sogar bei bis zu , selbst bei komplexen Seiten.

- Kosteneinsparung: Was früher ganze Teams oder teure Datenanbieter erforderte, lässt sich mit Scrappern automatisieren.

Hier ein Überblick typischer Business-Anwendungen und deren Mehrwert:

| Anwendungsfall | Erfasste Daten | Business-Nutzen (ROI) |

|---|---|---|

| Lead-Generierung im Vertrieb | Namen, E-Mails, Telefonnummern aus Verzeichnissen | Schneller Aufbau von Kontaktlisten; 4.000+ Leads in wenigen Stunden (Medium) |

| Preisüberwachung (E-Commerce) | Preise der Konkurrenz, Lagerbestände | Dynamische Preisgestaltung; John Lewis +4 % Umsatz (Browsercat) |

| Markt- & Wettbewerbsanalyse | Produktlisten, Bewertungen, Stimmungen | 73 % der Unternehmen nutzen Scraping für Marktanalysen (Browsercat) |

| Immobilienanalyse | Immobilienangebote, Preise, Ausstattungen | Aktuelle Vergleichswerte und Markttrends für Makler/Investoren |

| News- & Research-Aggregation | Schlagzeilen, Artikel, Forschungsdaten | Echtzeit-Feeds für Analysten; keine manuelle Recherche mehr |

Python-Scrapper im Einsatz: Branchenbeispiele

Wie werden Python-Scrapper konkret genutzt?

E-Commerce & Einzelhandel

Händler überwachen mit Scrappern die Preise, Verfügbarkeiten und Bewertungen der Konkurrenz. Rund setzen Scraping für dynamische Preisgestaltung ein – mit messbarem Erfolg.

Vertrieb & Lead-Generierung

Vertriebsteams sammeln mit Scrappern Kontakte aus öffentlichen Verzeichnissen, Verbandsseiten oder Google Maps. Warum für veraltete Lead-Listen zahlen, wenn man täglich tausende frische Kontakte selbst erfassen kann?

Immobilien

Makler und Investoren analysieren mit Scrappern Plattformen wie Zillow oder Realtor.com, um Angebote, Preise und Trends in Echtzeit zu verfolgen – ein klarer Wettbewerbsvorteil.

Marktforschung & News

Analysten nutzen Scrapper, um Newsseiten, Foren und Social Media nach Trends, Stimmungen und Wettbewerbsaktivitäten zu durchforsten. Manuelles Lesen aller Artikel ist bei der Datenmenge schlicht unmöglich.

Typische Herausforderungen

Natürlich läuft nicht immer alles reibungslos. Scrapper stoßen oft auf:

- Dynamische Inhalte: Webseiten, die Daten per JavaScript laden.

- Anti-Scraping-Maßnahmen: CAPTCHAs, IP-Sperren, Login-Pflichten.

- Strukturänderungen: Ein Website-Relaunch kann das Script über Nacht unbrauchbar machen.

Doch wie wir gleich sehen, machen moderne KI-Tools diese Hürden deutlich leichter überwindbar.

Die Technik dahinter: Wie funktioniert ein Python-Scrapper (ohne Fachchinesisch)?

So läuft ein typischer Python-Scrapper ab – ganz einfach erklärt:

- Anfrage senden: Der Scrapper „fragt“ die Webseite nach dem Seiteninhalt (wie dein Browser).

- Inhalte abrufen: Er bekommt den HTML-Code (und lädt ggf. dynamische Inhalte mit Tools wie Selenium).

- Daten auslesen: Mit Bibliotheken wie BeautifulSoup sucht er gezielt nach den gewünschten Infos – Produktnamen, Preise, E-Mails usw.

- Daten bereinigen & strukturieren: Die Daten werden aufbereitet – Leerzeichen entfernt, Formate vereinheitlicht, Telefonnummern geprüft.

- Export: Das finale Datenset wird als CSV, Excel oder in ein anderes Format gespeichert.

Wenn das Web eine riesige Bibliothek ist, ist ein Python-Scrapper wie ein Roboter-Bibliothekar, dem du sagst: „Finde alle Bücher über Schuhe, kopiere Preis und Autor und trag sie in meine Tabelle ein.“ Der Roboter wird nie müde, vergisst kein Buch und arbeitet blitzschnell.

Lernkurve: Welche Kenntnisse braucht man für einen Python-Scrapper?

Der Haken: Klassische Python-Scrapper sind mächtig, aber nicht ganz ohne Einstiegshürde.

- Programmierkenntnisse: Du musst Python beherrschen, Bibliotheken installieren und Fehler beheben können.

- HTML/CSS-Verständnis: Scrapping erfordert das Untersuchen von Webseiten, um die richtigen Elemente zu finden – z. B. „Finde das

<h2>-Tag mit der Klasse ‘product-title’.“ - Umgang mit Web-Hürden: Viele Seiten nutzen JavaScript, verlangen Logins oder blockieren Bots. Hier ist oft individuelles Scripting gefragt.

- Wartung: Webseiten ändern sich. Das Script kann plötzlich nicht mehr funktionieren und muss angepasst werden – manchmal genau dann, wenn man es am dringendsten braucht.

Für Nicht-Techniker ist das oft abschreckend. Aber auch Entwickler verlieren durch Wartung und Anpassung viel Zeit. Kein Wunder, dass viele wieder auf Copy & Paste zurückgreifen.

Thunderbit: Python-Scrapper-Power für alle

Genau hier setzt an. Thunderbit ist eine , die dir die Power eines Python-Scrappers bietet – ganz ohne Programmieraufwand.

So schließt Thunderbit die Lücke:

- KI-Feldvorschläge: Ein Klick genügt, und Thunderbits KI scannt die Seite, schlägt die wichtigsten Felder vor (z. B. „Produktname“, „Preis“, „E-Mail“) und benennt sie automatisch.

- Scraping mit zwei Klicks: Spalten prüfen, auf „Scrape“ klicken – Thunderbit erledigt den Rest, inklusive Paginierung, Unterseiten und dynamischer Inhalte.

- Export überallhin: Exportiere deine Daten direkt nach Excel, Google Sheets, Notion, Airtable, CSV oder JSON – ohne Zusatzkosten oder Umwege.

- Unterseiten-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch jede Unterseite (z. B. Produktdetails oder LinkedIn-Profile) und ergänzt deine Tabelle.

- Keine Einrichtung, keine Wartung: Erweiterung installieren und loslegen. Ändert sich eine Website, einfach „KI-Feldvorschläge“ erneut nutzen – Thunderbit passt sich an.

Kurz: Python-Scrapper als Service – aber für alle, nicht nur für „Python-Gurus“.

Wie Thunderbit technische Hürden beseitigt

Vergleichen wir den klassischen Python-Scrapper-Workflow mit Thunderbit:

| Schritt | Klassischer Python-Scrapper | Thunderbit KI-Web-Scraper |

|---|---|---|

| Erforderliche Kenntnisse | Python, HTML/CSS, Fehlersuche | Keine – nur grundlegende Webkenntnisse |

| Einrichtung | Stunden bis Tage (Installation, Code, Debug) | Minuten (Erweiterung installieren, loslegen) |

| Paginierung | Code-Schleifen schreiben, bei Änderungen debuggen | KI erkennt und klickt automatisch durch Seiten |

| Unterseiten-Scraping | Individueller Code je Website | Ein Klick – KI navigiert und verknüpft automatisch |

| Dynamische Inhalte | Selenium/Playwright, Browser steuern | Browserbasiert – sieht, was du siehst |

| Export nach Excel/Sheets | Export-Code schreiben, Dateiformate beachten | Ein Klick – Export nach Excel, Sheets, Notion, Airtable |

| Wartung | Code bei Website-Änderungen anpassen | „KI-Feldvorschläge“ erneut nutzen – KI passt sich an |

Kurzum: Thunderbit nimmt dir alle technischen Stolpersteine ab. Wer einen Browser bedienen kann, kann auch Thunderbit nutzen.

KI + Python-Scrapper: Mehr Datenqualität und Business-Mehrwert

Jetzt wird’s spannend: Thunderbit kopiert nicht nur Daten, sondern macht sie mit KI auch noch intelligenter:

- Intelligentere Extraktion: KI erkennt Muster, auch auf unübersichtlichen oder dynamischen Seiten, und steigert die Genauigkeit auf bis zu .

- Rausfiltern von Störfaktoren: Thunderbits KI blendet irrelevante Inhalte (z. B. Werbung, Fußzeilen, Navigation) aus und konzentriert sich auf die gewünschten Daten.

- Daten-Normalisierung: Du willst alle Telefonnummern im E.164-Format? Adressen vereinheitlichen? Produktkategorien automatisch zuordnen? Einfach eine Anweisung hinzufügen – Thunderbits KI erledigt das direkt beim Scraping.

- Datenanreicherung in Echtzeit: Du willst Texte übersetzen, Beschreibungen zusammenfassen oder Produkte kategorisieren? Mit den Field-AI-Prompts von Thunderbit geht das direkt während der Extraktion.

Das Ergebnis: Saubere, sofort nutzbare Datensätze – ohne stundenlange Nachbearbeitung.

Typische Hürden beim Web-Scraping? Moderne Tools lösen sie!

Web-Scraping ist nicht frei von Herausforderungen, aber moderne Tools machen vieles einfacher:

- Anti-Scraping-Maßnahmen: Thunderbit arbeitet browserbasiert und verhält sich wie ein echter Nutzer – so werden Blockaden und CAPTCHAs selten ausgelöst. Für besonders geschützte Seiten gibt es einen Cloud-Modus mit wechselnden IPs und Anti-Bot-Technik.

- Dynamische Inhalte: Was du im Browser siehst, kann Thunderbit auch extrahieren – kein Ärger mehr mit JavaScript oder versteckten Daten.

- Strukturänderungen: Ändert sich eine Website, einfach „KI-Feldvorschläge“ erneut nutzen – Thunderbit passt sich automatisch an.

- Datenqualität: Integrierte Duplikat-Prüfung, Fehlerbehandlung und KI-gestützte Bereinigung sorgen für hochwertige Daten.

- Compliance: Thunderbit fördert verantwortungsvolles Scraping – mit Rate-Limiting, Beachtung von robots.txt und Vermeidung sensibler Daten.

Kurz: Die technischen Hürden, die Scraping früher Entwicklern vorbehalten haben, werden heute automatisch gelöst.

Fazit: Die richtige Lösung für deine Datenextraktion

Was bleibt? Ein Python-Scrapper ist ein mächtiges Werkzeug, um das unstrukturierte Web in verwertbare Geschäftsdaten zu verwandeln. Er ist das Rückgrat moderner Vertriebs-, E-Commerce- und Marktforschungsprozesse. Doch bis vor Kurzem war er nur mit Programmierkenntnissen nutzbar.

Mit KI-Tools wie ist diese Hürde gefallen. Egal ob Vertriebsleiter, Marketer oder Immobilienprofi – du kannst die benötigten Daten in Minuten statt Monaten extrahieren. Ohne Code, ohne Einrichtung, ohne Wartung. Einfach Ergebnisse.

Wann lohnt sich ein klassischer Python-Scrapper? Wenn du ein Entwicklerteam hast, hochgradig individuelle Workflows brauchst oder tiefe Systemintegration wünschst, kann eigener Code sinnvoll sein. Für 99 % der Business-Anwender sind KI-Tools wie Thunderbit aber schneller, einfacher und zuverlässiger.

Neugierig? und probiere das Scraping direkt selbst aus. Du wirst dich fragen, wie du je ohne ausgekommen bist.

Mehr zu Web-Scraping, KI-Datenextraktion oder Business-Automatisierung? Im findest du weitere Anleitungen, Tipps und Praxisbeispiele.

Häufige Fragen (FAQ)

1. Was ist ein Python-Scrapper und wie unterscheidet er sich von manueller Datenerfassung?

Ein Python-Scrapper ist ein Programm, das die Datenerfassung von Webseiten automatisiert und Webinhalte in strukturierte Formate wie Tabellen umwandelt. Im Gegensatz zu Copy & Paste arbeitet er viel schneller, skaliert beliebig und minimiert Fehler.

2. Welche Daten kann ein Python-Scrapper extrahieren?

Python-Scrapper können Tabellen, Listen, Bilder, E-Mails, Telefonnummern, Preise, Produktdetails, Bewertungen und vieles mehr erfassen – praktisch alles, was auf einer Webseite sichtbar (oder versteckt) ist.

3. Muss ich programmieren können, um einen Python-Scrapper zu nutzen?

Klassische Python-Scrapper erfordern Programmierkenntnisse. Mit KI-Tools wie kann jedoch jeder mit wenigen Klicks Daten extrahieren – ganz ohne Coding.

4. Wie erleichtert Thunderbit Web-Scraping für Nicht-Techniker?

Thunderbit nutzt KI, um Datenfelder automatisch zu erkennen, Paginierung und Unterseiten zu verarbeiten und Ergebnisse nach Excel, Google Sheets, Notion oder Airtable zu exportieren. Du beschreibst einfach, was du brauchst – Thunderbit erledigt den Rest.

5. Ist Web-Scraping legal und sicher für Unternehmen?

Web-Scraping ist legal, wenn es verantwortungsvoll erfolgt – also nur öffentliche Daten, Beachtung der Website-Regeln und keine sensiblen Informationen. Thunderbit fördert ethisches Scraping und bietet Funktionen für Compliance.

Neugierig, wie einfach Webdaten-Extraktion sein kann? und mach das Web zu deinem Wettbewerbsvorteil.

Mehr erfahren