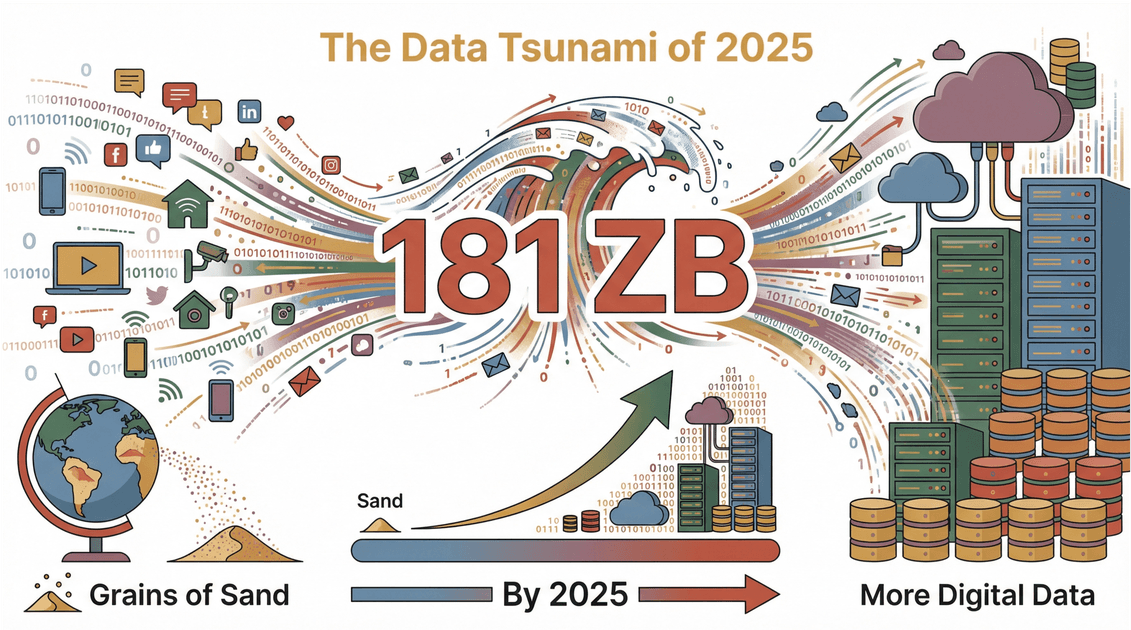

Das Internet wächst gefühlt noch schneller als mein täglicher Kaffeekonsum – und das will schon was heißen. Bis 2025 werden wir mit regelrecht überschwemmt – das sind mehr digitale Infos, als Sandkörner auf der Erde liegen. Das Problem dabei: Die meisten dieser Daten sind wild verstreut, unstrukturiert und irgendwo auf Webseiten versteckt – für Unternehmen ohne passende Tools kaum zu gebrauchen. Und nein, ich rede hier nicht von einem Spachtel aus dem Baumarkt. Im digitalen Alltag ist ein „Scraper“ nämlich etwas ganz anderes.

Oft höre ich die Frage: „Was macht so ein Scraper eigentlich?“ Ist das ein Roboter? Ein Hacker-Tool? Oder einfach nur eine clevere Kopierhilfe? Tatsächlich sind Web-Scraper die unsichtbaren Helfer im Hintergrund – sie bringen das Datenchaos des Internets in ordentliche Tabellen, die alles antreiben: von Vertriebskontakten bis zu Preisvergleichen. Lass uns anschauen, was ein Scraper wirklich kann, warum er für moderne Unternehmen so wichtig ist und wie Tools wie die Datenerfassung so einfach (und sicher) machen wie nie zuvor.

Was macht ein Scraper? Die Basics locker erklärt

Um es gleich klarzustellen: Ein Scraper ist im Datenkontext keine Scheibenwischerhilfe, sondern eine Software (meist „Web-Scraper“ genannt), die automatisch Infos von Webseiten einsammelt und sie in ein brauchbares Format bringt – zum Beispiel als Tabelle oder Datenbank. Stell dir einen superflinken Assistenten vor, der hunderte Webseiten abklappert, die gewünschten Infos kopiert und sie ordentlich in Zeilen und Spalten sortiert – während du entspannt deinen Kaffee genießt.

Kurz und knapp:

- Ein Scraper „liest“ Webseiten für dich.

- Er findet und sammelt gezielt die Infos, die du brauchst – etwa Preise, Kontaktdaten, Bewertungen oder Immobilienangebote.

- Er bringt diese Daten in eine strukturierte Tabelle, bereit für Analyse oder Import in deine Tools.

Mit einem Scraper wird aus „Ich hätte das gern alles in Excel“ ganz schnell „Hier ist deine fertige Tabelle“. Schluss mit endlosem Copy-Paste.

Die wichtigsten Funktionen und Einsatzbereiche eines Scrapers

Was kann ein Scraper konkret für dich tun? Hier die Kernfunktionen:

| Funktion | Beschreibung | Typische Anwendungsfälle |

|---|---|---|

| Datenerfassung | Spezifische Infos von Webseiten extrahieren (Text, Zahlen, Bilder, Links) | Produktlisten, Kontaktdaten, Bewertungen |

| Datenaufbereitung | Daten beim Sammeln bereinigen, formatieren oder kategorisieren | Telefonnummern vereinheitlichen, SKUs zuordnen |

| Datenstrukturierung | Unstrukturierte Webdaten in Tabellen oder Datenbanken bringen | Export nach Excel, Google Sheets, Notion |

| Automatisierung | Scraping-Aufgaben zeitgesteuert oder in großen Mengen ausführen | Tägliches Preis-Monitoring, Massen-Lead-Generierung |

| Unterseiten-Navigation | Verlinkte Seiten für Detailinfos besuchen | Produktdetails, Autorenprofile scrapen |

Typische Einsatzszenarien:

- Vertrieb: Leads aus LinkedIn oder Firmenverzeichnissen extrahieren

- E-Commerce: Preise und Lagerbestände der Konkurrenz im Blick behalten

- Marketing: Nutzerbewertungen, Feedback oder Social-Media-Erwähnungen einsammeln

- Immobilien: Angebote von Portalen wie Zillow bündeln

- Forschung: Nachrichten, wissenschaftliche Artikel oder Marktdaten zusammentragen

Immer wenn du denkst „Das müsste ich alles in eine Tabelle bekommen“, ist ein Scraper die Antwort.

Wie verschiedene Branchen mit Scrapers mehr aus Daten machen

Schauen wir mal in die Praxis – so nutzen verschiedene Branchen Scraper, um effizienter zu arbeiten:

E-Commerce: Konkurrenz im Blick behalten

Stell dir vor, du betreibst einen Online-Shop. Täglich ändern sich Preise und Verfügbarkeiten bei zig Wettbewerbern. Alles manuell prüfen? Keine Chance. Ein Scraper zieht automatisch Preise, Produktbeschreibungen und sogar Bilder von Konkurrenzseiten und zeigt sie übersichtlich im Dashboard. So kannst du auf Preisänderungen sofort reagieren und deine Strategie anpassen ().

Marketing: Kundenfeedback auf einen Blick

Für Marketer ist Kundenfeedback Gold wert. Scraper holen Bewertungen von Amazon, Yelp oder Foren, analysieren die Stimmung und erkennen Trends oder Probleme. Statt tausende Rezensionen einzeln zu lesen, bekommst du eine Zusammenfassung, was Kunden an deinem Produkt mögen – oder eben nicht ().

Immobilien: Angebotsdaten bündeln

Makler und Investoren brauchen aktuelle Immobilienangebote – und das möglichst schnell. Scraper sammeln Details, Preise, Fotos und sogar historische Trends von Portalen wie Zillow oder Realtor.com. Das ermöglicht eine schnellere Marktanalyse, bessere Vergleichswerte und fundiertere Investitionsentscheidungen ().

Mini-Case: Vertriebskontakte generieren

Ein Vertriebsteam möchte Entscheider im SaaS-Bereich erreichen. Statt veraltete Listen zu kaufen, nutzen sie einen Scraper, um aktuelle Namen, Positionen und E-Mail-Adressen von Firmenwebseiten und LinkedIn zu sammeln. Das Ergebnis: Präzisere Leads, bessere Rücklaufquoten und weniger Zeitverschwendung ().

Die Entwicklung der Datenerfassung: Wie KI Scraper noch smarter macht

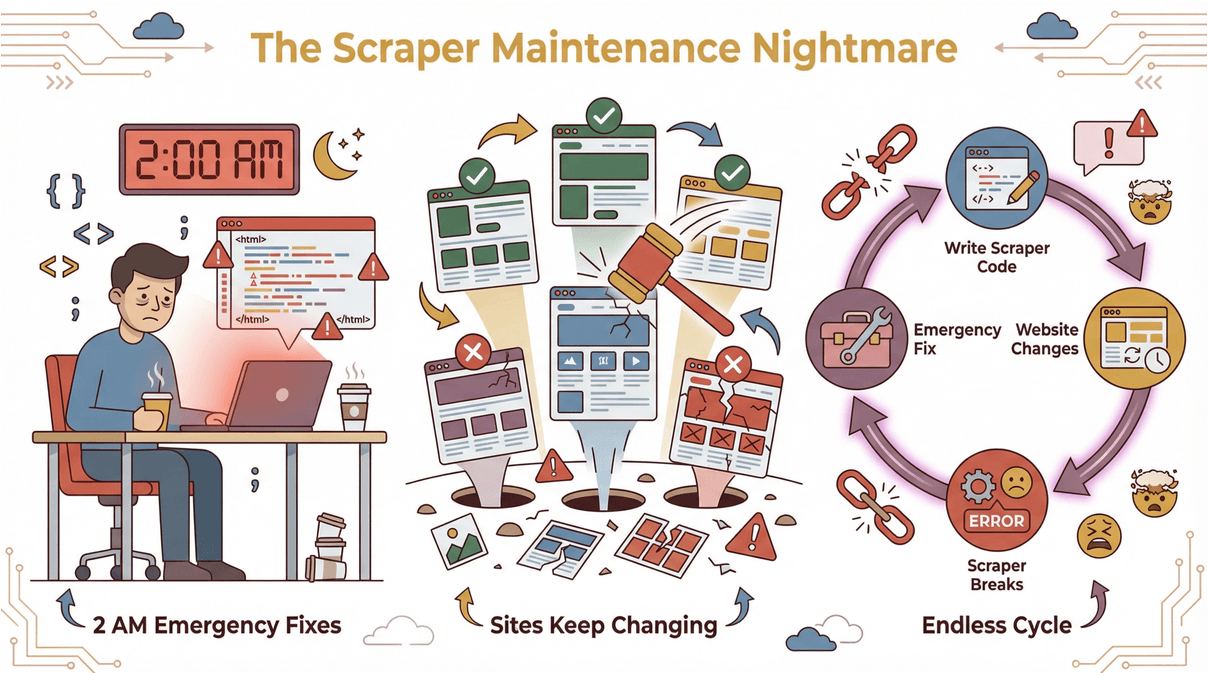

Früher war Web Scraping ein endloses Katz-und-Maus-Spiel: Für jede Webseite musste man Code oder Vorlagen schreiben – und sobald sich das Layout änderte, war alles hinüber. Notfall-Reparaturen um 2 Uhr nachts waren keine Seltenheit ().

Dann kam KI ins Spiel. Moderne Scraper wie nutzen künstliche Intelligenz, um Webseiten zu „verstehen“ – fast wie ein Mensch. Das bringt viele Vorteile:

Dann kam KI ins Spiel. Moderne Scraper wie nutzen künstliche Intelligenz, um Webseiten zu „verstehen“ – fast wie ein Mensch. Das bringt viele Vorteile:

- Kein Programmieren nötig: Einfach beschreiben, was du brauchst („Alle Produktnamen und Preise erfassen“), und die KI erledigt den Rest.

- Automatische Felderkennung: Die KI schlägt passende Spalten vor, selbst auf komplexen oder unübersichtlichen Seiten.

- Robust bei Layout-Änderungen: Ändert sich die Webseite, passt sich die KI an – keine kaputten Scripte mehr.

- Universell einsetzbar: Egal ob E-Commerce, Immobilien oder andere Bereiche – KI-Web-Scraper kommen mit verschiedenen Layouts, Sprachen und Datentypen klar ().

Das Ergebnis: Schneller Start, weniger Wartung und Datenerfassung, die jeder nutzen kann – nicht nur Entwickler.

Wie Thunderbit das klassische Scraper-Modell aufmischt

Ganz ehrlich: Ich habe entwickelt, weil ich es satt hatte, dass Teams an komplizierten, code-lastigen Scraper-Lösungen verzweifeln. Thunderbit macht Scraping so einfach wie eine Essensbestellung. So läuft’s ab:

- Einfache Spracheingabe: Sag Thunderbit einfach, welche Daten du brauchst. Kein Gefummel mit Selektoren oder Code.

- KI-Feldvorschläge: Mit „KI-Felder vorschlagen“ scannt Thunderbit die Seite und empfiehlt Spalten wie „Name“, „Preis“ oder „E-Mail“.

- Unterseiten-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch verlinkte Seiten (z. B. Produktdetails oder Autorenprofile) und ergänzt deine Tabelle.

- Sofort-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Shopify) gibt’s fertige Templates – ein Klick reicht ().

- Kostenloser Datenexport: Ergebnisse direkt nach Excel, Google Sheets, Notion oder Airtable exportieren – ohne versteckte Kosten.

So einfach geht’s:

- Thunderbit Chrome-Erweiterung auf der Zielseite öffnen.

- „KI-Felder vorschlagen“ anklicken und passende Spalten auswählen.

- Auf „Scrapen“ klicken – Thunderbit sammelt und strukturiert die Daten.

- Exportieren und fertig.

Thunderbit wird schon von über genutzt – vom Vertrieb bis zur Immobilienbranche. Und: Es gibt eine kostenlose Version, mit der du direkt loslegen kannst.

Datensicherheit und rechtliche Aspekte beim Scraping

Mit großer Scraping-Power kommt auch Verantwortung. Es ist wichtig, Webseiten-Regeln, Datenschutz und rechtliche Vorgaben zu beachten. Das solltest du wissen:

- robots.txt respektieren: Viele Seiten geben in der Datei

robots.txtan, was gescraped werden darf (). - Keine sensiblen Daten sammeln: Persönliche Daten nur mit Erlaubnis und berechtigtem Grund erfassen ().

- Daten ethisch nutzen: Gescrapete Inhalte nicht einfach weiterverbreiten oder verkaufen. Nutze sie für Analysen, Forschung oder interne Zwecke.

- Gesetze beachten: Vorschriften wie DSGVO (Europa) und CCPA (Kalifornien) regeln die Datenerhebung streng.

Thunderbit unterstützt dich dabei, indem es Scraping in 34 Sprachen ermöglicht, Webseitenregeln respektiert und verantwortungsvolle Nutzung fördert ().

Gängige Scraper-Typen und wie du den passenden findest

Nicht jeder Scraper ist gleich. Hier die wichtigsten Varianten:

| Typ | Vorteile | Nachteile | Ideal für |

|---|---|---|---|

| Browser-Erweiterungen | Einfach, keine Installation, schneller Start | Nur sichtbare Daten im Browser erfassbar | Nicht-Techniker |

| Cloud-Tools | Skalierbar, läuft im Hintergrund, planbar | Oft Abo nötig, Einrichtung kann dauern | Teams, wiederkehrende Jobs |

| Eigene Scripte | Voll anpassbar, sehr leistungsfähig | Programmierkenntnisse, hoher Wartungsaufwand | Entwickler, Spezialfälle |

So findest du das richtige Tool:

- Für schnelle Ergebnisse ohne Programmieren: Browser-Erweiterung wie Thunderbit.

- Für große oder regelmäßig wiederkehrende Aufgaben: Cloud-Tools.

- Für maximale Kontrolle (und wenn du coden kannst): Eigene Scripte.

Mehr dazu im .

Zukunftstrends: KI und Automatisierung beim Scraping

Die Zukunft des Scraping ist KI-gestützt und voll automatisiert. Das kommt auf uns zu:

- Geplantes Scraping: Einmal einrichten, automatisch regelmäßig aktualisieren ().

- Integration in Business-Tools: Gescrapete Daten fließen direkt in CRM, Dashboards und Analyse-Tools.

- Mehrsprachigkeit: Scraper erfassen Daten von Webseiten in jeder Sprache – weltweit.

- Vorausschauende Extraktion: KI erkennt nicht nur Daten, sondern prognostiziert, welche Infos künftig wichtig werden ().

- Wartungsfreie Tools: Keine kaputten Scripte mehr – KI passt sich automatisch an Webseitenänderungen an.

Thunderbit ist hier ganz vorne dabei – mit Features wie geplantem Scraping, Unterseiten-Navigation und KI-gestützten Feldvorschlägen. Und das ist erst der Anfang.

Fazit: Wie Scraper Unternehmen heute stärken

Was macht ein Scraper? In einer Welt voller Daten sind Scraper die Rettungsboote – sie helfen Unternehmen, relevante Infos zu sammeln, zu ordnen und wirklich zu nutzen. Egal ob Vertrieb, E-Commerce, Marketing oder Immobilien: Scraper sparen Zeit, erhöhen die Genauigkeit und liefern Erkenntnisse, die sonst verborgen bleiben.

Moderne Tools wie machen Scraping für alle zugänglich – ohne Programmieren, ohne Frust, mit schnellen Ergebnissen. Wer Webdaten effizient in seine Arbeitsabläufe bringen will, sollte es ausprobieren.

Neugierig, was Scraping für dein Team leisten kann? und leg los. Weitere Tipps findest du im .

Häufige Fragen (FAQ)

1. Was macht ein Web-Scraper genau?

Ein Web-Scraper ist eine Software, die gezielt Infos von Webseiten sammelt und sie in strukturierte Formate wie Tabellen oder Datenbanken bringt. So sparst du dir mühsames Copy-Paste und kannst große Datenmengen effizient auswerten.

2. Ist die Nutzung eines Scrapers legal und sicher?

Web Scraping ist legal, wenn du Webseitenregeln und Datenschutz beachtest und keine sensiblen Daten ohne Erlaubnis sammelst. Schau immer in die robots.txt und nutze gescrapete Daten verantwortungsvoll.

3. Wie unterscheidet sich ein KI-Scraper von klassischen Scraper-Tools?

KI-Web-Scraper wie Thunderbit nutzen künstliche Intelligenz, um Webseiten zu verstehen, Felder vorzuschlagen und sich an Layout-Änderungen anzupassen. Das heißt: Kein Programmieren, weniger Wartung, schnellerer Start als bei klassischen, vorlagenbasierten Tools.

4. Was sind die wichtigsten Vorteile eines Scrapers für Unternehmen?

Scraper sparen Zeit, reduzieren Fehler und liefern wertvolle Erkenntnisse durch automatisierte Datenerfassung. Sie werden für Lead-Generierung, Preisüberwachung, Marktforschung und vieles mehr eingesetzt – und helfen Teams, datenbasierte Entscheidungen zu treffen.

5. Wie finde ich den passenden Scraper für meine Anforderungen?

Wer keine Programmierkenntnisse hat, startet am besten mit einer Browser-Erweiterung wie Thunderbit. Für größere oder wiederkehrende Aufgaben eignen sich Cloud-Tools. Entwickler mit speziellen Anforderungen greifen zu eigenen Scripten. Entscheidend sind dein technisches Know-how, das Datenvolumen und die gewünschte Integration.