Hast du dich schon mal gefragt, warum Google scheinbar jede Ecke des Internets kennt oder wie Preisvergleichsseiten immer die aktuellsten Angebote parat haben? Im Hintergrund sind unzählige digitale „Spinnen“ unterwegs, die das Netz Tag und Nacht durchkämmen und für uns eine riesige Landkarte bauen, damit wir in Sekunden das finden, was wir suchen. Tatsächlich machen heute fast die Hälfte des gesamten Internet-Traffics Bots aus – und die meisten davon sind Crawler, die leise Infos für Suchmaschinen, KI-Modelle und Unternehmen einsammeln, ordnen und strukturieren ().

Ich entwickle seit Jahren bei Thunderbit Automatisierungs- und KI-Lösungen und kann dir sagen: Wer Crawler versteht, hat einen echten Vorsprung. Egal ob Vertrieb, E-Commerce oder Operations – zu wissen, was Crawler sind und wie moderne, KI-gestützte Tools wie funktionieren, öffnet dir neue Datenquellen, automatisiert die Recherche und bringt dich der Konkurrenz einen Schritt voraus. Lass uns gemeinsam hinter die Kulissen dieser digitalen Helfer schauen und entdecken, warum sie heute wichtiger sind als je zuvor.

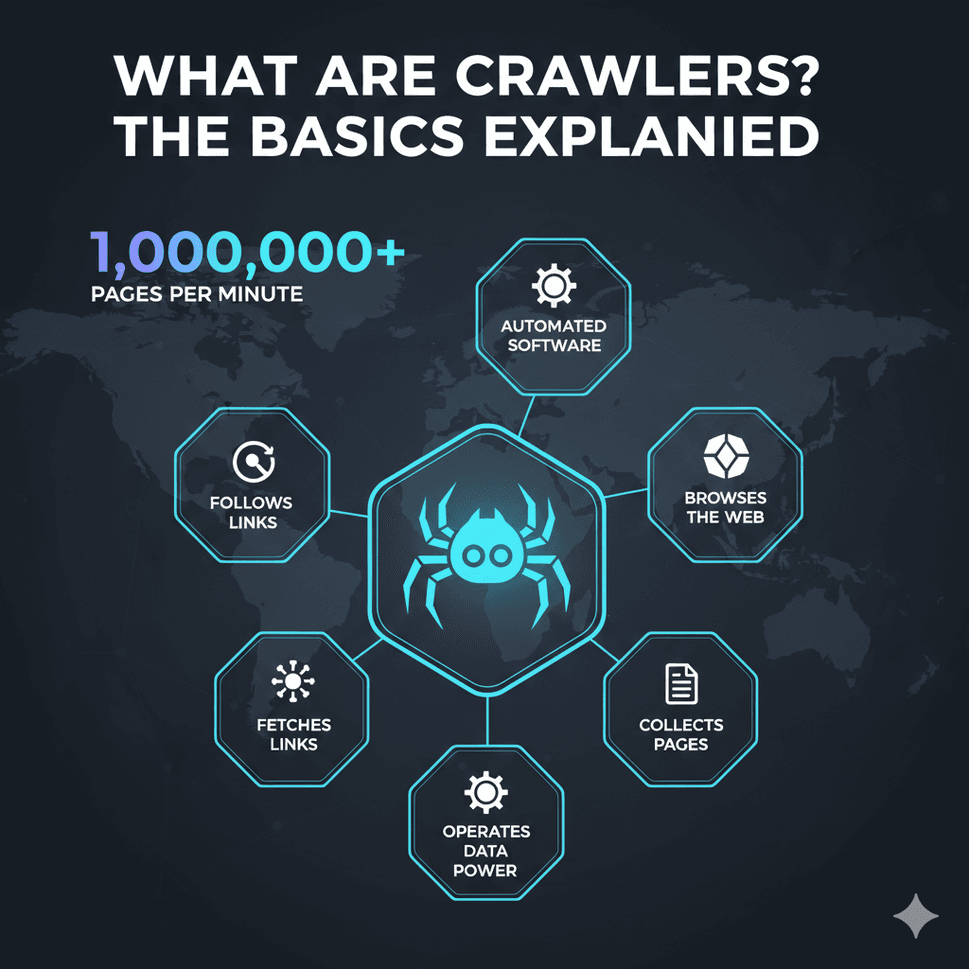

Was sind Crawler? Die Basics auf den Punkt gebracht

Was steckt eigentlich hinter dem Begriff Crawler? Kurz gesagt: Ein Crawler (auch Spider oder Bot genannt) ist ein Softwareprogramm, das automatisch Webseiten besucht, Inhalte abruft, Links folgt und dabei Infos sammelt. Stell dir Crawler wie fleißige Bibliothekare des Internets vor: Sie besuchen Websites, lesen alles durch und katalogisieren die Inhalte, damit sie später auffindbar sind (, ).

Stell dir das Web wie eine riesige Stadt vor und Crawler als Boten, die an einer Adresse starten, alles notieren, was sie finden, und dann jedem Wegweiser (Hyperlink) zum nächsten Ort folgen. So entsteht nach und nach eine durchsuchbare Karte des Internets.

Zu den bekanntesten Crawlern gehören Googlebot (für Google Search), Bingbot (für Bing) und neuere KI-Crawler wie GPTBot (für OpenAI-Modelle). Diese Bots indexieren hunderte Milliarden Webseiten – allein Googles Index belegt über 100 Millionen Gigabyte Speicherplatz (). Ohne Crawler könnten Suchmaschinen, KI-Assistenten und viele Business-Tools gar nicht funktionieren.

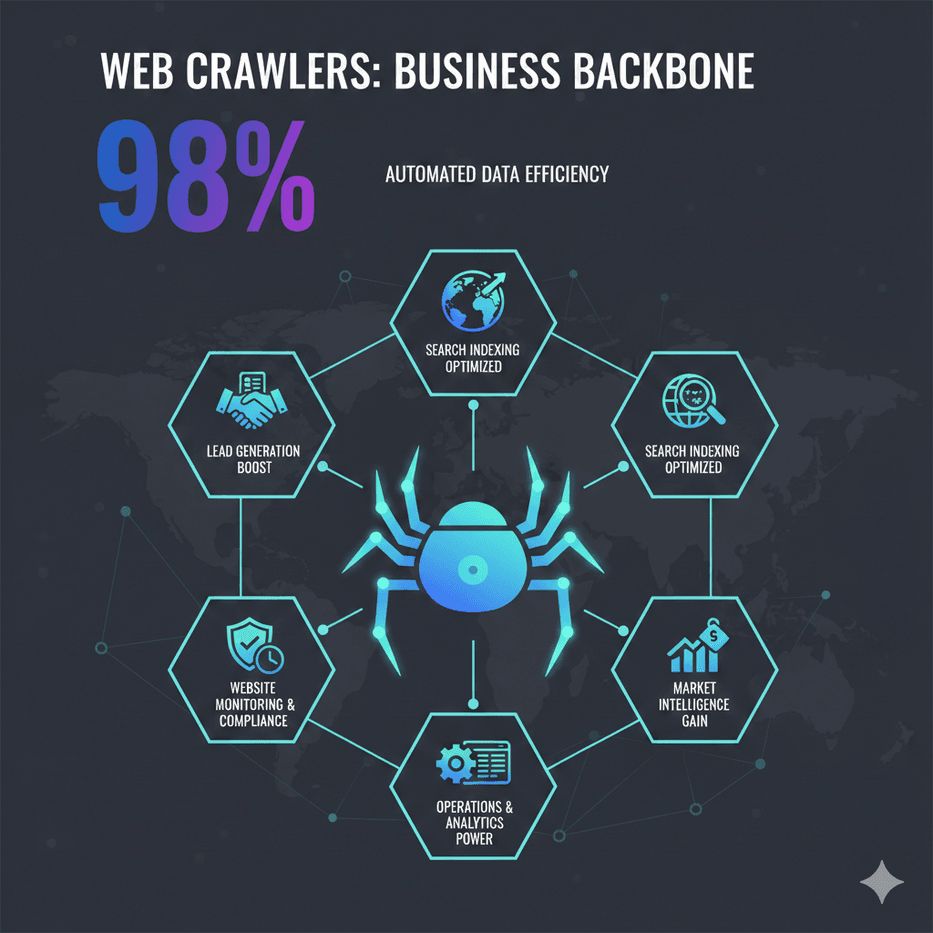

Warum sind Crawler wichtig? Zentrale Aufgaben und Business-Anwendungen

Crawler sind nicht nur für Suchmaschinen da – sie sind das Rückgrat vieler moderner Geschäftsprozesse. Hier die wichtigsten Einsatzbereiche:

- Suchmaschinen-Indexierung: Crawler durchforsten das Web, damit Suchmaschinen relevante Ergebnisse liefern können. Wird deine Seite nicht gecrawlt, taucht sie bei Google oder Bing nicht auf ().

- Datengewinnung & Marktanalyse: Unternehmen nutzen Crawler (und Web-Scraper), um Wettbewerberpreise, Produktdaten, Bewertungen und mehr zu sammeln. So konnte der britische Händler John Lewis durch Preisüberwachung den Umsatz um 4 % steigern, während ASOS mit regionalen Webdaten die internationalen Verkäufe verdoppelte ().

- Website-Monitoring & Compliance: Crawler überwachen eigene oder fremde Websites auf Änderungen – etwa neue Produkte, Preisupdates oder Einhaltung von Vorschriften.

- Leadgenerierung: Vertriebsteams nutzen Crawler, um Kontaktdaten aus Verzeichnissen oder Firmenlisten zu sammeln – was früher stundenlange Recherche bedeutete, läuft jetzt automatisiert.

- Betrieb & Analyse: Von der Bestandsüberwachung bis zur Aggregation von Immobilienangeboten – Crawler liefern Daten für Dashboards und Analysen und ermöglichen so bessere Entscheidungen.

Hier eine übersichtliche Tabelle zu den wichtigsten Crawler-Anwendungen für verschiedene Teams:

| Team/Funktion | Crawler-Anwendungsfall | Nutzen |

|---|---|---|

| Vertrieb & Leadgen | Kontaktdaten von Websites oder Verzeichnissen sammeln | Automatisierte Lead-Listen; Wachstum ohne manuelle Dateneingabe |

| Marketing/Research | Wettbewerberseiten und Online-Bewertungen überwachen | Echtzeit-Markteinblicke; fundierte Strategie |

| E-Commerce & Handel | Preis- und Produktüberwachung bei der Konkurrenz | Dynamische Preisgestaltung; bessere Margen und Umsätze |

| Betrieb/Produkt | Website-Änderungen für Compliance oder Updates erkennen | Qualitätskontrolle; schnelle Reaktion auf externe Änderungen |

| Datenanalyse & KI | Großflächige Datensammlung für Analysen oder KI-Training | Datenbasierte Erkenntnisse; Trainingsmaterial für Machine Learning |

()

Wie funktionieren Crawler? Schritt für Schritt erklärt

Auch wenn Crawler nach Hightech klingen, ist ihr Grundablauf ziemlich simpel ():

- Seed-URLs: Crawler starten mit einer Liste von Startadressen (den „Seeds“). Das kann eine Homepage, eine Sitemap oder eine von dir bereitgestellte Liste sein.

- Abrufen: Der Crawler besucht jede URL und lädt den HTML-Code der Seite herunter – ähnlich wie dein Browser.

- Parsen & Extrahieren: Er liest die Seite, extrahiert relevante Infos (z. B. Text, Metadaten, Links) und notiert alle gefundenen Hyperlinks.

- Speichern & Indexieren: Die gesammelten Daten werden in einer Datenbank oder einem Index abgelegt – strukturiert und durchsuchbar.

- Links folgen: Alle neuen Links kommen in die Warteschlange, und der Crawler wiederholt den Prozess – so wird das Web Stück für Stück erschlossen.

Moderne Crawler sind dabei rücksichtsvoll: Sie prüfen die robots.txt-Datei einer Website, um zu sehen, was sie durchsuchen dürfen, und drosseln ihre Anfragen, damit Server nicht überlastet werden (). Suchmaschinen setzen sogar „Crawl-Budgets“ ein, um zu steuern, wie oft eine Seite besucht wird – besonders wichtige oder oft aktualisierte Seiten werden bevorzugt.

Crawler vs. Scraper: Wo liegt der Unterschied?

Oft werden „Crawling“ und „Scraping“ gleichgesetzt, aber es gibt einen entscheidenden Unterschied ():

- Crawling bedeutet, möglichst viele Seiten zu entdecken und zu indexieren (also das Web zu kartografieren).

- Scraping heißt, gezielt bestimmte Daten von ausgewählten Seiten zu extrahieren (z. B. Preise von Produktseiten).

In der Praxis gehen beide oft Hand in Hand: Erst wird eine Website gecrawlt, um alle Produktseiten zu finden, dann werden diese gezielt gescraped, um Details wie Preis und Verfügbarkeit zu erfassen. Für Unternehmen ist es wichtig, diesen Unterschied zu kennen, um das passende Tool auszuwählen.

Crawler-Typen: Von Suchmaschinen bis KI-Bots

Nicht alle Crawler sind gleich. Hier die wichtigsten Typen ():

- Suchmaschinen-Crawler: Die großen Player wie Googlebot, Bingbot, Baidu Spider und Yandex Bot. Ihr Ziel: Das gesamte Web indexieren, damit wir es durchsuchen können.

- Fokussierte Crawler: Suchen gezielt nach Seiten zu einem bestimmten Thema (z. B. nur Jobbörsen oder News zu „Klimawandel“).

- Inkrementelle Crawler: Konzentrieren sich darauf, nur neue oder geänderte Inhalte zu erfassen – spart Zeit und Bandbreite.

- Deep-Web-Crawler: Gelangen auch an Inhalte hinter Suchformularen, Logins oder versteckten Seiten.

- Site-Audit-Crawler: Tools wie Screaming Frog oder SEMrush Site Audit, die die eigene Website für SEO oder Qualitätschecks durchforsten.

- Vergleichs-/Monitoring-Crawler: Unternehmen nutzen sie, um Preise, Produktänderungen oder Compliance bei bestimmten Seiten zu überwachen.

- KI-gestützte Crawler: Die neue Generation – wie GPTBot von OpenAI oder CCBot von Common Crawl – sammeln Daten für KI-Training oder nutzen KI, um zu entscheiden, was und wie gecrawlt wird ().

KI-Crawler krempeln das Feld gerade komplett um. Schon 2025 machen KI-Bots etwa 30 % des Web-Traffics aus – und der Anteil wächst weiter ().

Herausforderungen klassischer Crawler und moderne Lösungen

Das Web wird immer komplexer – und klassische Crawler stoßen an ihre Grenzen:

- Anti-Crawling-Schutz: CAPTCHAs, IP-Sperren, Rate-Limits und Browser-Fingerprinting stoppen klassische Bots oft sofort. Über 95 % der Scraping-Fehlschläge gehen auf Anti-Bot-Maßnahmen zurück ().

- Dynamische Inhalte: Viele Seiten laden Daten per JavaScript oder mit unendlichem Scrollen – einfache Crawler kommen hier nicht weiter. Headless-Browser und KI-Parsing sind inzwischen unverzichtbar ().

- Häufige Änderungen: Schon kleine Layout-Änderungen können klassische Scraper lahmlegen und erfordern ständige Nachbesserung.

- Skalierung & Geschwindigkeit: Millionen Seiten schnell zu crawlen, braucht verteilte Systeme und Cloud-Infrastruktur – ein einzelner Rechner reicht nicht mehr aus.

- Rechtliche & ethische Fragen: Die Einhaltung von

robots.txt, Datenschutzgesetzen und Nutzungsbedingungen ist wichtiger denn je.

Moderne Lösungen – vor allem KI-gestützte Tools – gehen diese Probleme an. Sie nutzen maschinelles Lernen, um sich an neue Layouts anzupassen, simulieren echte Browser und interpretieren Seiten wie ein Mensch. KI-Scraper können inzwischen sogar Daten aus PDFs, Bildern oder ungewöhnlichen Webseiten extrahieren und sind dadurch deutlich flexibler und robuster.

Thunderbit: Crawler für das moderne Web optimiert

Hier kommt Thunderbit ins Spiel. Bei haben wir einen KI-gestützten Web-Scraper und Web-Scraper entwickelt, der für das dynamische, ständig wechselnde Web von 2025 gemacht ist. Unser Ziel: Webdaten für alle zugänglich machen – nicht nur für Entwickler.

Was macht Thunderbit besonders?

- KI-gestützte Einfachheit: Mit nur einem Klick auf „KI-Felder vorschlagen“ analysiert Thunderbits KI die Seite, schlägt passende Daten-Spalten vor (wie „Produktname“, „Preis“, „Bewertung“) und richtet die Extraktion automatisch ein. Kein Code, kein HTML-Gefrickel – einfach loslegen ().

- Meistert komplexe & Nischen-Seiten: Thunderbits KI kommt auch mit ungewöhnlichen Layouts, dynamischen Inhalten und Spezialseiten klar – ideal für Daten aus Nischen-Websites, die klassische Scraper überfordern.

- Unterseiten- & Paginierungs-Crawling: Du brauchst Details von allen Produktseiten einer Kategorie? Thunderbit folgt automatisch Links, crawlt Unterseiten und fasst die Daten in einer Tabelle zusammen – ganz ohne manuelle Konfiguration ().

- Cloud- & Browser-Modus: Wähle zwischen schnellem Cloud-Scraping für öffentliche Seiten oder Browser-Modus für geschützte oder login-pflichtige Seiten.

- Kostenloser Datenexport: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion – ohne versteckte Kosten ().

- No-Code, business-tauglich: Thunderbit ist für Business-Anwender gemacht – Vertrieb, Marketing, E-Commerce und Operations – die Ergebnisse wollen, ohne sich mit Web-Scraping-Technik beschäftigen zu müssen.

Thunderbit vs. klassische Crawler: Der Funktionsvergleich

So schlägt sich Thunderbit im Vergleich zu klassischen Tools:

| Funktion | Thunderbit (KI-gestützt) | Klassische Crawler/Scraper |

|---|---|---|

| Einrichtungszeit | 2-Klick-KI-Setup | Manuelle Konfiguration, steile Lernkurve |

| Anpassungsfähigkeit | KI passt sich Seitenänderungen an | Bricht bei Layout-Änderungen |

| Dynamische Inhalte | Ja (KI & Headless-Browser) | Eingeschränkt oder manuell nötig |

| Unterseiten/Paginierung | Automatisch integriert | Manuelles Scripting erforderlich |

| Datenexport | Kostenlos zu Excel, Sheets, Notion | Oft kostenpflichtig oder limitiert |

| Benötigte Kenntnisse | Keine (No-Code) | Programmier- oder Technikkenntnisse |

| Wartungsaufwand | Minimal (KI lernt neu) | Häufig manuelle Anpassungen |

| Vorlagen für bekannte Seiten | 1-Klick, immer aktuell | Community/geteilt, oft veraltet |

| Preis | Kostenloser Einstieg, günstige Pläne | Für alle Funktionen oft teuer |

()

Thunderbit im Detail: Innovative Features für einfaches Crawling

Was macht Thunderbit im Alltag besonders?

- KI-Felder vorschlagen: Mein persönliches Highlight. Ein Klick, und Thunderbits KI erkennt die wichtigsten Spalten, erstellt Extraktions-Prompts und nimmt dir das Rätselraten ab.

- Unterseiten-Crawling: Nach dem Scrapen einer Listen-Seite einfach „Unterseiten scrapen“ wählen – Thunderbit besucht automatisch alle verlinkten Detailseiten und ergänzt die Tabelle.

- Sofort-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Instagram, Shopify) gibt es 1-Klick-Vorlagen – kein Setup, sofort Ergebnisse.

- Kostenlose E-Mail-, Telefon- und Bild-Extraktoren: Alle E-Mails oder Bilder einer Seite mit einem Klick extrahieren – kostenlos.

- Geplantes Scraping: Wiederkehrende Scrapes (täglich, wöchentlich etc.) einfach in Klartext einrichten – ideal für Preisüberwachung oder Marktbeobachtung.

- Cloud- vs. Browser-Scraping: Wähle je nach Bedarf – Cloud für Geschwindigkeit, Browser für anspruchsvolle Seiten.

Thunderbit wird weltweit von über 30.000 Nutzern eingesetzt – von Solo-Gründern bis zu großen Unternehmen (). Und ja, es gibt eine , mit der du risikofrei starten kannst.

Crawler-Zugriff steuern: Best Practices für Unternehmen

Egal ob du eine Website betreibst oder Crawler nutzt – der richtige Umgang mit Zugriffen ist entscheidend:

Für Website-Betreiber:

- Mit

robots.txtklare Regeln setzen – sensible Bereiche ausschließen, Suchmaschinen erlauben, unerwünschte Crawler blockieren (). - Mit Meta-Tags (

noindex,nofollow) steuern, was indexiert wird. - Bot-Traffic überwachen und Crawl-Raten bei Bedarf anpassen.

- SEO (Auffindbarkeit) und Schutz der Inhalte ausbalancieren – die gewünschten Bots (wie Googlebot) nicht aussperren.

Für Unternehmen, die Crawler nutzen:

- Immer

robots.txtund Nutzungsbedingungen respektieren – ethisches Crawling ist Pflicht. - Den eigenen Bot mit einer klaren User-Agent-Kennung identifizieren.

- Anfragen drosseln, um Server nicht zu überlasten.

- Wenn möglich, APIs nutzen und nur öffentliche Daten scrapen.

- Die Auswirkungen des eigenen Crawlers überwachen und bei Bedarf anpassen.

Fazit: Die wachsende Bedeutung von Crawlern für datengetriebene Unternehmen

Crawler sind längst mehr als einfache „Spinnen“ – sie sind das Fundament für Suche, KI und Business Intelligence. Wer heute versteht, was Crawler sind und wie moderne, KI-gestützte Tools wie Thunderbit funktionieren, erschließt sich neue Chancen. Egal ob du SEO pushen, Recherche automatisieren oder smartere Vertriebspipelines aufbauen willst – Crawler sind deine unsichtbaren Helfer.

Und je weiter das Web wächst und sich verändert, desto erfolgreicher sind Unternehmen, die diese Tools verantwortungsvoll und kreativ einsetzen. Wenn du sehen willst, was KI-gestütztes Crawling für dein Business leisten kann, und probiere es aus. Noch mehr Tipps und Praxis-Guides findest du im .

FAQs

1. Was ist ein Web-Crawler – einfach erklärt?

Ein Web-Crawler ist ein Programm, das automatisch das Internet durchsucht, Websites besucht, Links folgt und Informationen sammelt. Man kann ihn sich wie einen digitalen Bibliothekar vorstellen, der Webseiten katalogisiert, damit sie von Suchmaschinen gefunden oder für Geschäftsdaten genutzt werden können.

2. Wie unterscheiden sich Crawler und Scraper?

Crawler sind darauf ausgelegt, möglichst viele Seiten zu entdecken und zu indexieren (das Web kartografieren), während Scraper gezielt bestimmte Daten von ausgewählten Seiten extrahieren. In der Praxis arbeiten beide oft zusammen: Erst crawlen, um Seiten zu finden, dann scrapen, um die gewünschten Details zu holen.

3. Warum setzen Unternehmen Crawler ein?

Unternehmen nutzen Crawler für alles von SEO (damit die eigene Seite indexiert wird) über Wettbewerbsbeobachtung (Preise, Produktänderungen), Leadgenerierung, Marktforschung bis hin zur automatisierten Datensammlung für Analysen oder KI.

4. Welche Herausforderungen haben klassische Crawler?

Klassische Crawler scheitern oft an Anti-Bot-Schutz (CAPTCHAs, IP-Sperren), dynamischen Inhalten (JavaScript, Infinite Scroll), häufigen Seitenänderungen und rechtlichen/ethischen Vorgaben. Moderne KI-Tools wie Thunderbit sind darauf ausgelegt, diese Hürden zu überwinden.

5. Wie erleichtert Thunderbit das Crawling für Unternehmen?

Thunderbit nutzt KI, um automatisch die Struktur von Webseiten zu erkennen, Datenfelder vorzuschlagen und komplexe Aufgaben wie Unterseiten-Crawling und dynamische Inhalte zu meistern. Es ist No-Code, schnell eingerichtet und exportiert Daten direkt in deine Lieblingstools – so wird Webdatenzugang für alle möglich, nicht nur für Entwickler.

Bereit, Crawler für dein Business einzusetzen? und erlebe, wie einfach Webdaten sein können.

Mehr erfahren