Das Internet ist für viele Branchen wie ein riesiger Daten-Schatz – egal ob du im Vertrieb, E-Commerce oder in der Marktforschung unterwegs bist: 웹 스크래퍼 ist das geheime Ass für Lead-Generierung, Preisbeobachtung und Wettbewerbsanalysen. Aber: Je mehr Unternehmen auf Scraping setzen, desto härter machen Webseiten dicht. Über , und sind längst Standard. Wer schon mal erlebt hat, wie ein Python-Skript 20 Minuten läuft und dann plötzlich mit 403-Fehlern abbricht, kennt den Frust nur zu gut.

Nach vielen Jahren in der SaaS- und Automatisierungswelt weiß ich: Scraping-Projekte können von „läuft wie geschmiert“ zu „überall geblockt“ kippen – und das schneller, als dir lieb ist. Deshalb wird’s jetzt praktisch: Ich zeige dir, wie du mit Python 웹 스크래퍼 betreibst, ohne geblockt zu werden, stelle die besten Techniken und Code-Beispiele vor und erkläre, wann KI-basierte Alternativen wie Sinn machen. Egal ob du Python-Profi bist oder gerade erst einsteigst – am Ende hast du ein Werkzeug-Set für zuverlässiges, blockfreies Data Mining.

Was bedeutet Web Scraping ohne Blockierung mit Python?

Im Kern heißt web scraping ohne blockierung python, dass du Daten so von Webseiten extrahierst, dass deren Anti-Bot-Systeme nicht anschlagen. In Python reicht es nicht, einfach eine requests.get()-Schleife zu schreiben – du musst dich wie ein echter User verhalten und den Erkennungssystemen immer einen Schritt voraus sein.

Warum Python? – dank einfacher Syntax, riesigem Ökosystem (requests, BeautifulSoup, Scrapy, Selenium) und Flexibilität von kleinen Skripten bis zu verteilten Crawlern. Aber genau deshalb sind viele Anti-Bot-Systeme inzwischen darauf trainiert, typische Python-Scraping-Muster zu erkennen.

Wer also dauerhaft erfolgreich scrapen will, muss mehr tun als nur die Basics. Es gilt zu verstehen, wie Webseiten Bots erkennen – und wie du diese Mechanismen austrickst, ohne ethische oder rechtliche Grenzen zu überschreiten.

Warum ist Blockierungsvermeidung bei Python-Scraping-Projekten so wichtig?

Geblockt zu werden ist nicht nur ein technisches Problem – es kann ganze Geschäftsprozesse lahmlegen. Hier ein Überblick:

| Anwendungsfall | Folgen einer Blockierung |

|---|---|

| Lead-Generierung | Unvollständige oder veraltete Kontaktlisten, entgangene Umsätze |

| Preisüberwachung | Verpasste Preisänderungen bei Wettbewerbern, falsche Preisentscheidungen |

| Content-Aggregation | Lücken in News, Bewertungen oder Forschungsdaten |

| Marktbeobachtung | Fehlende Einblicke in Wettbewerber oder Branchenentwicklungen |

| Immobilienangebote | Ungenaue oder veraltete Objektdaten, verpasste Chancen |

Wenn ein 웹 스크래퍼 blockiert wird, fehlen nicht nur Daten – du verschwendest Ressourcen, riskierst Compliance-Probleme und triffst womöglich falsche Geschäftsentscheidungen. In einer Welt, in der , ist Zuverlässigkeit das A und O.

Wie erkennen und blockieren Webseiten Python-Web-Scraper?

Webseiten sind mittlerweile ziemlich clever, wenn es darum geht, Bots zu entlarven. Die gängigsten Anti-Scraping-Methoden (, ):

- IP-Adressensperre: Zu viele Anfragen von einer IP? Zack, geblockt.

- User-Agent- und Header-Prüfung: Fehlen oder sind Header zu generisch (z. B.

python-requests/2.25.1), fällt das sofort auf. - Rate Limiting: Zu viele Anfragen in kurzer Zeit führen zu Drosselung oder Sperre.

- CAPTCHAs: „Beweise, dass du ein Mensch bist“ – für Bots meist das Aus.

- Verhaltensanalyse: Webseiten achten auf Roboter-Muster, z. B. immer gleiche Klicks im gleichen Abstand.

- Honeypots: Versteckte Felder oder Links, die nur Bots ausfüllen oder anklicken.

- Browser-Fingerprinting: Erfassung von Browser- und Geräteinfos, um Automatisierung zu erkennen.

- Cookie- und Session-Tracking: Wer Cookies oder Sessions nicht korrekt behandelt, fliegt auf.

Stell dir das wie eine Flughafenkontrolle vor: Wer sich unauffällig verhält, kommt durch. Wer auffällt, wird genauer unter die Lupe genommen.

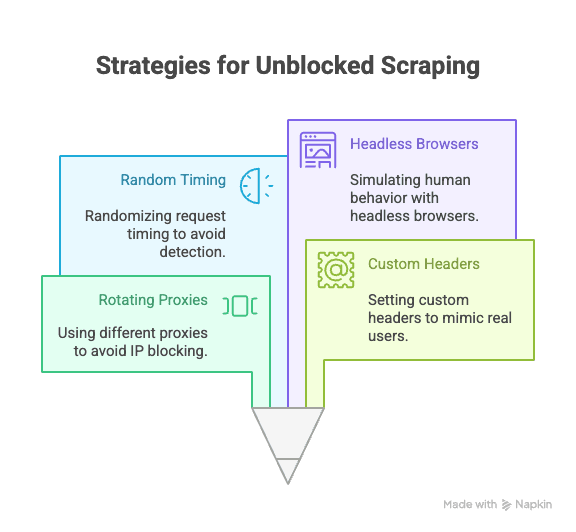

Unverzichtbare Python-Techniken für blockierungsfreies Web Scraping

Hier die wichtigsten Methoden, um Blockierungen beim Scraping mit Python zu vermeiden:

Proxies und IP-Adressen rotieren

Warum wichtig: Kommen alle Anfragen von einer IP, ist eine Sperre vorprogrammiert. Mit rotierenden Proxies verteilst du die Anfragen auf viele IPs und bleibst länger unentdeckt.

So geht’s in Python:

1import requests

2proxies = [

3 "<http://proxy1.example.com:8000>",

4 "<http://proxy2.example.com:8000>",

5 # ...weitere Proxies

6]

7for i, url in enumerate(urls):

8 proxy = {"http": proxies[i % len(proxies)]}

9 response = requests.get(url, proxies=proxy)

10 # Antwort verarbeitenFür mehr Zuverlässigkeit bieten sich kostenpflichtige Proxy-Dienste (z. B. Residential oder Rotating Proxies) an ().

User-Agent und Header anpassen

Warum wichtig: Standard-Header von Python verraten sofort, dass es sich um einen Bot handelt. Nutze echte Browser-Header, um dich zu tarnen.

Beispielcode:

1headers = {

2 "User-Agent": "Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/124.0.0.0 Safari/537.36",

3 "Accept-Language": "de-DE,de;q=0.9",

4 "Accept-Encoding": "gzip, deflate, br",

5 "Connection": "keep-alive"

6}

7response = requests.get(url, headers=headers)Noch unauffälliger wird’s, wenn du User-Agents regelmäßig wechselst ().

Anfragerhythmus und Muster variieren

Warum wichtig: Bots sind schnell und vorhersehbar, Menschen agieren zufällig. Verzögere Anfragen und variiere das Navigationsverhalten.

Python-Tipp:

1import time, random

2for url in urls:

3 response = requests.get(url)

4 time.sleep(random.uniform(2, 7)) # 2–7 Sekunden wartenMit Selenium kannst du auch Klickpfade und Scrollverhalten zufällig gestalten.

Cookies und Sessions verwalten

Warum wichtig: Viele Seiten setzen Cookies oder Session-Tokens voraus. Wer diese ignoriert, wird schnell geblockt.

So geht’s in Python:

1import requests

2session = requests.Session()

3response = session.get(url)

4# Cookies werden automatisch verwaltetFür komplexere Abläufe kannst du mit Selenium Cookies auslesen und wiederverwenden.

Menschliches Verhalten mit Headless-Browsern simulieren

Warum wichtig: Manche Seiten prüfen JavaScript, Mausbewegungen oder Scrollen als Echtheitsbeweis. Headless-Browser wie Selenium oder Playwright können diese Aktionen nachahmen.

Selenium-Beispiel:

1from selenium import webdriver

2from selenium.webdriver.common.action_chains import ActionChains

3import random, time

4driver = webdriver.Chrome()

5driver.get(url)

6actions = ActionChains(driver)

7actions.move_by_offset(random.randint(0, 100), random.randint(0, 100)).perform()

8time.sleep(random.uniform(2, 5))So umgehst du Verhaltensanalysen und dynamische Inhalte ().

Fortgeschritten: CAPTCHAs und Honeypots in Python umgehen

CAPTCHAs sind dazu da, Bots auszubremsen. Für einfache CAPTCHAs gibt’s Python-Bibliotheken, für komplexere setzen Profis auf externe Dienste wie 2Captcha oder Anti-Captcha ().

Beispiel-Integration:

1# Pseudocode für 2Captcha API

2import requests

3captcha_id = requests.post("<https://2captcha.com/in.php>", data={...}).text

4# Auf Lösung warten und dann mit Anfrage einreichenHoneypots sind versteckte Felder oder Links, die nur Bots ausfüllen oder anklicken. Klicke oder sende nichts, was im echten Browser nicht sichtbar ist ().

Robuste Request-Header mit Python-Bibliotheken gestalten

Neben dem User-Agent kannst du auch andere Header (wie Referer, Accept, Origin usw.) rotieren und variieren, um noch unauffälliger zu sein.

Mit Scrapy:

1class MySpider(scrapy.Spider):

2 custom_settings = {

3 'DEFAULT_REQUEST_HEADERS': {

4 'User-Agent': '...',

5 'Accept-Language': 'de-DE,de;q=0.9',

6 # Weitere Header

7 }

8 }Mit Selenium: Nutze Browser-Profile oder Extensions, um Header zu setzen, oder füge sie per JavaScript ein.

Halte deine Header-Liste aktuell – am besten kopierst du echte Browser-Anfragen aus den DevTools.

Wenn klassisches Python-Scraping an Grenzen stößt: Anti-Bot-Technologien auf dem Vormarsch

Die Realität: Je mehr gescrapt wird, desto ausgefeilter werden die Gegenmaßnahmen. . KI-gestützte Erkennung, dynamische Schwellenwerte und Browser-Fingerprinting machen es selbst für erfahrene Python-Skripte immer schwerer, unentdeckt zu bleiben ().

Manchmal hilft auch der beste Code nicht mehr weiter – dann ist es Zeit für einen anderen Ansatz.

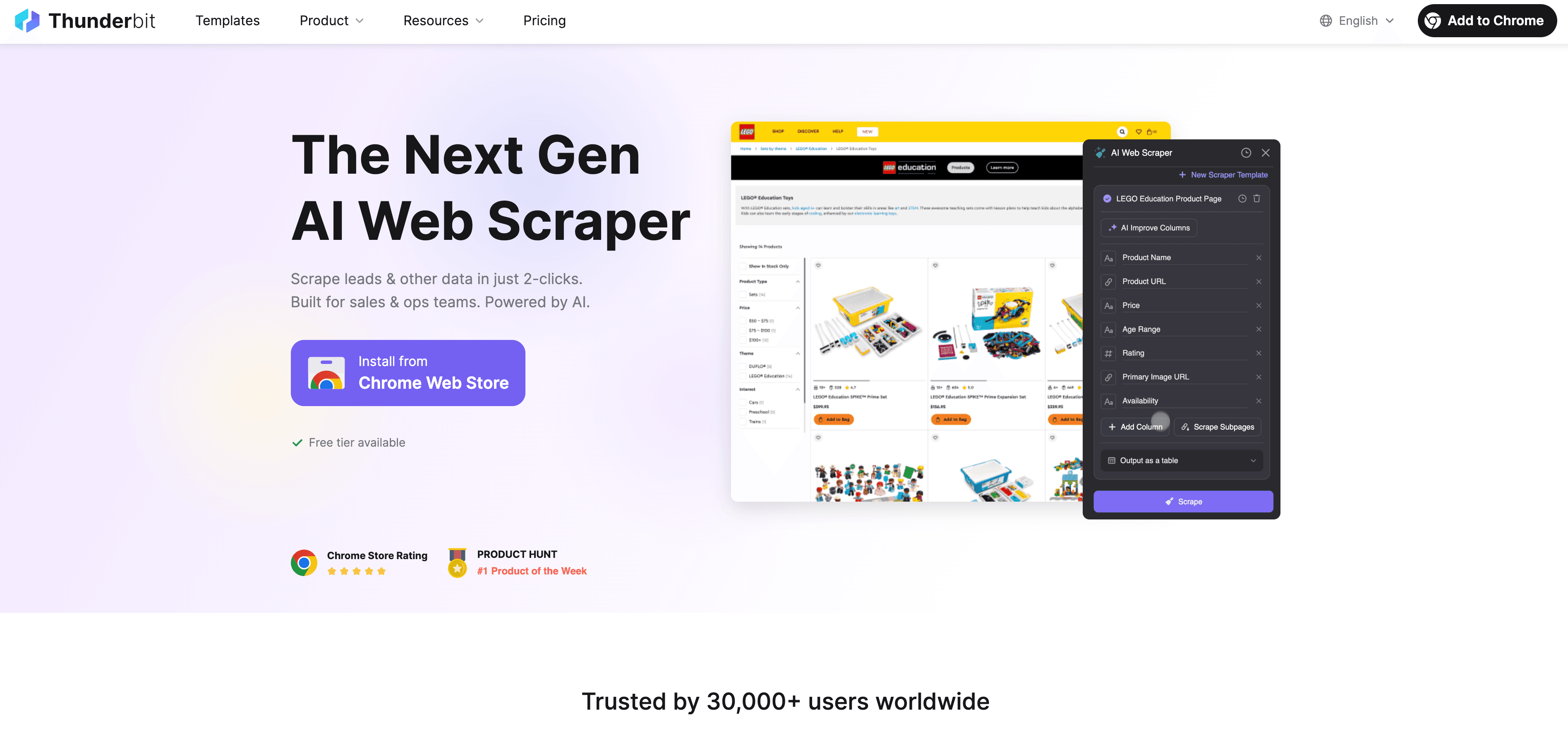

Thunderbit: Die KI-Web-Scraper-Alternative zu Python

Wenn Python an seine Grenzen stößt, übernimmt – ein No-Code, KI-basierter 웹 스크래퍼, der speziell für Business-Anwender entwickelt wurde. Statt dich mit Proxies, Headern und CAPTCHAs herumzuschlagen, liest Thunderbits KI die Webseite, schlägt die besten Felder vor und übernimmt alles von der Unterseiten-Navigation bis zum Datenexport.

Was macht Thunderbit besonders?

- KI-Feldvorschläge: Mit „AI Suggest Fields“ scannt Thunderbit die Seite, empfiehlt Spalten und erstellt sogar Extraktionsanweisungen.

- Unterseiten-Scraping: Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails oder LinkedIn-Profile) und ergänzt deine Tabelle.

- Cloud- oder Browser-Scraping: Wähle die schnellste Methode – Cloud für öffentliche Seiten, Browser für Login-geschützte Inhalte.

- Geplanter Scraper: Lege einen Zeitplan fest – Thunderbit hält deine Daten automatisch aktuell.

- Sofort-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Shopify usw.) gibt’s 1-Klick-Vorlagen – keine Einrichtung nötig.

- Kostenloser Datenexport: Exportiere nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

Thunderbit wird bereits von über eingesetzt – und du musst keine einzige Zeile Code schreiben.

Wie Thunderbit Blockierungen vermeidet und die Datenerfassung automatisiert

Thunderbits KI ahmt nicht nur menschliches Verhalten nach, sondern passt sich jeder Seite in Echtzeit an und minimiert so das Blockierungsrisiko. So funktioniert’s:

- KI passt sich Layout-Änderungen an: Keine kaputten Skripte mehr, wenn sich das Design ändert.

- Unterseiten- und Paginierungs-Handling: Thunderbit folgt automatisch Links und Listen – wie ein echter Nutzer.

- Cloud-Scraping in großem Stil: Bis zu 50 Seiten gleichzeitig, blitzschnell.

- Kein Code, keine Wartung: Du konzentrierst dich auf die Analyse, nicht aufs Debugging.

Mehr dazu im Beitrag .

Python Scraping vs. Thunderbit: Was passt zu dir?

Hier der direkte Vergleich:

| Funktion | Python Scraping | Thunderbit |

|---|---|---|

| Einrichtungsaufwand | Mittel–hoch (Skripte, Proxies etc.) | Gering (2 Klicks, KI übernimmt) |

| Technisches Know-how | Programmierkenntnisse nötig | Kein Coding erforderlich |

| Zuverlässigkeit | Schwankend (anfällig für Änderungen) | Hoch (KI passt sich an) |

| Blockierungsrisiko | Mittel–hoch | Gering (KI imitiert Nutzer, passt sich an) |

| Skalierbarkeit | Eigene Cloud/Code nötig | Integriertes Cloud-/Batch-Scraping |

| Wartung | Häufig (Seitenänderungen, Sperren) | Minimal (KI justiert automatisch) |

| Exportoptionen | Manuell (CSV, DB) | Direkt zu Sheets, Notion, Airtable, CSV |

| Kosten | Kostenlos (zeitintensiv) | Gratis-Tarif, kostenpflichtig für mehr Umfang |

Wann Python nutzen?

- Du brauchst volle Kontrolle, individuelle Logik oder Integration in andere Python-Workflows.

- Du scrapest Seiten mit wenig Anti-Bot-Schutz.

Wann Thunderbit nutzen?

- Du willst schnell, zuverlässig und ohne Setup starten.

- Du scrapest komplexe oder sich oft ändernde Seiten.

- Du möchtest dich nicht mit Proxies, CAPTCHAs oder Code beschäftigen.

Schritt-für-Schritt: Web Scraping ohne Blockierung mit Python einrichten

Ein Praxisbeispiel: Produktdaten von einer Beispielseite scrapen und dabei Anti-Blockierungs-Strategien anwenden.

1. Benötigte Bibliotheken installieren

1pip install requests beautifulsoup4 fake-useragent2. Skript vorbereiten

1import requests

2from bs4 import BeautifulSoup

3from fake_useragent import UserAgent

4import time, random

5ua = UserAgent()

6urls = ["<https://example.com/product/1>", "<https://example.com/product/2>"] # Eigene URLs einfügen

7for url in urls:

8 headers = {

9 "User-Agent": ua.random,

10 "Accept-Language": "de-DE,de;q=0.9"

11 }

12 response = requests.get(url, headers=headers)

13 if response.status_code == 200:

14 soup = BeautifulSoup(response.text, "html.parser")

15 # Daten extrahieren

16 print(soup.title.text)

17 else:

18 print(f"Blockiert oder Fehler bei {url}: {response.status_code}")

19 time.sleep(random.uniform(2, 6)) # Zufällige Pause3. Proxy-Rotation ergänzen (optional)

1proxies = [

2 "<http://proxy1.example.com:8000>",

3 "<http://proxy2.example.com:8000>",

4 # Weitere Proxies

5]

6for i, url in enumerate(urls):

7 proxy = {"http": proxies[i % len(proxies)]}

8 headers = {"User-Agent": ua.random}

9 response = requests.get(url, headers=headers, proxies=proxy)

10 # ...Rest wie oben4. Cookies und Sessions verwalten

1session = requests.Session()

2for url in urls:

3 response = session.get(url, headers=headers)

4 # ...Rest wie oben5. Tipps zur Fehlersuche

- Viele 403/429-Fehler? Anfragen verlangsamen oder neue Proxies testen.

- CAPTCHAs? Selenium oder einen CAPTCHA-Dienst nutzen.

- Immer die

robots.txtund Nutzungsbedingungen der Seite prüfen.

Fazit & wichtigste Erkenntnisse

웹 스크래퍼 mit Python ist mächtig – aber Blockierungen sind ein ständiges Risiko, weil Anti-Bot-Technologien immer besser werden. Die beste Strategie: Technische Best Practices (Proxy-Rotation, smarte Header, zufällige Pausen, Session-Handling, Headless-Browser) mit Respekt für die Regeln und Ethik der Zielseite kombinieren.

Doch manchmal reichen selbst die besten Python-Tricks nicht mehr aus. Dann glänzen KI-Tools wie – sie ermöglichen blockierungsfreies, geschäftstaugliches Scraping ganz ohne Code.

Neugierig, wie einfach Scraping sein kann? und probiere es aus – oder stöbere in unserem für weitere Tipps und Anleitungen.

FAQs

1. Warum blockieren Webseiten Python-Web-Scraper?

Webseiten schützen so ihre Daten, verhindern Serverüberlastung und wollen automatisierten Missbrauch vermeiden. Python-Skripte sind leicht zu erkennen, wenn sie Standard-Header nutzen, keine Cookies verwalten oder zu viele Anfragen senden.

2. Was sind die effektivsten Methoden, um beim Scraping mit Python nicht geblockt zu werden?

Rotierende Proxies, realistische User-Agents und Header, zufällige Anfragerhythmen, Session-Management und das Simulieren menschlichen Verhaltens mit Selenium oder Playwright.

3. Wie hilft Thunderbit, Blockierungen im Vergleich zu Python-Skripten zu vermeiden?

Thunderbit nutzt KI, um sich an Seitenlayouts anzupassen, menschliches Surfen zu imitieren und Unterseiten sowie Paginierungen automatisch zu handhaben. So sinkt das Blockierungsrisiko – ganz ohne Code oder Proxies.

4. Wann sollte ich Python-Scraping und wann ein KI-Tool wie Thunderbit nutzen?

Python eignet sich für individuelle Logik, Integration in andere Python-Prozesse oder einfache Seiten. Thunderbit ist ideal für schnelles, zuverlässiges und skalierbares Scraping – besonders bei komplexen, sich oft ändernden oder stark geschützten Seiten.

5. Ist Web Scraping legal?

Web Scraping ist für öffentlich zugängliche Daten legal, solange du die Nutzungsbedingungen, Datenschutzrichtlinien und geltende Gesetze beachtest. Niemals sensible oder private Daten scrapen und immer verantwortungsvoll handeln.

Bereit für intelligenteres Scraping? Probier Thunderbit aus und lass Blockierungen hinter dir.

Mehr erfahren:

- Google News Scraping mit Python: Schritt-für-Schritt-Anleitung

- Preis-Tracker für Best Buy mit Python bauen

- 14 Wege für Web Scraping ohne Blockierung

- 10 Top-Tipps, um beim Web Scraping nicht geblockt zu werden