Web Scraping ist mittlerweile ein echter Geheimtipp für alle Teams, die im Wettbewerb vorne mitspielen wollen – egal ob im Vertrieb, Operations, E-Commerce oder in der Immobilienbranche. Das Internet ist eine riesige Schatzkiste voller Daten, aber diese zu extrahieren – vor allem von dynamischen und interaktiven Webseiten – ist oft alles andere als simpel. Bis 2025 soll Web Scraping sogar einen globalen Markt von fast erreichen, und setzen schon heute auf Datenanalysen für ihre Entscheidungen. Doch je moderner Webseiten werden – mit endlosem Scrollen, Pop-ups und Inhalten, die erst durch JavaScript geladen werden – stoßen klassische Scraping-Tools schnell an ihre Grenzen.

Genau hier kommt Selenium ins Spiel. Selenium ist so etwas wie das Schweizer Taschenmesser unter den Web-Scraping-Tools: Es automatisiert echte Browser-Aktionen und kann selbst von den komplexesten, dynamischen Seiten Daten abgreifen. Wenn du dir schon mal gewünscht hast, einfach wie ein echter User durch eine Seite zu klicken und die Infos einzusammeln, ist Selenium das perfekte Werkzeug. In diesem Guide zeige ich dir Schritt für Schritt, wie du mit Selenium web scraping meisterst – ganz ohne Informatikstudium.

Was ist Web Scraping mit Selenium? Einfach erklärt

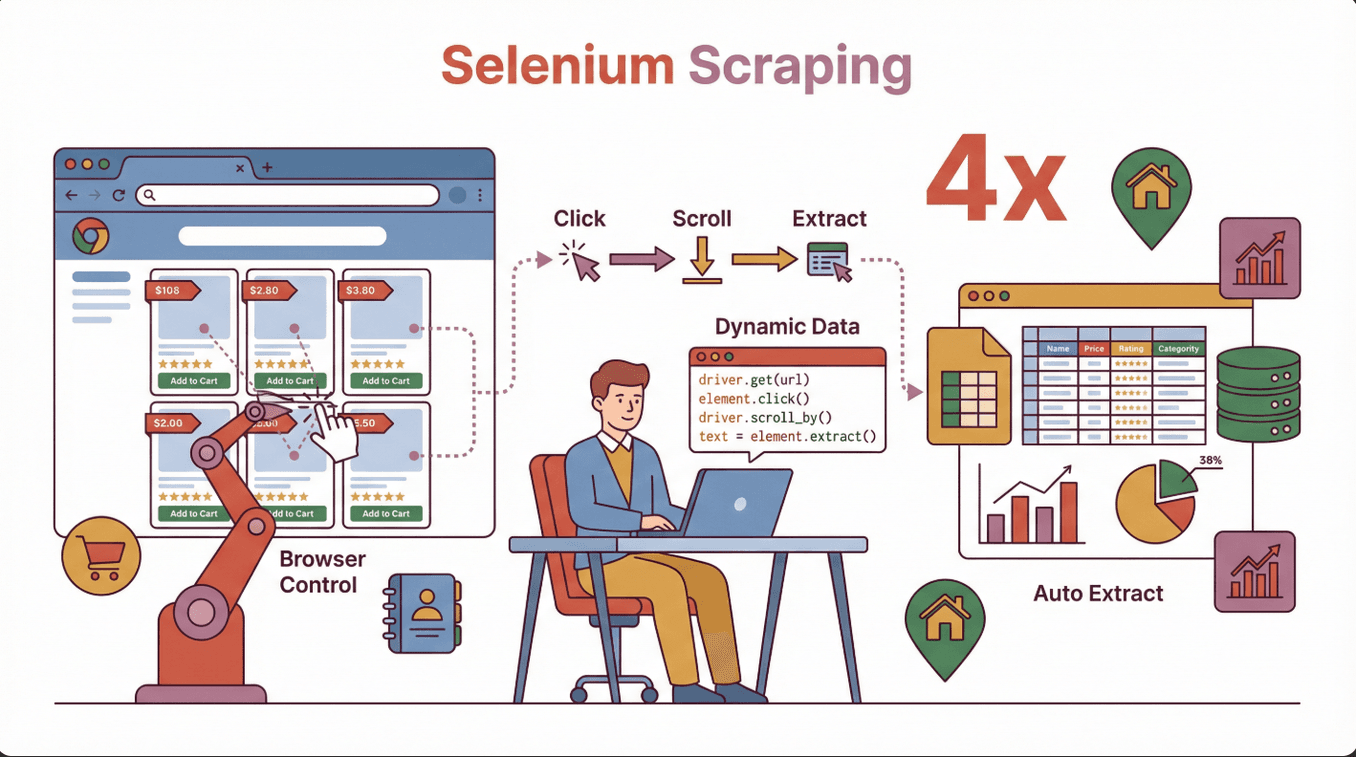

Kurz gesagt: Web Scraping mit Selenium bedeutet, dass du mit der Selenium-Bibliothek einen echten Webbrowser (wie Chrome oder Firefox) per Code steuerst und dabei menschliche Aktionen nachahmst – also Buttons klickst, Formulare ausfüllst, scrollst und vieles mehr. Im Gegensatz zu klassischen Scrapern, die nur statisches HTML lesen, kann Selenium mit Webseiten interagieren wie ein echter Nutzer. Das macht es ideal, um Daten von Seiten zu holen, die Inhalte erst nachträglich per JavaScript laden.

Kurz gesagt: Web Scraping mit Selenium bedeutet, dass du mit der Selenium-Bibliothek einen echten Webbrowser (wie Chrome oder Firefox) per Code steuerst und dabei menschliche Aktionen nachahmst – also Buttons klickst, Formulare ausfüllst, scrollst und vieles mehr. Im Gegensatz zu klassischen Scrapern, die nur statisches HTML lesen, kann Selenium mit Webseiten interagieren wie ein echter Nutzer. Das macht es ideal, um Daten von Seiten zu holen, die Inhalte erst nachträglich per JavaScript laden.

Typische Anwendungsfälle für Selenium:

- E-Commerce: Produktlisten, Preise und Bewertungen von Seiten extrahieren, die Daten erst beim Scrollen nachladen.

- Vertrieb & Lead-Generierung: Kontaktdaten aus Verzeichnissen holen, die Login oder mehrere Navigationsschritte erfordern.

- Immobilien: Immobiliendetails von interaktiven Karten oder Listings hinter Pop-ups sammeln.

- Marktforschung: Wettbewerbsdaten von modernen, app-ähnlichen Webseiten erfassen.

Wenn dein Scraping-Tool mal wieder nur die Hälfte der Daten findet, liegt das meist daran, dass die Infos erst nach dem Laden der Seite erscheinen – Selenium löst dieses Problem, indem es wartet, klickt und interagiert wie ein echter User ().

Warum Selenium fürs Web Scraping? Tool-Vergleich

Es gibt viele Web-Scraping-Tools – BeautifulSoup, Scrapy, und mehr. Warum also Selenium? Hier die wichtigsten Unterschiede:

| Tool | Am besten geeignet für | JavaScript-Unterstützung? | Interaktivität | Geschwindigkeit | Benutzerfreundlichkeit |

|---|---|---|---|---|---|

| Selenium | Dynamische, interaktive Seiten | Ja | Vollständig | Langsamer | Mittel |

| BeautifulSoup | Einfache, statische HTML-Seiten | Nein | Keine | Schnell | Einfach |

| Scrapy | Großprojekte, statische oder halb-dynamische Seiten | Eingeschränkt (mit Plugins) | Eingeschränkt | Sehr schnell | Mittel |

| Thunderbit | Schnelle, No-Code-Extraktion für Unternehmen | Ja (KI-gestützt) | Eingeschränkt | Schnell | Sehr einfach |

Stärken von Selenium:

- Kommt mit JavaScript-lastigen Seiten, endlosem Scrollen und Pop-ups klar.

- Kann sich einloggen, Buttons klicken und Formulare ausfüllen – wie ein Mensch.

- Perfekt, wenn Daten erst nach Nutzeraktionen erscheinen.

Wann solltest du Selenium nutzen?

- Die gewünschten Daten werden erst nach dem Laden der Seite angezeigt (z. B. durch JavaScript).

- Du musst mit der Seite interagieren (Login, Klicks, Scrollen).

- Die Seite nutzt komplexe Layouts oder Single-Page-Application-Frameworks.

Wann sind andere Tools besser?

- Die Seite ist statisch und einfach – dann sind BeautifulSoup oder Scrapy schneller.

- Du willst ohne Programmieren schnell Daten extrahieren – Thunderbit ist ideal für schnelle Ergebnisse ().

Selenium installieren & einrichten: So startest du ohne Stress

Der Einstieg mit Selenium wirkt oft komplizierter als er ist. Mit dieser Anleitung bist du in wenigen Schritten startklar – ohne Stolperfallen.

1. Python installieren (falls noch nicht geschehen)

Die meisten Selenium-Tutorials nutzen Python, aber auch Java, C# und andere Sprachen sind möglich. Lade Python von herunter.

2. Selenium mit pip installieren

Öffne das Terminal oder die Eingabeaufforderung und gib ein:

1pip install selenium()

3. Browser-Treiber herunterladen

Selenium braucht einen „Driver“, um den Browser zu steuern. Für Chrome ist das der ChromeDriver, für Firefox der GeckoDriver.

- Browser-Version herausfinden: In Chrome unter

chrome://settings/helpnachsehen. - Passenden Treiber herunterladen: .

- Treiber entpacken und ablegen: Lege den Treiber in einen Ordner und füge den Pfad zur Systemumgebung PATH hinzu.

Tipp: Die Treiberversion muss exakt zur Browserversion passen. Bei Abweichungen gibt es Fehler wie chromedriver executable needs to be available in the path ().

4. Teste deine Installation

Probiere folgenden Python-Code:

1from selenium import webdriver

2driver = webdriver.Chrome() # Oder Firefox()

3driver.get("https://www.google.com")

4print(driver.title)

5driver.quit()Wenn sich der Browser öffnet und der Titel ausgegeben wird, ist alles bereit!

Häufige Fehlerquellen:

- PATH nicht korrekt gesetzt – prüfe die Umgebungsvariablen.

- Treiber- und Browserversion passen nicht zusammen – immer beide aktualisieren.

- Rechteprobleme – auf Mac/Linux ggf.

chmod +x chromedriverausführen.

Dein erstes Selenium-Web-Scraping-Skript: Schritt für Schritt

Wir schreiben ein einfaches Skript, das Produktnamen von einer Beispiel-E-Commerce-Seite extrahiert. So geht’s:

1. Selenium importieren und Driver einrichten

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()2. Zielseite öffnen

1driver.get("https://example-ecommerce.com/products")3. Auf das Laden der Inhalte warten (falls nötig)

Für dynamische Inhalte empfiehlt sich ein explizites Warten:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3wait = WebDriverWait(driver, 10)

4wait.until(EC.presence_of_element_located((By.CLASS_NAME, "product-title")))4. Daten extrahieren

1products = driver.find_elements(By.CLASS_NAME, "product-title")

2for product in products:

3 print(product.text)5. Aufräumen

1driver.quit()Was passiert hier? Selenium öffnet den Browser, wartet auf das Laden der Produkte, sammelt alle Elemente mit der Klasse product-title und gibt deren Text aus.

Praktische Tipps für dynamische Inhalte mit Selenium

Dynamische Webseiten sind heute Standard – mit endlosem Scrollen, Pop-ups und Inhalten, die erst nach Klicks erscheinen. So gehst du damit um:

1. Auf Elemente warten

Webseiten laden nicht immer sofort. Mit expliziten Waits wartest du, bis die Daten da sind:

1wait.until(EC.presence_of_element_located((By.ID, "dynamic-content")))2. Scrollen, um mehr zu laden

Für Seiten mit unendlichem Scrollen:

1driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")Wiederhole das, um weitere Daten zu laden.

3. Pop-ups schließen

Pop-ups finden und schließen:

1try:

2 close_button = driver.find_element(By.CLASS_NAME, "close-popup")

3 close_button.click()

4except:

5 pass # Kein Pop-up gefunden4. Mit Formularen und Buttons interagieren

Suchfelder ausfüllen oder „Weiter“-Buttons klicken:

1search_box = driver.find_element(By.NAME, "search")

2search_box.send_keys("laptop")

3search_box.submit()Praxisbeispiel: Immobilienanzeigen, die beim Scrollen nachgeladen werden, oder Produktbewertungen, die erst nach Klick auf einen Tab erscheinen.

Typische Fehlerquellen beim Selenium Web Scraping und wie du sie löst

Auch erfahrene Scraper stoßen auf Probleme. Hier die häufigsten Stolpersteine – und wie du sie umgehst:

| Problem | Lösung |

|---|---|

| Element nicht gefunden | Wartezeiten nutzen, Selektoren prüfen, andere Suchstrategien ausprobieren |

| Timeout-Fehler | Wartezeit erhöhen, auf langsame Inhalte achten |

| CAPTCHA oder Bot-Erkennung | Anfragen verlangsamen, Aktionen variieren, ggf. Proxies nutzen |

| Treiber-/Browser-Mismatch | Beide auf kompatible Versionen aktualisieren |

| Website-Layout ändert sich | Selektoren und Skripte regelmäßig anpassen |

| Langsame Performance | Browseraktionen minimieren, Headless-Modus nutzen, wenn möglich |

Tipp: Selenium ist langsamer als andere Tools, weil es echte Nutzeraktionen simuliert (). Für große Datenmengen solltest du Alternativen prüfen oder die Arbeit aufteilen.

So nutzt du deine extrahierten Daten weiter

Sind die Daten gesammelt, willst du sie natürlich weiterverwenden. Hier ein schneller Workflow:

1. Daten in einer Liste oder DataFrame speichern

1import pandas as pd

2data = []

3for product in products:

4 data.append({"name": product.text})

5df = pd.DataFrame(data)2. Export als CSV oder Excel

1df.to_csv("products.csv", index=False)

2# Oder

3df.to_excel("products.xlsx", index=False)()

3. Integration mit Business-Tools

- Importiere deine CSV in Google Sheets oder Airtable.

- Automatisiere Datenflüsse mit Zapier oder APIs.

Hinweis: Bereinige inkonsistente Formate und fehlende Werte vor dem Import ().

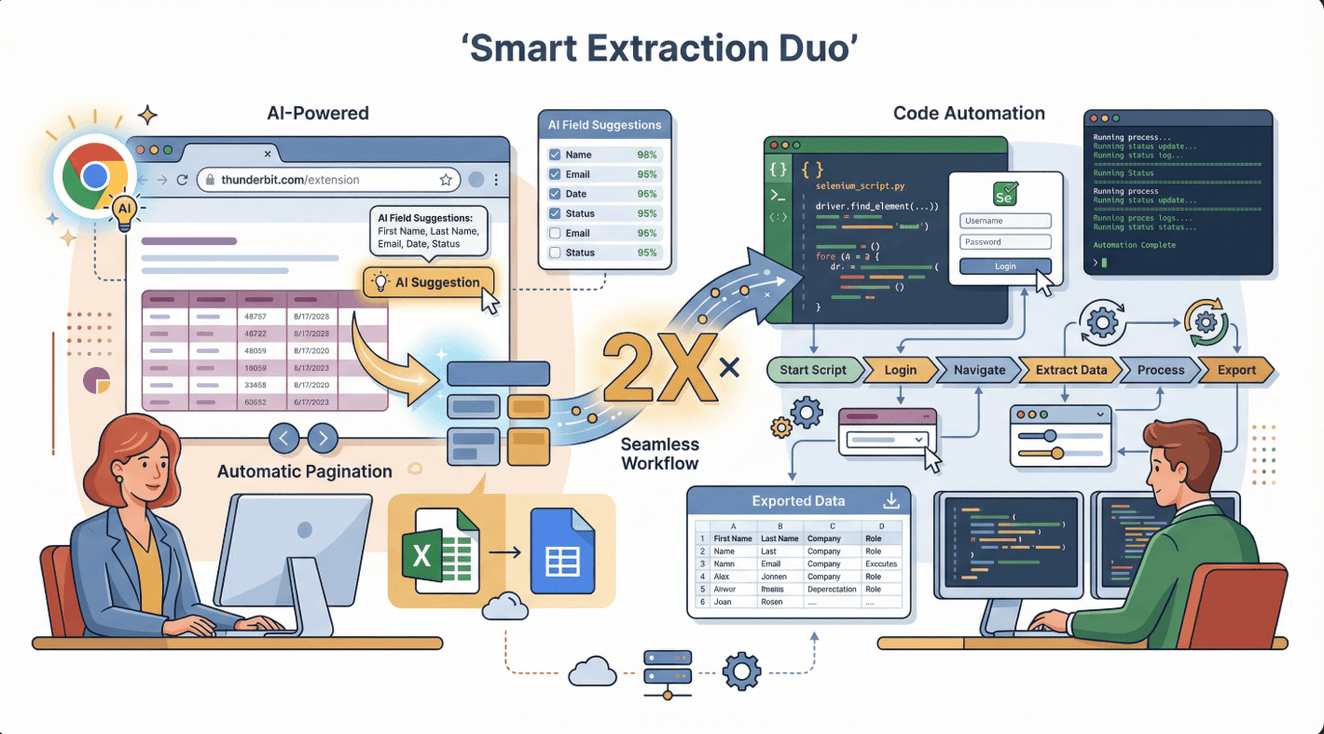

Selenium & Thunderbit: Das perfekte Duo für komplexe Datenextraktion

Selenium ist mächtig, aber nicht immer die schnellste oder einfachste Lösung. Hier kommt ins Spiel: Die KI-gestützte Web-Scraper Chrome Extension extrahiert Daten von den meisten Webseiten mit nur wenigen Klicks – ganz ohne Programmierung oder komplizierte Einrichtung.

Selenium ist mächtig, aber nicht immer die schnellste oder einfachste Lösung. Hier kommt ins Spiel: Die KI-gestützte Web-Scraper Chrome Extension extrahiert Daten von den meisten Webseiten mit nur wenigen Klicks – ganz ohne Programmierung oder komplizierte Einrichtung.

Wie ergänzen sich die Tools?

- Thunderbit ist perfekt für schnelle, strukturierte Datenerfassung aus Tabellen, Listen oder einfachen Seiten. Ideal für Vertrieb, E-Commerce oder Research, wenn es schnell gehen soll.

- Selenium ist die Wahl, wenn du komplexe Interaktionen automatisieren musst – etwa Logins, mehrstufige Abläufe oder Daten, die erst nach Nutzeraktionen erscheinen.

Profi-Workflow: Starte mit Thunderbit für die einfachen Fälle. Wenn du auf Hürden wie Logins oder interaktive Inhalte stößt, übernimm mit Selenium. Du kannst sogar Thunderbit-Daten exportieren und in Selenium-Skripte für weitergehende Analysen einbinden.

Vorteile von Thunderbit:

- KI-gestützte Feldvorschläge – einfach auf „KI Felder vorschlagen“ klicken und loslegen.

- Unterstützt Paginierung, Unterseiten und Export direkt nach Excel, Google Sheets, Notion oder Airtable.

- Kein Wartungsaufwand – die KI passt sich automatisch an Webseitenänderungen an ().

Rechtlich sicher: Legal & ethisch Web Scraping mit Selenium

Web Scraping ist ein mächtiges Werkzeug, bringt aber auch Verantwortung mit sich. So bleibst du auf der sicheren Seite:

1. Nutzungsbedingungen der Website prüfen

Lies immer die Nutzungsbedingungen, bevor du eine Seite scrapest. Manche Seiten verbieten Scraping ausdrücklich, andere erlauben es für den Privatgebrauch ().

2. robots.txt respektieren

Die Datei robots.txt gibt an, was gecrawlt oder gescrapet werden darf. Du findest sie unter https://website.com/robots.txt ().

3. Keine sensiblen oder persönlichen Daten sammeln

Verzichte auf das Scrapen von Gesundheits-, Finanz- oder privaten Daten – das kann rechtliche Konsequenzen haben ().

4. Fair bleiben: Anfragen begrenzen & identifizieren

Überlaste keine Server – setze Pausen zwischen den Anfragen und identifiziere deinen Scraper, wenn möglich.

5. Offizielle APIs bevorzugen

Wenn eine Seite eine öffentliche API anbietet, nutze diese – das ist der sicherste und zuverlässigste Weg.

Checkliste für rechtssicheres Scraping:

- [ ] Nutzungsbedingungen und robots.txt lesen und befolgen.

- [ ] Nur öffentliche, nicht-sensible Daten scrapen.

- [ ] Anfragerate begrenzen und die Seite nicht stören.

- [ ] Datenquellen angeben, falls gefordert.

- [ ] Über lokale Gesetze und Vorschriften informiert bleiben ().

Skalieren: Wann du über Selenium hinauswachsen solltest

Selenium ist super für kleine bis mittlere Projekte, hat aber auch Grenzen:

Einschränkungen:

- Langsamer als andere Tools (weil ein echter Browser läuft).

- Ressourcenintensiv – viele Browser gleichzeitig können den Rechner ausbremsen.

- Nicht ideal, um tausende Seiten in kurzer Zeit zu scrapen.

Wann solltest du upgraden?

- Du willst im großen Stil scrapen (tausende oder Millionen Seiten).

- Du möchtest Scraping automatisiert in der Cloud oder nach Zeitplan ausführen.

- Du brauchst Features wie Proxy-Rotation, Wiederholungen oder verteiltes Scraping.

Alternativen:

- Thunderbit: Für Business-User, die schnell und ohne Code mit KI scrapen wollen ().

- Scrapy: Für Entwickler, die große, verteilte Scraper bauen ().

- Managed APIs: Dienste wie ScraperAPI oder Apify für skalierbares, automatisiertes Scraping ().

| Tool | Am besten für | Vorteile | Nachteile |

|---|---|---|---|

| Selenium | Komplexe, interaktive | Kommt mit jeder Seite klar, volle Kontrolle | Langsam, ressourcenintensiv |

| Thunderbit | Schnelle Business-Jobs | Kein Code, KI, einfacher Export | Weniger Kontrolle für Profis |

| Scrapy | Großprojekte, Entwickler | Schnell, skalierbar, anpassbar | Programmierkenntnisse nötig, weniger Interaktivität |

| Managed APIs | Unternehmen, Automatisierung | Skalierbar, wartungsfrei | Kosten, weniger Flexibilität |

Fazit & wichtigste Erkenntnisse

Web Scraping mit Selenium ist ein echter Gamechanger, wenn du Daten von dynamischen, interaktiven Webseiten brauchst. Es ist das Tool der Wahl, wenn du echte Nutzeraktionen wie Klicken, Scrollen oder Logins nachbilden musst. Das solltest du dir merken:

- Selenium eignet sich besonders für: Dynamische Seiten, JavaScript-Inhalte und interaktive Abläufe.

- Installations-Tipps: Browser- und Treiberversionen abgleichen, PATH korrekt setzen und bei dynamischen Inhalten mit Waits arbeiten.

- Kombiniere mit Thunderbit: Für schnelle, No-Code-Extraktion Thunderbit nutzen; für komplexe Abläufe Selenium einsetzen.

- Rechtlich sicher bleiben: Immer Nutzungsbedingungen, robots.txt und Datenschutz beachten.

- Clever skalieren: Für große Projekte auf Managed APIs oder Cloud-Tools umsteigen.

Wenn du gerade erst anfängst, probiere ein einfaches Selenium-Skript, um Produktnamen oder Preise zu scrapen. Teste dann Thunderbit für dein nächstes Business-Datenprojekt – es ist kostenlos und spart dir jede Menge Zeit ().

Du willst tiefer einsteigen? Schau im vorbei für weitere Web-Scraping-Guides oder abonniere unseren für Schritt-für-Schritt-Anleitungen.

FAQs

1. Was unterscheidet Selenium von anderen Web-Scraping-Tools?

Selenium steuert einen echten Browser und kann so mit dynamischen, JavaScript-lastigen Seiten interagieren – etwas, das klassische Scraper wie BeautifulSoup nicht können. Ideal für Seiten, die Nutzeraktionen wie Klicks oder Logins erfordern.

2. Was sind die häufigsten Fehler bei der Einrichtung von Selenium?

Die größten Stolpersteine sind nicht zueinander passende Browser- und Treiberversionen, ein fehlender Treiber im PATH und fehlende Waits für dynamische Inhalte. Immer Versionen prüfen und explizite Waits nutzen.

3. Kann ich Selenium und Thunderbit zusammen verwenden?

Auf jeden Fall. Thunderbit ist super für schnelle, No-Code-Extraktion, während Selenium komplexe, interaktive Abläufe übernimmt. Viele Teams nutzen Thunderbit für einfache Daten und Selenium für anspruchsvolle Aufgaben.

4. Ist Web Scraping mit Selenium legal?

Web Scraping ist legal, solange du die Nutzungsbedingungen beachtest, robots.txt respektierst, keine sensiblen Daten sammelst und Server nicht überlastest. Prüfe immer die lokalen Gesetze und scrape verantwortungsvoll.

5. Wann sollte ich für Web Scraping über Selenium hinausgehen?

Wenn du tausende Seiten schnell scrapen oder Scraping in der Cloud automatisieren willst, sind Tools wie Thunderbit, Scrapy oder Managed APIs besser geeignet. Selenium ist ideal für kleine bis mittlere, interaktive Projekte.

Bereit, Web Scraping zu meistern? Probiere Selenium für dein nächstes Projekt aus – und entdecke Thunderbit für die schnellste Art, Geschäftsdaten aus dem Web zu holen.

Mehr erfahren