Web Scraping ist mittlerweile ein echter Geheimtipp für smarte Unternehmen geworden. Egal ob im Vertrieb, in der Organisation oder beim Beobachten der Konkurrenz – gezielt Daten von Webseiten zu sammeln, ist heute einfach Pflicht. Was hat sich in letzter Zeit verändert? Das Web ist viel dynamischer geworden: Interaktive Dashboards, endloses Scrollen und Inhalte, die erst nach einem Klick erscheinen, sind heute Standard. Im Mittelpunkt steht dabei JavaScript – die Sprache, die fast alles steuert, was du im Web siehst (und auch das, was du nicht siehst).

Aus meiner langjährigen Erfahrung im SaaS- und Automatisierungsbereich habe ich gesehen, wie JavaScript und Node.js von „nice-to-have“-Tools zu echten Must-haves für die Datengewinnung geworden sind. Die Zahlen sprechen für sich: , und der Markt für Web-Scraping wächst rasant weiter (). In diesem Guide zeige ich dir, was Web Scraping mit JavaScript und Node.js wirklich bedeutet, warum es so wichtig ist und – vor allem – wie auch Nicht-Programmierer mit Tools wie davon profitieren können. Egal ob du technisch fit bist oder nicht: Es war noch nie so einfach, das Chaos des Webs in wertvolle Geschäftsdaten zu verwandeln.

Was ist Web Scraping mit JavaScript? Die Basics auf einen Blick

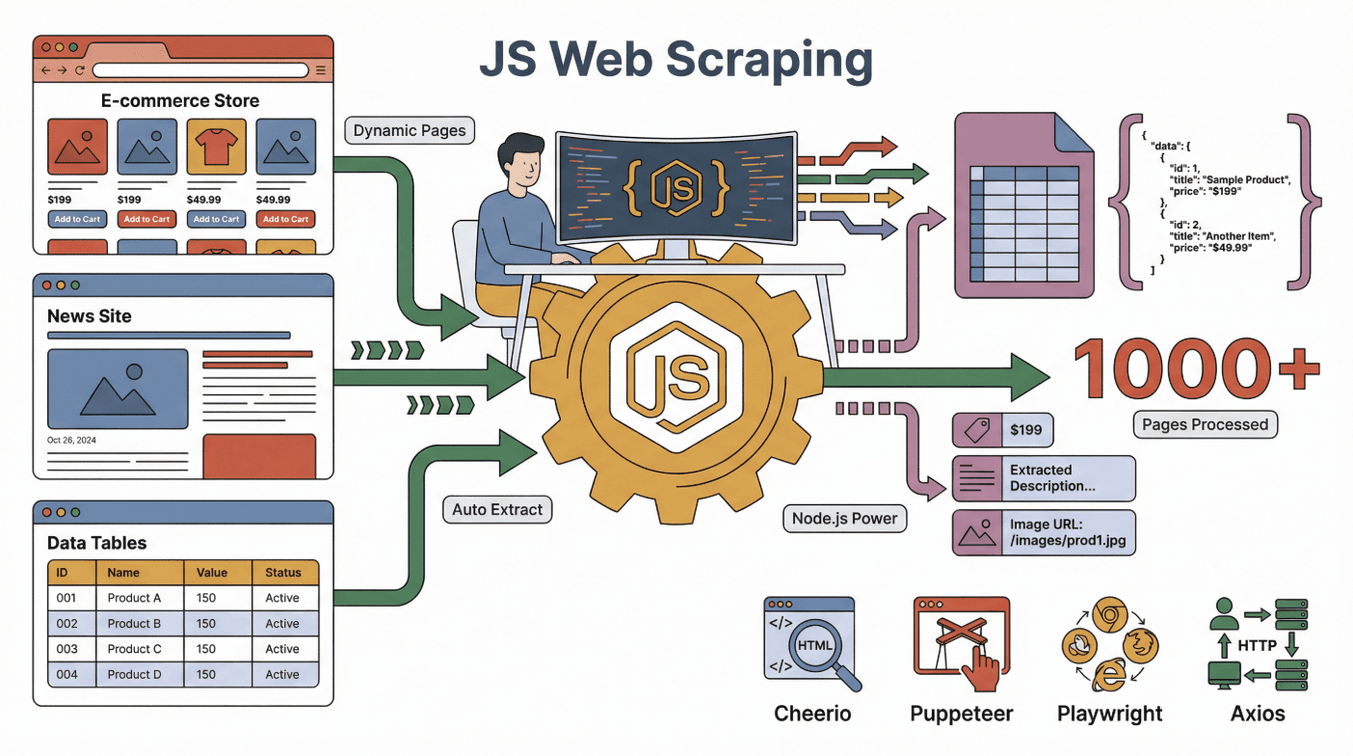

Fangen wir ganz von vorne an. Web Scraping mit JavaScript heißt, dass du mit JavaScript (oft zusammen mit Node.js) automatisiert Daten von Webseiten sammelst. Stell dir vor, du schickst einen digitalen Assistenten auf eine Website, der die Seite liest und die Infos, die du brauchst, in eine Tabelle schreibt – nur dass dieser Assistent tausende Seiten in Rekordzeit abarbeiten kann, nie müde wird und sogar mit Buttons und Formularen umgehen kann.

Fangen wir ganz von vorne an. Web Scraping mit JavaScript heißt, dass du mit JavaScript (oft zusammen mit Node.js) automatisiert Daten von Webseiten sammelst. Stell dir vor, du schickst einen digitalen Assistenten auf eine Website, der die Seite liest und die Infos, die du brauchst, in eine Tabelle schreibt – nur dass dieser Assistent tausende Seiten in Rekordzeit abarbeiten kann, nie müde wird und sogar mit Buttons und Formularen umgehen kann.

JavaScript ist hier besonders stark, weil es die Sprache ist, mit der Browser Webseiten aufbauen und aktualisieren. Mit Node.js kannst du JavaScript auch außerhalb des Browsers laufen lassen und so Aufgaben wie diese automatisieren:

- Eine Webseite laden (auch wenn sie dynamisch oder interaktiv ist)

- Buttons klicken, scrollen oder warten, bis Inhalte erscheinen

- Texte, Bilder, Preise, E-Mails oder andere sichtbare Daten extrahieren

Die beliebtesten Tools für Web Scraping mit JavaScript sind:

- : Perfekt, um statisches HTML zu parsen und auszulesen (wie jQuery, aber für den Server).

- : Steuert einen echten Chrome-Browser – ideal für dynamische Seiten, die Interaktion brauchen.

- : Ähnlich wie Puppeteer, aber noch flexibler für browserübergreifende Automatisierung.

- : Schickt HTTP-Anfragen, um Webseiten oder APIs abzurufen.

Die eigentliche Magie entsteht, wenn du diese Tools kombinierst: Axios oder Puppeteer lädt die Seite, Cheerio analysiert das HTML und Node.js hält alles zusammen.

Statische vs. dynamische Seiten: Warum JavaScript so wichtig ist

- Statische Seiten: Der Inhalt ist fest und wird direkt mit der Seite geladen. Mit einfachen Tools leicht zu scrapen.

- Dynamische Seiten: Inhalte werden erst nachträglich per JavaScript geladen. Hier brauchst du Browser-Automatisierung (wie Puppeteer), um die Daten zu sehen und zu extrahieren ().

Da immer mehr Websites auf dynamische Inhalte setzen (z. B. Amazon, LinkedIn, Zillow), ist JavaScript-basiertes Scraping heute der Goldstandard, um wirklich relevante Daten zu bekommen.

Warum JavaScript fürs Web Scraping? Die wichtigsten Vorteile im Vergleich

In Entwicklerforen wird oft diskutiert: JavaScript vs. Python vs. Ruby vs. Go fürs Web Scraping. Hier meine Einschätzung aus der Praxis:

Die Stärken von JavaScript

- Dynamische Inhalte nativ verarbeiten: Weil JavaScript die Sprache des Browsers ist, kommt es mit modernen, JavaScript-lastigen Seiten besonders gut klar ().

- Browser-Automatisierung: Mit Tools wie Puppeteer und Playwright kannst du Klicks, Scrolls und Formulare wie ein echter User ausführen.

- Vertrautheit im Frontend: Wer schon mit JavaScript im Web arbeitet, kann dieses Wissen direkt fürs Scraping nutzen ().

- Gleichzeitigkeit und Speed: Node.js kann viele Aufgaben parallel erledigen – ideal, um große Datenmengen schnell zu erfassen ().

- Riesiges Ökosystem: Tausende Bibliotheken, Tutorials und eine starke Community.

Wie schlägt sich JavaScript im Vergleich zu Python, Ruby und Go?

| Sprache | Dynamische Inhalte | Browser-Automatisierung | Community | Geschwindigkeit | Ideal für |

|---|---|---|---|---|---|

| JavaScript | Hervorragend | Hervorragend | Riesig | Schnell | Interaktive Seiten, Frontend-Teams |

| Python | Gut (mit Selenium/Playwright) | Gut | Riesig | Schnell | APIs, statische Seiten, Data Science |

| Ruby | Befriedigend | Eingeschränkt | Nische | Mittel | Einfache statische Scrapes |

| Go | Eingeschränkt | Eingeschränkt | Wächst | Sehr schnell | Hochskalige Backend-Scrapes |

Für moderne, interaktive Webseiten ist JavaScript (mit Node.js) oft die beste Wahl (). Python ist eine starke Alternative, aber bei stark JavaScript-basierten Seiten kommt nichts an JavaScript selbst ran ().

Die wichtigsten Tools für Web Scraping mit JavaScript und Node.js

Hier die zentralen Bausteine für JavaScript-Scraping:

- Node.js: Die Plattform, um JavaScript außerhalb des Browsers auszuführen – quasi das Steuerzentrum.

- Cheerio: Zum Parsen von HTML und gezielten Auslesen von Elementen (z. B. „alle Produktnamen auf dieser Seite“).

- Puppeteer/Playwright: Steuern einen echten Browser, um dynamische Inhalte, Logins und komplexe Interaktionen zu meistern.

- Axios/Fetch: Zum Abrufen von Webseiten oder APIs.

- Weitere Helfer: Bibliotheken für den Datenexport (CSV, Excel), Proxy-Handling oder geplante Scrapes.

Wie greifen diese Tools ineinander? Stell dir Puppeteer als deinen Roboter-Browser vor, Cheerio als Daten-Detektiv und Node.js als Projektmanager, der alles koordiniert.

So funktioniert Web Scraping mit JavaScript: Schritt für Schritt

So läuft ein typischer JavaScript-Web-Scraping-Prozess ab:

- Anfrage senden: Mit Axios oder Puppeteer die Webseite laden.

- Auf Inhalte warten: Bei dynamischen Seiten warten, bis JavaScript alles geladen hat (Puppeteer „sieht“ die fertige Seite).

- Daten extrahieren: Mit Cheerio oder Browser-APIs gezielt die gewünschten Daten auslesen.

- Paginierung/Unterseiten: „Weiter“-Klicks oder Links folgen, um mehr Daten zu sammeln.

- Daten exportieren: Ergebnisse als CSV, Excel, Google Sheets oder in eine Datenbank speichern.

Vergleich: Es ist, als würde ein hochmotivierter Praktikant jede Seite besuchen, Notizen machen und alles ordentlich in eine Tabelle eintragen.

Statische vs. dynamische Inhalte: Wo liegt der Unterschied?

- Statisches Beispiel: Ein Blog, bei dem alle Artikel direkt im HTML stehen. Cheerio + Axios reichen völlig aus.

- Dynamisches Beispiel: Ein Onlineshop, bei dem Preise erst nach dem Scrollen erscheinen. Hier brauchst du Puppeteer oder Playwright, um die finalen Preise zu erfassen ().

Tipp: Wenn beim Scraping eine leere Seite erscheint, ist sie wahrscheinlich dynamisch – dann hilft Puppeteer weiter.

Thunderbit: No-Code Web Scraping mit JavaScript-Power

Jetzt wird’s spannend – vor allem für alle, die nicht programmieren. Mit haben wir es uns zur Aufgabe gemacht, Web Scraping auf JavaScript-Niveau für alle zugänglich zu machen – nicht nur für Entwickler.

Unser Ansatz: Dein Web-Scraper sollte Aufgaben „wie ein Praktikant verstehen“ – du beschreibst, was du brauchst, und die KI erledigt den Rest.

So macht Thunderbit JavaScript-Scraping für alle nutzbar

- KI-Feldvorschläge: Ein Klick genügt – Thunderbits KI scannt die Seite, schlägt relevante Datenfelder vor und richtet den Scraper automatisch ein.

- Unterseiten-Scraping: Du brauchst mehr Details? Thunderbit besucht automatisch jede Unterseite (z. B. Produkt- oder Profilseiten) und ergänzt deine Tabelle.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, Shopify) einfach eine Vorlage auswählen und loslegen – ganz ohne Einrichtung.

- Kostenloser Datenexport: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

Praxisbeispiel: Vertriebsteams nutzen Thunderbit, um in wenigen Klicks hunderte Leads aus dynamischen Verzeichnissen samt E-Mail und Telefonnummer zu sammeln – ganz ohne Programmieraufwand. Es ist, als hättest du einen JavaScript-Entwickler im Team, nur ohne Recruiting.

Typische Anwendungsfälle: Web Scraping mit JavaScript im Vertrieb und in der Organisation

JavaScript-Web-Scraping ist längst nicht nur etwas für Technik-Fans. So setzen echte Teams es täglich ein:

| Team | Anwendungsfall | Ergebnis |

|---|---|---|

| Vertrieb | Lead-Generierung aus Verzeichnissen | 10x mehr Leads, direkt für CRM nutzbar |

| E-Commerce | Preisüberwachung bei Wettbewerbern | Dynamische Preisgestaltung, schnellere Reaktion |

| Operations | Bestandsaggregation | Einheitliche Übersicht über alle Lieferanten |

| Immobilien | Zusammenführung von Immobilienangeboten | Aktuelle Marktdaten in einer Tabelle |

| Marketing | Analyse von Bewertungen und Stimmungen | Schnellere Insights, gezieltere Kampagnen |

Beispiel: Ein E-Commerce-Team hat mit Thunderbit über 20 Stunden pro Woche gespart, weil es Wettbewerberpreise automatisch abruft und so die eigenen Preise fast in Echtzeit anpassen kann ().

Ethische und rechtliche Aspekte beim Web Scraping mit JavaScript

Jetzt zum wichtigen Thema: Ist Web Scraping legal? Die kurze Antwort: Meistens ja, solange du öffentliche Daten scrapest und die Regeln der Website beachtest (). Aber ein paar Grundregeln solltest du kennen:

- robots.txt respektieren: Wenn eine Seite Scraping verbietet, halte dich daran.

- Nutzungsbedingungen beachten: Manche Seiten untersagen Scraping ausdrücklich.

- Datenschutz wahren: Keine persönlichen Daten sammeln oder missbrauchen.

- Server nicht überlasten: Scrape in angemessenem Tempo.

Gerichte sehen das Scrapen öffentlicher Daten meist positiv, aber Urheber- und Datenschutzgesetze gelten weiterhin (). Im Zweifel immer juristischen Rat einholen.

Best Practice: Nur Daten scrapen, die du auch öffentlich teilen würdest, und Quellen immer angeben.

Die Zukunft des Web Scraping mit JavaScript: KI und Automatisierung

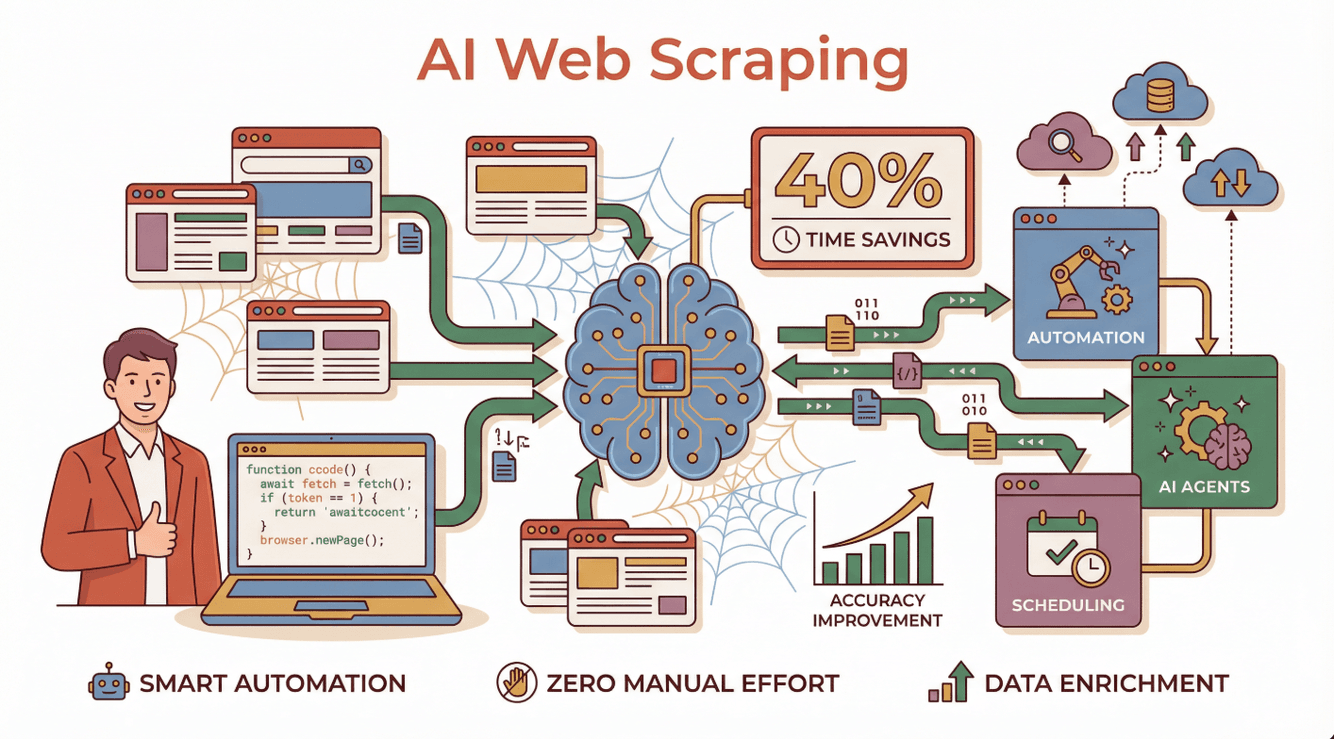

Jetzt wird’s richtig spannend. KI macht aus Web Scraping eine smarte, automatisierte Aufgabe. Unternehmen, die KI-gestützte Scraper nutzen, berichten von , höherer Genauigkeit und der Fähigkeit, selbst die komplexesten dynamischen Seiten zu meistern ().

Jetzt wird’s richtig spannend. KI macht aus Web Scraping eine smarte, automatisierte Aufgabe. Unternehmen, die KI-gestützte Scraper nutzen, berichten von , höherer Genauigkeit und der Fähigkeit, selbst die komplexesten dynamischen Seiten zu meistern ().

Wie sieht das konkret aus?

- KI-Agenten verstehen Anweisungen in natürlicher Sprache, passen sich an Webseitenänderungen an und beheben Fehler selbstständig ().

- Automatisierte Zeitpläne sorgen dafür, dass du täglich aktuelle Daten bekommst – ganz ohne manuelles Zutun.

- Datenanreicherung: KI kann Daten direkt beim Scraping kategorisieren, zusammenfassen oder sogar übersetzen.

Thunderbit ist Vorreiter dieser Entwicklung und macht es jedem möglich, KI-gestützte Web-Scraper zu erstellen und zu betreiben – ganz ohne Programmierung oder Wartung.

Du willst mehr über die Zukunft des KI-Web-Scrapings wissen? Lies unseren ausführlichen Guide zu

Einstieg: Praktische Tipps für Business-Anwender

Du willst Web Scraping mit JavaScript (oder Thunderbits No-Code-Ansatz) ausprobieren? So klappt der Start:

- Ziel definieren: Welche Daten brauchst du und warum?

- Tool auswählen: Technisch fit? Probier Node.js mit Puppeteer oder Cheerio. Ansonsten und die KI übernehmen lassen.

- Klein anfangen: Teste erst mit wenigen Seiten, bevor du skalierst.

- Exportieren & analysieren: Übertrage deine Daten nach Google Sheets, Excel oder Notion zur Auswertung.

- Ethisch bleiben: Datenschutz, Nutzungsbedingungen und Datenlimits immer beachten.

Mehr erfahren? Schau in die einsteigerfreundlichen Tutorials im oder tausch dich in Online-Communities wie Stack Overflow oder Reddit r/webscraping aus.

Fazit: Mit Web Scraping und JavaScript echten Mehrwert schaffen

Kurz gesagt: JavaScript und Node.js sind heute das Rückgrat modernen Web Scrapings – vor allem für dynamische, interaktive Seiten. Egal ob Entwickler oder Business-Anwender: Dank Browser-Automatisierung, riesigem Ökosystem und KI-gestützten Tools kannst du schneller und präziser denn je die gewünschten Daten extrahieren.

Und mit No-Code-Lösungen wie brauchst du keinen einzigen Code-Schnipsel, um von JavaScript-basiertem Scraping zu profitieren. Einfach beschreiben, was du brauchst, klicken – und schon stehen deine Daten bereit für Analyse, Lead-Generierung oder andere Geschäftsprozesse.

Wenn du das Chaos des Webs in strukturierte, nutzbare Erkenntnisse verwandeln willst, ist jetzt der perfekte Zeitpunkt. Viel Erfolg beim Scrapen – und mögen deine Daten immer sauber, rechtssicher und der Konkurrenz einen Schritt voraus sein.

Häufige Fragen (FAQ)

1. Was ist Web Scraping mit JavaScript und Node.js?

Web Scraping mit JavaScript und Node.js heißt, dass du mit JavaScript-Code (meist auf Node.js-Basis) automatisiert Daten von Webseiten extrahierst. Besonders bei dynamischen Seiten, die Inhalte per JavaScript laden, ist dieser Ansatz sehr effektiv.

2. Warum ist JavaScript besser als Python oder Ruby für dynamische Webseiten?

JavaScript ist die Sprache, mit der Browser Webseiten darstellen und aktualisieren – deshalb kommt es mit dynamischen Inhalten besonders gut klar. Tools wie Puppeteer und Playwright machen die Automatisierung echter Browser einfach und erleichtern das Scraping von JavaScript-lastigen Seiten.

3. Können auch Nicht-Techniker Web Scraping mit JavaScript nutzen?

Klar! No-Code-Tools wie bringen die Power von JavaScript-Scraping für alle. Du gibst einfach deine Anforderungen in natürlicher Sprache ein, die KI übernimmt den Rest.

4. Ist Web Scraping legal?

Im Allgemeinen ist das Scrapen öffentlicher Daten erlaubt, solange du die Nutzungsbedingungen, robots.txt und Datenschutzgesetze beachtest. Vermeide das Scrapen persönlicher oder urheberrechtlich geschützter Daten ohne Erlaubnis.

5. Wie verändert KI das Web Scraping mit JavaScript?

KI macht Web Scraping schlauer und zugänglicher. Sie kann sich an Webseitenänderungen anpassen, Fehler automatisch beheben und Daten direkt beim Scraping verarbeiten und anreichern – das spart Zeit und erhöht die Genauigkeit. Thunderbit ist ein Top-Beispiel für diese neue Generation KI-gestützter Scraper.

Weitere Tipps und Anleitungen findest du im oder auf unserem .

Mehr erfahren