Wer schon mal im Terminal unterwegs war, ist mit cURL sicher schon in Berührung gekommen. Dieses kleine Tool ist quasi das Schweizer Taschenmesser des Internets – auf Milliarden Geräten installiert, immer bereit, Daten abzurufen, zu senden oder Fehler zu analysieren. Laut dem cURL-Erfinder gibt es weltweit . Kein Scherz: Zwanzig. Milliarden.

Warum setzen Entwickler:innen (und auch viele Business-User:innen) im Jahr 2025 immer noch auf cURL, obwohl es mittlerweile unzählige moderne, KI-basierte Scraping-Tools gibt? Ganz einfach: Manchmal zählt nur, dass es schnell, skriptgesteuert und ohne viel Aufwand funktioniert. In diesem Guide zeige ich dir, warum cURL beim Web Scraping nach wie vor eine Rolle spielt, wann es die beste Wahl ist, wie du es clever einsetzt und wie du mit , unserem KI-Web-Scraper, deinen Workflow aufs nächste Level bringst.

Warum Web Scraping mit cURL auch 2025 noch überzeugt

Ich geb’s zu: Ich bin cURL-Fan. Es hat einfach was, mit einem einzigen Befehl Rohdaten zu bekommen. Und ich bin nicht allein: Die hatte letztes Jahr 28% mehr Teilnehmer:innen, und auf Stack Overflow gibt’s rund um „curl“. Entwickler:innen nennen es „bewährt“, „großartig“ und „die gemeinsame Sprache für Webanfragen“. Trotz neuer Tools entwickelt sich cURL stetig weiter – mittlerweile sogar mit HTTP/3-Support.

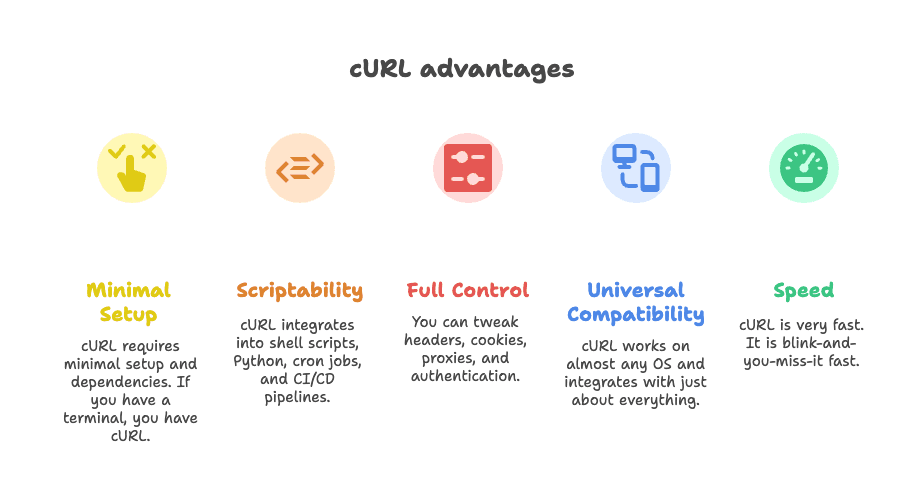

Was macht cURL also so langlebig für Web Scraping?

- Kaum Setup nötig: Keine endlosen Abhängigkeiten – ein Terminal reicht, cURL ist fast immer schon drauf.

- Skriptfähig: Lässt sich easy in Shell-Skripte, Python, Cronjobs oder CI/CD-Pipelines einbauen.

- Volle Kontrolle: Header, Cookies, Proxys und Auth kannst du flexibel anpassen.

- Läuft überall: Funktioniert auf fast jedem Betriebssystem und fügt sich in viele Workflows ein.

- Rasend schnell: Ergebnisse kommen in Sekundenbruchteilen.

Oder wie ein Entwickler auf sagt: „Was immer du machen willst, cURL kann es.“

Typische Anwendungsfälle: Wann cURL beim Web Scraping punktet

Ehrlich: cURL ist nicht immer die beste Lösung. Aber in bestimmten Situationen ist es unschlagbar. Hier spielt cURL seine Stärken aus:

1. REST-APIs für JSON-Daten abfragen

Viele moderne Websites laden Inhalte über API-Requests im Hintergrund. Wenn du den passenden Endpunkt findest (Tipp: Im Browser im Netzwerk-Tab schauen), holt cURL die JSON-Daten mit einem Befehl. Perfekt für schnelle Datenabfragen, API-Tests oder Automatisierungsskripte.

2. Daten aus statischen oder klar strukturierten Seiten extrahieren

Stehen die Daten direkt im HTML – etwa bei News-Artikeln, Branchenverzeichnissen oder Kategorieseiten – liefert cURL sie sofort. Mit Tools wie grep, sed oder jq kannst du die Ergebnisse direkt weiterverarbeiten.

3. Komplexe HTTP-Anfragen debuggen und nachstellen

Du willst einen Login simulieren, einen Webhook testen oder eine knifflige API-Anfrage nachvollziehen? Mit cURL hast du Zugriff auf alle Header, Cookies und Payloads. Ideal, um zu sehen, was im Hintergrund passiert.

4. Schnelle Datenabfragen in Skripte integrieren

cURL ist ein Liebling für Shell-Skripte, Python oder sogar Zapier-Webhooks. Es ist das unsichtbare Bindeglied vieler Automatisierungen.

Hier eine Übersicht, wann cURL passt – und wann nicht:

| Anwendungsfall | Warum cURL geeignet ist | Wo es an Grenzen stößt | Alternativen |

|---|---|---|---|

| JSON-APIs abfragen | Schnell, skriptbar, unterstützt Header/Tokens | Kein eingebautes JSON-Parsing, komplexe Authentifizierung manuell | Python Requests, Postman, Thunderbit |

| Statische HTML-Seiten | Leichtgewichtig, einfach mit CLI-Tools kombinierbar | Kein HTML-Parsing, kein JavaScript | Scrapy, BeautifulSoup, Thunderbit |

| Session-Authentifizierung | Cookies, Header, Basic Auth möglich | Mehrstufige Logins mühsam, kein JS | Requests Sessions, Selenium, Thunderbit |

| Shell/Python-Integration | Universell, läuft in jedem Skript | Parsing und Fehlerbehandlung manuell | Native HTTP-Bibliotheken, Thunderbit |

Mehr Details zu diesen Szenarien findest du in .

Praktische cURL Web Scraping Techniken für 2025

Jetzt wird’s praktisch: So nutzt du cURL 2025 effizient – inklusive meiner Lieblings-Tricks.

Header und User-Agent setzen

Viele Websites blocken Standard-cURL-Anfragen. Mit einem realistischen User-Agent und passenden Headern wirkst du wie ein echter Browser:

1curl -A "Mozilla/5.0 (Windows NT 10.0; Win64; x64)" -H "Accept: application/json" https://api.example.com/dataOder mehrere Header gleichzeitig:

1curl -H "User-Agent: Mozilla/5.0" -H "Accept: application/json" https://api.example.com/dataDas Anpassen der Header entscheidet oft, ob du Daten bekommst oder geblockt wirst. Mehr dazu im .

Cookies und Sessions verwalten

Für Logins oder Sitzungen nutzt du die Cookie-Funktion von cURL:

1# Login und Cookies speichern

2curl -c cookies.txt -d "username=me&password=secret" https://example.com/login

3# Cookies für weitere Anfragen nutzen

4curl -b cookies.txt https://example.com/dashboardCookies lassen sich auch direkt übergeben:

1curl -b "SESSIONID=abcd1234" https://example.com/pageBei Weiterleitungen (z. B. nach Login) hilft das -L-Flag, um Cookies mitzunehmen.

Proxys nutzen, um Blockaden zu umgehen

Wirst du wegen zu vieler Anfragen gesperrt? Dann leite deine Requests über einen Proxy:

1curl --proxy 198.199.86.11:8080 https://target.comFür rotierende Proxys kannst du cURL in einem Skript mit einer Proxy-Liste kombinieren. Achtung: Kostenlose Proxys sind oft unzuverlässig – bei „connection refused“ liegt’s meist nicht an cURL.

Antworten speichern und parsen

cURL liefert Rohdaten. Um sie auszuwerten, kombiniere cURL mit anderen Kommandozeilentools:

-

Für JSON: Mit

jqformatieren oder Felder extrahieren.1curl -s https://api.github.com/repos/user/repo | jq .stargazers_count -

Für HTML: Mit

grepodersednach Mustern suchen.1curl -s https://example.com | grep -oP '(?<=<title>).*?(?=</title>)' -

Für komplexeres Parsing: Tools wie

htmlq(CSS-Selektoren) oder Python mit BeautifulSoup nutzen.

Eine gute Anleitung zum Zusammenspiel von cURL und jq gibt’s bei .

Authentifizierung und Rate Limits mit cURL

Authentifizierung:

-

Basic Auth:

1curl -u username:password https://api.example.com/data -

Bearer Token:

1curl -H "Authorization: Bearer <token>" https://api.example.com/data -

Session-Cookies: Nutze die Optionen

-cund-bwie oben gezeigt.

Für komplexere Authentifizierungen (z. B. OAuth) musst du den Ablauf skripten – möglich, aber aufwendig.

Rate Limits und Wiederholungen:

-

Verzögerungen einbauen:

1for url in $(cat urls.txt); do 2 curl -s "$url" 3 sleep $((RANDOM % 3 + 2)) # zufällige Pause zwischen 2-4 Sekunden 4done -

Wiederholungen:

1curl --retry 3 --retry-delay 5 https://example.com/data

Sei fair – überlaste keine Server und achte auf 429 Too Many Requests-Antworten.

Grenzen von cURL beim Web Scraping: Das solltest du wissen

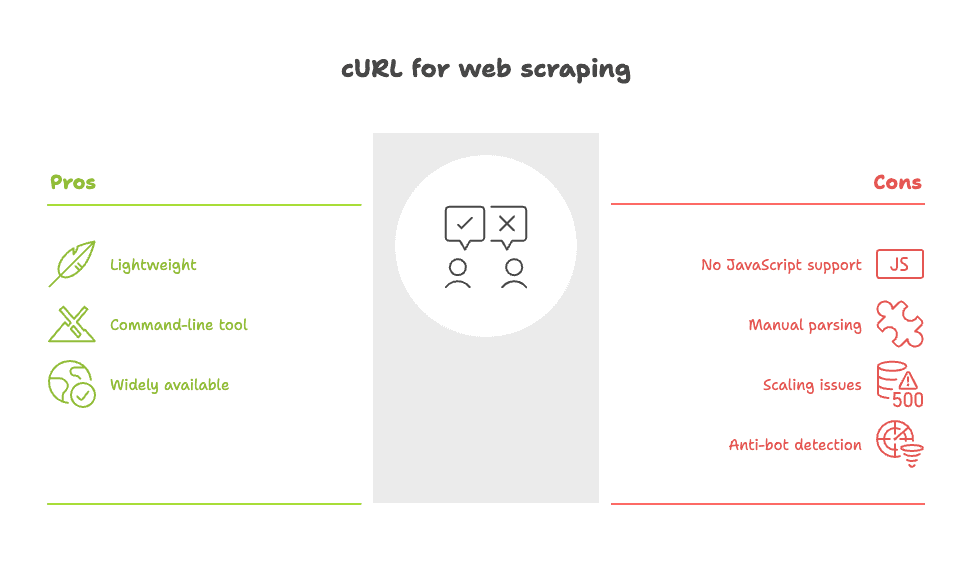

So sehr ich cURL mag – es gibt klare Grenzen:

- Kein JavaScript: cURL kann keine Skripte ausführen oder dynamische Inhalte laden. Werden Daten erst nach dem Seitenaufbau angezeigt, sieht cURL sie nicht. Dann musst du die API finden oder ein browserbasiertes Tool nutzen.

- Manuelles Parsing: Du bekommst Roh-HTML oder JSON. Die Strukturierung liegt bei dir – oft mit viel

grep,sedoder eigenen Skripten. - Skalierungsprobleme: Bei Hunderten oder Tausenden Seiten wird das Handling von Fehlern, Wiederholungen und Datenbereinigung schnell unübersichtlich.

- Leicht von Anti-Bot-Systemen erkennbar: Viele Websites erkennen cURL am Netzwerk-Fingerprint und blockieren es, selbst wenn du Header fälschst.

Oder wie ein Nutzer auf sagt: „Für einfache Scraping-Aufgaben reicht curl oder wget, aber bei komplexeren Seiten wird es sehr mühsam.“

Eine ausführliche Übersicht zu den Schwächen von cURL findest du im .

Mit Thunderbit das Beste aus cURL Web Scraping herausholen

Du willst die Geschwindigkeit und Kontrolle von cURL, aber ohne den manuellen Aufwand? Hier kommt ins Spiel.

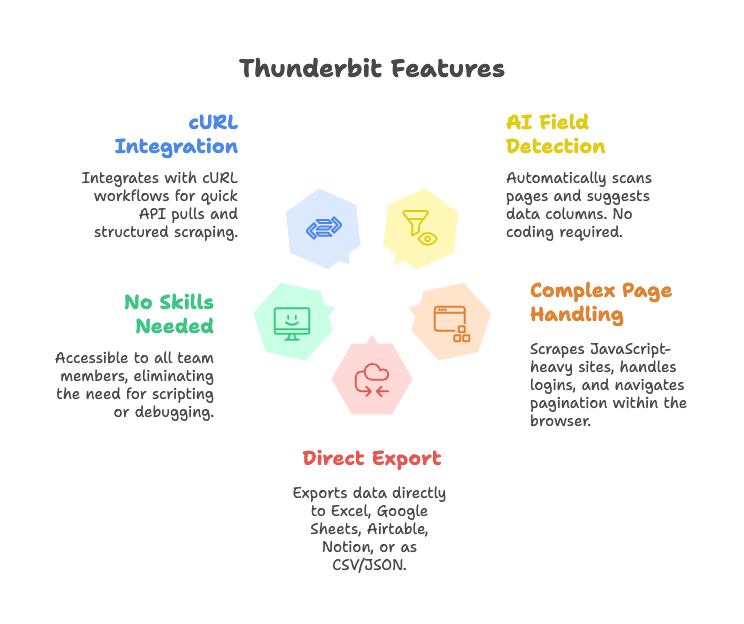

Thunderbit ist eine KI-gestützte Web-Scraper Chrome-Erweiterung, die das Extrahieren von Daten zum Kinderspiel macht. So ergänzt Thunderbit cURL:

- KI-Felderkennung: Mit „AI Suggest Fields“ erkennt Thunderbit automatisch relevante Datenfelder und strukturiert sie – ganz ohne Code oder Selektoren.

- Komplexe Seiten meistern: Thunderbit läuft direkt im Browser, kann also auch JavaScript-lastige Seiten, Logins und Unterseiten samt Paginierung verarbeiten.

- Direkter Export: Exportiere Daten direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON.

- Keine technischen Vorkenntnisse nötig: Jeder im Team kann Thunderbit nutzen – ganz ohne Skripte oder HTTP-Fehleranalyse.

- Nahtlose Integration mit cURL-Workflows: Entwickler:innen können cURL für schnelle API-Tests nutzen und für strukturierte, wiederholbare Scraping-Aufgaben auf Thunderbit umsteigen.

Du willst Thunderbit in Aktion sehen? Schau dir unsere an oder stöbere im nach weiteren Anwendungsbeispielen.

Thunderbit + cURL: Praxisbeispiele für Business-Teams

So können Teams cURL und Thunderbit im Alltag kombinieren:

1. Schnelle Marktanalysen

- Mit cURL prüfen, ob eine Wettbewerber-Website eine öffentliche API oder statisches HTML bietet.

- Bei Erfolg ein einmaliges Skript für einen schnellen Daten-Snapshot schreiben.

- Für tiefere Analysen (z. B. Produktlisten über mehrere Seiten) auf Thunderbit umsteigen – KI erkennt Felder, übernimmt die Paginierung und exportiert direkt in Sheets.

2. Lead-Generierung

- Mit cURL Kontaktdaten aus einer einfachen Verzeichnis-API abrufen.

- Für komplexere Seiten (z. B. Profile wie bei LinkedIn oder Immobilienportale) mit Thunderbit Namen, E-Mails, Telefonnummern und sogar Bilder extrahieren – ganz ohne manuelles Parsen.

3. Produkt- und Preisüberwachung

- Mit cURL-Skripten regelmäßig eine REST-API auf Preisänderungen prüfen.

- Für Seiten ohne API übernimmt Thunderbit das Scraping, strukturiert die Daten und schickt Updates direkt an Airtable oder Notion.

So könnte ein typischer Workflow aussehen:

1[Browser/Terminal] --(Test mit cURL)--> [Schneller Datenabruf]

2 |

3 v

4[Thunderbit Chrome-Erweiterung] --(KI-Extraktion)--> [Strukturierte Daten] --> [Sheets/Airtable/Notion]Thunderbit vs. selbstgeschriebene cURL-Skripte: Die Vorteile im Überblick

Hier der direkte Vergleich:

| Funktion | Thunderbit (KI-Web-Scraper) | cURL (CLI-Tool) |

|---|---|---|

| Einrichtung | Klick & los, KI erkennt Felder automatisch | Manuelles Skripten, HTML-Kenntnisse nötig |

| Bedienung | Für alle nutzbar, visuelles Feedback | Nur CLI, steile Lernkurve |

| Strukturierte Ausgabe | Ja – Tabellen, Spalten, Export zu Sheets/CRM | Roh-HTML/JSON, manuelles Parsen |

| Dynamische Seiten | Ja – läuft im Browser, unterstützt JS, Unterseiten, Paginierung | Nein – nur statisches HTML |

| Wartung | Gering – KI passt sich an Änderungen an | Hoch – Skripte brechen bei Änderungen |

| Integration | Exporte in Business-Tools integriert | Eigener Code nötig |

| Mehrsprachigkeit/Übersetzung | Ja – KI kann Felder übersetzen und normalisieren | Nein – nur manuell |

| Skalierung | Ideal für mittlere Aufgaben | Gut für große Jobs, wenn Skripte gebaut werden |

| Kosten | Kostenloser Einstieg, ab ca. 9 €/Monat | Kostenlos, aber Entwicklerzeit nötig |

Mehr dazu im .

Mit dem KI-gestützten Ansatz sparst du mit Thunderbit Zeit beim Skripten und kommst schneller zu verwertbaren Ergebnissen – egal ob Entwickler:in oder Business-Anwender:in.

Herausforderungen und Stolpersteine beim Web Scraping mit cURL

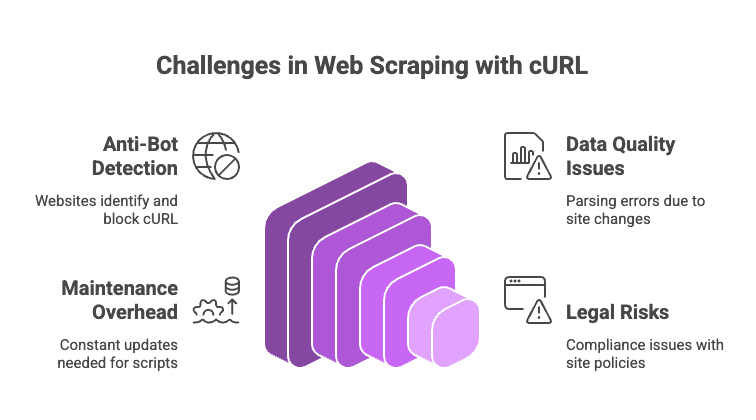

Web Scraping ist auch 2025 kein Selbstläufer. Das solltest du beachten:

- Anti-Bot-Maßnahmen: Dienste wie Cloudflare, Akamai oder DataDome erkennen cURL oft sofort. Selbst mit gefälschten Headern prüfen sie JavaScript-Ausführung, TLS-Fingerprints und mehr. Bei CAPTCHAs ist mit cURL Schluss.

- Datenqualität und Konsistenz: Rohes HTML mit Regex oder grep zu parsen ist fehleranfällig. Schon kleine Änderungen am Seitenaufbau können Skripte unbrauchbar machen.

- Wartungsaufwand: Jede Änderung an der Website bedeutet Anpassungen am Code und an den Selektoren.

- Rechtliche Risiken: Prüfe immer die Nutzungsbedingungen und Datenschutzrichtlinien der Zielseite. Nur weil etwas technisch möglich ist, ist es nicht immer erlaubt.

Profi-Tipps:

- User-Agents und IPs regelmäßig wechseln, um Blockaden zu vermeiden.

- Zufällige Pausen zwischen Anfragen einbauen.

- Für JSON

jq, für HTMLhtmlqnutzen. - Bei dynamischen oder geschützten Seiten auf browserbasierte Tools wie Thunderbit oder eine Scraping-API umsteigen.

Eine vollständige Liste der Stolpersteine (und wie du sie umgehst) findest du im .

Fazit: Die richtige Web Scraping Strategie 2025 wählen

Mein Fazit: Für schnelle, gezielte Scraping-Aufgaben – vor allem bei APIs, statischen Seiten oder zum Debuggen – bleibt cURL unschlagbar. Es ist der schnellste Weg, um eine Website zu testen und Möglichkeiten auszuloten.

Sobald du aber strukturierte Daten, dynamische Inhalte oder teamfähige Workflows brauchst, solltest du auf moderne Tools setzen. nimmt dir die Handarbeit ab, meistert komplexe Seiten und bringt die Daten direkt dorthin, wo du sie brauchst.

Wähle also das passende Werkzeug: Für kleine, skriptbare Aufgaben ist cURL ideal. Für größere, dynamische oder teamorientierte Projekte übernimmt Thunderbit die Schwerstarbeit.

FAQ: Web Scraping mit cURL 2025

1. Kann cURL JavaScript-generierte Inhalte abgreifen?

Nein. cURL holt nur das initiale HTML. Werden Daten per JavaScript nachgeladen, musst du die API finden oder ein browserbasiertes Tool wie Thunderbit nutzen.

2. Wie verhindere ich Blockaden beim Scraping mit cURL?

Setze realistische Header (User-Agent, Accept), rotiere IPs und User-Agents, baue Pausen zwischen Anfragen ein und verwende Cookies. Bei harten Anti-Bot-Systemen (z. B. Cloudflare) hilft oder der Umstieg auf einen Headless-Browser oder eine Scraping-API.

3. Wie strukturiere ich cURL-Ausgaben am besten?

Für JSON: Ausgabe an jq weiterleiten. Für HTML: grep, sed oder Kommandozeilen-Parser wie htmlq nutzen. Bei komplexeren Aufgaben empfiehlt sich Python mit BeautifulSoup oder Thunderbit für KI-gestützte Extraktion.

4. Ist cURL für große Scraping-Projekte geeignet?

Prinzipiell ja, aber du musst viel drumherum bauen – Fehlerbehandlung, Wiederholungen, Proxys und Datenbereinigung. Für sehr große Projekte sind Frameworks wie Scrapy oder browserbasierte Tools meist effizienter.

5. Wie verbessert Thunderbit klassisches cURL-Scraping?

Thunderbit erkennt Felder automatisch, verarbeitet dynamische Seiten, verwaltet Sessions und Unterseiten und exportiert strukturierte Daten direkt in Business-Tools. Kein Skripten, keine Selektoren, kein Wartungsaufwand.

Wenn du Scraping vereinfachen willst, probiere aus – oder installiere unsere und erlebe, wie KI deinen Workflow beschleunigt.

Und falls du dich im Terminal mit blinkendem Cursor am wohlsten fühlst: cURL bleibt dir erhalten. Aber denk daran, die Server fair zu behandeln – und deinem Lieblings-Admin ab und zu einen Kaffee auszugeben.

Mehr Tipps zu Web Scraping, Automatisierung und KI-Produktivität findest du im .