Hand aufs Herz: Wenn du schon mal versucht hast, Geschäftsdaten zu beschaffen, bist du bestimmt auch schon über die Frage „Web Scraping oder Data Mining?“ gestolpert. Ich habe schon viele Teams erlebt, die sich dabei im Kreis drehen – die einen wollen möglichst viele Infos aus dem Netz ziehen, die anderen wollen daraus echte Erkenntnisse gewinnen. Am Ende sitzen alle vor einer riesigen Tabelle und fragen sich: „Was machen wir hier eigentlich?“ Kommt dir das bekannt vor? Damit bist du definitiv nicht allein.

Als jemand, der seit Jahren SaaS- und Automatisierungslösungen entwickelt (und jetzt Mitgründer von ist), habe ich diese Verwirrung überall gesehen – vom Vertrieb bis ins Management. Zeit, das Ganze mal klarzustellen: Wo liegt wirklich der Unterschied zwischen Web Scraping und Data Mining, wer nutzt was – und wie kann man beides clever kombinieren, um echten Mehrwert fürs Team zu schaffen?

Web Scraping vs. Data Mining: Die Kurzfassung für alle, die wenig Zeit haben

Ganz ohne Technik-Blabla:

- Web Scraping: Hier werden Daten automatisiert von Webseiten gesammelt – quasi wie Copy-Paste, nur viel schneller und viel strukturierter. Ein Web-Scraper durchforstet Seiten, zieht gezielt Infos raus (z. B. Preise, Firmennamen, Artikel) und packt sie in eine Tabelle. Analysiert wird dabei noch nichts – es geht nur um die Rohdaten.

- Data Mining: Jetzt kommt der eigentliche Mehrwert: Die gesammelten Daten werden mit Statistik, Algorithmen oder KI ausgewertet, um Muster, Trends und Zusammenhänge zu erkennen. Aus der großen Tabelle werden so echte Erkenntnisse – zum Beispiel Kundensegmente, Umsatzprognosen oder Betrugserkennung.

Mein Lieblingsvergleich:

Web Scraping ist wie Zutaten einkaufen, Data Mining ist das Kochen. Wer ein gutes Essen will, braucht beides.

Wer nutzt Web Scraping, wer Data Mining – und warum?

Hier wird’s spannend. Es geht nicht nur um „Sammeln vs. Auswerten“, sondern auch um die jeweiligen Nutzergruppen und deren Ziele.

Wer setzt auf Web Scraping?

Typische Anwender:

- Vertriebsteams (Lead-Listen, Kontaktdaten sammeln)

- Marketing (Marktbeobachtung, Wettbewerbsanalyse)

- Operations (Preisüberwachung, Lieferketten-Insights)

- Forschung (z. B. Immobilien, Finanzen)

Ihr Ziel:

Aktuelle, externe Daten – und das möglichst schnell. Ob tausende Produktpreise, Leads von LinkedIn oder Wettbewerber-Launches: Diese Teams brauchen frische Infos für ihre täglichen Entscheidungen (, ).

Wer nutzt Data Mining?

Typische Anwender:

- Datenanalysten und Business-Intelligence-Teams

- Data Scientists

- Produktmanager und Strategieabteilungen

Ihr Ziel:

Daten verstehen und daraus Handlungsoptionen ableiten. Sie analysieren Rohdaten – egal ob aus dem Web oder internen Systemen – und suchen nach Mustern, Trends und Insights. Wie die Daten gesammelt wurden, ist für sie meist zweitrangig ().

Szenarientabelle: Wer macht was?

| Rolle | Web Scraping Beispiel | Data Mining Beispiel |

|---|---|---|

| Vertrieb | Firmenverzeichnisse für Leads scrapen | Analysieren, welche Leads am besten konvertieren |

| Marketing | Wettbewerber-Produktlaunches scrapen | Kunden nach Kaufverhalten segmentieren |

| Operations | Tägliche Lieferantenpreise scrapen | Nachfrage prognostizieren, Lager optimieren |

| BI/Data Science | (Scrapen meist nicht selbst) | Prognosemodelle bauen, Trends erkennen |

| Produktmanagement | App-Store-Bewertungen scrapen | Feature-Lücken identifizieren, Roadmap priorisieren |

Web Scraping: So werden Webseiten zu wertvollen Geschäftsdaten

Fakt ist: Das Internet ist eine riesige Datenquelle, aber die meisten Infos sind unstrukturiert und schwer zugänglich. Web Scraping ist der Schlüssel, um diese Daten nutzbar zu machen.

Warum Web Scraping (gerade für Nicht-Techniker) so wichtig ist

- Spart Zeit: Kein stundenlanges Copy-Paste mehr – ein Web-Scraper holt tausende Datenpunkte in Minuten.

- Skaliert: 50 Wettbewerber-Websites täglich überwachen? Mit Scraping kein Problem.

- Bleibt aktuell: Echtzeit-Updates zu Preisen, Lagerbeständen oder News – ganz ohne Handarbeit.

Über nutzen Web Scraping bereits für Analysen, und setzen es für Wettbewerbsbeobachtung und Preisüberwachung ein.

Typische Anwendungsfälle

- Leadgenerierung: Öffentliche Verzeichnisse oder soziale Netzwerke nach Namen, E-Mails, Telefonnummern durchsuchen.

- Preisüberwachung: Wettbewerberpreise oder Produktverfügbarkeit in Echtzeit tracken.

- Marktforschung: Online-Bewertungen sammeln, Social Media nach Stimmungen durchsuchen, News-Trends erkennen.

- Datenanreicherung: CRM mit aktuellen Infos von Firmenwebsites oder LinkedIn ergänzen.

- Immobilien & Finanzen: Immobilienanzeigen, Finanznachrichten oder alternative Daten für Investment-Analysen scrapen ().

Das Beste: Man muss heute kein Programmierer mehr sein. Über bieten Drag-and-Drop oder Point-and-Click – Scraping ist für alle zugänglich.

Wie Thunderbit Web Scraping für alle vereinfacht

Als wir entwickelt haben, war unser Ziel klar: Web Scraping so einfach machen wie Copy-Paste – nur übernimmt das jetzt ein KI-Agent, der nie müde wird und sich nicht ablenken lässt.

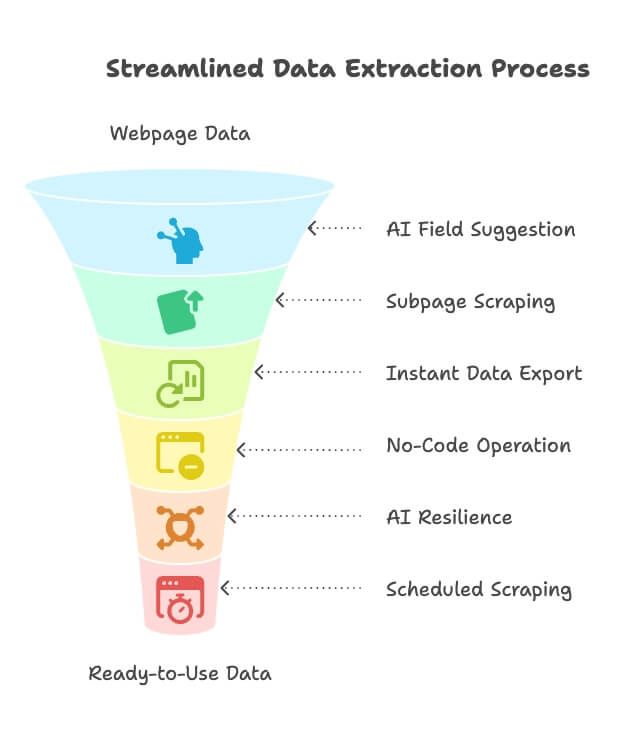

So schließt Thunderbit die Lücke zwischen Datensammlung und Analyse:

- KI-Feldvorschläge: Mit einem Klick scannt Thunderbits KI die Seite, schlägt relevante Datenfelder und Spaltennamen vor. Kein HTML-Gefummel mehr – einfach auswählen, was gebraucht wird ().

- Subseiten-Scraping: Mehr Details nötig (z. B. Produktinfos, Jobbeschreibungen)? Thunderbit klickt automatisch weiter, sammelt Zusatzinfos und ergänzt sie im Datensatz.

- Sofortiger Datenexport: Ein Klick, und die Daten landen in Excel, Google Sheets, Airtable, Notion oder als CSV/JSON. Keine versteckten Kosten, keine Umwege – sofort einsatzbereit.

- No-Code, Point-and-Click: Thunderbit läuft direkt im Browser. Einfach markieren, fertig. Auch ohne Vorkenntnisse ist man in Minuten startklar.

- KI-gestützte Anpassungsfähigkeit: Webseiten ändern sich ständig – Thunderbits KI passt sich vielen Layout-Änderungen automatisch an. Weniger Wartung, weniger Frust.

- Geplantes Scraping & KI-Autofill: Scrapes zeitgesteuert ausführen oder Formulare und Logins per KI ausfüllen lassen. Thunderbit verarbeitet sogar PDFs, Bilder, E-Mails und Telefonnummern mit nur einem Klick.

Das Ergebnis: Thunderbit schließt die Kompetenzlücke. Jetzt können Vertrieb, Marketing oder sogar die Geschäftsführung Scrapes einrichten – ganz ohne IT. Es ist die Brücke zwischen unstrukturierten Webdaten und den Tools, die für die Analyse genutzt werden.

Neugierig? Die ausprobieren oder mehr Anwendungsbeispiele im entdecken.

Data Mining: Aus Daten echte Erkenntnisse gewinnen

Du hast jetzt einen riesigen Datensatz gesammelt – und nun? Jetzt kommt Data Mining ins Spiel.

Was ist Data Mining (einfach erklärt)?

Data Mining bedeutet, große Datenmengen zu analysieren, um versteckte Muster, Zusammenhänge oder Auffälligkeiten zu entdecken, die geschäftlichen Mehrwert bieten. Es geht darum, aus Zahlen Wissen zu machen – etwa herauszufinden, dass Kunden, die Produkt A kaufen, oft auch Produkt B nehmen, oder dass bestimmte Verhaltensweisen auf eine hohe Kündigungswahrscheinlichkeit hindeuten.

Typische Business-Ziele

- Trends erkennen & Prognosen erstellen: Umsatzentwicklungen, Saisonalität oder Marktveränderungen frühzeitig erkennen und vorhersagen.

- Kundensegmentierung: Kunden nach Verhalten oder Demografie gruppieren, um gezielter zu vermarkten.

- Anomalien entdecken: Auffälligkeiten finden, die auf Betrug, Risiken oder neue Chancen hinweisen.

- Strategische Insights: Interne und externe Daten kombinieren, um große Entscheidungen zu treffen – z. B. Markteintritt oder Preisstrategie.

Wichtig: Data Mining ist nur so gut wie die Datenbasis. „Garbage in, garbage out“ gilt hier besonders. Analysten verbringen bis zu mit Datenaufbereitung, bevor sie überhaupt analysieren können.

Deshalb ist strukturiertes Web Scraping (wie mit Thunderbit) so wertvoll – die Daten sind sauber und direkt auswertbar.

Web Scraping vs. Data Mining: Direkt gegenübergestellt

Hier der direkte Vergleich, damit die Unterschiede und Überschneidungen klar werden:

| Aspekt | Web Scraping | Data Mining |

|---|---|---|

| Hauptzweck | Rohdaten von Webseiten sammeln (Datenextraktion) | Datensätze analysieren, um Muster und Erkenntnisse zu gewinnen (Datenanalyse) |

| Typische Nutzer | Vertrieb, Marketing, Operations, Forschung (oft Fachexperten, keine Techniker) | Datenanalysten, BI-Teams, Data Scientists, Strategie (analytische/technische Rollen) |

| Datenquellen | Webseiten, Online-Quellen, öffentliche Verzeichnisse, APIs | Strukturierte Datensätze: gescrapte Daten, interne Datenbanken, CSVs, Data Warehouses |

| Prozesse & Tools | Crawling, Extraktion (No-Code-Tools wie Thunderbit, Browser-Erweiterungen) | Datenanalyse (BI-Tools, Python/R, SQL, Machine-Learning-Plattformen) |

| Ergebnis | Strukturierter Datensatz (CSV, Tabelle, Datenbank) | Erkenntnisse, Berichte, Dashboards, Prognosemodelle |

| Beispiele | Wettbewerberpreise sammeln, Social Mentions scrapen, Listings extrahieren | Kunden segmentieren, Churn vorhersagen, Leads bewerten |

| Herausforderungen | Website-Änderungen, Anti-Scraping, Datenqualität, rechtliche/ethische Fragen | Unsaubere/unvollständige Daten, Modellwahl, Datenschutz, Interpretation |

Das Wichtigste:

Web Scraping liefert den „Treibstoff“ (Daten), Data Mining ist der „Motor“ (Erkenntnisse). Beides ist nötig, um voranzukommen.

Wie Web Scraping und Data Mining im Unternehmen zusammenspielen

Hier entsteht der eigentliche Mehrwert: Web Scraping und Data Mining sind keine Gegenspieler, sondern arbeiten Hand in Hand – wie zwei Abschnitte einer Datenpipeline.

Szenario 1: Marktbeobachtung

- Schritt 1: Wettbewerber-Produktlisten, Preise und Bewertungen von mehreren Seiten scrapen.

- Schritt 2: Die Daten nach Trends durchsuchen – Marktlücken erkennen, häufige Kundenbeschwerden identifizieren, Preisentwicklungen verfolgen.

- Ergebnis: Fundierte Insights für Produktstrategie oder Preisgestaltung.

Szenario 2: Lead-Scoring im Vertrieb

- Schritt 1: LinkedIn oder Firmenverzeichnisse scrapen, um Leads mit Infos wie Firmengröße, Branche, News anzureichern.

- Schritt 2: Analysieren, welche Merkmale mit hoher Abschlusswahrscheinlichkeit korrelieren, und Leads priorisieren.

- Ergebnis: Das Vertriebsteam konzentriert sich auf die besten Chancen, nicht nur auf die längste Liste.

Szenario 3: Preisoptimierung

- Schritt 1: Wettbewerberpreise und Lagerbestände in Echtzeit scrapen.

- Schritt 2: Diese Daten in Preisalgorithmen einspeisen und eigene Preise dynamisch anpassen.

- Ergebnis: Wettbewerbsfähig bleiben und Umsatz maximieren.

Was passiert, wenn man nur einen Ansatz verfolgt?

Wer nur scrapt, aber nicht analysiert, ertrinkt in Daten, bleibt aber ohne Erkenntnisse. Wer nur interne Daten analysiert, verpasst den Blick auf den Markt. Die besten Teams kombinieren beides – für ein vollständiges Bild und echte Insights ().

Typische Herausforderungen bei Web Scraping und Data Mining meistern

Beide Ansätze haben ihre Tücken. So lassen sie sich lösen (und so hilft Thunderbit):

1. Datenqualität und -bereinigung

- Problem: Gescrapte Daten sind oft unvollständig, uneinheitlich oder doppelt vorhanden.

- Lösung: Tools nutzen, die schon beim Extrahieren bereinigen. Thunderbit kann Daten direkt beim Scraping formatieren und kategorisieren – so sind sie sofort auswertbar (). Immer Stichproben prüfen, bevor es an die Analyse geht.

2. Website-Änderungen und Anti-Scraping

- Problem: Webseiten ändern ihr Layout, setzen CAPTCHAs ein oder blockieren Bots.

- Lösung: KI-basierte Web-Scraper wie Thunderbit nutzen, die sich automatisch anpassen.

robots.txtrespektieren, Seiten nicht überlasten und ggf. Proxies einsetzen ().

3. Rechtliche und ethische Fragen

- Problem: Öffentliches Scraping ist meist legal, aber Datenschutz und Nutzungsbedingungen sind zu beachten.

- Lösung: Immer die Nutzungsbedingungen prüfen, nur öffentliche Daten scrapen, wo möglich anonymisieren und DSGVO/CCPA einhalten. „Datenethik“ ist wichtiger als jeder Datensatz ().

4. Von Daten zu echten Entscheidungen

- Problem: Teams sammeln Daten, tun sich aber schwer, daraus Handlungen abzuleiten.

- Lösung: Mit klaren Business-Fragen starten, Visualisierungen nutzen und Fachexperten einbinden. Erkenntnisse direkt in Workflows integrieren (z. B. gefährdete Kunden im CRM markieren).

5. Tool- und Kompetenzlücken

- Problem: Nicht jedes Team hat Entwickler oder Data Scientists.

- Lösung: Nutzerfreundliche No-Code-Tools wie Thunderbit fürs Scraping und moderne BI-Plattformen fürs Mining einsetzen. In grundlegende Datenkompetenz investieren – oft reicht schon eine Pivot-Tabelle.

Die richtige Strategie: Web Scraping, Data Mining oder beides?

Wie entscheidet man, was gebraucht wird? Hier eine schnelle Entscheidungshilfe:

- Hast du die nötigen Daten bereits?

- Nein: Mit Web Scraping starten.

- Ja: Mit Data Mining Erkenntnisse gewinnen.

- Geht es um externe oder interne Fragestellungen?

- Extern (Wettbewerb, Markt, Leads): Web Scraping.

- Intern (Kundenverhalten, Umsatztrends): Data Mining.

- Braucht es beides?

- In der Praxis fast immer! Externe Daten scrapen, dann mit internen Daten gemeinsam analysieren.

- Teamfähigkeiten:

- Keine Programmierkenntnisse? No-Code-Scraper wie Thunderbit nutzen.

- Keine Data Scientists? Einfache BI-Tools oder Basisanalysen verwenden.

- Zeitfaktor:

- Echtzeitbedarf? Kontinuierliches Scraping und Analyse einrichten.

- Einmalprojekt? Einmal scrapen und auswerten.

Checkliste:

- „Habe ich alle nötigen Daten intern?“ Falls nein: scrapen.

- „Verstehe ich meine Daten?“ Falls nein: analysieren.

- „Ist das Problem groß genug für beide Ansätze?“ Falls ja: kombinieren.

- „Hat mein Team die nötigen Skills?“ Falls nein: No-Code-Tools nutzen oder Unterstützung holen.

Wichtig: Es muss nicht alles auf einmal passieren. Klein starten, testen, dann ausbauen.

Fazit: So wird Datenarbeit zum Wettbewerbsvorteil

Die wichtigsten Punkte im Überblick:

- Web Scraping und Data Mining sind zwei Schritte einer Kette. Scraping sammelt (vor allem externe) Daten, Mining wertet sie aus.

- Unterschiedliche Rollen, unterschiedliche Ziele: Vertrieb, Marketing und Operations scrapen; Analysten und BI-Teams analysieren.

- Sie ergänzen sich: Die besten Ergebnisse entstehen, wenn beide Ansätze kombiniert werden – für einen vollständigen, aussagekräftigen Datensatz.

- No-Code-Tools und KI senken die Einstiegshürden: Thunderbit & Co. machen Scraping für alle zugänglich, moderne BI-Tools vereinfachen die Analyse.

- Datenqualität und Ethik sind entscheidend: Daten bereinigen, Datenschutz beachten und verantwortungsvoll handeln.

- Der Use Case entscheidet: Mit der Geschäftsfrage starten, dann Datenbedarf und Analyseweg festlegen.

- Klein anfangen, dann skalieren: Mit kostenlosen Tools, Pilotprojekten und schnellen Erfolgen starten.

Am Ende geht es darum, Teams zu befähigen, bessere Entscheidungen mit Daten zu treffen. Ob der Vertrieb weniger Zeit mit Recherche verbringt (dank Scraping) oder Strategie-Meetings auf echten Insights basieren (dank Mining) – die Kombination beider Methoden verschafft modernen Unternehmen einen Vorsprung.

Also: Webdaten einsammeln, Erkenntnisse „kochen“ und dem Team die Infos liefern, die wirklich weiterbringen. Und falls du Unterstützung brauchst – macht die Vorbereitung zum Kinderspiel.

Neugierig geworden? Die ausprobieren und erleben, wie einfach Web Scraping heute ist. Weitere Tipps und Praxisberichte gibt’s im .

FAQs

1. Was ist der Hauptunterschied zwischen Web Scraping und Data Mining?

Web Scraping bedeutet, Rohdaten von Webseiten zu sammeln. Data Mining analysiert diese Daten, um Muster, Trends oder Erkenntnisse zu gewinnen. Scraping ist das Zutaten-Sammeln, Mining das Kochen.

2. Wer nutzt typischerweise Web Scraping und wer Data Mining?

Web Scraping wird vor allem von Vertrieb, Marketing, Operations und Forschung genutzt, die schnell externe Daten brauchen. Data Mining ist das Feld von Analysten, Data Scientists und Produktteams, die strategische Erkenntnisse aus Daten ziehen wollen.

3. Brauche ich Programmierkenntnisse für Web Scraping?

Nicht mehr. Tools wie bieten No-Code- und KI-gestützte Oberflächen, mit denen jeder – unabhängig vom technischen Hintergrund – per Klick Daten scrapen und sofort exportieren kann.

4. Wie arbeiten Web Scraping und Data Mining zusammen?

Web Scraping liefert die strukturierten Rohdaten, auf die Data Mining aufbaut. Zusammen entsteht eine Pipeline: Externe Daten sammeln, dann analysieren und für Geschäftsentscheidungen nutzen.

5. Was sind typische Praxisbeispiele für beide Ansätze?

Web Scraping wird für Leadgenerierung, Preisüberwachung und Wettbewerbsanalyse eingesetzt. Data Mining hilft bei Kundensegmentierung, Trendprognosen, Betrugserkennung und strategischer Planung auf Basis der gescrapten Daten.