Ich muss ehrlich sein: Noch vor ein paar Jahren hätte ich nie gedacht, dass „Web-Scraping“ mal zum Smalltalk-Thema an der Kaffeemaschine für Vertriebs- und Operationsteams wird. Aber jetzt, 2025, ist es plötzlich Alltag – egal ob Makler oder E-Commerce-Manager, alle tauschen sich über ihre liebsten Methoden zur Datenextraktion aus, als ginge es um das beste Grillrezept. Nach Jahren in der Entwicklung und Nutzung von SaaS-Automatisierungstools kann ich nur sagen: Der Wandel ist real – Webdaten sind längst nicht mehr nur ein Thema für die IT. Sie sind der Treibstoff moderner Firmen, von der Lead-Generierung bis zur Preisbeobachtung. Wer heute keinen Web-Scraper oder – noch besser – einen KI-Web-Scraper nutzt, bleibt im Copy-Paste-Zeitalter hängen.

Bei der riesigen Auswahl an Tools fühlt sich die Entscheidung für den richtigen Web-Scraper schnell an wie die Qual der Wahl im Supermarkt: Überfordernd – und die falsche Entscheidung kann dich monatelang ärgern. Deshalb werfen wir einen Blick auf die besten Web-Scraping-Tools für 2025 – von No-Code-KI-Lösungen bis zu Profi-Frameworks für Entwickler. Egal, ob du im Vertrieb, E-Commerce oder einfach auf der Suche nach mehr Automatisierung bist: Hier findest du das passende Werkzeug.

Warum Unternehmen 2025 auf einen Web-Scraper setzen sollten

Starten wir mit dem „Warum“. Warum reden plötzlich alle über Web-Scraping und Datenextraktion? Die Zahlen sprechen für sich: . Das ist kein kurzfristiger Hype, sondern eine echte Welle. Und es sind längst nicht mehr nur Tech-Unternehmen, die diesen Boom antreiben. Dank moderner Low-Code- und No-Code-Scraper können jetzt auch Vertriebs-, Marketing- und Operationsteams ohne IT-Kenntnisse Daten extrahieren ().

Typische Business-Anwendungsfälle

- Lead-Generierung: Vertriebsteams können öffentliche Verzeichnisse, Social Media und Firmenwebsites durchforsten und so gezielte Kontaktlisten aufbauen – Schluss mit veralteten Listen und Kaltakquise ins Blaue.

- Marktforschung & Preisüberwachung: E-Commerce- und Einzelhandelsteams nutzen Scraper, um Wettbewerberpreise, Lagerbestände und Produktsortimente im Blick zu behalten. John Lewis verdankt Web-Scraping zum Beispiel einen durch cleveres Pricing.

- Workflow-Automatisierung: Operationsteams automatisieren wiederkehrende Datensammlungen und sparen so viele Stunden, die früher für manuelles Copy-Paste draufgingen.

- Immobilien-Insights: Makler und Investoren bündeln Immobilienangebote, extrahieren Kontaktdaten und analysieren Markttrends – alles auf einen Schlag.

Das Beste daran: , und Jobdaten für Marktanalysen sind um 50 % gestiegen. In einer Welt, in der Schnelligkeit und Präzision zählen, sind Web-Scraper das Geheimrezept für Teams, die der Konkurrenz immer einen Schritt voraus sein wollen.

Der Wandel zu KI-Web-Scrapern

Früher waren Scraper zwar mächtig, aber man brauchte fast ein Informatikstudium (und viel Geduld), um sie zu bedienen. Heute drehen KI-Web-Scraper wie den Spieß um: Jeder kann mit wenigen Klicks strukturierte Daten extrahieren. Das Ergebnis? Mehr Teams können eigenständig arbeiten, Engpässe verschwinden und Daten werden zum echten Wettbewerbsvorteil.

Wie finde ich den passenden Web-Scraper oder KI-Web-Scraper?

Wie wählt man das richtige Tool aus? Hier ist meine Checkliste, die ich bei der Auswahl von Web-Scraping-Software nutze (und ich habe wirklich alles gesehen – von „so einfach, dass meine Oma es nutzen könnte“ bis „so komplex, dass ich einen zweiten Monitor nur für die Doku brauche“).

Wichtige Auswahlkriterien

- Benutzerfreundlichkeit: Kommen auch Nicht-Techniker ohne lange Einarbeitung zurecht?

- Genauigkeit der Datenerfassung: Holt das Tool zuverlässig die gewünschten Daten, auch wenn sich Websites ändern?

- Unterstützte Plattformen: Browser-Extension, Cloud-Service oder Code-Bibliothek?

- Integrationen: Kann man Daten direkt nach Google Sheets, Excel, Airtable, Notion oder ins CRM exportieren?

- Preisgestaltung: Gibt es eine kostenlose Version? Abrechnung pro Zeile, pro Lauf oder pro Monat?

- Automatisierung & Zeitplanung: Lässt sich das Tool automatisieren oder muss man jeden Durchlauf überwachen?

- KI-Funktionen: Nutzt das Tool KI, um die Einrichtung zu vereinfachen, Felder vorzuschlagen oder komplexe Seiten zu verarbeiten?

Hier ein schneller Vergleich (weiter unten gehen wir auf jedes Tool im Detail ein):

| Tool | Coding Required | AI Features | Scheduling | Export Options | Notable Strengths |

|---|---|---|---|---|---|

| Thunderbit | Nein | Ja | Ja | Sheets, Excel, Airtable, Notion | Einfachste Einrichtung, KI-Felderkennung |

| Web Scraper | Nein | Nein | Eingeschränkt | CSV, JSON, Sheets (Cloud) | Visuelle Konfiguration, flexibel |

| BeautifulSoup | Ja | Nein | Nein | Individuell (CSV, JSON, DB) | Einfach, ideal zum Parsen |

| Scrapy | Ja | Nein | Ja | CSV, JSON, XML, API | Skalierbar, robustes Crawling |

| Playwright | Ja | Nein | Nein | Individuell | Für JS-lastige Seiten geeignet |

| Apify | Nein/Ja | Teilweise | Ja | CSV, JSON, Sheets, API | Cloud-Scale, vorgefertigte Actors |

Thunderbit: Der einfachste KI-Web-Scraper für Unternehmen

ist eine Chrome-Erweiterung, die KI-gestütztes Web-Scraping für alle zugänglich macht – besonders für Vertriebs-, E-Commerce- und Immobilienteams, die schnell Daten brauchen und nicht auf die IT warten wollen.

Highlights

![]()

- KI-Feldvorschläge: Mit einem Klick liest Thunderbit die Seite, schlägt passende Spalten vor und erstellt sogar individuelle Prompts für jedes Feld. Kein Rätselraten mehr.

- Unterseiten-Scraping: Mehr als nur Listen? Thunderbit besucht automatisch jede Unterseite und ergänzt die Datentabelle.

- Sofort nutzbare Scraper-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Instagram, Shopify usw.) einfach Vorlage auswählen und loslegen – ganz ohne KI-Credits.

- Geplante Scrapes: Zeitpläne in natürlicher Sprache beschreiben („jeden Montag um 9 Uhr“), Thunderbit übernimmt den Rest.

- E-Mail-, Telefon- und Bild-Extraktoren & KI-Autofill: Mit einem Klick Kontaktinfos oder Bilder extrahieren, Formulare automatisch ausfüllen oder Web-Workflows automatisieren.

- Cloud- vs. Browser-Scraping: Wähle Cloud (schnell, bis zu 50 Seiten gleichzeitig) oder Browser (für Seiten mit Login).

Und ja, es gibt eine , mit der du bis zu 6 Seiten (oder 10 mit Testphase) scrapen kannst. Für die meisten Unternehmen reicht das, um die Magie zu erleben (okay, fast Magie).

Wer Thunderbit in Aktion sehen will, findet auf unserem oder in unseren Anleitungen zu , oder viele Beispiele.

Web Scraper: Flexibles, browserbasiertes Daten-Tool

Web Scraper (von ) ist eine klassische Chrome-Erweiterung, die seit Jahren beliebt ist. Besonders „Citizen Data Analysts“, die nicht programmieren wollen, aber gerne tüfteln, greifen gerne darauf zurück. Das Tool arbeitet mit sogenannten „Sitemaps“ – visuellen Bauplänen, die dem Scraper zeigen, wie er sich durch die Seite bewegen und was er extrahieren soll.

- Point-and-Click-Oberfläche: Kein Code nötig, aber man muss lernen, wie man Elemente auswählt und Navigationspfade baut.

- Unterseiten & Paginierung: Ideal für mehrstufige Seiten, aber jede Stufe muss manuell konfiguriert werden.

- Exportmöglichkeiten: Standardmäßig CSV und JSON; Cloud-Nutzer können Daten auch nach Google Sheets oder Dropbox exportieren.

- Zeitplanung: Nur im kostenpflichtigen Cloud-Tarif verfügbar.

- Community-Support: Viel Doku und Foren, aber wenig Echtzeit-Hilfe.

Der größte Vorteil? Flexibilität. Der größte Nachteil? Die Lernkurve. Wie ein Nutzer es ausdrückte: „Nur die technikaffine Fraktion findet sich in diesem Tool zurecht“ (). Wer Geduld und Experimentierfreude mitbringt, kann fast jede Seite scrapen. Wer Abkürzungen sucht, ist mit einem einfacheren Tool besser beraten.

Einen ausführlichen Vergleich findest du in unserem .

BeautifulSoup: Python-Bibliothek für individuelle Datenextraktion

Jetzt wird’s technisch: ist eine beliebte Python-Bibliothek zum Parsen von HTML und XML. Wer Python kann, kann damit maßgeschneiderte Skripte für jede Extraktion schreiben.

- Keine Benutzeroberfläche: Alles läuft über Code.

- Flexibel und schlank: Perfekt für kleine bis mittlere Projekte oder als Teil größerer Python-Workflows.

- Teilweise Paginierungsunterstützung: Schleifen und Logik für Links und Paginierung müssen selbst geschrieben werden.

- Keine eingebaute Zeitplanung: Für Automatisierung sind externe Tools wie Cronjobs nötig.

- Individuelle Ausgabe: Ob CSV, JSON, Datenbank – du entscheidest, wohin die Daten gehen.

BeautifulSoup eignet sich für gezielte, schnelle Scrapes oder als Baustein in größeren Datenpipelines. Für riesige Crawls ist es weniger geeignet (dafür gibt’s Scrapy), aber für Python-Fans ein super Einstieg.

Scrapy: Leistungsstarkes Framework für große Datenmengen

Wenn BeautifulSoup das Schweizer Taschenmesser ist, dann ist der Werkzeugkoffer. Scrapy ist ein Python-Framework, das für großflächiges Crawling und Extraktion entwickelt wurde.

- Für Entwickler gemacht: Einrichtung über die Kommandozeile, Python-Klassen und strukturierte Projektordner.

- Tiefes Crawling: Folgt automatisch Links, paginiert und beachtet robots.txt.

- Hohe Performance: Asynchrone Requests, automatisches Drosseln, Caching und Wiederholungen.

- Anpassbare Pipelines: Ausgabe in CSV, JSON, XML oder direkt an APIs und Datenbanken.

- Zeitplanung: Mit Scrapy Cloud oder externen Tools automatisierbar.

- Erweiterbar: Middleware für Proxy-Rotation, User-Agent-Wechsel und sogar Headless-Browser-Integration (für JavaScript-Seiten).

Der Haken? Die Komplexität. Scrapy hat eine steile Lernkurve, aber wer tausende oder Millionen Seiten zuverlässig scrapen will, kommt kaum daran vorbei.

Playwright: Moderne Automatisierung für Web-Scraping

Manche Websites machen es Scraping-Tools schwer: Sie verstecken Daten hinter JavaScript, verlangen Logins oder fordern Klicks durch ein Labyrinth von Buttons. Hier kommt (siehe ) ins Spiel – eine moderne Automatisierungsbibliothek (für Python, JavaScript u.a.), mit der man einen echten Browser steuern kann – fast wie ein Mensch.

- Dynamische Inhalte: Ideal für React-, Angular- oder andere JS-lastige Seiten.

- Simuliert Nutzeraktionen: Klicks, Formulare ausfüllen, Scrollen, auf Elemente warten.

- Keine eingebaute Zeitplanung: Skripte müssen manuell oder per externem Scheduler ausgeführt werden.

- Individuelle Ausgabe: Du bestimmst, wohin die Daten gehen.

- Ressourcenintensiv: Jeder Browser-Tab braucht viel Speicher – am besten für mittlere Datenmengen.

Playwright ist der Türöffner für schwierige Websites. Wer von klassischen Scrapern ausgesperrt wird, kommt hiermit oft weiter. Für Nicht-Techniker ist es aber nichts – und langsamer als netzwerkbasierte Tools wie Scrapy.

Apify: Cloud-basierter Web-Scraper für skalierbare Datenextraktion

ist die Schweizer Taschenplattform fürs Web-Scraping. Sie bietet sowohl No-Code- als auch Code-Optionen und ist ideal für Teams, die skalieren wollen, ohne eigene Infrastruktur zu betreiben.

- Vorgefertigte „Actors“: Tausende fertige Scraper für Seiten wie Google Maps, LinkedIn, Zillow und mehr. Einfach Parameter eingeben und loslegen.

- Eigene Scraper: Entwickler können individuelle Actors in JavaScript oder Python bauen und deployen.

- Cloud-Scheduling & Skalierung: Mehrere Scrapes parallel, Zeitpläne festlegen, Apify übernimmt die Technik.

- Integrationen: Export nach CSV, JSON, Excel, Google Sheets oder Zugriff per API. Webhooks und Automatisierungstools wie n8n oder Make werden unterstützt.

- KI-Integrationen: Einige Actors nutzen bereits KI für intelligentere Extraktion und Datenklassifizierung.

- Lernkurve: Die Begriffe (Actors, Datasets, Proxies) können anfangs verwirren, aber die Doku ist gut.

Apify eignet sich für Organisationen mit gemischten Skills oder alle, die große Scrapes ohne Server- oder Proxy-Management wollen. Aber: Mit viel Power kommt auch etwas Komplexität (und nutzungsabhängige Preise).

Direktvergleich: Welcher Web-Scraper oder KI-Web-Scraper passt zu dir?

Hier ein detaillierter Vergleich, um das passende Tool zu finden:

| Tool | No-Code Friendly | Subpage/Pagination | Scheduling | Scalability | Best For |

|---|---|---|---|---|---|

| Thunderbit | ⭐⭐⭐⭐⭐ | Auto (KI) | Integriert | Mittel | Vertrieb, Ops, Immobilien |

| Web Scraper | ⭐⭐ | Manuelle Konfig | Nur Cloud | Mittel | Datenanalysten, Geduldige |

| BeautifulSoup | ⭐ | Manuell (Code) | Nein | Gering | Python-Entwickler, kleine Projekte |

| Scrapy | ⭐ | Auto (Code) | Ja | Hoch | Entwickler, große Crawls |

| Playwright | ⭐ | Manuell (Code) | Nein | Mittel | Entwickler, dynamische JS-Seiten |

| Apify | ⭐⭐⭐ | Abhängig vom Actor | Integriert | Hoch | Teams, skalierbare Projekte |

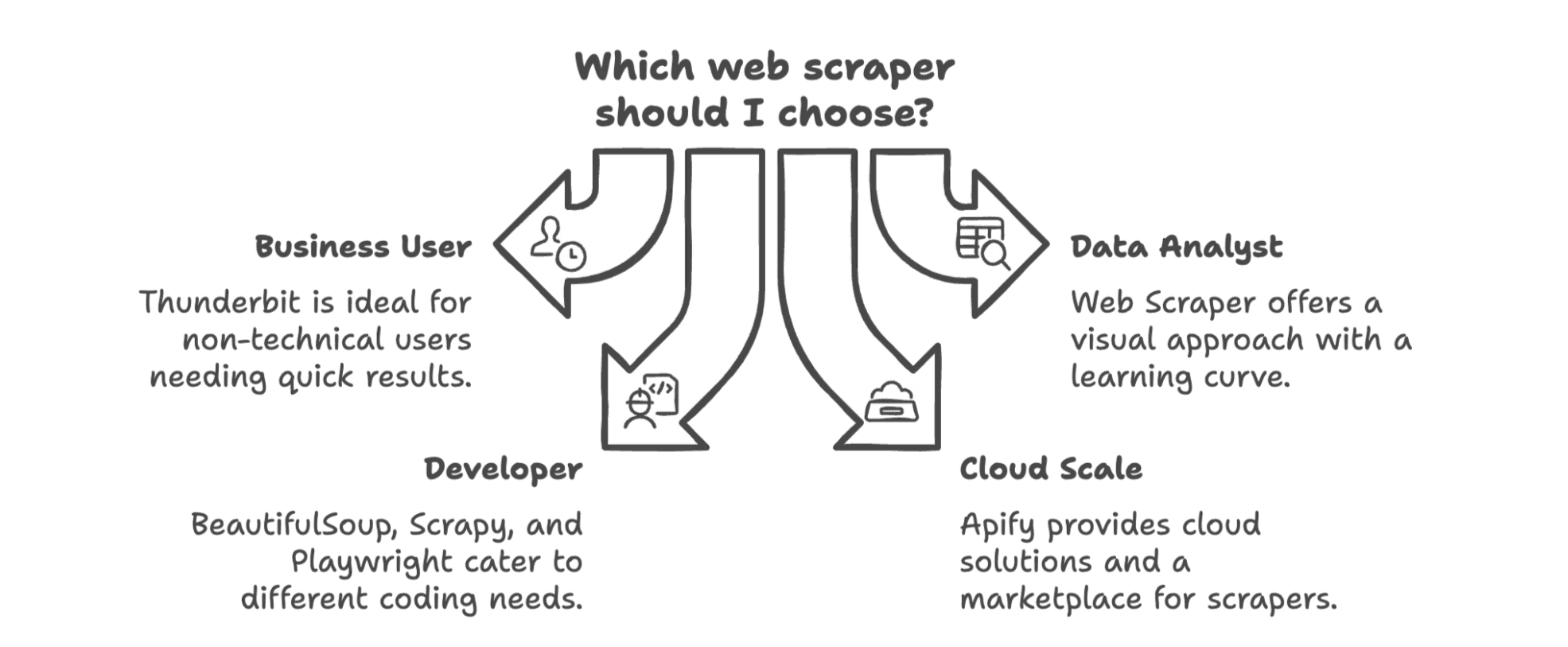

- Thunderbit: Ideal für Nicht-Techniker, die schnell Daten brauchen – mit minimalem Aufwand und KI-Automatisierung.

- Web Scraper: Gut für alle, die bereit sind, sich einzuarbeiten; flexibel, aber nicht ganz „Plug & Play“.

- BeautifulSoup/Scrapy/Playwright: Für Entwickler, die volle Kontrolle und keine Angst vor Code haben.

- Apify: Perfekt für Teams, die Cloud-Scale, vorgefertigte Lösungen und etwas Komplexität nicht scheuen.

Fazit: Der beste Web-Scraper für dein Unternehmen 2025

Was ist das Fazit? Der beste Web-Scraper hängt von deinem Team, deinen technischen Fähigkeiten und deinen Datenanforderungen ab.

- Für Business-Anwender (Vertrieb, Marketing, Operations), die ohne Code starten wollen, ist die beste Wahl. Entwickelt für dich, nicht für Entwickler – und du bist in Minuten startklar.

- Für Datenanalysten oder alle, die eine Lernkurve nicht scheuen, bietet Web Scraper viel Power, aber auch Trial & Error.

- Für Entwickler sind BeautifulSoup und Scrapy die Klassiker – BS4 für schnelle Skripte, Scrapy für große Crawls, Playwright für dynamische Seiten.

- Für Cloud-Scale oder einen Marktplatz mit fertigen Scrapern ist Apify stark, besonders für Teams mit gemischten Skills.

Nicht vergessen: Der Trend geht klar zu KI-gestützten No-Code-Lösungen, die sich direkt in deinen Workflow integrieren. Das alte „scrapen, downloaden, importieren, bereinigen, wiederholen“ hat ausgedient. Heute geht’s mit wenigen Klicks direkt von der Website ins Spreadsheet, CRM oder Notion.

Wer erleben will, wie einfach Web-Scraping sein kann, sollte die ausprobieren. Oder für mehr Tipps und Insights einfach im stöbern – inklusive How-tos und gelegentlichen schlechten Witzen von mir.

Auf ein 2025, in dem du endlich nicht mehr kopierst und einfügst – sondern die KI für dich arbeiten lässt.

Häufige Fragen

F1: Brauche ich 2025 noch Programmierkenntnisse für einen Web-Scraper? A: Nicht mehr. KI-Tools wie Thunderbit ermöglichen es auch Nicht-Technikern, mit wenigen Klicks Daten zu extrahieren – ganz ohne Code. Entwickler bevorzugen weiterhin Tools wie Scrapy oder Playwright für individuelle Logik.

F2: Welche Datentypen können KI-Web-Scraper extrahieren? A: Texte, Zahlen, Links, E-Mails, Telefonnummern, Bilder – sogar strukturierte Daten aus PDFs oder dynamischen Websites. Manche Tools bieten auch Terminierung, Übersetzung oder Kategorisierung direkt beim Export.

F3: Ist Web-Scraping für Unternehmen legal? A: Ja – solange du öffentlich zugängliche Daten für legitime Geschäftszwecke (z. B. Recherche oder Lead-Generierung) sammelst, ist das in der Regel erlaubt. Geschützte oder kostenpflichtige Inhalte solltest du ohne Erlaubnis nicht scrapen.

F4: Was ist der größte Vorteil von KI beim Web-Scraping? A: Geschwindigkeit und Zugänglichkeit. KI erkennt Felder, übernimmt Paginierung und automatisiert Workflows – so bleibt mehr Zeit für die Nutzung der Daten statt für die Konfiguration.

Mehr erfahren