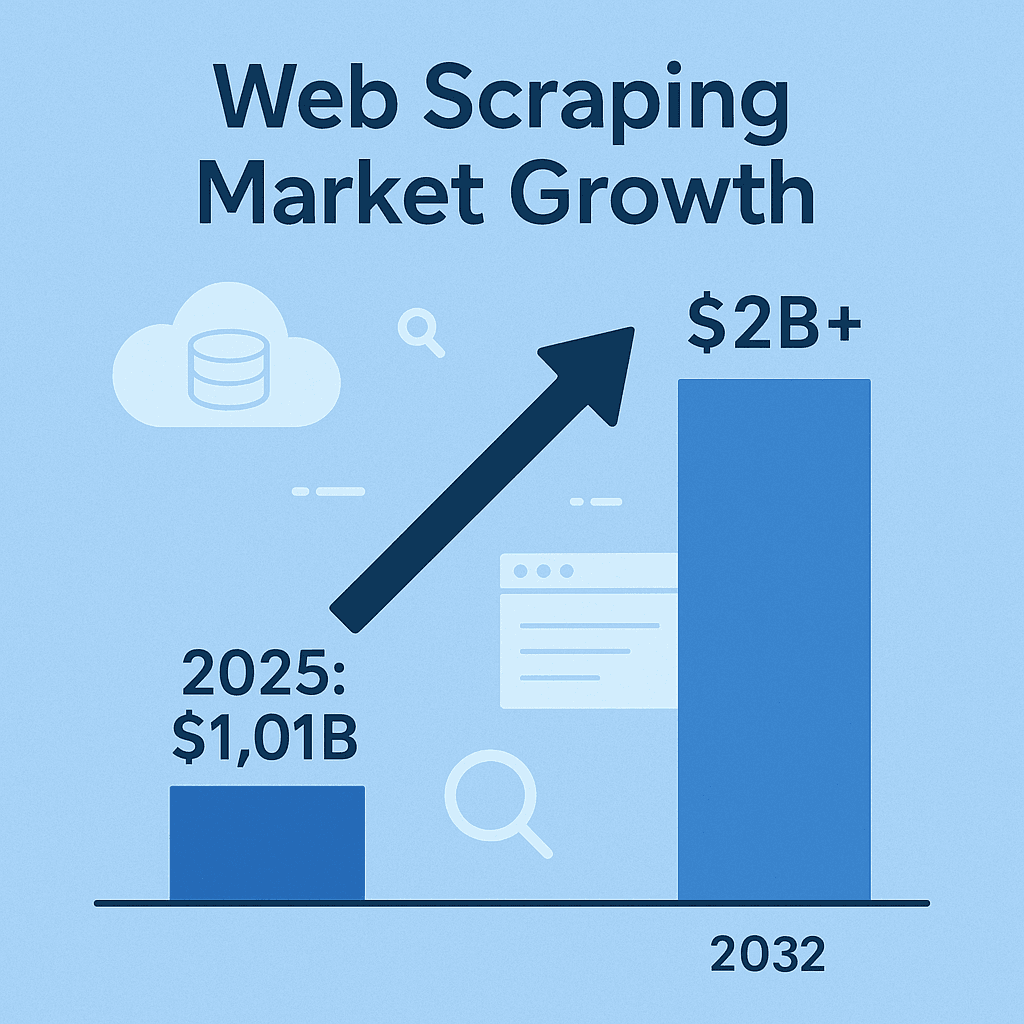

Web Scraping ist mittlerweile ein echter Geheimtipp, wenn es um moderne Business Intelligence, Vertriebssteuerung oder Marktanalysen geht. Wer heute keine Webdaten sammelt – sei es zu Wettbewerberpreisen, Produktangeboten, Marktstimmungen oder Leads – verpasst wertvolle Insights, die andere längst für sich nutzen. Der Markt für Web Scraping Software wird und soll sich bis 2032 sogar mehr als verdoppeln. Das ist keine kurzfristige Mode, sondern eine echte Revolution. Auch wenn Python oft im Rampenlicht steht, bleibt Java für viele Teams die erste Wahl, wenn es um Zuverlässigkeit, Geschwindigkeit und nahtlose Integration geht.

Nach vielen Jahren im SaaS- und Automatisierungsbereich kann ich bestätigen: Web Scraping mit Java ist lebendig wie eh und je – vor allem im Unternehmensumfeld, wo Stabilität, Multithreading und die Anbindung an Big Data Systeme entscheidend sind. Aber: Beim Scraping geht es nicht nur darum, Daten zu sammeln. Entscheidend ist, das Ganze effizient, sauber und – wenn du keinen Ärger mit der Rechtsabteilung willst – auch regelkonform zu machen. Also Ärmel hochgekrempelt: Hier kommen die wichtigsten Best Practices für Web Scraping mit Java – egal, ob du eigene Scraper baust oder mit KI-Tools wie deine Prozesse beschleunigen willst.

Web Scraping mit Java verstehen: Das solltest du wissen

Im Kern ist Web Scraping die Kunst (und manchmal auch Wissenschaft), automatisiert Informationen von Webseiten zu extrahieren. Der typische Ablauf: Dein Code schickt eine HTTP-Anfrage an eine Webseite, bekommt das HTML zurück, sucht gezielt nach den gewünschten Daten (z. B. Preise, Produktnamen, Bewertungen) und exportiert sie in ein nutzbares Format – etwa CSV, JSON oder direkt in eine Datenbank ().

Warum Java? Während Python für schnelle Skripte beliebt ist, punktet Java bei großen, langlaufenden und unternehmenskritischen Scraping-Projekten. Java ist statisch typisiert, robust und bietet ein breites Spektrum an Bibliotheken für Netzwerk, HTML-Parsing und Parallelisierung. Und wenn deine Datenpipeline sowieso auf Java basiert, profitierst du von reibungsloser Integration – ohne Sprachbarrieren ().

Kurz gesagt: Java-Scraper laufen tagelang, bewältigen riesige Datenmengen und fügen sich perfekt in bestehende Unternehmenssysteme ein. Entscheidend ist, die richtigen Tools zu kennen – und sie gezielt einzusetzen.

Die wichtigsten Java Web Scraping Tools und Bibliotheken

Hier die beliebtesten Java Web Scraping Libraries – jede hat ihre eigenen Stärken und Besonderheiten:

| Tool | Am besten geeignet für | Stärken | Einschränkungen |

|---|---|---|---|

| Jsoup | Statische HTML-Seiten, schnelle Extraktion | Schlank, einfache API, schnell, ideal für einfache Aufgaben | Kann kein JavaScript oder dynamische Inhalte verarbeiten |

| Selenium | Dynamische, interaktive Seiten | Steuert echte Browser, unterstützt JS, Nutzerinteraktionen, große Community | Ressourcenintensiv, langsamer, anfällig bei UI-Änderungen, benötigt Browser-Treiber |

| HtmlUnit | Headless-Browsing, moderates JS | Komplett in Java, kann etwas JS ausführen, kein externer Browser nötig | Langsamer als Jsoup, eingeschränkte Unterstützung moderner JS-Frameworks, kein Anti-Blocking |

| Playwright | Moderne JS-lastige Seiten, Automatisierung | Schnell, effizient, unterstützt mehrere Browser, kann Pop-ups und Multi-Page-Flows, Auto-Waiting | Noch junges Ökosystem, benötigt Browser-Ressourcen, weniger nativ für Java als Selenium |

(, )

Jsoup: Der Klassiker für statische HTML-Extraktion

ist das Standard-Tool für Java-Scraping, wenn es um statische Webseiten geht. Es funktioniert ähnlich wie jQuery für Java: Mit Jsoup.connect(URL).get() holst du die Seite, per CSS-Selektoren extrahierst du gezielt die gewünschten Daten. Alle <h1>-Überschriften? Kein Problem. Produktnamen in <div class="product-name">? Mit einer Zeile erledigt.

Beispiel: Produktnamen aus einer E-Commerce-Seite extrahieren

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements products = doc.select("div.product-name");

3for (Element product : products) {

4 System.out.println(product.text());

5}Jsoup ist schnell, unkompliziert und ideal für Blogposts, Produktlisten oder Nachrichtenartikel – aber: Es führt kein JavaScript aus. Ist die Information nicht im HTML-Quelltext, findet Jsoup sie nicht.

Selenium und HtmlUnit: Dynamische Inhalte meistern

Manchmal werden die gewünschten Daten erst durch JavaScript geladen oder sind hinter Nutzeraktionen (z. B. „Mehr laden“-Button) versteckt. Hier kommt ins Spiel. Selenium steuert echte Browser (Chrome, Firefox etc.), interagiert mit der Seite und holt die Inhalte wie ein Mensch.

HtmlUnit ist eine leichtere, rein in Java geschriebene Alternative, die mit einfachem JavaScript klarkommt – für moderne, JS-lastige Seiten reicht das aber meist nicht. Für React- oder Angular-Seiten empfiehlt sich Selenium oder Playwright.

Wann ein Headless-Browser sinnvoll ist: Wenn du dich einloggen, Buttons klicken oder Inhalte extrahieren musst, die erst nach Skriptausführung erscheinen, ist Browser-Automatisierung unverzichtbar. Allerdings sind diese Lösungen langsamer und wartungsintensiver – Webseiten ändern ihr Layout häufig.

Playwright: Moderne Automatisierung auf Höchstgeschwindigkeit

ist ein relativ neues Framework von Microsoft, das auf Geschwindigkeit und Zuverlässigkeit ausgelegt ist. Es ist bis zu 40–50 % schneller als Selenium, unterstützt verschiedene Browser-Engines und meistert auch komplexe Szenarien wie Pop-ups, Endlos-Scrollen und Multi-Page-Flows mit weniger Aufwand. Wer moderne, clientseitig gerenderte Seiten scrapen will, sollte Playwright ausprobieren.

Das richtige Java Web Scraping Tool auswählen

Nicht jedes Projekt braucht das große Besteck. So wähle ich das passende Tool:

- Komplexität der Webseite: Statisches HTML? Jsoup. Dynamisches JS? Selenium oder Playwright. Ein bisschen JS, aber überschaubar? HtmlUnit reicht oft.

- Datenmenge & Häufigkeit: Einmalige Extraktion? Einfach halten. Große, wiederkehrende Jobs? Tools mit Multithreading und Fehlerbehandlung bevorzugen.

- Bedienkomfort vs. Flexibilität: Jsoup ist schnell erlernt. Selenium/Playwright bieten mehr Möglichkeiten, erfordern aber mehr Setup und Wartung.

- Projektanforderungen & Budget: Open-Source-Bibliotheken sind kostenlos, aber du baust und wartest alles selbst. Bezahlte APIs oder Cloud-Lösungen sparen Zeit, kosten aber mehr.

Entscheidungsmatrix:

| Kriterium | Jsoup | Selenium | HtmlUnit | Playwright |

|---|---|---|---|---|

| Statisches HTML | ✔️ | ✔️ | ||

| Dynamisches JS | ✔️ | (teilw.) | ✔️ | |

| Geschwindigkeit | ✔️ | ✔️ | ||

| Einfache Nutzung | ✔️ | |||

| Logins/Klicks möglich | ✔️ | (einfach) | ✔️ | |

| Skalierbarkeit/Parallel | ✔️ | (schwieriger) | (ok) | ✔️ |

| Kostengünstig | ✔️ | ✔️ | ✔️ | ✔️ |

Starte möglichst einfach und steigere die Komplexität nur bei Bedarf. Und: Tools lassen sich auch kombinieren – manchmal ist ein hybrider Ansatz am effektivsten.

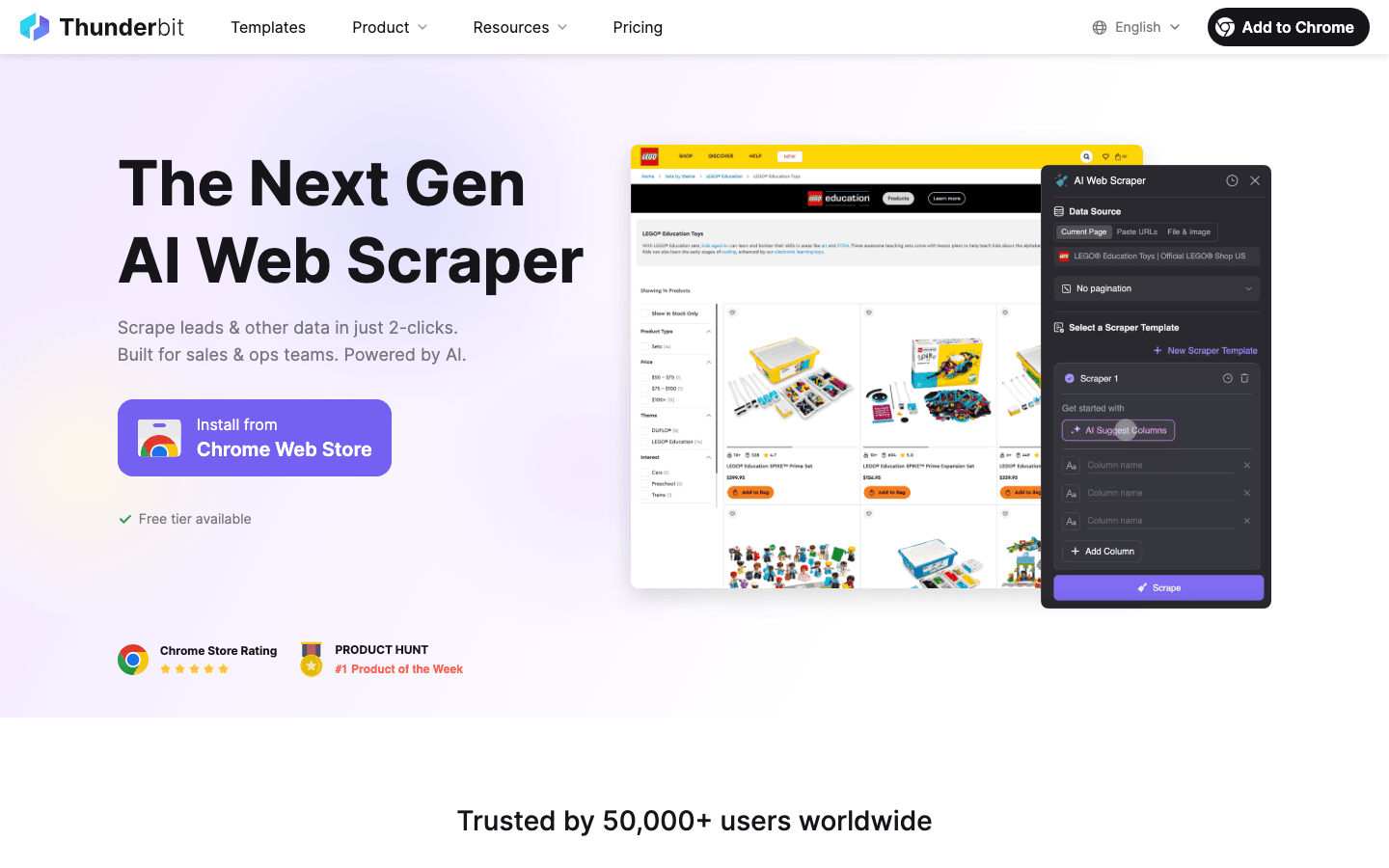

Thunderbit: Web Scraping für Java-Entwickler neu gedacht

Jetzt zu einer Lösung, die für viele Teams ein echter Gamechanger ist: . Thunderbit ist ein KI-Web-Scraper als Chrome-Erweiterung, mit dem du strukturierte Daten aus beliebigen Webseiten in wenigen Klicks extrahierst – ganz ohne Code, Vorlagen oder komplizierte Einstellungen.

So unterstützt Thunderbit Java-Entwickler und Business-Teams:

- KI-gestützte Felderkennung: Thunderbits KI analysiert die Seite und schlägt automatisch die besten Spalten zur Extraktion vor. Kein mühsames Suchen nach CSS-Selektoren oder fehleranfälliges Parsen mehr.

- Automatische Unterseiten-Navigation: Du brauchst Details von verlinkten Seiten? Thunderbit klickt sich automatisch durch Unterseiten und erweitert dein Dataset – ideal für Produktlisten mit Detailseiten.

- Paginierung & Endlos-Scroll: Thunderbit scrollt, klickt auf „Weiter“ und sammelt alle Daten, bis nichts mehr übrig ist.

- Strukturierter Export: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion. Oder lade CSV/JSON herunter und nutze die Daten in deiner Java-Anwendung.

- Cloud- oder Browser-Scraping: Führe Scrapes in der Cloud (bis zu 50 Seiten gleichzeitig – blitzschnell!) oder im Browser aus, falls ein Login nötig ist.

- Zeitplanung: Lege fest, wann Scrapes automatisch laufen sollen – täglich, wöchentlich oder nach deinem eigenen Zeitplan. Thunderbits KI versteht sogar natürliche Sprache („jeden Montag um 9 Uhr“).

Für Java-Entwickler ist Thunderbit ein echter Zeitsparer beim Prototyping, für schnelle Datenabfragen oder sogar im Produktivbetrieb – besonders, wenn auch nicht-technische Kollegen Daten selbstständig sammeln sollen.

Wie Thunderbit Sales- und Operationsteams unterstützt

Thunderbit ist nicht nur für Entwickler gedacht. Vertriebs-, Marketing-, E-Commerce- und Immobilienteams nutzen es täglich, um:

- Leads zu generieren: Kontaktdaten aus Verzeichnissen, LinkedIn oder Teilnehmerlisten extrahieren – ganz ohne Programmierkenntnisse.

- Wettbewerber zu beobachten: Preise, Produktangebote oder Marketingaktionen der Konkurrenz mit geplanten Scrapes im Blick behalten.

- Angebote aggregieren: Produkt-, Immobilien- oder Jobangebote von verschiedenen Seiten in einer strukturierten Tabelle zusammenführen.

Ich habe Teams erlebt, die in weniger als zehn Minuten von „Wir bräuchten diese Daten“ zu „Hier ist die Tabelle“ gekommen sind. Dank Unterseiten-Scraping und KI-gestützter Felderkennung werden selbst unstrukturierte Webseiten problemlos auswertbar.

Datenqualität bei Java Web Scraping sicherstellen

Daten zu sammeln ist nur die halbe Miete. Sind sie unvollständig, fehlerhaft oder veraltet, bringt das wenig. So halte ich meine Scraper und Daten sauber:

- Validieren und bereinigen: Prüfe auf Korrektheit, Vollständigkeit und Konsistenz. Mit Javas starker Typisierung fallen Ausreißer (z. B. Preis „N/A“ statt Zahl) schnell auf. Formate vereinheitlichen – etwa für Datum, Währung oder Telefonnummern ().

- Duplikate vermeiden: Scraping produziert oft doppelte Einträge. Nutze eindeutige Schlüssel (z. B. URLs oder IDs) und Javas

Set-Sammlungen, um Wiederholungen zu filtern. - Qualitätschecks automatisieren: Nach jedem Scrape Plausibilitätsprüfungen durchführen – stimmen die erwarteten Mengen? Sind Felder plötzlich leer? Auffälligkeiten loggen und ggf. Benachrichtigungen einrichten.

- Daten sinnvoll speichern: Bei großen Jobs Daten direkt in eine Datenbank (Postgres, MongoDB etc.) schreiben statt alles im Speicher zu halten. Das erleichtert auch die Duplikaterkennung ().

Fehlerbehandlung und Ausfallsicherheit: Robuste Scraper bauen

Web Scraping ist kein Selbstläufer. Webseiten sind mal offline, HTML-Strukturen ändern sich, Anti-Bot-Maßnahmen greifen. So bleibt dein Scraper stabil:

- Fehler elegant abfangen: HTTP-Fehler (404, 500), Timeouts und Parsing-Fehler abfangen. Fehlgeschlagene Anfragen mit exponentiellem Backoff wiederholen – nicht einfach den Server bombardieren ().

- Anpassungsfähigkeit: Robuste Selektoren, Null-Prüfungen und Fallback-Logik nutzen. Bei Strukturänderungen das Roh-HTML für die Fehlersuche speichern.

- Logging und Benachrichtigungen: Jeden Abruf, Erfolg und Fehler protokollieren. Bei kritischen Problemen (z. B. keine Items gefunden) Alarme auslösen.

- Checkpoints setzen: Bei langen Jobs regelmäßig den Fortschritt speichern. So kannst du nach einem Absturz weitermachen.

- Anfragen drosseln: Fair bleiben – Pausen zwischen Anfragen, begrenzte Parallelität und wechselnde User-Agent-Strings helfen, nicht blockiert zu werden.

Beispiel für Retry-Logik in Java:

1Document doc = null;

2for (int attempt = 1; attempt <= MAX_RETRIES; attempt++) {

3 try {

4 doc = Jsoup.connect(url).timeout(5000).get();

5 break;

6 } catch (IOException e) {

7 log("Versuch " + attempt + " fehlgeschlagen: " + e.getMessage());

8 Thread.sleep(1000 * attempt); // Exponentielles Backoff

9 }

10}()

Rechtliche und ethische Aspekte beim Web Scraping

Web Scraping ist kein rechtsfreier Raum. Wer Regeln ignoriert, riskiert Sperren, Abmahnungen oder Schlimmeres.

- Datenhoheit respektieren: Das Scrapen öffentlicher, nicht-sensibler Daten ist meist legal. Personenbezogene Daten (z. B. Namen, E-Mails) sind durch Gesetze wie DSGVO und CCPA geschützt. PII nur mit rechtlicher Grundlage sammeln ().

- AGB und robots.txt beachten: Wenn eine Seite Scraping verbietet, sollte man das respektieren – oder sich des Risikos bewusst sein. Immer robots.txt und Rate-Limits einhalten.

- Server nicht überlasten: Anfragen drosseln, Parallelität begrenzen und nie so aggressiv scrapen, dass die Seite leidet ().

- Urheberrecht und Logins beachten: Keine urheberrechtlich geschützten Inhalte scrapen und veröffentlichen. Daten hinter Logins nur mit Erlaubnis abrufen.

- Daten sicher und anonym speichern: Sensible Informationen sicher ablegen und Löschanfragen beachten.

Praktische Tipps für ethisches Web Scraping

- Vor dem Scraping AGB und robots.txt prüfen.

- Aussagekräftigen User-Agent verwenden (nicht nur „Java/1.8.0_201“).

- Anfragerate und Parallelität begrenzen.

- Wenn möglich, APIs oder öffentliche Datensätze bevorzugen.

- Dokumentieren, was und warum gescrapt wird.

- Über aktuelle Gesetze und Best Practices informiert bleiben ().

Performance optimieren: Java Web Scraper skalieren

Wenn der Datenbedarf wächst, zählt Performance. So skalierst du effizient:

- Anfragen parallelisieren: Mit Javas

ExecutorServiceoder Threadpools mehrere Seiten gleichzeitig abrufen. Parallelität steuern, um die Zielseite nicht zu überlasten (). - Daten streamen: Ergebnisse direkt in eine Datei oder Datenbank schreiben – nicht alles im Speicher halten.

- Effizientes Parsen: Mit Jsoup-Selektoren gezielt parsen. Bei sehr großen Jobs auf Streaming oder leichtere Parser setzen.

- Cloud-Ressourcen nutzen: Scraper auf Cloud-Servern laufen lassen für mehr Bandbreite und Zuverlässigkeit. Oder Cloud-Scraping-Plattformen wie Thunderbit für große Volumina nutzen.

- Netzwerkauslastung optimieren: Kompression nutzen, Scraper möglichst nah an der Zielseite betreiben und Antworten cachen, wenn möglich.

Beispiel für Multithreading in Java:

1ExecutorService pool = Executors.newFixedThreadPool(10);

2for (String url : urlList) {

3 pool.submit(() -> scrapePage(url));

4}

5pool.shutdown();()

Fazit: Die wichtigsten Erfolgsfaktoren für Web Scraping mit Java

Zusammengefasst – das brauchst du für erfolgreiches Web Scraping mit Java:

- Das richtige Tool wählen: Jsoup für statische Seiten, Selenium/Playwright für dynamische Inhalte, HtmlUnit für Headless-Scraping in Java.

- Automatisierung und KI nutzen: Tools wie beschleunigen Felderkennung, Unterseiten-Scraping und Datenexport – ideal für Business-User und schnelles Prototyping.

- Datenqualität sichern: Daten validieren, bereinigen, Duplikate entfernen und sinnvoll speichern.

- Rechtskonform bleiben: Rechtliche und ethische Grenzen respektieren – nur öffentliche Daten scrapen, Regeln der Seite beachten, keine personenbezogenen Daten ohne Erlaubnis sammeln.

- Für Skalierung optimieren: Javas Parallelisierung, effiziente Speicherung und Cloud-Ressourcen nutzen, um große Datenmengen zu bewältigen.

Web Scraping ist mehr als eine technische Fähigkeit – es ist ein echter Wettbewerbsvorteil. Egal ob du als Entwickler robuste Java-Scraper baust oder als Sales/Operations-Profi mit Thunderbit die Datensammlung automatisierst: Mit diesen Best Practices bist du bestens aufgestellt.

Neugierig auf KI-gestütztes Scraping? und erlebe, wie einfach sich jede Website in strukturierte Daten verwandeln lässt. Mehr Tipps, Vergleiche und Praxisbeispiele findest du im .

FAQs

1. Warum ist Java nach wie vor eine starke Wahl für Web Scraping?

Java steht für Zuverlässigkeit, leistungsfähiges Multithreading und nahtlose Integration in Unternehmenssysteme. Ideal für große, langlaufende oder performante Scraping-Projekte – besonders, wenn die Datenpipeline bereits auf Java basiert ().

2. Was unterscheidet Jsoup, Selenium, HtmlUnit und Playwright?

Jsoup eignet sich für statisches HTML; Selenium und Playwright meistern dynamische, JS-lastige Seiten; HtmlUnit ist ein reiner Java-Headless-Browser für moderates JS. Die Wahl hängt von der Komplexität der Seite und den Projektanforderungen ab ().

3. Wie unterstützt Thunderbit Java-Entwickler und Business-User?

Thunderbit nutzt KI, um Felderkennung, Unterseiten-Navigation und Datenstrukturierung zu automatisieren – ganz ohne Programmierung. Perfekt für Business-User oder Entwickler, die schnell Prototypen bauen oder Kollegen ohne IT-Kenntnisse befähigen wollen ().

4. Was sind Best Practices für Datenqualität beim Web Scraping?

Daten validieren und bereinigen, Duplikate entfernen, Qualitätschecks automatisieren und Ergebnisse bei großen Jobs in Datenbanken speichern. Gescrapte Daten immer als Rohmaterial betrachten, das weiterverarbeitet werden muss ().

5. Wie bleibe ich beim Web Scraping rechtlich und ethisch auf der sicheren Seite?

Nur öffentliche, nicht-sensible Daten scrapen; robots.txt und Nutzungsbedingungen beachten; Server nicht überlasten; keine personenbezogenen Daten ohne rechtliche Grundlage sammeln. Über Gesetze wie DSGVO und CCPA informiert bleiben ().

Bereit, dein Web Scraping auf das nächste Level zu bringen? Teste Thunderbit kostenlos oder entwickle deinen eigenen Java-Scraper – mit diesen Best Practices bist du bestens gerüstet. Viel Erfolg – und denk daran: Verantwortungsbewusst coden, ethisch scrapen und Daten immer sorgfältig prüfen, bevor du große Entscheidungen triffst.

Mehr erfahren