Daten von Webseiten zu sammeln klingt erstmal simpel – bis du zum zehnten Mal auf „Weiter“ klickst und merkst, dass du gerade mal an der Oberfläche kratzt. Wer schon mal einen Produktkatalog aufgebaut, eine Lead-Liste erstellt oder Immobilienangebote analysiert hat, weiß: Die wirklich spannenden Infos verstecken sich oft erst auf Seite zwei, drei oder fünfzig. Aus eigener Erfahrung kann ich sagen: Die wichtigsten Geschäftsdaten sind fast immer über mehrere Seiten verteilt. Wer diese Seiten übersieht, verpasst nicht nur wertvolle Erkenntnisse, sondern riskiert auch, dass der Chef unzufrieden ist.

Die gute Nachricht: Du musst dich nicht mit lückenhaften Datensätzen zufriedengeben oder stundenlang Copy & Paste machen. Mit Web-Scraper-Paginierung – vor allem in Kombination mit KI-Tools wie – holst du wirklich jede Zeile raus, egal wie tief die Daten versteckt sind. Lass uns anschauen, was Web-Scraper-Paginierung eigentlich ist, warum sie so wichtig ist und wie Thunderbit das Extrahieren über mehrere Seiten super einfach macht.

Was ist Web-Scraper-Paginierung und warum ist sie so wichtig?

Web-Scraper-Paginierung bedeutet, Daten von Webseiten zu extrahieren, die ihre Inhalte auf mehrere Seiten aufteilen. Denk an Online-Shops wie Amazon, Immobilienportale wie Zillow oder Branchenverzeichnisse – all diese Seiten paginieren ihre Listen, damit alles übersichtlich bleibt und die Seite schnell lädt. Für die Datenerfassung heißt das: Dein Scraper muss automatisch „umblättern“, genau wie ein Mensch.

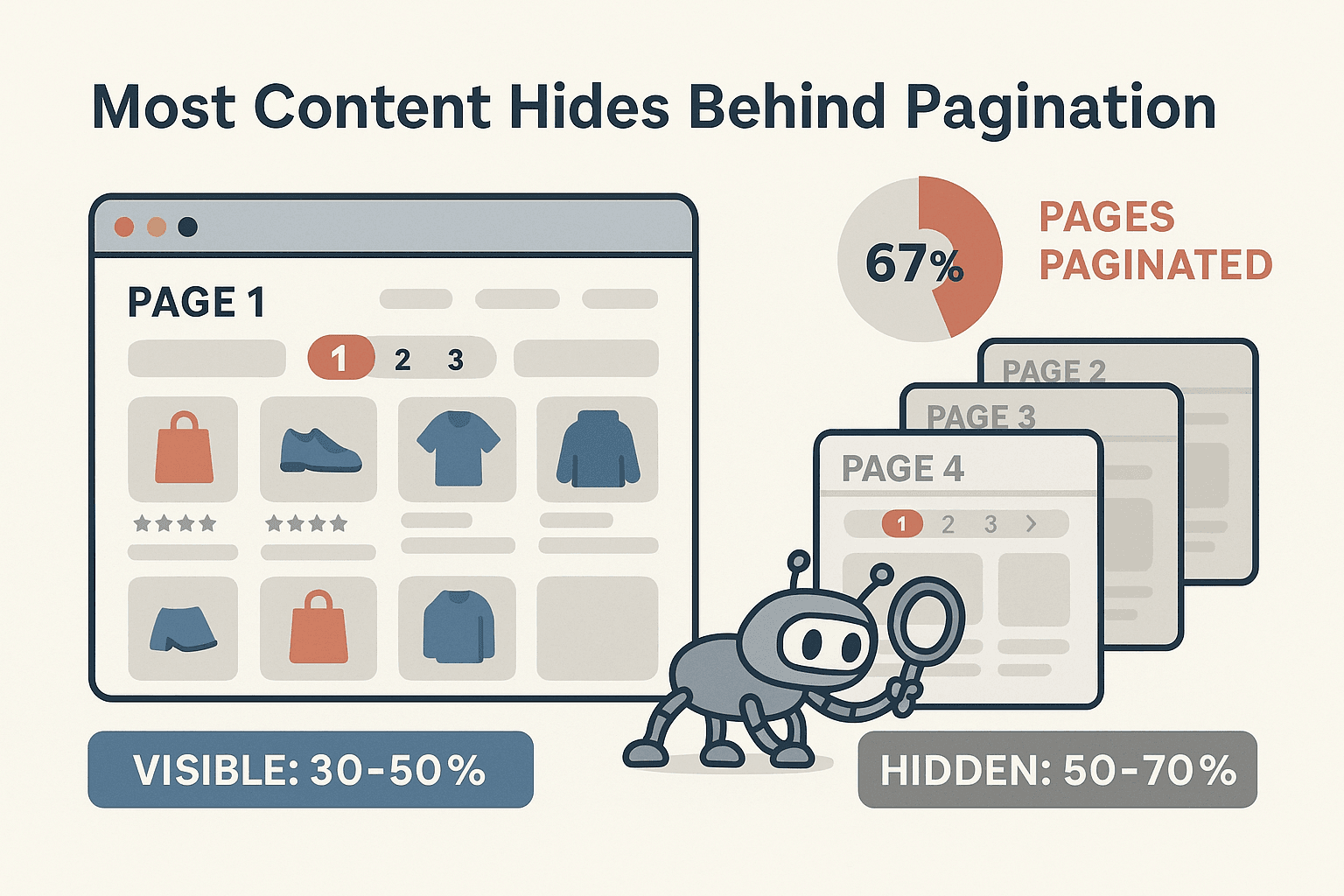

Warum ist das so wichtig? Weil die meisten relevanten Daten eben nicht auf der ersten Seite stehen. Tatsächlich sind einer Website paginiert, und Studien zeigen, dass 30–50 % der Produktinfos auf Folgeseiten versteckt sind. Wer nur die erste Seite abruft, lässt also den Großteil der Daten – und damit viele Chancen – einfach liegen.

Fehlende paginierte Daten können echte Folgen für dein Business haben. Stell dir vor, du analysierst Preise, vergleichst aber nur die ersten 20 Produkte. Oder du erstellst eine Lead-Liste und übersiehst die meisten potenziellen Kontakte. Das ist nicht nur unvollständig, sondern auch riskant. Mit Web-Scraper-Paginierung sicherst du dir alle relevanten Infos – ganz ohne monotone Handarbeit.

Gängige Paginierungsarten und ihre Herausforderungen beim Web Scraping

Nicht jede Paginierung läuft gleich ab. Webseiten nutzen verschiedene Methoden, um Inhalte aufzuteilen – und jede bringt ihre eigenen Tücken für Scraper mit:

„Weiter“-Button-Paginierung

Der Klassiker: Ein „Weiter“- oder „>“-Button am Seitenende führt dich durch die Ergebnisse. Diese Methode findest du überall – bei Amazon, LinkedIn, Yelp und vielen anderen. Die Herausforderung für Scraper: Das wiederholte Klicken auf „Weiter“ muss automatisiert werden, und der Scraper muss erkennen, wann Schluss ist. Wird der Button übersehen, fehlen Daten.

Seitenzahlen-Paginierung

Manche Seiten zeigen eine Reihe von Seitenzahlen – „1 2 3 … 10 Weiter“ – und erlauben das direkte Springen zu einer bestimmten Seite. Klingt einfach, kann aber tricky werden, wenn sich die Links dynamisch ändern oder der „Weiter“-Button nach einer bestimmten Seite verschwindet. Die Gefahr: Seiten werden übersprungen oder doppelt erfasst.

Unendliches Scrollen und „Mehr laden“-Buttons

Viele moderne Webseiten setzen auf unendliches Scrollen: Beim Herunterscrollen werden automatisch weitere Inhalte geladen. Alternativ gibt es einen „Mehr laden“-Button, der neue Ergebnisse anzeigt. Für klassische Scraper ist das besonders schwierig, weil die Daten dynamisch per JavaScript nachgeladen werden. Kann dein Tool kein Scrollen oder Klicken simulieren, bleibt es bei den ersten Ergebnissen ().

Die manuelle Qual

Diese Paginierungsarten per Hand zu bewältigen, ist ein Rezept für Mausarm und Datenchaos. Stell dir vor, du klickst 50-mal auf „Weiter“, kopierst und fügst jede Seite ein und verlierst dabei womöglich noch den Überblick. Das ist nicht nur mühsam, sondern garantiert auch, dass wichtige Infos verloren gehen.

Wie Thunderbits KI die Web-Scraper-Paginierung automatisiert

Hier kommt ins Spiel und macht die Datenerfassung für Unternehmen richtig smart. Anstatt selbst Schleifen zu bauen oder eigene Skripte zu schreiben, erkennt Thunderbits KI automatisch die Paginierung und navigiert durch alle Seiten – egal ob „Weiter“-Button, Seitenzahlen, unendliches Scrollen oder „Mehr laden“-Funktion ().

KI-gesteuerte Erkennung und Navigation

Thunderbits KI liest Webseiten wie ein Mensch. Sie findet die Paginierungs-Elemente – egal wie sie heißen oder aussehen – und klickt automatisch darauf. Gibt es einen „Weiter“-Button, klickt Thunderbit so lange, bis keine weiteren Seiten mehr da sind. Bei unendlichem Scrollen scrollt Thunderbit, bis alles geladen ist. So bekommst du immer einen vollständigen Datensatz, ohne dass du manuell eingreifen oder Einstellungen anpassen musst.

Das Besondere: Thunderbit passt sich an Änderungen an. Ändert eine Website das Layout oder ersetzt „Weiter“ durch ein Pfeil-Icon, erkennt die KI das sofort. Ein riesiger Vorteil gegenüber klassischen, regelbasierten Scraper-Tools, die bei jeder kleinen Änderung aussteigen.

Paginierung per natürlicher Sprache einrichten

Du musst kein Technikprofi sein, um Thunderbit zu nutzen. Beschreib einfach in Alltagssprache, was du brauchst – zum Beispiel: „Extrahiere alle Produkte aus dieser Kategorie, inklusive Name, Preis und Bewertung.“ Thunderbits KI richtet den Scraper inklusive Paginierung automatisch ein. Die Funktion „KI-Felder vorschlagen“ scannt die Seite, schlägt passende Spalten vor und übernimmt die Paginierungslogik im Hintergrund. Kein Programmieren, kein manuelles Mapping, kein Stress.

Schritt-für-Schritt-Anleitung: So nutzt du Thunderbit für Web-Scraper-Paginierung

Hier zeigen wir, wie du mit Thunderbit Daten von einer paginierten Website extrahierst – zum Beispiel von Amazon oder Zillow. Du wirst sehen, wie einfach du von „Ich brauche alle diese Daten“ zu „Hier ist meine vollständige Tabelle“ kommst.

Schritt 1: Thunderbit installieren und starten

Lade zuerst die herunter. Klicke auf „Zu Chrome hinzufügen“, erstelle ein kostenloses Konto und pinne die Erweiterung an deine Symbolleiste. In weniger als zwei Minuten bist du startklar.

Schritt 2: Zielseite aufrufen

Öffne deinen Browser und geh auf die gewünschte Website. Für unser Beispiel nehmen wir eine Amazon-Suchergebnisseite für „Gaming-Laptops“. Falls die Seite einen Login braucht (wie LinkedIn), melde dich zuerst an, damit Thunderbit auf die Inhalte zugreifen kann.

Schritt 3: Mit „KI-Felder vorschlagen“ die Extraktion einrichten

Klicke auf das Thunderbit-Icon. Im Seitenmenü wählst du „KI-Felder vorschlagen“. Thunderbit scannt die Seite und schlägt Spalten wie Produktname, Preis, Bewertung und Produkt-URL vor. Du kannst Felder bearbeiten, hinzufügen oder entfernen. Thunderbits KI erkennt außerdem, dass es sich um eine paginierte Liste handelt, und bereitet die Extraktion aller Seiten automatisch vor – ganz ohne zusätzliche Einstellungen.

Schritt 4: Scraping starten und Fortschritt überwachen

Klicke auf „Scrapen“, um die Extraktion zu starten. Thunderbit sammelt die Daten der aktuellen Seite und navigiert dann automatisch durch alle Folgeseiten – klickt auf „Weiter“, scrollt oder lädt weitere Ergebnisse, je nach Bedarf. Die Tabelle füllt sich in Echtzeit. Bei großen Projekten kann Thunderbits Cloud-Modus bis zu 50 Seiten gleichzeitig erfassen – das spart richtig viel Zeit.

Du kannst den Vorgang jederzeit pausieren, stoppen oder anpassen. Falls ein Feld nicht korrekt erfasst wird, kannst du „KI-Felder vorschlagen“ erneut ausführen.

Schritt 5: Strukturierte Daten exportieren

Nach Abschluss zeigt Thunderbit die Ergebnisse in einer Tabelle an. Exportiere die Daten als Excel, CSV oder schick sie direkt an Google Sheets, Airtable oder Notion. Jede Zeile von jeder Seite – übersichtlich und bereit zur Analyse.

Praxisbeispiel: Mehrseitige Daten aus Online-Shops extrahieren

Angenommen, du willst alle „Gaming-Laptops“ auf Amazon analysieren. Normalerweise müsstest du jede Seite einzeln kopieren – eine echte Geduldsprobe (und eine Belastung fürs Handgelenk). Mit Thunderbit gehst du so vor:

- Rufe die Amazon-Suchergebnisse für „Gaming-Laptops“ auf.

- Klicke auf Thunderbit, nutze „KI-Felder vorschlagen“ und starte das Scraping.

- Thunderbit navigiert durch alle 20+ Seiten und sammelt Produktnamen, Preise, Bewertungen und mehr.

- Exportiere die Daten nach Excel.

Das Ergebnis? Eine Tabelle mit Hunderten von Produkten, nicht nur den ersten 20. Du kannst nach Preis sortieren, nach Bewertung filtern oder eigene Analysen machen – und bist sicher, dass du nichts übersehen hast.

So könnte dein Datensatz aussehen:

| Produktname | Preis | Bewertung | Anzahl Bewertungen |

|---|---|---|---|

| Acer Nitro 5 Gaming Laptop | $799.99 | 4.5 | 1.234 |

| ASUS TUF Gaming F15 | $1.099,00 | 4.6 | 567 |

| HP Pavilion Gaming Laptop | $699.99 | 4.3 | 845 |

| ...und viele weitere Zeilen... | ... | ... | ... |

Das klappt genauso mit Zillow, Shopify, LinkedIn oder jeder anderen Seite mit Paginierung.

Thunderbit im Vergleich zu anderen Web-Scraper-Paginierungstools

Wie schlägt sich Thunderbit im Vergleich zu anderen bekannten Tools wie Octoparse und ParseHub? Hier ein Überblick:

| Tool | Paginierungs-Einrichtung | Benutzerfreundlichkeit | KI-Funktionen | Datenqualität & Vollständigkeit | Einschränkungen |

|---|---|---|---|---|---|

| Thunderbit | Automatisch (KI erkennt und navigiert) | Sehr einfach (2-Klick-Setup) | Ja (Felderkennung, natürliche Sprache, passt sich an Änderungen an) | Hoch (bewältigt dynamische, wechselnde Seiten) | Neues Tool; manche KI-Prompts erfordern Einarbeitung |

| Octoparse | Manuell (Nutzer richtet Schleife ein) | Mittel (visuelle Oberfläche) | Nein (nur Mustererkennung) | Gut (bei richtiger Konfiguration) | Manuelle Paginierung; kann bei Änderungen ausfallen |

| ParseHub | Manuell (Nutzer fügt „nächste Seite“-Schritt hinzu) | Mittel (visuelle Oberfläche) | Nein | Gut (bei richtiger Konfiguration) | Kann Daten übersehen; langsamer bei großen Projekten |

Thunderbits größter Vorteil ist die KI-gesteuerte Automatisierung. Du musst keine Schleifen oder Selektoren manuell einrichten. Die KI passt sich an Webseitenänderungen an, reduziert Wartungsaufwand und minimiert das Risiko, Daten zu verpassen. Octoparse und ParseHub sind leistungsfähig, brauchen aber mehr Handarbeit – besonders bei der Paginierung ().

Tipps für maximale Effizienz bei der Web-Scraper-Paginierung

So holst du das Maximum aus deinen paginierten Scraping-Projekten raus:

- Immer auf Paginierung prüfen: Achte darauf, dass dein Tool „Weiter“-Buttons, Seitenzahlen oder unendliches Scrollen erkennt. Bei Thunderbit läuft das automatisch, aber ein kurzer Test schadet nie.

- KI-Feld-Prompts nutzen: Mit Thunderbit kannst du individuelle Anweisungen für Felder geben – zum Beispiel „nur die Stadt aus der Adresse extrahieren“. So bleibt dein Datensatz über alle Seiten hinweg sauber und einheitlich.

- Große Datenmengen planen: Bei Hunderten von Seiten lohnt es sich, den Job in Abschnitte zu teilen oder den Cloud-Modus für mehr Speed zu nutzen.

- Anti-Scraping-Maßnahmen beachten: Manche Seiten blocken zu viele Anfragen. Thunderbits Browser-Modus hilft hier, und du kannst das Scraping bei Bedarf verlangsamen.

- Wiederkehrende Scrapes einplanen: Wenn du regelmäßig aktuelle Daten brauchst, nutze Thunderbits Zeitplan-Funktion („jeden Montag um 9 Uhr“), um den Prozess zu automatisieren.

- Letzte Seite prüfen: Kontrolliere nach dem Scraping, ob auch die letzte Seite erfasst wurde – vergleiche die letzte Zeile deiner Tabelle mit dem letzten Eintrag auf der Website.

- Gut organisieren: Verwende klare Dateinamen und behalte den Überblick über deine Exporte, besonders bei großen oder wiederkehrenden Projekten.

Fazit & wichtigste Erkenntnisse

Web-Scraper-Paginierung ist der Schlüssel zu vollständigen, aussagekräftigen Datensätzen aus dem Web. Da bis zu 70 % der geschäftsrelevanten Daten auf Folgeseiten liegen, solltest du Paginierung auf keinen Fall ignorieren. Manuelle Extraktion ist langsam, fehleranfällig und lückenhaft – KI-gestützte Tools wie Thunderbit machen den Prozess schnell, präzise und für jeden zugänglich.

Das solltest du dir merken:

- Paginierung ist überall: Online-Shops, Immobilienportale, Verzeichnisse und mehr.

- Thunderbits KI meistert alles: „Weiter“-Buttons, Seitenzahlen, unendliches Scrollen und „Mehr laden“ – ganz ohne manuelle Einrichtung.

- Du bekommst immer vollständige Daten: Keine fehlenden Seiten oder unvollständigen Datensätze mehr.

- Für alle einfach zu bedienen: Natürliche Sprache, KI-Feldvorschläge und Export zu Excel, Google Sheets, Airtable oder Notion.

- Produktivität steigt: Unternehmen, die KI-gestütztes Web Scraping nutzen, sparen 30–40 % Zeit bei der Datenerfassung ().

Bereit, das manuelle Blättern hinter dir zu lassen? und erlebe, wie einfach Web-Scraper-Paginierung sein kann. Noch mehr Tipps und Insights findest du im .

FAQs

1. Was ist Web-Scraper-Paginierung?

Web-Scraper-Paginierung heißt, Daten von Webseiten zu extrahieren, die ihre Inhalte auf mehrere Seiten verteilen. So stellst du sicher, dass du alle verfügbaren Daten bekommst – nicht nur die der ersten Seite.

2. Warum ist Paginierungsunterstützung für die Datenerfassung wichtig?

Weil die meisten geschäftsrelevanten Daten – wie Produktlisten oder Kontaktverzeichnisse – über mehrere Seiten verteilt sind. Ohne Paginierungsunterstützung verpasst du 30–70 % der Daten.

3. Wie geht Thunderbit mit verschiedenen Paginierungsarten um?

Thunderbits KI erkennt und navigiert automatisch durch „Weiter“-Buttons, Seitenzahlen, unendliches Scrollen und „Mehr laden“-Buttons. Du musst nichts manuell einrichten oder programmieren.

4. Kann ich mit Thunderbit Daten von Seiten wie Amazon oder Zillow extrahieren?

Klar! Thunderbit ist darauf ausgelegt, beliebte Online-Shops, Immobilien- und Verzeichnisseiten zu erfassen – über alle Seiten hinweg und mit Export zu Excel, Google Sheets, Airtable oder Notion.

5. Was macht Thunderbit bei der Paginierung besser als andere Web-Scraping-Tools?

Thunderbit nutzt KI, um die Paginierung zu automatisieren, passt sich an Webseitenänderungen an und braucht keine manuelle Konfiguration. Es ist schneller, präziser und einfacher zu bedienen als klassische Tools wie Octoparse oder ParseHub.

Viel Erfolg beim Scrapen – und mögen deine Datensätze immer vollständig sein!

Mehr erfahren