Stell dir vor, du launchst deine Website, bist bereit für einen Ansturm neuer Kund:innen – und dann merkst du: Die Hälfte deines Traffics kommt gar nicht von echten Menschen, sondern von Bots. Keine Science-Fiction, sondern Alltag im Netz: Digitale Crawler – von Suchmaschinen, KI-Bots bis hin zu Analyse-Tools – surfen rund um die Uhr auf deiner Seite, wie eine unsichtbare Welle von Besuchern. Im Jahr 2026 ist das längst Standard. Zu wissen, wer oder was deine Website eigentlich crawlt, wie oft und warum, ist heute ein Muss für jedes Online-Business.

Ich bin seit Jahren in SaaS, Automatisierung und KI unterwegs und habe hautnah erlebt, wie sich web crawling von einer technischen Randnotiz zu einer echten Business-Challenge entwickelt hat. Die Zahlen sprechen für sich: Fast die Hälfte des gesamten Internet-Traffics stammt mittlerweile von Bots – in manchen Regionen sind sie sogar in der Überzahl. Mit dem Siegeszug von KI-gesteuerten Crawlern, die Inhalte für große Sprachmodelle sammeln, steigen die Anforderungen an Infrastruktur, Budget und Markenstrategie. Lass uns gemeinsam auf die aktuellsten web crawling statistiken, Benchmarks und die Auswirkungen für dein Unternehmen 2026 schauen.

Web Crawling 2026: Ein Überblick

Web crawling ist heute eine ganz andere Nummer – sowohl was die Masse als auch die Komplexität angeht. Jeden Tag werden Milliarden automatisierte Anfragen von einer immer bunteren Mischung an Crawlern verschickt. Früher waren es vor allem Suchmaschinen-Bots wie Googlebot oder Bingbot, die fürs Indexieren zuständig waren. Heute sind sie nur noch ein Teil des Ganzen: KI-Crawler, Social-Media-Scraper, Analyse-Bots und viele mehr sind dazugekommen.

Das Wichtigste: – in manchen Regionen sogar mehr als von echten Menschen. Im Cloudflare-Netzwerk . Und das Wachstum kommt nicht nur von Suchmaschinen – immer mehr KI-Crawler holen sich Daten für Chatbots und generative KI-Tools.

Die Bandbreite ist größer denn je:

- Nützliche Bots: Suchmaschinen, Uptime-Monitoring, seriöse Datensammler.

- Schädliche Bots: Spam, Hacking, unerlaubtes Scraping.

- KI-Crawler: Die neuen Player, die Inhalte für KI-Training und Echtzeit-Antworten sammeln.

KI-Crawler ticken oft ganz anders als klassische Suchmaschinen-Bots. Sie laden meist komplette Seiteninhalte für semantische Analysen herunter, nicht nur einzelne Keywords – und das in riesigen Mengen, manchmal mit Millionen Anfragen in wenigen Tagen. Das Ergebnis: – klassische Indexierung verschmilzt mit dem Datenhunger der KI.

Wichtige Web Crawling Statistiken für Unternehmen

Schauen wir uns die Zahlen an, die das Web 2026 prägen. Diese web crawling statistiken sind kein Nerd-Kram, sondern sollten deine Infrastruktur, Content-Strategie und dein Budget beeinflussen.

Bots vs. Menschen: Wer dominiert den Traffic?

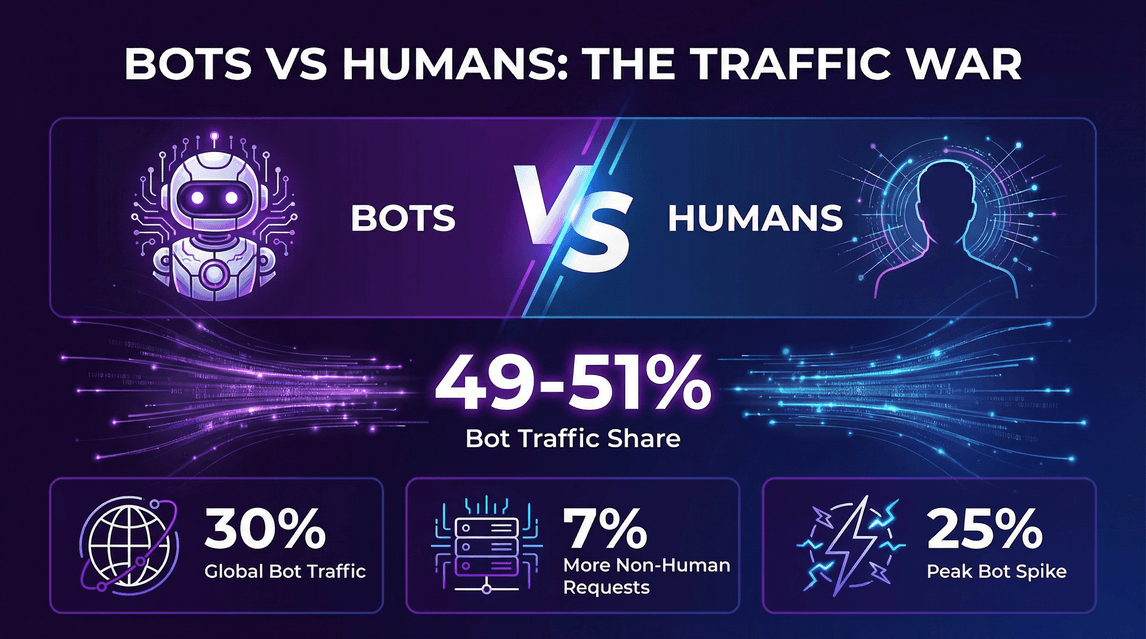

- 49–51 % des gesamten Internet-Traffics werden inzwischen von Bots verursacht – automatisierte Anfragen sind mit menschlichen Besuchern gleichauf oder sogar drüber ().

- Cloudflare-Daten: .

- Nicht-menschliche Anfragen an HTML-Seiten waren ~7 % höher als menschliche Anfragen ().

- Zu bestimmten Zeiten .

Der KI-Crawler-Boom

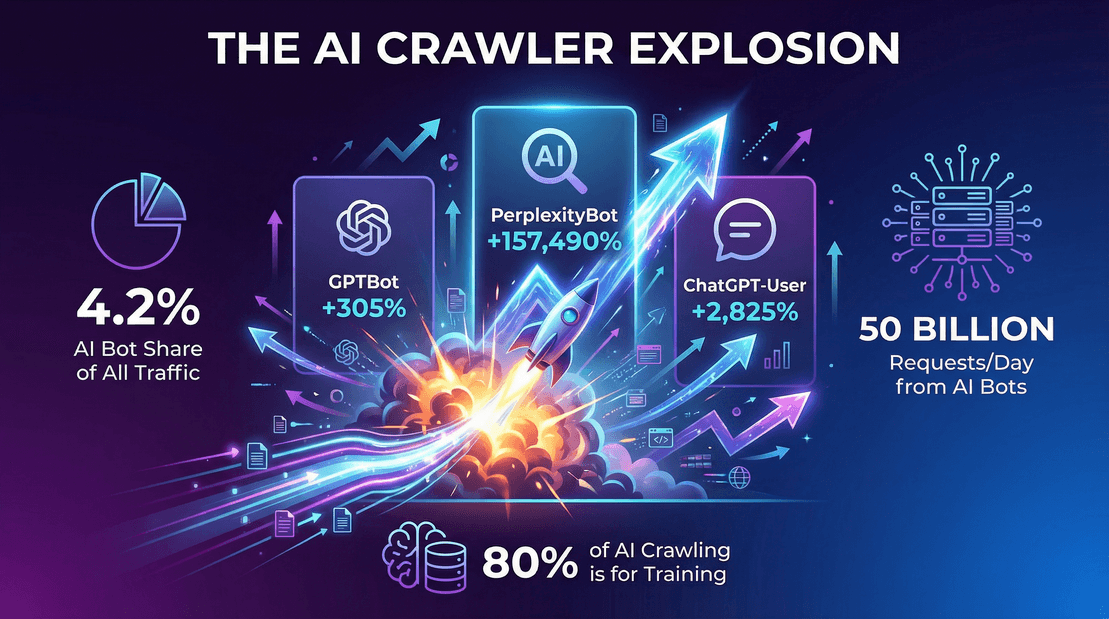

- KI-orientierte Bots machten 2025 4,2 % aller HTML-Anfragen aus ().

- OpenAI’s GPTBot: Stieg von null auf – ein Wachstum von 305 % in nur einem Jahr.

- Perplexity.ai’s Bot: .

- Googlebot: und machte etwa 50 % aller Such-/KI-Crawler-Anfragen aus.

Crawler-Traffic im Praxisbeispiel

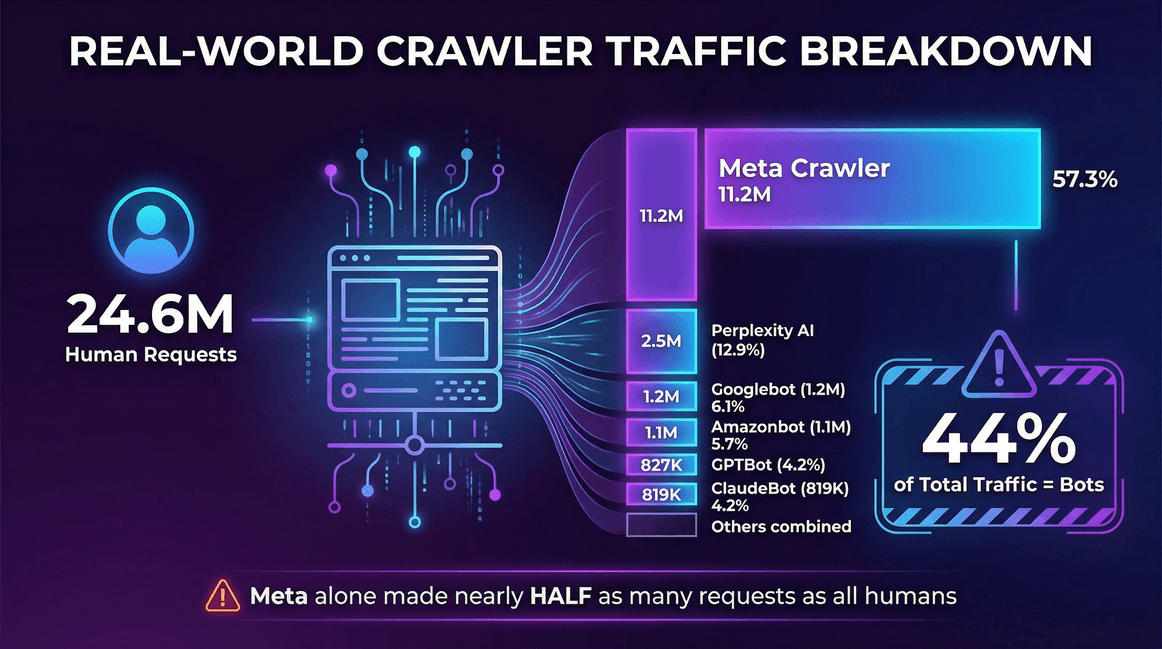

Ein Beispiel aus den :

| Traffic Source | Requests (Monthly) | Share of Crawlers |

|---|---|---|

| Real Users (human) | 24,647,904 | -- |

| Meta Crawler (Facebook) | 11,175,701 | 57.3% |

| Perplexity AI | 2,512,747 | 12.9% |

| Googlebot | 1,180,737 | 6.1% |

| Amazonbot | 1,120,382 | 5.7% |

| OpenAI GPTBot | 827,204 | 4.2% |

| ClaudeBot (Anthropic) | 819,256 | 4.2% |

| Bingbot | 599,752 | 3.1% |

| ChatGPT-User (OpenAI) | 557,511 | 2.9% |

| Ahrefs Crawler | 449,161 | 2.3% |

| ByteDance Spider | 267,393 | 1.4% |

Auf dieser Website machten Bots 44 % des gesamten Traffics aus – allein der Meta-Crawler verursachte fast halb so viele Anfragen wie alle echten Nutzer zusammen.

Das große Ganze

- Crawler-Traffic (Such- und KI-Bots) stieg zwischen Mai 2024 und Mai 2025 um 18 % bei einer konstanten Auswahl an Websites ().

- LLM-Trainingsbots machten auf einigen großen CDNs fast 80 % des gesamten Bot-Traffics aus ().

- Im Cloudflare-Netzwerk gab es Ende 2025 täglich rund 50 Milliarden Crawler-Anfragen allein von KI-Bots ().

Der Aufstieg der KI-Crawler: Wie KI das Web Crawling verändert

Jetzt zum Elefanten (oder besser: Roboter) im Raum – den KI-Crawlern. Diese Bots indexieren deine Seite nicht nur für die Suche, sondern saugen Inhalte, um große Sprachmodelle zu trainieren oder sofortige KI-Antworten zu liefern. Und das in einem Ausmaß, das selbst Suchmaschinen alt aussehen lässt.

Was treibt den KI-Crawler-Boom an?

- Datenhungrige KI-Modelle: Moderne LLMs brauchen riesige, vielfältige Datensätze. Das Web ist ihr All-you-can-eat-Buffet – und dein Content steht auf der Karte.

- Training vs. Echtzeit-Antworten: , nicht nur der Beantwortung von Live-Anfragen.

- Neue Crawl-Muster: KI-Bots können Websites in massiven Wellen abgrasen, oft Millionen Seiten in wenigen Tagen – vor allem bei Modell-Updates.

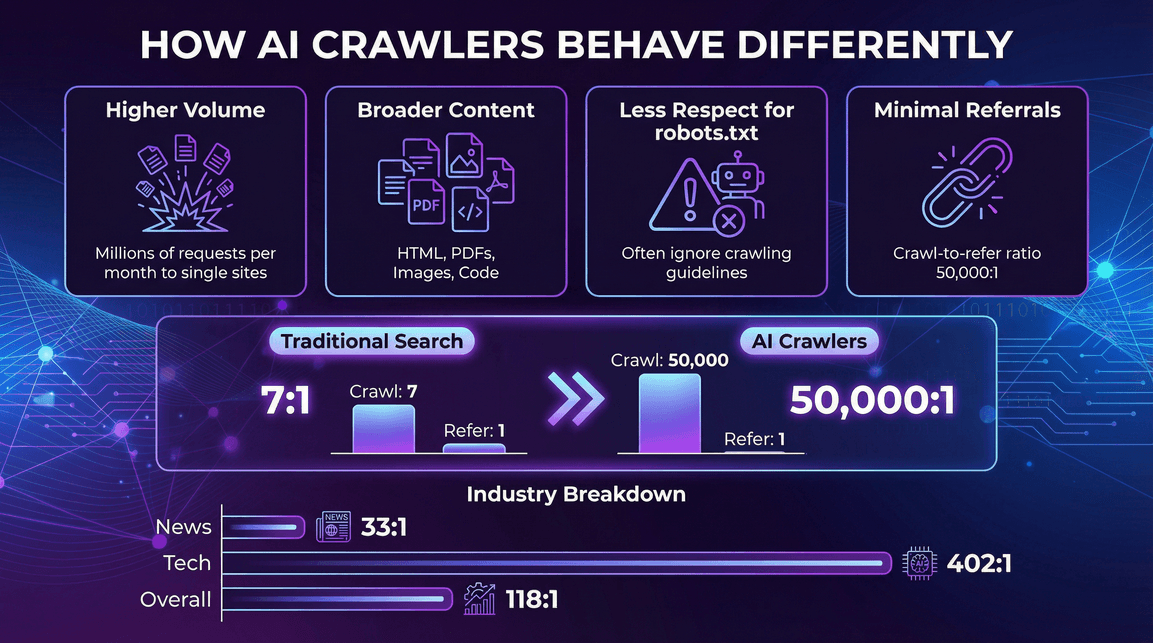

Wie sich KI-Crawler von klassischen Bots unterscheiden

- Höheres Anfragevolumen pro Bot: Ein einzelner KI-Bot kann Millionen Anfragen pro Monat an eine Website schicken ().

- Vielfältigere Inhalte: Nicht nur HTML – auch PDFs, Bilder, Quellcode und mehr werden gecrawlt.

- robots.txt wird oft ignoriert: Manche KI-Crawler halten sich nur teilweise oder gar nicht an Crawling-Regeln ().

- Kaum Referral-Traffic: Im Gegensatz zu Suchmaschinen bringen KI-Crawler selten neue Besucher auf deine Seite. .

KI-Crawler-Traffic nach Branche

Nicht alle Branchen werden gleich stark gecrawlt. Beispiele:

- Nachrichten & Medien: Besonders hohe KI-Crawler-Aktivität, aber etwas bessere Referral-Raten (z. B. Perplexity: 33:1 auf News-Seiten, 118:1 im Schnitt) ().

- Technologie & Elektronik: GPTBot und Amazonbot dominieren, Referral-Verhältnis bleibt hoch (OpenAI: 402:1 im Tech-Bereich) ().

- Finanzen, Wissenschaft, weitere Sektoren: Jede Branche hat ihre eigene Bot-Mischung und Referral-Quoten – aber der Trend ist klar: KI-Crawler sind überall, und die wenigsten bringen Besucher zurück.

Die wichtigsten Web Crawler 2026: Wer durchsucht das Web am meisten?

Wer sind die Big Player beim web crawling? Hier das Ranking laut :

| Crawler (Owner) | % of Crawls (May 2025) | YoY Request Growth |

|---|---|---|

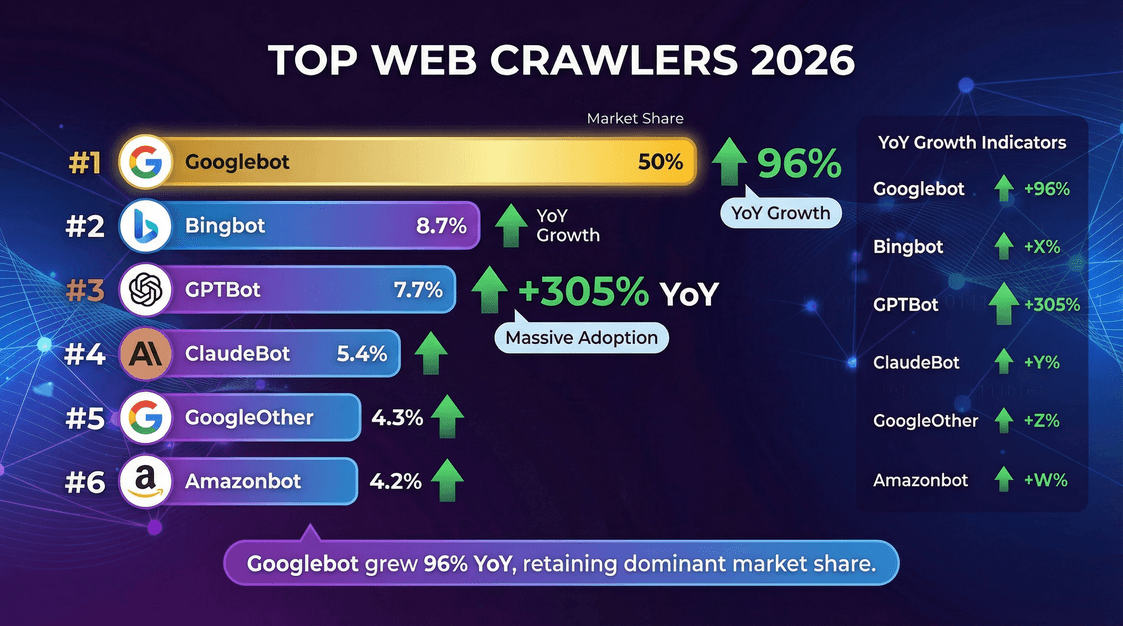

| Googlebot (Google) | 50.0% | +96% |

| Bingbot (Microsoft) | 8.7% | +2% |

| GPTBot (OpenAI) | 7.7% | +305% |

| ClaudeBot (Anthropic) | 5.4% | –46% |

| GoogleOther (Google) | 4.3% | +14% |

| Amazonbot (Amazon) | 4.2% | –35% |

| Googlebot-Image (Google) | 3.3% | –13% |

| Bytespider (ByteDance) | 2.9% | –85% |

| YandexBot (Yandex) | 2.2% | –10% |

| ChatGPT-User (OpenAI) | 1.3% | +2825% |

| Applebot (Apple) | 1.2% | –26% |

| PerplexityBot | 0.2% | +157,490% |

Wichtige Erkenntnisse:

- Googlebot bleibt der Platzhirsch und ist für die Hälfte aller Crawling-Aktivitäten verantwortlich.

- GPTBot und Meta’s Crawler wachsen am schnellsten – GPTBot hat seinen Anteil in einem Jahr verdreifacht.

- PerplexityBot und ChatGPT-User sind zwar noch klein, wachsen aber rasant.

Web Crawling Benchmarks: Crawling-Rate, Durchsatz und Performance

Beim web crawling zählt nicht nur die Masse, sondern auch, wie schnell und effizient die Crawler unterwegs sind. Das solltest du zu Crawling-Raten und Performance-Benchmarks 2026 wissen:

Beim web crawling zählt nicht nur die Masse, sondern auch, wie schnell und effizient die Crawler unterwegs sind. Das solltest du zu Crawling-Raten und Performance-Benchmarks 2026 wissen:

Crawling-Rate: Wie schnell holen sich Crawler Seiten?

- Crawling-Rate wird meist in Seiten pro Sekunde (oder Anfragen pro Sekunde) gemessen ().

- Threads/Parallele Verbindungen: Mehr Threads = mehr Speed. Beispiel: 200 Threads mit 2 Sekunden Verzögerung pro Seite ergeben etwa 100 Seiten pro Sekunde ().

- Praxiswerte: 100–200 Seiten pro Sekunde sind für einen gut optimierten Crawler auf einem ordentlichen Servercluster realistisch.

- Google und Bing: Holen sich vermutlich weltweit tausende Seiten pro Sekunde – verteilt auf Millionen Websites.

Faktoren, die die Crawling-Rate beeinflussen

- Anzahl der Threads/Parallele Fetcher: Mehr Threads, mehr Speed – bis andere Engpässe auftreten.

- Anzahl aktiver Websites: Mehrere Domains parallel erhöhen den Durchsatz.

- Crawl-Delay/Wartezeit: Längere Pausen = langsamere Crawling-Rate.

- Ressourcen-Limits: Bandbreite, CPU, Datenbank-Performance können limitieren.

- Performance der Zielseite: Langsame oder limitierte Seiten bremsen das Crawling.

Beispiel: Hat dein Crawler 100 Threads und 1 Sekunde Verzögerung pro Seite, sind etwa 100 Seiten pro Sekunde drin – es sei denn, deine Datenbank ist der Flaschenhals.

Web Crawling im Business: Kosten, Chancen und Risiken

Web crawling ist längst kein reines Technikthema mehr – es hat direkte Auswirkungen auf dein Business.

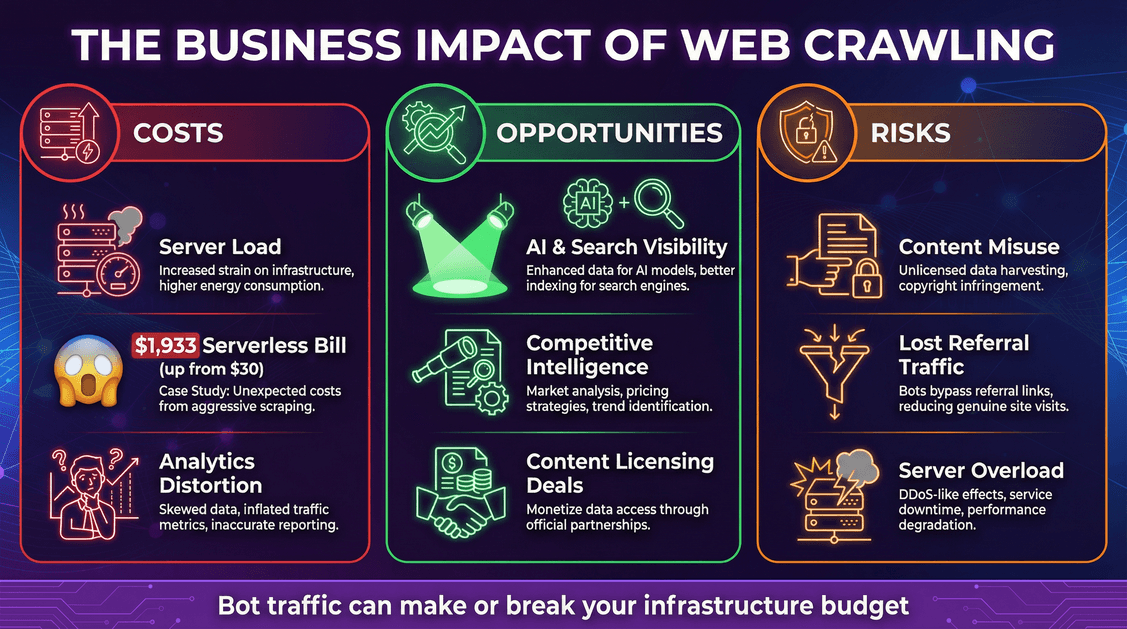

Kosten: Infrastruktur und unerwartete Rechnungen

- Serverlast: Jede Bot-Anfrage verbraucht CPU, Speicher und Bandbreite.

- Cloud-Kosten: Bei nutzungsbasierten Modellen (z. B. Serverless) können Bots hohe Kosten verursachen. Ein Entwickler berichtete, dass .

- Verfälschte Analysen: Bots können Web-Analytics verzerren und echte Nutzertrends verschleiern.

Chancen: Sichtbarkeit und Datenvorteile

- KI- und Such-Sichtbarkeit: In KI-Trainingsdaten oder Suchindizes vertreten zu sein, kann die Reichweite deiner Marke steigern ().

- Wettbewerbsanalyse: Unternehmen nutzen Crawler für Marktbeobachtung, Preisüberwachung und mehr.

- Monetarisierung: Einige Publisher lizenzieren ihre Inhalte inzwischen an KI-Unternehmen ().

Risiken: Content-Missbrauch und Traffic-Verlust

- Content-Missbrauch: KI-Crawler können deine Inhalte in ihre Modelle aufnehmen – oft ohne klare Erlaubnis oder Vergütung.

- Verlorener Referral-Traffic: KI-Antworten können Nutzer zufriedenstellen, ohne sie auf deine Seite zu leiten („Disintermediation“).

- Sicherheitsrisiken und Ausfälle: Aggressive Crawler können Server überlasten und zu Ausfällen führen.

Web Crawler Traffic steuern: Best Practices

Wie schützt du dich vor explodierenden Bot-Kosten?

- robots.txt gezielt einsetzen

- Mit

robots.txtkannst du bestimmten Bots Zugriff erlauben oder verweigern. Seriöse Crawler (wie Googlebot) halten sich daran, viele KI-Bots aber nicht (). - Mitte 2025 hatten etwa 14 % der Top-Websites explizite Regeln für KI-Bots ergänzt ().

- Bot-Management-Tools nutzen

- Web Application Firewalls (WAFs) und Bot-Management-Lösungen können verdächtigen Traffic blockieren oder drosseln.

- Cloudflare und andere Anbieter bieten Bot-Schutz und sogar „AI Audit“-Tools für Content Creators ().

- Rate Limiting und Caching einsetzen

- Begrenze die Anfragerate einzelner Bots.

- Biete Bots möglichst gecachte Inhalte an – so sparst du teure Serverless-Funktionen oder Datenbankabfragen ().

- Bot-Traffic überwachen und analysieren

- Behalte deine Server-Logs im Blick. Welche Bots kommen wann und wie oft?

- Richte Alarme für ungewöhnliche Traffic-Spitzen ein.

- Neue Standards im Auge behalten

- Beobachte neue Meta-Tags oder HTTP-Header für KI-Nutzungsrechte (z. B.

<meta name="ai:allow" content="no">). - Verfolge Initiativen wie ) und Zahlungsprotokolle wie .

Web Crawling Trends 2026 und darüber hinaus

Web crawling entwickelt sich rasant weiter. Worauf solltest du achten?

- KI-gesteuertes Crawling nimmt weiter zu: Immer mehr KI-Bots crawlen immer mehr Content-Typen (Text, Bilder, Videos).

- Content-Lizenzierung und Zahlungsstandards: Der „Wilde Westen“ weicht und .

- Regulierung kommt: Es wird mehr rechtliche Klarheit geben, was Bots – insbesondere für KI-Training – dürfen und was nicht ().

- Technische Standards für Content-Nutzung: Neue Meta-Tags, robots.txt-Erweiterungen und maschinenlesbare Bot-Deklarationen sind zu erwarten.

- Publisher-KI-Kooperationen: Immer mehr Publisher werden aktiv und bieten strukturierte Datenfeeds oder APIs für KI-Unternehmen an.

Fazit: Was bedeuten diese Web Crawling Statistiken für dein Unternehmen?

Das Fazit: Web crawling ist 2026 ein dominanter Faktor – und das Wachstum geht weiter. Automatisierte Bots, vor allem KI-Crawler, machen einen riesigen Teil deines Traffics aus und beeinflussen Infrastruktur, Budget und Content-Strategie immer stärker.

Was solltest du tun?

- Rechne mit viel Bot-Traffic: Plane Infrastruktur, Budget und Monitoring entsprechend.

- Kenne deine Crawler: Nicht jeder Bot ist gleich – passe deine Maßnahmen gezielt an.

- Überwache deine Kennzahlen: Verfolge Bot-Traffic genauso wie menschliche Besucher.

- Schütze deine Inhalte und dein Budget: Nutze technische Maßnahmen, rechtliche Vereinbarungen und neue Standards.

- Nutze die Chancen: Sichtbarkeit in KI- und Suchindizes kann deine Marke stärken – achte aber darauf, dass du davon profitierst.

- Bleib informiert und flexibel: Die Crawling-Landschaft verändert sich schnell. Beobachte neue Standards, Gesetze und Geschäftsmodelle.

Aus meiner Erfahrung mit Automatisierung und KI-Tools (und jetzt bei ) weiß ich: Erfolgreiche Unternehmen machen web crawling zur strategischen Priorität – nicht nur zum Technikthema. Egal ob Vertrieb, E-Commerce, Marketing oder Immobilien: Wer web crawling statistiken und Benchmarks versteht, ist klar im Vorteil.

Wenn du also das nächste Mal deine Server-Logs checkst und eine Bot-Parade entdeckst, zuck nicht nur mit den Schultern. Nutze die Daten. Vergleiche deine Werte. Passe deine Strategie an. Und denk dran: Im KI-Zeitalter sind die Bots nicht auf dem Weg – sie sind schon da. Mach sie zu deinem Vorteil.

Bleib wachsam, bleib neugierig – und mögen deine Server-Logs immer zu deinen Gunsten ausfallen.

Du willst mehr über Web Scraping, Automatisierung und KI-gestützte Produktivität erfahren? Im findest du ausführliche Analysen, Anleitungen und aktuelle Trends. Und wenn du deine Daten selbst in die Hand nehmen willst, probiere die für KI-basiertes Web Scraping – ganz ohne Programmierung, ganz ohne Aufwand, mit echten Ergebnissen.

Quellen und weiterführende Informationen: