Hand aufs Herz: Im Jahr 2025 ist das Internet längst nicht mehr nur ein Tummelplatz für Katzenvideos und endloses Scrollen durch Social Media – es ist zur echten Goldgrube für Geschäftsdaten geworden, und jeder will ein Stück davon abhaben. Egal ob Vertrieb, E-Commerce, Marketing oder Immobilien: Noch nie war es so wichtig, Webdaten effizient zu erfassen, zu strukturieren und clever zu nutzen. Doch bei der riesigen Auswahl an website scraping tools fühlt man sich schnell wie vor dem Regal mit 30 Müslisorten – alle versprechen das Beste, aber welches passt wirklich zu dir?

Nach vielen Jahren in der SaaS- und Automatisierungswelt weiß ich: Das richtige web-scraper-Tool kann stundenlanges Copy-Paste in einen Zwei-Klick-Job verwandeln. Aber nicht jedes Tool ist für jeden gemacht. Manche richten sich an Entwickler, andere an Business-User, und wieder andere an alle, die einfach nur schnell an ihre Daten wollen. In diesem Guide stelle ich dir die 17 besten website scraping tools für 2025 vor – von ki-web-scraper wie über No-Code-Lösungen bis hin zu APIs und Python-Bibliotheken. Ich zeige dir echte Nutzerbewertungen, Preise und meine Einschätzung, was jedes Tool besonders macht – oder eben nicht.

Schnellvergleich: Die besten website scraping tools im Überblick

Bevor wir ins Detail gehen, hier ein direkter Vergleich der 17 Top-Tools. Die Tabelle zeigt Kategorien, Preise, Bedienkomfort, Automatisierungsfunktionen, Exportmöglichkeiten, Integrationen, Nutzerbewertungen (von , , und Chrome Store) sowie die Zielgruppe. (Spoiler: Nicht jedes Tool passt zu jedem.)

| Tool | Kategorie | Preis (Free/Paid) | Bedienkomfort | Automatisierung & KI | Exportoptionen | Integrationen | Nutzerbewertungen | Zielgruppe |

|---|---|---|---|---|---|---|---|---|

| Thunderbit | KI-Web-Scraper (No-Code) | Kostenlos; ab ca. 9 $/Monat | Sehr einfach | Hoch (KI-Autoerkennung) | Sheets, Airtable, Notion, CSV | Chrome, Zapier (indirekt) | Chrome Store: ~4,9★ | Vertrieb, Operations, Nicht-Programmierer |

| Kadoa | KI-Web-Scraper (No-Code) | 500 Credits gratis; ab 39 $/Monat | Mittel | Sehr hoch (LLM-Agents) | JSON/CSV, API, Dashboard | API, Webhooks | N/A (neu) | Datenanalysten, Unternehmen |

| Octoparse | No-Code-Scraper | Kostenlos; ab 119 $/Monat | Mittel | Mittel (Autoerkennung) | CSV, Excel, API, DB | Native API, Scheduler | G2: ~4,4★, Capterra: ~4,5★ | Nicht-Programmierer, Analysten |

| ParseHub | No-Code-Scraper | Kostenlos; ab 149 $/Monat | Mittel | Niedrig (regelbasiert) | CSV, JSON, API | Manuell/API | G2: ~4,2★, Capterra: ~4,3★ | Technikaffine Nicht-Programmierer |

| Web Scraper | No-Code-Extension | Kostenlos (lokal); Cloud 50 $/Monat | Mittel | Niedrig (manuell) | CSV, JSON, API (Cloud) | Google Sheets (Cloud) | G2: ~4,2★, Capterra: ~4,4★ | Hobbyisten, Analysten |

| Browse AI | No-Code (Bots) | Kostenlos; ab ca. 49 $/Monat | Einfach | Mittel (KI-unterstützt) | Sheets, Zapier, API | Sheets, Slack, Zapier | G2: ~4,8★, Capterra: ~4,5★ | Marketer, KMU |

| Bardeen AI | No-Code (KI-Automatisierung) | Kostenlos; ab 60 $/Monat | Mittel | Mittel (KI-Workflows) | Sheets, Notion, Salesforce | 130+ Apps | G2: ~4,7★, Capterra: ~4,5★ | Business-Automatisierer |

| ScrapeStorm | No-Code (KI-unterstützt) | Kostenlos; ab ca. 50 $/Monat | Einfach/Mittel | Mittel (KI-Felderkennung) | CSV, Excel, JSON, SQL | Manuell | G2: ~4,0★ (wenige Daten) | Nicht-Programmierer, schneller Einstieg |

| ScraperAPI | Scraping-API | 1.000 gratis/Monat; ab 29 $/Monat | Anspruchsvoll (Programmierung) | Mittel (Proxy, CAPTCHA) | Raw HTML/JSON | Eigener Code | G2: ~4,5★ | Entwickler |

| Bright Data Web Scraper | Scraping-API (Enterprise) | Gratis-Test; ab ca. 500 $/Monat | Mittel | Hoch (KI, Proxies) | JSON, CSV, DB | Enterprise-Systeme | G2: ~4,5★, Trustpilot: 4,3★ | Unternehmen |

| Zyte | Scraping-API/Plattform | Kostenlos; ab 29 $/Monat | Anspruchsvoll (Dev-Fokus) | Hoch (Smart Proxy, KI) | JSON, HTML, API | Scrapy Cloud | G2: ~4,3★ | Entwickler, Firmen |

| ZenRows | Scraping-API | Gratis-Test; ab 49 $/Monat | Anspruchsvoll (Programmierung) | Mittel (Anti-Bot, JS) | HTML, JSON (Beta) | Eigene App | N/A (neu, positives Dev-Feedback) | Entwickler, Startups |

| ScrapingBee | Scraping-API | Gratis-Test; ab 49 $/Monat | Anspruchsvoll (Dev-Fokus) | Mittel (JS-Rendering) | HTML, Screenshots | Eigene App | G2: ~4,6★ | Entwickler (JS-lastige Seiten) |

| Selenium | Open-Source-Bibliothek | Kostenlos (OSS) | Anspruchsvoll (Programmierung) | Niedrig (manuelles Scripting) | Beliebig (per Code) | Beliebig (per Code) | G2: ~4,5★ (als Test-Tool) | QA, Devs, dynamische Seiten |

| Beautiful Soup | Open-Source-Bibliothek | Kostenlos (OSS) | Mittel (Python) | Niedrig (nur Parsing) | Beliebig (per Code) | Beliebig (Python-Ökosystem) | Dev: 5★ (Community) | Python-Entwickler, statisches HTML |

| Playwright | Open-Source-Bibliothek | Kostenlos (OSS) | Anspruchsvoll (Coding/Async) | Niedrig/Mittel (Browser-Autom.) | Beliebig (per Code) | Beliebig (per Code) | Dev: ~4,8★ (Community) | Devs, moderne Web-Apps |

| Urllib3 | Open-Source-Bibliothek | Kostenlos (OSS) | Anspruchsvoll (Low-Level) | Niedrig (nur HTTP) | Beliebig (per Code) | Beliebig (Python) | Dev: 4,5★ (Community) | Python-Entwickler, volle HTTP-Kontrolle |

Für mehr Details zu Funktionen, Stärken und Schwächen der einzelnen Tools einfach weiterlesen. Noch mehr Praxisbeispiele findest du im .

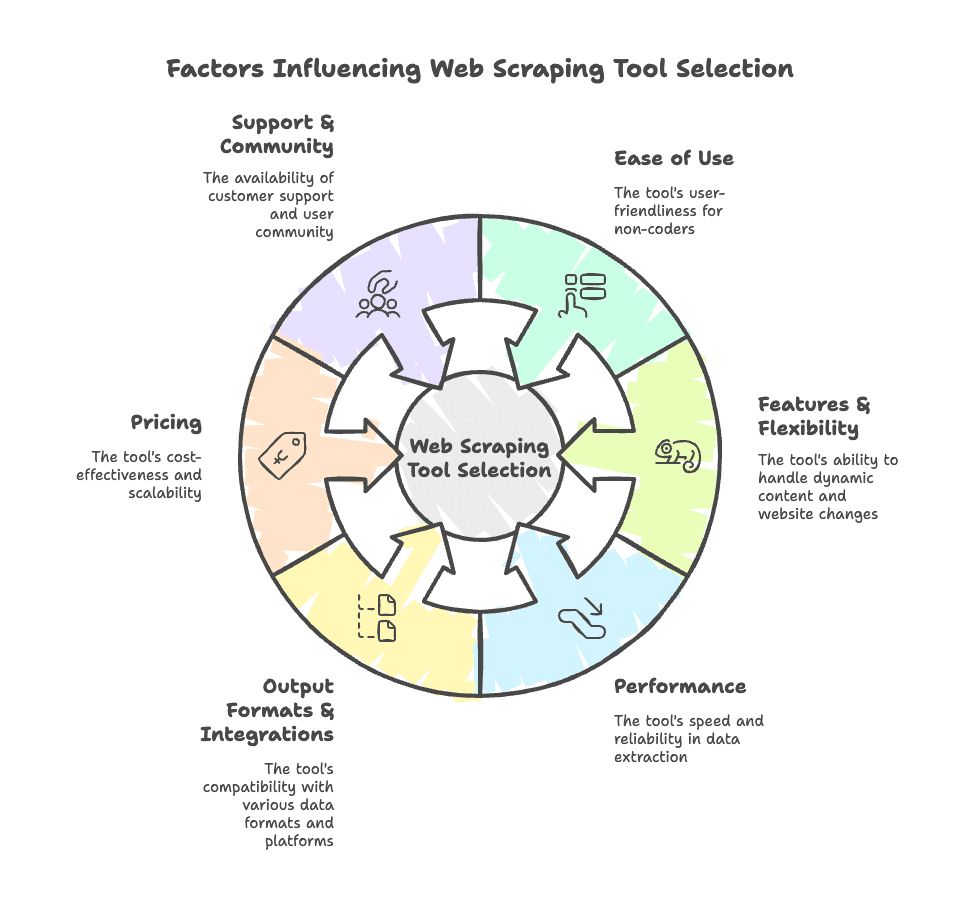

Wie finde ich das passende website scraping tool?

- Bedienkomfort: Bist du Entwickler oder bekommst du schon beim Anblick der Kommandozeile Schweißausbrüche? Tools wie oder Browse AI sind für Nicht-Programmierer gemacht, während APIs und Bibliotheken wie ScraperAPI oder Selenium eher für Entwickler gedacht sind.

- Funktionen & Flexibilität: Kommt das Tool mit dynamischen Inhalten, Logins, Paginierung oder Anti-Bot-Maßnahmen klar? Kann es sich anpassen, wenn sich das Website-Layout ändert?

- Performance: Wie schnell und zuverlässig werden Daten extrahiert? Gibt es Schutz vor IP-Sperren und werden große Datenmengen bewältigt?

- Export & Integrationen: Kannst du die Daten als CSV, Excel, Google Sheets, Airtable, Notion exportieren oder ins CRM übertragen?

- Preisgestaltung: Gibt es eine kostenlose Version oder faire Einstiegspreise? Skalieren die Kosten mit deinem Bedarf?

- Support & Community: Gibt es schnellen Support, gute Dokus oder eine aktive Community?

Gerade für Business-Anwender – zum Beispiel im Vertrieb oder Operations – empfehle ich, ein Tool zu wählen, das zu deinem technischen Level und Workflow passt. Wer Lead-Generierung oder Wettbewerbsbeobachtung automatisieren will, ohne zu programmieren, ist mit ki-web-scraper oder No-Code-Tools bestens beraten. Wer ein Entwicklerteam hat und skalieren will, sollte zu APIs oder Python-Bibliotheken greifen.

Noch mehr Tipps zur Auswahl findest du hier:

KI-Web-Scraper: Die nächste Generation der website scraping tools

Jetzt kommt der eigentliche Gamechanger: ki-web-scraper. Damit wird Web-Scraping auch für Nicht-Techniker zum Kinderspiel. Im Gegensatz zu klassischen Tools, bei denen du mit CSS-Selektoren oder XPath hantieren musst (und manchmal das Gefühl hast, du müsstest JavaScript im Schlaf können), nutzen ki-web-scraper große Sprachmodelle, um Webseiten wie ein Mensch zu „lesen“. Das heißt: Einfach die Seite angeben, und die KI erkennt, was extrahiert werden soll – ganz ohne manuelle Konfiguration oder Selector-Frust.

Was macht einen ki-web-scraper besonders?

- Keine CSS-Selektoren nötig: Die KI analysiert die Seitenstruktur und den Inhalt, nicht nur den Code. Du musst keine passenden Selektoren suchen oder dich um Layout-Änderungen sorgen.

- Schneller Einstieg: Die meisten ki-web-scraper holen die gewünschten Daten mit wenigen Klicks. Einfach sagen, was du brauchst – der Rest läuft automatisch.

- Hohe Genauigkeit: KI kommt auch mit unstrukturierten oder chaotischen Seiten klar und kann Daten sogar direkt zusammenfassen, kategorisieren oder übersetzen.

- Weniger Wartung: Ändert sich die Website, passt sich die KI an – kein ständiges Nachjustieren mehr nötig.

Gerade für Vertrieb, E-Commerce oder Immobilien ist das ein echter Fortschritt: Leads, Produktlisten oder Immobiliendaten lassen sich ohne Programmierkenntnisse extrahieren.

Thunderbit: KI-Web-Scraper für Business-Teams

Klar, ich bin voreingenommen – aber aus gutem Grund. ist der ki-web-scraper, den mein Team und ich entwickelt haben, um genau die Probleme zu lösen, mit denen Business-Anwender seit Jahren kämpfen.

Highlights:

- KI-Feldvorschläge: Mit „AI Suggest Fields“ liest Thunderbit die Website, schlägt passende Spaltennamen vor und richtet den Scraper automatisch ein.

- Unterseiten-Scraping: Du willst Details von jeder Produkt- oder Angebotsseite? Thunderbit besucht automatisch alle Unterseiten und ergänzt die Datentabelle.

- Sofort-Export: Exportiere deine Daten direkt nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON – komplett kostenlos.

- Verschiedene Datentypen: Extrahiere Text, Zahlen, Daten, URLs, E-Mails, Telefonnummern (automatisch formatiert) und Bilder.

- Vorlagen: Für Seiten wie Amazon, Zillow, Instagram oder Shopify gibt es fertige Templates für den Sofortstart.

- KI-Autofill: Lass die KI Online-Formulare ausfüllen und Workflows automatisieren – ohne Zusatzkosten.

- Geplantes Scraping: Richte automatische, zeitgesteuerte Scrapes ein (ganz einfach in Alltagssprache dank KI).

- Kostenlose Extraktion von E-Mails, Telefonnummern und Bildern: Kontaktdaten oder Bilder mit nur einem Klick extrahieren.

Preise: Die Gratis-Version erlaubt das Scrapen von 6 Seiten (bzw. 10 mit Testphase). Bezahlpläne starten ab 9 $/Monat (jährliche Abrechnung) für 5.000 Credits und skalieren für größere Anforderungen.

Nutzerbewertungen: Thunderbit ist noch recht neu, hat aber bereits eine 4,9★-Bewertung im Chrome Web Store und über 30.000 Nutzer. Besonders gelobt werden der „extrem einfache Einstieg“ und die „riesige Zeitersparnis“, vor allem bei Lead-Generierung und Produktüberwachung. (Bewertungen auf G2 und Capterra folgen, das Feedback ist aber durchweg positiv.)

Vorteile:

- Einfachste Einrichtung, die ich je gesehen habe – selbst meine Mutter kommt damit klar.

- Die KI passt sich automatisch an Seitenänderungen an, kein Nachjustieren nötig.

- Direkter Export in alle gängigen Business-Tools.

- Kostenlose Features für Kontakt- und Bilderextraktion.

Nachteile:

- Nicht für riesige Enterprise-Crawls gedacht (die KI braucht für Genauigkeit etwas länger).

- Erweiterte Funktionen und mehr Credits gibt’s nur im Bezahlplan.

- Läuft als Chrome-Erweiterung (für die meisten Nutzer), daher nicht für Headless-/Serverbetrieb geeignet.

Ideal für: Vertriebsteams, die Leads scrapen, E-Commerce-Teams für Preis- und Produktüberwachung, Makler für Immobilienlisten oder alle, die strukturierte Daten aus chaotischen Webseiten brauchen – ohne Programmierung.

Neugierig? Lade die herunter oder schau auf unserem vorbei.

Kadoa: KI-gestützter Web-Scraper

Kadoa ist ein weiteres starkes KI-Tool, das sich auf automatisierte Extraktion im großen Stil für Unternehmen und Datenteams spezialisiert hat.

Highlights:

- KI-Orchestrierung: Mehrere KI-Agents navigieren durch Seiten, steuern Paginierung und passen sich Änderungen an.

- Selbstheilende Scraper: Ändert sich die Seitenstruktur, aktualisiert die KI automatisch die Extraktionslogik.

- Automatische Datenaufbereitung: Daten werden mit integrierten ML-Modellen bereinigt und ins Wunschformat gebracht.

- Skalierbarkeit: Für große Datenmengen – Millionen von Datensätzen pro Tag.

Preise: Gratis (500 Credits), danach ab 39 $/Monat für 25.000 Credits. Enterprise-Tarife für unbegrenzte Nutzer und Features.

Nutzerbewertungen: Noch neu, daher kaum Bewertungen auf G2/Capterra. Erste Rückmeldungen von Hedgefonds und SaaS-Firmen sind aber sehr positiv, vor allem wegen Zuverlässigkeit und geringem Wartungsaufwand.

Vorteile:

- Komplett No-Code und nach der Einrichtung praktisch wartungsfrei.

- Kommt mit komplexen, dynamischen Seiten (Logins, mehrstufige Navigation) klar.

- Starke Anti-Blocking-Maßnahmen und Enterprise-Optionen.

Nachteile:

- Noch in Entwicklung – einige Features werden laufend verbessert.

- Für einfache Aufgaben oft zu mächtig.

- Workflow-Konfiguration für komplexe Jobs erfordert Einarbeitung.

Ideal für: Unternehmen, die kontinuierlich und großflächig Daten extrahieren – z.B. Finanzanalysten, E-Commerce-Intelligence-Teams oder alle, die „einmal einrichten und laufen lassen“ wollen.

No-/Low-Code-Web-Scraper: Visuelle Point-and-Click-Tools

Du willst deine Daten (noch) nicht der KI überlassen? No-/Low-Code-Web-Scraper ermöglichen visuelle Workflows – ohne Programmierung, aber mit etwas Verständnis für Selektoren und Klicklogik.

Typische Features:

- Visuelle Workflow-Builder (Drag & Drop oder Klick-Auswahl)

- Unterstützung für dynamische Inhalte, Logins und Paginierung

- Zeitplanung und Automatisierung

- Export als CSV, Excel, JSON oder via API

Hier die beliebtesten No-/Low-Code-Scraper im Überblick:

Octoparse: Visueller Web-Scraper für Nicht-Programmierer

Highlights:

- Drag-and-Drop-Oberfläche mit intelligenter Autoerkennung für Listen und Tabellen.

- Kommt mit dynamischen Inhalten, Logins und Anti-Bot-Maßnahmen (IP-Rotation) klar.

- Cloud-Scraping und Zeitplanung für große Projekte.

- Hunderte Vorlagen für gängige Websites.

Preise: Gratis (10 Tasks), Bezahlpläne ab 119 $/Monat.

Nutzerbewertungen: G2: ~4,4★, Capterra: ~4,5★. Vielseitig und leistungsstark, aber steile Lernkurve und hoher Preis.

Ideal für: Nicht-Programmierer und Analysten, die komplexe Seiten im großen Stil scrapen und bereit sind, sich einzuarbeiten.

ParseHub: Flexibler Low-Code-Web-Scraper

Highlights:

- Visueller Workflow-Builder mit Unterstützung für Bedingungen und mehrstufige Navigation.

- Kommt mit AJAX, Formularen und dynamischen Inhalten klar.

- Cloud-Ausführung und Zeitplanung.

Preise: Gratis (5 Projekte), Bezahlpläne ab 149 $/Monat.

Nutzerbewertungen: G2: ~4,2★, Capterra: ~4,3★. Vielseitig, aber teils langsam und mit altmodischer Oberfläche.

Ideal für: Technikaffine Nicht-Programmierer (z.B. Journalisten, Forscher), die komplexe Seiten mit Navigation oder Formularen scrapen wollen.

Web Scraper.io: Chrome-Extension für schnelle Datenerfassung

Highlights:

- Kostenlose Browser-Erweiterung für Chrome und Firefox.

- Visueller „Sitemap“-Builder – Elemente auswählen und Navigation definieren.

- Unterstützt dynamische Inhalte und Paginierung.

- Cloud-Service für Zeitplanung und Automatisierung verfügbar.

Preise: Lokal kostenlos; Cloud-Service 50 $/Monat.

Nutzerbewertungen: G2: ~4,2★, Capterra: ~4,4★. Ideal für Einsteiger und Hobbyisten, aber etwas technisches Verständnis für Selektoren nötig.

Ideal für: Kleine bis mittlere Scraping-Aufgaben, Lernprojekte oder alle, die eine kostenlose, schlanke Lösung suchen.

Browse AI

Highlights:

- No-Code „Record & Run“-Bots – einfach vormachen, was extrahiert werden soll.

- Echtzeit-Überwachung und Änderungsbenachrichtigungen.

- Massenextraktion und Workflow-Verknüpfung.

- Integration mit Google Sheets, Zapier u.v.m.

Preise: Gratis (50 Credits), Bezahlpläne ab ca. 49 $/Monat.

Nutzerbewertungen: G2: ~4,8★, Capterra: ~4,5★. Sehr nutzerfreundlich und gut integrierbar, bei komplexen Seiten aber manchmal Nacharbeit nötig.

Ideal für: Marketer, kleine Unternehmen und alle, die Webdaten überwachen oder einfache Scrapes automatisieren wollen.

Bardeen AI

Highlights:

- No-Code-Automatisierung mit KI-gestütztem „MagicBox“-Workflow-Builder.

- Integration mit 130+ Apps (Sheets, Notion, Salesforce etc.).

- Kann Daten scrapen, Formulare ausfüllen und Browseraufgaben automatisieren.

Preise: Gratis (100 Credits), Bezahlpläne ab 60 $/Monat.

Nutzerbewertungen: G2: ~4,7★, Capterra: ~4,5★. Sehr leistungsfähig für Automatisierung, aber mit Lernkurve.

Ideal für: Business-Anwender, die mehrstufige Aufgaben mit Datenextraktion und App-Integration automatisieren wollen.

ScrapeStorm

Highlights:

- Visueller Scraper mit KI-Felderkennung.

- Unterstützt dynamische Inhalte, Logins und Cloud-/Lokalausführung.

- Verschiedene Exportoptionen (CSV, Excel, JSON, SQL).

Preise: Gratis-Version; Bezahlpläne ab ca. 50 $/Monat (auch Lifetime-Lizenzen).

Nutzerbewertungen: G2: ~4,0★ (wenige Daten). Schneller Einstieg für einfache Aufgaben, bei komplexen Layouts aber manchmal Probleme.

Ideal für: Nicht-Programmierer, die schnell und KI-unterstützt E-Commerce- oder Verzeichnisdaten scrapen wollen.

Web-Scraper-APIs: Skalierbare Datenerfassung für Entwickler

Für Entwickler (oder alle mit Entwickler im Team) bieten Web-Scraper-APIs die Möglichkeit, Scraping direkt in eigene Workflows zu integrieren. Diese Services übernehmen die schwierigen Aufgaben – Proxies, CAPTCHAs, JavaScript-Rendering – sodass du dich auf die Datenverarbeitung konzentrieren kannst.

Typische Features:

- Proxy-Management und Anti-Bot-Maßnahmen

- Headless-Browser-Rendering für JS-lastige Seiten

- Strukturierte Datenendpunkte (teilweise)

- Hohe Skalierbarkeit und Parallelität

Hier die wichtigsten API-Anbieter:

ScraperAPI: API-First-website scraping tool

Highlights:

- Riesiges Proxy-Netzwerk mit automatischer Rotation.

- CAPTCHA-Handling und JavaScript-Rendering.

- Einfache API – Ziel-URL übergeben, HTML erhalten.

Preise: 1.000 Aufrufe/Monat gratis; Bezahlpläne ab 29 $/Monat.

Nutzerbewertungen: G2: ~4,5★. Entwickler schätzen Zuverlässigkeit und Einfachheit.

Ideal für: Entwickler, die eigene Scraper bauen und sich nicht mit Proxy- oder Anti-Bot-Logik herumschlagen wollen.

Bright Data Web Scraper API

Highlights:

- Riesiges Proxy-Netzwerk (72 Mio. IPs), Geo-Targeting.

- Visueller Scraper-Builder und strukturierte Datenausgabe.

- Compliance und Sicherheit für Unternehmen.

Preise: Gratis-Test; ab ca. 500 $/Monat.

Nutzerbewertungen: G2: ~4,5★, Trustpilot: 4,3★. Sehr leistungsstark, aber teuer.

Ideal für: Unternehmen, die große, zuverlässige und rechtssichere Datenerfassung brauchen.

Zyte

Highlights:

- Intelligentes Proxy-Management und Headless-Browser-API.

- KI-gestützte Datenerfassung für gängige Datentypen.

- Scrapy Cloud-Plattform für eigene Spider.

Preise: Kostenlos; Bezahlpläne ab 29 $/Monat.

Nutzerbewertungen: G2: ~4,3★. In der Entwickler-Community für Zuverlässigkeit und Flexibilität geschätzt.

Ideal für: Entwickler und Unternehmen, die ein robustes Scraping-Backend oder Managed-Lösungen suchen.

ZenRows

Highlights:

- API-Endpunkt für HTML oder strukturierte Daten.

- Automatischer Anti-Bot-Schutz und JavaScript-Rendering.

- Einfache, entwicklerfreundliche Preisstruktur.

Preise: Gratis-Test; ab 49 $/Monat.

Nutzerbewertungen: Noch neu, aber positives Feedback von Entwicklern für die einfache Nutzung.

Ideal für: Entwickler und Startups, die eine unkomplizierte, Anti-Block-API suchen.

ScrapingBee

Highlights:

- Headless-Browser-as-a-Service (ideal für JS-lastige Seiten).

- Proxy-Management und individuelle Rendering-Optionen.

- Screenshot-API für Debugging oder visuelle Daten.

Preise: Gratis-Test; ab 49 $/Monat.

Nutzerbewertungen: G2: ~4,6★. Besonders für JS-lastige Seiten und guten Support gelobt.

Ideal für: Entwickler, die moderne Web-Apps scrapen oder zuverlässiges JS-Rendering brauchen.

Python-Web-Scraping-Bibliotheken: Für individuelle und komplexe Projekte

Wer sich mit Code wohlfühlt (oder ein Entwicklerteam hat), bekommt mit Python-Bibliotheken maximale Flexibilität. Hier muss man zwar alles selbst steuern – von Requests bis Parsing und Proxies – kann aber maßgeschneiderte Lösungen bauen.

Selenium: Browser-Automatisierung für dynamische Webseiten

Highlights:

- Automatisiert Browser (Chrome, Firefox etc.) für dynamische Inhalte.

- Unterstützt Headless-Modus und vollständige Nutzerinteraktion (Klicks, Formulare).

- Funktioniert in mehreren Programmiersprachen.

Preise: Kostenlos (Open Source).

Nutzerbewertungen: G2: ~4,5★ (als Test-Tool). Sehr mächtig, aber für große Jobs eher langsam.

Ideal für: QA-Engineers und Entwickler, die hochdynamische Seiten scrapen oder Nutzeraktionen simulieren wollen.

Beautiful Soup: Einfaches HTML-Parsing

Highlights:

- Python-Bibliothek zum Parsen von HTML/XML.

- Einfach zu nutzen, robust auch bei fehlerhaftem HTML.

- Oft in Kombination mit

requestszum Laden von Seiten.

Preise: Kostenlos (Open Source).

Nutzerbewertungen: 5★ in der Entwickler-Community. Besonders für die Einfachheit geschätzt.

Ideal für: Python-Entwickler, die statische HTML-Inhalte in strukturierte Daten umwandeln wollen.

Playwright: Moderne Automatisierung für komplexe Seiten

Highlights:

- Unterstützt Chromium, Firefox, WebKit.

- Schnelle, zuverlässige Browser-Automatisierung.

- Ideal für moderne Web-Apps und asynchrones Scraping.

Preise: Kostenlos (Open Source).

Nutzerbewertungen: ~4,8★ in der Entwickler-Community. Schnell und robust.

Ideal für: Entwickler, die schnelle und zuverlässige Browser-Automatisierung für moderne Seiten brauchen.

Urllib3: Leichtgewichtige HTTP-Requests

Highlights:

- Low-Level-HTTP-Client für Python.

- Connection-Pooling, Wiederholungen, Proxy-Support.

- Häufig als Basis für andere Scraping-Bibliotheken genutzt.

Preise: Kostenlos (Open Source).

Nutzerbewertungen: 4,5★ in der Entwickler-Community. Zuverlässig und effizient.

Ideal für: Python-Entwickler, die volle Kontrolle über HTTP-Requests in ihren Scraping-Skripten wollen.

Kostenlose web-scraping-tools: Was gibt es gratis?

Manchmal will man einfach nur schnell an die Daten – ohne gleich ein Abo abzuschließen. Hier die besten kostenlosen Optionen aus unserer Liste:

- : Kostenlos (6 Seiten, mit Test 10); unbegrenzter Gratis-Export nach Excel, Sheets, Airtable, Notion.

- Kadoa: 500 Credits gratis.

- Octoparse: Gratis (10 Tasks, begrenzte Geschwindigkeit).

- ParseHub: Gratis (5 Projekte, 200 Seiten pro Lauf).

- Web Scraper.io: Kostenlose Browser-Erweiterung für unbegrenzte lokale Nutzung.

- Browse AI: Gratis (50 Credits/Monat).

- Bardeen AI: Gratis (100 Credits/Monat).

- ScrapeStorm: Gratis-Version (begrenzte Seiten).

- Selenium, Beautiful Soup, Playwright, Urllib3: Alle kostenlos und Open Source.

Einschränkungen: Die Gratis-Versionen sind meist in Seitenzahl, Credits oder Geschwindigkeit limitiert. Für Unternehmen eignen sie sich gut zum Testen, Prototypen oder kleine Aufgaben – für regelmäßiges oder großflächiges Scraping ist meist ein Upgrade nötig.

website scraping tools: Vorteile, Nachteile und beste Einsatzbereiche

Hier die wichtigsten Kategorien im Überblick:

KI-Web-Scraper (Thunderbit, Kadoa)

- Vorteile: Schnellste Einrichtung, passt sich Seitenänderungen an, kein Coding nötig, ideal für chaotische oder sich oft ändernde Seiten.

- Nachteile: Nicht für riesige Enterprise-Jobs (KI braucht Zeit), erweiterte Features kostenpflichtig.

- Ideal für: Vertrieb, Operations, E-Commerce, Immobilien – alle, die strukturierte Daten aus komplexen Seiten ohne Coding wollen.

No-/Low-Code-Scraper (Octoparse, ParseHub, Web Scraper, Browse AI, Bardeen AI, ScrapeStorm)

- Vorteile: Visuelle Einrichtung, unterstützt dynamische Inhalte, Zeitplanung, teils KI-Unterstützung.

- Nachteile: Lernkurve, Verständnis für Selektoren nötig, bei großen Projekten langsam oder teuer.

- Ideal für: Nicht-Programmierer mit Lernbereitschaft, Analysten, Marketer, Forscher.

Web-Scraper-API (ScraperAPI, Bright Data, Zyte, ZenRows, ScrapingBee)

- Vorteile: Skalierbar, übernimmt Proxies und Anti-Bot, Integration in eigene Workflows.

- Nachteile: Programmierkenntnisse nötig, Parsing-Logik selbst bauen, bei großen Volumen teurer.

- Ideal für: Entwickler, Startups, Unternehmen mit eigenem Dev-Team.

Python-Bibliotheken (Selenium, Beautiful Soup, Playwright, Urllib3)

- Vorteile: Maximale Flexibilität, kostenlos, in jeden Workflow integrierbar.

- Nachteile: Programmierung und manuelle Einrichtung nötig, für große Jobs langsam.

- Ideal für: Entwickler, technische Teams, individuelle Projekte.

Das Web-Scraping-Universum 2025 ist so vielfältig und leistungsfähig wie nie zuvor. Egal ob du als Business-Anwender eine KI-Lösung wie suchst, als Entwickler eigene Workflows baust oder einfach nur eine lästige Aufgabe automatisieren willst – es gibt das passende Tool für dich.

Fazit: Das richtige website scraping tool für 2025 finden

Dank ki-web-scraper muss heute niemand mehr Programmierer sein, um wertvolle Webdaten zu extrahieren. Aber: Mit großer Macht kommt auch Verantwortung – halte dich immer an die Nutzungsbedingungen und Datenschutzgesetze der Zielseiten.

Mein Tipp: Starte mit einer kostenlosen Testversion der Top-Tools (besonders Thunderbit, wenn du KI in Aktion sehen willst) und probiere verschiedene Ansätze aus. Das richtige web-scraper-Tool spart dir Stunden, eröffnet neue Geschäftschancen und sorgt dafür, dass du weniger Zeit mit Copy-Paste verbringst – und mehr mit den wirklich wichtigen Aufgaben.

Mehr erfahren? Im findest du ausführliche Guides, Tutorials und die neuesten Trends rund um ki-web-scraper. Oder lade direkt herunter und erlebe, wie einfach Datenerfassung heute sein kann.

Viel Spaß beim Scrapen – und möge deine Datenquelle immer strukturiert, aktuell und nur einen Klick entfernt sein.

FAQs

Frage 1: Was unterscheidet klassische von KI-basierten web-scraper?

Klassische Scraper setzen meist auf manuelle Konfiguration mit CSS-Selektoren oder XPath und brechen oft bei Layout-Änderungen. KI-basierte Tools wie Thunderbit oder Kadoa nutzen Sprachmodelle, um Webseiten wie ein Mensch zu verstehen – ganz ohne Coding und mit automatischer Anpassung an Layout-Änderungen.

Frage 2: Worauf sollte ich bei der Auswahl eines web-scraper achten?

Achte auf Bedienkomfort, Automatisierungsfunktionen, Exportmöglichkeiten, Kosten und wie gut das Tool mit dynamischen Inhalten oder Anti-Bot-Maßnahmen umgeht. Business-Anwender bevorzugen meist No-Code-KI-Tools, Entwickler greifen für mehr Kontrolle und Skalierbarkeit zu APIs oder Python-Bibliotheken.

Frage 3: Warum ist Thunderbit besonders für Business-Anwender geeignet?

richtet sich an nicht-technische Teams, die schnell strukturierte Webdaten brauchen. Die KI übernimmt das Lesen der Seite, das Navigieren von Unterseiten und die Felderkennung – ganz ohne Programmierung. Mit Sofort-Export zu Sheets, Airtable, Notion und großzügigem Gratis-Kontingent ist es ideal für Vertrieb, Operations und E-Commerce.

Mehr erfahren: