Hast du dich schon mal dabei ertappt, wie du vor einer Webseite sitzt und dir wünschst, du könntest einfach alle Infos auf einmal in eine Tabelle ziehen? Damit bist du echt nicht allein. Ich kenne das nur zu gut: ständiges Klicken, Kopieren, Einfügen – und immer wieder die Frage, ob es nicht einen smarteren Weg gibt, das Datenchaos im Netz sinnvoll zu nutzen. Die gute Nachricht: Den gibt’s! Und das Ganze ist längst nicht mehr nur was für IT-Nerds oder Datenprofis.

Webseiten sind heute viel mehr als nur digitale Visitenkarten – sie sind wahre Schatzkisten voller Infos. Egal ob Vertrieb, Onlinehandel, Analyse oder Selbstständige: Alle suchen nach Wegen, Daten blitzschnell aus dem Netz zu ziehen, herunterzuladen und weiterzuverarbeiten. Die Zahlen sprechen für sich: , und . Wer noch manuell kopiert, verpasst die Effizienz, die moderne site ripper bieten.

Lass uns also gemeinsam in die Welt des Site Rip eintauchen: Was steckt dahinter, wer profitiert davon und welche Tools – inklusive KI-gestützter Lösungen – helfen dir, Dateien von URLs online herunterzuladen, Workflows zu automatisieren und Webseiten in echte Datenschätze zu verwandeln.

Was ist Site Rip? Webseiten in nutzbare Daten verwandeln

Fangen wir ganz vorne an: Was bedeutet eigentlich „Site Rip“? Kurz gesagt: Dabei wird der komplette oder ein Teil des Inhalts einer Webseite heruntergeladen – für die Offline-Nutzung, als Backup oder, mein Favorit, zur Datenextraktion. Stell dir das wie einen Schnappschuss einer Webseite vor – egal, ob du alles oder nur die wichtigsten Infos sichern willst.

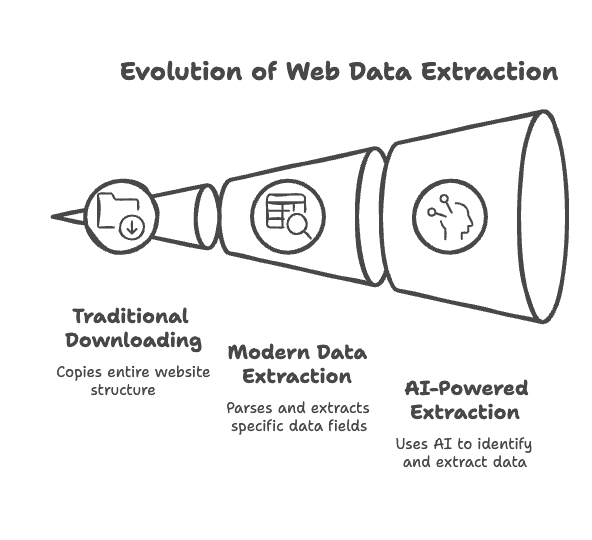

Klassische site ripper (oft auch genannt) wie HTTrack oder Wget wurden entwickelt, um Webseiten zu „spiegeln“: Sie laden HTML-Seiten, Bilder, PDFs und andere Dateien herunter und erhalten die Linkstruktur, sodass du offline wie gewohnt surfen kannst. Perfekt für Backups, Migrationen oder um sich den Quellcode einer Seite anzuschauen.

Aber die Entwicklung geht weiter: Moderne site ripper können viel mehr. Es geht nicht mehr nur ums Kopieren von Dateien, sondern um das . Statt einem Ordner voller Dateien bekommst du Tabellen, CSVs oder direkt ausgelesene Daten aus den Seiten. Beispiel: Anstatt nur eine Produktseite zu speichern, liefert dir ein modernes Tool eine übersichtliche Tabelle mit Produktnamen, Preisen und Bewertungen.

Mit KI-basierten Web-Scraper-Tools wird’s noch smarter. Sie erkennen Inhalte, passen sich an Änderungen an und können die Ergebnisse sogar direkt weiterverarbeiten – zum Beispiel Texte zusammenfassen oder Infos kategorisieren. Kurz gesagt: .

Wer braucht Site Rip? Mehrwert für Vertrieb, Operations & Co.

Site Rip ist längst nicht mehr nur ein Thema für Entwickler oder Hacker. Heute nutzen Fachabteilungen in Unternehmen jeder Größe diese Tools, um aus Webdaten echten Mehrwert zu ziehen. Hier ein Überblick, wer Site Rip nutzt – und warum:

| Nutzergruppe | Beispiel-Anwendung | Vorteil / ROI |

|---|---|---|

| Vertriebsteams | Geschäftsdatenbanken oder LinkedIn-Profile für Leads und Kontakte scrapen | Schnellere Lead-Generierung: In Minuten neue Listen, mehr Zeit fürs Verkaufen |

| Marketing | Wettbewerber-Monitoring, Kundenbewertungen aggregieren | Bessere Marktkenntnis: Aktuelle Insights für gezieltere Kampagnen |

| E-Commerce | Preise und Lagerbestände bei Mitbewerbern überwachen | Schnelle Entscheidungen: Automatisiertes Preis- und Bestandsmonitoring |

| Forschung/Analyse | Große Datensätze von Newsseiten, Foren oder öffentlichen Datenbanken sammeln | Umfangreiche, fehlerarme Datensätze: Mehr Tiefe für Analysen |

| Immobilienmakler | Immobilienangebote und Kontaktdaten von Portalen extrahieren | Wettbewerbsvorteil: Vollständige, aktuelle Listings für bessere Beratung |

| Content-Manager | Website-Inhalte und Medien sichern oder für Migration exportieren | Content-Sicherung: Immer ein aktuelles Offline-Backup, einfachere Migration und Notfallwiederherstellung |

In allen Fällen gilt: . Unternehmen, die Datenerfassung automatisieren, berichten von , und bis 2023 hatten rund .

Wie funktioniert Site Rip? Vom Download zur Datenextraktion

Das Grundprinzip ist simpel, aber die Wahl des Tools macht den Unterschied.

Klassische website downloader:

Du gibst eine URL ein, wählst aus, welche Dateitypen du willst, und das Tool crawlt die Seite, lädt Seiten und Dateien herunter und erhält die Struktur. Tools wie HTTrack oder Cyotek WebCopy sind dafür ideal – sie kopieren alles, aber extrahieren keine gezielten Daten.

Moderne Datenextraktionstools:

Hier geht’s einen Schritt weiter. Statt nur Dateien zu speichern, . Du klickst z. B. auf einen Produktnamen oder Preis, und das Tool erstellt einen Workflow, um diese Infos von allen ähnlichen Seiten zu sammeln. Das Ergebnis: Strukturierte Daten in Excel, CSV, JSON oder direkt in Google Sheets.

Die Rolle der KI:

Jetzt wird’s spannend: KI-gestützte Tools wie verstehen deine Wünsche in natürlicher Sprache („Produktname, Preis, Bild-URL“) und extrahieren die Daten automatisch – ganz ohne HTML- oder CSS-Kenntnisse. Die KI hilft auch beim Bereinigen und Strukturieren der Daten und passt sich an, wenn sich das Layout einer Website ändert. Kurz: .

Die 8 besten Site Rip Tools für schnelle und einfache Datenextraktion

Jetzt zu den Tools! Ich habe die besten Lösungen getestet, recherchiert und verglichen – von klassischen Downloadern bis zu KI-basierten Web-Scraper-Tools. Hier meine Top 8, jeweils mit ihren Besonderheiten.

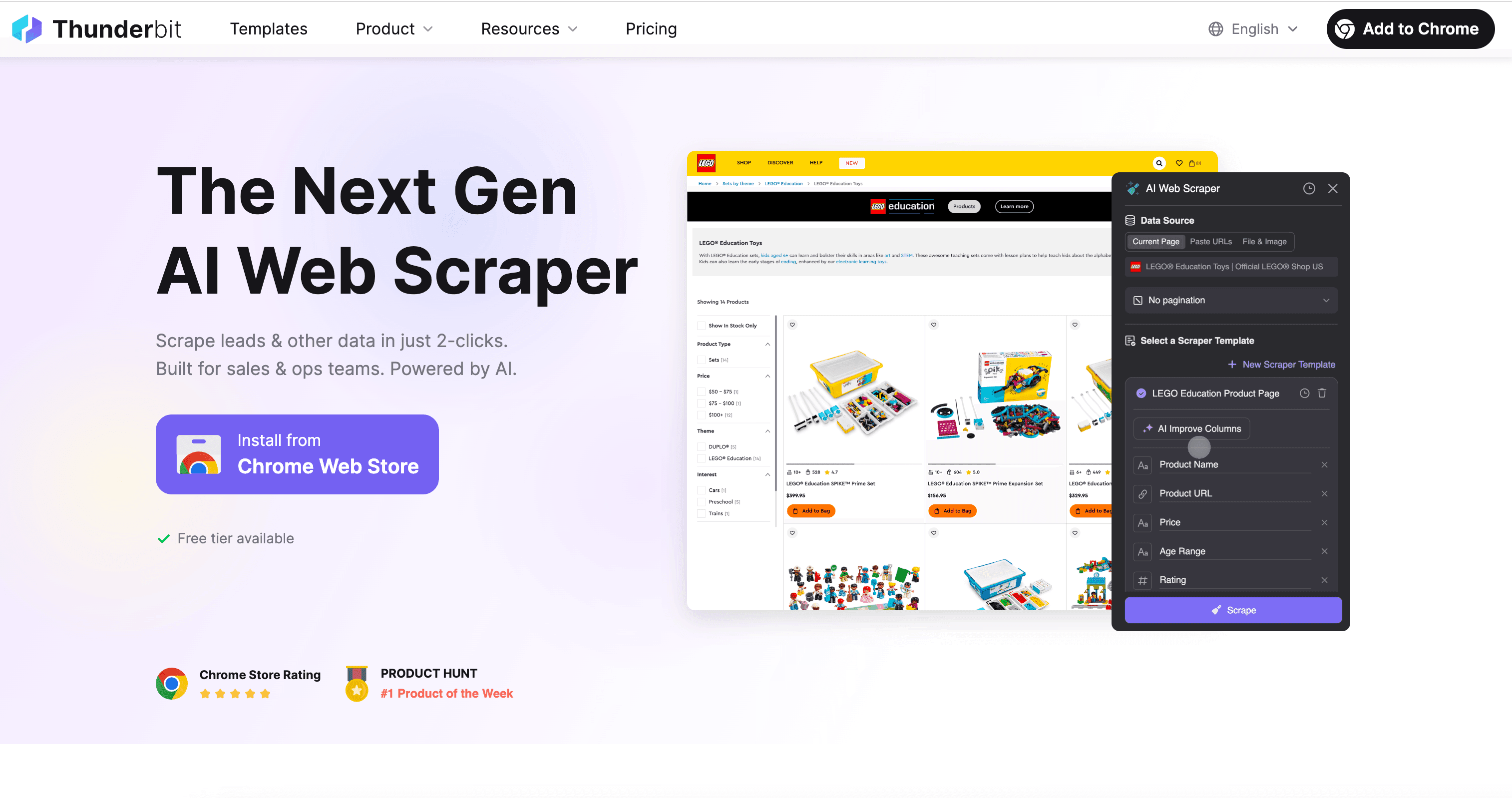

1. Thunderbit: KI-gestütztes Site Rip für alle

Ich gebe zu, ich bin hier etwas voreingenommen – Thunderbit ist mein eigenes Projekt, entwickelt, um genau die beschriebenen Probleme zu lösen. Unser Ansatz: „Webseiten sind nicht nur zum Lesen da – sie sind strukturierte Datenquellen, die genutzt werden wollen.“ Das Web ist eine riesige, unstrukturierte Informationsquelle, und site ripper sind der Schlüssel dazu. KI macht daraus nutzbare Daten.

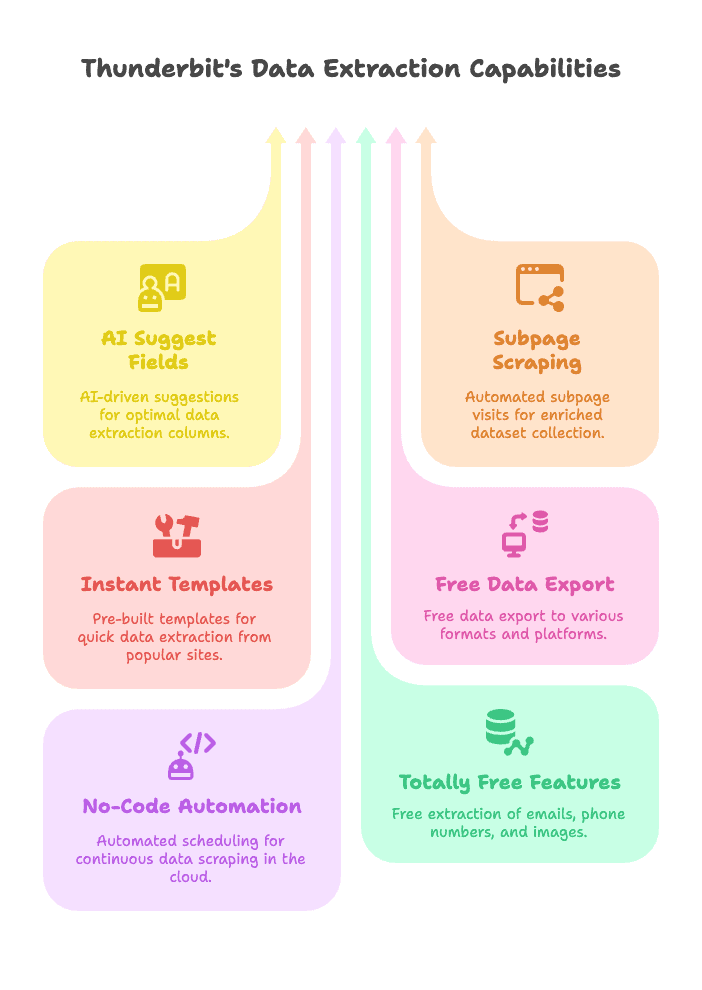

Was Thunderbit besonders macht

- KI-Feldvorschläge: Ein Klick, und Thunderbits KI erkennt automatisch die wichtigsten Datenfelder und richtet den Web-Scraper für dich ein. Kein Rätselraten, kein Programmieren.

- Unterseiten-Scraping: Du brauchst mehr als nur die Übersichtsseite? Thunderbit besucht automatisch jede Unterseite (z. B. Produktdetails) und erweitert so deinen Datensatz.

- Sofort-Vorlagen: Für viele bekannte Webseiten (Amazon, Zillow, Instagram, Shopify u. v. m.) gibt es fertige Templates für den 1-Klick-Export – ohne Einrichtung.

- Kostenloser Datenexport: Exportiere deine Daten nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON – auch im Gratis-Tarif ohne Zusatzkosten.

- No-Code-Automatisierung: Plane Scrapes automatisch (z. B. tägliche Preisüberwachung) und lass Thunderbit die Arbeit in der Cloud erledigen.

- Komplett kostenlose Features: E-Mails, Telefonnummern und Bilder mit nur einem Klick extrahieren – völlig gratis.

- Unterstützt 34 Sprachen: Die Chrome-Erweiterung ist weltweit nutzbar.

Thunderbit ist für alle gemacht, die keine IT-Kenntnisse haben – kein Code, kein IT-Team nötig. Einfach klicken und extrahieren. Unsere Nutzer reichen von Vertriebsteams über E-Commerce-Betreiber bis zu Immobilienmaklern. Das Beste: .

Wer Thunderbit in Aktion sehen will, schaut auf unserem vorbei oder entdeckt weitere Anwendungsfälle im .

Thunderbit ist der einfachste Weg, strukturierte Daten aus jeder Webseite zu gewinnen – egal ob für Vertrieb, E-Commerce oder Forschung. Dank KI-Felderkennung und Unterseiten-Scraping automatisierst du deine Datensammlung mit wenigen Klicks.

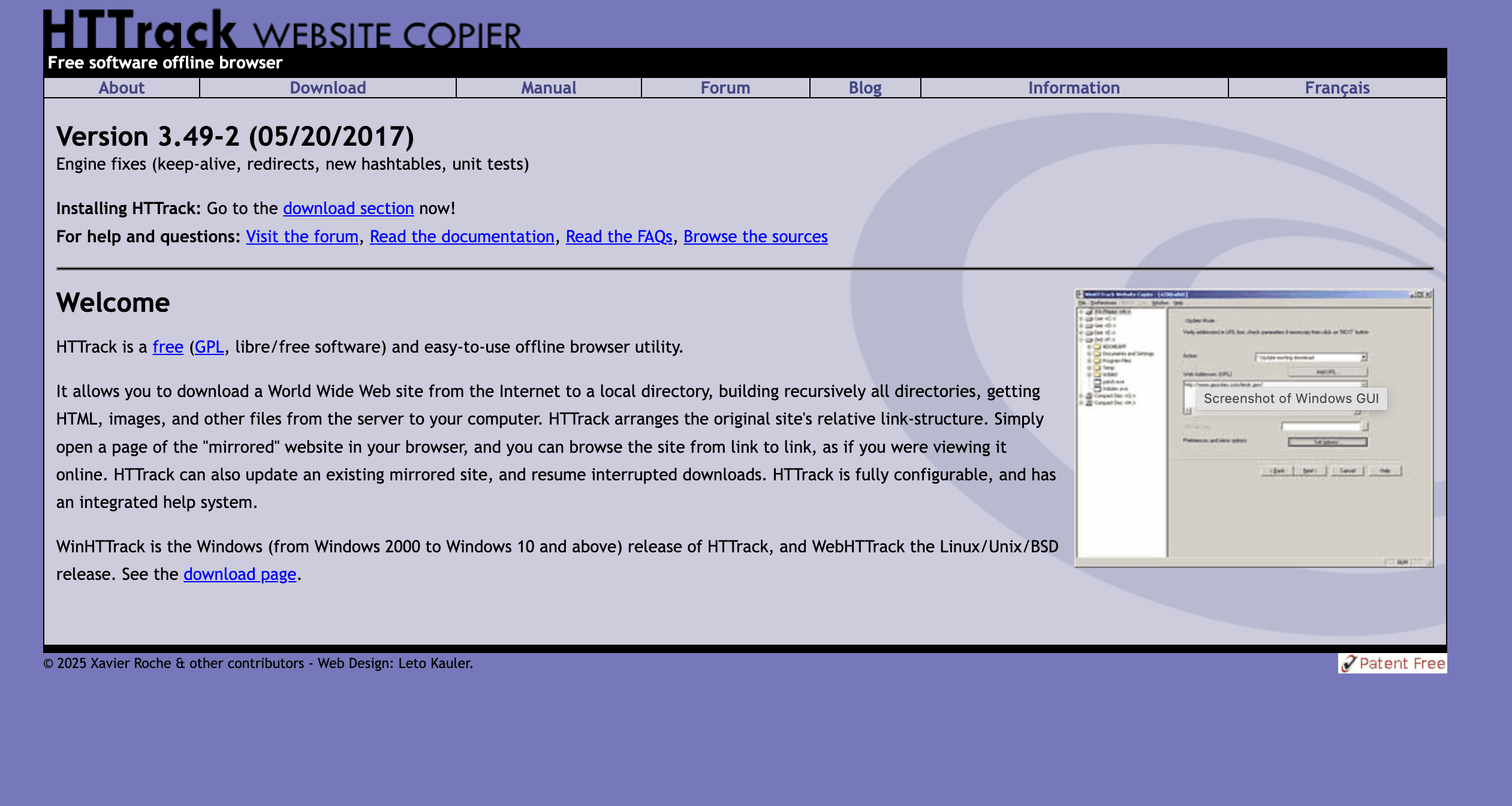

2. HTTrack: Klassiker für Offline-Kopien

HTTrack ist der Urvater unter den site ripper. Seit den späten 90ern beliebt bei Archivaren, Forschern und allen, die komplette Webseiten offline sichern wollen.

Was es kann

- Offline-Nutzung: Ganze Webseiten (HTML, Bilder, Stylesheets usw.) herunterladen und die Linkstruktur erhalten.

- Plattformübergreifend: Für Windows, Linux und Android verfügbar.

- Anpassbar: Filter, Crawltiefe und Fortsetzen abgebrochener Downloads einstellbar.

Grenzen

- Kein dynamischer Content: Kommt mit JavaScript-lastigen Seiten nicht klar.

- Keine strukturierten Daten: Liefert Dateien und Ordner, keine Tabellen.

- Kann zu viel kopieren: Ohne Filter wird alles geladen.

HTTrack eignet sich perfekt für Backups statischer Seiten, Archivierung oder Offline-Surfen. Es ist kostenlos und Open Source, aber nicht geeignet, wenn du gezielt Daten in Tabellenform brauchst.

3. Octoparse: Visuelles Site Rip & Cloud-Datenextraktion

Octoparse ist ein Schwergewicht im Web-Scraping, besonders für Business-Anwender, die visuelle Workflows bevorzugen. Die Windows-App (plus Cloud-Plattform) ermöglicht das Erstellen von Scraping-Aufgaben per Klick – ohne Programmierkenntnisse, aber mit Verständnis für Website-Strukturen.

Wichtige Funktionen

- Visueller Workflow: Datenfelder per Klick auswählen, Paginierung, Logins und Scrollen automatisieren.

- Cloud-Scraping: Aufgaben auf Octoparse-Servern ausführen, Zeitpläne festlegen, Daten in verschiedenen Formaten exportieren.

- Vorlagen: Templates für Amazon, Twitter, Yelp und mehr.

- Erweiterte Optionen: IP-Rotation, Anti-Blocking, API-Zugriff, Teamarbeit.

Vorteile & Nachteile

- Vorteile: Meistert komplexe, dynamische Seiten; leistungsstark für große Datenmengen; kein Coding nötig.

- Nachteile: Für Einsteiger recht komplex; kostenpflichtige Pläne können teuer werden; Fokus auf Windows (Cloud ist plattformübergreifend).

Für Datenanalysten oder E-Commerce-Manager, die regelmäßig tausende Datensätze extrahieren, ist Octoparse eine gute Wahl – aber mit Einarbeitungszeit. Einen ausführlichen Vergleich findest du in .

4. Cyotek WebCopy: Kostenloses, flexibles Site Rip für Windows

Cyotek WebCopy ist ein kostenloses Windows-Tool, mit dem du ganze oder Teile von Webseiten für die Offline-Nutzung herunterladen kannst. Moderner als HTTrack und mit mehr Kontrolle über die Auswahl.

Highlights

- Eigene Regeln: URLs oder Dateitypen per Wildcard oder Regex ein- oder ausschließen.

- Link-Anpassung: Passt Links für reibungsloses Offline-Surfen an.

- Berichte: Crawl-Reports zeigen fehlende oder defekte Links.

Nachteile

- Nur für Windows: Keine Mac- oder Linux-Version.

- Kein JavaScript: Wie HTTrack keine dynamischen Inhalte.

- Einarbeitung nötig: Viele Einstellungen für komplexe Aufgaben.

Wer als Windows-Nutzer mehr Kontrolle über Offline-Backups will, findet in Cyotek WebCopy eine flexible (und kostenlose) Lösung.

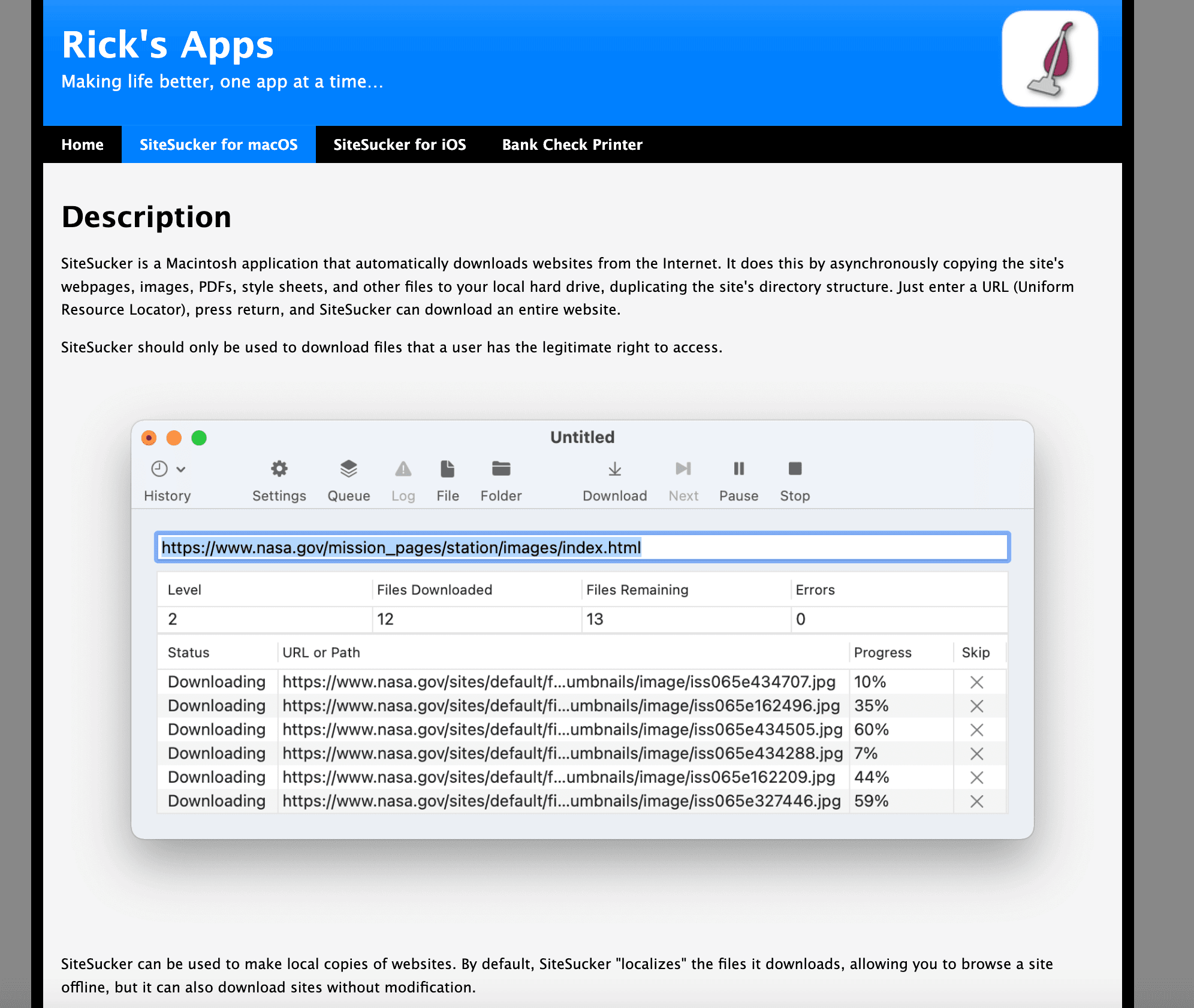

5. SiteSucker: Website-Downloader für Mac

SiteSucker ist die erste Wahl für Mac-Nutzer, die Webseiten für die Offline-Nutzung herunterladen möchten. Im Mac App Store erhältlich und extrem einfach zu bedienen.

Funktionen

- Ein-Klick-Download: URL eingeben, Zielordner wählen, fertig.

- Pause/Fortsetzen: Praktisch bei großen Seiten oder instabiler Verbindung.

- Mehrsprachig: In mehreren Sprachen lokalisiert.

Einschränkungen

- Nur für Mac: Keine Windows- oder Linux-Version.

- Nur statische Inhalte: Keine dynamischen oder interaktiven Seiten.

- Kostenpflichtig: Ca. 5 €, aber viele schätzen die Einfachheit.

SiteSucker eignet sich ideal zum Archivieren von Blogs, Dokus oder Seiten für das Offline-Lesen. Für strukturierte Datenextraktion gibt es bessere Alternativen.

6. Getleft: Open-Source-Downloader mit Mehrsprachigkeit

Getleft ist ein weniger bekanntes, quelloffenes site ripper mit einfacher Oberfläche und Unterstützung für 14 Sprachen. Leichtgewichtig und kostenlos – beliebt bei Studierenden und Hobbyisten.

Vorteile

- Dateitypen wählen: Bestimme, welche Dateien (HTML, Bilder, PDFs etc.) geladen werden.

- Linkbearbeitung: Passt Links für Offline-Nutzung an.

- Downloads fortsetzen: Kommt mit Unterbrechungen klar.

Nachteile

- Veraltet: Kommt mit modernen, JavaScript-lastigen Seiten nicht zurecht.

- Keine strukturierten Daten: Nur statisches HTML.

- Altmodische Oberfläche: Wirkt etwas aus der Zeit gefallen.

Wer eine einfache, quelloffene Lösung für statische Seiten sucht, ist mit Getleft gut bedient.

7. Website : Dateien online per Klick herunterladen

Manchmal braucht man eine schnelle, browserbasierte Lösung – ohne Installation. Website ist ein Online-Tool: URL eingeben, und du erhältst ein ZIP mit HTML, CSS, Bildern und anderen Assets.

Vorteile

- Keine Installation: Funktioniert in jedem Browser.

- Schnelle Ergebnisse: Ideal für Einmal-Downloads oder gesperrte Rechner.

- Statische Assets: Lädt HTML, Bilder, PDFs usw.

Einschränkungen

- Dateilimit: Gratis-Version auf ca. 200 Dateien begrenzt.

- Keine strukturierten Daten: Rohdateien, keine Tabellen.

- Wenig Kontrolle: Keine Filter, keine Logins.

Wer oder Quellcode sichern will, findet in Website ein praktisches Tool.

8. Erwähnenswerte Alternativen

Neben den sieben genannten gibt es noch einige Nischenlösungen:

- Wget: Kommandozeilentool für Fortgeschrittene, besonders unter Linux.

- Wayback Machine Downloader: Für das Archivieren historischer Website-Versionen.

- Weitere Chrome-Erweiterungen: Es gibt viele, aber kaum eine bietet so viele KI-Features wie Thunderbit.

Vergleichstabelle: Welches Site Rip Tool passt zu dir?

| Tool | Plattform | Preis | Hauptfunktionen | Ideal für | Einschränkungen |

|---|---|---|---|---|---|

| Thunderbit | Chrome-Erweiterung + Cloud | Kostenlos/kostenpflichtig | KI-Felderkennung, Unterseiten-Scraping, Vorlagen, Zeitplanung, Exporte | Strukturierte Datenerfassung, No-Code-Nutzer | Credit-Limits, Chrome erforderlich |

| HTTrack | Windows/Linux/Android | Kostenlos (Open Source) | Komplettes Site-Mirroring, anpassbar, Fortsetzen, plattformübergreifend | Offline-Nutzung, Backups | Kein JS, keine Datentabellen |

| Cyotek WebCopy | Windows | Kostenlos | Eigene Regeln, Linkanpassung, Berichte | Individuelle Offline-Kopien | Nur Windows, kein JS, Einarbeitung nötig |

| Octoparse | Windows + Cloud | Kostenlos/kostenpflichtig | Visueller Workflow, Cloud-Scraping, Vorlagen, API | Datenanalysten, E-Commerce, große Datenmengen | Einarbeitung, Preis, Windows-Fokus |

| SiteSucker | macOS | Kostenpflichtig (~5 €) | Ein-Klick-Download, Pause/Fortsetzen, mehrsprachig | Mac-Nutzer, Offline-Lesen | Nur Mac, statische Inhalte, keine Datentabellen |

| Getleft | Windows/Linux | Kostenlos (Open Source) | Dateitypenwahl, mehrsprachig, Fortsetzen | Open-Source-Fans, einfache Seiten | Veraltet, kein JS, keine strukturierten Daten |

| Website Downloader.io | Web (alle OS) | Kostenlos/kostenpflichtig | Browserbasiert, schnelles ZIP, statische Assets | Schnelle Downloads, keine Installation | Dateilimit, keine Filter, nur statisch |

Mehr Details findest du in der .

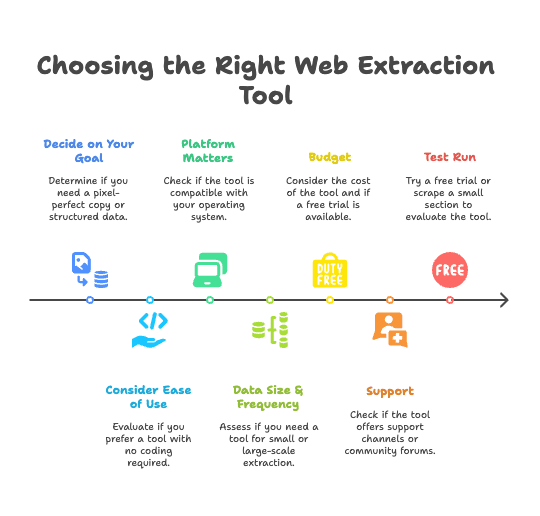

Wie wähle ich das richtige Site Rip Tool für meinen Workflow?

Bei so vielen Optionen: Wie findest du das passende Tool? Hier meine Praxistipps aus jahrelanger Erfahrung mit Webdaten-Automatisierung:

- Ziel festlegen:

- Brauchst du eine exakte Offline-Kopie? Dann nutze klassische Downloader (HTTrack, WebCopy, SiteSucker).

- Willst du strukturierte Daten (z. B. Produkt- oder Kontaktlisten)? Dann setze auf Datenextraktionstools (Thunderbit, Octoparse).

- Benutzerfreundlichkeit:

- Willst du schnelle Ergebnisse ohne Programmieren? ist ideal.

- Bist du bereit, dich einzuarbeiten und brauchst mehr Kontrolle? Dann probiere Octoparse oder Cyotek WebCopy.

- Plattform:

- Mac? Thunderbit (Chrome) oder SiteSucker.

- Windows? Alle Optionen offen.

- Linux? HTTrack, Getleft oder Thunderbit (über Chrome).

- Datenmenge & Häufigkeit:

- Einmaliger, kleiner Job? Website oder ein Gratis-Tool reicht.

- Regelmäßige, große Extraktion? Setze auf Automatisierung mit Thunderbit oder Octoparse.

- Budget:

- Kostenlose/Open-Source-Tools sind super, aber kostenpflichtige Lösungen sparen oft langfristig Zeit und Nerven.

- Viele kostenpflichtige Tools bieten Gratis-Tests – nutze sie!

- Support:

- Brauchst du Hilfe? Thunderbit und Octoparse bieten Support. Open-Source-Tools setzen auf Community-Foren.

- Testlauf:

- Probiere eine Gratis-Version oder scrape einen kleinen Bereich, um zu sehen, ob das Tool passt.

Beispiel-Szenarien:

Beispiel-Szenarien:

- Vertrieb: Wöchentlich Leads sammeln? Thunderbits KI und Zeitplanung sparen Stunden.

- Archivierung: Backup der Firmenwebsite? HTTrack oder WebCopy nutzen.

- Forschung: Wettbewerberdaten? Thunderbit oder Octoparse liefern strukturierte Tabellen.

- Offline-Lesen: Tolle Tutorial-Seite gefunden? SiteSucker (Mac) oder HTTrack (Windows) sind ideal.

Noch unsicher? ist der perfekte Einstieg – probiere es aus, und wenn es nicht passt, teste ein anderes Tool.

Fazit: Die Zukunft von Site Rip – von Handarbeit zu KI-Datenextraktion

Die Zeiten, in denen man Webseiten mühsam in Excel kopiert hat, sind vorbei. Site ripper haben sich von simplen Downloadern zu KI-gestützten Datenplattformen entwickelt. Die Zukunft? Webseiten werden als Datenquellen genutzt, nicht nur als Lesestoff.

Thunderbits Vision ist klar: „Webseiten sind nicht nur zum Lesen da – sie sind zum Nutzen da.“ Die cleversten Teams kopieren nicht mehr von Hand, sondern lassen die KI die Arbeit machen. Mit dem richtigen Tool kann jeder die Informationsflut des Webs in wertvolle Erkenntnisse, Backups oder Produkte verwandeln.

Also: Schluss mit der Handarbeit, her mit der Automatisierung! Egal ob Vertrieb, Marketing, Forschung oder einfach neugieriger Webnutzer – es gibt das passende site ripper Tool für dich. Die Ära des KI-gestützten Site Rip ist da und macht Webdaten für alle zugänglich.

Bereit für den nächsten Schritt? und gehöre zu denen, die Copy-Paste endgültig hinter sich lassen.

Weiterführende Artikel:

Viel Erfolg beim Datensammeln!

FAQs

1. Was ist Site Rip und wie funktioniert es?

Site Rip bedeutet, dass du ganze oder Teile einer Webseite für die Offline-Nutzung, als Backup oder zur Datenextraktion herunterlädst. Klassische Tools wie HTTrack spiegeln Seiten für das Offline-Surfen, moderne Tools nutzen KI, um strukturierte Daten wie Tabellen, Produktlisten oder Kontakte direkt als CSV oder Excel zu exportieren.

2. Wer profitiert von Site Rip Tools?

Site ripper sind für viele Nutzergruppen wertvoll: Vertriebsteams für Lead-Generierung, Marketing für Wettbewerbsbeobachtung, E-Commerce für Preisüberwachung, Forschung für Datensammlungen, Immobilienmakler für Listings und Content-Manager für Backups.

3. Wie unterscheiden sich KI-basierte Site Rip Tools von klassischen Downloadern?

KI-Tools wie Thunderbit erkennen Webseiteninhalte, finden automatisch relevante Datenfelder, passen sich an Layout-Änderungen an und exportieren saubere, strukturierte Daten. Klassische Tools kopieren dagegen nur Rohdateien ohne Inhaltsanalyse.

4. Was sind die besten Site Rip Tools aktuell?

Zu den Top-Tools zählen Thunderbit für KI-basierte Datenextraktion, HTTrack und Cyotek WebCopy für komplette Site-Downloads, Octoparse für visuelle Scraping-Workflows, SiteSucker für Mac-Nutzer und Downloader.io für schnelle, browserbasierte Downloads. Die Wahl hängt von Plattform, Anwendungsfall und Know-how ab.

5. Wie finde ich das passende Site Rip Tool?

Definiere zuerst dein Ziel – Offline-Zugriff oder strukturierte Datenextraktion. Dann entscheide nach Plattform (Windows, Mac etc.), Benutzerfreundlichkeit, Budget und Häufigkeit/Umfang der Extraktion. Thunderbit ist ideal für No-Code-Nutzer mit Fokus auf strukturierte Daten, HTTrack für statische Backups.