Stell dir vor: Es ist 8:30 Uhr, der Kaffee dampft, und dein Chef (oder sogar dessen Chef) will von dir eine Tabelle mit allen Produktpreisen der Konkurrenz, Kundenbewertungen und – warum eigentlich nicht – dem Lieblingspizzabelag des CEOs. Du könntest jetzt stundenlang Daten per Copy & Paste zusammensuchen – oder du lässt Python für dich schuften. Aber was, wenn du keine Lust auf Programmieren hast oder morgens lieber nicht mit HTML-Fehlermeldungen kämpfen willst? Genau dafür ist dieser Guide da.

Ich bin Shuai Guan, Mitgründer und CEO von . Seit Jahren helfe ich Teams aus SaaS, Automatisierung und KI dabei, aus dem Datenchaos im Netz wertvolle Infos zu ziehen. In diesem Beitrag stelle ich dir die 10 besten Python Web-Scraping-Bibliotheken für 2025 vor – mit ihren Features, Stärken, Schwächen und typischen Einsatzbereichen. Und falls du denkst: „Klingt cool, aber Python ist nicht mein Ding“, keine Sorge: Ich zeige dir auch, wie du mit Thunderbits No-Code KI-Web-Scraper in nur zwei Klicks ans Ziel kommst – ganz ohne Programmierkenntnisse, Stress oder Koffein-Overkill.

Warum Python Web-Scraping-Bibliotheken für Unternehmen unverzichtbar sind

- Leadgenerierung & Vertrieb: Durchsuche Verzeichnisse, soziale Netzwerke oder Foren, um gezielte Kontaktlisten zu bauen – Namen, E-Mails, Social-Profile und mehr. So sparen Vertriebsteams stundenlange Recherche ().

- Preisbeobachtung & Wettbewerbsanalyse: E-Commerce-Teams behalten Preise, Lagerbestände und Aktionen der Konkurrenz in Echtzeit im Blick und können ihre Strategie flexibel anpassen ().

- Marktforschung & Trendanalyse: Durch das Auslesen von Bewertungen, Social Media oder News erkennen Marketing- und Produktteams Trends und Stimmungen, bevor sie Mainstream werden ().

- Immobilien & Objektdaten: Makler und Analysten bündeln Angebote, Preise und Objektdetails aus verschiedenen Quellen und machen so die Marktanalyse leichter.

- E-Commerce-Operations: Von Lieferantendaten bis Katalog-Checks – Web Scraping sorgt für saubere Daten und spart mühsames Copy-Paste.

Kurz gesagt: . Der Haken: Die meisten Python-Bibliotheken setzen Programmierkenntnisse voraus. Für Nicht-Techies ist das eine echte Hürde. Deshalb werden No-Code-Tools wie mit KI immer beliebter – dazu gleich mehr.

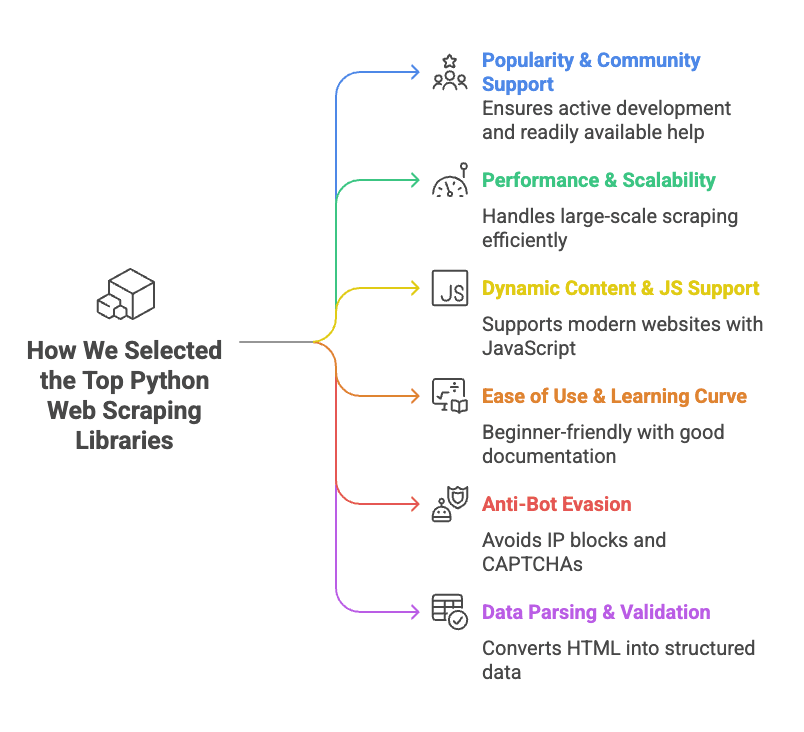

So haben wir die besten Python Web-Scraping-Bibliotheken ausgewählt

- Beliebtheit & Community: Bibliotheken mit vielen GitHub-Sternen, aktiver Entwicklung und vielen Tutorials. Wer feststeckt, will Antworten auf Stack Overflow – keine Funkstille.

- Performance & Skalierbarkeit: Kann das Tool tausende Seiten abarbeiten? Unterstützt es parallele oder asynchrone Anfragen? Ist es flott oder wünscht man sich doch lieber einen Praktikanten?

- Dynamische Inhalte & JS-Support: Viele moderne Seiten laden Daten per JavaScript. Bibliotheken, die das können (z.B. via Browser-Automatisierung oder API), schneiden besser ab.

- Benutzerfreundlichkeit & Lernkurve: Manche Tools sind sofort startklar, andere verlangen ein „Diplom in Warum geht das nicht?“. Wir bevorzugen Einsteigerfreundlichkeit und gute Doku.

- Anti-Bot-Umgehung: Kommt das Tool mit IP-Sperren, CAPTCHAs oder Rate-Limits klar? Sonst ist nach fünf Minuten Scraping für fünf Tage Schluss.

- Daten-Parsing & Validierung: Es geht nicht nur ums HTML – die Daten müssen sauber und strukturiert sein. Bibliotheken mit Parsing- und Validierungsfunktionen bekommen Extrapunkte.

Zu jeder Bibliothek gibt’s eine Übersicht, Anwendung, Vor- und Nachteile sowie die besten Einsatzszenarien.

Schnellvergleich: Python Web-Scraping-Bibliotheken im Überblick

Hier findest du die Top 10 Bibliotheken im Direktvergleich – so findest du schnell das passende Tool (und kannst vielleicht sogar deinen Chef mit neuem Web-Scraping-Wissen beeindrucken):

| Bibliothek | Benutzerfreundlichkeit | JS-Support | HTTP-Anfragen | HTML-Parsing | Anti-Bot-Features | Datenvalidierung | Ideal für |

|---|---|---|---|---|---|---|---|

| ZenRows | Sehr einfach (API) | ✅ (Browser) | ✅ (API) | ✅ | ✅ (Proxies, CAPTCHA-Umgehung) | ❌ | Großflächiges Scraping geschützter Seiten |

| Selenium | Mittel | ✅ (Browser) | ✅ (Browser) | Teilweise | ❌ | ❌ | Dynamische, interaktive Seiten |

| Requests | Sehr einfach | ❌ | ✅ | ❌ | ❌ | ❌ | Statische Seiten, APIs |

| Beautiful Soup | Einfach | ❌ | ❌ | ✅ | ❌ | ❌ | HTML-Parsing statischer Seiten |

| Playwright | Mittel | ✅ (Browser) | ✅ (Browser) | DOM-Zugriff | ❌ | ❌ | Moderne Web-Apps, Multi-Browser |

| Scrapy | Mittel/Schwer | Teilweise (Add-ons) | ✅ (async) | ✅ | ❌ | Eingeschränkt | Großflächiges, strukturiertes Crawling |

| urllib3 | Einfach (Low-Level) | ❌ | ✅ | ❌ | ❌ | ❌ | Individuelle HTTP-Anfragen, hohe Parallelität |

| HTTPX | Einfach/Mittel | ❌ (async IO) | ✅ (async) | ❌ | ❌ | ❌ | High-Performance, asynchrones Scraping |

| lxml | Mittel | ❌ | ❌ | ✅ (schnell) | ❌ | ❌ | Schnelles Parsing, komplexes HTML/XML |

| Pydantic | Mittel | N/A | N/A | N/A | N/A | ✅ | Datenvalidierung nach dem Scraping |

Hinweis: „JS-Support“ meint die Fähigkeit, JavaScript-generierte Inhalte zu verarbeiten. „Anti-Bot-Features“ bezieht sich auf eingebaute Maßnahmen, nicht auf eigene Workarounds.

ZenRows: All-in-One-Lösung für Python Web Scraping

Was ist das?

ist eine Web-Scraping-API, die dir alles abnimmt: Proxies, CAPTCHA-Umgehung, Browser-Fingerprinting und JavaScript-Rendering. Du machst einfach einen API-Call – ZenRows liefert die Seite.

So läuft’s ab:

API-Key holen, dann mit Python requests ZenRows ansprechen:

1import requests

2url = "<https://example.com>"

3apikey = "<YOUR_ZENROWS_API_KEY>"

4params = {

5 "url": url,

6 "apikey": apikey,

7 "js_render": "true",

8 "premium_proxy": "true"

9}

10response = requests.get("<https://api.zenrows.com/v1/>", params=params)

11print(response.text[:500])Vorteile:

- Umgeht die meisten Anti-Bot-Maßnahmen (Proxies, CAPTCHAs etc.)

- Verarbeitet JavaScript-lastige Seiten

- Einfache API – kein Proxy- oder Browser-Management nötig

- Skalierbar für große Projekte

Nachteile:

- Kostenpflichtig (es gibt eine kostenlose Testphase, aber für Dauerbetrieb kostet’s)

- Abhängigkeit von einem Drittanbieter-API

Ideal für:

Großflächiges Scraping, vor allem bei Seiten mit starker Bot-Abwehr oder JavaScript-Rendering. Wer keine Lust auf CAPTCHAs hat, sollte ZenRows ausprobieren ().

Selenium: Browser-Automatisierung für dynamisches Web Scraping

Was ist das?

ist der Klassiker für Browser-Automatisierung. Du steuerst Chrome, Firefox & Co. direkt aus Python, simulierst Klicks, Formulare, Scrollen und mehr. Was ein Mensch im Browser kann, kann Selenium auch.

So funktioniert’s:

Selenium-Paket und Browser-Treiber (z.B. ChromeDriver) installieren, dann:

1from selenium import webdriver

2from selenium.webdriver.chrome.options import Options

3options = Options()

4options.add_argument("--headless=new")

5driver = webdriver.Chrome(options=options)

6driver.get("<https://example.com>")

7html = driver.page_source

8print(html[:200])

9driver.quit()Vorteile:

- Kann alles, was ein echter Browser kann (dynamische Inhalte, Logins, Pop-ups)

- Simuliert Nutzerinteraktionen (Klicks, Eingaben etc.)

- Multi-Browser-Support

Nachteile:

- Ressourcenhungrig (jeder Browser braucht RAM & CPU)

- Langsamer als HTTP-basiertes Scraping

- Höhere Einstiegshürde (vor allem bei Parallelisierung)

- Kann von fortschrittlichen Anti-Bot-Systemen erkannt werden

Ideal für:

Dynamische, JavaScript-lastige Seiten mit Interaktion – z.B. LinkedIn, Dashboards oder alles hinter einem Login ().

Requests: Der Standard-HTTP-Client für Python

Was ist das?

ist die „HTTP for Humans“-Bibliothek. Der Standard, um Webseiten oder APIs in Python abzurufen – einfach, zuverlässig, überall verfügbar.

So läuft’s:

Statische Seite abrufen:

1import requests

2response = requests.get("<https://www.example.com>")

3if response.status_code == 200:

4 html_text = response.text

5 print(html_text[:300])Vorteile:

- Sehr einfache API

- Schnell und ressourcenschonend

- Unterstützt Cookies, Redirects und gängige HTTP-Funktionen

- Riesige Community, viele Tutorials

Nachteile:

- Kein JavaScript, keine dynamischen Inhalte

- Kein HTML-Parsing (kombinieren mit Beautiful Soup oder lxml)

- Keine Anti-Bot-Features (Header, Proxies etc. manuell nötig)

Ideal für:

Statische Seiten, APIs oder alles, was direkt im HTML steht. Für Einsteiger ist Requests + Beautiful Soup der Klassiker ().

Beautiful Soup: Einfaches HTML-Parsing für Python Web Scraping

Was ist das?

(BS4) ist eine Python-Bibliothek zum Parsen von HTML und XML. Sie lädt keine Seiten selbst – das übernimmt z.B. Requests oder Selenium – macht aber das Extrahieren von Daten aus HTML super einfach.

So läuft’s:

Produktnamen auslesen:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("<https://example.com/products>").text

4soup = BeautifulSoup(html, "html.parser")

5product_names = [tag.get_text() for tag in soup.find_all("h2", class_="product-name")]

6print(product_names)Vorteile:

- Einsteigerfreundlich, auch bei „schlechtem“ HTML

- Flexible Suche (Tag, Klasse, CSS-Selektor, Regex)

- Schnell und leichtgewichtig

- Umfangreiche Dokumentation und Beispiele

Nachteile:

- Lädt keine Seiten, kein JavaScript

- Bei sehr großen Dokumenten langsamer als lxml

- Für komplexe Abfragen weniger geeignet (dafür lxml nutzen)

Ideal für:

Rohes HTML in strukturierte Daten verwandeln – Produktlisten, Tabellen, Links. Wer HTML hat, kann mit Beautiful Soup direkt loslegen ().

Playwright: Moderne Browser-Automatisierung für Python Web Scraping

Was ist das?

ist der moderne Herausforderer im Bereich Browser-Automatisierung, entwickelt von Microsoft. Wie Selenium steuert es Browser, ist aber schneller, unterstützt mehrere Engines (Chromium, Firefox, WebKit) und bietet eine zeitgemäße API.

So läuft’s:

Seiteninhalt abrufen:

1from playwright.sync_api import sync_playwright

2with sync_playwright() as p:

3 browser = p.chromium.launch(headless=True)

4 page = browser.new_page()

5 page.goto("<https://example.com>")

6 content = page.content()

7 print(content[:200])

8 browser.close()Vorteile:

- Verarbeitet dynamische, JS-lastige Seiten

- Multi-Browser-Support (Chromium, Firefox, WebKit)

- Automatisches Warten auf Elemente (weniger Fehler als Selenium)

- Unterstützt Async und Parallelisierung

Nachteile:

- Immer noch ressourcenintensiv (Browser-Automatisierung)

- Lernkurve, vor allem bei Async-Code

- Nicht immun gegen Anti-Bot-Erkennung

Ideal für:

Moderne Web-Apps, Seiten mit unterschiedlichem Verhalten je nach Browser oder wenn du Netzwerk-Anfragen abfangen musst ().

Scrapy: Skalierbares Python Web-Scraping-Framework

Was ist das?

ist ein vollwertiges Web-Scraping-Framework. Es ist für großflächiges Crawling gebaut, mit eingebauter Parallelisierung, Pipelines und Exportoptionen. Wer tausende Seiten scrapen will, ist hier richtig.

So läuft’s:

Spider definieren:

1import scrapy

2class QuotesSpider(scrapy.Spider):

3 name = "quotes"

4 start_urls = ["<http://quotes.toscrape.com>"]

5 def parse(self, response):

6 for quote in response.css("div.quote"):

7 yield {

8 'text': quote.css("span.text::text").get(),

9 'author': quote.css("small.author::text").get()

10 }Mit scrapy crawl quotes im Scrapy-Projekt ausführen.

Vorteile:

- Hohe Performance, eingebaute Parallelisierung

- Strukturierte Projektarchitektur (Spiders, Pipelines, Middlewares)

- Einfacher Export nach CSV, JSON, Datenbanken

- Große Community, viele Plugins

Nachteile:

- Steile Lernkurve für Einsteiger

- Projekt-Setup nötig (nicht ideal für schnelle Einmal-Jobs)

- JavaScript-Support begrenzt (Add-ons nötig)

Ideal für:

Großflächige, wiederkehrende Crawls – z.B. Immobilienangebote von mehreren Seiten oder komplette Produktkataloge ().

Urllib3: Zuverlässige HTTP-Bibliothek für Python Web Scraping

Was ist das?

ist ein Low-Level-HTTP-Client, der z.B. Requests antreibt. Wer maximale Kontrolle über Verbindungen, Wiederholungen oder Pooling braucht, ist hier richtig.

So läuft’s:

Seite abrufen:

1import urllib3

2http = urllib3.PoolManager()

3resp = http.request("GET", "<http://httpbin.org/html>")

4if resp.status == 200:

5 html_text = resp.data.decode('utf-8')

6 print(html_text[:100])Vorteile:

- Schnelles, effizientes Connection-Pooling

- Thread-sicher, ideal für paralleles Scraping

- Feine Kontrolle über HTTP-Verhalten

Nachteile:

- Mehr Handarbeit als bei Requests

- Kein HTML-Parsing, kein JavaScript

- Weniger Einsteiger-Dokus

Ideal für:

Individuelle HTTP-Szenarien, hochparalleles Scraping oder wenn maximale Performance gefragt ist ().

HTTPX: Moderne, asynchrone Python Web-Scraping-Bibliothek

Was ist das?

ist der nächste Schritt unter den HTTP-Clients für Python. Ähnlich wie Requests, aber mit Async-Support und HTTP/2 von Haus aus. Wer tausende Seiten parallel scrapen will, ist hier richtig.

So läuft’s:

Synchron:

1import httpx

2response = httpx.get("<https://httpbin.org/get>")

3if response.status_code == 200:

4 data = response.json()

5 print(data)Asynchron:

1import httpx, asyncio

2urls = ["<https://example.com/page1>", "<https://example.com/page2>"]

3async def fetch(url, client):

4 resp = await client.get(url)

5 return resp.status_code

6async def scrape_all(urls):

7 async with httpx.AsyncClient(http2=True) as client:

8 tasks = [fetch(u, client) for u in urls]

9 results = await asyncio.gather(*tasks)

10 print(results)

11asyncio.run(scrape_all(urls))Vorteile:

- Async-Support für hochparalleles Scraping

- HTTP/2-Unterstützung (schneller für viele Seiten)

- Requests-ähnliche API (leichter Umstieg)

- Verbesserte Fehlerbehandlung

Nachteile:

- Noch relativ neu, weniger Tutorials als Requests

- Async erfordert Verständnis von Event-Loops

- Kein eingebautes HTML-Parsing

Ideal für:

High-Throughput-Scraping, APIs oder wenn viele Seiten schnell verarbeitet werden sollen ().

lxml: Schnelles und leistungsstarkes HTML/XML-Parsing für Python Web Scraping

Was ist das?

ist eine Hochleistungsbibliothek zum Parsen von HTML und XML, mit Unterstützung für XPath und CSS-Selektoren. Sie ist das Herzstück vieler anderer Tools (z.B. Scrapy-Selektoren).

So läuft’s:

Zitate und Autoren extrahieren:

1import requests

2from lxml import html

3page = requests.get("<http://quotes.toscrape.com>").content

4tree = html.fromstring(page)

5quotes = tree.xpath('//div[@class="quote"]/span[@class="text"]/text()')

6authors = tree.xpath('//div[@class="quote"]/small[@class="author"]/text()')

7print(list(zip(quotes, authors)))Vorteile:

- Extrem schnell, auch bei großen Dokumenten

- Mächtige XPath-Unterstützung für komplexe Abfragen

- Speicherfreundlich

Nachteile:

- Lernkurve bei XPath-Syntax

- Weniger einsteigerfreundliche Doku als BS4

- Installation kann auf manchen Systemen knifflig sein

Ideal für:

Parsing großer oder komplexer HTML/XML-Dokumente oder wenn fortgeschrittene Abfragen nötig sind ().

Pydantic: Datenvalidierung für saubere Python Web-Scraping-Ergebnisse

Was ist das?

ist kein Scraper, sondern eine Bibliothek für Datenvalidierung und -modellierung. Nach dem Scraping sorgt Pydantic dafür, dass deine Daten sauber, typisiert und bereit für die Weiterverarbeitung sind.

So läuft’s:

Gescrapte Daten validieren:

1from pydantic import BaseModel, validator

2from datetime import date

3class ProductItem(BaseModel):

4 name: str

5 price: float

6 listed_date: date

7 @validator('price')

8 def price_must_be_positive(cls, v):

9 if v <= 0:

10 raise ValueError('price must be positive')

11 return v

12raw_data = {"name": "Widget", "price": "19.99", "listed_date": "2025-02-15"}

13item = ProductItem(**raw_data)

14print(item.price, type(item.price))

15print(item.listed_date, type(item.listed_date))Vorteile:

- Strenge Validierung (Fehler werden früh erkannt)

- Automatische Typumwandlung (Strings zu Zahlen, Daten etc.)

- Deklarative Datenmodelle (übersichtlicher, wartbarer Code)

- Unterstützt komplexe, verschachtelte Daten

Nachteile:

- Lernkurve bei der Modellsyntax

- Etwas Overhead im Datenprozess

Ideal für:

Sicherstellen, dass gescrapte Daten sauber, konsistent und bereit für Analyse oder Import sind ().

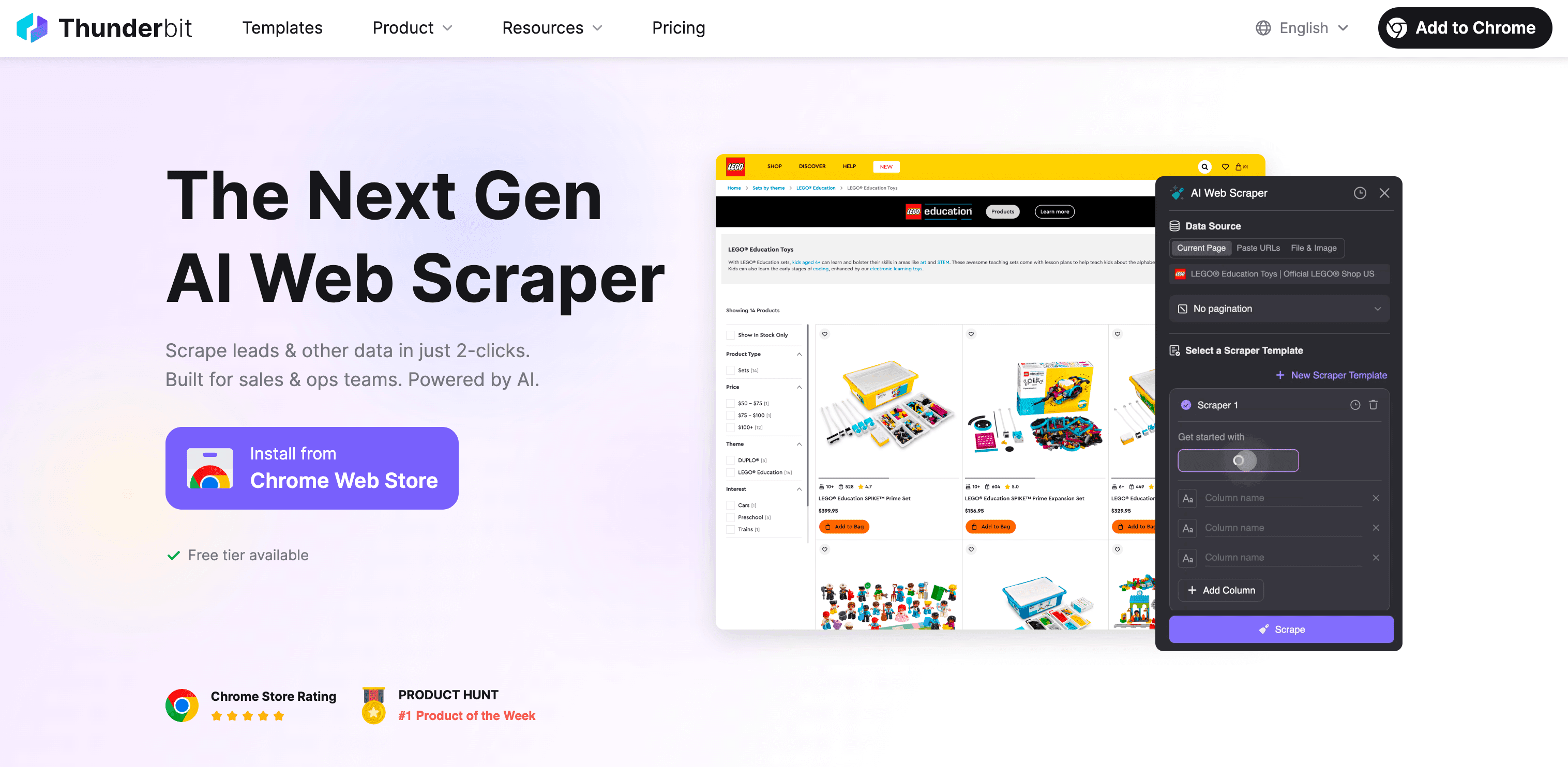

No-Code-Alternative: Thunderbit KI-Web-Scraper für Business-Anwender

Mal ehrlich: Wenn du bis hier gelesen hast und denkst „Python ist cool, aber XPath am Wochenende lernen? Lieber nicht!“, bist du nicht allein. Genau deshalb haben wir entwickelt.

Was ist Thunderbit?

Thunderbit ist eine KI-gestützte, No-Code Web-Scraper Chrome-Erweiterung. Entwickelt für Business-Anwender – Vertrieb, E-Commerce, Marketing, Immobilien – die Webdaten brauchen, aber keine Lust auf Code, Proxies oder Anti-Bot-Probleme haben.

Warum Thunderbit für Nicht-Programmierer besser ist als Python-Bibliotheken:

- Kein Programmieren nötig: Einfach auf „KI-Felder vorschlagen“ klicken, Thunderbits KI liest die Seite und mit „Scrapen“ starten. Du kannst jede Website, PDF oder jedes Bild in zwei Klicks auslesen.

- Verarbeitet dynamische Inhalte: Da Thunderbit im Browser (oder in der Cloud) läuft, werden auch JavaScript-Seiten, Infinite Scrolls oder Inhalte hinter Logins problemlos erfasst.

- Unterseiten-Scraping: Du willst Details von allen Produkt- oder Profilseiten? Thunderbit besucht automatisch jede Unterseite und ergänzt deine Tabelle.

- KI-gestützte Datenstrukturierung: Thunderbit schlägt Feldnamen, Datentypen und sogar individuelle Prompts vor. Du kannst Daten direkt benennen, formatieren, übersetzen und organisieren.

- Anti-Bot-Resistenz: Keine Proxy-Einrichtung oder Angst vor Sperren – Thunderbit nutzt echte Browsersitzungen und KI, um die meisten Anti-Scraping-Hürden zu umgehen.

- Export überallhin: Exportiere deine Daten nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON – kostenlos und unbegrenzt.

- Vorlagen für beliebte Seiten: Für Amazon, Zillow, Instagram, Shopify & Co. gibt es fertige Templates – einfach auswählen und loslegen.

- Kostenlose Features: E-Mail-, Telefon- und Bild-Extraktoren sind komplett gratis. Ebenso das KI-Autofill für Online-Formulare.

Wie schneidet Thunderbit im Vergleich zu Python-Bibliotheken ab?

| Funktion | Python-Bibliotheken | Thunderbit |

|---|---|---|

| Programmierkenntnisse nötig | Ja | Nein |

| Dynamische Inhalte | Teilweise (Browser-Tools) | Ja (Browser/Cloud) |

| Anti-Bot-Handling | Manuell (Proxies, Header) | Integriert (Browsersitzung, KI) |

| Datenstrukturierung | Manuell (Code, Parsing) | KI-gestützt, automatisch |

| Unterseiten-Scraping | Individueller Code | 1-Klick |

| Exportoptionen | CSV/JSON (Code) | Excel, Google Sheets, Airtable, Notion etc. |

| Vorlagen | DIY oder Community | Integriert für beliebte Seiten |

| Wartung | Sie (Skripte aktualisieren) | Thunderbit-Team übernimmt Updates |

Für wen ist Thunderbit gedacht?

Ob Vertrieb, E-Commerce, Marketing oder Immobilien: Wer Webdaten – Leads, Preise, Produktinfos, Immobilienangebote – braucht, aber keine technische Ausbildung hat, ist mit Thunderbit bestens bedient. So kommst du blitzschnell von „Ich brauche diese Daten“ zu „Hier ist die Tabelle“ – ganz ohne Python.

Du willst Thunderbit live ausprobieren? und teste kostenlos. Oder stöbere im für weitere Tipps.

Fazit: Die richtige Python Web-Scraping-Bibliothek (oder No-Code-Tool) wählen

Kurz und knapp: Python Web-Scraping-Bibliotheken sind mächtig, flexibel und meistern fast jedes Szenario – vorausgesetzt, du bist mit Code vertraut und investierst Zeit. Hier ein schneller Überblick:

- ZenRows: Ideal für großflächiges Scraping geschützter Seiten mit eingebauten Anti-Bot-Features.

- Selenium & Playwright: Perfekt für dynamische, interaktive Seiten, aber ressourcenintensiver und komplexer.

- Requests & HTTPX: Optimal für statische Seiten und APIs; HTTPX glänzt bei asynchronem, schnellem Scraping.

- Beautiful Soup & lxml: Die Klassiker fürs HTML-Parsing – BS4 für Einsteiger, lxml für Geschwindigkeit und Power.

- Scrapy: Das Framework für große, strukturierte Crawls.

- urllib3: Für individuelle, hochparallele HTTP-Anwendungen.

- Pydantic: Sorgt für saubere, business-taugliche Daten.

Aber: Wenn du nicht programmieren willst – oder einfach schnell Ergebnisse brauchst – ist dein Shortcut. Kein Code, keine Wartung, einfach Resultate.

Mein Tipp:

- Wer Python liebt und volle Kontrolle will, wählt die passende Bibliothek für den eigenen Use Case und Kenntnisstand.

- Wer einfach nur Daten braucht (und vielleicht mehr Schlaf), lässt Thunderbits KI die Arbeit machen.

So oder so: Das Web ist voller Daten, die nur darauf warten, in Erkenntnisse verwandelt zu werden. Egal ob Python-Profi oder Business-Anwender ohne Programmiererfahrung – 2025 gibt es für jeden das passende Tool. Und falls du mal über Scraping, Automatisierung oder die besten Pizzabeläge für CEOs plaudern willst – du weißt, wo du mich findest.

Viel Spaß beim Scrapen!

FAQs

1. Welche Python-Bibliotheken sind am beliebtesten fürs Web Scraping?

Zu den beliebtesten Python-Bibliotheken fürs Web Scraping zählen Requests für statische Seiten, Selenium für dynamische Seiten mit JavaScript und Scrapy für großflächige Crawls. Die Wahl hängt meist von der Komplexität der Daten, dem Bedarf an Parallelisierung und der Dynamik der Inhalte ab.

2. Wie gehe ich beim Scraping mit JavaScript-lastigen Webseiten um?

Für Seiten mit viel JavaScript sind Selenium und Playwright besonders geeignet. Sie simulieren echte Browseraktionen und laden dynamische Inhalte wie ein Nutzer. ZenRows ist eine weitere Option, die per API JavaScript-Inhalte verarbeitet und Anti-Bot-Maßnahmen automatisch umgeht.

3. Wie unterstützt Thunderbit mein Unternehmen beim Web Scraping?

Thunderbit ist ein No-Code KI-Web-Scraper, mit dem Business-Anwender Webdaten ohne Programmierung sammeln können. Egal ob Konkurrenzpreise, Leadgenerierung oder Produktdaten – Thunderbit macht Scraping einfach, automatisiert mit KI, verarbeitet dynamische Inhalte, umgeht Anti-Bot-Sperren und bietet Exportoptionen in nur zwei Klicks.

Mehr erfahren: