Wer schon mal stundenlang Daten per Copy & Paste in eine Tabelle geschoben hat – egal ob für Preisvergleiche oder um mal eben eine Lead-Liste zu bauen – weiß, wie nervig das werden kann. Laut verbringen über 40 % der Angestellten mindestens ein Viertel ihrer Arbeitszeit mit immer gleichen Datentätigkeiten. Das sind schnell Hunderte Stunden pro Monat und Team – pure Zeitverschwendung. Die gute Nachricht: No-Code-Web-Scraper beenden das Daten-Hamsterrad und machen es jedem möglich – auch ohne Programmierkenntnisse – Webdaten in wenigen Minuten automatisch zu erfassen.

Ich entwickle seit Jahren SaaS- und Automatisierungstools und habe gesehen, wie diese Plattformen Vertriebs-, Marketing- und Operationsteams empowern, ohne auf IT-Support warten zu müssen. Der Markt für Web Scraping boomt (bis 2025 werden erwartet) – und No-Code-Lösungen sind ganz vorne dabei. Egal ob Solo-Gründer, datengetriebener Marketer oder einfach genervt vom Tabellen-Marathon: Mit dieser Liste findest du garantiert den passenden No-Code-Web-Scraper für deinen Workflow.

Warum No-Code-Web-Scraper für moderne Teams ein Muss sind

Mal ehrlich: Manuelle Datenerfassung killt jede Produktivität. Im Schnitt macht ein Büroangestellter – bei einem 10er-Team sind das mehr als 400 Stunden im Monat, die einfach weg sind. No-Code-Web-Scraper lösen das Problem, indem sie:

- Zeit sparen: Aus stundenlanger Handarbeit werden ein paar Minuten.

- IT-Engpässe umgehen: Kein Warten mehr auf Entwickler oder individuelle Skripte.

- Flexibilität steigern: Vertrieb sammelt Leads, Marketing beobachtet Wettbewerber, Operations trackt Produktdaten – alles ohne Technik-Hürden.

- Genauigkeit erhöhen: Automatisierung reduziert Fehler und sorgt für saubere Daten.

Das macht sich auch messbar bemerkbar: sparen kleine Unternehmen durch Automatisierung täglich rund 96 Minuten. Und wer auf Low-/No-Code-Tools setzt, berichtet von bis zu .

So haben wir die besten No-Code-Web-Scraper ausgewählt

Die Auswahl ist riesig – und nicht jedes Tool hält, was es verspricht. So habe ich die Top 9 ausgewählt:

- Benutzerfreundlichkeit: Kann auch jemand ohne Technik-Background direkt loslegen? Intuitive Oberflächen, Point-and-Click-Auswahl und KI-Support waren entscheidend.

- Automatisierung & Intelligenz: Automatische Felderkennung, Navigation auf Unterseiten, Zeitplanung und Cloud-Ausführung.

- Skalierbarkeit: Von kleinen Einzelaufgaben bis zu großen, wiederkehrenden Projekten geeignet.

- Datenexport & Integration: Export zu Excel, Google Sheets, JSON oder direkte API-Anbindung.

- Support & Community: Vorlagen, Dokus und schneller Support bei Problemen.

- Preis & Zugänglichkeit: Kostenlose Testversionen, transparente Preise und Optionen für Einzelpersonen und Teams.

Hier kommen die neun besten No-Code-Web-Scraper für 2025 – mit ihren jeweiligen Stärken, Besonderheiten und Einsatzgebieten.

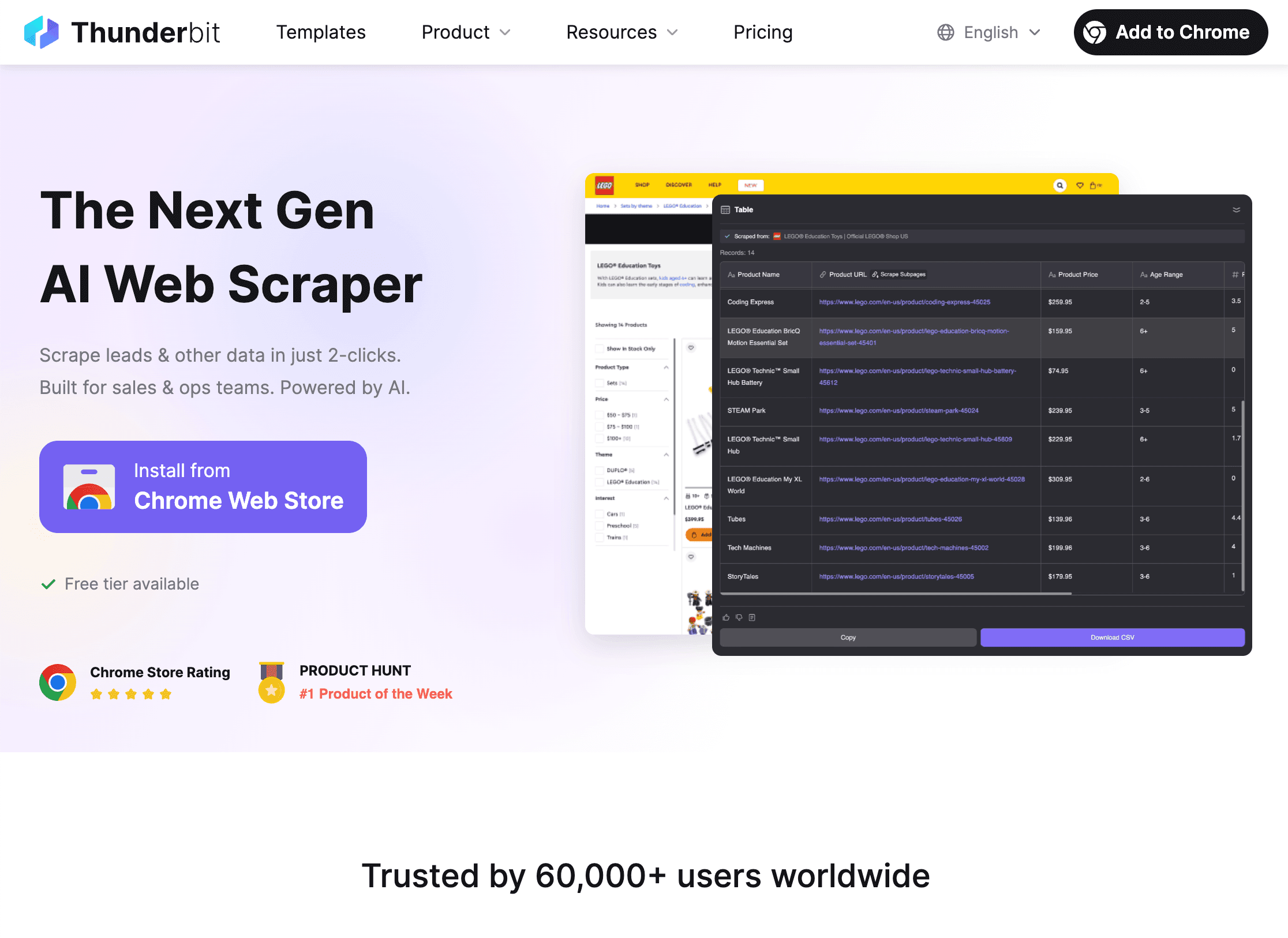

1. Thunderbit

ist meine absolute Empfehlung für alle, die mit zwei Klicks von „Ich brauch diese Daten“ zu „Hier ist meine Tabelle“ kommen wollen. Klar, als Mitgründer bin ich voreingenommen – aber unser Ziel war immer, Web Scraping so easy wie Essensbestellung zu machen.

ist meine absolute Empfehlung für alle, die mit zwei Klicks von „Ich brauch diese Daten“ zu „Hier ist meine Tabelle“ kommen wollen. Klar, als Mitgründer bin ich voreingenommen – aber unser Ziel war immer, Web Scraping so easy wie Essensbestellung zu machen.

Was macht Thunderbit besonders?

- KI-gestützte Einfachheit: Mit „KI-Felder vorschlagen“ scannt Thunderbits KI die Seite, erkennt relevante Daten (z. B. Namen, Preise, E-Mails) und erstellt den Scraper automatisch. Kein Code, kein Selector-Gefrickel.

- 2-Klick-Scraping: Vorschläge annehmen, auf „Scrapen“ klicken – fertig. Schneller kommst du nicht von der Website zu strukturierten Daten.

- Automatisierte Unterseiten & Paginierung: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z. B. Produkt- oder Profilseiten) und ergänzt die Tabelle – perfekt für Leads oder Produktspezifikationen.

- Cloud- & Browser-Scraping: Scrapes direkt im Browser (ideal für eingeloggte Seiten) oder in der Cloud (bis zu 50 Seiten gleichzeitig, richtig schnell).

- Kostenloser Datenexport: Exportiere zu Excel, Google Sheets, Airtable, Notion oder als CSV/JSON – ohne Bezahlschranke für deine eigenen Daten.

- KI-Autofill: Webformulare automatisch mit KI ausfüllen – komplett gratis.

- Zeitplanung: Wiederkehrende Scrapes in natürlicher Sprache planen („jeden Montag um 9 Uhr“) und den Agenten automatisch laufen lassen.

Thunderbit wird von genutzt – von Vertriebsteams über Makler bis zu kleinen Online-Shops. Die kostenlose Version erlaubt 6–10 Seiten zum Testen, bezahlte Pläne starten ab 15 $/Monat (guthabenbasiert, du zahlst nur, was du nutzt).

Du willst sehen, wie einfach Web Scraping sein kann? und probier’s aus.

2. Parsehub

ist ein alter Hase unter den No-Code-Scrapern und bekannt für seinen visuellen Workflow-Builder sowie die Fähigkeit, auch komplexe und dynamische Websites zu verarbeiten.

ist ein alter Hase unter den No-Code-Scrapern und bekannt für seinen visuellen Workflow-Builder sowie die Fähigkeit, auch komplexe und dynamische Websites zu verarbeiten.

- Visueller Workflow: Scraper werden durch Klicks im Live-Browser erstellt – Parsehub zeichnet die Aktionen auf und erstellt ein Schritt-für-Schritt-Rezept.

- Dynamische Inhalte meistern: Ideal für Seiten mit JavaScript, Pop-ups oder schwieriger Navigation (z. B. E-Commerce, Jobbörsen, Immobilien).

- Bedingte Logik & Schleifen: Mehrstufige Workflows, Logins und Paginierung problemlos umsetzbar.

- Cloud-Ausführung & Zeitplanung: Jobs laufen auf Parsehubs Servern, wiederkehrende Aufgaben können geplant werden (in den kostenpflichtigen Plänen).

- API-Integration: Daten können programmatisch für fortgeschrittene Workflows abgerufen werden.

Parsehub ist besonders für Analysten oder Forscher geeignet, die viel Kontrolle ohne Programmierung wollen. Die Gratisversion deckt kleine Jobs (bis 200 Seiten pro Lauf) ab, kostenpflichtige Pläne starten bei 189 $/Monat für mehr Umfang und Zeitplanung. Für komplexe Projekte gibt’s eine gewisse Lernkurve, aber für anspruchsvolle Scraping-Aufgaben ist Parsehub ein echtes Kraftpaket.

3. Octoparse

steht für das Motto „Webdaten in 10 Minuten extrahieren“ – und mit Drag-and-Drop-Oberfläche sowie einer riesigen Vorlagenbibliothek klappt das auch.

steht für das Motto „Webdaten in 10 Minuten extrahieren“ – und mit Drag-and-Drop-Oberfläche sowie einer riesigen Vorlagenbibliothek klappt das auch.

- Point-and-Click-Bedienung: Einfach Elemente auf der Seite anklicken, Octoparse erkennt Listen, Tabellen und Weiter-Buttons automatisch.

- Über 100 Vorlagen: Vorgefertigte Scraper für Amazon, LinkedIn, Twitter, Zillow und mehr – einfach URL eingeben und loslegen.

- Cloud-Scraping & Zeitplanung: Mehrere Jobs parallel ausführen, wiederkehrende Aufgaben planen, IP-Rotation und Anti-Blocking inklusive.

- Datenbereinigung & Export: Daten mit Filtern aufbereiten und als CSV, Excel, JSON oder via API exportieren.

Octoparse ist besonders beliebt bei Marketern, kleinen Unternehmen und Datenfans. Die kostenlose Version eignet sich super zum Testen, kostenpflichtige Pläne starten bei 75 $/Monat (Standard) bzw. 249 $/Monat (Professional) für mehr Daten und parallele Jobs. Wer schnelle Ergebnisse mit wenig Aufwand sucht, ist hier richtig.

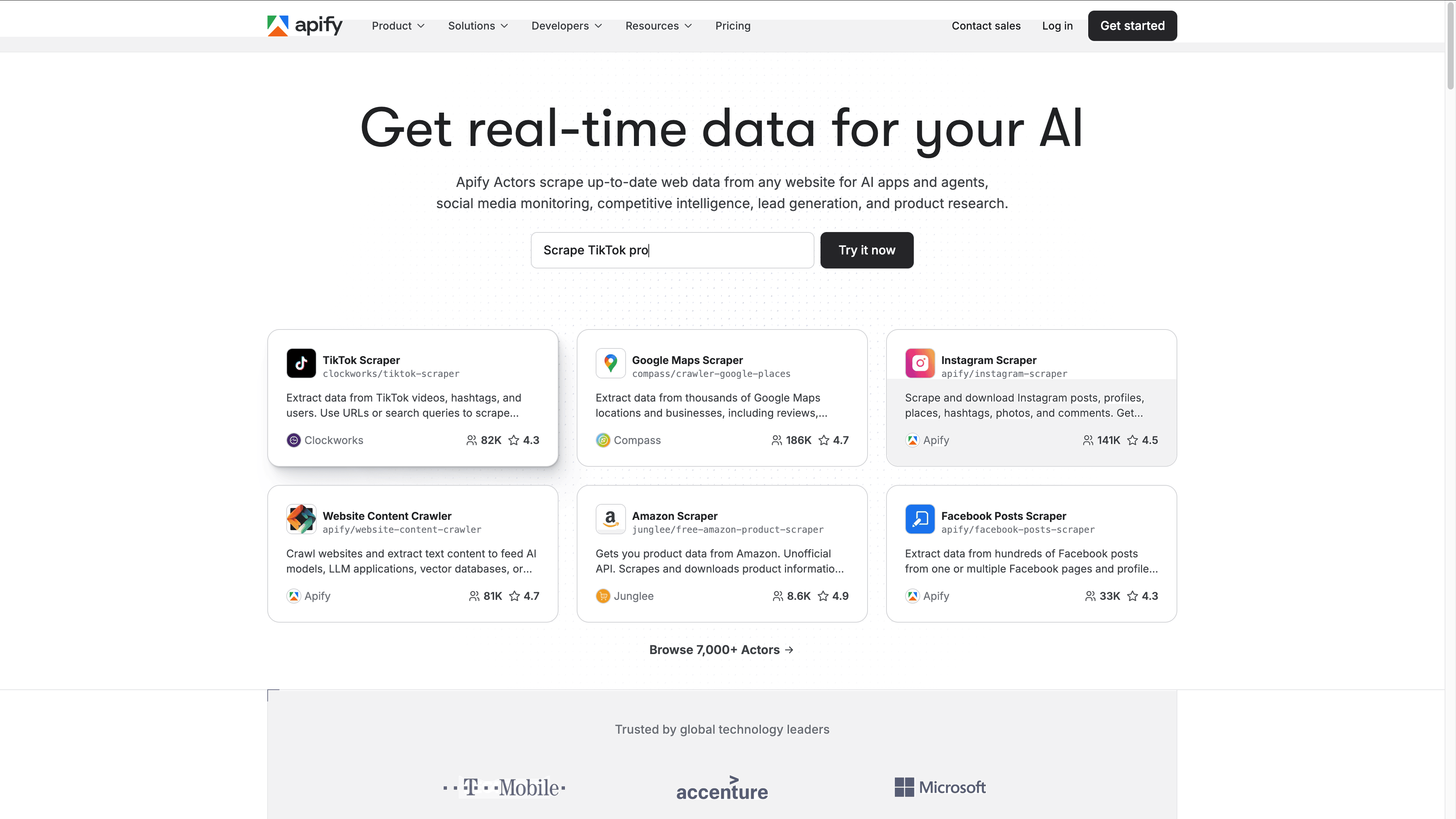

4. Apify

ist das Schweizer Taschenmesser unter den Web-Scraping-Plattformen: Cloud-basiert, mit über 5.000 fertigen „Actors“ (Scrapern) und der Möglichkeit, eigene Workflows zu bauen.

ist das Schweizer Taschenmesser unter den Web-Scraping-Plattformen: Cloud-basiert, mit über 5.000 fertigen „Actors“ (Scrapern) und der Möglichkeit, eigene Workflows zu bauen.

- Actor-Marktplatz: Scraper für Google Maps, Amazon, Social Media und Nischenseiten – einfach Parameter eingeben und starten.

- Individuelle Workflows: Scraper visuell oder (für Fortgeschrittene) mit Code erstellen, mehrstufige Prozesse automatisieren.

- Cloud-Infrastruktur: Jobs in großem Umfang ausführen, mit Proxy-Rotation, Anti-Blocking und Zeitplanung.

- Teamarbeit: Projekte teilen, Zugriffsrechte verwalten, Ausführungen mit Logs und Dashboards überwachen.

- API & Integration: Export zu JSON, CSV oder Anbindung an Datenbanken, BI-Tools oder Apps via Webhooks.

Apify ist ideal für Datenteams, Entwickler und alle, die skalierbares, kollaboratives Scraping brauchen. Es gibt ein kostenloses Kontingent (Credits pro Monat), bezahlte Pläne starten bei 49 $/Monat und skalieren für Enterprise-Anforderungen.

5. Import.io

ist die Enterprise-Lösung für No-Code-Webdatenpipelines.

ist die Enterprise-Lösung für No-Code-Webdatenpipelines.

- Visueller Point-and-Click-Extractor: Der Scraper wird durch Beispiele trainiert – einfach Elemente anklicken, Import.io erkennt die Muster.

- Strukturiertes Crawling & Zeitplanung: Ganze Websites crawlen, Paginierung meistern und automatisierte Datenfeeds einrichten.

- Datenaufbereitung & Integration: Daten bereinigen, normalisieren und direkt an BI-Tools, Datenbanken oder via API exportieren.

- Compliance & Support: Audit-Trails, dedizierter Support und Funktionen für rechtliche Anforderungen – wichtig für große Unternehmen.

Import.io richtet sich an Unternehmen und große Datenteams mit hohen Anforderungen. Die Preise sind individuell (ab ca. 300–400 $/Monat), dafür gibt’s umfassenden Support und starke Automatisierung. Eine kostenlose Testphase ist verfügbar.

6. Data Miner

ist eine Browser-Erweiterung (Chrome/Edge), mit der du Daten per Klick schnell und ohne Code extrahieren kannst.

ist eine Browser-Erweiterung (Chrome/Edge), mit der du Daten per Klick schnell und ohne Code extrahieren kannst.

- Automatische Tabellen- & Listenerkennung: Erkennt und extrahiert Tabellen oder Listen von jeder Webseite.

- Über 60.000 Vorlagen: Ein-Klick-Scraper für viele bekannte Seiten – einfach suchen und anwenden.

- Paginierung & Crawl-Sequenzen: „Weiter“-Buttons folgen, mehrere Seiten scrapen oder eine URL-Liste abarbeiten.

- Export zu CSV, Excel oder Google Sheets: Daten direkt herunterladen oder in die bevorzugte Tabelle übertragen.

Data Miner ist besonders bei Vertriebsmitarbeitern, Recruitern und Forschern beliebt, die schnell und unkompliziert Daten brauchen. Die Gratisversion deckt 500 Seiten/Monat ab, kostenpflichtige Pläne starten bei 19,99 $/Monat für mehr Funktionen und höhere Limits.

7. Dexi.io

(früher CloudScrape) ist eine Cloud-Plattform für komplexe, automatisierte Scraping-Workflows – komplett ohne Programmierung.

(früher CloudScrape) ist eine Cloud-Plattform für komplexe, automatisierte Scraping-Workflows – komplett ohne Programmierung.

- Visueller Robot-Designer: Mehrstufige Scraping-Prozesse mit bedingter Logik, Schleifen und Datenumwandlung gestalten.

- Cloud-Ausführung & Zeitplanung: Roboter laufen in der Cloud, wiederkehrende Jobs können geplant und mit mehreren „Workern“ skaliert werden.

- Integration: Daten in Cloud-Speicher, Datenbanken oder APIs übertragen; Anbindung an Drittanbieter möglich.

- Enterprise-Features: Wird von einem Drittel der Fortune-500-Händler für kontinuierliche Datenanalyse, Monitoring und Reporting genutzt.

Dexi.io eignet sich besonders für fortgeschrittene Nutzer und Unternehmen mit laufendem, großvolumigem Scraping-Bedarf. Preise starten bei 119 $/Monat (1 Worker), höhere Stufen für mehr Parallelität.

8. Web Scraper

ist eine kostenlose, quelloffene Browser-Erweiterung (Chrome/Firefox) – ideal für Einsteiger und kleine Projekte.

ist eine kostenlose, quelloffene Browser-Erweiterung (Chrome/Firefox) – ideal für Einsteiger und kleine Projekte.

- Sitemap-basiertes Scraping: Navigation und Extraktionsregeln durch Klicks definieren – perfekt für strukturierte Seiten.

- Paginierung & mehrstufiges Crawling: Listen scrapen, Links folgen und Details von Unterseiten extrahieren.

- Datenexport: Ergebnisse als CSV oder JSON herunterladen.

- Cloud-Service (optional): Größere Jobs, geplante Scrapes und API-Zugriff (ab ca. 50 $/Monat).

Web Scraper ist ideal für Studierende, Hobbyisten und alle, die Web Scraping kostenlos ausprobieren möchten.

9. ScraperAPI

geht einen anderen Weg: Ein API-zentrierter Service, der Proxies, CAPTCHAs und Headless-Browser automatisch regelt.

geht einen anderen Weg: Ein API-zentrierter Service, der Proxies, CAPTCHAs und Headless-Browser automatisch regelt.

- No-Code DataPipeline: Scraping-Jobs einrichten, Zeitpläne festlegen und Daten über ein Dashboard verwalten – ganz ohne Programmierung.

- Automatische Proxy- & Anti-Bot-Lösungen: Auch stark geschützte Seiten lassen sich in großem Umfang auslesen.

- Strukturierte Daten-Endpunkte: Für viele bekannte Seiten (Amazon, Google, Walmart etc.) gibt’s direkt geparste JSON-Daten.

- Hohe Skalierbarkeit: Millionen Anfragen pro Monat, schnelle parallele Verarbeitung.

ScraperAPI ist ideal für Entwickler, Datenteams und alle, die zuverlässiges, großvolumiges Scraping brauchen. Preise starten bei 49 $/Monat für 250.000 Anfragen, höhere Stufen für größere Projekte.

Vergleichstabelle: No-Code-Web-Scraper

| Tool | Hauptfunktionen | Ideal für | Kostenlose Version | Bezahlpläne (ab) |

|---|---|---|---|---|

| Thunderbit | KI-2-Klick-Scraping, Unterseiten, Export zu Sheets | Vertrieb, Operations, Einsteiger | Ja (6–10 Seiten) | 15 $/Monat (guthabenbasiert) |

| Parsehub | Visueller Workflow, dynamische Seiten, Cloud-Planung | Analysten, Forscher, komplexe Fälle | Ja (200 Seiten) | 189 $/Monat (Standard) |

| Octoparse | Drag-and-Drop, 100+ Vorlagen, Cloud, Zeitplanung | Marketing, KMU, schnelle Automatisierung | Ja (begrenzt) | 75 $/Monat (Standard) |

| Apify | Cloud, 5.000+ Actors, Teamarbeit, API | Datenteams, Entwickler, Skalierung | Ja (Credits) | 49 $/Monat (guthabenbasiert) |

| Import.io | Visueller Extractor, Compliance, BI-Integration | Unternehmen, große Datenteams | Kostenlose Testphase | Individuell (ab 300–400 $/Monat) |

| Data Miner | Browser-Erweiterung, 60k+ Vorlagen, Google Sheets | Vertrieb, Recruiting, schnelle Aufgaben | Ja (500 Seiten) | 19,99 $/Monat (Solo) |

| Dexi.io | Visueller Robot-Designer, Cloud, Workflow-Automation | Unternehmen, Monitoring | Kostenlose Testphase | 119 $/Monat (1 Worker) |

| Web Scraper | Kostenlose Erweiterung, Sitemap-basiert, CSV-Export | Einsteiger, Studierende, kleine Jobs | Ja (unbegrenzt) | 50 $/Monat (Cloud, optional) |

| ScraperAPI | API, Anti-Bot, DataPipeline, JSON-Endpunkte | Entwickler, Datenteams, große Mengen | Kostenlose Testphase | 49 $/Monat (250k Anfragen) |

Wie finde ich den passenden No-Code-Web-Scraper?

Hier ein kleiner Guide für verschiedene Anwendungsfälle:

- Neu beim Scraping und schnelle Ergebnisse gewünscht? für KI-gestützte Einrichtung oder für Vorlagen und Tutorials ausprobieren.

- Komplexe, dynamische Seiten scrapen? und meistern schwierige Navigation und mehrstufige Workflows.

- Wiederkehrende, großvolumige Projekte? , oder bieten Cloud-Ausführung, Zeitplanung und Integration.

- Schnelle Einmal-Extraktionen? oder sind ideal, um Tabellen oder Listen direkt im Browser zu erfassen.

- Enterprise-Anforderungen, Compliance & Support? und bieten Premium-Service und umfassende Automatisierung.

Starte am besten immer mit einer kostenlosen Testversion – prüfe deinen Anwendungsfall, die Datenqualität und ob die Bedienung für dich passt. Das beste Tool ist das, das dein Team wirklich nutzt.

Fazit: Mehrwert für Unternehmen durch No-Code-Web-Scraper

No-Code-Web-Scraper sind mehr als nur eine Abkürzung – sie sind ein echter Produktivitäts-Booster für alle, die Webdaten für Entscheidungen brauchen. Mit Tools wie , und automatisierst du Routineaufgaben, reduzierst Fehler und kannst dich auf das Wesentliche konzentrieren: Analyse, Strategie und Wachstum.

Die Vorteile liegen auf der Hand: Zeitersparnis, mehr Produktivität und die Freiheit, jederzeit an die Daten zu kommen, die du brauchst. Egal ob Lead-Listen, Wettbewerbsbeobachtung oder das nächste große Projekt – es gibt garantiert einen passenden No-Code-Web-Scraper für dich.

Bereit, das Copy-Paste-Karussell hinter dir zu lassen? oder probiere ein paar Tools aus dieser Liste. Für mehr Tipps und Deep Dives schau im vorbei.

Häufige Fragen (FAQ)

1. Was ist ein No-Code-Web-Scraper?

Ein No-Code-Web-Scraper ist ein Tool, mit dem du Daten von Websites extrahieren kannst, ohne programmieren zu müssen. Dank visueller Oberflächen, KI oder Vorlagen kann jeder die Datenerfassung automatisieren – ganz ohne Coding.

2. Wie finde ich den richtigen No-Code-Web-Scraper für mich?

Überlege dir, wie technikaffin du bist, wie komplex die Zielseiten sind, wie viel Daten du brauchst und welche Integrationen du benötigst. Starte mit einer kostenlosen Testversion und prüfe, welches Tool am besten zu deinem Workflow passt.

3. Können No-Code-Web-Scraper auch dynamische oder geschützte Seiten verarbeiten?

Viele Tools können das! , und kommen mit dynamischen Inhalten, Logins und Paginierung klar. Für besonders geschützte Seiten bietet fortschrittliche Anti-Bot-Lösungen.

4. Ist Web Scraping legal?

Web Scraping ist legal, solange du öffentlich zugängliche Daten extrahierst und die Nutzungsbedingungen der Website beachtest. Verzichte auf das Scrapen von persönlichen oder sensiblen Daten und prüfe immer die Richtlinien der jeweiligen Seite.

5. Wie kann ich Daten aus einem No-Code-Web-Scraper exportieren?

Die meisten Tools bieten Export zu CSV, Excel, Google Sheets, Airtable, Notion oder via API. und ermöglichen den direkten Export in gängige Tabellenprogramme – so kannst du deine Daten sofort weiterverwenden.

Bereit, deine Webdatenerfassung zu automatisieren? Probier einen No-Code-Web-Scraper aus dieser Liste und entdecke, wie viel Zeit du sparen kannst. Viel Erfolg beim Scrapen!

Mehr erfahren