Das Internet im Jahr 2025 ist ein echtes Bilderparadies – überall, wo du hinschaust, findest du Fotos: von Produktgalerien und Immobilienanzeigen bis hin zu Memes und Infografiken. Wer im Vertrieb, Marketing oder in der Organisation unterwegs ist, weiß: Bilder aus dem Netz zu sichern, ist längst kein „Nice-to-have“ mehr, sondern ein Muss für Recherche, Content-Produktion und Wettbewerbsanalysen. Aber mal ehrlich: Niemand hat Lust, stundenlang per Rechtsklick hunderte Bilder zu speichern – vor allem nicht, wenn der Chef den Katalog vom Konkurrenten „bis heute Abend“ auf dem Tisch haben will. (Schon erlebt – Kaffee über die Tastatur, T-Shirt ruiniert.)

Genau deshalb sind bild-scraper-Tools so gefragt wie nie zuvor. Egal ob du gerade erst anfängst oder schon ein Datenprofi bist: Es gibt mittlerweile für jeden das passende Tool, um Bilder schnell, zuverlässig und meistens ohne großen Aufwand von jeder Website zu holen. Ich habe bei viele dieser Lösungen ausprobiert und stelle dir hier die 10 besten bild-scraper-Tools für 2025 vor – mit ehrlichen Einschätzungen, für wen welches Tool am besten passt.

Warum du 2025 einen bild-scraper brauchst

Visueller Content ist viel mehr als nur Deko – er liefert wertvolle Einblicke fürs Business. Beiträge mit Bildern bekommen bis zu , und die Interaktion in sozialen Netzwerken steigt mit Bildern um . Unternehmen nutzen bild-scraping für Marktanalysen (Trends bei der Konkurrenz erkennen), Content-Produktion (Produktbilder sammeln) oder KI-Training (Modelle mit gelabelten Fotos füttern).

Aber es gibt einen Haken: Websites werden immer trickreicher. Bilder laden dynamisch, verstecken sich hinter endlosem Scrollen oder sind auf zig Unterseiten verteilt. Manuelles Herunterladen ist langsam, fehleranfällig und – ganz ehrlich – einfach nervig. Und für Teams ohne Programmierkenntnisse ist ein eigener Crawler fast schon Raketenwissenschaft.

Hier kommen moderne bild-scraper-Tools ins Spiel. Sie nehmen dir die Fleißarbeit ab, kommen auch mit komplexen Seiten klar und machen es jedem möglich – ja, sogar deinem „Ich nutze nur Excel“-Kollegen – Bilder in großem Stil zu sammeln. Der Markt für web-scraping-Software boomt und soll , über setzen bereits auf web-scraping für Business Insights. Fazit: Wer keinen bild-scraper nutzt, ist schon im Rückstand.

So haben wir die besten bild-scraper-Tools ausgewählt

Nicht jeder bild-scraper ist gleich. Das waren meine wichtigsten Kriterien für die Top 10:

- Benutzerfreundlichkeit: Kommt man auch ohne Programmierkenntnisse in wenigen Minuten ans Ziel? Tools mit natürlicher Sprache, Point-and-Click und direktem Feedback sind besonders stark.

- Exportmöglichkeiten: Kannst du Bilder oder URLs direkt nach Excel, Google Sheets, Notion oder per API exportieren? Integration ist entscheidend für effiziente Workflows.

- Anpassbarkeit & Flexibilität: Kommt das Tool mit Logins, dynamischen Inhalten oder individuellen Extraktionsregeln klar? Fortgeschrittene Nutzer brauchen mehr als nur „Speichern unter“.

- Automatisierung & Zeitplanung: Kann man Aufgaben planen und automatisiert ausführen lassen? Cloud-Scraping und geplante Extraktionen sind Gold wert für wiederkehrende Aufgaben.

- Skalierbarkeit: Schafft das Tool auch 10.000 Bilder? Es sollte sowohl kleine als auch große Projekte meistern.

- Preis-Leistungs-Verhältnis: Gibt es eine kostenlose Version? Ist der Preis für kleine Teams fair oder richtet sich das Tool eher an Großunternehmen?

Mit diesen Kriterien im Hinterkopf kommen hier die 10 besten bild-scraper-Tools für 2025 – jeweils mit ihren Stärken, Eigenheiten und idealen Einsatzbereichen.

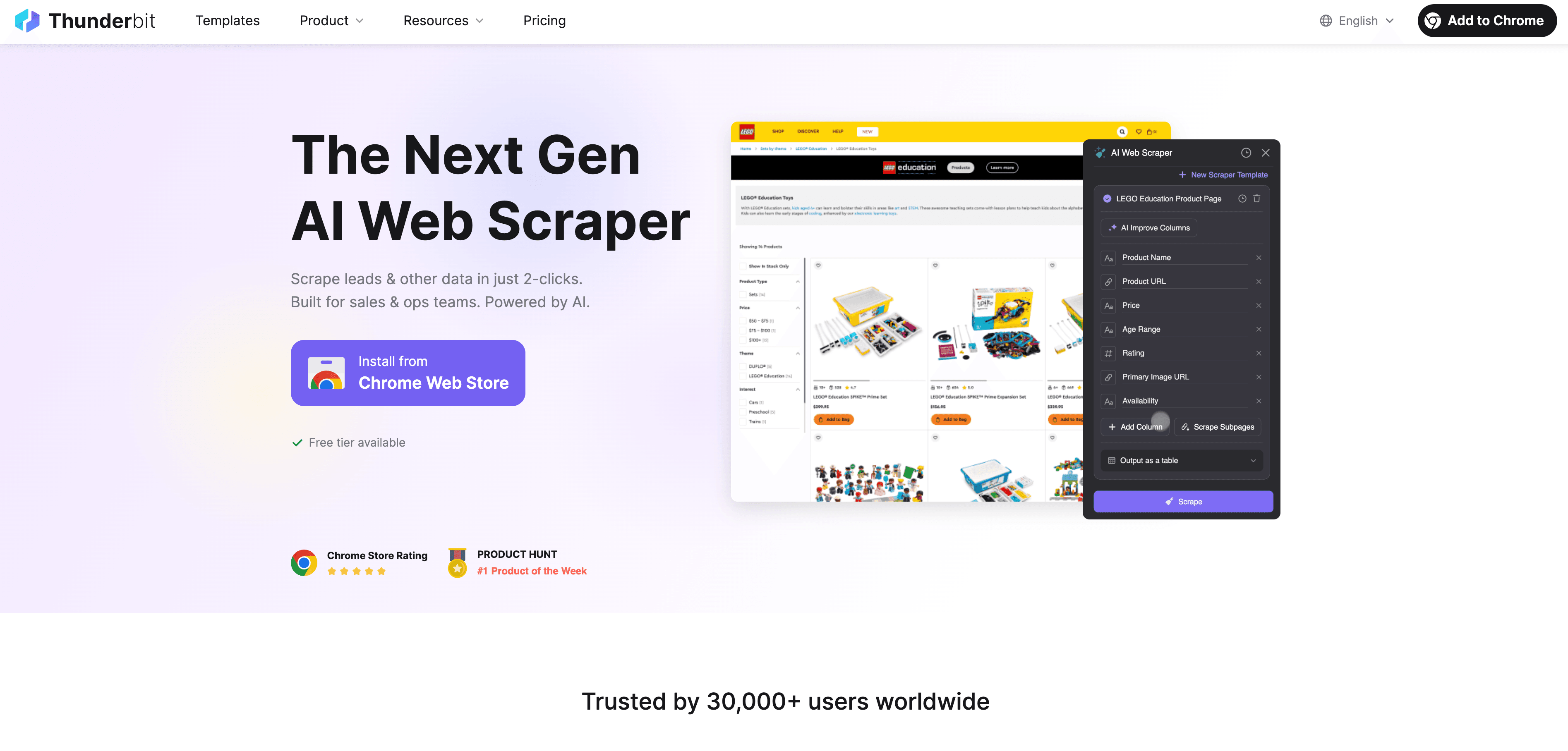

1. Thunderbit

ist meine Empfehlung für alle, die ohne Technikstress Bilder extrahieren möchten – besonders für Teams ohne Programmiererfahrung. Als Mitgründer bin ich natürlich voreingenommen, aber unser Ziel war immer: web-scraping so einfach machen, dass sogar Oma damit Wettbewerbsanalysen machen könnte (wenn sie Lust hätte).

Was Thunderbit besonders macht: Hier steht Einfachheit im Mittelpunkt. Einfach auf „KI-Felder vorschlagen“ klicken, die KI erkennt alle Bilder (und andere Daten), dann auf „Scrapen“ drücken. Thunderbit navigiert automatisch durch Unterseiten, meistert endloses Scrollen und exportiert Bilder direkt nach Excel, Google Sheets, Airtable oder Notion. Mit der kostenlosen kannst du sogar mit einem Klick alle Bilder einer Seite extrahieren – ohne Einrichtung, ohne Code.

Wichtige Funktionen:

- Bilder mit nur 2 Klicks extrahieren (KI übernimmt die Arbeit)

- Unterseiten automatisch durchsuchen (z.B. Produktdetails)

- Kostenlose Extraktoren für Bilder, E-Mails und Telefonnummern

- Sofortiger Export nach Sheets, Notion, Airtable, Excel, CSV oder JSON

- Kostenloser Tarif (6 Seiten, unbegrenzte Zeilen), Bezahlpläne ab 15 $/Monat

- Mehrsprachigkeit (34 Sprachen)

- Kein Wartungsaufwand – die KI passt sich automatisch an Webseitenänderungen an

Ideal für: Vertriebs-, Marketing- und Operationsteams, die schnell und ohne Programmierung präzise Bilddaten benötigen. Perfekt für Produktkataloge, Immobilienfotos oder Content-Sammlungen.

Mehr Details, wie Thunderbit im Vergleich abschneidet, findest du im .

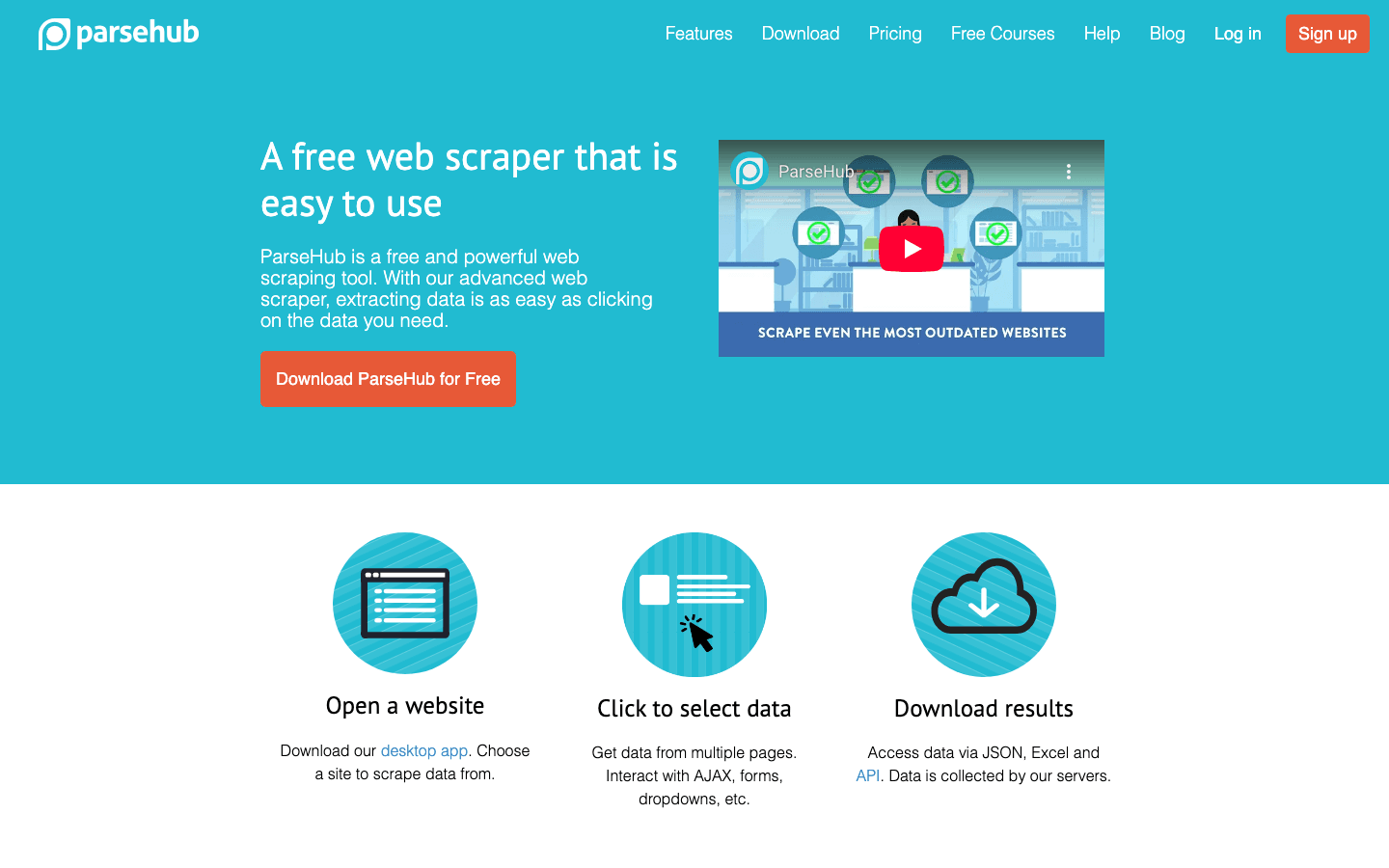

2. ParseHub

ist ein echtes Kraftpaket für alle, die Bilder von komplexen, dynamischen Websites extrahieren müssen – etwa bei endlosem Scrollen, AJAX-Galerien oder Seiten mit vielen Filtern und Pop-ups.

Warum ParseHub überzeugt: Mit dem visuellen Workflow-Editor kannst du mehrstufige Extraktionslogik ganz ohne Code zusammenklicken. Bedingungen, Schleifen und Variablen helfen, auch schwierige Seiten zu meistern. ParseHub kann mit Formularen interagieren, Buttons klicken und Bilder extrahieren, die erst nach bestimmten Aktionen erscheinen.

Wichtige Funktionen:

- Visueller Editor mit fortgeschrittener Logik (Bedingungen, Schleifen)

- Meistert JavaScript-lastige und dynamische Inhalte

- Cloud-Scraping und API-Zugriff

- Automatische IP-Rotation gegen Blockaden

- Export nach CSV, JSON und Integration mit Tableau

Ideal für: Datenanalysten, Journalisten oder Forscher, die komplexe Seiten ohne Programmierung auslesen möchten. Es gibt einen kostenlosen Tarif (bis zu 200 Seiten pro Durchlauf), für große Projekte empfiehlt sich der Cloud-Plan ab 189 $/Monat.

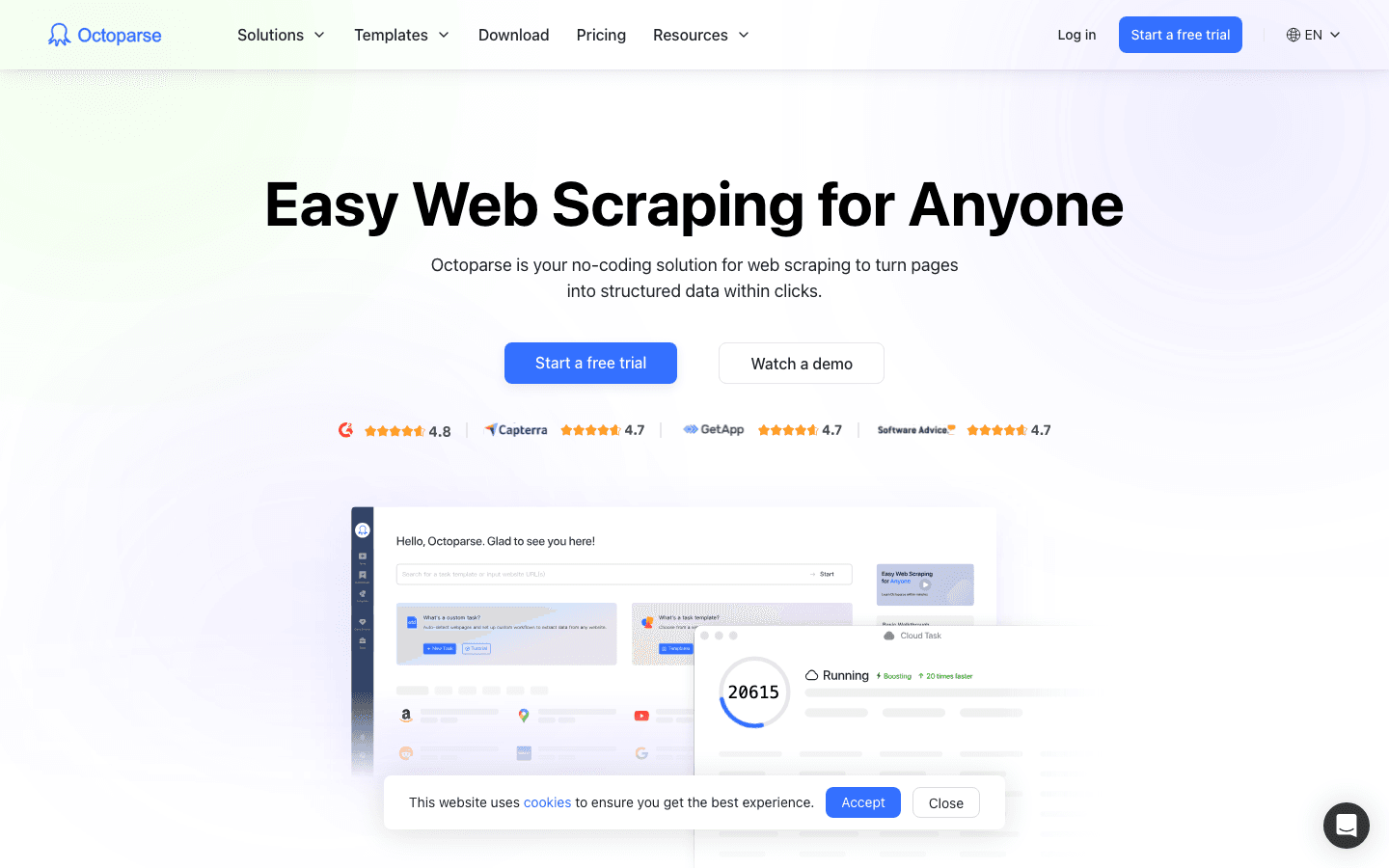

3. Octoparse

ist der No-Code-Champion für die Massenextraktion von Bildern. Die tabellenähnliche Oberfläche und die automatische Erkennung machen es besonders einsteigerfreundlich.

Warum Octoparse so beliebt ist: Einfach auf ein Bild oder eine Liste klicken, und die KI schlägt vor, was extrahiert werden soll. Besonders stark bei Paginierung, endlosem Scrollen und Login-Seiten. Cloud-Scraping und Zeitplanung gibt es in den Bezahlplänen – so laufen große Jobs, ohne den eigenen Rechner zu blockieren.

Wichtige Funktionen:

- No-Code, Point-and-Click-Bedienung

- Automatische Erkennung von Listen und Bildern

- Unterstützt Paginierung, endloses Scrollen und Logins

- Cloud-Scraping und Zeitplanung

- Export nach CSV, Excel, JSON und Datenbanken

Ideal für: Marketingteams, kleine Unternehmen oder alle, die viele Bilder schnell und ohne Programmierung extrahieren möchten. Kostenlos für kleine Aufgaben, Bezahlpläne ab 119 $/Monat.

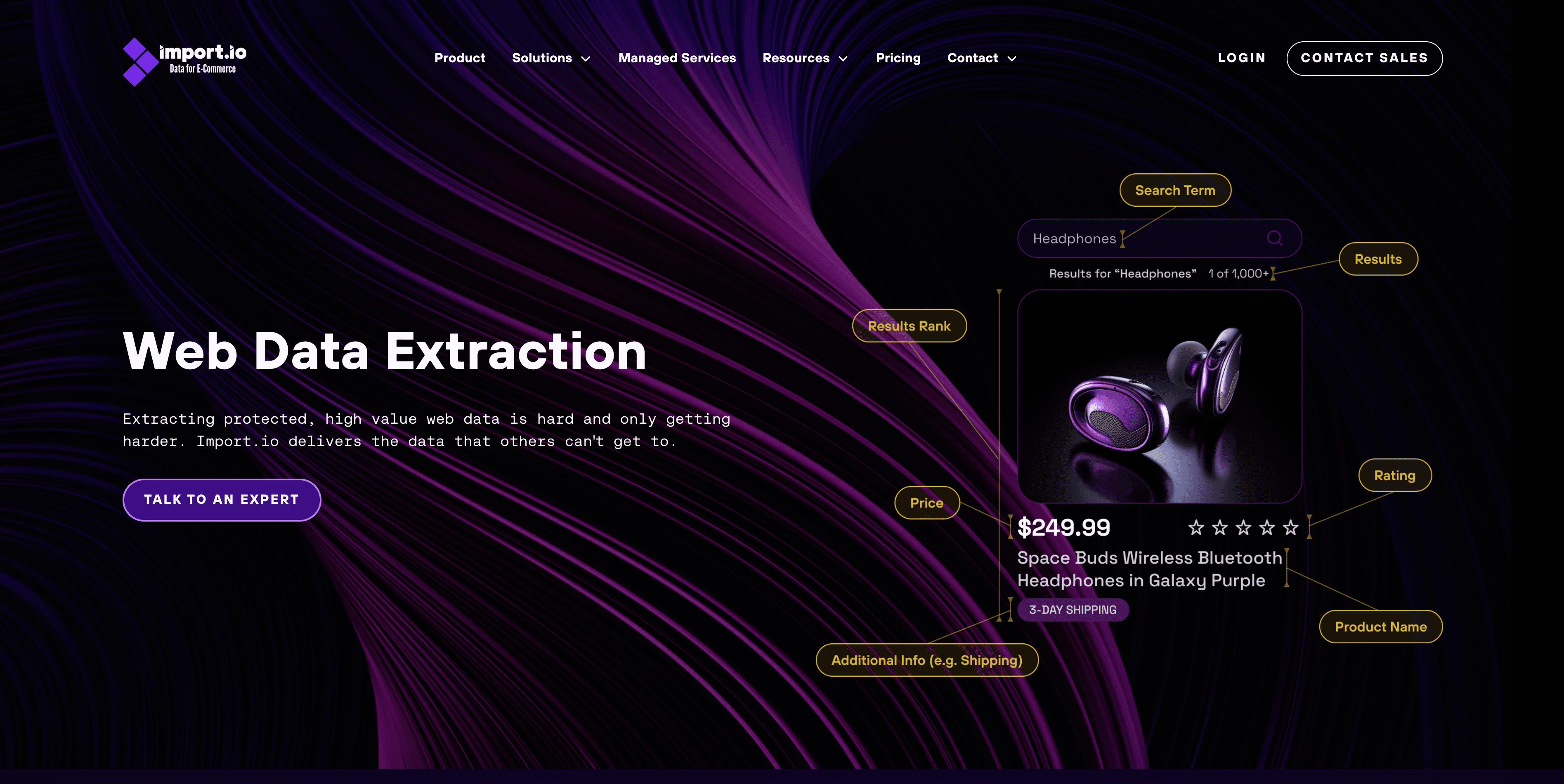

4.

ist eine professionelle Datenextraktionsplattform, die auch als leistungsstarker bild-scraper dient. Mit der interaktiven Oberfläche kannst du Workflows (z.B. Login, Filter, Galerien durchklicken) aufzeichnen und dann in der Cloud skalieren.

Was besonders macht: Die Integration steht im Fokus – extrahierte Bilder und Daten können direkt in Analyse-Dashboards, BI-Tools oder Datenbanken per API und Webhooks fließen. Auch geschützte oder dynamische Inhalte sind kein Problem.

Wichtige Funktionen:

- Interaktiver Workflow-Recorder

- Unterstützt Logins, dynamische Inhalte und geschützte Seiten

- API/Webhook-Integration für Analyse-Workflows

- Managed Services für Unternehmen

Ideal für: Mittelständische und große Unternehmen, die zuverlässige, skalierbare Bildextraktion als Teil einer größeren Datenpipeline benötigen. Preise ab ca. 299 $/Monat, kostenlose Testphase verfügbar.

5. Apify

ist eine Entwickler-freundliche Automatisierungsplattform mit einem Marktplatz für fertige „Actors“ (vorgefertigte Scraper) und der Möglichkeit, eigene in Node.js oder Python zu programmieren.

Warum Apify so flexibel ist: Es gibt fertige Actors für viele bekannte Seiten (z.B. Instagram oder Amazon) oder du baust dir deinen eigenen Scraper. Die Cloud-Infrastruktur übernimmt Zeitplanung, Proxy-Management und Skalierung – so kannst du tausende Seiten parallel scrapen.

Wichtige Funktionen:

- Actor-Marktplatz (vorgefertigte Scraper für beliebte Seiten)

- Eigene Scripte in Node.js/Python

- Cloud-Scraping und Speicherung

- Leistungsstarke API-Integration

Ideal für: Entwickler, Startups oder Data Engineers, die programmierbare, skalierbare Scraping-Lösungen suchen. Kostenlos für kleine Projekte, Bezahlpläne ab 49 $/Monat.

6. Mozenda

ist eine Enterprise-Lösung für strukturierte Datenerfassung – inklusive Bilder, Dateien und PDFs. Die Point-and-Click-Oberfläche ist einfach, die wahre Stärke liegt aber in Automatisierung, Zeitplanung und Teamfunktionen.

Warum Mozenda unternehmensreif ist: Hier steht Zuverlässigkeit im Fokus – mit robuster Zeitplanung, Benachrichtigungen und Workflow-Automatisierung. Mozenda kann Daten aus verschiedenen Quellen zusammenführen, in viele Formate exportieren und sogar On-Premises für sensible Projekte laufen.

Wichtige Funktionen:

- Visueller Agent-Builder (kein Code nötig)

- Meistert komplexe Seiten, mehrstufige Daten und Bilder

- Zeitplanung, Benachrichtigungen und Workflow-Automatisierung

- Teamarbeit und Managed Services

Ideal für: Große Unternehmen oder Teams mit laufendem, geschäftskritischem Scraping-Bedarf. Preise ab ca. 99 $/Monat, individuelle Enterprise-Angebote möglich.

7. VisualScraper

ist ein schlankes, benutzerfreundliches Tool für schnelle Bildextraktionen. Die Oberfläche ist minimalistisch – einfach klicken und extrahieren.

Warum VisualScraper praktisch ist: Perfekt für kleine oder einmalige Projekte. Aufgaben lassen sich planen, Export in CSV/JSON/XML, Ergebnisse können sogar per E-Mail oder FTP zugestellt werden. Nicht so mächtig wie die großen Tools, aber für Basisaufgaben unschlagbar einfach (und meist kostenlos).

Wichtige Funktionen:

- Einfache Point-and-Click-Oberfläche

- Vorschau der Daten in Echtzeit

- Zeitplanung und Export in verschiedene Formate

- Kostenlose Windows-App für kleine Aufgaben

Ideal für: Einzelpersonen, Hobbyanwender oder kleine Unternehmen, die gelegentlich Bilder extrahieren möchten – ohne Lernaufwand.

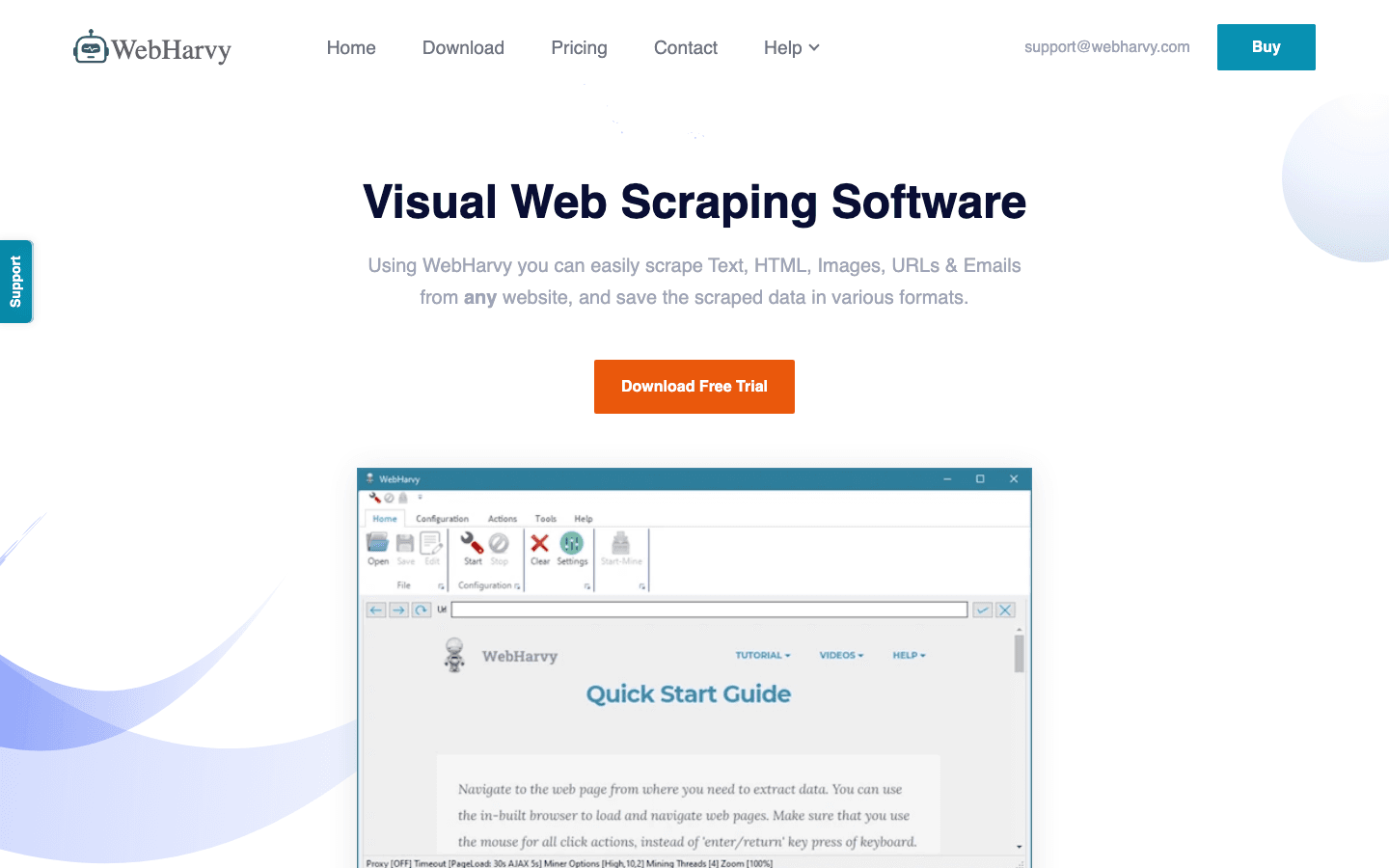

8. WebHarvy

ist ein Windows-basiertes, visuelles Scraping-Tool mit intelligenter Mustererkennung. Ein Klick auf ein Bild genügt, und WebHarvy findet und extrahiert automatisch alle ähnlichen Bilder auf der Seite.

Warum WebHarvy clever ist: Es unterstützt mehrstufiges Scraping (z.B. Galeriebilder aus Produktdetails), kann Formulare ausfüllen, Buttons klicken und sogar eigenes JavaScript für schwierige Seiten ausführen. Einmalige Lizenz – keine laufenden Kosten.

Wichtige Funktionen:

- Intelligente Mustererkennung

- Mehrstufiges und Galerie-Bild-Scraping

- Export nach Excel, CSV, JSON, SQL

- Einmalige Lizenz (kein Abo)

Ideal für: Nicht-Programmierer, die einfache Bedienung und fortgeschrittene Funktionen auf Windows suchen. Ideal für Forscher und kleine Unternehmen.

9. Diffbot

ist das KI-Hirn der Webdaten-Extraktion. Einfach eine (oder eine Million) URLs eingeben, und die Computer Vision/NLP erkennt und extrahiert alle Hauptbilder – ganz ohne Regeln oder Selektoren.

Warum Diffbot einzigartig ist: API-first, extrem skalierbar und anpassungsfähig bei Webseitenänderungen (die KI lernt automatisch). Mit dem Knowledge Graph kannst du sogar webweite Bild- und Strukturdaten abfragen.

Wichtige Funktionen:

- KI-gesteuerte Extraktion (keine Einrichtung nötig)

- Verarbeitet Millionen Seiten per API

- Liefert Bild-URLs, Metadaten und Tags

- Knowledge Graph für webweite Abfragen

Ideal für: Unternehmen, KI-Firmen oder Datenanbieter, die riesige, wartungsfreie Bilddatensätze benötigen. Kostenlos für 10.000 API-Calls/Monat, Bezahlpläne ab 299 $/Monat. Etwas Programmierkenntnisse erforderlich.

10. Scrapy

ist das Open-Source-Framework für individuelles web-scraping in Python. Entwickler erhalten hier volle Kontrolle – eigene Spider schreiben, beliebige Seiten crawlen, Bilder extrahieren und nach Wunsch weiterverarbeiten.

Warum Scrapy so mächtig ist: Die integrierte Images Pipeline automatisiert das Herunterladen von Bildern, erstellt Thumbnails und filtert nach Größe oder Format. Scrapy ist schnell, skalierbar und bietet zahlreiche Erweiterungen für Proxies, Cloud-Crawling und mehr.

Wichtige Funktionen:

- Code-basiert, maximale Flexibilität

- Asynchrones, schnelles Crawling

- Integriertes Bild-Download und -Verarbeitung

- Kostenlos und Open Source

Ideal für: Entwickler und technische Teams mit individuellen oder groß angelegten Scraping-Projekten. Die einzigen Kosten: Zeit und Serverressourcen.

Vergleichstabelle der bild-scraper-Tools

| Tool | Benutzerfreundlichkeit | Exportformate | Automatisierung/Planung | Ideal für | Preis (ca.) |

|---|---|---|---|---|---|

| Thunderbit | ★★★★★ | Excel, Sheets, Notion | Ja | Nicht-Techniker, KMU | Kostenlos, ab 15 $/Monat |

| ParseHub | ★★★★☆ | CSV, JSON, Tableau | Ja (Cloud) | Analysten, komplexe Seiten | Kostenlos, ab 189 $/Monat |

| Octoparse | ★★★★☆ | CSV, Excel, JSON | Ja (Cloud) | No-Coder, Massenextraktion | Kostenlos, ab 119 $/Monat |

| Import.io | ★★★★☆ | API, CSV, DB | Ja (Cloud) | Unternehmen, BI-Integration | ab 299 $/Monat |

| Apify | ★★★☆☆ | JSON, CSV, API | Ja (Cloud) | Entwickler, skalierbare Projekte | Kostenlos, ab 49 $/Monat |

| Mozenda | ★★★★☆ | CSV, Excel, API, DB | Ja | Unternehmen, Team-Workflows | ab 99 $/Monat |

| VisualScraper | ★★★★☆ | CSV, JSON, XML, E-Mail | Ja | Einzelne, kleine Projekte | Kostenlos, ab 49 $/Monat (Cloud) |

| WebHarvy | ★★★★☆ | Excel, CSV, JSON, SQL | Ja | No-Coder, Windows-Nutzer | 99 $ einmalig |

| Diffbot | ★★★☆☆ | API (JSON, Metadaten) | Ja (API) | Unternehmen, KI, Entwickler | Kostenlos, ab 299 $/Monat |

| Scrapy | ★★★☆☆ | Beliebig (eigener Code) | Ja (individuell) | Entwickler, eigene Pipelines | Kostenlos |

Wie wählst du das richtige bild-scraper-Tool für dein Unternehmen?

Hier eine schnelle Entscheidungshilfe:

- Du bist nicht technisch und willst es einfach? Starte mit oder .

- Du musst komplexe, dynamische Seiten scrapen? Probiere oder .

- Du brauchst Integration und Support auf Enterprise-Niveau? Schau dir , oder an.

- Du bist Entwickler und willst volle Kontrolle? oder sind deine Favoriten.

- Du brauchst nur ein schnelles, kostenloses Tool für kleine Aufgaben? ist eine gute Wahl.

Teste immer die kostenlosen Versionen – mach einen kleinen Probelauf auf deiner Zielseite, um das passende Tool für deinen Workflow und deine Daten zu finden.

Fazit: Finde deinen idealen bild-scraper für 2025

Das visuelle Gold des Internets wartet nur darauf, von dir gehoben zu werden – mit dem richtigen bild-scraper. Egal ob du einen Produktkatalog aufbaust, die Konkurrenz im Blick hast oder deine nächste virale Kampagne planst: Diese Tools sparen dir Stunden (und Nerven). Mein Tipp: Starte mit deinem konkreten Anwendungsfall, wähle das Tool, das zu deinen Skills und deinem Budget passt, und probiere ruhig verschiedene Lösungen aus.

Wenn du sehen willst, wie einfach Bilder extrahieren sein kann, und probiere es selbst aus. Dein Finger wird sich über weniger „Speichern unter“ freuen.

Mehr Tipps und Vergleiche findest du im .

FAQs

1. Was ist ein bild-scraper-Tool und wie funktioniert es?

Ein bild-scraper-Tool automatisiert das Extrahieren von Bildern (oder deren URLs) von Websites. Meist kannst du per KI, Klick oder Code festlegen, was extrahiert werden soll – und die Bilder dann gesammelt exportieren. Das spart dir stundenlange Handarbeit.

2. Kann ich bild-scraper-Tools ohne Programmierkenntnisse nutzen?

Auf jeden Fall. Tools wie , und sind speziell für Nicht-Techniker gemacht – mit natürlicher Sprache oder visueller Oberfläche.

3. Was unterscheidet kostenlose von kostenpflichtigen bild-scraper-Tools?

Kostenlose Tools eignen sich für kleine, gelegentliche Aufgaben, haben aber oft Limits bei Umfang, Funktionen oder Support. Bezahlte Tools bieten mehr Automatisierung, Cloud-Verarbeitung und Profi-Features – ideal für Unternehmen.

4. Wie exportiere ich Bilder nach Excel, Google Sheets oder Notion?

Die meisten modernen Scraper (wie ) ermöglichen den direkten Export nach Excel, Sheets, Notion oder Airtable mit nur einem Klick. Andere bieten CSV/JSON-Downloads oder API-Integration für individuelle Workflows.

5. Ist es legal, Bilder von jeder Website zu scrapen?

Beachte immer die Nutzungsbedingungen und Urheberrechte der jeweiligen Website. Extrahiere nur öffentlich zugängliche Bilder und verwende sie nicht ohne Erlaubnis für kommerzielle Zwecke. Im Zweifel: Rechtsberatung einholen oder Bilder nur intern nutzen.

Bereit, das Extrahieren von Bildern zum einfachsten Teil deines Workflows zu machen? Probiere ein paar Tools aus dieser Liste – vielleicht ist dein nächstes großes Projekt nur einen Klick entfernt.

Mehr erfahren: