Das Internet ist mittlerweile eine wahre Datenflut – bis 2025 werden wir täglich mit unfassbaren an neuen Daten rechnen müssen. Wer im Vertrieb, E-Commerce, in der Forschung oder im operativen Alltag unterwegs ist, kennt das Problem: Wie filtert man aus diesem Datenchaos die wirklich nützlichen Infos heraus? Manuell kopieren und einfügen? Vergiss es – das ist nicht nur langsam und fehleranfällig, sondern auch so spannend wie ein verregneter Sonntagnachmittag. Kein Wunder also, dass mittlerweile auf KI setzen, um Webdaten automatisch zu extrahieren. Was früher Wochen dauerte, geht heute in wenigen Minuten.

Ich habe selbst viele Jahre im SaaS- und Automatisierungsbereich gearbeitet und erlebt, wie ein cleverer KI-Web-Scraper die Produktivität auf ein ganz neues Level hebt. Aber bei der riesigen Auswahl an Tools: Wie findet man das richtige? Hier stelle ich dir die 10 besten Tools vor, die mit KI Webseiten effizient scrapen – von einfachen Chrome-Add-ons bis zu professionellen Cloud-Lösungen.

Warum KI beim Web Scraping? Entdecke neue Möglichkeiten

Klassische Web-Scraper sind wie alte Navi-Apps – sobald sich die Route ändert, sind sie verloren. Sie arbeiten mit festen Regeln und Selektoren, die bei jeder kleinen Layout-Änderung einer Website sofort aussteigen. KI-basierte Scraper dagegen nutzen maschinelles Lernen und natürliche Sprachverarbeitung, erkennen Muster, passen sich an Änderungen an und verstehen sogar, was du in ganz normaler Alltagssprache beschreibst ().

Das bringt KI beim Web Scraping:

- Tempo: KI-Scraper machen aus wochenlanger Recherche ein paar Minuten automatisierte Extraktion ().

- Präzision: Sie nutzen Computer Vision und NLP, um z. B. Produktnamen und Beschreibungen sauber zu trennen – für verlässliche, saubere Daten.

- Robustheit: Ändert sich eine Website, passt sich die KI an – kein ständiges Nachjustieren mehr.

- Zugänglichkeit: Auch ohne Technik-Know-how kannst du Daten extrahieren, indem du einfach beschreibst, was du brauchst – perfekt für Lead-Generierung, Preisüberwachung oder Marktforschung.

- Kosteneffizienz: Teams berichten von und deutlich weniger Handarbeit.

Kurz gesagt: Mit KI scrapest du schneller und zuverlässiger – ganz ohne Programmierkenntnisse oder komplizierte Regex-Befehle.

So haben wir die besten KI-Web-Scraper ausgewählt

Bei der Auswahl der Top 10 habe ich auf folgende Punkte geachtet:

- Benutzerfreundlichkeit: Kommen auch Nicht-Programmierer schnell ans Ziel? Gibt es eine visuelle Oberfläche oder Unterstützung für natürliche Sprache?

- KI-Funktionen: Nutzt das Tool KI für Felderkennung, Anpassung an Layout-Änderungen oder das Verstehen von Anweisungen in Alltagssprache?

- Funktionsumfang: Unterstützung für Paginierung, Zeitplanung, Proxy-Management, CAPTCHA-Lösungen und verschiedene Exportformate.

- Skalierbarkeit: Von wenigen Seiten bis zu Millionen – gibt es eine Cloud-Option?

- Preis & Zugänglichkeit: Gibt es eine kostenlose Version? Ist das Tool für Einzelpersonen, KMU und Unternehmen erschwinglich?

- Support & Community: Gute Dokumentation, schneller Support und eine aktive Nutzerbasis.

- Reputation: Echte Nutzerbewertungen, Erfahrungsberichte und eine verlässliche Historie.

Die Liste deckt Browser-Erweiterungen, Desktop-Apps, Cloud-Plattformen und Entwickler-Frameworks ab – egal ob Solo-Gründer, Datenanalyst oder Enterprise-Team, hier ist für jeden was dabei.

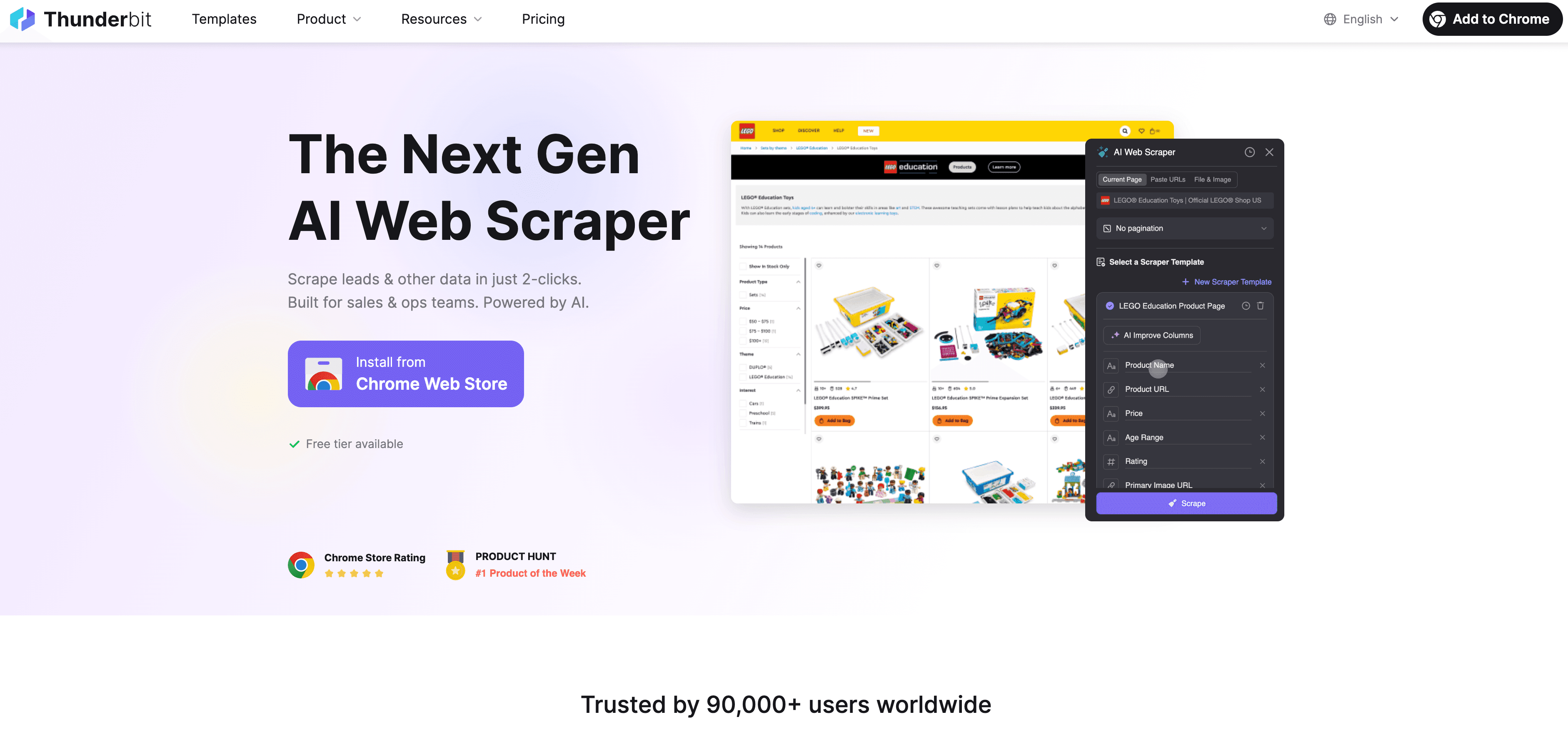

1. Thunderbit

ist meine absolute Empfehlung für Business-Anwender, die mit KI Webseiten schnell und unkompliziert scrapen wollen. Als Chrome-Erweiterung funktioniert Thunderbit wie ein smarter KI-Assistent, der jede Webseite (sogar PDFs oder Bilder) liest und die Daten mit nur zwei Klicks strukturiert ausgibt.

ist meine absolute Empfehlung für Business-Anwender, die mit KI Webseiten schnell und unkompliziert scrapen wollen. Als Chrome-Erweiterung funktioniert Thunderbit wie ein smarter KI-Assistent, der jede Webseite (sogar PDFs oder Bilder) liest und die Daten mit nur zwei Klicks strukturiert ausgibt.

Was macht Thunderbit besonders?

- Natürliche Sprache: Einfach beschreiben, was du extrahieren willst („Alle Produktnamen, Preise und Bilder von dieser Seite extrahieren“) – die KI macht den Rest.

- KI-Feldvorschläge: Ein Klick, und die KI schlägt passende Spalten vor. Du kannst sie anpassen oder direkt übernehmen – dann einfach auf „Scrapen“ klicken.

- Unterseiten & Paginierung: Thunderbit folgt automatisch Links zu Unterseiten (z. B. Produktdetails) und kommt auch mit endlosem Scrollen klar.

- Sofortiger Datenexport: Export direkt nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

- Kostenlose Kontakt-Extraktoren: E-Mails, Telefonnummern und Bilder mit nur einem Klick extrahieren – komplett gratis.

- Geplantes Scraping: Wiederkehrende Aufgaben per natürlicher Sprache einrichten („jeden Montag um 9 Uhr“) – die KI übernimmt den Rest.

Thunderbit zeigt seine Stärken besonders bei unübersichtlichen, komplexen oder ungewöhnlichen Webseiten – etwa bei Nischenverzeichnissen, Immobilienportalen oder E-Commerce-Seiten, an denen andere Scraper scheitern. Nutzer feiern die einfache Bedienung und starke Performance, mit einer .

Preise: Kostenlos für bis zu 6–10 Seiten; kostenpflichtige Pläne ab ca. 15 $/Monat für 500 Credits (Seiten), größere Pakete für mehr Bedarf. Datenexport ist immer gratis.

Ideal für: Vertrieb, Marketing, E-Commerce und alle, die ohne Programmieraufwand Daten extrahieren möchten.

2. import.io

ist eine KI-basierte Web-Scraping-Plattform für Unternehmen, der auch große Namen wie Unilever und Volvo vertrauen. Sie ist für großvolumige, unternehmenskritische Datenextraktion konzipiert.

ist eine KI-basierte Web-Scraping-Plattform für Unternehmen, der auch große Namen wie Unilever und Volvo vertrauen. Sie ist für großvolumige, unternehmenskritische Datenextraktion konzipiert.

Warum import.io wählen?

- KI-„Selbstheilende“ Pipelines: Ändert sich eine Website, passt sich die KI automatisch an – keine kaputten Scraper mehr.

- Prompt-basierte Extraktion: Extraktionen mit einfachen Anweisungen einrichten, die KI übernimmt die Details.

- Automatische Compliance: Integrierte Filter für Datenschutzgesetze (GDPR, CCPA) und anpassbare PII-Maskierung.

- Vollständig gemanagte Cloud: Proxy-Rotation, Zeitplanung und Infrastruktur werden übernommen.

- API-Integration: Jede Website kann als Live-API für Analysen oder Geschäftsanwendungen genutzt werden.

Preise: Ab ca. 299 $/Monat, individuelle Enterprise-Tarife möglich. Kostenlose Testphase verfügbar.

Ideal für: Unternehmen und Datenteams, die zuverlässige, skalierbare und rechtskonforme Webdaten-Pipelines benötigen.

3. Bright Data

steht für Skalierbarkeit. Wer Millionen von Seiten scrapen, weltweite Preisüberwachung betreiben oder KI-Modelle mit Daten versorgen will, ist hier richtig.

steht für Skalierbarkeit. Wer Millionen von Seiten scrapen, weltweite Preisüberwachung betreiben oder KI-Modelle mit Daten versorgen will, ist hier richtig.

Wichtige Funktionen:

- 100M+ Proxy-Netzwerk: Wohn-, Mobil- und Rechenzentrums-IPs für maximale Blockade-Umgehung.

- KI-basierter Unblocker: Löst CAPTCHAs, rotiert Header und passt sich Anti-Bot-Maßnahmen in Echtzeit an.

- Vorgefertigte Scraper: APIs für über 120 bekannte Seiten (Amazon, LinkedIn, Google usw.).

- Dataset-Marktplatz: Zugriff auf riesige, vorab gescrapte Datensätze.

- LLM-fähige Datenströme: Echtzeit-Webdaten direkt in KI-Systeme einspeisen.

Preise: Nutzungsbasiert; bei großem Volumen kann es teuer werden. Kostenlose Testphase und einige Gratis-Datensätze verfügbar.

Ideal für: Große Unternehmen, KI-Projekte und alle, die riesige, zuverlässige und rechtskonforme Webdaten benötigen.

4. ParseHub

ist eine Desktop-App (Windows, Mac, Linux), die visuelles Web Scraping auch für dynamische, JavaScript-lastige Seiten einfach macht.

ist eine Desktop-App (Windows, Mac, Linux), die visuelles Web Scraping auch für dynamische, JavaScript-lastige Seiten einfach macht.

Warum ParseHub?

- Maschinelles Lernen für Mustererkennung: Ein Klick auf ein Element, und ParseHub findet automatisch alle ähnlichen Elemente.

- Dynamische Inhalte: Funktioniert mit AJAX, endlosem Scrollen und interaktiven Elementen.

- Visueller Workflow-Builder: Mehrstufige Scraping-Prozesse ohne Code einrichten.

- Cloud-Scheduling: Aufgaben in der Cloud ausführen und wiederkehrend planen.

- Flexibler Export: CSV, Excel, JSON oder per API.

Preise: Kostenlos für bis zu 5 Projekte (200 Seiten/Lauf); kostenpflichtige Pläne ab 189 $/Monat.

Ideal für: Analysten, Forscher und kleine Unternehmen, die eine leistungsstarke, visuelle Lösung für komplexe Seiten suchen.

5. Scrapy

ist das Entwickler-Toolkit für Web Scraping. Ein Open-Source-Framework in Python, das sich flexibel erweitern lässt.

ist das Entwickler-Toolkit für Web Scraping. Ein Open-Source-Framework in Python, das sich flexibel erweitern lässt.

Was macht Scrapy besonders?

- Maximale Flexibilität: Eigene Spider für beliebige Anforderungen und jedes Volumen schreiben.

- KI-Integrationen: Erweiterungen wie Scrapy-LLM für die Verarbeitung mit großen Sprachmodellen oder NLP für intelligente Extraktion.

- Asynchrones Crawling: Sehr schnell und effizient bei großen Projekten.

- Offenes Ökosystem: Viele Plugins für Proxies, Browser-Automatisierung und mehr.

Preise: Kostenlos und Open Source; nur eigene Infrastruktur muss bezahlt werden.

Ideal für: Entwickler und Technikteams, die volle Kontrolle und KI-Integration in individuelle Scraping-Workflows wünschen.

6. Octoparse

ist ein No-Code, cloudbasierter Web-Scraper für Business-Anwender und Teams.

ist ein No-Code, cloudbasierter Web-Scraper für Business-Anwender und Teams.

Besondere Funktionen:

- KI-Auto-Detect: Die KI scannt die Seite und schlägt vor, welche Daten extrahiert werden – ganz ohne manuelle Einrichtung.

- Drag-and-Drop-Workflow: Scraper visuell bauen, inklusive Login, Paginierung und dynamischer Inhalte.

- Vorgefertigte Templates: Hunderte fertige Vorlagen für bekannte Websites.

- Cloud-Scheduling: Scrapes in der Cloud ausführen und planen; Export zu Sheets, Excel oder per API.

- KI Regex-Helfer: Regex-Muster mit KI-Unterstützung generieren.

Preise: Kostenlos (10 Aufgaben); kostenpflichtige Pläne ab ca. 75 $/Monat.

Ideal für: Nicht-Programmierer, Marketing-Teams und KMU, die eine benutzerfreundliche, No-Code-Lösung suchen.

7. WebHarvy

ist eine Windows-Desktop-App, bekannt für intelligente Mustererkennung und Einmal-Lizenz.

ist eine Windows-Desktop-App, bekannt für intelligente Mustererkennung und Einmal-Lizenz.

Warum WebHarvy?

- Automatische Mustererkennung: Ein Klick auf ein Element, und WebHarvy findet alle ähnlichen Daten auf der Seite.

- Visuelles Scraping: Im integrierten Browser Daten per Klick auswählen – ganz ohne Code.

- Bild- & E-Mail-Scraping: Bilder herunterladen oder E-Mails einfach extrahieren.

- Einmalige Lizenz: Lebenslange Lizenz (ab 129 $) mit optionalen kostenpflichtigen Updates.

Preise: Ab 129 $ einmalig pro Nutzer.

Ideal für: Kleine Unternehmen, Forscher oder alle, die unter Windows eine günstige Offline-Lösung suchen.

8. Apify

ist eine Cloud-Automatisierungsplattform für Web Scraping und Workflow-Integration, geeignet für Entwickler und Nicht-Programmierer.

ist eine Cloud-Automatisierungsplattform für Web Scraping und Workflow-Integration, geeignet für Entwickler und Nicht-Programmierer.

Wichtige Funktionen:

- Actors Marketplace: Über 200 vorgefertigte Bots für gängige Scraping-Aufgaben.

- Eigene Actors: Eigene Bots in JavaScript/Python schreiben oder visuelle Tools nutzen.

- KI-Integrationen: Gescrapte Daten in LLMs einspeisen oder Scraper von KI-Agenten auslösen lassen.

- Cloud-Scheduling & Storage: Aufgaben skalierbar ausführen, Ergebnisse speichern und per API oder Workflow-Tools integrieren.

- Proxy- & Headless-Browser-Support: Dynamische Seiten und Anti-Bot-Maßnahmen meistern.

Preise: Kostenlos (5 $ monatliches Guthaben); kostenpflichtige Pläne ab 49 $/Monat.

Ideal für: Entwickler, Startups und Teams, die skalierbares, automatisiertes Scraping mit Workflow-Integration suchen.

9. Diffbot

ist führend bei KI-gestützter Webdaten-Extraktion und Knowledge Graphs.

ist führend bei KI-gestützter Webdaten-Extraktion und Knowledge Graphs.

Was macht Diffbot einzigartig?

- Vollständig KI-gesteuerte Extraktion: Jede URL an die API schicken und strukturierte JSON-Daten erhalten – ohne Einrichtung.

- Knowledge Graph: Zugriff auf einen riesigen, ständig aktualisierten Graphen mit über 10 Mrd. Entitäten (Unternehmen, Personen, Produkte, Artikel).

- Computer Vision + NLP: Extrahiert Daten aus Text, Bildern und erkennt sogar Zusammenhänge.

- Faktenbasierte LLMs: Fragen stellen und Antworten mit Web-Quellen erhalten.

Preise: Kostenloser Entwickler-Test (10.000 Aufrufe/Monat); Startup-Plan 299 $/Monat für 250.000 Credits.

Ideal für: Unternehmen, KI-Firmen und Forscher, die sofort strukturierte Daten oder eine abfragebereite Wissensdatenbank benötigen.

10. Data Miner

ist eine Chrome/Edge-Erweiterung, die schnelles, vorlagenbasiertes Scraping für alle zugänglich macht.

ist eine Chrome/Edge-Erweiterung, die schnelles, vorlagenbasiertes Scraping für alle zugänglich macht.

Warum Data Miner?

- 50.000+ öffentliche Rezepte: Ein-Klick-Scraping für über 15.000 Seiten (LinkedIn, Gelbe Seiten, Amazon usw.).

- Visuelle Anpassung: Eigene Scraping-Vorlagen per Klick erstellen.

- Paginierung & Automatisierung: Mehrere Seiten oder URL-Listen direkt im Browser scrapen.

- Direkter Export: Download als CSV/Excel oder Upload zu Google Sheets.

Preise: Kostenlos für bis zu 500 Seiten/Monat; kostenpflichtige Pläne ab ca. 19 $/Monat.

Ideal für: Nicht-Techniker, die schnell und browserbasiert kleine bis mittlere Scraping-Aufgaben erledigen möchten.

Vergleich der besten KI-Web-Scraper

Hier ein schneller Überblick über alle 10 Tools:

| Tool | Ideal für | KI-Funktionen | Benutzerfreundlichkeit | Skalierbarkeit | Preise | Support/Community |

|---|---|---|---|---|---|---|

| Thunderbit | Nicht-Programmierer, Business | LLM-Felderkennung, NL-UI | Sehr einfach | Mittel (Cloud) | Kostenlos, ab $15/Monat | Schneller E-Mail-Support, aktive Entwicklung |

| import.io | Unternehmen, Datenteams | Selbstheilend, Prompt-KI | Mittel | Sehr hoch | Ab $299/Monat | Dedizierter Enterprise-Support |

| Bright Data | Große Unternehmen, KI-Projekte | Unblocker, 100M+ Proxies | Mittel | Extrem hoch | Nutzungsbasiert | Enterprise, Doku |

| ParseHub | Analysten, KMU, dynamische Seiten | ML-Mustererkennung | Einfach/mittel | Mittel-hoch | Kostenlos, ab $189/Monat | Doku, Forum |

| Scrapy | Entwickler, individuelle Workflows | LLM/NLP-Plugins | Schwierig (Code) | Sehr hoch | Kostenlos (OSS) | Community, Doku |

| Octoparse | KMU, Nicht-Programmierer, Teams | KI-Auto-Detect, Templates | Sehr einfach | Hoch (Cloud) | Kostenlos, ab $75/Monat | Live-Chat, Tutorials |

| WebHarvy | Windows-Nutzer, KMU, Forscher | Mustererkennung | Sehr einfach | Mittel | $129 einmalig | E-Mail, Bewertungen |

| Apify | Entwickler, Startups, Automatisierung | KI-Integrationen, Actors | Mittel | Sehr hoch | Kostenlos, ab $49/Monat | Doku, Slack, Support |

| Diffbot | KI/Data Science, Unternehmen | Vollständige KI-Extraktion, KG | Einfach (API) | Extrem hoch | Kostenlos, ab $299/Monat | Dediziert, akademisch |

| Data Miner | Nicht-Techniker, schnelle Browser-Jobs | 50k+ Rezepte, Muster-KI | Sehr einfach | Niedrig-mittel | Kostenlos, ab $19/Monat | Office Hours, Rezepte |

Wie finde ich das richtige KI-Web-Scraping-Tool?

Hier ein paar Tipps für die Auswahl:

- Nicht-Programmierer, schnelle Aufgaben: Thunderbit, Octoparse, Data Miner oder WebHarvy.

- Große, unternehmensweite Projekte: import.io, Bright Data, Diffbot.

- Individuelle Entwickler-Workflows: Scrapy, Apify.

- Dynamische oder komplexe Seiten: ParseHub, Octoparse, Apify (mit Browser-Automatisierung).

- Sofort strukturierte Daten von jeder Seite: Diffbot.

- Einmalige Lizenz (kein Abo): WebHarvy.

Mein Tipp: Oft ist die Kombination mehrerer Tools am effektivsten. Zum Beispiel kann Thunderbit unstrukturierte Daten schnell ordnen, während WebHarvy mit seiner Mustererkennung für Feinschliff sorgt.

Wichtige Auswahlkriterien:

- Budget: Kostenlose Versionen eignen sich super zum Testen; Enterprise-Tools bieten Skalierung und Support, sind aber teurer.

- Technisches Know-how: No-Code-Tools für Business-Anwender, Frameworks für Entwickler.

- Datenvolumen: Browser-Tools für kleine Aufgaben, Cloud-Plattformen für große Projekte.

- Support-Bedarf: Enterprise-Tools bieten SLAs, andere setzen auf Community oder E-Mail.

Fazit: Die Zukunft des KI-gestützten Web Scraping

KI macht Web Scraping zum Mainstream – nicht mehr nur für Entwickler, sondern für alle, die Leads generieren, Preise überwachen oder KI-Modelle mit Daten füttern wollen. Die zehn vorgestellten Tools zeigen, wie vielseitig und leistungsstark das Ökosystem heute ist.

Mit der Weiterentwicklung von KI werden Web-Scraper noch smarter: natürlichere Bedienung, bessere Anpassung an Webseiten-Änderungen und tiefere Integration in Geschäftsprozesse. Mein Tipp: Teste verschiedene Tools, finde das passende für deinen Workflow und kombiniere sie für das beste Ergebnis.

Wer sehen will, wie modernes, KI-gestütztes Scraping funktioniert, sollte oder weitere Anleitungen im lesen. Die Zukunft der Webdaten ist da – und sie ist deutlich produktiver (und angenehmer) als endloses Copy-Paste.

Häufige Fragen (FAQ)

1. Warum sollte ich KI zum Scrapen von Webseiten nutzen statt klassischer Tools?

KI-Scraper passen sich automatisch an Webseiten-Änderungen an, erkennen Muster selbstständig und ermöglichen es auch Nicht-Technikern, Daten einfach per Beschreibung zu extrahieren. Das bedeutet schnellere, zuverlässigere Ergebnisse mit weniger Wartungsaufwand.

2. Welches KI-Web-Scraping-Tool eignet sich am besten für Nicht-Programmierer?

Thunderbit, Octoparse, Data Miner und WebHarvy sind ideal für Nutzer ohne Programmierkenntnisse. Sie bieten visuelle Oberflächen, Unterstützung für natürliche Sprache und erfordern kein Coding.

3. Was ist das beste Tool für großvolumiges oder unternehmensweites Web Scraping?

import.io, Bright Data und Diffbot sind für Skalierbarkeit, Zuverlässigkeit und Compliance ausgelegt. Sie verarbeiten Millionen von Seiten, bieten leistungsstarke APIs und dedizierten Support für Unternehmen.

4. Kann ich verschiedene Tools kombinieren, um meinen Web-Scraping-Workflow zu optimieren?

Absolut! Viele Teams nutzen eine Kombination – etwa Thunderbit für die schnelle Strukturierung und WebHarvy für die Mustererkennung oder Apify für die Workflow-Automatisierung. So nutzt man die Stärken jedes Tools optimal.

5. Gibt es kostenlose Möglichkeiten, diese KI-Web-Scraping-Tools zu testen?

Ja! Die meisten Tools bieten eine kostenlose Version oder Testphase. Thunderbit, Octoparse, Data Miner und Apify haben alle Gratis-Tarife, sodass du vor dem Kauf ausprobieren kannst.

Bereit, dein Webdaten-Game aufs nächste Level zu bringen? Probiere einige dieser Tools aus und entdecke, wie viel Zeit (und Nerven) du sparen kannst. Für mehr Tipps zu Web Scraping, Automatisierung und KI schau im vorbei oder abonniere unseren . Viel Erfolg beim Scrapen!

Mehr lesen