Als ich das erste Mal mit Web Scraping in Kontakt kam, dachte ich mir: „Wie schwer kann das schon sein? Ein bisschen HTML abgreifen und fertig.“ Heute weiß ich: Wer im Vertrieb, E-Commerce oder in der Marktforschung unterwegs ist, kommt an Web Scraping kaum vorbei. Das Netz ist eine gigantische Datenquelle – mit – und Unternehmen sind ständig auf der Jagd nach neuen Insights. Das Problem: Die meisten Daten verstecken sich hinter dynamischen Seiten, JavaScript und interaktiven Elementen, an die einfache Tools nicht rankommen.

Genau hier kommen Python-Web-Scraper wie Selenium ins Spiel. Mit Selenium Python kannst du einen echten Browser fernsteuern und so auch komplexe, dynamische Webseiten auslesen. In diesem Einsteiger-Guide zeige ich dir Schritt für Schritt, wie das funktioniert – inklusive einem Praxisbeispiel mit Produktdaten von . Und weil ich es gerne unkompliziert mag, stelle ich dir außerdem moderne KI-Tools wie vor, mit denen du das Ganze in einem Bruchteil der Zeit (und fast ohne Code) erledigen kannst.

Warum Web Scraping so wichtig ist (und warum dynamische Seiten oft nerven)

Web Scraping ist längst kein Nerd-Hobby mehr. Für Teams aus Vertrieb, Marketing, E-Commerce und Operations ist es ein unverzichtbares Werkzeug. Du willst Preise der Konkurrenz beobachten? Leads generieren? Kundenbewertungen auswerten? Web Scraping macht’s möglich. Tatsächlich geben an, dass Preisdaten ihr Hauptziel sind – und 80–90 % aller Online-Daten sind unstrukturiert. Einfach kopieren und in Excel einfügen? Fehlanzeige.

Das Problem: Moderne Websites sind dynamisch. Inhalte werden per JavaScript nachgeladen, Daten verstecken sich hinter Buttons oder erscheinen erst nach endlosem Scrollen. Einfache Scraper wie requests oder BeautifulSoup sehen nur das statische HTML – wie eine Zeitung, die nie aktualisiert wird. Wenn die Infos erst nach Klicks, Scrollen oder Login erscheinen, brauchst du ein Tool, das wie ein echter Nutzer agiert.

Was ist Selenium Python und warum eignet es sich fürs Web Scraping?

Selenium Python ist ein Tool zur Browser-Automatisierung. Du schreibst Python-Skripte, die einen echten Browser steuern – Buttons klicken, Formulare ausfüllen, Seiten scrollen und natürlich Daten auslesen, die erst nach Interaktion sichtbar werden.

Was unterscheidet Selenium Python von einfachen Scraping-Tools?

- Selenium Python: Steuert einen echten Browser (z. B. Chrome), führt JavaScript aus, interagiert mit dynamischen Elementen und wartet, bis Inhalte geladen sind – wie ein Mensch.

- Requests/BeautifulSoup: Holt nur das statische HTML. Schnell und schlank, aber kann kein JavaScript oder nutzergetriebene Inhalte verarbeiten.

Stell dir Selenium wie einen Roboter-Praktikanten vor: Er kann alles im Browser machen, braucht aber klare Anweisungen (und manchmal etwas Geduld).

Wann solltest du Selenium einsetzen?

- Endlos-Scroll-Feeds (z. B. Social Media, Produktlisten)

- Interaktive Filter oder Dropdowns (z. B. Schuhgröße auswählen auf )

- Inhalte hinter Logins oder Pop-ups

- Single Page Applications (React, Vue, etc.)

Für einfache, statische Seiten reicht BeautifulSoup. Aber sobald es dynamisch wird, ist Selenium die bessere Wahl.

Selenium Python einrichten – Schritt für Schritt

Bevor wir loslegen, richten wir die nötigen Tools ein. Keine Sorge, du brauchst keine Vorkenntnisse.

1. Python und Selenium installieren

Zuerst sicherstellen, dass Python 3 installiert ist. Download unter . Prüfen mit:

1python --versionDann Selenium per pip installieren:

1pip install seleniumDamit hast du das aktuelle Selenium-Paket für Python. Einfach, oder?

2. ChromeDriver herunterladen und einrichten

Selenium braucht einen „Driver“, um den Browser zu steuern. Für Chrome ist das der .

- Chrome-Version herausfinden: Chrome öffnen, Menü → Hilfe → Über Google Chrome.

- Passenden ChromeDriver herunterladen: Die Version muss zu deinem Browser passen.

- Driver entpacken und ablegen:

chromedriver.exe(bzw. das Mac/Linux-Pendant) in den System-Pfad oder ins Projektverzeichnis legen.

Tipp: Es gibt Python-Pakete wie webdriver_manager, die den Driver automatisch laden. Für den Einstieg reicht aber die manuelle Variante.

3. Testen, ob alles funktioniert

Erstelle eine Datei test_selenium.py:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://www.example.com")

4print(driver.title)

5driver.quit()Wenn sich Chrome öffnet, lädt, der Titel ausgegeben wird und der Browser schließt, bist du startklar!

Dein erstes Selenium Python-Skript: Produkte von auslesen

Jetzt wird’s praktisch: Wir holen Produktnamen und Preise von .

Schritt 1: Browser starten und Seite aufrufen

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3driver = webdriver.Chrome()

4driver.get("https://www.allbirds.com/collections/mens")Schritt 2: Auf das Laden dynamischer Inhalte warten

Dynamische Seiten brauchen manchmal etwas. Wir nutzen Seleniums Wartefunktionen:

1from selenium.webdriver.support.ui import WebDriverWait

2from selenium.webdriver.support import expected_conditions as EC

3WebDriverWait(driver, 10).until(

4 EC.presence_of_element_located((By.CSS_SELECTOR, "div.product-card"))

5)(Den passenden CSS-Selektor findest du per Seiten-Inspektion. Im Beispiel nehmen wir div.product-card.)

Schritt 3: Elemente finden und Daten extrahieren

1products = driver.find_elements(By.CSS_SELECTOR, "div.product-card")

2print(f"{len(products)} Produkte gefunden")

3data = []

4for prod in products:

5 name = prod.find_element(By.CSS_SELECTOR, ".product-name").text

6 price = prod.find_element(By.CSS_SELECTOR, ".price").text

7 data.append((name, price))

8 print(name, "-", price)Die Ausgabe sieht dann etwa so aus:

124 Produkte gefunden

2Wool Runner - $110

3Tree Dasher 2 - $135

4...Schritt 4: Daten als CSV speichern

Ergebnisse in eine CSV-Datei schreiben:

1import csv

2with open("allbirds_products.csv", "w", newline="") as f:

3 writer = csv.writer(f)

4 writer.writerow(["Produktname", "Preis"])

5 writer.writerows(data)Und nicht vergessen, den Browser zu schließen:

1driver.quit()Öffne die CSV – und schon hast du alle Produktnamen und Preise für deine Auswertung.

Typische Herausforderungen beim Web Scraping mit Selenium Python

In der Praxis läuft selten alles glatt. Hier ein paar Tipps für die häufigsten Stolpersteine:

Auf das Laden von Elementen warten

Dynamische Seiten sind oft langsam. Nutze explizite Wartezeiten:

1WebDriverWait(driver, 10).until(

2 EC.visibility_of_element_located((By.CSS_SELECTOR, ".product-card"))

3)So stellst du sicher, dass dein Skript nicht zu früh auf Elemente zugreift.

Mit Paginierung umgehen

Du willst mehr als nur die erste Seite? Dann durchlaufe die Seiten:

1while True:

2 try:

3 next_btn = driver.find_element(By.LINK_TEXT, "Next")

4 next_btn.click()

5 WebDriverWait(driver, 10).until(EC.presence_of_element_located((By.CSS_SELECTOR, ".product-card")))

6 except Exception:

7 break # Keine weiteren SeitenOder für endloses Scrollen:

1import time

2last_height = driver.execute_script("return document.body.scrollHeight")

3while True:

4 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

5 time.sleep(2)

6 new_height = driver.execute_script("return document.body.scrollHeight")

7 if new_height == last_height:

8 break

9 last_height = new_heightPop-ups und Logins handhaben

Pop-ups im Weg? So schließt du sie:

1driver.find_element(By.CSS_SELECTOR, ".modal-close").click()Automatischer Login? Felder ausfüllen und absenden:

1driver.find_element(By.ID, "email").send_keys("user@example.com")

2driver.find_element(By.NAME, "login").click()Beachte: CAPTCHAs und Zwei-Faktor-Authentifizierung sind schwer zu automatisieren.

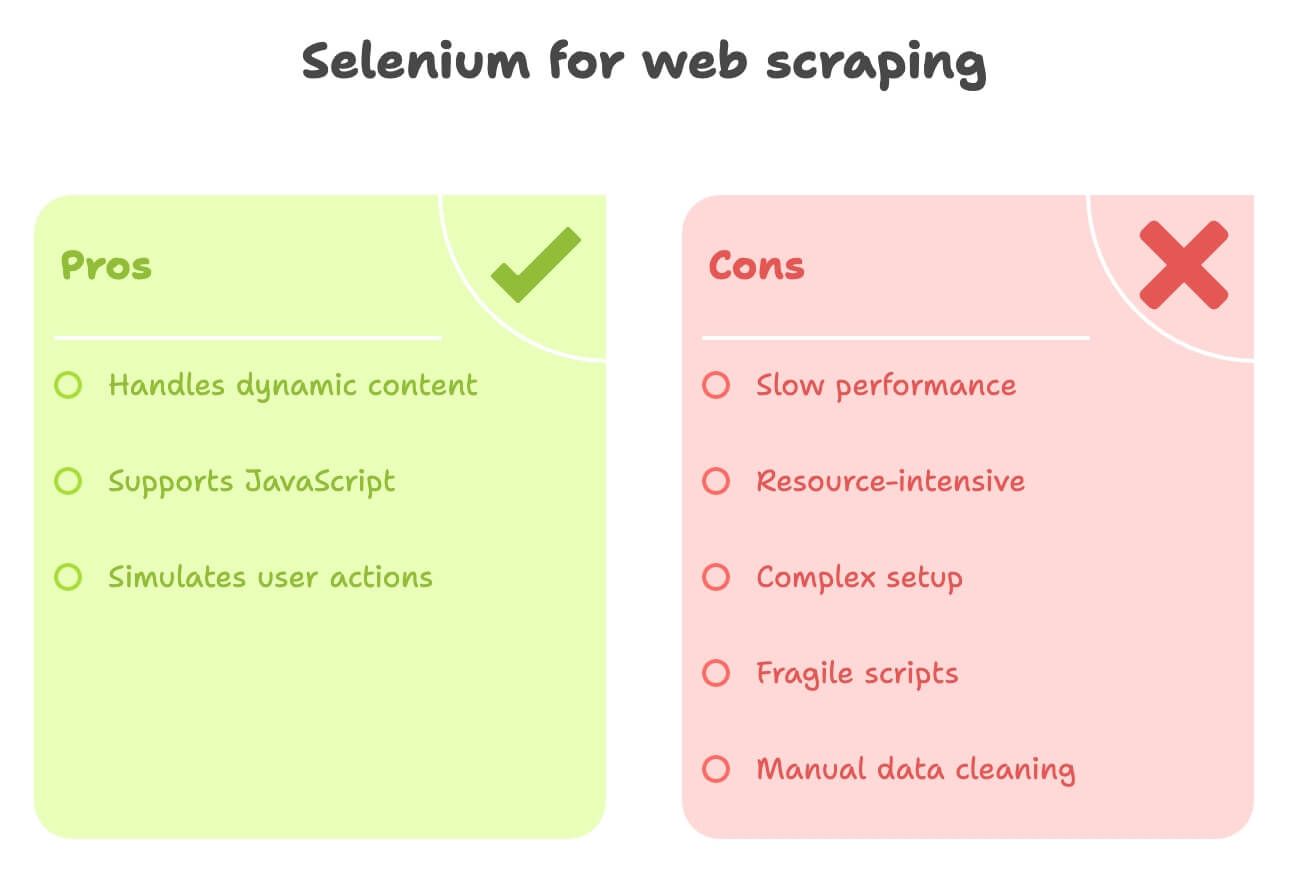

Die Schattenseiten von Selenium Python beim Web Scraping

So mächtig Selenium auch ist – es gibt ein paar Nachteile:

- Langsam: Jeder Seitenaufruf lädt einen kompletten Browser inklusive Bilder und Skripte. Bei 1.000 Seiten brauchst du Geduld.

- Ressourcenintensiv: Hoher CPU- und RAM-Bedarf. Viele Browser parallel? Da kommt selbst ein starker Rechner an seine Grenzen.

- Komplexe Einrichtung: ChromeDriver-Versionen müssen passen, Updates beachten, für jede Seite eigenen Code schreiben – das kann aufwendig werden.

- Anfällig: Ändert sich das Website-Layout, kann dein Skript über Nacht nicht mehr funktionieren.

- Manuelle Datenaufbereitung: Für Übersetzungen oder Sentiment-Analysen brauchst du zusätzliche Bibliotheken oder APIs.

Gerade für Nicht-Techniker oder alle, die einfach schnell strukturierte Daten brauchen, wirkt Selenium oft wie mit Kanonen auf Spatzen geschossen.

Thunderbit kennenlernen: Die KI-Alternative zu Selenium Python

Jetzt zu einem Tool, das besonders für Business-Anwender vieles vereinfacht: . Thunderbit ist ein KI-Web-Scraper als Chrome-Erweiterung, mit dem du Daten von jeder Website extrahieren kannst – ganz ohne Code, ohne komplizierte Einrichtung, mit nur wenigen Klicks.

Was macht Thunderbit anders?

- KI-Felderkennung: Mit „AI Suggest Fields“ erkennt Thunderbits KI automatisch, welche Felder relevant sind – z. B. Produktname, Preis, Bilder usw.

- Unterseiten-Scraping: Du brauchst Details von Produktseiten? Thunderbit klickt sich automatisch durch und sammelt Zusatzinfos.

- Datenanreicherung: Beschreibungen übersetzen, Texte zusammenfassen oder Sentiment-Analysen durchführen – direkt beim Scraping.

- Export mit einem Klick: Daten direkt nach Excel, Google Sheets, Notion oder Airtable exportieren. Kein Coding, kein Aufwand.

- No-Code Oberfläche: Für alle, die nicht programmieren wollen. Wer einen Browser bedienen kann, kann auch Thunderbit nutzen.

Ich bin voreingenommen (ich habe an Thunderbit mitgearbeitet!), aber ich bin überzeugt: Für Vertrieb, E-Commerce und Recherche ist es der schnellste Weg zu strukturierten Webdaten.

Thunderbit vs. Selenium Python: Der direkte Vergleich

Hier die wichtigsten Unterschiede auf einen Blick:

| Kriterium | Selenium Python | Thunderbit (KI, No-Code) |

|---|---|---|

| Einrichtungsaufwand | Mittel bis hoch – Python, Selenium, ChromeDriver installieren, Code schreiben | Sehr schnell – Chrome-Erweiterung installieren, in Minuten startklar |

| Erforderliche Kenntnisse | Hoch – Programmier- und HTML-Wissen nötig | Gering – Point-and-Click, KI übernimmt die Arbeit |

| Dynamische Inhalte | Hervorragend – kann JS, Klicks, Scrollen | Hervorragend – läuft im Browser, unterstützt AJAX, Endlos-Scroll, Unterseiten |

| Geschwindigkeit | Langsam – Browser-Overhead | Schnell bei kleinen/mittleren Jobs – KI erkennt Felder automatisch, direkter DOM-Zugriff |

| Skalierbarkeit | Schwer skalierbar – ressourcenintensiv | Gut für Hunderte/Tausende Einträge; nicht für Massenscraping |

| Datenverarbeitung | Manuell – Datenbereinigung, Übersetzung, Sentiment per Code | Automatisch – KI kann direkt übersetzen, zusammenfassen, kategorisieren, anreichern |

| Exportoptionen | Individueller Code für CSV, Sheets etc. | Export mit einem Klick nach Excel, Google Sheets, Notion, Airtable |

| Wartung | Hoch – empfindlich bei Website-Änderungen | Gering – KI passt sich vielen Layouts an, wenig Pflege nötig |

| Besondere Features | Vollständige Browser-Automatisierung, individuelle Workflows | KI-Insights, Vorlagen, Datenanreicherung, kostenlose Extractor-Vorlagen |

Für die meisten Business-Anwender ist Thunderbit eine echte Erleichterung – kein Stress mehr mit Code oder Browser-Treibern.

Praxisbeispiel: mit Thunderbit auslesen

So einfach geht’s mit Thunderbit:

- Zu navigieren

- Thunderbit-Icon anklicken und „AI Suggest Fields“ wählen

- Thunderbits KI erkennt automatisch Spalten wie „Produktname“, „Preis“, „Produkt-URL“ usw.

- (Optional) Spalte für „Beschreibung (Japanisch)“ oder „Sentiment“ hinzufügen

- Thunderbit übersetzt oder analysiert direkt beim Scraping.

- Auf „Scrape“ klicken

- Thunderbit sammelt alle Produktdaten in einer Tabelle.

- Mit einem Klick nach Google Sheets, Notion oder Excel exportieren

Kein Code, kein Warten auf Browser, kein CSV-Gefrickel. Einfach strukturierte Daten, sofort einsatzbereit.

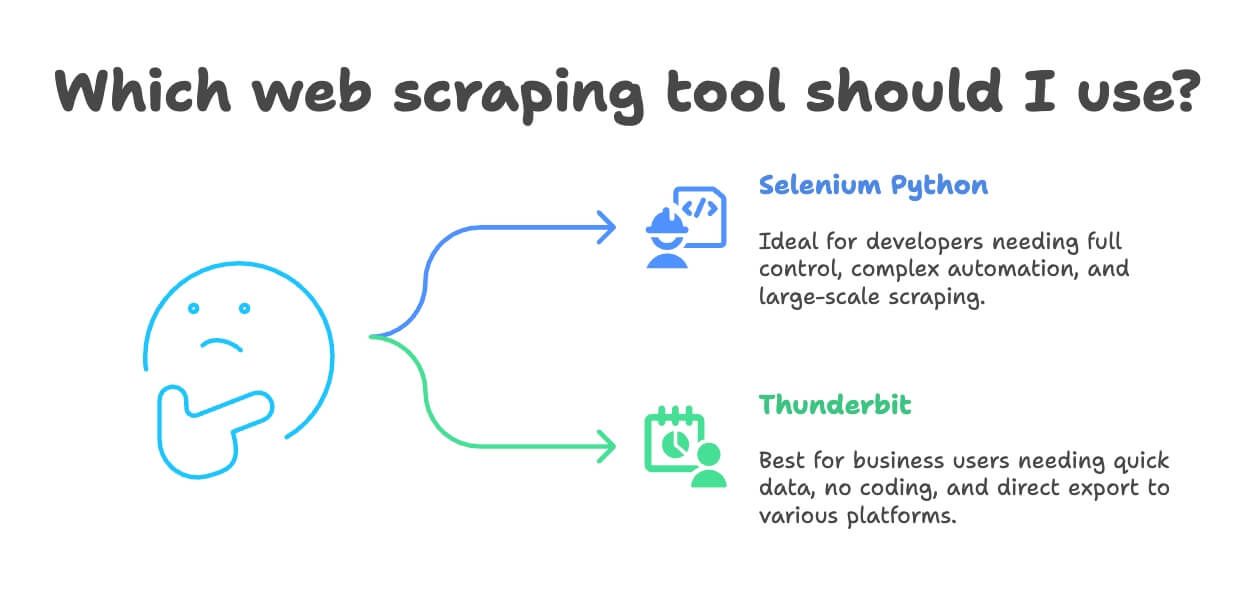

Wann solltest du Selenium Python oder Thunderbit fürs Web Scraping nutzen?

Welches Tool passt zu dir? Hier meine Empfehlung:

- Selenium Python nutzen, wenn:

- Du Entwickler bist oder volle Kontrolle über die Browser-Automatisierung brauchst

- Die Aufgabe sehr individuell ist oder Teil eines größeren Softwareprojekts

- Du komplexe Workflows automatisieren willst (Logins, Downloads, mehrstufige Formulare)

- Du im großen Stil scrapen willst (mit entsprechender Infrastruktur)

- Thunderbit nutzen, wenn:

- Du Business-Anwender, Analyst oder Marketer bist und schnell an Daten kommen willst

- Du keine Lust auf Coding und Einrichtung hast

- Du Übersetzungen, Sentiment-Analysen oder Datenanreicherung direkt beim Scraping brauchst

- Dein Projekt klein bis mittelgroß ist (Hunderte bis wenige Tausend Einträge)

- Du direkt nach Excel, Google Sheets, Notion oder Airtable exportieren willst

Ich habe schon erlebt, dass Teams tagelang an Selenium-Skripten basteln, während Thunderbit die gleiche Aufgabe in 10 Minuten erledigt. Wenn du keine tiefgreifende Anpassung oder Massenscraping brauchst, ist Thunderbit meist die schnellere und angenehmere Lösung.

Bonus: Tipps für verantwortungsvolles und effektives Web Scraping

Bevor du loslegst, ein paar wichtige Hinweise:

- robots.txt und Nutzungsbedingungen beachten: Prüfe immer, was erlaubt ist. Wenn eine Seite Scraping verbietet, halte dich daran.

- Anfragen drosseln: Server nicht überlasten – Pausen einbauen oder eingebaute Limits nutzen.

- User-Agents/IPs rotieren, falls nötig: Hilft gegen einfache Sperren, aber nicht tricksen, wenn es gegen die Regeln verstößt.

- Keine persönlichen oder sensiblen Daten scrapen: Bleib bei öffentlichen Infos und beachte Datenschutzgesetze wie die DSGVO.

- APIs nutzen, wenn vorhanden: Wenn eine Seite eine API anbietet, nutze sie – das ist sicherer und stabiler.

- Nicht ohne Erlaubnis hinter Logins oder Paywalls scrapen: Das ist rechtlich und ethisch problematisch.

- Aktivitäten protokollieren und Fehler abfangen: Bei Blockaden lieber pausieren und die Strategie anpassen.

Mehr zu Ethik und Recht beim Scraping findest du in .

Fazit: Das richtige Tool für deine Web-Scraping-Projekte

Web Scraping hat sich enorm weiterentwickelt – von manuellen Skripten bis zu KI-gestützten No-Code-Tools. Selenium Python ist für Entwickler, die komplexe, dynamische Seiten auslesen wollen, eine starke Option – aber mit Lernkurve und Wartungsaufwand. Für die meisten Business-Anwender bietet Thunderbit einen schnelleren, einfacheren Weg zu strukturierten Webdaten – inklusive Übersetzung, Sentiment-Analyse und Export mit einem Klick.

Mein Tipp: Probiere beide Ansätze aus. Wenn du Entwickler bist, schreibe ein Selenium-Skript für eine Seite wie und schau, wie aufwendig es ist. Wenn du schnelle Ergebnisse willst (oder dir den Aufwand sparen möchtest), teste – es gibt eine kostenlose Version, mit der du direkt loslegen kannst.

Und denk daran: Scrape verantwortungsvoll, nutze deine Daten sinnvoll – und möge deine IP nie gesperrt werden.

Du willst mehr erfahren? Hier findest du weiterführende Ressourcen: