Stell dir vor: Es ist Dienstag, 14 Uhr. Dein Chef kommt spontan vorbei und will eine Preisliste der Konkurrenz – und du sitzt vor einer Webseite, voll mit wertvollen Infos, die aber tief im HTML-Dschungel versteckt sind. Greifst du jetzt direkt zum Python Web-Scraper? Oder wünschst du dir insgeheim einen magischen Knopf, der alles für dich erledigt?

Web Scraping ist längst nicht mehr nur was für Nerds oder Datenprofis mit drei Monitoren. Heute ist es eine Kernkompetenz für Business-Teams, Marketing, Forschung – kurz: für alle, die Webseiten in strukturierte Daten verwandeln wollen. Die Branche boomt: – und es geht steil bergauf. Aber bei der Masse an Tools fühlt sich die Auswahl oft an wie die Frage: Schweizer Taschenmesser oder Präzisionsmesser? Heute schauen wir uns die beiden Python-Klassiker Scrapy und Beautiful Soup genauer an – und zeigen, wie No-Code-KI-Tools wie für alle, die nicht programmieren wollen, eine echte Alternative sind.

Scrapy vs. Beautiful Soup: Die Basics beim Python Web Scraping

Wer schon mal nach „Python Web-Scraper“ gesucht hat, ist an Scrapy und Beautiful Soup kaum vorbeigekommen. Beide sind feste Größen im Python-Universum – aber sie haben ganz unterschiedliche Stärken.

- Scrapy ist ein Framework. Stell dir eine komplette Profiküche vor: Scrapy übernimmt das Laden der Seiten, das Folgen von Links, das Parsen der Daten und den Export – alles aus einer Hand. Perfekt für große Projekte mit vielen Seiten und komplexen Anforderungen.

- Beautiful Soup ist eine Bibliothek. Sie ist wie ein scharfes Küchenmesser: Ideal, um HTML zu zerschneiden und gezielt Daten rauszupicken. Aber das Drumherum – also das Laden der Seite, das Durchklicken, das Speichern – musst du selbst erledigen.

Mit beiden Tools kannst du sogenannte „Python Web-Scraper“ bauen – also Skripte, die Daten aus Webseiten ziehen. Die Wahl hängt aber nicht nur von den Features ab, sondern auch davon, wie viel du selbst coden willst.

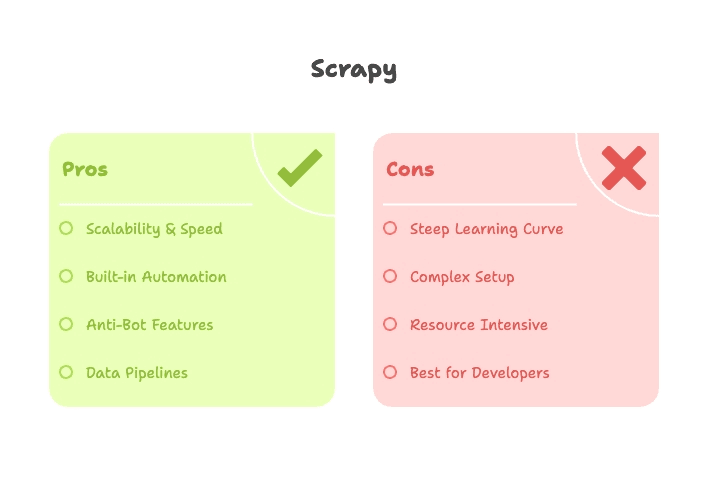

Wann ist Scrapy die richtige Wahl? Power und Skalierbarkeit für große Scraping-Projekte

Angenommen, du sollst einen kompletten Online-Shop mit tausenden Produktseiten regelmäßig auslesen – inklusive Updates und Schutz vor Anti-Bot-Maßnahmen. Genau hier spielt Scrapy seine Stärken aus.

Scrapy ist für große, automatisierte Web-Scraping-Projekte gemacht. Es bietet dir:

- Asynchrone Anfragen: Viele Seiten gleichzeitig abfragen, nicht eine nach der anderen.

- Integriertes Crawling: Automatisches Folgen von Links, Paginierung und Verwaltung der URL-Warteschlange.

- Pipelines: Daten bereinigen, prüfen und direkt als CSV, JSON oder in Datenbanken exportieren – ohne Zusatzcode.

- Proxy- und User-Agent-Rotation: Mitgelieferte Middleware hilft, einfache Blockaden zu umgehen.

- Zeitplanung: Scrapy-Spider können regelmäßig und automatisiert laufen – ideal für Monitoring und Datenaktualisierung.

Wenn du ein System brauchst, das täglich läuft, Fehler abfängt und mit deinen Anforderungen wächst, ist Scrapy wie ein eingespieltes Küchenteam.

Scrapy: Die Stärken für Python Web-Scraper-Projekte

- Skalierbarkeit: Scrapy kann tausende oder sogar Millionen Seiten effizient und parallel abarbeiten ().

- Geschwindigkeit: Durch asynchrones Design besonders flott bei großen Datenmengen ().

- Erweiterbarkeit: Egal ob CAPTCHAs, JavaScript-Rendering oder Export zu S3 – für fast alles gibt’s Plugins oder Middleware.

- Automatisierung: Scrapy ist für den Dauerbetrieb gebaut – einmal einrichten, dann läuft’s von selbst.

Wo Scrapy an seine Grenzen stößt

Aber: Scrapy ist kein Tool für absolute Anfänger. Du musst dich mit Spidern, Pipelines, Middleware und Projektstrukturen auskennen. Die Installation kann tricky sein (Stichwort: Twisted-Abhängigkeiten) und das Debuggen von Selektoren braucht Geduld.

- Hohe Einstiegshürde: Bis der erste Spider läuft, vergehen oft einige Stunden oder Tage ().

- Für kleine Aufgaben zu mächtig: Wer nur eine einzelne Seite auslesen will, ist mit Scrapy meist nicht gut beraten.

- JavaScript-lastige Seiten: Scrapy kann von Haus aus kein JavaScript ausführen – dafür braucht’s Zusatztools wie Splash oder Selenium.

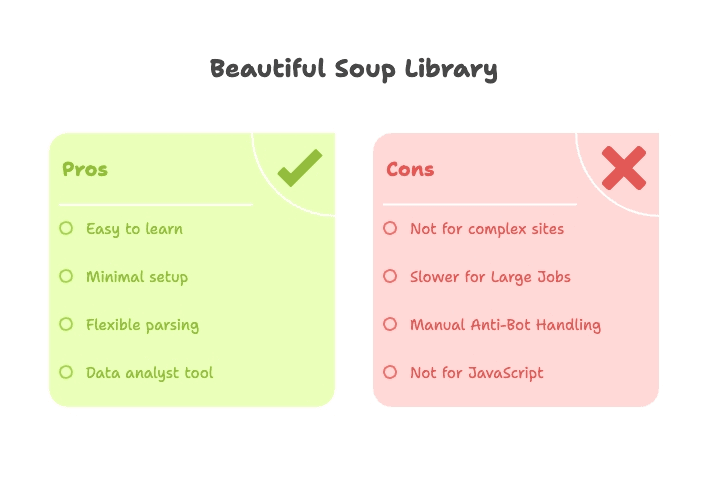

Beautiful Soup: Schnell, flexibel und ideal für Einsteiger

Du willst nur die aktuellen Schlagzeilen einer Nachrichtenseite abgreifen oder eine Tabelle von Wikipedia für eine einmalige Analyse extrahieren? Hier glänzt Beautiful Soup.

Beautiful Soup ist eine schlanke Bibliothek zum Parsen von HTML und XML. Sie lädt keine Webseiten selbst – dafür kombinierst du sie meist mit der requests-Bibliothek, um das HTML zu holen, und nutzt dann Beautiful Soup, um gezielt die gewünschten Daten herauszufiltern.

- Kaum Einrichtung nötig: Mit pip installieren, importieren und loslegen.

- Sanfte Lernkurve: Auch ohne große Python-Erfahrung kommst du schnell zu Ergebnissen ().

- Flexibles Parsen: Nach Tags, Klassen, IDs oder Text suchen – ideal für unübersichtliches oder fehlerhaftes HTML.

Vorteile von Beautiful Soup für Python Web-Scraper-Einsteiger

- Einsteigerfreundlich: Keine Framework-Kenntnisse nötig – Grundkenntnisse in Python und HTML reichen.

- Schnelle Ergebnisse: Perfekt für Prototypen, Studien oder einmalige Datenabfragen.

- Flexibel: Lässt sich leicht mit anderen Python-Tools wie requests oder pandas kombinieren.

- Robust bei fehlerhaftem HTML: Beautiful Soup verzeiht auch unsauberen Code.

Die Grenzen von Beautiful Soup

Beautiful Soup ist kein Komplettwerkzeug:

- Kein integriertes Crawling: Du musst selbst durch Seiten iterieren oder Links verfolgen.

- Langsam bei großen Datenmengen: Arbeitet sequentiell – bei vielen Seiten wird’s schnell zäh.

- Wenig Schutz vor Blockaden: Header oder Proxies musst du selbst setzen, Anti-Bot-Mechanismen sind nicht integriert.

- Nicht für dynamische Inhalte: Bei JavaScript-basierten Seiten brauchst du zusätzliche Tools wie Selenium oder Playwright.

Scrapy vs. Beautiful Soup: Der direkte Vergleich

Hier der Überblick im direkten Vergleich:

| Funktion | Scrapy | Beautiful Soup |

|---|---|---|

| Typ | Framework (All-in-One) | Bibliothek (nur Parser) |

| Einrichtung | Projektstruktur, CLI, Konfigurationsdateien | Einfaches Skript, pip-Installation |

| Optimal für | Große, wiederkehrende, automatisierte Scraping-Projekte | Kleine Aufgaben, Prototypen, Einzelabfragen |

| Geschwindigkeit | Schnell bei großen Datenmengen (async, parallel) | Schnell bei Einzelseiten, langsam bei Masse |

| Crawling | Integriert (folgt Links, Paginierung) | Manuell (eigene Schleifen nötig) |

| Anti-Bot-Features | Proxies, User-Agent-Rotation, Wiederholungen, Plugins | Manuell (Header, Proxies in requests) |

| Erweiterbarkeit | Plugins, Middleware, Pipelines | Kombinierbar mit anderen Python-Bibliotheken |

| Lernkurve | Anspruchsvoll (Spiders, Pipelines, Async) | Einfach (Grundlagen Python + HTML) |

| Dynamische Inhalte | Plugins nötig (Splash, Selenium) | Selenium/Playwright erforderlich |

| Datenexport | CSV, JSON, Datenbanken (integriert) | Manuell (Datei schreiben oder pandas nutzen) |

| Zielgruppe | Entwickler, Data Engineers, laufende Projekte | Einsteiger, Analysten, schnelle Skripte |

Kurz gesagt: Scrapy ist die erste Wahl für große, komplexe oder wiederkehrende Scraping-Aufgaben – vorausgesetzt, du bist mit Python und Frameworks vertraut. Beautiful Soup eignet sich perfekt für kleine, gezielte Aufgaben oder den Einstieg ins Thema.

Lernkurve: Welcher Python Web-Scraper ist einsteigerfreundlicher?

Mal ehrlich: Niemand will eine Woche investieren, nur um eine Tabelle von einer Webseite zu holen.

- Beautiful Soup: Vom Einstieg bis zum ersten Ergebnis vergehen oft nur wenige Stunden. Grundkenntnisse in Python und ein bisschen HTML reichen. Es gibt viele Tutorials und schnelle Erfolgserlebnisse ().

- Scrapy: Du musst dich mit Spidern, Pipelines, asynchronen Abläufen und Kommandozeilentools beschäftigen. Kein Hexenwerk, aber deutlich mehr als ein einfaches „Hello World“-Skript ().

Für Nicht-Techniker oder alle, die schnell ans Ziel wollen, ist Beautiful Soup der angenehmere Einstieg. Wer aber ein robustes, skalierbares Scraping-System aufbauen will, profitiert langfristig von Scrapy.

Performance & Anti-Bot: Scrapy und Beautiful Soup im Praxistest

Performance:

- Scrapy: Unterstützt von Haus aus parallele Anfragen. So kannst du 16, 32 oder mehr Seiten gleichzeitig abfragen – ideal für große Datenmengen ().

- Beautiful Soup: Arbeitet sequentiell, es sei denn, du baust eigene Threading- oder Async-Logik ein. Für wenige Seiten top, bei vielen Seiten langsam.

Anti-Bot:

- Scrapy: Bietet Middleware für Proxies, User-Agent-Rotation, Wiederholungen und sogar Plugins für CAPTCHAs oder JavaScript ().

- Beautiful Soup: Hier bist du auf dich allein gestellt. Header und Proxies musst du selbst setzen, Blockaden musst du manuell umgehen ().

Typische Anwendungsfälle: Welcher Python Web-Scraper passt zu deinem Projekt?

Hier eine praktische Übersicht:

| Anwendungsfall | Bestes Tool | Warum? |

|---|---|---|

| Lead-Generierung (kleine Menge) | Beautiful Soup | Schnelle, einmalige Extraktion weniger Seiten |

| Lead-Generierung (groß/regelmäßig) | Scrapy oder Thunderbit | Scrapy für Entwickler, Thunderbit für Nicht-Techniker – beide skalierbar und automatisierbar |

| Preisüberwachung im E-Commerce | Scrapy oder Thunderbit | Scrapy für individuelle, laufende Crawls; Thunderbit für sofortiges, codefreies Scraping |

| Content-/News-Monitoring | Scrapy oder Thunderbit | Scrapy für geplante, mehrseitige Crawls; Thunderbit für Business-User, schnelle Einrichtung |

| SEO-Audits (wenige Seiten) | Beautiful Soup | Einfach zu skripten, schnelle Ergebnisse |

| SEO-Audits (ganze Website) | Scrapy | Hunderte Seiten crawlen, strukturierte Daten exportieren |

| Social Media Scraping | Thunderbit | Vorgefertigte Templates, dynamische Inhalte, kein Coding nötig |

| Wissenschaftliche Einmalprojekte | Beautiful Soup | Schnelles Prototyping, minimale Einrichtung |

| Datenanreicherung/-aggregation | Thunderbit | KI-gestützte Anreicherung, einfacher Export zu Sheets/Airtable |

Gerade für Business-Anwender, die nicht programmieren, sind Tools wie ein echter Gamechanger – oder besser gesagt: ein enormer Zeitgewinn.

Jenseits von Python: Thunderbit als No-Code-Lösung für Web Scraping

Kommen wir zum Punkt: Nicht jeder will programmieren. Und ehrlich gesagt – das muss auch nicht sein, wenn du einfach nur eine Webseite in eine Tabelle verwandeln willst.

Hier kommt ins Spiel. Thunderbit ist ein No-Code KI-Web-Scraper – eine Chrome-Erweiterung, mit der du Daten aus jeder beliebigen Webseite mit wenigen Klicks extrahieren kannst. So funktioniert’s:

- Kein Python, keine Einrichtung: Erweiterung installieren, Seite öffnen, loslegen.

- KI-Feldvorschläge: Mit „AI Suggest Fields“ erkennt Thunderbit automatisch relevante Spalten und baut deine Tabelle selbstständig auf ().

- Unterseiten-Scraping: Du brauchst Details von verlinkten Seiten? Thunderbit folgt Links und reichert deine Daten an – ganz ohne verschachtelte Schleifen oder Spider ().

- Paginierung & Endlos-Scroll: Mehrseitige Listen oder unendliches Scrollen? Ein Klick genügt.

- Sofortiger Datenexport: Exportiere deine Daten direkt nach Google Sheets, Airtable, Notion oder als CSV/Excel ().

- Live-Vorschau: Sieh die Ergebnisse schon beim Scrapen – kein „Run & Pray“ mehr.

- KI-gestützte Anreicherung: Daten direkt zusammenfassen, kategorisieren oder übersetzen ().

Thunderbit bietet außerdem vorgefertigte Templates für beliebte Seiten wie Amazon, LinkedIn, Google Maps und viele mehr. Für die meisten Business-Anforderungen ist es so nah an „Knopfdruck“ wie möglich.

Warum Thunderbit statt Python Web-Scraping-Tools?

- Keine Lernkurve: Du brauchst weder Python noch HTML-Kenntnisse – und auch keine Fehlersuche bei 403-Fehlern. Wer einen Browser bedienen kann, kann Thunderbit nutzen.

- Geschwindigkeit: Von „Ich brauche diese Daten“ zu „Hier ist die Tabelle“ in wenigen Minuten – statt Stunden oder Tagen.

- Wartungsfrei: Thunderbits KI passt sich vielen Webseitenänderungen automatisch an, Templates werden vom Team gepflegt. Keine nächtlichen Script-Abstürze mehr.

- Anti-Bot-Handling: Läuft im Browser (wie ein echter Nutzer) oder in der Cloud – mit integrierten Strategien gegen Blockaden.

- Zusammenarbeit: Templates und Ergebnisse lassen sich einfach im Team teilen – ganz ohne Code-Repos oder Versionskontrolle.

- Kosteneffizient: Kostenlos für kleine Aufgaben, günstige Tarife für größere Projekte ().

Für Vertrieb, Marketing, Operations oder alle, die einfach schnell an Daten kommen wollen, ist Thunderbit eine echte Erleichterung. (Und als jemand, der schon viele Nächte mit Python-Fehlersuche verbracht hat, weiß ich das sehr zu schätzen.)

Welches Web-Scraping-Tool passt zu mir? Die Entscheidungshilfe

Welches Tool ist nun das richtige? Hier ein kompakter Entscheidungsbaum:

- Kennst du dich mit Python-Programmierung aus?

- Ja: Weiter zu Schritt 2.

- Nein: Nutze oder ein anderes No-Code-Tool.

- Ist dein Projekt klein (eine Seite, einmalig, Prototyp)?

- Ja: Beautiful Soup (mit requests) verwenden.

- Nein: Für große, wiederkehrende oder komplexe Aufgaben Scrapy nutzen.

- Musst du Anti-Bot-Maßnahmen, Parallelität oder Automatisierung abdecken?

- Ja: Scrapy ist die beste Wahl.

- Nein: Für einfache, risikoarme Aufgaben reicht Beautiful Soup.

- Willst du sofortige Ergebnisse, einfachen Export oder Teamarbeit?

- Ja: Thunderbit ist die beste Lösung – ohne Code, ohne Aufwand.

Hier die Übersicht als Checkliste:

| Ihr Bedarf | Bestes Tool |

|---|---|

| Kein Coding, sofortige Ergebnisse | Thunderbit |

| Kleine, einmalige, skriptbare Aufgabe | Beautiful Soup |

| Große, automatisierte, komplexe Crawls | Scrapy |

| Laufende Geschäftsdaten-Erfassung | Thunderbit oder Scrapy |

| Wissenschaftliches Prototyping | Beautiful Soup |

Fazit: Scrapy, Beautiful Soup oder Thunderbit – was passt zu dir?

Web Scraping ist heute zugänglicher – und wichtiger – denn je. Egal, ob du als Entwickler robuste Datenpipelines baust oder als Business-Anwender einfach eine Webseite in eine Tabelle verwandeln willst: Es gibt das passende Tool.

- Scrapy: Ideal für Entwickler, große, wiederkehrende oder komplexe Scraping-Projekte. Leistungsstark, aber mit Lernkurve.

- Beautiful Soup: Perfekt für Einsteiger, Analysten oder alle, die schnell Daten aus wenigen Seiten ziehen wollen. Einfach, flexibel, ideal für Prototypen.

- Thunderbit: Die No-Code-KI-Lösung für alle anderen. Wer auf Coding, Fehlersuche und Wartung verzichten will, kann mit Thunderbit in Minuten Daten extrahieren, anreichern und exportieren – direkt im Browser.

Wenn du No-Code-Scraping ausprobieren willst, und leg los. Oder stöbere in unserem für weitere Anleitungen, Tipps und Praxisbeispiele.

Am Ende zählt: Das beste Tool ist das, mit dem du deine Daten schnell und stressfrei bekommst – und dein Dienstag nicht in einer Python-Fehlersuche endet. Und falls du mal Web-Scraping-Anekdoten austauschen willst, weißt du, wo du mich findest.

FAQs

1. Was ist für Einsteiger besser: Scrapy oder Beautiful Soup?

Beautiful Soup ist deutlich einsteigerfreundlicher. Die Installation ist einfach, die Bedienung intuitiv und für kleine Scraping-Aufgaben ideal. Scrapy ist zwar leistungsstark, aber mit einer steileren Lernkurve – am besten für Entwickler, die große oder wiederkehrende Crawler bauen möchten.

2. Kann ich Scrapy oder Beautiful Soup ohne Programmierkenntnisse nutzen?

Nicht wirklich. Beide Tools setzen Python-Kenntnisse und ein Grundverständnis von HTML voraus. Wer keine Skripte schreiben möchte, ist mit einem No-Code-Tool wie besser beraten – hier kannst du direkt im Browser und in Alltagssprache Daten extrahieren.

3. Muss ich Scrapy und Beautiful Soup zusammen verwenden?

In den meisten Fällen nicht. Scrapy bringt einen eigenen Parser mit und funktioniert unabhängig. Beautiful Soup wird meist allein für kleinere Aufgaben genutzt. Fortgeschrittene Nutzer kombinieren beide manchmal, aber für schnelle, praktische Ergebnisse ist das selten nötig.

4. Was, wenn die Seite JavaScript oder Endlos-Scroll nutzt?

Weder Scrapy noch Beautiful Soup können JavaScript von Haus aus ausführen – dafür braucht’s Zusatztools wie Selenium. kann viele moderne Webseiten automatisch verarbeiten, auch mit Endlos-Scroll oder dynamischen Inhalten.

5. Ich will nur eine Webseite in eine Tabelle verwandeln. Muss ich dafür Python lernen?

Nein. Wer einfach nur strukturierte Daten – etwa eine Preisliste oder ein Verzeichnis – in Excel holen will, muss nicht extra Scrapy oder Beautiful Soup lernen. erledigt das in zwei Klicks, ganz ohne Programmierung.

Neugierig geworden? Lies , oder stöbere weiter im .