Lass mich dich mal mitnehmen zu meinem allerersten Versuch, Produktdaten von einer E-Commerce-Seite zu ziehen. Ausgestattet mit Python, einer frischen Tasse Kaffee und dem Plan, einen Preis-Tracker für Amazon zu basteln, war ich voller Tatendrang. Nach ein paar Stunden war aus dem „schnellen Projekt“ ein ziemliches Chaos aus XPath-Selektoren, Paginierungsproblemen und endlosem Debugging geworden. Wer schon mal versucht hat, Webdaten per Code zu sammeln, kennt das Gefühl: Erst Euphorie, dann die Frage „Warum ist das eigentlich so kompliziert?“

Das Spannende daran: Web-Scraping ist längst nicht mehr nur ein Thema für Data Scientists oder Entwickler. Heute ist es eine echte Schlüsselqualifikation für Vertrieb, E-Commerce-Manager, Marketing und alle, die aus dem Datenwust des Internets wertvolle Infos ziehen wollen. Der Markt für Web-Scraping-Software lag – und wächst weiter. Python und Frameworks wie Scrapy sind zwar immer noch das Maß der Dinge für große, individuelle Scraping-Projekte, aber für Einsteiger sind sie oft eine echte Hürde. Deshalb zeige ich dir in diesem Tutorial Schritt für Schritt, wie du mit Scrapy arbeitest – am Beispiel Amazon – und stelle dir eine viel einfachere, KI-gestützte Alternative für Nicht-Programmierer vor: .

Was ist Scrapy Python? Dein Profi-Tool fürs Web-Scraping

Starten wir mit den Basics. Scrapy ist ein Open-Source-Framework für Python, das speziell fürs Web-Crawling und -Scraping entwickelt wurde. Stell dir Scrapy wie einen Werkzeugkasten vor, mit dem du eigene „Spiders“ (so nennt Scrapy seine Crawler) baust, Websites durchstöberst, Links folgst, Paginierung meisterst und strukturierte Daten im großen Stil extrahierst.

Was unterscheidet Scrapy von einfachen Python-Bibliotheken wie requests und BeautifulSoup? Während diese für kleine, einmalige Aufgaben super sind, ist Scrapy für große, komplexe Projekte gemacht – also wenn du zum Beispiel:

- Tausende Seiten durchforsten willst (z. B. das komplette Produktsortiment eines Shops)

- Automatisch Links und Paginierung abbilden möchtest

- Daten asynchron und damit besonders flott verarbeiten willst

- Deine Daten sauber, strukturiert und wiederholbar exportieren möchtest

Kurz gesagt: Scrapy ist das Schweizer Taschenmesser unter den Web-Scraping-Tools – mächtig, flexibel, aber für Einsteiger durchaus fordernd.

Warum Scrapy Python fürs Web-Scraping nutzen?

Warum greifen Entwickler und Datenteams immer wieder zu Scrapy? Hier die wichtigsten Vorteile auf einen Blick:

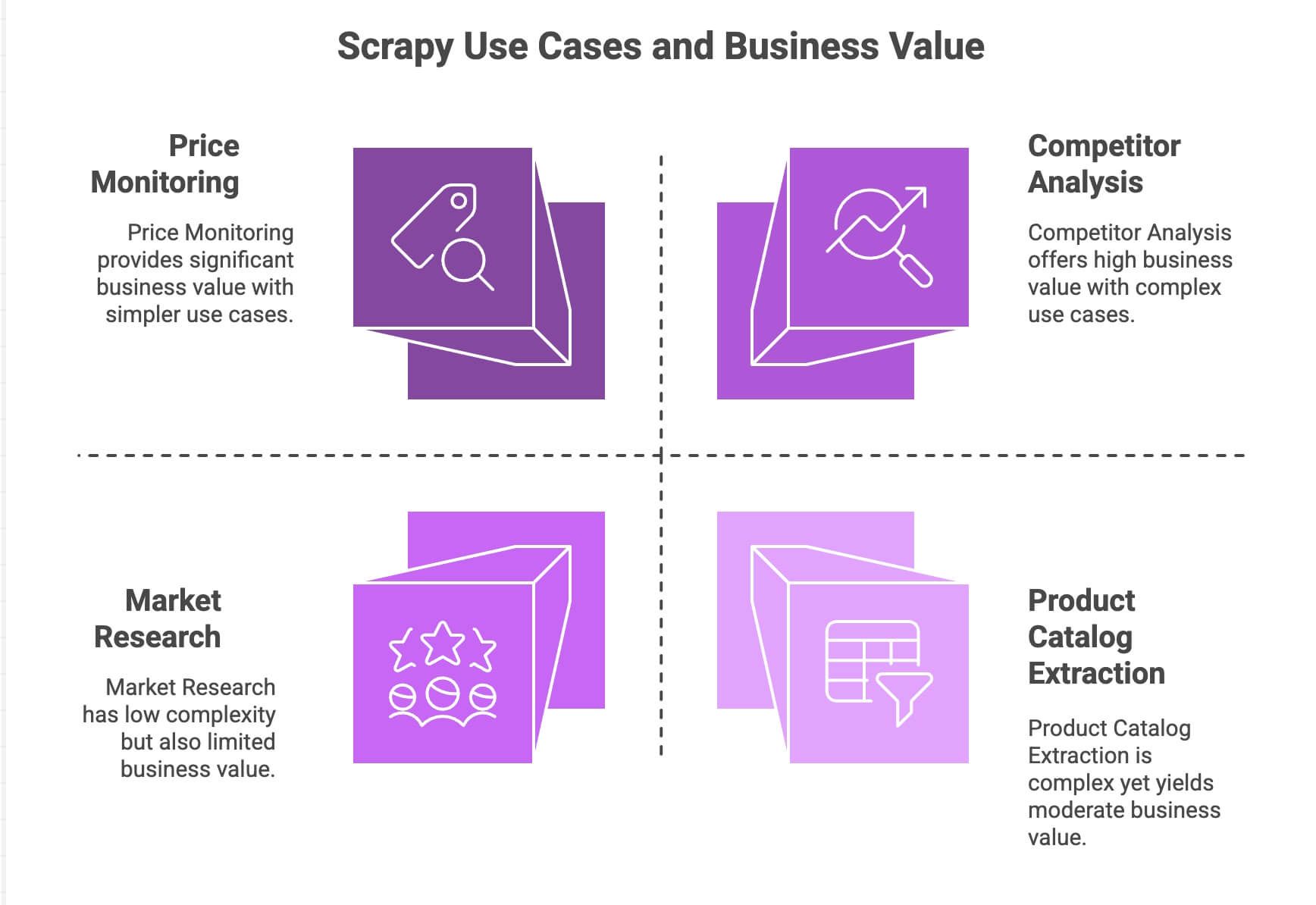

| Anwendungsfall | Stärken von Scrapy | Business-Nutzen |

|---|---|---|

| Preisüberwachung | Beherrscht Paginierung, asynchrone Requests, Zeitplanung | Konkurrenz im Blick, dynamische Preisgestaltung |

| Produktkatalog-Extraktion | Folgt Links, extrahiert strukturierte Daten | Aufbau von Produktdatenbanken, Analytics-Feeds |

| Wettbewerbsanalyse | Skalierbar, robust bei Website-Änderungen | Trends, neue Produkte, Lagerbestände verfolgen |

| Marktforschung | Modulare Pipelines für Datenbereinigung/-transformation | Bewertungen aggregieren, Sentiment-Analysen durchführen |

Dank des asynchronen Kerns (basiert auf Twisted) kann Scrapy viele Seiten gleichzeitig abfragen – das macht es schnell und skalierbar. Die modulare Architektur erlaubt es, eigene Logik (z. B. Proxys, User-Agents, Datenbereinigung) flexibel einzubinden. Und mit Pipelines kannst du deine Daten nach Belieben verarbeiten, prüfen und in jedes gewünschte Format exportieren – egal ob CSV, JSON oder direkt in eine Datenbank.

Für Teams mit Python-Know-how ist Scrapy ein echtes Power-Tool. Aber: Für die meisten Business-Anwender ist es alles andere als selbsterklärend.

Scrapy Python: So richtest du deine Umgebung ein

Bereit für den Einstieg? So installierst du Scrapy Schritt für Schritt:

1. Scrapy installieren

Stell sicher, dass Python 3.9 oder neuer auf deinem Rechner läuft. Öffne dann das Terminal und gib ein:

1pip install scrapyMit folgendem Befehl prüfst du, ob alles geklappt hat:

1scrapy versionUnter Windows oder mit Anaconda empfiehlt sich ein virtuelles Environment, um Ärger mit Abhängigkeiten zu vermeiden. Scrapy läuft auf Windows, macOS und Linux.

2. Ein neues Scrapy-Projekt anlegen

Starte ein neues Projekt, z. B. amazonscraper:

1scrapy startproject amazonscraperDie Ordnerstruktur sieht dann so aus:

1amazonscraper/

2├── scrapy.cfg

3├── amazonscraper/

4│ ├── __init__.py

5│ ├── items.py

6│ ├── pipelines.py

7│ ├── middlewares.py

8│ ├── settings.py

9│ └── spiders/Wofür sind diese Dateien?

scrapy.cfg: Projekt-Konfiguration (meist bleibt die so)items.py: Hier legst du deine Datenmodelle an (z. B. Produkt mit Name, Preis etc.)pipelines.py: Hier werden Daten bereinigt, geprüft und exportiertmiddlewares.py: Für fortgeschrittene Einstellungen (Proxys, eigene Header)settings.py: Hier steuerst du Scrapy-Parameter (z. B. Parallelität, Wartezeiten)spiders/: Hier liegt die eigentliche Scraping-Logik

Falls du jetzt schon denkst „Puh, das ist viel“: Du bist nicht allein. Genau hier steigen viele Nicht-Programmierer aus.

Python Web-Scraper bauen: Amazon-Produktdaten mit Scrapy extrahieren

Gehen wir ein Praxisbeispiel durch: Wir holen Produktdaten aus den Amazon-Suchergebnissen. (Achtung: Das Scrapen von Amazon ist laut deren Nutzungsbedingungen nicht erlaubt und Amazon setzt starke Anti-Bot-Maßnahmen ein. Dieses Beispiel ist nur zu Lernzwecken!)

1. Einen Spider erstellen

Lege im Ordner spiders/ eine Datei namens amazon_spider.py an:

1import scrapy

2class AmazonSpider(scrapy.Spider):

3 name = "amazon_example"

4 allowed_domains = ["amazon.com"]

5 start_urls = ["https://www.amazon.com/s?k=smartphones"]

6 def parse(self, response):

7 products = response.xpath("//div[@data-component-type='s-search-result']")

8 for product in products:

9 yield {

10 'name': product.xpath(".//span[@class='a-size-medium a-color-base a-text-normal']/text()").get(),

11 'price': product.xpath(".//span[@class='a-price-whole']/text()").get(),

12 'rating': product.xpath(".//span[@aria-label]/text()").get()

13 }

14 next_page = response.xpath("//li[@class='a-last']/a/@href").get()

15 if next_page:

16 yield scrapy.Request(url=response.urljoin(next_page), callback=self.parse)Was passiert hier?

- Wir starten auf einer Amazon-Suchergebnisseite für „Smartphones“.

- Für jedes Produkt werden Name, Preis und Bewertung per XPath extrahiert.

- Der „Nächste Seite“-Link wird gesucht und Scrapy folgt ihm, um weitere Produkte zu erfassen.

2. Spider ausführen

Im Projektverzeichnis ausführen:

1scrapy crawl amazon_example -o products.jsonFertig – Scrapy durchforstet die Suchergebnisse, folgt der Paginierung und speichert die Daten als JSON-Datei.

Paginierung und dynamische Inhalte meistern

Scrapy kann Links und Paginierung von Haus aus abbilden – das ist eine seiner größten Stärken. Aber was ist mit dynamischen Inhalten, die per JavaScript nachgeladen werden? Standardmäßig sieht Scrapy nur das statische HTML. Für Inhalte, die erst durch JavaScript erscheinen (z. B. Infinite Scroll oder Pop-up-Bewertungen), musst du Tools wie Selenium oder Splash einbinden – das ist ein eigenes Thema für sich.

Daten mit Scrapy Python verarbeiten und exportieren

Nach dem Scraping willst du deine Daten meist noch aufbereiten und weiterverarbeiten.

- Pipelines: In

pipelines.pykannst du Python-Klassen schreiben, um Daten zu bereinigen, zu prüfen oder anzureichern (z. B. Preise in Zahlen umwandeln, unvollständige Zeilen rauswerfen oder Übersetzungs-APIs nutzen). - Export: Scrapy exportiert mit dem

-o-Flag direkt in CSV, JSON oder XML. Für komplexere Exporte (z. B. nach Google Sheets) brauchst du zusätzlichen Code oder eine externe Bibliothek.

Du willst Sentiment-Analysen oder Übersetzungen? Dafür musst du externe APIs oder Python-Bibliotheken anbinden – Scrapy bringt das nicht von Haus aus mit.

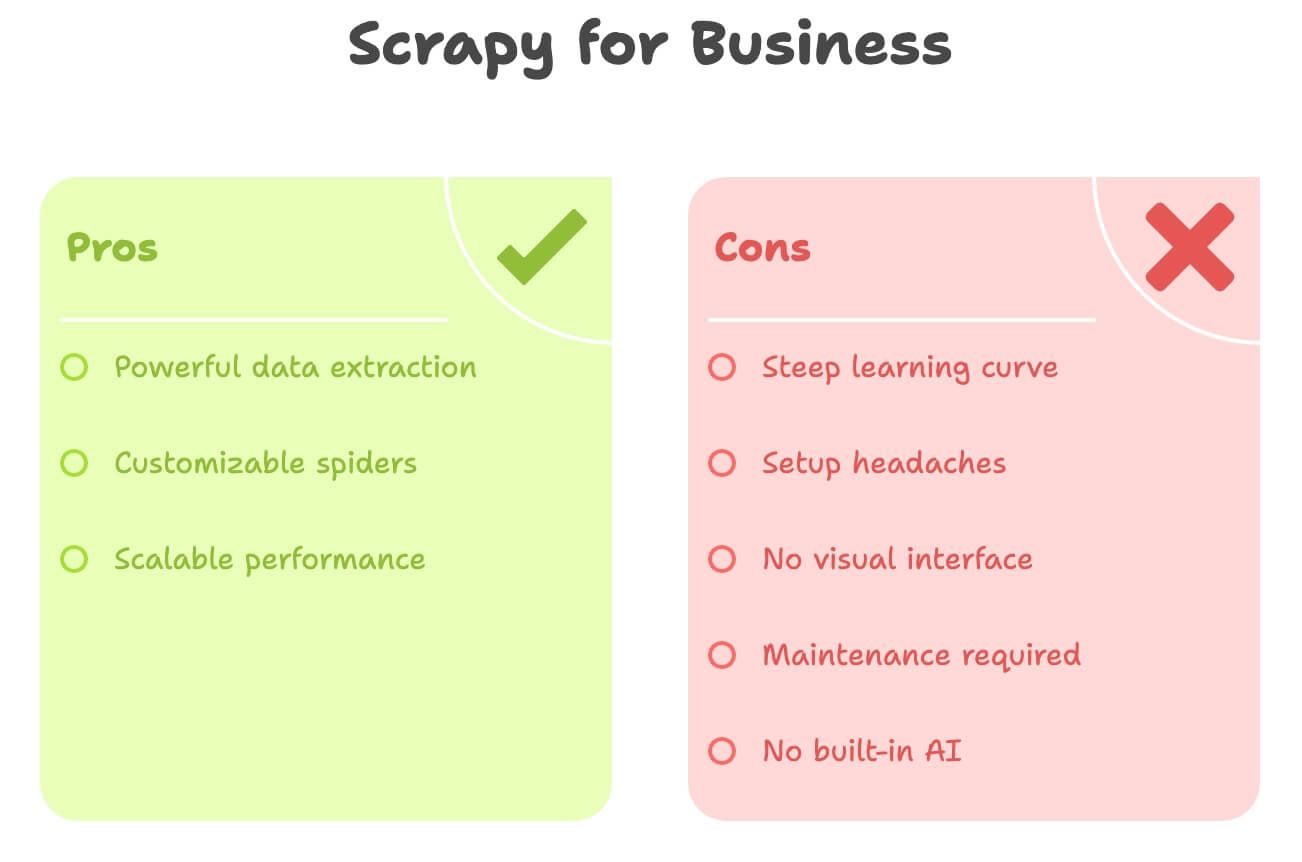

Die versteckten Hürden: Scrapy Python aus Business-Sicht

Ganz ehrlich: Scrapy ist mächtig, aber für Nicht-Entwickler alles andere als intuitiv. Das sind die größten Stolpersteine:

- Hohe Einstiegshürde: Du brauchst Kenntnisse in Python, HTML, XPath/CSS-Selektoren und der Scrapy-Projektstruktur. Bis man sich sicher fühlt, vergeht oft einiges an Zeit.

- Aufwendige Einrichtung: Python-Installation, Abhängigkeitsmanagement und Fehlersuche können gerade unter Windows nerven.

- Keine visuelle Oberfläche: Alles läuft über Code. Du kannst nicht einfach auf ein Element klicken, um es auszuwählen.

- Wartung: Ändert sich die Website, funktioniert dein Spider nicht mehr – und du musst nachbessern.

- Keine integrierte KI: Übersetzen, Zusammenfassen oder Sentiment-Analysen? Dafür ist zusätzlicher Code nötig.

Hier ein schneller Vergleich:

| Herausforderung | Scrapy (Python) | Business-Anforderungen |

|---|---|---|

| Programmierkenntnisse nötig | Ja | Lieber ohne Code |

| Einrichtungszeit | Stunden (oder Tage) | Minuten |

| Wartung | Laufend (bei Website-Änderungen) | Minimal |

| Datenexport | CSV/JSON (manuelle Integration) | Direkt nach Excel/Sheets/Notion |

| KI-Funktionen | Keine (selbst integrieren) | Übersetzung/Sentiment integriert |

Für Solo-Marketer, Vertrieb oder Operations fühlt sich Scrapy oft wie mit Kanonen auf Spatzen schießen an.

Thunderbit: Die No-Code-Alternative zu Scrapy Python

Hier kommt ins Spiel. Nach Jahren in der Automatisierung weiß ich: Die meisten Business-Anwender wollen nicht programmieren – sie wollen einfach schnell an die Daten.

Thunderbit ist ein KI-Web-Scraper als Chrome-Erweiterung. Entwickelt für alle, die ohne Technikkenntnisse:

- Mit wenigen Klicks Daten von jeder Website extrahieren möchten

- In natürlicher Sprache beschreiben, was sie brauchen („Produktname, Preis, Bewertung“)

- Paginierung und Unterseiten automatisch abbilden lassen

- Daten direkt nach Excel, Google Sheets, Airtable oder Notion exportieren

- Übersetzen, zusammenfassen oder Sentiment-Analysen direkt im Tool nutzen wollen

Kein Python. Keine Selektoren. Keine Wartungsprobleme.

Thunderbit richtet sich an Business-Anwender, die schnell Ergebnisse wollen und die KI die Arbeit machen lassen.

Thunderbit vs. Scrapy Python: Der Direktvergleich

Hier die beiden Tools im Überblick:

| Kriterium | Scrapy (Python) | Thunderbit (KI-Tool) |

|---|---|---|

| Erforderliche Kenntnisse | Python, HTML, Selektoren | Keine – Point & Click, natürliche Sprache |

| Einrichtungszeit | Stunden (Installation, Code, Debugging) | Minuten (Chrome-Erweiterung, Login) |

| Datenstrukturierung | Manuell (Items, Pipelines definieren) | KI erkennt Spalten, schlägt Felder vor |

| Paginierung/Unterseiten | Code nötig | 1 Klick (KI übernimmt) |

| Übersetzung | Eigener Code/API nötig | Integriert – einfach „Übersetzen“ aktivieren |

| Sentiment-Analyse | Externe Bibliothek/API | Integriert – „Sentiment“-Spalte hinzufügen |

| Exportoptionen | CSV/JSON (manueller Import) | 1 Klick nach Excel, Google Sheets, Airtable, Notion |

| Wartung | Manuell (Code anpassen bei Änderungen) | KI passt sich kleinen Änderungen automatisch an |

| Skalierung | Ideal für große, laufende Projekte | Optimal für schnelle Aufgaben, mittlere Datenmengen |

| Kosten | Kostenlos (aber Zeit-/Entwickleraufwand) | Kostenloser Einstieg + bezahlte Pläne (ab 9 $/Monat, spart viel Zeit und Nerven) |

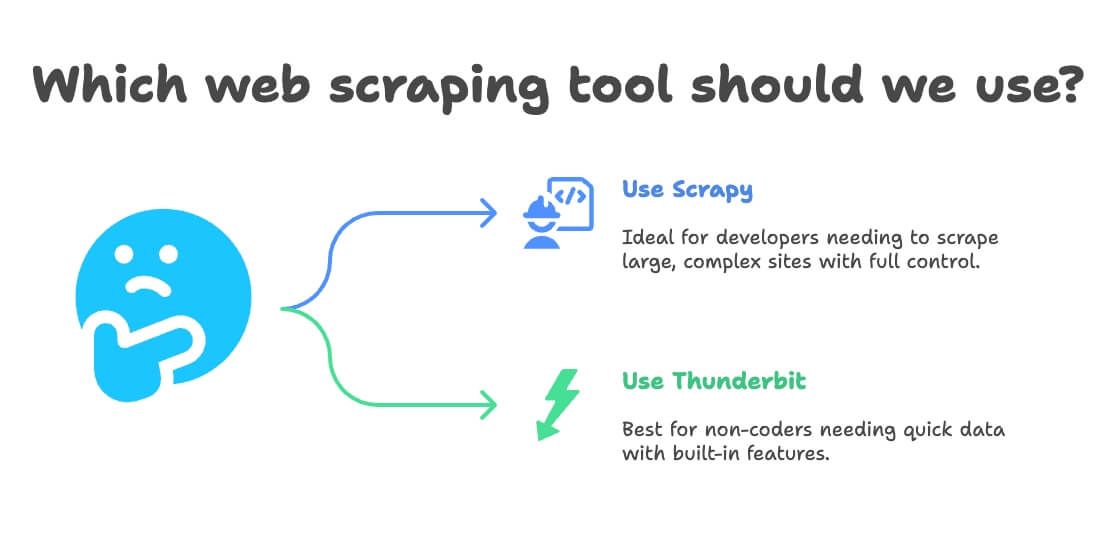

Wann Scrapy Python, wann Thunderbit fürs Web-Scraping?

Meine Faustregel:

- Scrapy nutzen, wenn:

- Du Entwickler bist oder einen im Team hast

- Du zehntausende Seiten scrapen oder eine dauerhafte Pipeline bauen willst

- Die Website sehr komplex ist oder spezielle Logik erfordert

- Du volle Kontrolle willst (und Wartung nicht scheust)

- Thunderbit nutzen, wenn:

- Du nicht programmieren (willst)

- Du schnell Daten für eine einmalige oder wiederkehrende Aufgabe brauchst

- Du Übersetzung, Sentiment oder Datenanreicherung direkt im Tool möchtest

- Du Wert auf Tempo und Flexibilität legst

Hier eine schnelle Entscheidungs-Checkliste:

- Kannst du Python programmieren?

- Ja → Scrapy oder Thunderbit (für schnelle Aufgaben)

- Nein → Thunderbit

- Ist dein Projekt groß und dauerhaft?

- Ja → Scrapy

- Nein → Thunderbit

- Brauchst du Übersetzung oder Sentiment-Analyse?

- Ja → Thunderbit

- Nein → Beides möglich

Schritt für Schritt: Amazon-Produktdaten mit Thunderbit scrapen (ohne Code)

Nehmen wir unser Amazon-Beispiel – diesmal auf die einfache Art.

1. Thunderbit installieren

- Kostenlos registrieren

2. Amazon öffnen und Produkt suchen

- Gehe auf und suche z. B. nach „Laptops“ (oder einem anderen Produkt)

3. Thunderbit auf der Seite starten

- Klicke auf das Thunderbit-Icon im Browser

- Das Seitenpanel öffnet sich und erkennt die Amazon-Seite automatisch

4. KI-Felder vorschlagen lassen

- Klicke auf „KI-Felder vorschlagen“

- Thunderbits KI scannt die Seite und schlägt Spalten wie „Produktname“, „Preis“, „Bewertung“, „Anzahl Bewertungen“ vor

- Du kannst Spalten hinzufügen oder entfernen (z. B. „Produkt-URL“ oder „Prime-Status“ einfach eintippen)

5. Paginierung und Unterseiten aktivieren

- Paginierung aktivieren: Thunderbit klickt automatisch auf „Weiter“ und sammelt alle Seiten

- Unterseiten aktivieren: Thunderbit besucht jede Produktdetailseite und holt Zusatzinfos (z. B. Beschreibung oder ASIN)

6. Scraping starten

- Klicke auf Scrapen

- Thunderbit sammelt die Daten live, Seite für Seite

7. Übersetzen und Sentiment analysieren (optional)

- Produktbeschreibungen übersetzen? Einfach „Übersetzen“ für die Spalte aktivieren

- Sentiment-Analyse für Bewertungen? „Sentiment“-Spalte hinzufügen – Thunderbits KI erledigt den Rest

8. Daten exportieren

- Klicke auf Exportieren

- Wähle Excel, Google Sheets, Airtable oder Notion

- Die Daten sind sofort einsatzbereit – kein manueller Import, kein CSV-Chaos

9. Wiederkehrende Scrapes planen (optional)

- Lege einen Zeitplan fest (z. B. täglich um 8 Uhr)

- Thunderbit führt das Scraping automatisch aus und aktualisiert dein Zielsystem

Das war’s. Kein Code, keine Selektoren, keine Wartung. Einfach Daten, bereit für dein Business.

Extra-Tipps: So holst du mehr aus deinen Web-Scraping-Projekten raus

Egal ob mit Scrapy, Thunderbit oder anderen Tools – diese Best Practices haben sich bewährt:

- Daten prüfen: Kontrolliere immer auf fehlende oder auffällige Werte (z. B. 0 € Preise oder leere Namen)

- Rechtliche Vorgaben beachten: Prüfe die Nutzungsbedingungen der Website, respektiere

robots.txtund überlaste keine Server - Automatisierung mit Augenmaß: Plane regelmäßige Scrapes, aber nicht häufiger als nötig

- Kostenlose Tools nutzen: Thunderbit bietet kostenlose E-Mail-, Telefon- und Bild-Extraktoren – ideal für Lead-Generierung oder Content-Kuration

- Daten für Analyse organisieren: Exportiere direkt nach Sheets/Excel, um schnell filtern, pivotieren und visualisieren zu können

Weitere Tipps findest du im oder im .

Für noch mehr Tipps schau im oder im vorbei.

Fazit: Web-Scraping leicht gemacht – das richtige Tool für dein Team

Das Wichtigste zum Schluss: Scrapy ist ein Top-Tool für Entwickler, aber für die meisten Business-Anwender zu komplex. Wer mit Python fit ist und große, individuelle Scraper bauen will, ist mit Scrapy bestens bedient. Wer aber schnell Ergebnisse ohne Code, mit Übersetzung und Sentiment-Analyse will, fährt mit deutlich entspannter.

Ich habe selbst erlebt, wie viel Zeit und Nerven Thunderbit gerade für nicht-technische Teams spart. Von „Ich hätte gern diese Daten“ bis „Sie sind in meiner Tabelle“ vergehen oft nur Minuten – nicht Stunden oder Tage. Mit Features wie KI-Feldvorschlägen, Unterseiten-Scraping und 1-Klick-Export war es nie einfacher, das Web in Business-Intelligenz zu verwandeln.

Wenn du also das nächste Mal Produktdaten sammelst, Preise überwachst oder eine Lead-Liste baust, frag dich: Willst du Python schreiben – oder einfach Ergebnisse? Probier Thunderbit kostenlos aus und erlebe, wie einfach Web-Scraping heute sein kann.

Neugierig geworden? Schau auf der , oder stöbere im nach weiteren Best Practices rund ums Web-Scraping.

Weiterführende Artikel:

Hinweis: Achte beim Web-Scraping immer auf die Nutzungsbedingungen der jeweiligen Website und die geltenden Gesetze. Im Zweifel lieber rechtlichen Rat einholen – niemand will wegen einer Tabelle eine Abmahnung riskieren.

Verfasst von Shuai Guan, Co-Founder & CEO von Thunderbit. Ich beschäftige mich seit Jahren mit SaaS, Automatisierung und KI – damit du es nicht musst.