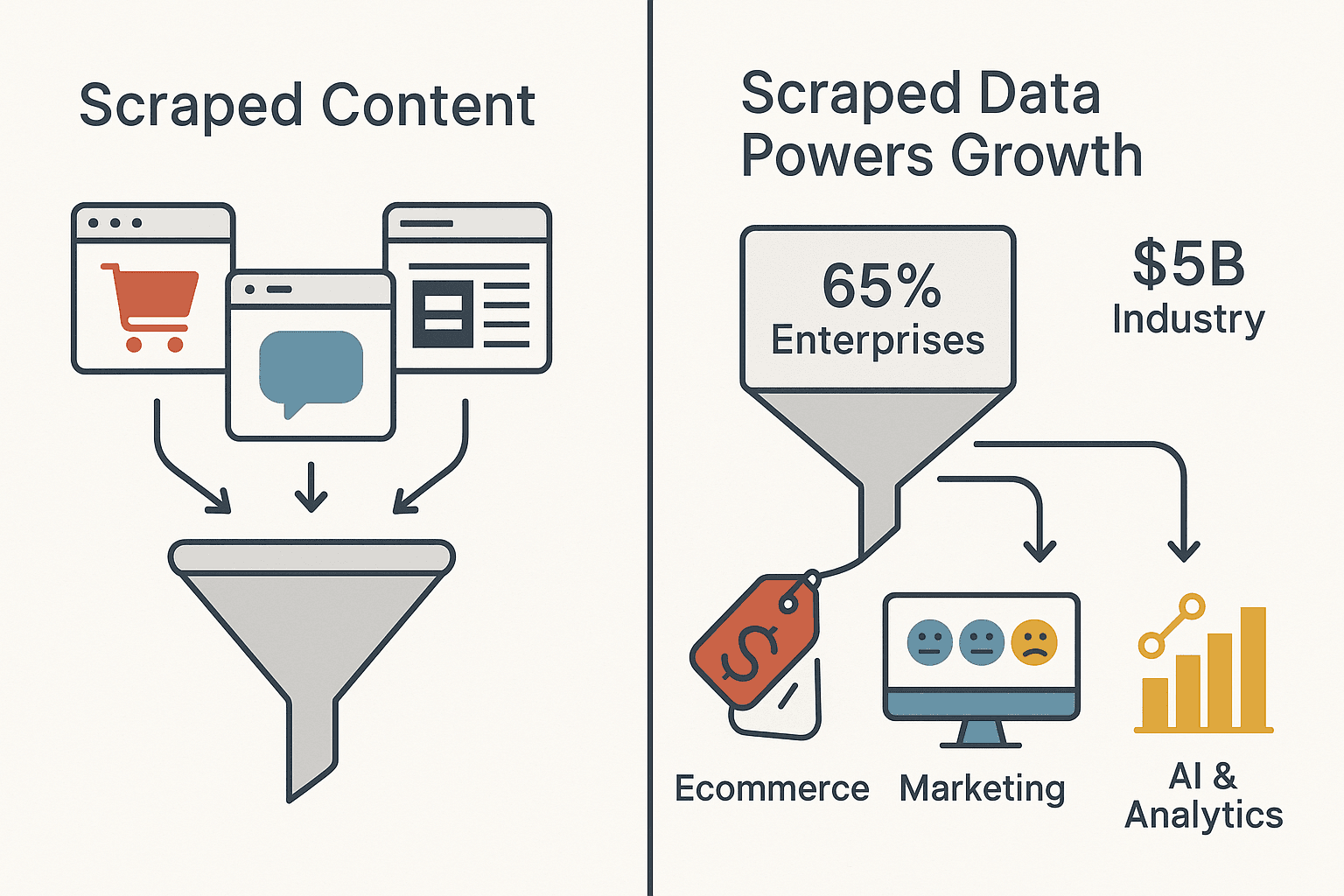

Hast du dich schon mal gefragt, wie manche Unternehmen immer einen Schritt voraus sind, wenn es um die Preise der Konkurrenz, angesagte Produkte oder die Meinung der Kunden geht – und das, bevor es alle anderen mitbekommen? Dahinter steckt kein Hexenwerk und auch kein Großraumbüro voller Praktikanten, die stundenlang Webseiten durchklicken. Das eigentliche Geheimnis heißt Scraped Content: Daten, die automatisiert von Webseiten und Online-Quellen gesammelt und anschließend in wertvolle Insights für das Business verwandelt werden. In der heutigen digitalen Welt ist Scraped Content der Motor für alles – von Preiskämpfen im E-Commerce bis hin zu Echtzeit-Stimmungsanalysen im Marketing. Tatsächlich setzen inzwischen auf Web-Scraping, um KI und Analysen zu unterstützen, und die globale Web-Scraping-Branche ist schon schwer.

Als jemand, der seit Jahren Automatisierungs- und KI-Tools entwickelt (und dabei selbst viele Daten aus dem Web extrahiert hat), habe ich hautnah erlebt, wie Scraped Content die Spielregeln für Unternehmen verändert. Aber: Mit großen Datenmengen kommt auch große Verantwortung – vor allem, wenn es um rechtliche Vorgaben und Datenqualität geht. Lass uns gemeinsam anschauen, was Scraped Content wirklich bedeutet, warum er so wichtig ist, wie du ihn verantwortungsvoll nutzt und warum für mich das Tool der Wahl ist, um das Maximum aus diesen Daten rauszuholen.

Scraped Content: Was steckt dahinter?

Fangen wir ganz von vorne an. Scraped Content sind alle Daten, die mit automatisierten Tools – also Bots, Skripten oder KI-Agenten – von Webseiten oder Online-Plattformen extrahiert werden. Statt Informationen mühsam per Hand zu kopieren, kann ein Web-Scraper alles von Produktpreisen und Bewertungen bis hin zu Bildern und Kontaktdaten in großem Stil und schön strukturiert erfassen.

Fachleute wie beschreiben Data Scraping als „den Prozess, gezielt strukturierte Daten von öffentlich zugänglichen Webseiten oder Online-Quellen zu extrahieren“. Einfach gesagt: Ein Scraper besucht eine Webseite, sammelt die gewünschten Infos (wie Namen, Preise, Daten) und speichert sie in einer Tabelle oder Datenbank für die weitere Analyse.

Manuelle vs. Automatisierte Datensammlung

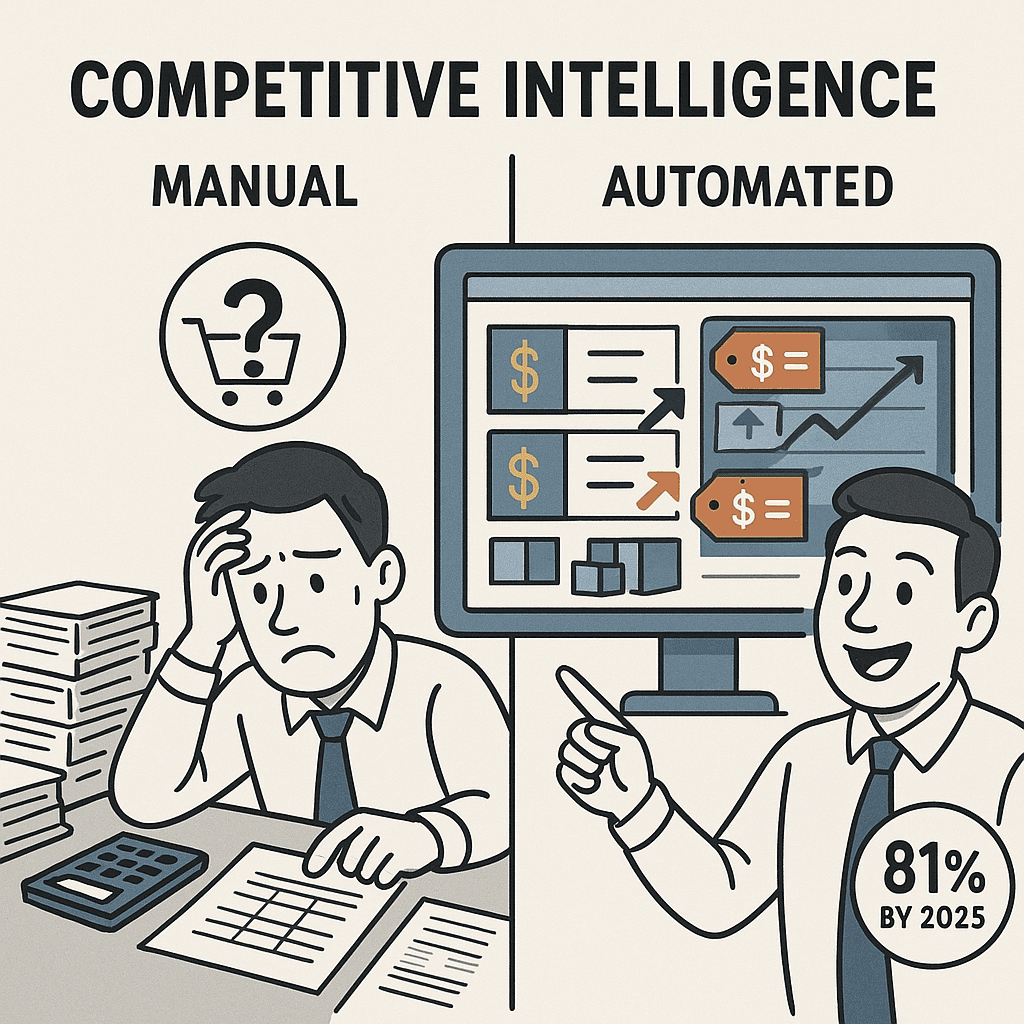

Früher musste man Daten von Webseiten entweder mühsam per Hand kopieren oder hoffen, dass es eine API gibt. Scraped Content dreht den Spieß um und automatisiert diesen Prozess. Moderne Scraper kommen auch mit dynamischen Webseiten klar (z. B. mit JavaScript, unendlichem Scrollen oder „Mehr laden“-Buttons) und können sogar menschliches Surfverhalten nachahmen, um Inhalte zu erfassen, die erst nach Interaktion sichtbar werden.

Was lässt sich alles scrapen?

Fast alles, was du auf einer Webseite siehst, lässt sich extrahieren, zum Beispiel:

- Text: Produktbeschreibungen, Preise, Nachrichtenartikel, Social-Media-Posts.

- Bilder: Fotos aus Inseraten, sozialen Netzwerken oder Produktgalerien.

- Links und Metadaten: URLs, Tags oder andere HTML-Attribute.

- Strukturierte Daten: Tabellen, Verzeichnisse, Börsendaten, Immobilienangebote.

- Nutzer-generierte Inhalte: Bewertungen, Kommentare, Ratings.

Unternehmen konzentrieren sich meist auf gezielte Datenpunkte, die für ihre Ziele relevant sind – etwa Preise von Wettbewerbern im E-Commerce oder das Sammeln von Kundenbewertungen für Stimmungsanalysen im Marketing.

Grundlage für Data Science und Forschung

Nach dem Scraping werden die Daten in einem strukturierten Format gespeichert (z. B. CSV, Excel oder JSON). Sie bilden die Basis für Analysen, Dashboards und Machine-Learning-Modelle. Egal ob Preisoptimierung, Marktbeobachtung oder Lead-Generierung – Scraped Content ist oft das Rückgrat datengetriebener Entscheidungen.

Warum Scraped Content für Unternehmen so wichtig ist

Scraped Content ist mehr als nur ein Buzzword – er ist der Rohstoff, der die Arbeitsweise von Unternehmen grundlegend verändert. Hier die wichtigsten Gründe:

- Wettbewerbsanalyse: Händler erfassen Preise und Produktdaten der Konkurrenz, um ihr eigenes Angebot in Echtzeit anzupassen. Bis 2025 werden voraussichtlich automatisierte Preis-Scraper einsetzen.

- Geschwindigkeit und Skalierbarkeit: Mit Scraping lassen sich riesige Datenmengen in Minuten erfassen – für schnelle, fundierte Entscheidungen.

- Datenbasierte Entscheidungen: Teams aus Vertrieb, Marketing, Produktmanagement und Operations nutzen Scraped Content für Preisanalysen, Trendbeobachtung, Lead-Generierung und vieles mehr.

Hier ein Überblick, wie verschiedene Branchen Scraped Content einsetzen:

| Branche/Team | Einsatz von Scraped Content | Geschäftlicher Nutzen |

|---|---|---|

| E-Commerce/Handel | Preise und Produktlisten der Konkurrenz scrapen | Dynamische Preisgestaltung in Echtzeit, Optimierung der Produktstrategie |

| Marketing & Branding | Bewertungen, Ratings, Social-Media-Kommentare scrapen | Stimmungsanalyse, Überwachung des Markenrufs |

| Vertrieb & Lead-Gen | Verzeichnisse, LinkedIn, Kontaktdaten scrapen | Aufbau gezielter Lead-Listen, effizientere Ansprache |

| Immobilien | Immobilienangebote von mehreren Portalen scrapen | Marktanalyse, Bestandsübersicht, Preisstrategie |

| Finanzen/Investments | Finanznachrichten, Börsendaten, öffentliche Meldungen | Alternative Daten für Handel, Risikomanagement, Echtzeit-Markteinblicke |

Scraped Content bringt echten Mehrwert: Unternehmen, die KI-gestützte Scraping-Tools nutzen, berichten von bei der Datenerfassung – so bleibt mehr Zeit für Analyse und Strategie.

Scraped Content und Recht: Was ist erlaubt?

Bei all diesen Möglichkeiten gibt es einen wichtigen Punkt: Scraping ist kein rechtsfreier Raum. Die Regeln rund um Scraped Content werden durch Urheberrecht, Nutzungsbedingungen und Datenschutzgesetze bestimmt. Das solltest du wissen:

Ist Web-Scraping legal?

Grundsätzlich ist das Scrapen öffentlich zugänglicher Informationen in den meisten Ländern nicht per se verboten – aber wie du die Daten sammelst und nutzt, kann rechtliche Probleme verursachen. In den USA hat ein wegweisendes Gerichtsurteil (hiQ Labs vs. LinkedIn) entschieden, dass das Scrapen öffentlich zugänglicher Daten nicht gegen Anti-Hacking-Gesetze verstößt – das Missachten der Nutzungsbedingungen einer Website kann aber trotzdem zu Klagen führen ().

Wichtige rechtliche Rahmenbedingungen:

- Urheberrecht: Fakten wie Preise oder Lagerbestände sind nicht geschützt, aber das Kopieren und Veröffentlichen kreativer Inhalte (z. B. Artikel, Bilder) kann Urheberrechtsverletzungen bedeuten. Nutze Scraped Content am besten für interne Analysen oder achte auf „Fair Use“.

- Datenschutz: Gesetze wie die europäische oder der kalifornische CCPA greifen, wenn du personenbezogene Daten scrapest. Auch öffentliche Profile können geschützt sein – Verstöße werden teuer.

- Nutzungsbedingungen: Wer gegen die ToS einer Website verstößt (z. B. Scraping trotz ausdrücklichem Verbot), riskiert zivilrechtliche Klagen – auch bei öffentlichen Daten.

Regionale Unterschiede: Die EU ist beim Scraping personenbezogener Daten deutlich strenger und verlangt meist eine ausdrückliche Einwilligung oder ein berechtigtes Interesse. In den USA ist der Umgang mit öffentlichen Daten lockerer, aber Urheber- und Vertragsrechte werden durchgesetzt.

Datenschutz und Einwilligung beim Scraping

Datenschutz ist ein zentrales Thema, vor allem beim Scraping personenbezogener oder sensibler Daten:

- Öffentlich ≠ Freie Nutzung: Nur weil Daten öffentlich sind, heißt das nicht, dass sie beliebig verwendet werden dürfen. Behörden erwarten, dass Unternehmen Datensparsamkeit wahren und transparent machen, wie sie Scraped Content nutzen.

- Einwilligung schwierig: Es ist kaum möglich, von allen betroffenen Personen eine Einwilligung einzuholen. Viele Unternehmen berufen sich auf „berechtigtes Interesse“, was in der EU aber zunehmend kritisch gesehen wird.

- Best Practices: Daten möglichst anonymisieren, nur das Nötigste sammeln und eine klare Datenschutzerklärung zum Scraping veröffentlichen. Bei Widerspruch solltest du Daten entfernen können.

Mehr zu rechtlichen Aspekten findest du in .

Thunderbit: Scraped Content clever und sicher nutzen

Wie kommt man nun an diese Daten – ohne rechtliche Risiken oder Kopfschmerzen? ist eine KI-gestützte Web-Scraper Chrome-Erweiterung, die speziell für Business-Anwender entwickelt wurde, die Ergebnisse wollen – keine Probleme.

Warum Thunderbit?

- Super einfach zu bedienen: Mit Thunderbit brauchst du keine Programmierkenntnisse. Einfach Webseite öffnen, auf „KI-Felder vorschlagen“ klicken und die KI erkennt automatisch, welche Daten extrahiert werden sollen – z. B. Produktnamen, Preise oder Kontaktdaten.

- KI-gestützte Datenstrukturierung: Thunderbit sorgt dafür, dass deine gescrapten Daten sauber, strukturiert und direkt auswertbar sind. Du kannst sogar eigene KI-Prompts hinzufügen, um Daten beim Scraping zu formatieren, zu kategorisieren oder zu übersetzen.

- Unterseiten- und Paginierungsscraping: Du willst Details von allen Produktseiten oder mit unendlichem Scrollen erfassen? Thunderbit erkennt Unterseiten und paginierte Inhalte automatisch und übernimmt die Navigation.

- Cloud- oder lokales Scraping: Scrape in der Cloud für Geschwindigkeit (bis zu 50 Seiten gleichzeitig) oder im Browser für passwortgeschützte Seiten.

- Kostenloser Datenexport: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten oder Umwege.

- Compliance-First-Ansatz: Thunderbit unterstützt verantwortungsvolles Scraping, indem du genau steuern kannst, welche Daten du erfasst – so vermeidest du unnötige Risiken mit sensiblen Informationen.

Thunderbit wird bereits von über eingesetzt – von Vertriebsteams über E-Commerce-Betreiber bis hin zu Immobilienprofis.

So vereinfacht Thunderbit den Scraped-Content-Workflow

So läuft der Workflow mit Thunderbit ab:

- KI-Felder vorschlagen: Webseite öffnen, Thunderbit-Icon anklicken und die KI schlägt automatisch relevante Felder vor (z. B. „Produktname“, „Preis“, „Details-URL“).

- Felder anpassen: Spalten hinzufügen oder umbenennen, Datentypen festlegen oder KI-Prompts für Formatierung/Kategorisierung ergänzen.

- Scrapen: Auf „Scrapen“ klicken und Thunderbit erledigt den Rest. Bei paginierten oder mehrstufigen Seiten navigiert Thunderbit automatisch.

- Unterseiten anreichern: Du brauchst mehr Details? Mit „Unterseiten scrapen“ besucht Thunderbit jede verlinkte Seite und sammelt zusätzliche Infos.

- Exportieren: Überprüfe deine strukturierte Tabelle und exportiere sie in dein bevorzugtes Tool – Excel, Sheets, Notion oder Airtable.

- Planen: Richte wiederkehrende Scrapes ein („jeden Montag um 9 Uhr“), damit deine Daten immer aktuell bleiben.

Im Vergleich zu klassischen Scraping-Tools (die oft Programmierung, manuelle Einrichtung und ständige Wartung erfordern) setzt Thunderbit auf KI und Automatisierung – das bedeutet weniger Aufwand, weniger Fehler und mehr Zeit für die Analyse.

Scraped Content in der Praxis: So nutzen Unternehmen die Daten

Konkret – so verschaffen sich Unternehmen mit Scraped Content einen Vorsprung:

- Preisüberwachung im E-Commerce: Händler erfassen täglich (oder stündlich) die Preise der Konkurrenz, um ihre eigenen Preise in Echtzeit anzupassen. Inzwischen nutzen automatisiertes Scraping für dynamische Preisgestaltung.

- Kundenstimmungs-Analyse: Marketing-Teams scrapen Bewertungen und Social-Media-Kommentare, um die Kundenzufriedenheit zu messen und Probleme frühzeitig zu erkennen. Eine Hotelkette nutzte gescrapte Bewertungen, um schwächelnde Standorte zu identifizieren und das Personal gezielt zu schulen – mit messbar besseren Gästebewertungen.

- Lead-Generierung: Vertriebsteams bauen gezielte Lead-Listen auf, indem sie Verzeichnisse, LinkedIn oder Teilnehmerlisten von Events scrapen. Mit Thunderbit können Leads sogar durch Scraping von Unterseiten angereichert werden.

- Marktforschung in der Immobilienbranche: Makler und Investoren scrapen Immobilienangebote von verschiedenen Portalen, um Preistrends, Bestände und Marktveränderungen zu analysieren – das spart viel Zeit und hilft, Chancen schneller zu erkennen.

- Automatisierung von Betriebsabläufen: Teams scrapen Lieferanten-Webseiten, um Lagerbestände oder Preisänderungen zu überwachen – ein Prozess, der früher manuell und fehleranfällig war.

In all diesen Fällen ist Scraped Content nicht einfach nur ein Datenhaufen – sondern ein strategischer Vorteil für schnellere, bessere Entscheidungen.

Scraped Content im Wandel: Von Masse zu Klasse

Früher galt beim Web-Scraping: „Je mehr, desto besser“ – möglichst viele Daten sammeln und später sortieren. Heute, mit fortschrittlicher KI und Analytik, zählt Qualität statt Quantität:

- Gezieltes Scraping: Unternehmen konzentrieren sich auf die richtigen Quellen und Datenpunkte, statt alles zu sammeln, was möglich ist.

- KI zur Datenanreicherung: Tools wie Thunderbit nutzen KI, um Daten beim Scraping zu bereinigen, zu kategorisieren oder sogar zusammenzufassen – so werden sie direkt nutzbar.

- Aktualität und Relevanz: Echtzeit- oder geplantes Scraping sorgt dafür, dass Daten immer aktuell sind – entscheidend für Preisüberwachung oder Stimmungsanalysen.

- Compliance als Qualitätsmerkmal: Rechtlich und ethisch einwandfreie Daten sind hochwertiger, weil sie sicher genutzt werden können und keine Risiken bergen.

Thunderbit ist für diese neue Ära gemacht: Du konzentrierst dich auf die wirklich relevanten Daten, bekommst sie strukturiert und rechtssicher – und kannst sie nahtlos in deine Arbeitsabläufe integrieren.

Scraping entwickelt sich rasant weiter – wer vorne bleiben will, braucht die richtigen Tools und Best Practices.

Typische Herausforderungen und wie du sie meisterst

Scraping läuft nicht immer reibungslos. Hier die häufigsten Stolpersteine – und wie Thunderbit sie löst:

- Doppelte Daten: Beim Scraping aus mehreren Quellen entstehen oft Dubletten. Thunderbit strukturiert Daten mit eindeutigen Schlüsseln und erleichtert das Entfernen von Duplikaten in Excel oder Sheets.

- Qualität und Genauigkeit: Änderungen an Webseiten können Scraper aus dem Tritt bringen oder zu fehlenden Daten führen. Thunderbits KI passt sich Layout-Änderungen an, und mit „KI-Felder vorschlagen“ kannst du schnell nachjustieren.

- Website-Schutzmechanismen: CAPTCHAs, IP-Sperren und dynamische Inhalte machen einfachen Scraper-Tools das Leben schwer. Thunderbits browserbasierter Ansatz meistert dynamische Seiten, und Cloud-Scraping nutzt mehrere IPs für Geschwindigkeit und Zuverlässigkeit.

- Skalierung und Performance: Du musst tausende Seiten scrapen? Im Cloud-Modus schafft Thunderbit bis zu 50 Seiten gleichzeitig, und du kannst wiederkehrende Jobs für laufende Anforderungen einrichten.

- Compliance-Risiken: Das versehentliche Scrapen personenbezogener oder sensibler Daten kann rechtlich heikel sein. Mit Thunderbit steuerst du genau, was gesammelt wird – und vermeidest so unnötige Risiken.

Wichtig ist, ein flexibles, KI-gestütztes Tool zu nutzen, das für Business-Anwender entwickelt wurde – nicht nur für Entwickler.

Fazit: So holst du das Beste aus Scraped Content heraus

Hier die wichtigsten Punkte zum Abschluss:

- Scraped Content ist ein Grundpfeiler moderner, datengetriebener Unternehmen. Er ermöglicht alles von Wettbewerbsanalysen bis Lead-Generierung – und wird immer wichtiger.

- Qualität schlägt Quantität. Konzentriere dich auf relevante, präzise und aktuelle Daten – nicht auf Masse.

- Recht und Ethik sind Pflicht. Prüfe Urheberrecht, Datenschutz und Nutzungsbedingungen, bevor du scrapest.

- Thunderbit macht Scraping einfach und verantwortungsvoll. Mit KI-gestützten Feldvorschlägen, Unterseiten-Scraping und Compliance-First-Design ist Thunderbit der einfachste Weg, Webdaten in Geschäftswert zu verwandeln.

- Integriere Scraped Content in deine Entscheidungsprozesse. Der wahre Mehrwert entsteht, wenn du die Daten aktiv für deine Strategie nutzt – nicht, wenn sie nur in einer Tabelle liegen.

Neugierig, wie Scraped Content deinen Workflow verändern kann? und probiere es selbst aus – ganz ohne Programmierkenntnisse. Weitere Tipps findest du im .

Häufige Fragen (FAQ)

1. Was ist Scraped Content genau?

Scraped Content sind Daten, die automatisiert von Webseiten oder Online-Quellen mit Tools wie Web-Scrapern oder KI-Agenten gesammelt werden. Dazu zählen Texte, Bilder, Preise, Bewertungen, Kontaktdaten und vieles mehr – alles strukturiert für Analyse und geschäftliche Nutzung.

2. Ist Web-Scraping legal?

Das Scrapen öffentlicher Daten ist meist erlaubt, aber die Nutzung in einer Weise, die Urheberrecht, Datenschutz oder die Nutzungsbedingungen einer Website verletzt, kann rechtliche Probleme verursachen. Prüfe immer die lokalen Vorschriften und scrape verantwortungsvoll.

3. Wie nutzen Unternehmen Scraped Content?

Unternehmen setzen Scraped Content für Preisanalysen, Lead-Generierung, Stimmungsanalysen, Marktforschung und mehr ein. So können Teams schneller und datenbasiert entscheiden.

4. Was unterscheidet Thunderbit von anderen Scraping-Tools?

Thunderbit nutzt KI, um Scraping auch für Nicht-Techniker einfach zu machen. Funktionen wie „KI-Felder vorschlagen“, Unterseiten- und Paginierungsscraping sowie direkter Export nach Excel, Sheets, Notion und Airtable machen den Unterschied. Außerdem stehen Compliance und Datenqualität im Fokus.

5. Wie stelle ich sicher, dass mein Scraping rechtlich und ethisch einwandfrei ist?

Beschränke dich auf öffentliche Daten, vermeide das Sammeln personenbezogener oder sensibler Informationen, respektiere die Nutzungsbedingungen der Website und anonymisiere Daten, wo möglich. Mit Tools wie Thunderbit behältst du die volle Kontrolle und minimierst Risiken.

Du willst tiefer einsteigen? Entdecke weitere Leitfäden und Best Practices im – und mach das Web zu deinem nächsten Wettbewerbsvorteil.