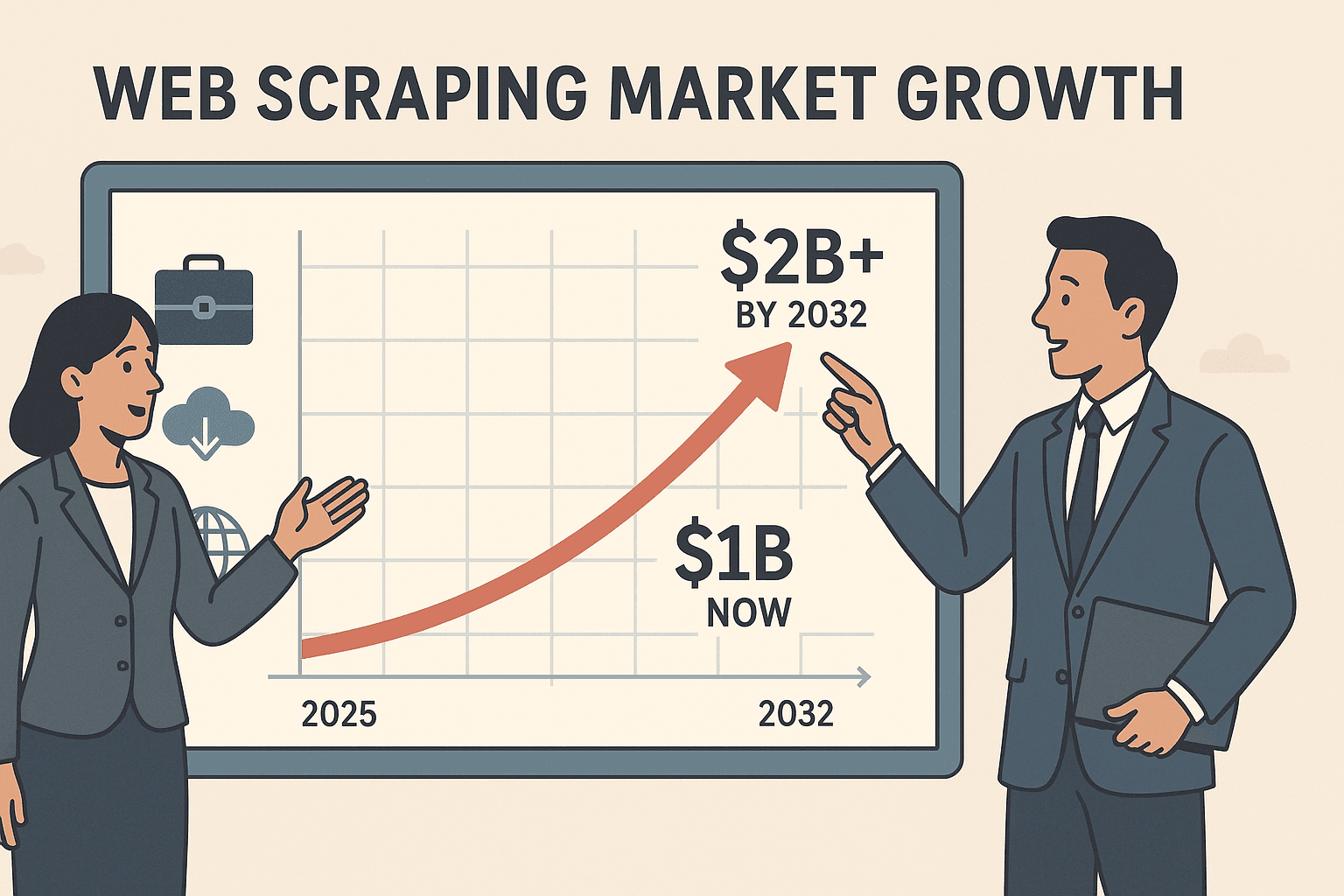

Wer 2025 immer noch Daten per Copy & Paste von Webseiten sammelt, ist wie jemand, der mit Hausschuhen einen Marathon läuft – einfach nicht mehr zeitgemäß. Der Markt für Web-Scraper-Software ist mittlerweile über schwer und wird sich bis 2032 voraussichtlich mehr als verdoppeln. Schon jetzt nutzen über die Hälfte aller US-Unternehmen externe Webseitendaten, um die Konkurrenz im Blick zu behalten, Preise zu vergleichen oder neue Leads zu finden. Wer die frischesten Daten hat, ist klar im Vorteil.

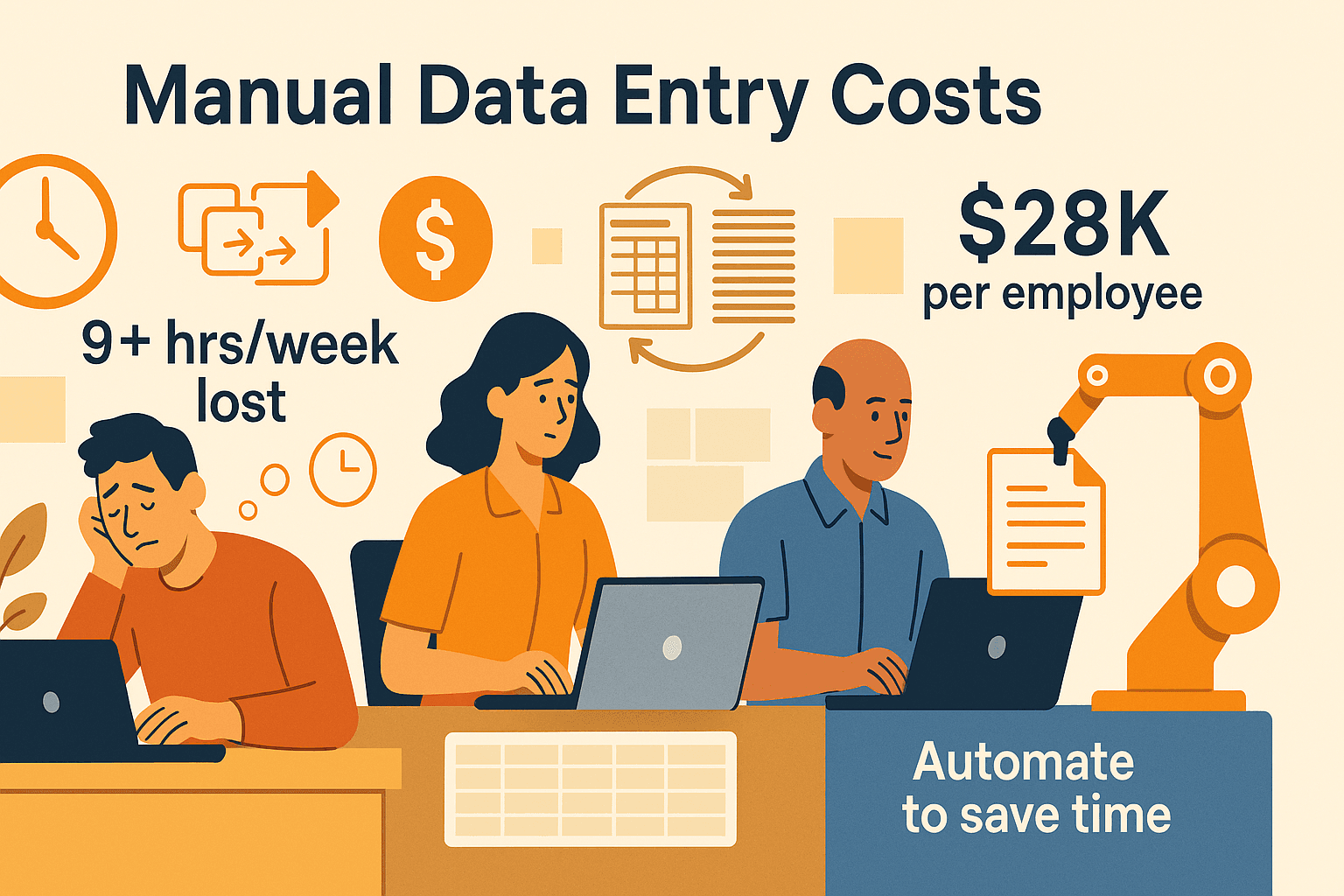

Das Problem: Die wenigsten im Unternehmen sind Coder. Ich habe schon Vertriebler, Marketing- und Operations-Kollegen erlebt, die über 9 Stunden pro Woche mit stumpfer Dateneingabe verbringen – das kostet Unternehmen . Fast 60 % der Beschäftigten sagen, dass sie diese Aufgaben auslaugen. Die gute Nachricht: Webseitendaten automatisieren ist heute für jeden möglich – auch ohne IT-Kenntnisse. Hier erfährst du, wie du in wenigen Schritten von „Ich brauche diese Daten“ zu „Hier ist meine Tabelle“ kommst – und welche Tools dir dabei helfen.

Was heißt eigentlich, Webseitendaten extrahieren?

Im Kern bedeutet Webseitendaten extrahieren, dass du mit Software automatisch Infos von Webseiten abgreifst und sie in eine strukturierte Form bringst – zum Beispiel als Tabelle, Excel-Datei oder Datenbank. Stell dir vor, du hast einen digitalen Assistenten, der hunderte Seiten besucht, die gewünschten Infos (wie Namen, Preise, E-Mails) einsammelt und alles direkt in Excel ablegt, während du entspannt einen Kaffee trinkst.

Manuelles Kopieren und Einfügen klappt vielleicht für ein paar Zeilen. Aber wenn du Daten von Dutzenden oder Tausenden Seiten brauchst, sind Fehler und Frust vorprogrammiert. Automatisierte Web-Scraper nehmen dir diese Arbeit ab – schnell, zuverlässig und mit viel weniger Fehlern ().

Die Grundschritte beim Web Scraping:

- Definiere, welche Daten du brauchst (z. B. Produktpreise, Kontaktdaten, Bewertungen).

- Extrahiere die Daten mit einem Tool oder Skript.

- Exportiere die Ergebnisse in ein auswertbares Format (CSV, Excel, Google Sheets usw.).

Moderne Web-Scraper können sogar durch mehrere Seiten blättern, „Weiter“-Buttons klicken und Unterseiten besuchen – so bekommst du wirklich alle relevanten Daten.

Warum ist das Extrahieren von Webseitendaten für Unternehmen so wichtig?

Warum sollten Sales-, Marketing- und Operations-Teams diese Fähigkeit unbedingt draufhaben?

- Lead-Generierung: Erstelle gezielte Listen potenzieller Kunden, indem du Branchenverzeichnisse, LinkedIn oder Teilnehmerlisten von Events extrahierst. Schluss mit veralteten Listen oder stundenlanger Google-Suche.

- Preisbeobachtung: Überwache Preise und Lagerbestände der Konkurrenz auf Marktplätzen. Einzelhändler wie John Lewis konnten ihren Umsatz durch gescrapte Preisdaten um steigern.

- Marktforschung: Sammle Bewertungen, Sterne und Social-Media-Erwähnungen, um Trends und Kundenstimmung in Echtzeit zu erkennen.

- Effizienzsteigerung: Halte Produktkataloge, Lieferantendaten oder Immobilienangebote automatisch aktuell.

Hier eine schnelle Übersicht der Vorteile:

| Hauptvorteil | Bedeutung | Praxisbeispiel |

|---|---|---|

| Zeitersparnis | Stundenlanges manuelles Datensammeln automatisieren | +9 Std./Woche pro Mitarbeiter (PRNewswire) |

| Genauigkeit | Weniger Fehler, konsistente Daten | Bis zu 99,5 % Genauigkeit (Scrapingdog) |

| Wettbewerbsvorteil | Schnellere, aktuellere Erkenntnisse als die Konkurrenz | Dynamische Preise, gezielteres Marketing |

| Workflow-Automatisierung | Daten aktualisieren sich selbst – keine manuellen Kontrollen mehr | Tägliche/wöchentliche Berichte automatisch |

Kein Wunder, dass mit externer Datennutzung bessere Entscheidungen treffen und mehr als die Hälfte Umsatzsteigerungen verzeichnen.

Schritt-für-Schritt: Webseitendaten ohne Programmieren extrahieren

Oft gefragt: „Wie fange ich an, wenn ich keine Technikexpertin bin?“ Hier ein einfacher Fahrplan:

1. Ziel und Datenfelder festlegen

Überlege dir, was du brauchst. Zum Beispiel: Eine Liste aller Restaurants in deiner Stadt von Yelp – mit Name, Adresse und Telefonnummer. Oder die Preise von Konkurrenzprodukten auf Amazon. Schreib die gewünschten Felder auf.

2. Das passende Tool wählen

Wenn du nicht programmierst, lass Python-Skripte links liegen. Nutze No-Code-Tools wie (eine KI-basierte Chrome-Erweiterung) oder visuelle Scraper wie Octoparse oder ParseHub.

3. Tool einrichten

Installiere dein gewähltes Tool (bei Thunderbit einfach die herunterladen). Registrieren, einloggen – und los geht’s.

4. Daten auf der Webseite identifizieren

Öffne die Zielseite. Bei Thunderbit reicht ein Klick auf „KI-Felder vorschlagen“ – die KI analysiert die Seite und schlägt passende Spalten vor (z. B. Name, Preis, E-Mail).

5. Testlauf machen

Starte mit einer kleinen Probe. Extrahiere eine Seite oder ein paar Einträge, um zu checken, ob die Daten stimmen. Spalten oder Prompts ggf. anpassen.

6. Gesamtdaten extrahieren

Wenn alles passt, starte den vollständigen Scrape. Für große Datenmengen empfiehlt sich der Cloud-Modus (dazu gleich mehr). Das Tool übernimmt Paginierung und Unterseiten, wenn eingerichtet.

7. Daten exportieren und nutzen

Exportiere die Ergebnisse nach Excel, Google Sheets, Airtable oder Notion. Kontrolliere stichprobenartig, ob alles korrekt ist.

Tipp: Typische Fehler vermeiden – z. B. Paginierung vergessen, zu viele Daten auf einmal scrapen oder die Nutzungsbedingungen der Seite ignorieren. Schritt für Schritt vorgehen, dann wirst du schnell zum Scraping-Profi.

Tool-Vergleich: Thunderbit vs. klassische Scraping-Lösungen

Hier ein Vergleich der Möglichkeiten:

| Lösung | Benutzerfreundlichkeit | Einrichtungszeit | Wartung | Skalierbarkeit | Kosten | Ideal für |

|---|---|---|---|---|---|---|

| Thunderbit (KI No-Code) | Sehr hoch | Minuten | Gering | Hoch (Cloud) | Gratis, ab 15 $/Monat | Vertrieb, Ops, Nicht-Programmierer |

| Klassische Erweiterungen | Mittel | 30+ Min. | Mittel | Eingeschränkt | Günstig/kostenlos | Geduldige Nutzer, einfache Aufgaben |

| Eigener Code (Python) | Gering | Stunden+ | Hoch | Sehr hoch | Entwicklerzeit | Entwickler, Datenteams |

| Outsourcing-Dienste | Hoch | Tage | Gering | Hoch | Teuer | Große, einmalige Projekte |

Thunderbit ist besonders für Nicht-Techniker ein Volltreffer: Kein Code, KI-Feldvorschläge und ein Workflow, der so einfach ist wie Essen bestellen. Klassische Tools brauchen mehr Handarbeit, und eigene Skripte sind was für Entwickler.

Thunderbit in der Praxis: Webseitendaten in wenigen Klicks extrahieren

So würde ich mit zum Beispiel ein Maklerverzeichnis auslesen:

- Chrome-Erweiterung installieren und einloggen.

- Zielwebseite öffnen (z. B. ein Immobilienverzeichnis).

- Thunderbit-Icon anklicken und die Seitenleiste öffnen.

- „KI-Felder vorschlagen“ wählen. Thunderbit scannt die Seite und schlägt Spalten wie Name, Agentur, Telefon, E-Mail vor.

- Felder prüfen und anpassen – Spalten umbenennen, eigene Prompts hinzufügen, z. B. für Kategorisierung.

- Auf „Scrapen“ klicken. Thunderbit extrahiert die Daten in eine Tabelle, inklusive Paginierung und endlosem Scrollen.

- Export nach Excel, Google Sheets oder Notion – ohne Zusatzkosten oder versteckte Gebühren.

Wenn die Namen der Makler auf Profilseiten verlinken, nutze Subpage Scraping: Thunderbit besucht jede Profilseite, sammelt weitere Infos (z. B. Adresse, Berufserfahrung) und ergänzt diese in deiner Tabelle. Kein mühsames Öffnen einzelner Tabs mehr.

Browser-Scraping vs. Cloud-Scraping: Welcher Modus passt zu dir?

Thunderbit bietet zwei Modi:

- Browser-Scraping: Läuft direkt im Chrome-Browser. Perfekt für Daten hinter Logins oder personalisierte Seiten (z. B. dein LinkedIn-Konto oder interne Dashboards). Nutzt deine Sitzung und Cookies – was du siehst, kann Thunderbit extrahieren.

- Cloud-Scraping: Läuft auf Thunderbits Servern. Ideal für öffentliche Daten – extrahiert bis zu 50 Seiten gleichzeitig, blockiert deinen Rechner nicht und läuft weiter, auch wenn du den Laptop zuklappst. Optimal für große Projekte wie das Auslesen aller Produkte eines Onlineshops.

Wann welchen Modus nutzen?

- Browser-Modus: Für Login-geschützte Seiten, personalisierte Feeds, kleine Aufgaben.

- Cloud-Modus: Für große, öffentliche Datenmengen, geplante Scrapes oder wenn du den Prozess automatisieren willst.

Thunderbit unterstützt Paginierung und Unterseiten in beiden Modi – so bekommst du immer vollständige Datensätze.

Effizienz auf Knopfdruck: Mit KI Felder und Formate optimieren

Mein Lieblingsfeature bei Thunderbit ist „KI-Felder verbessern“. Was bringt das?

- Automatische Formatierung: Telefonnummern, Preise oder Datumsangaben werden direkt beim Scrapen vereinheitlicht – Schluss mit chaotischen Tabellen.

- Kategorisierung: Füge eine Spalte „Kategorie“ hinzu und lass die KI jede Zeile automatisch zuordnen (z. B. Elektronik, Kleidung, Möbel).

- Übersetzung: Extrahiere Daten von fremdsprachigen Seiten und lass Thunderbit die Felder direkt ins Deutsche (oder 34+ andere Sprachen) übersetzen.

- Eigene Prompts: Du willst Stimmungen aus Bewertungen extrahieren oder Unternehmen nach Größe taggen? Einfach einen KI-Prompt zum Feld hinzufügen.

So bekommst du analysierbare Daten direkt aus dem Tool – ohne stundenlanges Nachbearbeiten.

Automatisiere deine Arbeit: Regelmäßiges Webseitendaten-Scraping planen

Warum nur einmal scrapen? Mit der Planungsfunktion von Thunderbit kannst du wiederkehrende Scrapes einrichten – täglich, wöchentlich oder wann immer du willst.

- Beschreibe den Zeitplan in Alltagssprache („jeden Montag um 9 Uhr“).

- Projekt und Exportziel wählen (Excel, Google Sheets, Airtable, Notion).

- Thunderbit führt den Scrape automatisch aus und aktualisiert deine Daten – ganz ohne manuelles Zutun.

Typische Anwendungsfälle:

- Vertrieb: Tägliche Lead-Listen automatisch aktualisieren.

- E-Commerce: Preisüberwachung automatisieren.

- Operations: Bestands- oder Lagerwarnungen.

- Marktforschung: News- oder Bewertungsaggregation.

Mit geplanten Scrapes bleiben deine Daten immer aktuell – dein Team hat jederzeit Zugriff auf die neuesten Infos.

Vergleich beliebter Tools zum Webseitendaten-Scraping: Die Übersicht

Hier ein direkter Vergleich der gängigsten Lösungen:

| Tool-Typ | Benutzerfreundlichkeit | Einrichtungszeit | Skalierbarkeit | Wartung | Kosten | Ideal für |

|---|---|---|---|---|---|---|

| Thunderbit (KI No-Code) | ⭐⭐⭐⭐⭐ | Minuten | Hoch | Gering | Gratis/ab 15 $/Monat | Vertrieb, Ops, Nicht-Programmierer |

| Klassische Erweiterungen | ⭐⭐⭐ | 30+ Min. | Mittel | Mittel | Günstig/kostenlos | Geduldige Nutzer, einfache Aufgaben |

| Eigener Code (Python) | ⭐ | Stunden+ | Sehr hoch | Hoch | Entwicklerzeit | Entwickler, Datenteams |

| Outsourcing-Dienste | ⭐⭐⭐⭐ | Tage | Hoch | Gering | Teuer | Große, einmalige Projekte |

Für die meisten Unternehmen ist Thunderbit die beste Wahl – schnell, einfach und günstig.

Fazit: So extrahierst du Webseitendaten effizient

- Web-Scraping ist für alle zugänglich. Kein Programmieren nötig – einfach das passende Tool wählen und loslegen.

- Definiere Ziele und Felder vorab. Überlege dir, welche Daten du brauchst und wo sie zu finden sind.

- Nutze KI-gestützte Tools wie Thunderbit für die schnellsten und einfachsten Ergebnisse – besonders für Nicht-Techniker.

- Automatisiere wiederkehrende Aufgaben mit Zeitplänen, damit deine Daten sich selbst aktualisieren.

- Optimiere deine Daten schon beim Scrapen mit KI-Prompts – so bekommst du sofort auswertbare Ergebnisse.

Bereit für den Einstieg? und starte deinen ersten Scrape kostenlos. Oder stöbere im für weitere Anleitungen und Praxisbeispiele.

Häufige Fragen

1. Ist Web Scraping legal und sicher für Unternehmen?

Ja, solange du öffentlich zugängliche Daten extrahierst und die Nutzungsbedingungen der Webseiten beachtest. Verzichte auf das Scrapen persönlicher oder sensibler Daten ohne Erlaubnis und prüfe immer die Richtlinien der jeweiligen Seite.

2. Welche Daten kann ich mit Thunderbit extrahieren?

Du kannst Texte, Zahlen, Daten, URLs, E-Mails, Telefonnummern, Bilder und mehr auslesen. Thunderbits KI kann Felder sogar kategorisieren, labeln und übersetzen.

3. Kann ich Daten von Seiten mit Login extrahieren?

Absolut – nutze den Browser-Modus von Thunderbit, um Daten von allen Seiten zu extrahieren, auf die du im Browser Zugriff hast, auch hinter Logins.

4. Wie geht Thunderbit mit vielen Seiten oder Unterseiten um?

Thunderbit unterstützt automatische Paginierung und Subpage-Scraping. Es folgt „Weiter“-Buttons und besucht verlinkte Detailseiten, um alle Daten in einer Tabelle zusammenzuführen.

5. Kann ich Scrapes automatisch planen?

Ja! Mit der Planungsfunktion von Thunderbit kannst du wiederkehrende Scrapes (täglich, wöchentlich usw.) einrichten und die Ergebnisse direkt nach Excel, Google Sheets, Airtable oder Notion exportieren.

Webseitendaten zu extrahieren muss kein Kraftakt sein. Mit den richtigen Tools und einer klaren Strategie machst du das Web zu deiner persönlichen Datenquelle – ganz ohne Programmieren, ohne Stress, mit maximalem Nutzen. Viel Erfolg beim Scrapen!