Die Welt diskutiert – und ein Großteil dieser Gespräche findet auf Twitter (heute X) statt. Mit und ist Twitter eine echte Goldgrube für Unternehmen, Forschende und alle, die Trends, Meinungen oder aktuelle Stimmungen in Echtzeit erfassen wollen. Doch an die begehrten Daten zu kommen, ist heute viel komplizierter als früher. Die Twitter-API ist mittlerweile stark limitiert (und teuer), weshalb viele nach anderen Wegen suchen, um an die Infos zu kommen.

Hier kommt Python-Web-Scraping ins Spiel – und Tools wie . Egal, ob du als Entwickler automatisiert Daten sammeln willst oder als Nicht-Programmierer einfach aktuelle Trends für deine nächste Kampagne brauchst: Es gibt für jeden eine Lösung. In diesem Guide zeige ich dir, wie du twitter daten mit python extrahieren kannst (ganz ohne API), worauf du achten solltest und wie Thunderbit den Prozess für alle noch einfacher macht.

Was bedeutet Twitter-Daten-Scraping und warum ist es relevant?

Im Kern heißt Twitter-Daten-Scraping, dass du Infos von öffentlichen Twitter-Webseiten – also Tweets, Profile, Hashtags und Trends – direkt ausliest, statt die offizielle API zu nutzen. Das kann manuell (Copy & Paste) oder viel effizienter mit Automatisierungstools und Skripten passieren.

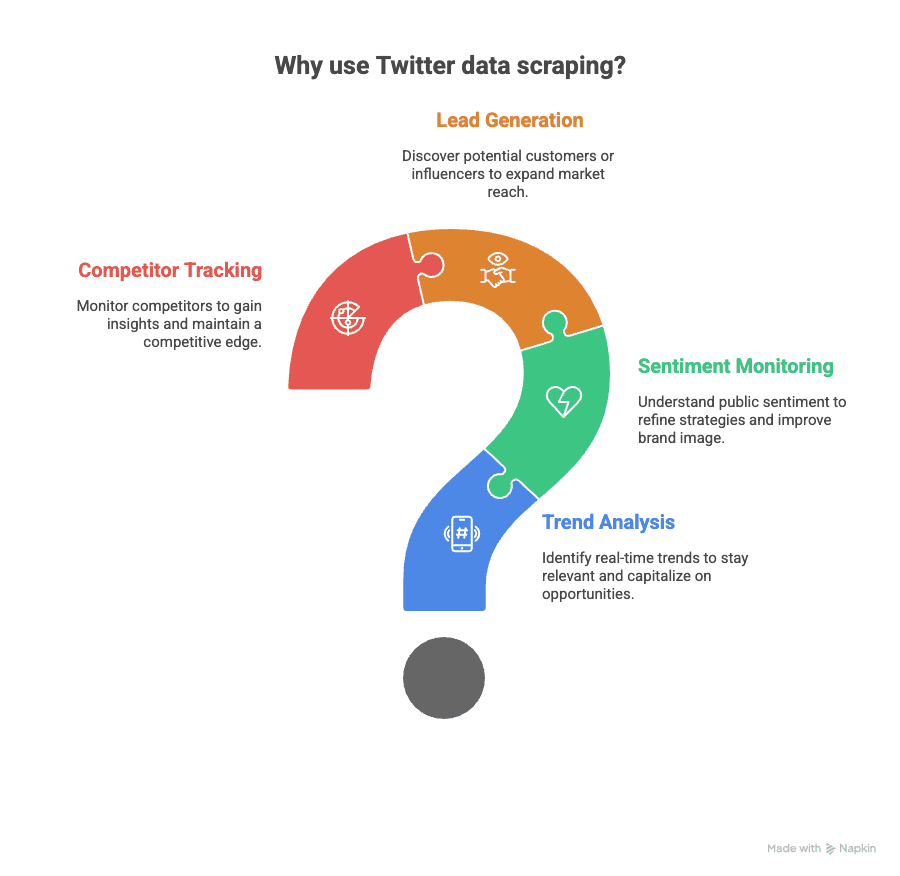

Warum ist das so spannend? Weil Twitter-Daten für viele Zwecke genutzt werden können:

- Trend-Analyse: Finde in Echtzeit heraus, was gerade angesagt ist – von viralen Memes bis zu aktuellen News.

- Stimmungsanalyse: Verfolge, wie die Community auf Produkte, Marken oder politische Themen reagiert.

- Lead-Generierung: Entdecke potenzielle Kunden oder Influencer, die über deine Branche sprechen.

- Wettbewerbsbeobachtung: Behalte im Blick, was die Konkurrenz postet – und was über sie gesagt wird.

Früher war die das Mittel der Wahl. Doch seit 2024 ist der kostenlose Zugang Geschichte, und selbst Basis-Tarife kosten schnell mehrere Hundert oder Tausend Euro im Monat. Die API und verlangt oft komplexe Authentifizierung.

Deshalb setzen immer mehr Nutzer auf Web-Scraping – mit Python oder No-Code-Tools – um flexibler und unabhängiger zu arbeiten und API-Hürden zu umgehen.

Twitter scrapen mit Python: API-Beschränkungen umgehen

Jetzt wird’s technisch: Beim Scraping von Twitter-Daten mit Python automatisierst du im Grunde einen Browser, der Twitter-Seiten besucht, das HTML ausliest und die gewünschten Infos extrahiert. So bist du nicht an API-Limits gebunden oder musst für den Zugang zahlen – du liest einfach das aus, was öffentlich sichtbar ist.

Beliebte Python-Bibliotheken für Twitter-Scraping

Diese Tools sind besonders gefragt, wenn du Twitter ohne API scrapen möchtest:

- : Perfekt, um statisches HTML auszulesen. Schnell und leichtgewichtig, aber bei dynamischen Inhalten (wie Endlos-Scrollen) stößt es an Grenzen.

- : Steuert einen echten Browser (Chrome, Firefox etc.) und eignet sich daher für dynamische Seiten wie Twitter. Kann JavaScript, Klicks und Scrollen verarbeiten.

- : Der Newcomer unter den Tools. Ähnlich wie Selenium, aber schneller und stabiler für moderne Webanwendungen.

Mit diesen Bibliotheken kannst du zum Beispiel folgende Daten erfassen:

- Öffentliche Tweets (Text, Zeitstempel, Likes, Retweets)

- Nutzerprofile (Bio, Follower-Zahl, Beitrittsdatum)

- Aktuelle Trends

- Hashtags und Suchergebnisse

Wichtig: Du kannst nur öffentlich sichtbare Inhalte scrapen – private Accounts und Direktnachrichten sind tabu.

Vergleich der Python-Scraping-Bibliotheken

Hier ein Überblick über Stärken und Schwächen:

| Bibliothek | Ideal für | JavaScript-Unterstützung? | Geschwindigkeit | Bedienkomfort | Hinweise |

|---|---|---|---|---|---|

| BeautifulSoup | Statisches HTML | Nein | Schnell | Einfach | Mit requests für einfache Seiten nutzen |

| Selenium | Dynamische Inhalte, UI | Ja | Mittel | Mittel | Gut für Seiten mit viel JS |

| Playwright | Moderne dynamische Seiten | Ja | Am schnellsten | Mittel | Async-Unterstützung, stabiler als Selenium |

Da Twitter viel mit dynamischem Nachladen und Endlos-Scrollen arbeitet, sind Selenium und Playwright meist die beste Wahl ().

Rechtliche Hinweise: Twitter-Daten verantwortungsvoll scrapen

Bevor du loslegst, solltest du ein paar Spielregeln beachten:

- Twitter-Richtlinien respektieren: Seit 2024 und bestimmte kommerzielle Zwecke. Für private, wissenschaftliche oder nicht-kommerzielle Nutzung – und wenn du nur öffentliche Daten sammelst – wird Scraping meist toleriert, ist aber offiziell nicht erlaubt.

- Server schonen: Baue Pausen (2–5 Sekunden zwischen Anfragen) ein, begrenze die Anzahl der abgerufenen Seiten pro Stunde und vermeide Dauerbetrieb. So wirst du nicht als Bot erkannt und dein Zugang bleibt erhalten ().

- Nur öffentliche Daten scrapen: Greife niemals auf private Accounts, DMs oder geschützte Bereiche zu.

- Datenschutz beachten: Wenn du personenbezogene Daten sammelst (z. B. E-Mails, Namen), halte dich an Datenschutzgesetze wie die DSGVO. Sensible Infos immer anonymisieren oder aggregieren.

Mehr zu rechtlichen Aspekten findest du im .

Schritt für Schritt: twitter daten mit python extrahieren

Jetzt wird’s praktisch! So kannst du mit Python und Selenium Tweets von einem öffentlichen Twitter-Profil extrahieren:

1. Umgebung einrichten

Installiere die benötigten Bibliotheken:

1pip install selenium pandas webdriver-manager2. Den Web-Scraper schreiben

Hier ein einfaches Beispiel-Skript:

1from selenium import webdriver

2from selenium.webdriver.common.by import By

3from selenium.webdriver.chrome.service import Service

4from webdriver_manager.chrome import ChromeDriverManager

5import pandas as pd

6import time

7# Treiber einrichten

8driver = webdriver.Chrome(service=Service(ChromeDriverManager().install()))

9# Twitter-Profil aufrufen (URL anpassen)

10profile_url = '<https://twitter.com/nytimes>'

11driver.get(profile_url)

12time.sleep(5) # Seite laden lassen

13# Scrollen, um mehr Tweets zu laden

14for _ in range(3): # Für mehr Tweets anpassen

15 driver.execute_script("window.scrollTo(0, document.body.scrollHeight);")

16 time.sleep(3)

17# Tweets extrahieren

18tweets = driver.find_elements(By.CSS_SELECTOR, '[data-testid="tweetText"]')

19tweet_texts = [tweet.text for tweet in tweets]

20# Zeitstempel extrahieren

21timestamps = driver.find_elements(By.CSS_SELECTOR, 'time')

22tweet_times = [ts.get_attribute('datetime') for ts in timestamps]

23# In DataFrame zusammenführen

24df = pd.DataFrame({'Tweet': tweet_texts, 'Timestamp': tweet_times})

25# Export nach Excel

26df.to_excel('twitter_scrape.xlsx', index=False)

27driver.quit()Tipps:

- Passe die Scroll-Schleife an, um mehr Tweets zu laden.

- Likes, Retweets und Antworten kannst du über die jeweiligen CSS-Selektoren extrahieren ().

- Falls Fehler auftreten, prüfe, ob Twitter das Seitenlayout geändert hat – dann müssen die Selektoren angepasst werden.

Twitter-Daten auslesen und exportieren

Das obige Skript exportiert bereits nach Excel. Alternativ kannst du auch:

1df.to_csv('twitter_scrape.csv', index=False)Strukturiere deine Spalten: Tweet-Text, Zeitstempel, Nutzername, Likes, Retweets, Antworten. So wird die Auswertung in Excel, Google Sheets oder Python deutlich einfacher.

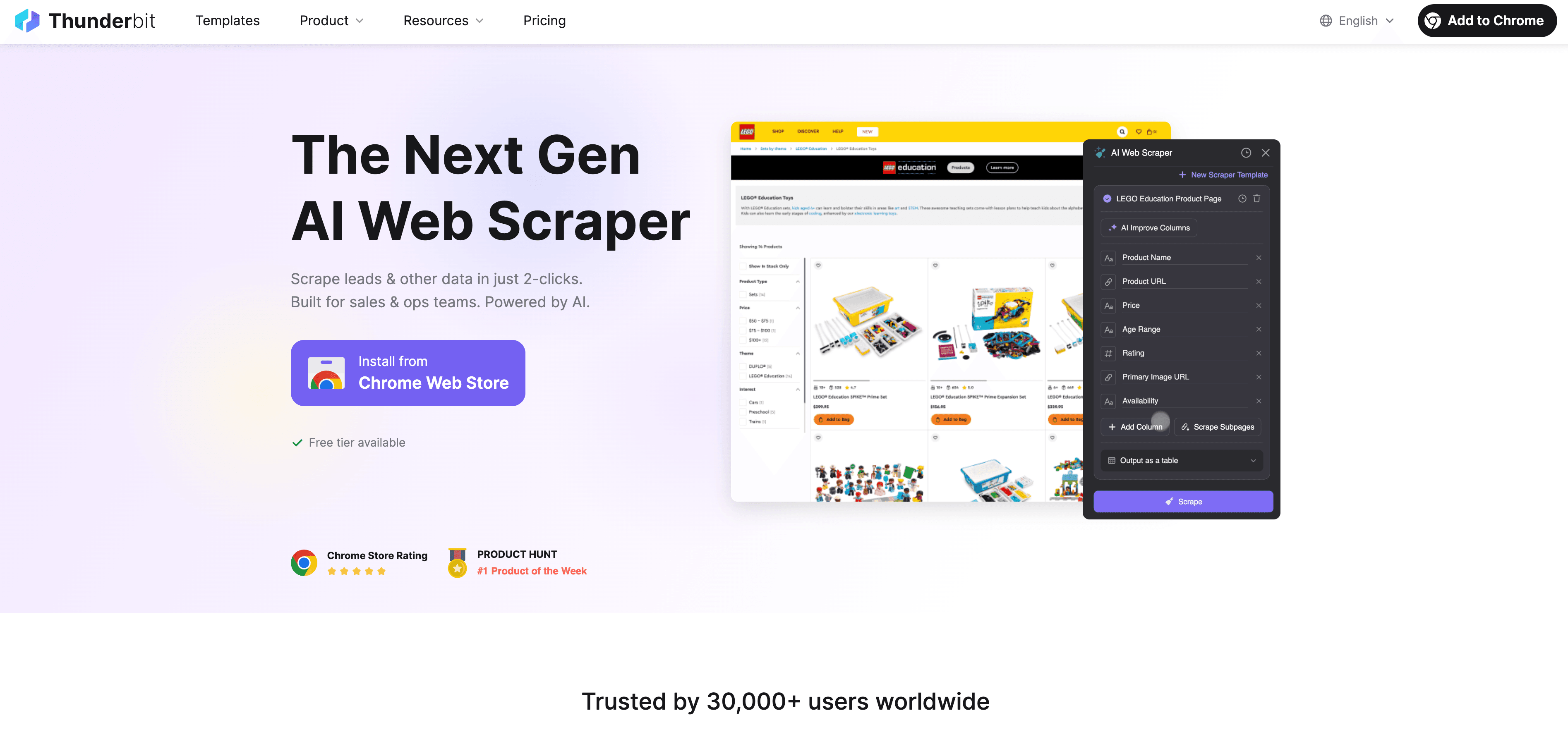

Thunderbit: Twitter-Daten extrahieren ohne Programmierkenntnisse

Und wenn du nicht programmieren kannst – oder einfach Zeit sparen willst? Genau hier punktet . Thunderbit ist eine KI-gestützte Chrome-Erweiterung, mit der du Twitter-Daten in wenigen Klicks extrahierst – ganz ohne Python, Installation oder technisches Know-how.

So funktioniert Thunderbit für Twitter

- Twitter in Chrome öffnen.

- Thunderbit-Erweiterung anklicken.

- Beschreibe dein Ziel: Zum Beispiel „Alle Tweets, Daten und Nutzernamen von dieser Seite extrahieren“.

- KI schlägt Felder vor: Thunderbit analysiert die Seite und empfiehlt passende Spalten (Tweet-Text, Zeitstempel, Likes usw.).

- Auf Scrape klicken: Thunderbit sammelt die Daten – auch von Unterseiten, falls nötig.

- Exportieren: Direkt als Excel, Google Sheets, Airtable, Notion oder CSV herunterladen – kostenlos und sofort.

Thunderbit bietet sogar , sodass du direkt mit der Analyse starten kannst.

Was macht das so praktisch? Du musst dich nicht mit Code, Treibern oder CSS-Selektoren herumschlagen. Thunderbits KI passt sich automatisch an Layout-Änderungen an und kann deine Daten beim Scrapen sogar anreichern (z. B. zusammenfassen, kategorisieren, übersetzen) ().

Thunderbit vs. Python: Was passt zu dir?

Hier der direkte Vergleich:

| Funktion | Python-Scraping | Thunderbit (No-Code) |

|---|---|---|

| Programmierkenntnisse nötig | Ja | Nein |

| Einrichtungszeit | 30+ Minuten | 1–2 Minuten |

| Dynamische Seiten unterstützt | Ja (Selenium/Playwright) | Ja (KI-basiert) |

| Anpassbarkeit | Hoch (mit Code) | Hoch (per KI-Prompt) |

| Wartung | Manuell (Skripte anpassen) | KI passt sich automatisch an |

| Exportformate | CSV, Excel, JSON | Excel, Sheets, Notion, CSV |

| Ideal für | Entwickler, Datenprofis | Business-Anwender, Nicht-Programmierer |

Wenn du technisch fit bist und volle Kontrolle willst, ist Python unschlagbar. Für die meisten Unternehmen ist Thunderbit jedoch schneller, einfacher und wartungsfrei. (Und du kannst es kostenlos testen – .)

Praxisbeispiel: Twitter-Trends mit Python und Thunderbit extrahieren

So sieht es in der Praxis aus: Du möchtest aktuelle Twitter-Trends erfassen und zur Analyse nach Excel exportieren.

Mit Python

Du nutzt Selenium oder Playwright, um:

- Die zu öffnen.

- Nach unten zu scrollen, um Trends zu laden.

- Trendnamen, Tweet-Anzahl und URLs zu extrahieren.

- Alles als Excel oder CSV zu speichern.

Beispiel-Code:

1# ... (Setup wie oben)

2driver.get('<https://twitter.com/explore>')

3time.sleep(5)

4trends = driver.find_elements(By.CSS_SELECTOR, '[data-testid="trend"]')

5trend_names = [trend.text for trend in trends]

6df = pd.DataFrame({'Trend': trend_names})

7df.to_excel('twitter_trends.xlsx', index=False)Mit Thunderbit

- Öffne die Explore-Seite von Twitter in Chrome.

- Klicke auf Thunderbit, wähle die oder beschreibe einfach: „Alle Trendthemen und Tweet-Anzahlen extrahieren“.

- Klicke auf Scrape.

- Exportiere direkt nach Excel, Google Sheets oder Notion.

Fazit: Beide Wege liefern die Daten – aber mit Thunderbit geht es in Sekunden, ohne Code und mit weniger Risiko bei Twitter-Updates.

Workflow optimieren: Python und Thunderbit kombinieren

Das Beste: Du musst dich nicht für ein Tool entscheiden – kombiniere beide Ansätze für maximale Effizienz:

- Mit Thunderbit schnell und ohne Code Twitter-Posts, Profile oder Trends extrahieren und nach Excel oder Google Sheets exportieren.

- Mit Python fortgeschrittene Analysen durchführen – importiere die exportierten Daten und führe z. B. Sentiment-Analysen, NLP oder Visualisierungen durch.

- Mit Thunderbit automatisieren: Lege geplante Scrapes an, um deine Datensätze aktuell zu halten ().

- Direkte Integration mit Airtable oder Notion: Thunderbit exportiert direkt, sodass dein Team mit Live-Daten arbeiten kann.

So profitierst du von der Geschwindigkeit des No-Code-Ansatzes und der Flexibilität von Python.

Tipps & Troubleshooting für erfolgreiches Twitter-Scraping

Twitter ändert sich ständig – Scraping läuft also nicht immer reibungslos. Hier meine wichtigsten Tipps:

- Selektoren ändern sich: Wenn dein Python-Skript nicht mehr funktioniert, prüfe, ob Twitter das HTML angepasst hat. Thunderbit passt sich automatisch an, Skripte müssen ggf. aktualisiert werden.

- Sperren/IP-Blockaden: Baue Pausen ein, wechsle ggf. die IP und vermeide zu viele Anfragen in kurzer Zeit.

- Dynamische Inhalte: Für Endlos-Scroll nutze Selenium oder Playwright, um mehr Daten zu laden.

- Rechtliche Vorgaben: Prüfe immer die und scrape verantwortungsvoll.

Weitere Tipps findest du im ) und im .

Fazit & wichtigste Erkenntnisse

Twitter-Daten sind wertvoller – und schwerer zugänglich – als je zuvor. Egal, ob du Trends verfolgst, Stimmungen analysierst oder Leads sammelst: Scraping ist oft der flexibelste Weg. Python bietet volle Kontrolle (für Technikaffine), während mit KI und No-Code-Ansatz für alle anderen die Tür öffnet.

- Python-Scraping: Ideal für Entwickler, die individuelle Workflows brauchen und Wartung nicht scheuen.

- Thunderbit: Perfekt für Business-Anwender, Marketer und Forschende, die schnell und ohne Code Ergebnisse wollen.

- Hybrid-Workflows: Mit Thunderbit exportieren, in Python analysieren und den Datenfluss automatisieren.

Wichtig: Immer verantwortungsvoll scrapen, Datenschutz und rechtliche Vorgaben beachten und bei Twitter-Änderungen am Ball bleiben. Die Diskussionen auf Twitter hören nie auf – und jetzt auch nicht mehr dein Datenstrom.

Häufige Fragen (FAQ)

1. Ist es legal, Twitter-Daten mit Python oder Thunderbit zu scrapen?

Das Scrapen öffentlicher Twitter-Daten für private oder wissenschaftliche Zwecke wird meist toleriert, aber die Twitter-AGB verbieten Scraping für KI-Training und manche kommerzielle Nutzungen. Prüfe immer die aktuellen und scrape niemals private oder sensible Daten.

2. Was ist der Unterschied zwischen Twitter-API und Web-Scraping?

Die API bietet strukturierte, zuverlässige Daten – ist aber inzwischen teuer und eingeschränkt. Web-Scraping liest die öffentliche Webseite direkt aus, umgeht API-Limits, erfordert aber mehr Pflege und kann bei Twitter-Updates brechen.

3. Welche Python-Bibliothek eignet sich am besten für Twitter-Scraping?

Für statische Inhalte ist BeautifulSoup schnell und einfach. Für dynamische Seiten (z. B. Endlos-Scroll) sind Selenium oder Playwright besser. Playwright ist meist schneller und robuster für moderne Webanwendungen.

4. Wie erleichtert Thunderbit das Twitter-Scraping?

Thunderbit nutzt KI, um Twitter-Seiten zu analysieren, Felder vorzuschlagen und Daten mit wenigen Klicks zu extrahieren – ganz ohne Programmierung. Es passt sich automatisch an Layout-Änderungen an und exportiert direkt nach Excel, Google Sheets, Notion oder Airtable.

5. Kann ich Thunderbit und Python für fortgeschrittene Workflows kombinieren?

Absolut! Mit Thunderbit kannst du Daten extrahieren und exportieren, um sie anschließend mit Python weiterzuverarbeiten oder zu analysieren. So profitierst du von Geschwindigkeit und Flexibilität für jedes Twitter-Datenprojekt.

Mehr erfahren: