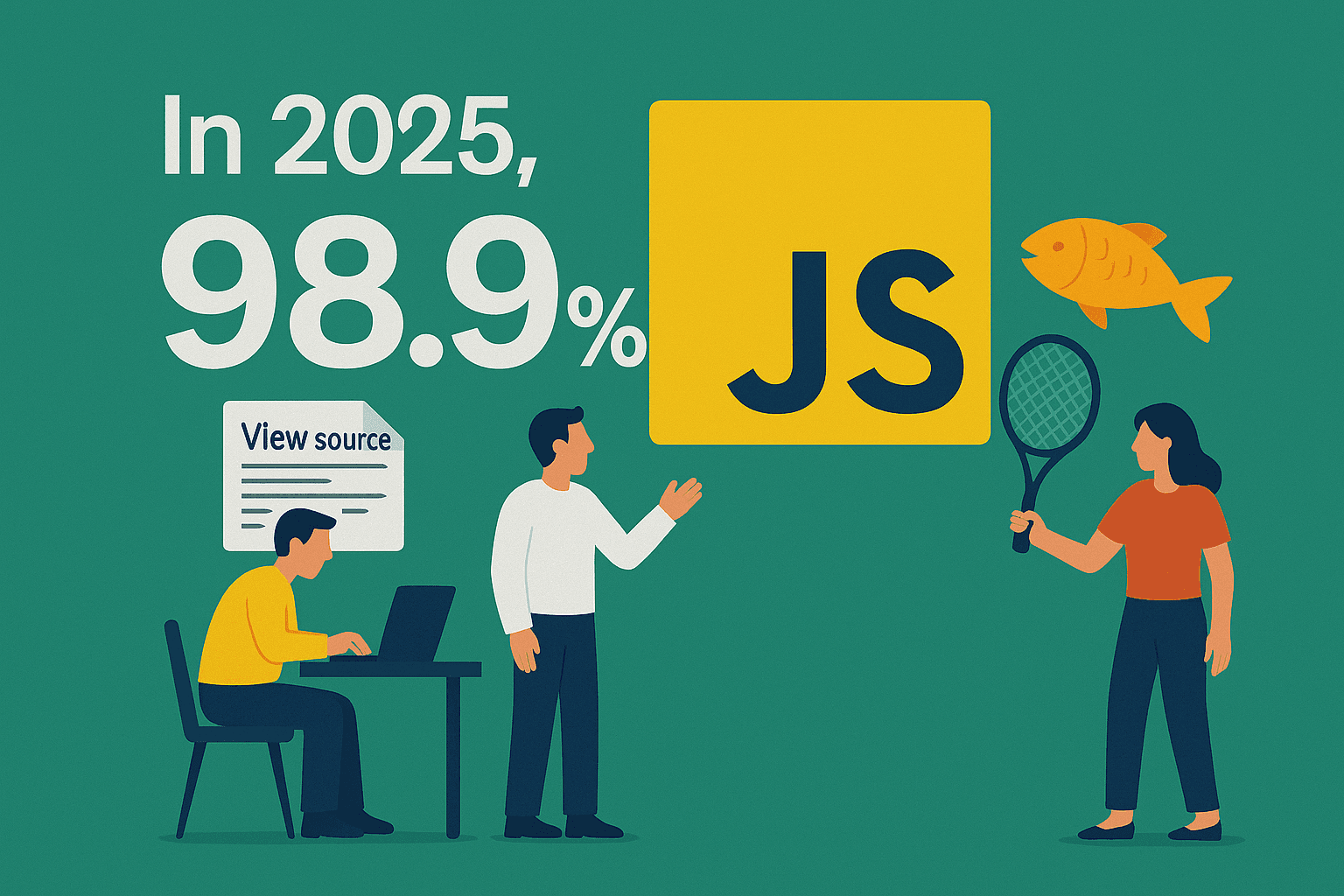

Wer schon mal versucht hat, Produktlisten von Amazon zu ziehen, Immobilienangebote auf Zillow im Blick zu behalten oder neue Leads aus modernen Online-Verzeichnissen zu sammeln, kennt das Problem: Die Infos, die du suchst, tauchen im Quelltext oft gar nicht auf. Willkommen in der Welt der dynamischen Webseiten – hier werden die wirklich spannenden Daten erst nachträglich per JavaScript, AJAX oder durch endloses Scrollen geladen. Im Jahr 2025 setzen beeindruckende , was bedeutet: Das klassische „View Source und Copy-Paste“ ist heute so effektiv wie Fische fangen mit einem Tennisschläger.

Als jemand, der seit Jahren Automatisierungslösungen baut und heute Thunderbit führt, weiß ich aus erster Hand: Das Scrapen dynamischer Webseiten ist für Teams aus Vertrieb, E-Commerce und Operations mittlerweile unverzichtbar. Egal ob du Preise der Konkurrenz checken, dein CRM anreichern oder Marktforschung betreiben willst – die wirklich wertvollen Daten verstecken sich oft hinter mehreren Schichten dynamischer Inhalte. Aber keine Panik: Ich zeige dir, was dynamisches Web Scraping besonders macht, warum klassische Tools oft nicht ausreichen und wie Thunderbits KI-Ansatz dir das Ganze ohne Programmierkenntnisse ermöglicht.

Dynamische Webseiten scrapen: Was ist anders?

Starten wir mit den Basics: Was ist eigentlich eine dynamische Webseite? Ganz easy: Eine statische Seite ist wie ein gedruckter Flyer – alles steht direkt im HTML, was du im Quelltext siehst, ist auch auf der Seite sichtbar. Typische Beispiele sind klassische Blogs oder einfache Firmenwebseiten.

Dynamische Webseiten dagegen funktionieren wie ein Snackautomat: Die Seite lädt, aber die eigentlichen Inhalte – Produktlisten, Bewertungen, Preise – werden erst nachträglich per JavaScript oder AJAX nachgeladen. Wenn du JavaScript im Browser ausschaltest und die Seite plötzlich leer oder kaputt aussieht, hast du es mit dynamischen Inhalten zu tun (). Moderne Online-Shops, Immobilienportale und soziale Netzwerke setzen auf diese Technik, um Inhalte individuell, aktuell und skalierbar bereitzustellen.

Hier ein schneller Überblick:

| Funktion | Statische Webseite | Dynamische Webseite |

|---|---|---|

| Inhalt im HTML? | Ja | Meist nein – wird später per JS/AJAX geladen |

| „View Source“ zeigt Daten? | Ja | Meist nicht – Daten werden zur Laufzeit eingefügt |

| Beispiele | Einfache Blogs, News, Über-uns-Seiten | Amazon, Zillow, LinkedIn, Twitter |

| Scraping-Schwierigkeit | Einfach | Anspruchsvoll – Browser-Automatisierung nötig |

Warum ist das wichtig? Weil die meisten geschäftsrelevanten Daten heute dynamisch geladen werden. Wer also Daten für Analysen, Lead-Generierung oder Preisbeobachtung braucht, muss neue Tools und Methoden nutzen.

Die besonderen Herausforderungen beim Scrapen dynamischer Webseiten

Das Scrapen dynamischer Webseiten ist kein Kinderspiel, sondern oft die einzige Möglichkeit, an aktuelle und vollständige Daten zu kommen. Dabei gibt’s aber ein paar Stolpersteine:

- Inhalte werden nachgeladen: Du holst dir das HTML – und findest… nichts. Die eigentlichen Daten werden erst nach dem Laden per JavaScript eingefügt.

- AJAX und endloses Scrollen: Seiten wie Amazon oder Zillow laden weitere Daten per AJAX, wenn du scrollst oder auf „Weiter“ klickst. Ohne Simulation dieser Aktionen verpasst du die meisten Ergebnisse.

- Anti-Bot-Maßnahmen: Dynamische Seiten setzen gezielt auf CAPTCHAs, Logins, Rate-Limits und IP-Sperren (). Wer zu schnell oder zu viel scrapt, wird blockiert oder bekommt leere Daten.

- Interaktionen erforderlich: Oft musst du Tabs anklicken, Dropdowns öffnen oder andere Aktionen ausführen, um an die Daten zu kommen. Klassische Scraper können das nicht.

- Verschachtelte und komplexe Daten: Dynamische Seiten nutzen oft verschachtelte JSON-Strukturen, React-Komponenten oder andere Formate, die schwer zu parsen sind.

Praxisbeispiel: Du willst alle Immobilienangebote einer Stadt auf Zillow scrapen. Ein einfacher HTML-Scraper liefert nur wenige oder gar keine Ergebnisse, weil die eigentlichen Daten erst nach Interaktion mit der Karte oder beim Scrollen per AJAX geladen werden. Das Gleiche gilt für Amazon-Bewertungen, LinkedIn-Suchergebnisse oder Twitter-Feeds.

Wo herkömmliche Web-Scraper an ihre Grenzen stoßen

Warum scheitern viele beliebte „Point-and-Click“- oder Code-Scraper bei dynamischen Seiten?

- Kein JavaScript-Support: Die meisten klassischen Scraper (wie BeautifulSoup oder einfache No-Code-Tools) holen nur das HTML. Wird der Inhalt per JavaScript geladen, bleibt er unsichtbar ().

- Keine Interaktion oder Paginierung: Sie können nicht auf „Weiter“ klicken oder scrollen – es bleibt bei Seite 1.

- Anfällige Selektoren: Ändert sich das Layout oder werden Daten anders versteckt, bricht der Scraper und muss ständig angepasst werden.

- Blockiert durch Anti-Bot-Systeme: Kein Proxy-Wechsel, keine CAPTCHA-Lösung, keine Tarnung – und schon bist du auf der Blockliste.

Hier ein direkter Vergleich:

| Szenario | Statische Seite (klassischer Scraper) | Dynamische Seite (klassischer Scraper) |

|---|---|---|

| Daten im HTML vorhanden? | Ja | Meist nicht |

| Paginierung/Endlos-Scroll? | Nicht nötig | Scheitert – nur erste Seite |

| Übersteht Layout-Änderungen? | Manchmal | Bricht schnell |

| Anti-Bot-Maßnahmen? | Selten nötig | Wird oft blockiert |

| Datenvollständigkeit | Hoch | Gering/unvollständig |

Beispiel: Jemand versucht, Amazon-Bewertungen mit einem einfachen Scraper zu extrahieren – Ergebnis: keine Bewertungen, weil diese erst nach dem Rendern geladen werden. Oder: Beim Scrapen von Zillow-Angeboten werden nur wenige Einträge gefunden, der Großteil fehlt.

Thunderbit: Die KI-Lösung für dynamisches Web Scraping

Hier kommt ins Spiel. Thunderbit wurde speziell für Business-Anwender entwickelt, die dynamische Webseiten scrapen möchten – ganz ohne Programmierung oder komplizierte Browser-Automatisierung.

Thunderbit funktioniert wie ein smarter Assistent: Du öffnest die Seite, klickst auf „KI-Felder vorschlagen“ und die KI liest die Inhalte wie ein Mensch. Sie wartet auf JavaScript, klickt durch Seiten und besucht sogar Unterseiten, um alle Details zu erfassen. Kein Rätselraten bei Selektoren oder ständiges Reparieren von Skripten mehr.

KI-Unterseiten-Scraping und Paginierung: Tiefgehende Daten automatisch erfassen

Ein echtes Highlight bei Thunderbit ist das KI-Unterseiten-Scraping. Wenn du zum Beispiel eine Produktliste scrapen willst, aber die eigentlichen Details (wie Verkäuferinfos oder Bewertungen) erst auf der Produktdetailseite stehen, kann Thunderbit automatisch jede Unterseite besuchen, die Zusatzinfos extrahieren und alles in einer Tabelle zusammenführen.

Auch die Paginierungs-Unterstützung ist ein echter Gamechanger. Thunderbit klickt automatisch auf „Weiter“ oder scrollt, um alle Ergebnisse über mehrere Seiten oder endloses Scrollen hinweg zu erfassen. Das ist besonders bei Seiten wie eBay, Amazon oder Zillow wichtig, wo die Daten auf viele Seiten verteilt sind.

Praxisbeispiel: Du scrapest Amazon nach „kabellosen Kopfhörern“ – pro Seite gibt es 50 Produkte, aber insgesamt 20 Seiten. Thunderbit klickt sich durch alle 20 Seiten und kann auf Wunsch jede Produktdetailseite besuchen, um Verkäuferbewertungen, Lagerbestand oder die ersten drei Rezensionen zu holen. Und das mit nur wenigen Klicks.

Natürliche Sprache: Sag Thunderbit, was du brauchst

Thunderbits KI ist nicht nur clever, sondern auch gesprächig. Du kannst in ganz normalem Deutsch (oder Englisch) angeben, was du extrahieren möchtest, zum Beispiel:

- „Extrahiere Produktname, Preis und Bewertung von dieser Seite.“

- „Hole Adresse, Preis und Telefonnummer des Maklers aus jedem Immobilienangebot.“

- „Für jede Firma: Name des CEOs und LinkedIn-Profil.“

Thunderbit erkennt, wo die Daten liegen – selbst wenn sie verschachtelt oder dynamisch geladen sind. Du kannst sogar eigene Anweisungen für Formatierung, Kategorisierung oder Zusammenfassung der Daten hinzufügen ().

Schritt-für-Schritt: So scrapen Sie dynamische Webseiten mit Thunderbit

Neugierig, wie einfach das geht? Hier eine Anleitung für Einsteiger:

1. Thunderbit Chrome-Erweiterung installieren

Geh zur und füge die Erweiterung deinem Browser hinzu. Das Thunderbit-Icon erscheint in deiner Symbolleiste. Registriere dich kostenlos, um loszulegen.

2. Zielseite öffnen

Öffne die gewünschte Seite – Amazon, Zillow, LinkedIn oder jede andere dynamische Website. Falls ein Login nötig ist (z. B. bei LinkedIn), melde dich zuerst an. Thunderbit funktioniert auf eingeloggten Seiten im Browser-Modus.

3. Thunderbit öffnen und Datenquelle wählen

Klick auf das Thunderbit-Icon. Im Seitenmenü wählst du die Datenquelle:

- Aktuelle Seite: Scrapen, was du gerade siehst.

- URL-Liste: Mehrere URLs für Massen-Scraping einfügen.

- Datei & Bild: Für das Scrapen aus PDFs oder Bildern.

Für die meisten dynamischen Webseiten reicht „Aktuelle Seite“.

4. Scraper-Vorlage einrichten

Klick auf „KI-Felder vorschlagen“. Thunderbits KI scannt die Seite und schlägt Spalten wie „Produktname“, „Preis“, „Bewertung“ oder „Detailseiten-URL“ vor. Du kannst Spalten umbenennen, hinzufügen oder entfernen. Möchtest du Daten von Unterseiten extrahieren? Markiere die entsprechende Spalte als URL und aktiviere Unterseiten-Scraping.

5. Scraping-Modus wählen: Browser oder Cloud

- Browser-Modus: Nutzt deine lokale Browsersitzung – ideal für eingeloggte oder standortabhängige Seiten.

- Cloud-Modus: Läuft auf Thunderbits Servern – sehr schnell für öffentliche Daten, kann bis zu 50 Seiten gleichzeitig scrapen.

Wähle den passenden Modus. Für Login-geschützte oder personalisierte Inhalte empfiehlt sich der Browser-Modus. Für große Mengen öffentlicher Daten ist der Cloud-Modus optimal.

6. Scraping starten

Klick auf „Scrapen“ und lass Thunderbit arbeiten. JavaScript, Paginierung, Unterseiten und Anti-Bot-Maßnahmen werden automatisch gehandhabt. Du kannst den Fortschritt verfolgen oder entspannt einen Kaffee holen – Thunderbit benachrichtigt dich, wenn alles fertig ist.

7. Daten prüfen und exportieren

Nach Abschluss zeigt Thunderbit deine Daten übersichtlich in einer Tabelle an. Check ein paar Zeilen zur Kontrolle. Dann kannst du deine Daten exportieren:

- In die Zwischenablage kopieren

- Als CSV oder Excel herunterladen

- Direkt nach Google Sheets, Airtable oder Notion exportieren

- Als JSON herunterladen (für Entwickler)

Der Export ist immer kostenlos und du kannst deine Daten direkt in deine bevorzugten Business-Tools übernehmen.

Daten weiterverwenden: Von Thunderbit zu Excel, Google Sheets und Airtable

Das Sammeln der Daten ist nur der erste Schritt – der eigentliche Mehrwert entsteht bei der Nutzung:

- Excel & CSV: Öffne die Datei in Excel, bereinige Spalten, erstelle Pivot-Tabellen oder Diagramme. Perfekt für Preisbeobachtung, Lead-Listen oder Bestandsanalysen.

- Google Sheets: Exportiere direkt für die Zusammenarbeit im Team. Mit Google Data Studio oder integrierten Diagrammen lassen sich Trends und Wettbewerberpreise visualisieren.

- Airtable & Notion: Erstelle Live-Datenbanken, verknüpfe gescrapte Daten mit anderen Tabellen oder baue visuelle Kataloge für dein Team. Thunderbit lädt sogar Produktbilder direkt in Notion oder Airtable hoch.

Tipp: Mit dem Scheduled Scraper von Thunderbit kannst du regelmäßige Scrapes einrichten – deine Daten werden automatisch aktualisiert, ganz ohne manuelles Nacharbeiten.

Aus Daten werden Insights: So nutzen Unternehmen dynamische Webdaten

Du hast die Daten – und jetzt? So setzen Teams dynamische Webdaten gewinnbringend ein:

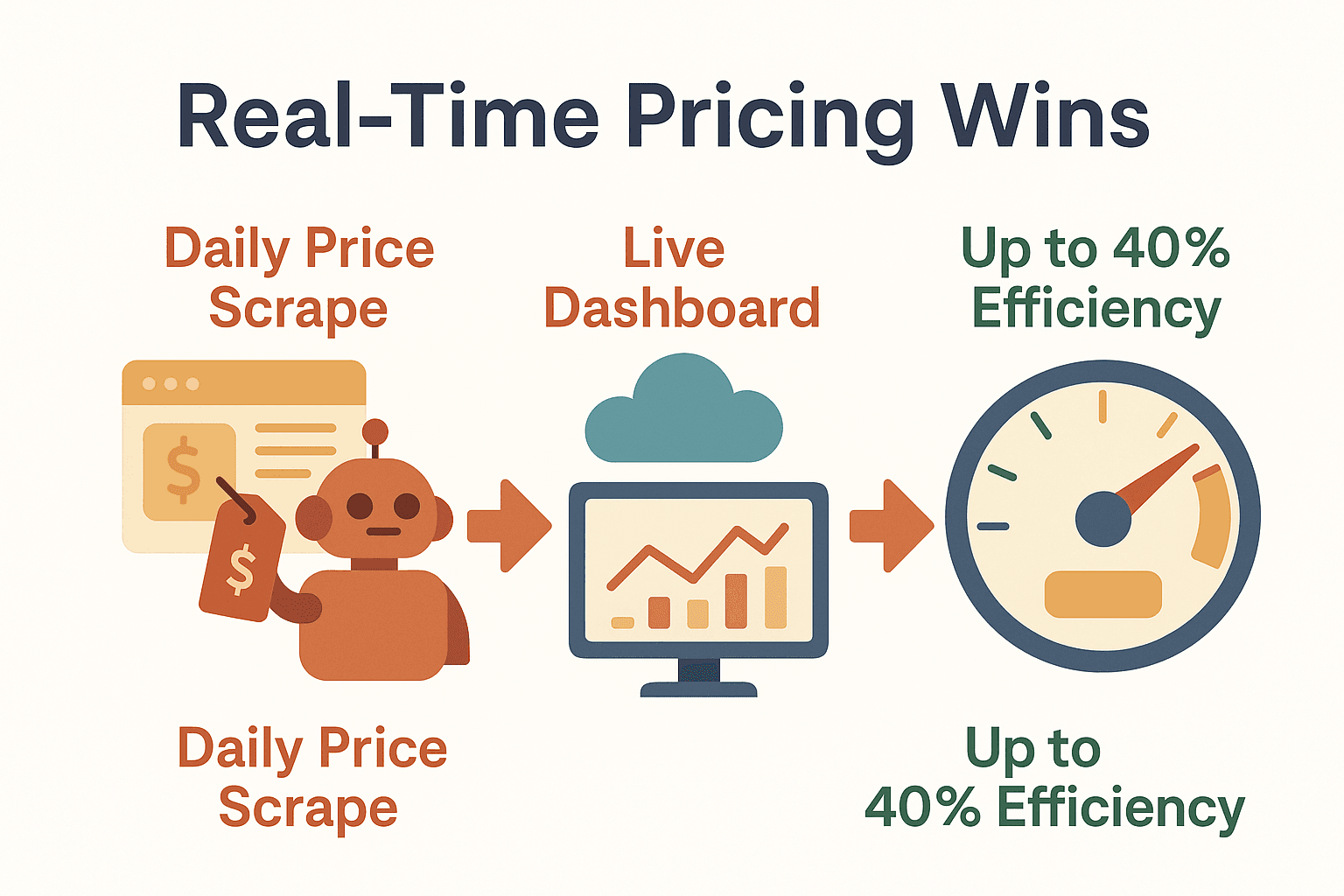

- Wettbewerbspreise überwachen: Tägliches Scrapen der Konkurrenzpreise, Visualisierung im Dashboard und flexible Preisstrategie in Echtzeit. Unternehmen, die auf Echtzeit-Preisanalysen setzen, erzielen .

- Markttrends erkennen: Bewertungen, Social-Media-Posts oder Forenbeiträge aggregieren. Mit Sentiment-Analyse oder Keyword-Tracking Trends frühzeitig erkennen ().

- Immobilieninvestitionen: Angebote, Preishistorie und Nachbarschaftsdaten von dynamischen Immobilienseiten scrapen. Analyse von Marktzyklen, Preisentwicklungen oder Angebotsschwankungen für bessere Investitionsentscheidungen.

- Lead-Anreicherung: Firmenverzeichnisse scrapen und mit Thunderbits Unterseiten-Scraping E-Mails, Telefonnummern oder LinkedIn-Profile zu jedem Unternehmen holen. Die angereicherten Daten direkt ins CRM importieren.

Thunderbits KI kann Daten sogar schon beim Scrapen kategorisieren, zusammenfassen oder übersetzen – so sind deine Ergebnisse direkt einsatzbereit.

Thunderbit im Vergleich zu anderen Lösungen für dynamisches Web Scraping

Wie schlägt sich Thunderbit im Vergleich zur Konkurrenz? Hier ein Überblick:

| Kriterium | Thunderbit (KI No-Code) | ScraperAPI (API) | Selenium (Code-Automation) |

|---|---|---|---|

| Zielgruppe | Nicht-Techniker | Entwickler | Entwickler |

| Bedienkomfort | 2 Klicks, kein Code | Programmierung nötig | Programmierung nötig |

| Dynamische Inhalte | Ja, integriert | Ja, mit Code | Ja, mit Code |

| Unterseiten/Paginierung | Automatisch, KI-gesteuert | Manuell | Manuell |

| Wartungsaufwand | Gering – KI passt sich an | Hoch – Skripte brechen | Hoch – Skripte brechen |

| Anti-Bot-Handling | Integriert, automatisch | API-Ebene | Manuell |

| Export-Integrationen | Sheets, Airtable, Notion | Keine | Keine |

| Geschwindigkeit & Skalierung | Schnell, parallel in der Cloud | Hoch, API-basiert | Langsam, ressourcenintensiv |

| Kosten | Credit-basiert, Gratis-Tarif | API-basiert | Entwicklerzeit, Infrastruktur |

Fazit: Thunderbit richtet sich an Business-Anwender, die schnell Ergebnisse wollen – ohne stundenlanges Coden oder Troubleshooting. Entwickler bevorzugen für Spezialprojekte vielleicht APIs oder Browser-Automation, aber für 99 % aller Business-Scraping-Anforderungen ist Thunderbit der schnellste Weg von der dynamischen Seite zu verwertbaren Daten ().

Typische Fehler beim Scrapen dynamischer Webseiten – und wie du sie vermeidest

Auch mit den besten Tools gibt’s ein paar Stolperfallen:

- Nicht auf das Laden der Inhalte warten: Der Scraper muss warten, bis JavaScript fertig ist. Thunderbit macht das automatisch, aber bei leeren Ergebnissen hilft oft der Browser-Modus.

- Paginierung oder endloses Scrollen vergessen: Aktiviere immer die entsprechenden Einstellungen, um alle Ergebnisse zu erfassen – nicht nur Seite 1.

- Daten hinter Interaktionen übersehen: Manche Daten erscheinen erst nach Klicks auf Tabs oder Buttons. Nutze Unterseiten-Scraping oder öffne die Bereiche manuell vor dem Scrapen.

- Blockiert werden: Nicht zu schnell oder zu viel scrapen. Mit dem Scheduled Scraper von Thunderbit kannst du Anfragen zeitlich verteilen und bei Blockaden den Modus wechseln.

- Falscher Modus: Für Login- oder standortabhängige Seiten den Browser-Modus nutzen, für öffentliche Massenjobs den Cloud-Modus.

- Daten nicht bereinigen: Prüfe und formatiere deine Daten vor dem Import in Business-Tools. Thunderbits KI hilft schon beim Scrapen bei der Formatierung und Kategorisierung.

Checkliste für erfolgreiches Scraping:

- KI-Felder vorschlagen lassen für präzise Spalten.

- Paginierung/Scrollen aktivieren, wenn nötig.

- Daten vor dem Export prüfen.

- Den passenden Modus wählen.

- Verantwortungsbewusst und ethisch scrapen.

Fazit & wichtigste Erkenntnisse

Dynamische Webseiten sind heute Standard – und die wertvollsten Geschäftsdaten liegen hinter JavaScript, AJAX und Nutzerinteraktionen verborgen. Klassische Scraper kommen hier nicht mehr mit: Sie übersehen Daten, sind fehleranfällig und scheitern an modernen Anti-Bot-Maßnahmen.

Thunderbit macht dynamisches Web Scraping für alle zugänglich. Mit KI-gestützten Feldvorschlägen, automatischer Unterseiten- und Paginierungsfunktion sowie natürlicher Sprache kommst du in wenigen Minuten von der komplexen Seite zu einem sauberen, exportbereiten Datensatz – ganz ohne Programmierung oder Stress.

Das solltest du dir merken:

- Dynamische Inhalte sind der neue Standard: Fast jede moderne Website nutzt sie.

- Klassische Tools reichen nicht mehr aus: Du brauchst KI und Browser-Automatisierung für vollständige Daten.

- Thunderbit ist für Business-Anwender gemacht: Kein Code, keine Wartung, nur Ergebnisse.

- Der Business-Mehrwert ist enorm: Schnellere Insights, bessere Entscheidungen, echter Wettbewerbsvorteil.

Neugierig, wie einfach das Scrapen dynamischer Webseiten sein kann? und probier es beim nächsten Projekt aus. Weitere Tipps, Anleitungen und Deep Dives findest du im .

Häufige Fragen (FAQ)

1. Was ist eine dynamische Webseite und warum ist das Scrapen schwieriger?

Eine dynamische Webseite lädt Inhalte erst nach dem initialen Seitenaufruf, meist per JavaScript oder AJAX. Die Daten stehen daher nicht im HTML-Quelltext und klassische Scraper können sie nicht erfassen. Du brauchst Tools, die JavaScript ausführen und wie ein echter Nutzer mit der Seite interagieren.

2. Wie geht Thunderbit beim Scrapen dynamischer Inhalte anders vor als andere Scraper?

Thunderbit nutzt KI, um Daten wie ein Mensch zu lesen und zu extrahieren – inklusive JavaScript-Ausführung, Paginierung und automatischem Besuch von Unterseiten. Du musst nicht coden und die KI passt sich an Änderungen der Seite an – ideal für dynamische Websites.

3. Wann sollte ich in Thunderbit den Browser-Modus und wann den Cloud-Modus nutzen?

Der Browser-Modus eignet sich für Seiten mit Login, personalisierten oder standortabhängigen Inhalten. Der Cloud-Modus ist optimal für öffentliche, große Scraping-Jobs – er ist schneller und kann viele Seiten parallel verarbeiten.

4. Kann Thunderbit Daten direkt in Business-Tools wie Excel oder Google Sheets exportieren?

Ja! Thunderbit ermöglicht den direkten Export nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON-Datei. Der Export ist immer kostenlos und sofort verfügbar.

5. Was sind die häufigsten Fehler beim Scrapen dynamischer Webseiten?

Paginierung vergessen, nicht auf das Laden der Inhalte warten, Anti-Bot-Maßnahmen ignorieren oder den falschen Scraping-Modus wählen. Thunderbits KI löst die meisten Probleme automatisch, aber prüfe immer deine Einstellungen und kontrolliere die Daten vor der geschäftlichen Nutzung.

Bereit, dynamische Webseiten in deinen nächsten Geschäftsvorteil zu verwandeln? Probier Thunderbit aus und erlebe den Unterschied selbst.