Ich erinnere mich noch gut an mein allererstes Web-Scraping-Projekt: Mit einer frischen Tasse Kaffee am Schreibtisch wollte ich endlich die lästige Aufgabe loswerden, stundenlang Produktpreise per Copy & Paste zu übertragen. Also öffnete ich Python, installierte BeautifulSoup – und wurde direkt von einem Wirrwarr aus kryptischem HTML und Fehlermeldungen begrüßt. Wer schon mal versucht hat, mit Python Webdaten zu extrahieren, kennt das Gefühl: eine Mischung aus Neugier, Frust und dem Drang, den Laptop aus dem Fenster zu werfen.

Eins ist aber klar: Webdaten sind heute Gold wert. Unternehmen brauchen aktuelle Infos – egal ob für Preisvergleiche, Lead-Listen oder Marktanalysen. Python ist seit Jahren das Standardwerkzeug dafür. Doch mit immer komplexeren Webseiten und cleveren Anti-Scraping-Technologien wirkt der klassische, code-lastige Ansatz inzwischen ziemlich angestaubt. Deshalb zeige ich dir heute beide Seiten: das bewährte Python-Toolkit und die neue Generation von KI-Web-Scrapern wie , die den Alltag von Sales-, E-Commerce- und Operations-Teams komplett verändern.

Was ist Python Web Scraping?

Kurz gesagt: Web Scraping heißt, Daten automatisiert von Webseiten zu sammeln. Statt Infos mühsam per Hand zu kopieren, übernimmt ein Skript diese Arbeit. Python ist besonders beliebt, weil es leicht zu verstehen ist, eine riesige Community hat und viele Bibliotheken bietet – perfekt auch für Einsteiger ohne große Programmierkenntnisse.

Warum Python?

- Einfacher Einstieg: Die Syntax von Python ist besonders einsteigerfreundlich.

- Viele Bibliotheken: Tools wie Requests, BeautifulSoup, Selenium und Scrapy decken alles ab – von einfachen statischen Seiten bis zu komplexen, JavaScript-lastigen Webseiten.

- Große Community: Bei Problemen findet man fast immer eine Lösung oder zumindest einen hilfreichen Thread auf Stack Overflow.

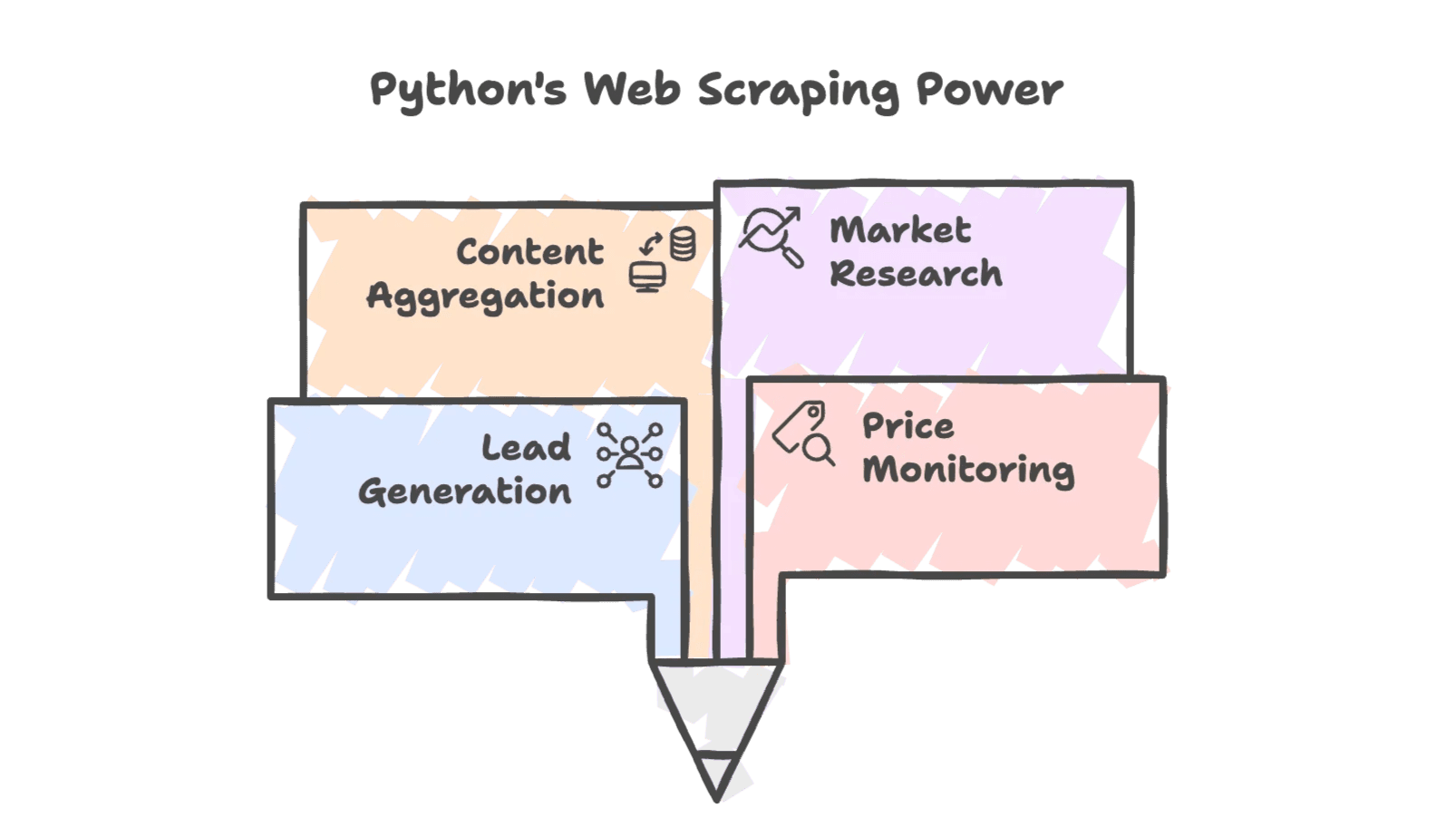

Typische Anwendungsfälle

Python Web Scraping wird in vielen Bereichen eingesetzt:

- Lead-Generierung: Kontaktdaten aus Verzeichnissen oder sozialen Netzwerken ziehen.

- Preisüberwachung: Preise der Konkurrenz im Blick behalten für dynamische Preisstrategien.

- Content-Aggregation: Nachrichten, Bewertungen oder Produktlisten einsammeln.

- Marktforschung: Trends aus Foren, Social Media oder Suchergebnissen analysieren.

Und das ist längst nicht nur was für IT-Profis – auch Sales-, E-Commerce- und Immobilien-Teams nutzen gescrapte Daten, um am Ball zu bleiben. Tatsächlich setzen Web Scraping ein, um individuelle Datensätze für Analysen und Lead-Scoring zu erstellen.

Warum setzen Unternehmen auf Python für Web Scraping?

Die Flexibilität von Python und die starken Bibliotheken machen es zur ersten Wahl für Web Scraping. Hier ein paar typische Business-Szenarien:

| Szenario | Wie hilft Python Web Scraping? | Beispielhafter Nutzen (ROI) |

|---|---|---|

| Lead-Generierung | Namen, E-Mails, Telefonnummern aus Verzeichnissen extrahieren | Über Nacht eine 500er-Liste potenzieller Kunden erstellen statt 50 per Hand |

| Preisüberwachung | Wettbewerberpreise regelmäßig abrufen | Dynamische Preisgestaltung – ein Händler steigerte den Umsatz um 4 % durch gescrapte Daten |

| Bestandsüberwachung | Lagerbestände der Konkurrenz prüfen | Kunden gezielt ansprechen, wenn Wettbewerber ausverkauft sind – spart viele Stunden manueller Recherche |

| Wettbewerbsanalyse | Produktdetails und Bewertungen crawlen | Über 1.000 Bewertungen der Konkurrenz auswerten für Marketing und Produktentwicklung |

| Marktforschung | Daten aus Foren, Social Media, Suchergebnissen aggregieren | Kampagnen mit aktuellen Markttrends steuern und die Strategie an echte Kundeninteressen anpassen |

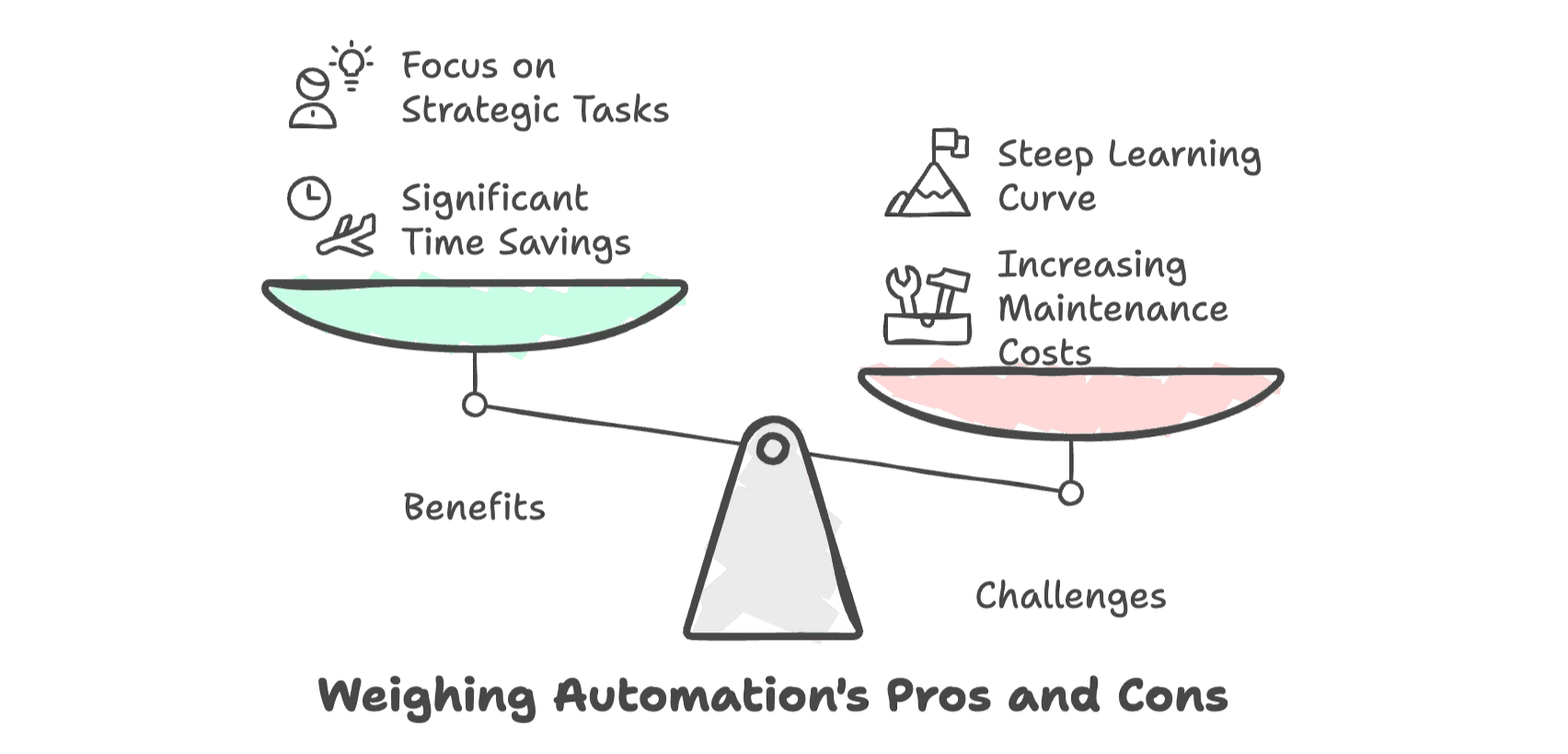

Das Ergebnis: Mit Python automatisierte Datensammlung spart im Schnitt 80 % Zeit gegenüber manuellen Methoden (). So bleibt mehr Zeit für Abschlüsse oder Analysen – und weniger für Fleißarbeit.

Aber – und das ist wichtig – je komplexer Webseiten werden, desto größer werden auch Aufwand, Wartung und Frust. Für Nicht-Techniker ist der Einstieg oft ziemlich steil.

Die wichtigsten Tools für Python Web Scraping

Wer neu einsteigt, findet im Python-Universum einige bewährte Tools. Hier ein Überblick:

| Tool | Ideal für | JavaScript-Unterstützung? | Einstiegshürde | Geschwindigkeit & Skalierung |

|---|---|---|---|---|

| Requests + BeautifulSoup | Einfache, statische Seiten | Nein | Gering | Schnell bei Einzelabfragen |

| Selenium | Dynamische, JS-lastige Seiten; Interaktionen | Ja | Mittel | Langsamer pro Seite |

| Scrapy | Großprojekte, strukturierte Crawls | Teilweise (mit Plugins) | Hoch | Sehr leistungsfähig, skalierbar |

Requests + BeautifulSoup

Das klassische Duo für statische Webseiten: Requests holt den HTML-Code, BeautifulSoup durchsucht und extrahiert die gewünschten Daten. Leichtgewichtig, ideal für kleine Projekte und Einsteiger (, ).

Selenium

Wenn Daten erst nach dem Laden von JavaScript erscheinen, ist Selenium das Mittel der Wahl. Es steuert einen echten Browser, kann also auch Logins, Klicks und Scrollen automatisieren (). Nachteil: Es ist langsamer und aufwendiger einzurichten.

Scrapy

Für große Projekte – etwa das Crawlen tausender Seiten oder wiederkehrende Datenpipelines – ist Scrapy das Schwergewicht. Ein vollwertiges Framework für robuste Spider, parallele Verarbeitung und saubere Code-Struktur (). Die Lernkurve ist steiler, aber für große Aufgaben lohnt es sich.

Schritt für Schritt: Dein erster Python Web-Scraper

Lass uns praktisch werden: Wir holen uns Buchtitel und Preise von – einer Demo-Seite zum Üben von Web Scraping.

Python-Umgebung einrichten

Stelle sicher, dass Python installiert ist. Dann im Terminal:

1pip install requests beautifulsoup4Als Editor empfehle ich VS Code oder PyCharm – Syntax-Highlighting macht das Leben leichter.

Dein erstes Web-Scraping-Skript

Hier ein einfaches Beispiel, das die Startseite abruft und die Buchdaten extrahiert:

1import requests

2from bs4 import BeautifulSoup

3url = "http://books.toscrape.com/"

4response = requests.get(url)

5html_content = response.text

6soup = BeautifulSoup(html_content, 'html.parser')

7book_elements = soup.find_all('article', class_='product_pod')

8books_data = []

9for book in book_elements:

10 title = book.find('h3').find('a')['title']

11 price = book.find('p', class_='price_color').text

12 books_data.append([title, price])

13print(books_data)Was passiert hier?

- Mit Requests wird das HTML geladen.

- BeautifulSoup parst den Code.

- Alle Buch-Elemente werden gefunden.

- Titel und Preis jedes Buchs werden extrahiert.

Gescrapte Daten exportieren

Damit du die Daten weiterverwenden kannst, speichere sie als CSV:

1import csv

2with open('books.csv', 'w', newline='', encoding='utf-8') as f:

3 writer = csv.writer(f)

4 writer.writerow(["Title", "Price"])

5 writer.writerows(books_data)Jetzt kannst du books.csv in Excel oder Google Sheets öffnen und deine Ergebnisse weiterverarbeiten.

Profi-Tipps:

- Prüfe immer, ob die Ausgabe vollständig und korrekt ist.

- Bei komischen Zeichen: Achte darauf, dass du UTF-8 verwendest.

- Wenn das Skript plötzlich nicht mehr läuft, hat sich wahrscheinlich die Webseitenstruktur geändert.

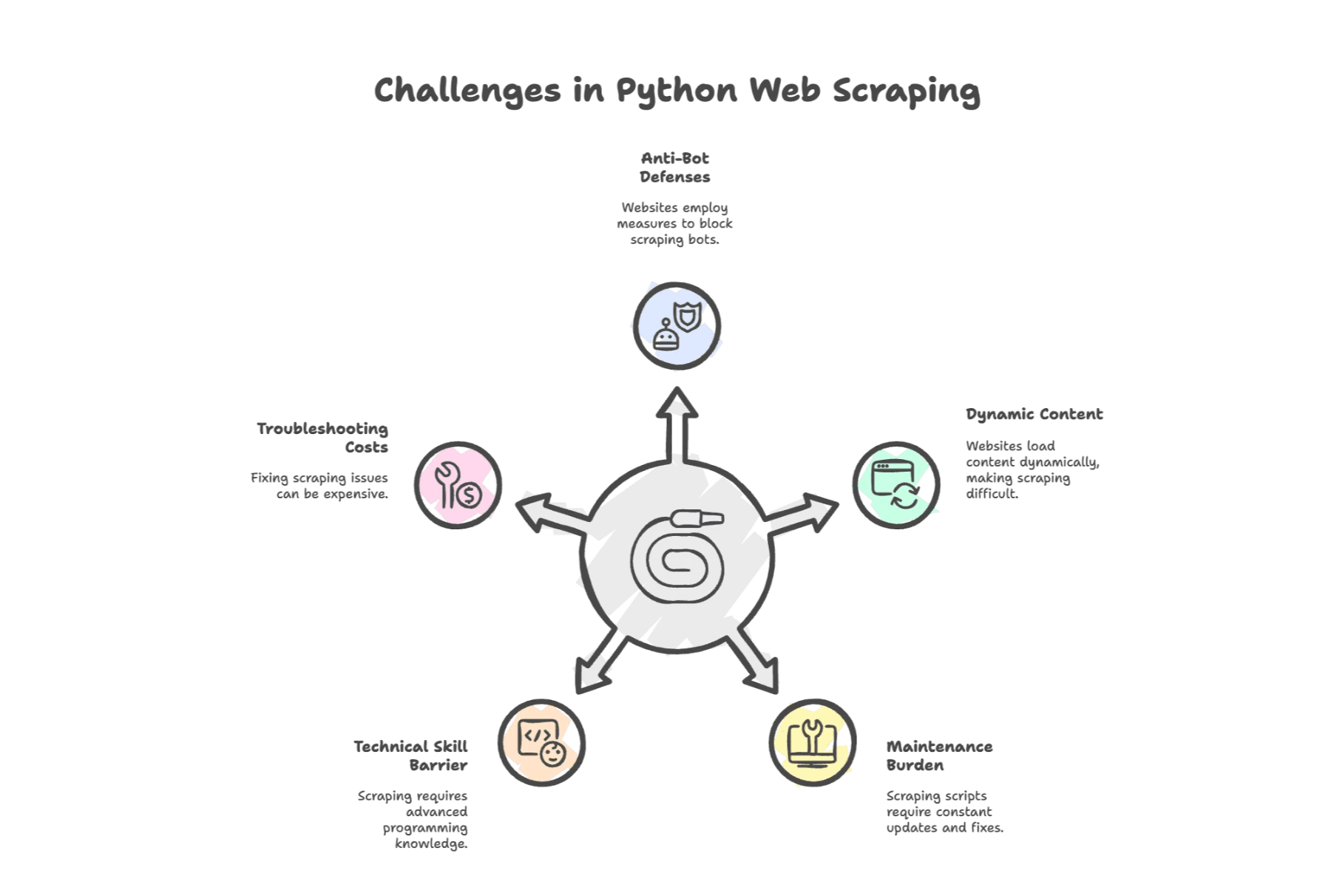

Typische Herausforderungen beim Python Web Scraping

Hier wird’s knifflig: Python Web Scraping ist mächtig, aber nicht immer einfach. Die häufigsten Stolperfallen:

1. Anti-Bot-Schutz

Webseiten wehren sich. Laut einer aktuellen Umfrage nennen Blockaden (IP-Sperren, CAPTCHAs) als größte Hürde. Viele Seiten erkennen automatisierte Zugriffe und setzen gezielt Barrieren ein.

2. Dynamische Inhalte

Moderne Webseiten setzen auf JavaScript. Werden Daten erst nachträglich geladen, bleibt dein Requests + BeautifulSoup-Skript leer. Dann hilft nur Selenium oder das Reverse-Engineering einer API.

3. Hoher Wartungsaufwand

Webseiten ändern sich ständig. Schon kleine Anpassungen im HTML können dein Skript lahmlegen. Laut Analysen verbringen Entwickler mit Reparaturen – Unternehmen geben dafür jährlich bis zu 15.000 $ aus.

4. Technische Einstiegshürden

Auch wenn Python einfach ist: Man muss HTML, CSS-Selektoren und manchmal HTTP-Protokolle verstehen. Für Nicht-Entwickler fühlt sich das wie eine neue Sprache an – und das ist es auch.

5. Aufwändige Fehlersuche

Wenn etwas schiefgeht (und das passiert), braucht man oft Proxies, Headless-Browser oder externe Dienste. Jede Stunde Debugging ist eine Stunde weniger für die eigentliche Arbeit.

Automatisierte Web-Scraping-Tools: Der nächste Schritt

Was tun, wenn man keine Zeit (oder Nerven) für Code und Fehlersuche hat? Hier kommen automatisierte Web-Scraping-Tools und moderne KI-Web-Scraper ins Spiel.

Diese Tools nehmen dir die technische Arbeit ab. Kein Skripten für jede Seite, keine nächtlichen Debugging-Sessions. Einfach Seite auswählen, Daten markieren – und fertig.

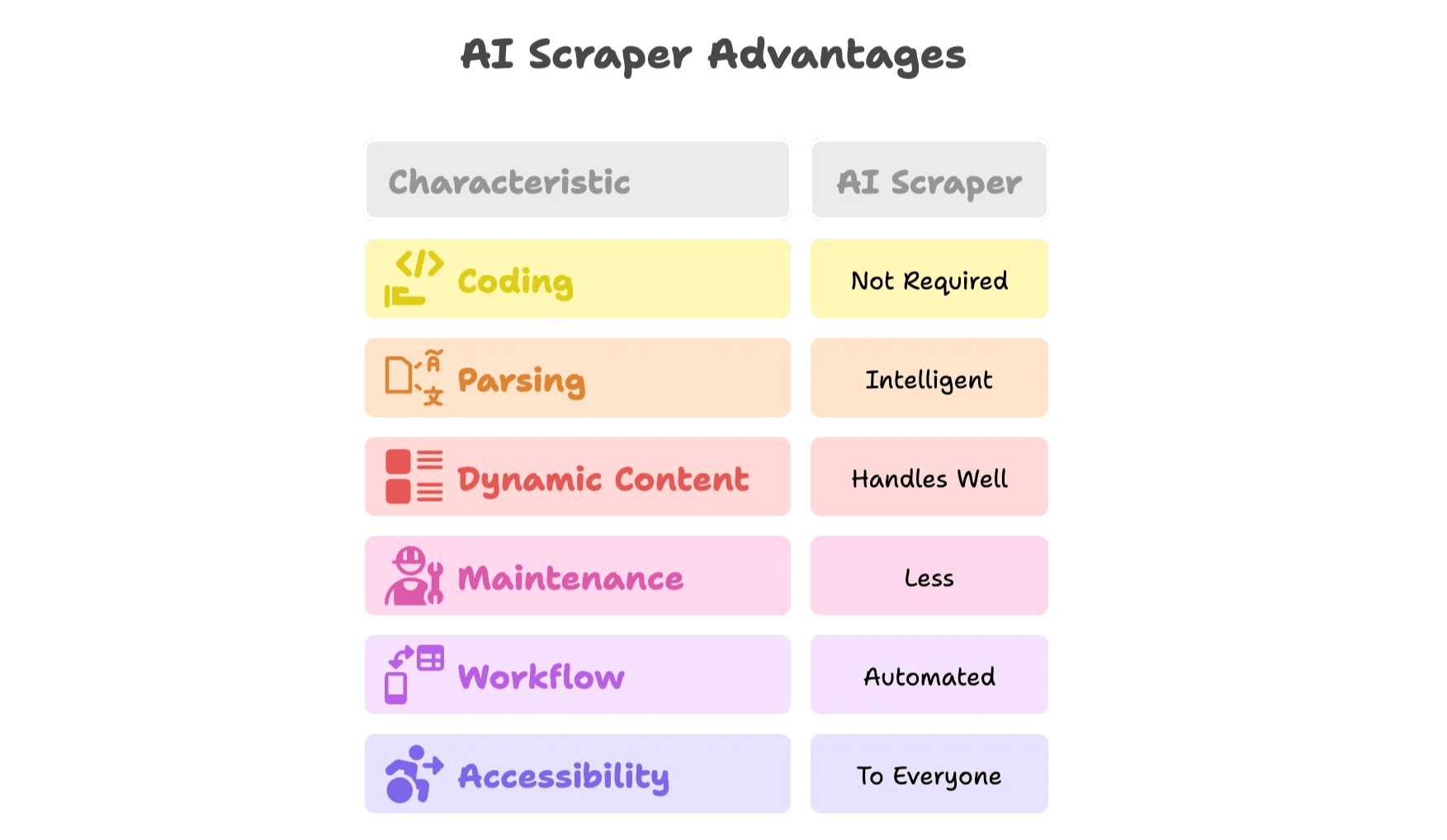

Was unterscheidet einen KI-Web-Scraper?

KI-Scraper sind ein echter Gamechanger. Warum?

- Kein Programmieren nötig: Über visuelle Oberflächen oder Browser-Erweiterungen wählst du die Daten aus, den Rest erledigt die KI.

- Intelligente Datenerkennung: KI-Modelle erkennen automatisch Felder wie Namen, Preise oder E-Mails – ganz ohne HTML-Inspektion.

- Komplexe Inhalte kein Problem: KI-Scraper arbeiten im echten Browser, können also auch JavaScript, Scrollen und Klicks verarbeiten.

- Weniger Wartung: Ändert sich eine Seite, passt sich die KI an – oder das Tool-Team liefert Updates.

- Automatisierte Workflows: Scrapes planen, Daten direkt nach Google Sheets, Airtable, Notion oder Excel exportieren.

- Für alle zugänglich: Keine Abhängigkeit mehr vom „Python-Profi“ im Team.

Wie das in der Praxis aussieht, zeigt .

Thunderbit: Die clevere Alternative zu Python Web Scraping

Ich habe Thunderbit mitgegründet, weil ich gesehen habe, wie viel Zeit und Energie Teams mit manuellen Scraping-Prozessen vergeuden. Unser Ziel: Webdaten für alle zugänglich machen – ohne Programmierung, ohne Frust, einfach Ergebnisse.

Die wichtigsten Funktionen des Thunderbit KI-Web-Scrapers

- 2-Klick-KI-Web-Scraper: Webseite öffnen, „KI-Felder vorschlagen“ anklicken – Thunderbit schlägt die besten Spalten vor. Ein Klick auf „Scrapen“ und fertig.

- Vorlagen für beliebte Seiten: Für Plattformen wie Amazon, Zillow, LinkedIn & Co. gibt es fertige Templates – keine Einrichtung nötig.

- Unterseiten & Paginierung: Thunderbit klickt automatisch in Unterseiten (z. B. Produktdetails) und kommt auch mit Paginierung oder Endlos-Scroll klar.

- Kostenloser Datenexport: Exportiere deine Daten nach Excel, Google Sheets, Airtable oder Notion – ohne Bezahlschranke.

- E-Mail- & Telefon-Extraktoren: Kontaktdaten mit einem Klick extrahieren – ideal für Vertrieb und Lead-Generierung.

- KI-gestützte Datenverarbeitung: Daten direkt zusammenfassen, kategorisieren, übersetzen oder formatieren.

- Geplantes Scraping: Wiederkehrende Scrapes mit natürlicher Sprache planen.

- Cloud- & Browser-Modus: Wähle zwischen schnellem Cloud-Scraping oder browserbasiertem Scraping für Login-Seiten.

- Unterstützung für 34 Sprachen: Thunderbit ist für internationale Teams gemacht.

Du willst es ausprobieren? Schau dir unsere und den für Anleitungen und Praxisbeispiele an.

Wann solltest du von Python auf einen KI-Scraper umsteigen?

Hier eine schnelle Checkliste zur Entscheidungshilfe:

| Situation | Python-Skript | KI-Scraper (Thunderbit) |

|---|---|---|

| Einfache, einmalige statische Seite | ✔️ | ✔️ |

| Dynamische Inhalte (JS, Logins, Endlos-Scroll) | ⚠️ | ✔️ |

| Häufige Webseitenänderungen, hoher Wartungsaufwand | ⚠️ | ✔️ |

| Nicht-technisches Team, schnelle Ergebnisse nötig | ⚠️ | ✔️ |

| Datenintegration in verschiedene Tools (Sheets, CRM) | ⚠️ | ✔️ |

| Großprojekte, wiederkehrende Scrapes | ⚠️ | ✔️ |

| Bedarf an Planung, Anreicherung oder Automatisierung | ⚠️ | ✔️ |

Wenn du in deinem Workflow viele ⚠️ siehst, ist es Zeit, einen KI-Scraper auszuprobieren.

Bonus: Tipps für effizientes und nachhaltiges Webdaten-Management

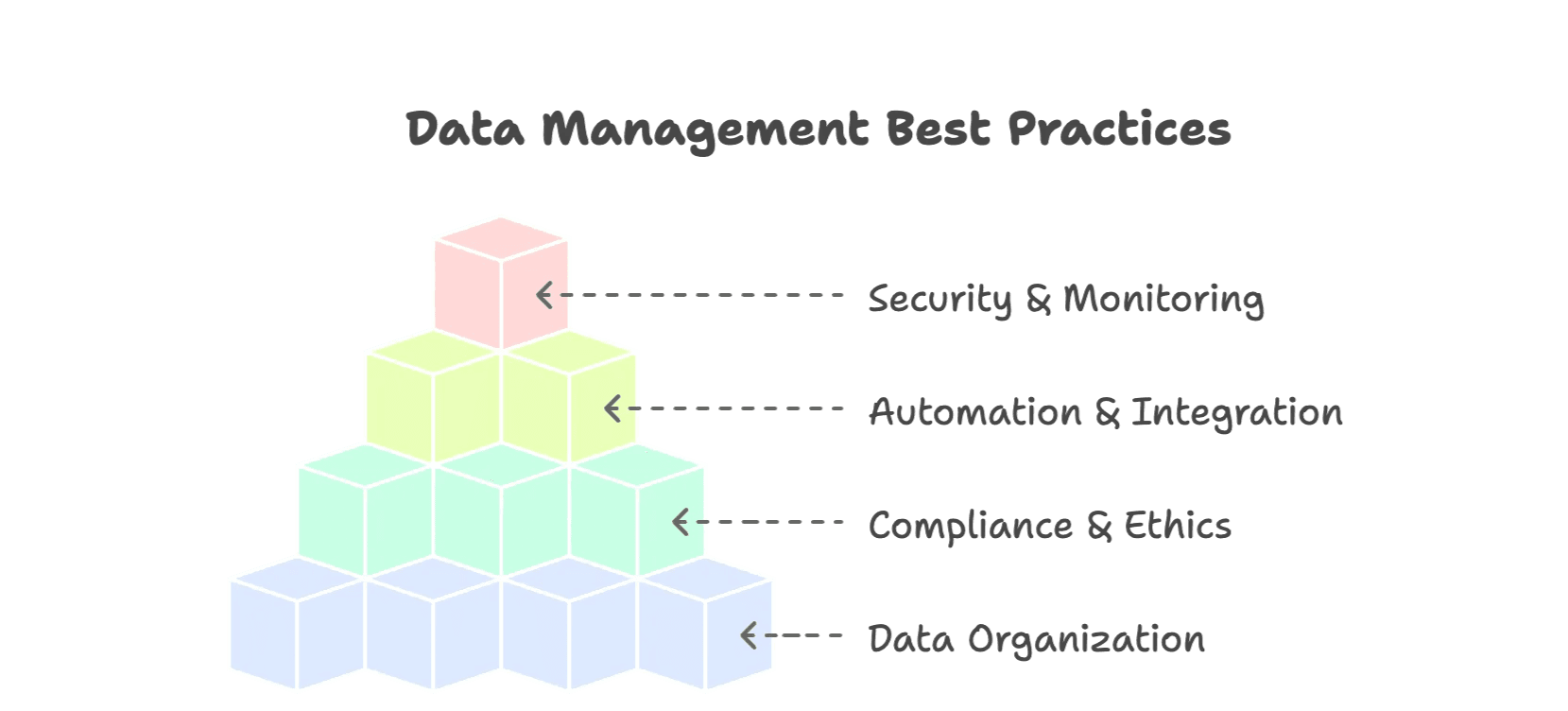

Egal ob Python oder KI-Tool – mit diesen Best Practices holst du das Beste aus deinen Daten:

1. Daten sauber organisieren

- Nutze strukturierte Formate (CSV, Excel, Datenbanken).

- Felder vereinheitlichen (z. B. Datumsformate, Währungen, Kategorien).

- Metadaten (Quelle, Scrape-Datum) ergänzen.

- Doppelte Einträge entfernen und Daten validieren.

2. Rechtlich und ethisch korrekt bleiben

- Respektiere robots.txt und die Nutzungsbedingungen der Webseiten ().

- Keine Überlastung der Server – Pausen einbauen.

- Keine sensiblen oder personenbezogenen Daten scrapen.

- Wenn möglich, öffentliche APIs nutzen.

3. Automatisieren und integrieren

- Wiederkehrende Scrapes planen.

- Daten direkt in Workflow-Tools (Sheets, Airtable, Notion) exportieren.

- Fehler frühzeitig durch Monitoring erkennen.

4. Sicherheit und Monitoring

- Scraping-Läufe und Fehler protokollieren.

- Datensicherungen anlegen.

- Zugriff auf sensible Daten beschränken.

Mehr Tipps findest du in .

Fazit: Web Scraping wird intelligenter

Die Zeiten von handgeschriebenen Python-Skripten und stundenlangem Debugging sind vorbei. Webdaten sind heute ein strategischer Vorteil – fließen in öffentliche Webdaten, und der Markt für KI-gestützte Scraping-Tools wird bis geschätzt.

Python ist nach wie vor super, um die Grundlagen zu lernen und kleinere Scraping-Aufgaben zu lösen. Doch mit der steigenden Komplexität moderner Webseiten braucht es neue Tools. KI-Scraper wie Thunderbit bieten einen effizienteren, flexibleren Ansatz – genau passend für die Anforderungen moderner Teams.

Wenn du mehr Zeit mit Fehlersuche als mit Ergebnissen verbringst oder neugierig bist, wie modernes Scraping funktioniert, probiere Thunderbit aus: . Dein Sales-, E-Commerce- oder Operations-Team wird den Unterschied merken.