Das Web im Jahr 2025 fühlt sich an wie ein chaotischer, ständig wechselnder Dschungel – eben noch checkst du die Preise deiner Mitbewerber, im nächsten Moment kämpfst du dich durch dynamisches JavaScript und trickreiche Anti-Bot-Sperren. Nach Jahren in der Entwicklung von Automatisierungslösungen für Sales- und Operations-Teams kann ich sagen: Web-Scraping ist längst kein nettes Extra mehr, sondern eine absolute Kernkompetenz für jedes Business. Mittlerweile setzen auf Datenanalysen für strategische Entscheidungen, und das Online-Datenvolumen ist in nur vier Jahren um . Wer es schafft, das wilde Web-Chaos in brauchbare Insights zu verwandeln, gehört zu den Gewinnern.

Aber mal ehrlich: Web-Scraping ist heute ein ganz anderes Spiel als noch vor ein paar Jahren. Die Zeiten, in denen ein paar Zeilen Python-Code gereicht haben, um statisches HTML zu holen, sind vorbei. Heute warten dynamische Inhalte, endloses Scrollen und Anti-Bot-Technik, die selbst Profis ins Schwitzen bringt. Egal, ob du gerade erst loslegst oder dein Scraping-Setup aufs nächste Level bringen willst – in diesem Guide zeige ich dir die besten Methoden, Tools und Workflows für Python-Scraping im Jahr 2025. Außerdem erfährst du, wie du mit KI-Tools wie deine Projekte noch smarter machst.

Von den Basics zum Scraping-Profi: Python-Scraping verstehen

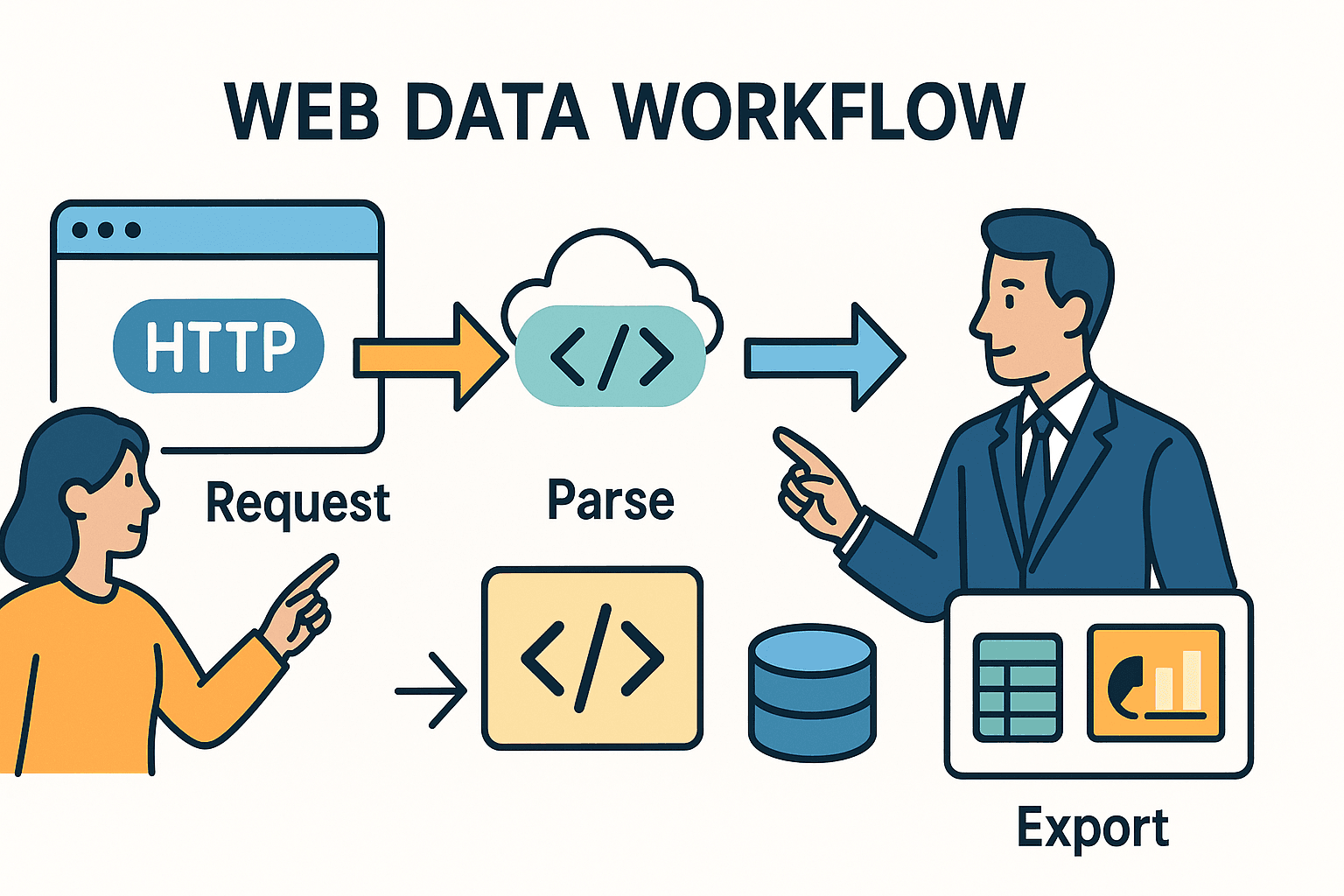

Lass uns ganz vorne anfangen. Web-Scraping heißt im Grunde: Das, was du sonst im Browser manuell machen würdest, automatisieren – also Seite aufrufen, Daten finden, abspeichern. In Python läuft das meistens in drei Schritten ab:

- HTTP-Anfrage schicken (wie dein Browser beim Laden einer URL).

- HTML parsen, um die gewünschten Infos zu finden.

- Daten exportieren oder weiterverarbeiten – zum Beispiel in eine Tabelle, Datenbank oder ein Dashboard.

Wichtig: Welche Tools du brauchst (und welche Hürden du nehmen musst), hängt davon ab, wie komplex die Website ist und was du vorhast.

Python-Scraping 101: So läuft’s ab

Stell dir Scraping vor wie einen Bibliothekar, der für dich die Zeitung holt, und du schneidest mit der Schere nur die Artikel aus, die dich interessieren. Die Python-Bibliothek requests ist dein Bibliothekar – sie holt das HTML. BeautifulSoup ist deine Schere – damit schneidest du gezielt die relevanten Infos heraus.

Aber was, wenn die Zeitung mit unsichtbarer Tinte geschrieben ist (Stichwort JavaScript!) oder die Artikel über viele Seiten verteilt sind? Dann brauchst du fortgeschrittene Tools – oder ein bisschen KI-Magie.

Die wichtigsten Tools im Vergleich

Hier ein schneller Überblick über die gängigsten Python-Scraping-Tools und wann du sie am besten einsetzt:

| Tool/Bibliothek | Einsatz, wenn... | Vorteile | Nachteile |

|---|---|---|---|

| Requests + BeautifulSoup | Statische Seiten oder kleine Aufgaben | Einfach, schnell, ideal für Einsteiger. Volle Kontrolle. | Kein JavaScript, nicht für große Crawls geeignet. |

| Scrapy | Große Projekte, viele Seiten/Websites | Sehr leistungsstark, integriertes Crawling, asynchron, Pipelines, robustes Fehlerhandling. | Höhere Einstiegshürde, mehr Setup-Aufwand. |

| Selenium/Playwright | Seiten mit JavaScript, Logins oder Nutzerinteraktion | Kann alles extrahieren, was im Browser sichtbar ist. Für dynamische Inhalte, Logins, Infinite Scroll. | Langsamer, ressourcenintensiv, komplexer im Betrieb. |

| Thunderbit (KI) | Unstrukturierte Daten, PDFs, Bilder, No-Code | KI erkennt Felder automatisch, verarbeitet Unterseiten, Export nach Excel/Sheets, kein Coding nötig. | Weniger flexibel bei Spezialfällen, nutzungsabhängig. |

Für die meisten Business-Anwendungen reicht requests mit BeautifulSoup für einfache, statische Seiten völlig aus. Bei größeren oder komplexeren Aufgaben ist Scrapy die richtige Wahl. Und wenn du an Grenzen stößt – etwa bei dynamischen Inhalten, Anti-Bot-Schutz oder unstrukturierten Daten – sind KI-Tools wie oft die Rettung.

Schritt für Schritt: Best Practices für komplexes Scraping

Wie kommst du von „Ich will diese Daten“ zu einem stabilen, wartbaren Scraper? Hier mein bewährter Workflow:

1. Zielseite analysieren und verstehen

Bevor du loslegst, öffne die Entwicklertools deines Browsers (F12 oder Rechtsklick > Untersuchen). Such die gewünschten Daten im HTML. Stehen sie in einer Tabelle? In mehreren <div>s? Gibt es vielleicht einen versteckten API-Call, der JSON liefert? Oft ist der einfachste Weg direkt vor deiner Nase.

Tipp: Siehst du im Netzwerk-Tab eine Anfrage, die beim Klicken auf „Nächste Seite“ oder „Mehr laden“ JSON zurückliefert, kannst du meist direkt diese API mit Python ansprechen – HTML-Parsing entfällt.

2. Prototyp auf einer Einzelseite bauen

Starte klein. Hole mit requests eine Seite, extrahiere mit BeautifulSoup ein paar Felder und gib sie aus. Falls du blockiert wirst oder Daten fehlen, probiere es mit Headern (z. B. User-Agent wie im Browser) oder prüfe, ob die Inhalte per JavaScript nachgeladen werden (dann siehe Schritt 3).

3. Dynamische Inhalte und Paginierung meistern

Sind die Daten nicht im HTML, werden sie vermutlich per JavaScript geladen. Was tun?

- Browser-Automatisierung: Nutze oder , um die Seite zu öffnen, auf Inhalte zu warten und das gerenderte HTML zu extrahieren.

- API-Calls: Suche im Netzwerk-Tab nach XHR-Anfragen. Findest du eine JSON-API, kannst du diese meist direkt mit

requestsansprechen. - Paginierung: Bei mehreren Seiten durchlaufe die Seitennummern oder folge „Weiter“-Links. Bei Infinite Scroll scrolle mit Selenium nach unten oder simuliere die API-Calls, die beim Scrollen ausgelöst werden.

4. Fehlerbehandlung und Fairness

Websites freuen sich selten über Scraper. Damit du nicht blockiert wirst:

- robots.txt beachten: Prüfe immer

example.com/robots.txtauf gesperrte Pfade oder Crawl-Delays. - Rate Limiting: Baue Pausen (

time.sleep()) zwischen Anfragen ein. Steht in der robots.txtCrawl-delay: 5, dann warte mindestens 5 Sekunden. - Eigener User-Agent: Stelle dich höflich vor (z. B.

"MyScraper/1.0 (your@email.com)"). - Retry-Logik: Fange Fehler mit try/except ab. Wiederhole Anfragen bei Fehlern, pausiere bei HTTP 429 (zu viele Anfragen).

5. Daten extrahieren und bereinigen

Nutze BeautifulSoup oder Scrapy-Selektoren, um Felder zu extrahieren. Entferne Leerzeichen, wandle Preise in Zahlen um, parse Datumsangaben und prüfe die Vollständigkeit. Bei großen Datenmengen hilft pandas beim Bereinigen und Duplikate entfernen.

6. Unterseiten scrapen

Oft stecken die wirklich wertvollen Infos auf Detailseiten. Extrahiere eine Liste von Links und besuche jede Seite einzeln, um weitere Daten zu holen. In Python bedeutet das: URLs durchlaufen und jede Seite abfragen. Mit kannst du die Funktion „Unterseiten scrapen“ nutzen – die KI besucht automatisch jede Detailseite und ergänzt deinen Datensatz.

7. Export und Automatisierung

Exportiere deine bereinigten Daten als CSV, Excel, Google Sheets oder in eine Datenbank. Für wiederkehrende Aufgaben plane dein Skript mit cron, Airflow oder (bei Thunderbit) mit einer natürlichen Spracheingabe wie „jeden Montag um 9 Uhr“ als Cloud-Scrape.

Thunderbit: Wenn KI dein Python-Scraping aufs nächste Level hebt

Manchmal stößt selbst der beste Python-Code an seine Grenzen – etwa bei unstrukturierten, chaotischen oder geschützten Daten. Genau hier kommt ins Spiel.

So ergänzt Thunderbit Python

Thunderbit ist eine KI-basierte Chrome-Erweiterung, die Webseiten (oder PDFs, Bilder usw.) liest und strukturierte Daten ausgibt – ganz ohne Programmierung. So setze ich es ein:

- Bei unstrukturierten Daten: Wenn ich auf PDFs, Bilder oder unvorhersehbares HTML stoße, lasse ich Thunderbits KI die Arbeit machen. Sie extrahiert Tabellen aus PDFs, liest Texte aus Bildern und schlägt sogar Felder automatisch vor.

- Für Unterseiten und mehrstufiges Scraping: Die Funktion „Unterseiten scrapen“ spart enorm Zeit. Erstellt eine Liste, dann besucht die KI jede Detailseite und kombiniert die Ergebnisse – ohne dass ich verschachtelte Schleifen schreiben oder Zustände verwalten muss.

- Für den Export: Thunderbit exportiert direkt nach Excel, Google Sheets, Notion oder Airtable. Die Daten kann ich dann in meine Python-Pipeline übernehmen und weiterverarbeiten.

Praxisbeispiel: Python + Thunderbit im Zusammenspiel

Angenommen, ich beobachte Immobilienangebote. Mit Python und Scrapy sammele ich die Listing-URLs verschiedener Portale. Doch auf einer Seite stehen die Details nur in herunterladbaren PDFs. Statt einen eigenen PDF-Parser zu schreiben, lade ich die Dateien bei Thunderbit hoch, lasse die KI die Tabellen extrahieren und exportiere als CSV. Anschließend führe ich alle Daten in Python für eine Marktanalyse zusammen.

Oder ich baue eine Lead-Liste für den Vertrieb. Mit Python sammele ich die Firmen-URLs, dann nutze ich Thunderbits E-Mail- und Telefon-Extraktoren (kostenlos!), um Kontaktdaten von jeder Seite zu ziehen – ganz ohne Regex-Frust.

Einen nachhaltigen Scraping-Workflow aufbauen: Von Skript zu Pipeline

Ein einmaliges Skript ist nett für schnelle Ergebnisse, aber die meisten Business-Scraping-Prozesse laufen regelmäßig. So baue ich einen wartbaren, skalierbaren Scraping-Stack:

Das CCCD-Modell: Crawl, Collect, Clean, Debug

- Crawl: Sammle alle Ziel-URLs (aus Sitemaps, Suchseiten oder Listen).

- Collect: Extrahiere die Daten von jeder URL (mit Python, Thunderbit oder beidem).

- Clean: Normalisiere, entferne Duplikate und prüfe die Daten.

- Debug/Monitor: Protokolliere jeden Lauf, fange Fehler ab und richte Benachrichtigungen bei Problemen oder Auffälligkeiten ein.

Stell dir das als Pipeline vor:

URLs → [Crawler] → [Scraper] → [Cleaner] → [Exporter] → [Business-Plattform]

Planung und Überwachung

- Für Python: Nutze cronjobs, Airflow oder Cloud-Scheduler, um Skripte regelmäßig auszuführen. Protokolliere Ausgaben, versende E-Mail- oder Slack-Benachrichtigungen bei Fehlern.

- Für Thunderbit: Nutze den integrierten Scheduler – einfach „jeden Montag um 9 Uhr“ eintippen, und Thunderbit erledigt den Rest in der Cloud und exportiert die Daten dorthin, wo du sie brauchst.

Dokumentation und Übergabe

Lege deinen Code in einer Versionsverwaltung (z. B. Git) ab, dokumentiere den Workflow und stelle sicher, dass mindestens eine weitere Person weiß, wie die Pipeline läuft oder aktualisiert wird. Bei gemischten Python/Thunderbit-Workflows notiere, welches Tool welche Seite übernimmt und wohin die Ergebnisse gehen (z. B. „Thunderbit extrahiert Site C nach Google Sheets, Python führt wöchentlich alle Daten zusammen“).

Ethik und Recht: Verantwortungsvolles Scraping 2025

Mit großer Scraping-Power kommt große Verantwortung. So bleibst du rechtlich und ethisch auf der sicheren Seite:

Robots.txt und Fairness

- robots.txt prüfen: Sieh dir immer die robots.txt der Seite an, um gesperrte Pfade und Crawl-Delays zu erkennen. Mit Pythons

robotparserkannst du das automatisieren. - Höfliches Scraping: Baue Pausen zwischen Anfragen ein, besonders wenn ein Crawl-Delay angegeben ist. Überlaste die Seite nie mit zu vielen Anfragen.

- User-Agent: Gib dich ehrlich zu erkennen. Gib dich nicht als Googlebot oder Browser aus.

Datenschutz und Compliance

- DSGVO/CCPA: Wenn du personenbezogene Daten (Namen, E-Mails, Telefonnummern) sammelst, musst du sie gemäß Datenschutzgesetzen behandeln. Nur das Nötigste extrahieren, Daten sicher speichern und auf Anfrage löschen können.

- Nutzungsbedingungen: Scrape keine Inhalte hinter Logins ohne Erlaubnis. Viele ToS verbieten automatisierten Zugriff – Verstöße können zu Sperrungen oder Schlimmerem führen.

- Nur öffentliche Daten: Beschränke dich auf öffentlich zugängliche Informationen. Keine privaten, urheberrechtlich geschützten oder sensiblen Daten extrahieren.

Compliance-Checkliste

- [ ] robots.txt auf Regeln und Delays geprüft

- [ ] Fairen Rate-Limit und eigenen User-Agent gesetzt

- [ ] Nur öffentliche, nicht sensible Daten extrahiert

- [ ] Personenbezogene Daten datenschutzkonform behandelt

- [ ] Keine ToS- oder Urheberrechtsverletzungen

Häufige Fehler und Debugging-Tipps: So wird dein Scraper robust

Auch die besten Scraper stoßen auf Probleme. Hier die häufigsten Fehler – und wie ich sie löse:

This paragraph contains content that cannot be parsed and has been skipped.

Debugging-Workflow:

- Gib das rohe HTML aus, wenn etwas schiefgeht.

- Vergleiche mit den Browser-DevTools, was dein Skript sieht vs. was der Browser anzeigt.

- Logge jeden Schritt – URLs, Statuscodes, Anzahl der extrahierten Elemente.

- Teste erst mit einer kleinen Stichprobe, bevor du skalierst.

Fortgeschrittene Projektideen: So hebst du dein Python-Scraping aufs nächste Level

Bereit, Best Practices in die Tat umzusetzen? Hier ein paar Praxisprojekte:

1. Preisüberwachung für E-Commerce

Preise und Lagerbestände von Amazon, eBay und Walmart extrahieren. Anti-Bot-Maßnahmen und dynamische Inhalte meistern, täglich nach Google Sheets exportieren und Trends analysieren. Nutze für schnelle Ergebnisse.

2. Jobbörsen-Aggregator

Stellenanzeigen von Indeed und Nischenportalen sammeln. Titel, Unternehmen, Standorte und Veröffentlichungsdaten extrahieren. Paginierung meistern und nach Job-ID deduplizieren. Tägliche Exporte nach Airtable planen.

3. Kontakt-Extraktor für Lead-Generierung

Aus einer Liste von Firmen-URLs E-Mails und Telefonnummern von Start- und Kontaktseiten extrahieren. Regex in Python oder Thunderbits kostenlose Extraktoren für Ein-Klick-Ergebnisse nutzen. Export nach Excel für das Vertriebsteam.

4. Immobilienanzeigen-Vergleich

Angebote von Zillow und Realtor.com für eine bestimmte Region scrapen. Adressen und Preise normalisieren, Trends vergleichen und Ergebnisse in Google Sheets visualisieren.

5. Social-Media-Mentions-Tracker

Markenerwähnungen auf Reddit über deren JSON-API verfolgen. Beitragszahlen aggregieren, Sentiment analysieren und Zeitreihendaten für Marketing-Insights exportieren.

Fazit: Die wichtigsten Erkenntnisse für Python-Scraping 2025

Hier die wichtigsten Punkte im Überblick:

- Web-Scraping ist wichtiger denn je für Business Intelligence, Vertrieb und Operations. Das Web ist eine Goldgrube – wenn du weißt, wie du sie erschließt.

- Python ist dein Schweizer Taschenmesser: Starte einfach mit

requestsundBeautifulSoup, skaliere mit Scrapy und nutze Browser-Automatisierung für dynamische Seiten. - KI-Tools wie Thunderbit sind dein Geheimtipp für unstrukturierte, komplexe oder No-Code-Scraping-Aufgaben. Kombiniere Python und KI für maximale Effizienz.

- Best Practices sind entscheidend: Erst analysieren, modular coden, Fehler abfangen, Daten bereinigen und den Workflow automatisieren.

- Compliance ist Pflicht: Immer robots.txt prüfen, Datenschutzgesetze beachten und ethisch scrapen.

- Bleib flexibel: Das Web verändert sich – überwache deine Scraper, debugge regelmäßig und passe deine Strategie an.

Die Zukunft des Web-Scrapings ist hybrid, verantwortungsvoll und businessorientiert. Egal ob Einsteiger oder Profi: Bleib neugierig, lerne weiter und lass die Daten deinen nächsten Erfolg antreiben.

Anhang: Python-Scraping-Tutorials & Tools

Hier meine Favoriten zum Lernen und Troubleshooten:

- – HTTP für Menschen, mit allen Extras.

- – HTML-Parsing wie ein Profi lernen.

- – Für große, produktive Scraping-Projekte.

- / – Für Browser-Automatisierung und dynamische Inhalte.

- – Der einfachste KI-Web-Scraper für Business-Anwender.

- – Tutorials, Praxisbeispiele und Best Practices für KI-gestütztes Scraping.

- – Immer auf dem neuesten Stand zu Compliance und Ethik.

- / ** – Community-Fragen und Troubleshooting.

Und wenn du sehen willst, wie Thunderbit dein Scraping wirklich vereinfacht, schau auf unserem vorbei – dort gibt’s Demos und Deep Dives.

FAQs

1. Welche Python-Bibliothek ist 2025 am besten für Web-Scraping?

Für statische Seiten und kleine Aufgaben bleibt requests + BeautifulSoup die erste Wahl. Für große oder mehrseitige Scrapes ist optimal. Für dynamische Inhalte nutze oder . Für unstrukturierte oder schwierige Daten sind KI-Tools wie unschlagbar.

2. Wie gehe ich mit JavaScript-lastigen oder dynamischen Seiten um?

Nutze Browser-Automatisierung wie Selenium oder Playwright, um die Seite zu rendern und Daten zu extrahieren. Alternativ: Im Netzwerk-Tab nach API-Calls suchen, die JSON liefern – das ist oft einfacher und stabiler zu scrapen.

3. Ist Web-Scraping legal?

Das Extrahieren öffentlicher Daten ist in den USA meist legal, aber prüfe immer die , beachte die Nutzungsbedingungen und halte dich an Datenschutzgesetze wie DSGVO/CCPA. Niemals private, urheberrechtlich geschützte oder sensible Daten scrapen.

4. Wie kann ich meine Scraping-Workflows automatisieren und planen?

Für Python-Skripte nutze cronjobs, Airflow oder Cloud-Scheduler. Für No-Code-Automatisierung bietet einen integrierten Scheduler – einfach Zeitplan in Klartext eingeben und die Cloud erledigt den Rest.

5. Was tun, wenn mein Scraper nicht mehr funktioniert?

Prüfe zuerst, ob sich die Website-Struktur geändert hat oder ob du blockiert wirst (HTTP 403/429). HTML inspizieren, Selektoren anpassen, Anfragen verlangsamen und auf Anti-Bot-Maßnahmen achten. Bei hartnäckigen Problemen Thunderbits KI-Features oder Browser-Automatisierung nutzen.

Viel Erfolg beim Scrapen – möge deine Datenquelle immer sauber, compliant und einsatzbereit sein. Wenn du sehen willst, wie Thunderbit in deinen Workflow passt, und probiere es aus. Und für noch mehr Tipps ist der immer einen Besuch wert.