Mal ehrlich: Wer hat schon Lust, morgens 500 Produktpreise per Copy & Paste in eine Tabelle zu schieben? (Falls doch, Hut ab – gönn dir auf jeden Fall eine ordentliche Handgelenkstütze!) Egal ob du im Vertrieb, im Operations-Team oder einfach der Konkurrenz immer einen Schritt voraus sein willst: Wer mit Webdaten arbeitet, kennt das Problem. Webdaten sind heute das Rückgrat vieler Geschäftsprozesse – und der Bedarf an automatisierter Datenerfassung wächst rasant. .

Nach etlichen Jahren in der SaaS- und Automatisierungswelt habe ich schon alles gesehen: Von heldenhaften Excel-Makros bis zu Python-Skripten, die nachts um zwei noch schnell zusammengezimmert wurden. In diesem Leitfaden zeige ich dir, wie du mit einem Python HTML Parser echte Webdaten extrahierst (wir holen uns gemeinsam IMDb-Filmbewertungen!) – und warum es 2025 noch cleverer geht: Mit KI-Tools wie , die dir den ganzen Code-Kram abnehmen und direkt Ergebnisse liefern.

Was ist ein HTML Parser – und warum Python?

Kurz gesagt: Ein HTML Parser ist wie dein persönlicher Bibliothekar fürs Web. Er nimmt den oft chaotischen HTML-Code einer Webseite auseinander und bringt ihn in eine übersichtliche Baumstruktur. So kannst du gezielt die Infos rausziehen, die du brauchst – Titel, Preise, Links – ohne im Tag-Dschungel unterzugehen.

Python ist für diese Aufgabe die erste Wahl – und das aus gutem Grund. Die Sprache ist leicht verständlich, einsteigerfreundlich und bietet eine riesige Auswahl an Bibliotheken für Web-Scraping und Parsing. – dank flacher Lernkurve und einer starken Community.

Die wichtigsten Python HTML Parser im Überblick

Hier die gängigsten Tools, um HTML in Python zu parsen:

- BeautifulSoup: Der Klassiker, besonders für Einsteiger super geeignet.

- lxml: Extrem schnell und leistungsstark, unterstützt komplexe Abfragen.

- html5lib: Sehr tolerant bei fehlerhaftem HTML, arbeitet ähnlich wie ein Browser.

- PyQuery: Erlaubt jQuery-ähnliche Selektoren in Python.

- HTMLParser: Der eingebaute Parser von Python – immer verfügbar, aber recht minimalistisch.

Jede Bibliothek hat ihre Eigenheiten, aber alle helfen dir, aus rohem HTML strukturierte Daten zu machen.

Typische Anwendungsfälle: So profitieren Unternehmen von Python HTML Parsern

Webdaten-Extraktion ist längst nicht mehr nur ein Thema für Entwickler oder Data Scientists. Gerade im Vertrieb und in der Betriebsführung ist sie heute unverzichtbar. Warum?

| Anwendungsfall (Branche) | Typische Daten | Geschäftlicher Nutzen |

|---|---|---|

| Preisüberwachung (Einzelhandel) | Wettbewerberpreise, Lagerbestände | Dynamische Preisgestaltung, bessere Margen (Quelle) |

| Wettbewerbsanalyse | Produktlisten, Bewertungen, Verfügbarkeit | Lücken erkennen, Leads generieren (Quelle) |

| Lead-Generierung (B2B-Vertrieb) | Firmennamen, E-Mails, Kontakte | Automatisierte Akquise, Wachstum der Pipeline (Quelle) |

| Marktsentiment (Marketing) | Social Posts, Bewertungen, Ratings | Echtzeit-Feedback, Trends erkennen (Quelle) |

| Immobilien-Übersicht | Inserate, Preise, Maklerinfos | Marktanalyse, Preisstrategie (Quelle) |

| Recruiting-Intelligenz | Kandidatenprofile, Gehälter | Talentsuche, Gehaltsbenchmarks (Quelle) |

Kurz gesagt: Wer noch manuell Daten kopiert, verschenkt Zeit und Geld.

Die wichtigsten Python HTML Parser im Vergleich

Jetzt wird’s praktisch. Hier ein schneller Vergleich der beliebtesten Python HTML Parser, damit du das passende Tool für deinen Anwendungsfall findest:

| Bibliothek | Bedienkomfort | Geschwindigkeit | Flexibilität | Wartungsaufwand | Ideal für |

|---|---|---|---|---|---|

| BeautifulSoup | ⭐⭐⭐⭐⭐ | ⭐⭐ | ⭐⭐⭐ | Mittel | Einsteiger, unordentliches HTML |

| lxml | ⭐⭐ | ⭐⭐⭐⭐⭐ | ⭐⭐⭐⭐ | Mittel | Geschwindigkeit, XPath, große Dokumente |

| html5lib | ⭐⭐⭐ | ⭐ | ⭐⭐⭐⭐⭐ | Gering | Browser-ähnliches Parsen, fehlerhaftes HTML |

| PyQuery | ⭐⭐⭐ | ⭐⭐⭐⭐ | ⭐⭐⭐ | Mittel | jQuery-Fans, CSS-Selektoren |

| HTMLParser | ⭐⭐⭐ | ⭐⭐⭐ | ⭐ | Gering | Einfache, eingebaute Aufgaben |

BeautifulSoup: Der perfekte Einstieg

BeautifulSoup ist der Klassiker für Einsteiger. Die Syntax ist leicht verständlich, die Dokumentation super, und auch mit fehlerhaftem HTML kommt das Tool gut klar (). Nachteil: Bei großen oder komplexen Seiten ist es nicht das schnellste und unterstützt keine fortgeschrittenen Selektoren wie XPath von Haus aus.

lxml: Schnell und leistungsstark

Wenn du Wert auf Geschwindigkeit legst oder XPath-Abfragen nutzen willst, ist lxml die richtige Wahl (). Die Bibliothek basiert auf C und ist daher extrem schnell, aber die Installation kann knifflig sein und die Lernkurve ist steiler.

Weitere Alternativen: html5lib, PyQuery und HTMLParser

- html5lib: Parst HTML wie ein Browser – ideal bei fehlerhaftem oder ungewöhnlichem Markup, aber langsam ().

- PyQuery: Erlaubt jQuery-ähnliche Selektoren in Python – praktisch für alle mit Frontend-Erfahrung ().

- HTMLParser: Die eingebaute Lösung von Python – schnell und immer verfügbar, aber mit begrenztem Funktionsumfang.

Schritt 1: Python HTML Parser-Umgebung einrichten

Bevor du loslegst, musst du deine Python-Umgebung vorbereiten. So geht’s:

-

Python installieren: Download unter , falls noch nicht vorhanden.

-

pip installieren: Ab Python 3.4 meist schon dabei, sonst im Terminal

pip --versionprüfen. -

Bibliotheken installieren (für dieses Tutorial nutzen wir BeautifulSoup und requests):

1pip install beautifulsoup4 requests lxmlbeautifulsoup4ist der Parser.requestslädt Webseiten herunter.lxmlist ein schneller Parser, den BeautifulSoup nutzen kann.

-

Installation prüfen:

1python -c "import bs4, requests, lxml; print('Alles ok!')"

Tipps bei Problemen:

- Bei Berechtigungsfehlern:

pip install --user ...verwenden - Auf Mac/Linux ggf.

python3undpip3nutzen - Bei „ModuleNotFoundError“: Schreibweise und Umgebung prüfen

Schritt 2: Deine erste Webseite mit Python parsen

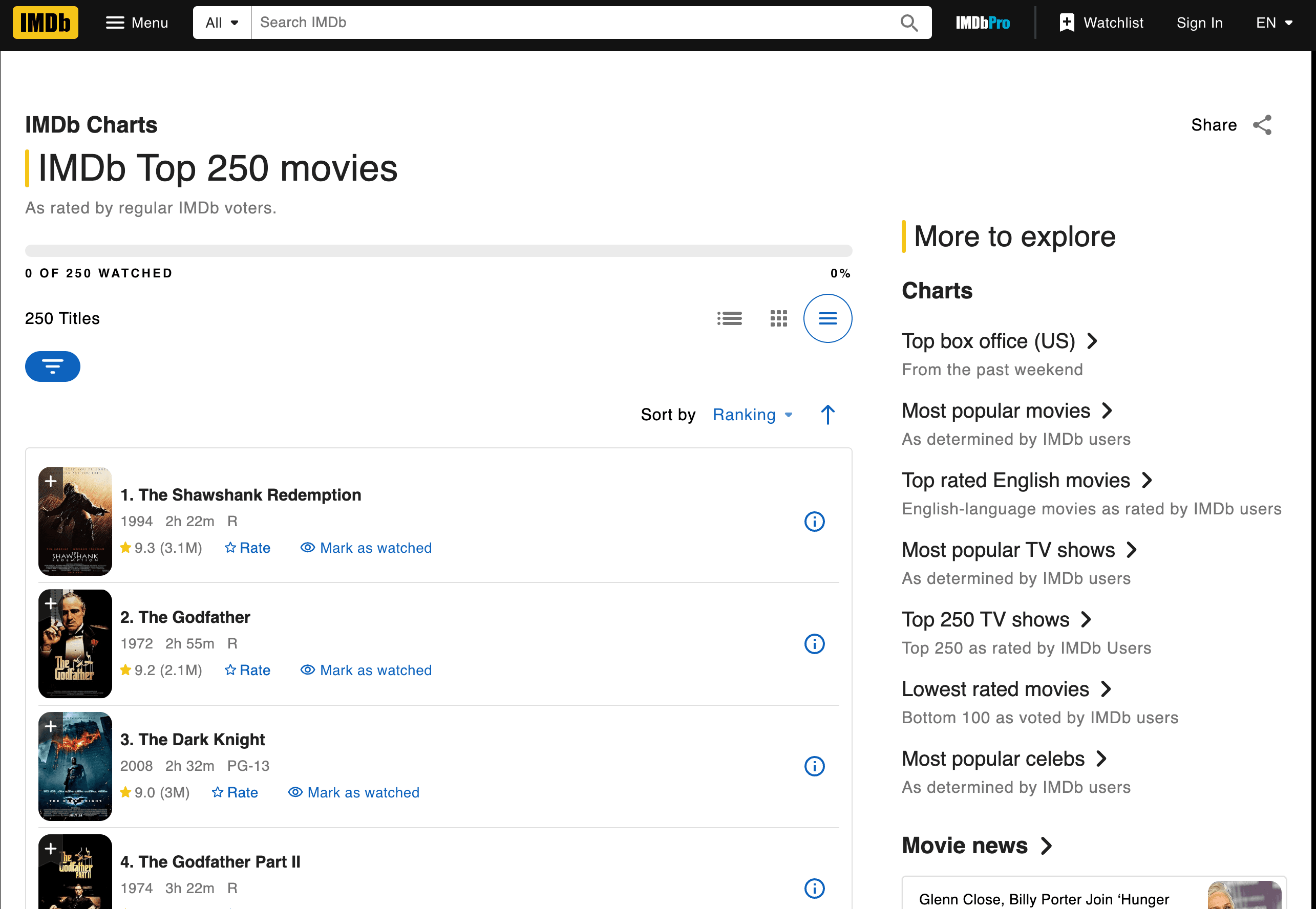

Jetzt wird’s praktisch: Wir holen uns die Top 250 Filme von IMDb – inklusive Titel, Jahr und Bewertung.

Seite abrufen und parsen

Hier ein Beispiel-Skript:

1import requests

2from bs4 import BeautifulSoup

3url = "<https://www.imdb.com/chart/top/>"

4resp = requests.get(url)

5soup = BeautifulSoup(resp.text, 'html.parser')

6# Alle Titel- und Bewertungszellen finden

7title_cells = soup.find_all('td', class_='titleColumn')

8rating_cells = soup.find_all('td', class_='ratingColumn imdbRating')

9# Die ersten 3 Filme als Beispiel ausgeben

10for i in range(3):

11 title_cell = title_cells[i]

12 rating_cell = rating_cells[i]

13 title = title_cell.a.text

14 year = title_cell.span.text.strip("()")

15 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

16 print(f"{i+1}. {title} ({year}) -- Bewertung: {rating}")Was passiert hier?

- Mit

requests.get()holen wir die Seite. BeautifulSoupparst das HTML.- Wir suchen die relevanten

<td>-Elemente anhand ihrer Klassen. - Wir extrahieren Titel, Jahr und Bewertung als Text.

Ausgabe:

11. Die Verurteilten (1994) -- Bewertung: 9.3

22. Der Pate (1972) -- Bewertung: 9.2

33. The Dark Knight (2008) -- Bewertung: 9.0Daten extrahieren: Titel, Bewertungen und mehr

Wie weiß man, welche Tags und Klassen man braucht? Einfach im Browser die IMDb-Seite mit Rechtsklick > „Element untersuchen“ analysieren. Achte auf wiederkehrende Muster – hier steht jeder Film in <td class="titleColumn">, die Bewertung in <td class="ratingColumn imdbRating"> ().

Tipp: Bei anderen Seiten immer zuerst die HTML-Struktur und eindeutige Klassen prüfen.

Ergebnisse speichern und exportieren

So speicherst du die Daten als CSV:

1import csv

2movies = []

3for i in range(len(title_cells)):

4 title_cell = title_cells[i]

5 rating_cell = rating_cells[i]

6 title = title_cell.a.text

7 year = title_cell.span.text.strip("()")

8 rating = rating_cell.strong.text if rating_cell.strong else rating_cell.text

9 movies.append([title, year, rating])

10with open('imdb_top250.csv', 'w', newline='', encoding='utf-8') as f:

11 writer = csv.writer(f)

12 writer.writerow(['Titel', 'Jahr', 'Bewertung'])

13 writer.writerows(movies)Praxistipps zur Datenbereinigung:

- Mit

.strip()Leerzeichen entfernen - Fehlende Daten mit

if-Abfragen abfangen - Für Excel-Export: CSV in Excel öffnen oder mit

pandasdirekt.xlsxschreiben

Schritt 3: HTML-Änderungen und Wartungsaufwand meistern

Jetzt wird’s knifflig: Webseiten ändern gerne mal ihr Layout – manchmal gefühlt nur, um Scraper zu ärgern. Wenn IMDb z.B. class="titleColumn" in class="movieTitle" ändert, liefert dein Skript plötzlich keine Ergebnisse mehr. Schon erlebt, schon geflucht.

Wenn Skripte plötzlich nicht mehr funktionieren

Typische Probleme:

- Selektoren nicht gefunden: Das Tag oder die Klasse existiert nicht mehr.

- Leere Ergebnisse: Die Seitenstruktur hat sich geändert oder Inhalte werden per JavaScript nachgeladen.

- HTTP-Fehler: Die Seite hat Anti-Bot-Maßnahmen eingeführt.

So gehst du vor:

- Prüfe, ob das HTML, das du parst, mit dem im Browser übereinstimmt.

- Passe deine Selektoren an die neue Struktur an.

- Werden Inhalte dynamisch geladen, brauchst du ggf. ein Tool wie Selenium oder suchst nach einer API.

Das eigentliche Problem: Wer viele verschiedene Seiten scraped, verbringt oft mehr Zeit mit Reparaturen als mit der eigentlichen Datenanalyse ().

Schritt 4: Skalierung – Die versteckten Kosten manuellen Python-Scrapings

Angenommen, du willst nicht nur IMDb, sondern auch Amazon, Zillow, LinkedIn und viele weitere Seiten auslesen. Jede Seite braucht ihr eigenes Skript. Und bei jeder Änderung bist du wieder am Debuggen.

Die versteckten Kosten:

- Wartungsaufwand: .

- Infrastruktur: Proxies, Fehlerbehandlung, Monitoring werden nötig.

- Performance: Skalierung erfordert parallele Verarbeitung, Rate-Limits etc.

- Qualitätssicherung: Je mehr Skripte, desto mehr Fehlerquellen.

Gerade für nicht-technische Teams ist das kaum zu stemmen. Es ist, als würde man ein Praktikantenteam zum Copy-Pasten anheuern – nur dass die Praktikanten Python-Skripte sind, die bei jeder Webseitenänderung „krank“ werden.

Mehr als Python HTML Parser: Thunderbit als KI-Alternative

Jetzt wird’s spannend: Was wäre, wenn du auf Code und Wartung verzichten und trotzdem immer die gewünschten Daten bekommen könntest – egal, wie sich die Webseite verändert?

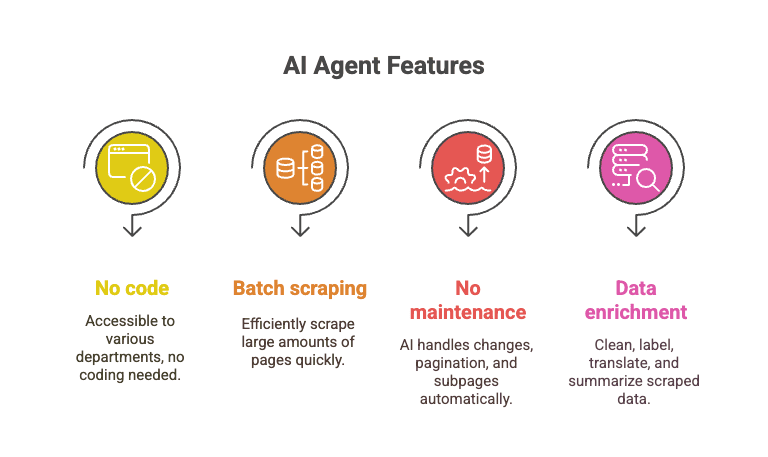

Genau das bietet : Ein KI-Web-Scraper als Chrome-Erweiterung, mit dem du strukturierte Daten aus jeder Webseite in wenigen Klicks extrahierst. Kein Python, keine Skripte, keine Kopfschmerzen.

Python HTML Parser vs. Thunderbit: Der Direktvergleich

| Kriterium | Python HTML Parser | Thunderbit (Preise ansehen) |

|---|---|---|

| Einrichtungsaufwand | Hoch (Installation, Code, Debugging) | Gering (Erweiterung installieren, klicken) |

| Bedienkomfort | Programmierkenntnisse nötig | Kein Code – einfach klicken |

| Wartung | Hoch (Skripte brechen oft) | Gering (KI passt sich automatisch an) |

| Skalierbarkeit | Komplex (Skripte, Proxies, Infrastruktur) | Integriert (Cloud-Scraping, Batch-Jobs) |

| Datenanreicherung | Manuell (zusätzlicher Code) | Integriert (Labeling, Bereinigung, Übersetzung, Unterseiten) |

Warum selbst bauen, wenn KI das Problem löst?

Warum KI für Webdaten-Extraktion?

Thunderbits KI-Agent liest die Seite, erkennt die Struktur und passt sich bei Änderungen automatisch an. Es ist wie ein Super-Praktikant, der nie schläft und sich nie über geänderte Klassennamen beschwert.

- Kein Code nötig: Jeder kann es nutzen – Vertrieb, Operations, Marketing usw.

- Batch-Scraping: 10.000+ Seiten in der Zeit, in der ein Python-Skript noch debuggt wird.

- Keine Wartung: Die KI übernimmt Layout-Änderungen, Paginierung, Unterseiten und mehr.

- Datenanreicherung: Daten direkt beim Scraping bereinigen, labeln, übersetzen und zusammenfassen.

Stell dir vor, du scrapest alle IMDb Top 250 Filme, dazu alle Detailseiten und Bewertungen – mit wenigen Klicks, während dein Python-Skript noch an Zeile 12 mit einem „NoneType“-Fehler hängt.

Schritt-für-Schritt: IMDb-Bewertungen mit Thunderbit extrahieren

So einfach geht’s mit Thunderbit:

- .

- Zur navigieren.

- Thunderbit-Icon anklicken.

- „AI Suggest Fields“ wählen. Thunderbit erkennt automatisch die passenden Spalten (Titel, Jahr, Bewertung).

- Spalten prüfen oder anpassen.

- Auf „Scrape“ klicken. Thunderbit extrahiert alle 250 Einträge in Sekunden.

- Export nach Excel, Google Sheets, Notion oder als CSV – ganz nach Wunsch.

Das war’s. Kein Code, kein Debugging, keine leeren Listen mehr.

Du willst es live sehen? Schau auf dem vorbei oder lies unsere für ein weiteres Praxisbeispiel.

Fazit: Das richtige Tool für deine Webdaten

Python HTML Parser wie BeautifulSoup und lxml sind mächtig, flexibel und kostenlos. Sie sind ideal für Entwickler, die volle Kontrolle wollen und gerne selbst Hand anlegen. Aber sie bringen eine steile Lernkurve, laufenden Wartungsaufwand und versteckte Kosten mit – vor allem, wenn der Bedarf wächst.

Für Business-Anwender, Vertriebsteams und alle, die einfach nur Daten (statt Code) wollen, sind KI-Tools wie eine echte Erleichterung. Sie ermöglichen es, Webdaten schnell, sauber und angereichert zu extrahieren – ganz ohne Programmierung und Wartung.

Mein Tipp: Nutze Python, wenn du gerne skriptest und alles selbst steuern willst. Aber wenn dir deine Zeit (und Nerven) lieb sind, probiere Thunderbit aus. Warum Skripte bauen und pflegen, wenn KI die Arbeit übernimmt?

Mehr zu Web Scraping, Datenextraktion und KI-Automatisierung findest du im – zum Beispiel oder .