Hast du dich schon mal gefragt, wie Unternehmen so genau wissen, was ihre Konkurrenz verlangt oder wie Vertriebsteams scheinbar mühelos immer wieder neue Leads an Land ziehen? Die Antwort ist oft simpler, als man denkt: Ein Großteil dieser Infos kommt direkt aus dem Web – und zwar per Web-Scraping. Ich habe selbst miterlebt, wie sich Web-Scraping von einem Nerd-Thema zu einem echten Must-have für Firmen entwickelt hat – egal ob für Preisvergleiche, Marktanalysen oder Lead-Generierung. Und wenn man mal hinter die Kulissen schaut, sieht man: In den meisten Fällen läuft da Python-Code im Hintergrund. Über , und .

Aber mal ehrlich: „Python-Code für Web-Scraping“ klingt für viele erstmal abschreckend, vor allem wenn man kein Entwickler ist. In diesem Guide zeige ich dir, was Python-Web-Scraping wirklich bedeutet, warum Python so beliebt ist, wie das Ganze abläuft – und vor allem, wie Tools wie Web-Scraping für alle zugänglich machen, nicht nur für Programmierer.

Aber mal ehrlich: „Python-Code für Web-Scraping“ klingt für viele erstmal abschreckend, vor allem wenn man kein Entwickler ist. In diesem Guide zeige ich dir, was Python-Web-Scraping wirklich bedeutet, warum Python so beliebt ist, wie das Ganze abläuft – und vor allem, wie Tools wie Web-Scraping für alle zugänglich machen, nicht nur für Programmierer.

Python-Code für Web-Scraping: Was steckt dahinter?

Fangen wir ganz von vorne an. Python-Code für Web-Scraping heißt, dass du mit Python-Skripten automatisch Daten von Webseiten sammelst. Stell dir vor, du gibst einem digitalen Helfer die Aufgabe: „Geh auf diese Seite, hol mir diese Infos und speicher sie ab.“ Statt alles mühsam per Hand zu kopieren, übernimmt Python das für dich und bringt Ordnung in die Webdaten ().

Web-Scraping selbst ist einfach der automatisierte Weg, Infos aus Webseiten zu ziehen – und unstrukturierte Webinhalte in brauchbare, strukturierte Daten zu verwandeln. Es ist kein Hacking, keine Screenshots und auch keine Magie (auch wenn es manchmal so wirkt). Python-Web-Scraping bedeutet einfach, dass du Python als Sprache für diese Aufgabe nutzt.

Warum Python beim Web-Scraping so beliebt ist

Warum setzen so viele beim Web-Scraping auf Python? Hier die wichtigsten Gründe:

- Einfache, verständliche Syntax: Python ist super lesbar und auch für Einsteiger leicht zu lernen.

- Starke Bibliotheken: Mit Tools wie , und kannst du Webseiten abrufen und auch komplexes HTML easy auslesen.

- Vielseitigkeit: Egal ob simple statische Seite oder dynamische Web-App – Python hat für fast alles die passenden Tools.

- Große Community: Weil so viele Python fürs Scraping nutzen, gibt’s eine riesige Community und massig Anleitungen – Hilfe ist also immer in Reichweite.

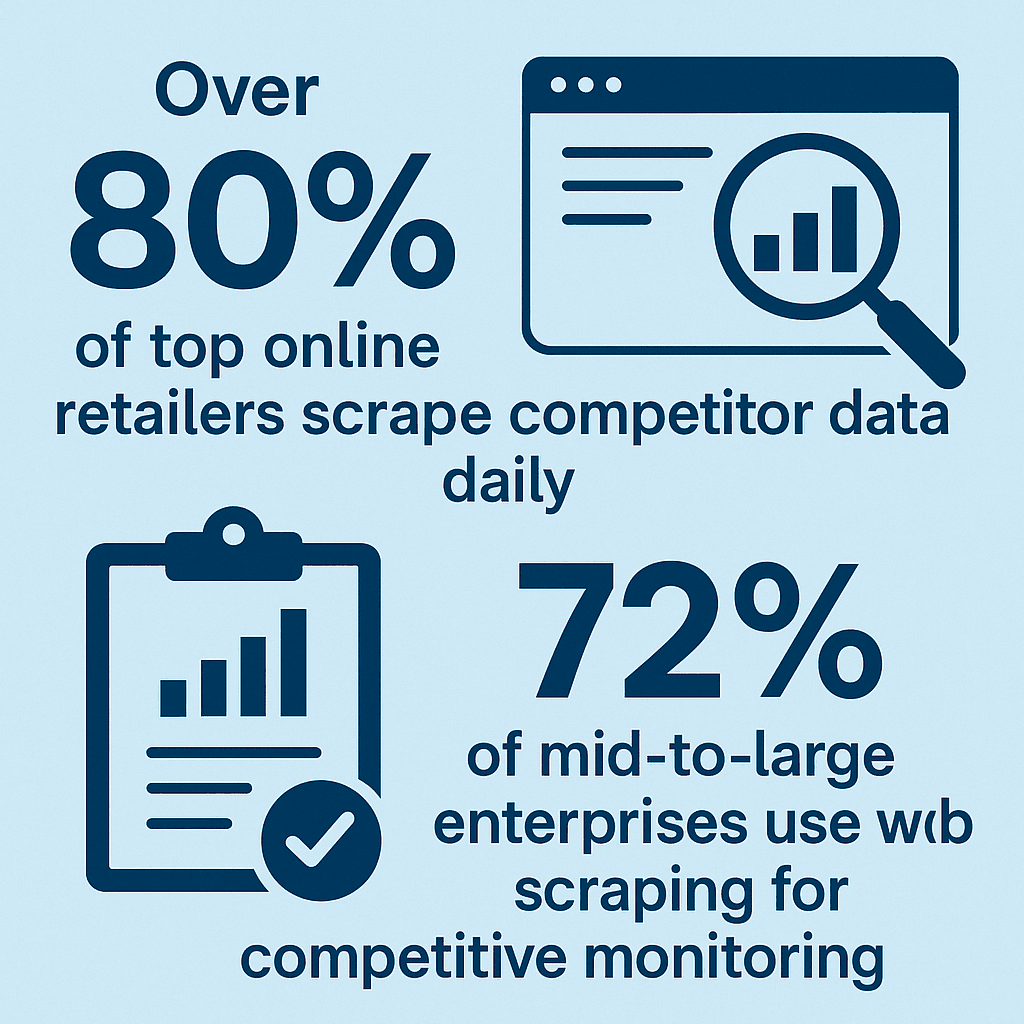

Python ist kein kurzfristiger Trend. Es ist das Rückgrat für viele datengetriebene Prozesse in Vertrieb, E-Commerce, Marketing und Finanzen. Zum Beispiel nutzen , und .

Wie läuft Python-Web-Scraping eigentlich ab?

Schauen wir uns mal an, was beim Web-Scraping mit Python im Hintergrund passiert – ganz ohne Code, nur die Grundidee:

- HTTP-Anfrage schicken: Das Python-Skript „besucht“ eine Webseite, indem es eine Anfrage losschickt – so wie du es im Browser machst.

- HTML-Inhalt abholen: Die Seite antwortet mit dem HTML-Code (quasi das Rohmaterial der Webseite).

- HTML parsen: Mit einer Bibliothek wie BeautifulSoup liest Python den HTML-Code aus und macht ihn für das Skript durchsuchbar.

- Gezielt Daten rausziehen: Das Skript sucht gezielt nach den Infos, die du brauchst – zum Beispiel Produktnamen, Preise oder E-Mail-Adressen – und liest sie aus.

- Daten speichern oder ausgeben: Die gesammelten Daten werden in ein nützliches Format gebracht (z. B. CSV, Excel, Datenbank).

Die wichtigsten Bausteine beim Python-Web-Scraping

Hier die zentralen Komponenten im Überblick:

- HTTP-Request-Modul (z. B. Requests): Baut die Verbindung zur Webseite auf und holt die Rohdaten – quasi der „Bote“.

- HTML-Parser (z. B. BeautifulSoup, lxml): Liest den HTML-Code und hilft, die richtigen Stellen zu finden – wie ein Inhaltsverzeichnis im Buch.

- Logik zur Datenerfassung: Markiert gezielt die Infos, die du brauchst (z. B. Preise).

- Speicher-/Ausgabe-Mechanismus: Legt die extrahierten Daten in einer Tabelle oder Datenbank ab.

Wenn du zum Beispiel als Vertriebler Kontakte aus einem Online-Verzeichnis sammelst, hilft dir der Python-Parser, gezielt Namen und E-Mails rauszufiltern – und nicht die ganze Seite zu kopieren.

Typische Anwendungsfälle für Python-Web-Scraping

Python-Web-Scraping ist längst nicht nur was für IT-Profis – es bringt in vielen Branchen echten Mehrwert. Hier ein paar klassische Beispiele:

| Anwendungsfall | Nutzen für Unternehmen |

|---|---|

| Lead-Generierung im Vertrieb | Automatisches Sammeln von Kontaktdaten aus Verzeichnissen oder LinkedIn – das CRM füllt sich wie von selbst. Unternehmen konnten durch Automatisierung 30 % mehr qualifizierte Leads generieren. |

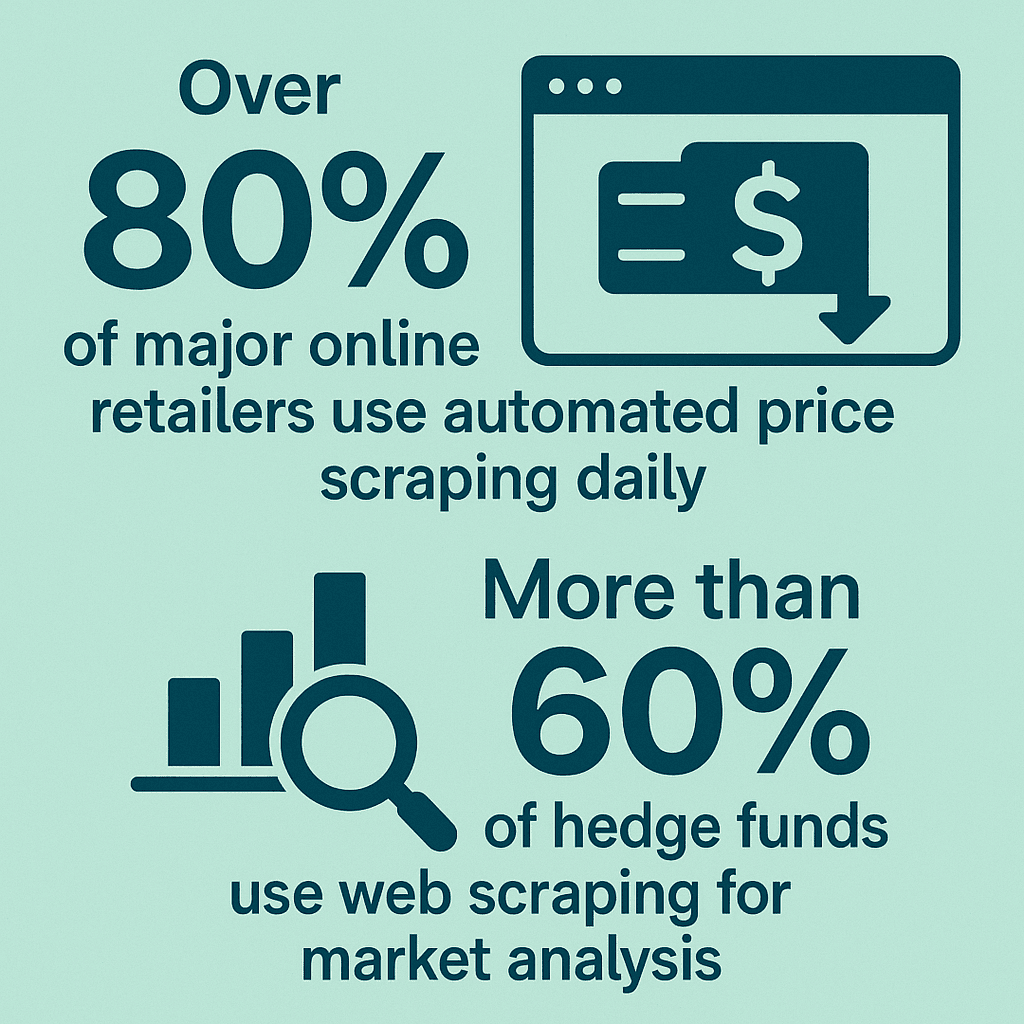

| Preisüberwachung (E-Commerce) | Konkurrenzpreise und Lagerbestände in Echtzeit verfolgen. 81 % der Händler nutzen automatisierte Preis-Scraper, um wettbewerbsfähig zu bleiben. |

| Marktforschung | Bewertungen, Nachrichten und Social-Media-Erwähnungen bündeln, um Trends und Stimmungen zu erkennen. |

| Markenreputation | Bewertungen und Social-Media-Beiträge sammeln, um das Markenimage zu überwachen und zu verbessern. |

| Immobilienanalyse | Immobilienangebote und Preise von Plattformen wie Zillow für Investitionen oder Marktanalysen extrahieren. |

Das Fazit: Python-Scraping spart dir unzählige Stunden Handarbeit und liefert Insights, die du per Hand kaum bekommen würdest.

Die Herausforderungen von Python-Web-Scraping für Nicht-Techniker

Hier wird’s tricky: So mächtig Python auch ist, für Leute ohne Programmierkenntnisse ist der Einstieg oft steinig. Typische Stolperfallen:

- Programmierkenntnisse nötig: Du musst Python und HTML verstehen und Fehler beheben können.

- Pflegeaufwand: Webseiten ändern regelmäßig ihr Layout – dann muss das Skript angepasst werden.

- Aufwendige Einrichtung: Python, Bibliotheken und Abhängigkeiten zu installieren, kann mühsam sein – vor allem bei Versionskonflikten.

- Anti-Bot-Schutz: Viele Seiten setzen CAPTCHAs, Zugriffsbeschränkungen oder IP-Sperren ein. Diese zu umgehen, braucht Erfahrung.

- Zeitaufwand: Ein robustes Skript zu schreiben und zu pflegen, kann Stunden oder Tage dauern – besonders bei komplexen Seiten.

Ich kenne viele Business-Anwender, die sich ins Web-Scraping einarbeiten wollten, aber an Layout-Änderungen oder Fehlern gescheitert sind. Für viele ist der Aufwand am Ende größer als gedacht ().

Thunderbit: Die No-Code-Alternative zu Python beim Web-Scraping

Hier kommt ins Spiel. Als Mitgründer und CEO bin ich natürlich voreingenommen – aber ich bin überzeugt: Thunderbit ist der einfachste Weg für Business-Anwender, Webdaten ganz ohne Programmierkenntnisse zu extrahieren.

Thunderbit ist eine , mit der du Daten einfach per Beschreibung extrahieren kannst. Die Funktion „KI-Felder vorschlagen“ liest die Seite, schlägt passende Spalten vor und strukturiert die Daten automatisch. Kein Code, keine komplizierte Einrichtung – einfach Ergebnisse.

So macht Thunderbit Web-Scraping super easy

So läuft ein typischer Thunderbit-Workflow ab:

- Erweiterung installieren: Thunderbit über unsere zu Chrome hinzufügen.

- Zielseite öffnen: Die gewünschte Webseite im Browser aufrufen.

- „KI-Felder vorschlagen“ klicken: Thunderbits KI analysiert die Seite und schlägt relevante Datenspalten vor (z. B. „Produktname“, „Preis“, „Bild“).

- Felder prüfen oder anpassen: Spalten umbenennen, hinzufügen oder entfernen – auch individuelle Anweisungen sind möglich.

- „Scrapen“ klicken: Thunderbit extrahiert die Daten in eine übersichtliche Tabelle – Listen, Unterseiten und Paginierung werden automatisch erkannt.

- Daten exportieren: Als CSV/Excel herunterladen oder direkt nach Google Sheets, Airtable oder Notion exportieren.

Thunderbit kann auch Unterseiten scrapen (z. B. Detailseiten), Cloud-Scraping (bis zu 50 Seiten gleichzeitig) und geplantes Scraping (z. B. tägliche Preisüberwachung oder Lead-Updates). Für kleine Aufgaben ist Thunderbit sogar kostenlos.

Mehr dazu findest du im oder in unseren .

Python-Code vs. Thunderbit: Der direkte Vergleich beim Web-Scraping

Stellen wir Python und Thunderbit mal direkt gegenüber:

| Kriterium | Python-Code für Web-Scraping | Thunderbit (No-Code KI-Tool) |

|---|---|---|

| Benutzerfreundlichkeit | Programmierkenntnisse und Einrichtung erforderlich. | Intuitive Point-and-Click-Oberfläche; für jeden nutzbar. |

| Flexibilität | Extrem flexibel; jede Logik möglich, wenn man programmieren kann. | Deckt die meisten Business-Anwendungen ab; für Spezialfälle ist Code nötig. |

| Skalierbarkeit | Skalierbar, aber Verwaltung von Servern, Proxys etc. liegt beim Nutzer. | Integriertes Cloud-Scraping für bis zu 50 Seiten gleichzeitig; ideal für die meisten Geschäftsanforderungen. |

| Wartung | Skripte brechen bei Layout-Änderungen; man muss sie selbst reparieren. | KI passt sich Layout-Änderungen an; kaum Wartungsaufwand für Nutzer. |

| Anti-Bot-Handling | Proxys, Verzögerungen und weitere Tricks müssen selbst implementiert werden. | Thunderbit kümmert sich im Hintergrund um Anti-Bot-Maßnahmen. |

| Lernkurve | Für Nicht-Programmierer steil; Python und HTML müssen gelernt werden. | Sehr niedrig; die meisten Nutzer erzielen in wenigen Minuten Ergebnisse. |

| Kosten | Python ist kostenlos, aber Zeit- und ggf. Entwicklerkosten fallen an. | Kostenlose Basisversion; kostenpflichtige Pläne für größere Datenmengen. |

| Ideal für | Entwickler, Technik-Teams oder sehr individuelle/groß angelegte Projekte. | Business-Anwender, Vertrieb, Marketing, Operations – alle, die schnell und einfach an Daten kommen wollen. |

Kurz gesagt: Python ist unschlagbar für individuelle, komplexe oder tief integrierte Scraping-Projekte – vorausgesetzt, du hast das Know-how und die Zeit. Thunderbit ist perfekt für alle, die ohne Aufwand und Wartung schnell an Daten kommen wollen.

Rechtliches & Risiken: Was du beim Web-Scraping beachten solltest

Egal, welches Tool du nutzt: Web-Scraping bringt rechtliche und ethische Pflichten mit sich. Das solltest du beachten:

- Nur öffentliche Daten scrapen: Alles, was du ohne Login oder Bezahlung im Browser siehst, ist in der Regel okay. Hinter Logins oder Paywalls solltest du nicht scrapen ().

- AGB und robots.txt respektieren: Schau dir immer die Nutzungsbedingungen und die robots.txt der Seite an. Bei Verbot drohen Sperren oder rechtliche Konsequenzen.

- Server nicht überlasten: Mach Pausen zwischen den Anfragen, damit die Seite nicht überlastet wird. Viele Tools (auch Thunderbit) haben eingebaute Limits.

- Keine personenbezogenen Daten: Bei Namen, E-Mails oder sensiblen Infos ist besondere Vorsicht geboten – Datenschutzgesetze wie DSGVO und CCPA gelten.

- Daten verantwortungsvoll nutzen: Keine urheberrechtlich geschützten Inhalte veröffentlichen und keine persönlichen Daten für Spam verwenden.

Mehr zum Thema Compliance findest du im .

Fazit: So findest du den richtigen Ansatz fürs Web-Scraping

Zusammengefasst:

- Python-Code für Web-Scraping ist ein mächtiges Tool zur Automatisierung der Datensammlung – braucht aber Programmierkenntnisse, laufende Wartung und Zeit.

- Die Stärken von Python liegen in Flexibilität, Skalierbarkeit und individueller Anpassung. Perfekt für Entwickler oder Teams mit speziellen Anforderungen.

- Thunderbit und andere No-Code-Tools machen Web-Scraping für alle zugänglich. Dank KI-gestützter Felderkennung, Unterseiten-Scraping und Sofort-Export ist Thunderbit ideal für Business-Anwender, die ohne Aufwand Ergebnisse wollen.

- Compliance ist Pflicht: Immer verantwortungsvoll scrapen – nur öffentliche Daten, Regeln der Seite beachten und keine Server überlasten oder personenbezogene Daten missbrauchen.

Mein Tipp: Wähle das Tool, das zu deinen technischen Skills und deinem Projekt passt. Wenn du als Business-Anwender einfach nur schnell an Daten kommen willst, – du wirst überrascht sein, wie viel du mit ein paar Klicks erreichen kannst. Und wenn du gerne programmierst, ist Python dein Spielfeld.

Du willst tiefer einsteigen? Im findest du weitere Anleitungen, oder schau in unsere .

Häufige Fragen (FAQ)

1. Was ist Python-Code für Web-Scraping?

Python-Code für Web-Scraping heißt, dass du mit Python-Skripten automatisch Daten von Webseiten sammelst und strukturierst – wie ein programmierbarer Roboter, der Online-Infos für dich sortiert.

2. Warum ist Python beim Web-Scraping so beliebt?

Python punktet mit leicht verständlicher Syntax, starken Bibliotheken (wie BeautifulSoup, Scrapy und Requests) und einer großen Community. Es eignet sich für einfache wie auch komplexe Webanwendungen.

3. Was sind die größten Herausforderungen beim Web-Scraping mit Python?

Die größten Hürden sind die nötigen Programmierkenntnisse, die laufende Wartung der Skripte (weil sich Webseiten oft ändern), der Umgang mit Anti-Bot-Maßnahmen und der Zeitaufwand für Einrichtung und Fehlerbehebung.

4. Wie unterscheidet sich Thunderbit von Python-Code beim Web-Scraping?

Thunderbit ist eine No-Code-KI-Erweiterung für Chrome, mit der du Webdaten per Mausklick extrahierst – ganz ohne Programmierung. Perfekt für Business-Anwender, die schnell Ergebnisse wollen, ohne sich mit Code oder Wartung zu beschäftigen.

5. Ist Web-Scraping legal?

Web-Scraping ist in der Regel legal, wenn du öffentlich zugängliche Daten sammelst und die Nutzungsbedingungen, robots.txt und Datenschutzgesetze beachtest. Vermeide Scraping hinter Logins, das Überlasten von Servern oder das Sammeln personenbezogener Daten ohne Einwilligung.

Bereit, das Potenzial von Web-Scraping für dein Unternehmen zu entdecken? und verwandle das Web in verwertbare Daten – ganz ohne Python.