Ich erinnere mich noch lebhaft an den Moment, als ich zum ersten Mal jemanden dabei beobachtete, wie er stundenlang Daten per Copy-Paste von einer Webseite in eine Tabelle übertrug. Das war, als würde man versuchen, mit einem Teelöffel einen Swimmingpool leerzuschöpfen. Heute hat sich die Welt der Prozessautomatisierung rasant weiterentwickelt – vor allem beim Web-Scraping. Doch je mehr Teams ihre wiederkehrenden Aufgaben automatisieren wollen, desto öfter taucht eine neue Frage auf: Sollte man auf klassische RPA (Robotic Process Automation) setzen oder direkt auf KI-Agenten und KI-Web-Scraper umsteigen?

Wer im Vertrieb, E-Commerce oder in der operativen Abwicklung arbeitet, kennt diese Unsicherheit nur zu gut. Die Zahlen sprechen für sich: , weitere 19 % planen es in naher Zukunft. Gleichzeitig gewinnen KI-Agenten und KI-Web-Scraper immer mehr an Fahrt und versprechen, selbst die komplexesten und dynamischsten Webseiten mit wenigen Klicks zu automatisieren. Wie also entscheidet man sich? Schauen wir uns an, was Prozessautomatisierung wirklich bedeutet, worin sich RPA und KI-Agenten unterscheiden und warum die Zukunft des Web-Scrapings immer mehr nach dem -Ansatz aussieht.

Was steckt hinter Prozessautomatisierung?

Ganz einfach gesagt: Prozessautomatisierung bedeutet, dass Software die langweiligen, immer gleichen Aufgaben übernimmt. Stell dir das wie eine automatische Waschanlage für dein Unternehmen vor – Maschinen erledigen die Routine, damit du dich auf die wirklich wichtigen Dinge konzentrieren kannst (oder zumindest auf deinen Kaffee).

Im Alltag geht es bei Prozessautomatisierung darum, Abläufe zu verschlanken, Fehler zu vermeiden und das Team zu entlasten. Beim Web-Scraping heißt das: Tools übernehmen das Sammeln von Daten – etwa Preise, Kontaktdaten oder Bewertungen – direkt von Webseiten, ohne dass du jede Seite einzeln durchklicken musst. Statt stundenlangem Kopieren und Einfügen richtest du einen digitalen „Roboter“ oder Agenten ein, der die Arbeit übernimmt. Es ist wie ein E-Mail-Autoresponder – nur für das ganze Internet.

Die Vorteile sind klar: . Aus meiner Erfahrung mit SaaS- und Automatisierungslösungen kann ich sagen: Wer einmal Web-Scraping automatisiert hat, will nie wieder manuell Daten sammeln.

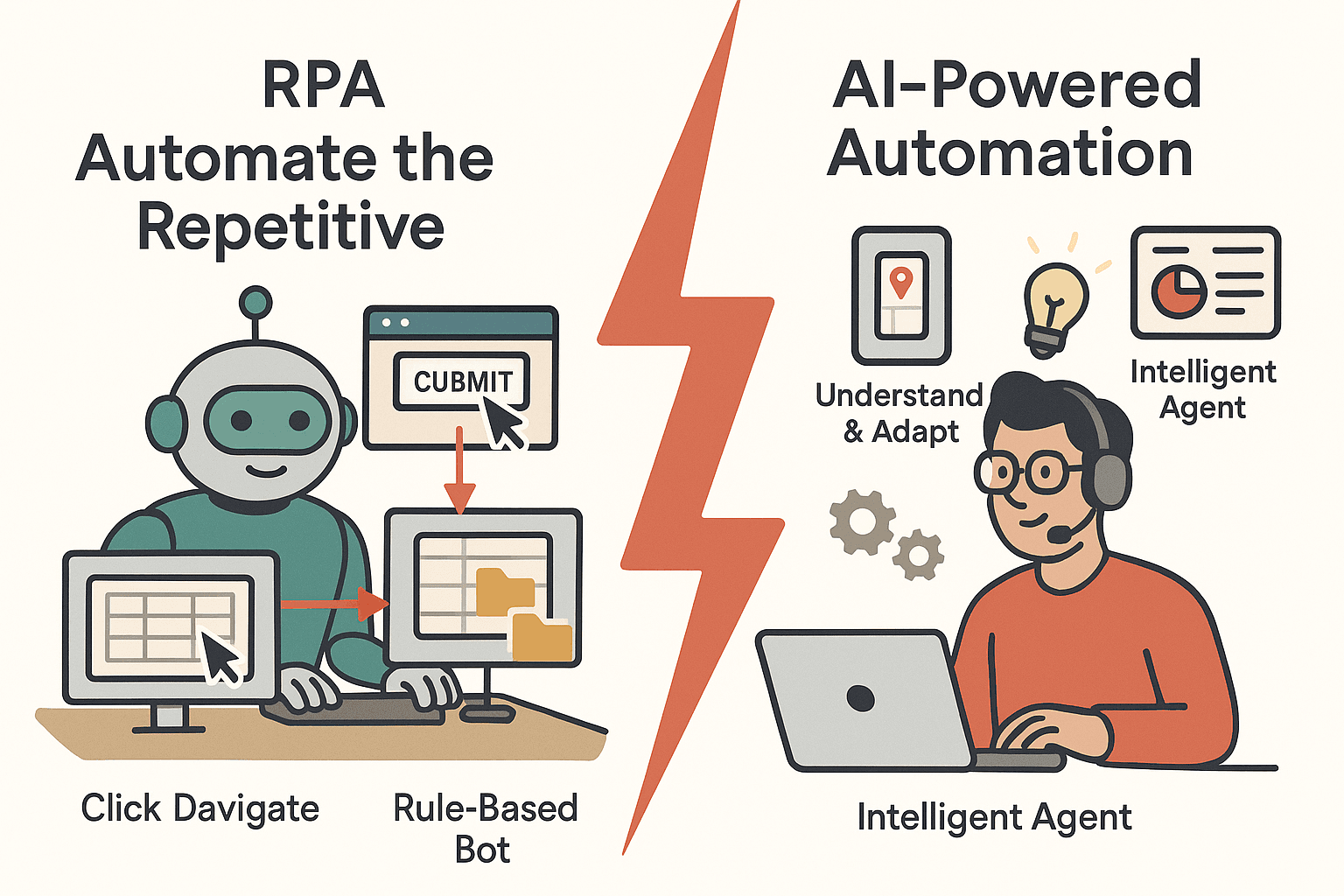

RPA erklärt: Was ist Robotic Process Automation?

Robotic Process Automation (RPA) ist der Klassiker unter den Automatisierungslösungen. RPA nutzt Software-Roboter, die menschliche Aktionen am Computer nachahmen – also Buttons klicken, Webseiten durchgehen, Daten zwischen Anwendungen kopieren. Diese Bots folgen klaren, regelbasierten Anweisungen und sind ideal für strukturierte, sich wiederholende Aufgaben.

Typische RPA-Anwendungsfälle beim Web-Scraping

- Einloggen auf einer Webseite und gezieltes Auslesen von Feldern

- Übertragen von Daten aus Webformularen in interne Datenbanken

- Geplantes Herunterladen von Berichten aus Webportalen

RPA ist in Branchen wie Finanzen, E-Commerce und Operations ein echtes Arbeitstier. Ein Händler kann damit zum Beispiel jede Nacht die Preise der Konkurrenz erfassen oder ein Finanzteam die aktuellen Börsenkurse automatisch in Tabellen einpflegen lassen.

Stärken von RPA

- Zuverlässigkeit: Bots werden nicht müde und machen keine Tippfehler. Sie arbeiten rund um die Uhr und sind .

- Compliance: Jeder Schritt wird dokumentiert – ideal für Audits.

- Schnelle Einrichtung: Für einfache, wiederkehrende Aufgaben ist RPA schnell startklar – ohne aufwändige Integrationen.

Grenzen von RPA

Aber es gibt einen Haken: RPA hält sich strikt an Regeln. Ändert sich das Layout einer Webseite, kann der Bot aussteigen. Es ist, als würde man Autofahren lernen, indem man jede Kurve auswendig lernt – sobald sich die Strecke ändert, ist man verloren. RPA hat Schwierigkeiten mit:

- Dynamischen Inhalten: Unendliches Scrollen, Pop-ups oder wechselnde Layouts erfordern zusätzliche Logik und Pflege.

- Unstrukturierten Daten: Stehen die Daten nicht immer am gleichen Ort, kommt RPA schnell durcheinander.

- Wartung: .

Für klar definierte, stabile Aufgaben ist RPA also top – aber nicht besonders flexibel.

Die neue Generation: Was ist ein KI-Agent?

Jetzt kommen die KI-Agenten ins Spiel – eine neue Art der Automatisierung, die Flexibilität und Intelligenz mitbringt. Im Web-Scraping ist ein KI-Agent ein autonomes Programm, dem du ein Ziel gibst („Sammle alle Produktnamen und Preise von dieser Seite“) und das selbstständig den besten Weg dorthin findet.

So unterscheiden sich KI-Agenten von RPA

- Lernen und Anpassen: KI-Agenten nutzen maschinelles Lernen und natürliche Sprachverarbeitung, um zu verstehen, zu entscheiden und zu handeln. Sie erkennen Muster, verarbeiten unstrukturierte Daten und passen sich neuen Situationen an.

- Kontextverständnis: Statt starrer Regeln interpretieren KI-Agenten den Seiteninhalt – sie erkennen Zusammenhänge, Muster und können sogar Bilder oder freien Text auswerten.

- Natürliche Sprache: Oft reicht eine einfache Beschreibung in Alltagssprache, und der KI-Agent erledigt den Rest.

Stell dir RPA als fleißigen Sachbearbeiter vor, der Anweisungen exakt befolgt, während ein KI-Agent wie ein flexibler Assistent agiert, der improvisieren und sich auf Neues einstellen kann.

Der KI-Web-Scraper: Die nächste Stufe

KI-Web-Scraper gehen noch einen Schritt weiter. Sie erkennen automatisch relevante Datenfelder, bewältigen Paginierung und unendliches Scrollen und extrahieren sogar Daten von Unterseiten – alles mit minimalem Aufwand. Hier setzen Tools wie neue Maßstäbe und machen Prozessautomatisierung für alle zugänglich, nicht nur für Entwickler.

Prozessautomatisierung für Web-Scraping: Warum ist das wichtig?

Warum sollte man Web-Scraping überhaupt automatisieren? Weil manuelle Datenerfassung langsam, fehleranfällig und nicht skalierbar ist. Automatisierung bringt:

- Zeitersparnis: Bots können in Minuten hunderte Seiten auslesen – was früher Tage oder Wochen dauerte.

- Kostensenkung: , wenn manuelle Dateneingabe durch Automatisierung ersetzt wird.

- Genauigkeit: Automatisierte Prozesse liefern konsistente, fehlerfreie Daten.

- Skalierbarkeit: Automatisierte Scraper können tausende Produkte oder Millionen Datensätze verarbeiten.

- Wettbewerbsvorteil: Schnellere, aktuellere Daten ermöglichen bessere Entscheidungen und schnellere Reaktionen.

Hier eine Übersicht typischer Web-Scraping-Anwendungsfälle und der Vorteile der Automatisierung:

| Web Scraping-Anwendungsfall | Was wird gesammelt & warum | Vorteil der Automatisierung |

|---|---|---|

| Wettbewerber-Preisüberwachung | Produktpreise, Lagerbestand | Echtzeit-Preisanalysen, spart stundenlange manuelle Vergleiche |

| Lead-Generierung | Namen, E-Mails, Telefonnummern | Füllt den Vertriebstrichter rund um die Uhr, entlastet das Team |

| Marktforschung | Bewertungen, Ratings | Schnelle Meinungsaggregation, Trend-Erkennung |

| Produktkatalog-Aggregation | Produktdetails | Hält Datenbanken aktuell, beschleunigt Markteinführung |

| Immobilienanzeigen | Preise, Standorte | Tägliche Marktübersicht, umfassende Reports |

| Finanzdaten-Extraktion | Aktienkurse, Berichte | Echtzeit-Updates, skalierbar auf tausende Datenpunkte |

| Compliance-Überwachung | Markennutzung, Richtlinien | Einheitliche Kontrolle, sofortige Benachrichtigungen, Audit-Trails |

Das Fazit: .

RPA vs. KI-Agent: Wie automatisieren sie Web-Scraping?

Wie gehen RPA und KI-Agenten praktisch an Web-Scraping heran? Hier ein direkter Vergleich:

| Schritt | RPA-Ansatz | KI-Agent-Ansatz |

|---|---|---|

| Ersteinrichtung | Nutzer zeichnet jede Aktion auf, definiert Felder | Nutzer gibt URL und gewünschte Daten an; KI erkennt Felder automatisch |

| Flexibilität | Anfällig für Änderungen | Anpassungsfähig – erkennt neue Layouts und Muster |

| Strukturierte Daten | Funktioniert gut | Funktioniert gut |

| Unstrukturierte Daten | Schwierig | Hervorragend – kann Text, Bilder, Kontext auslesen |

| Paginierung/Scrollen | Erfordert explizite Skripte | Erkennt und verarbeitet automatisch |

| Wartung | Hoch – bei jeder Änderung Anpassung nötig | Gering – KI passt sich kleinen Änderungen an |

| Technisches Know-how | Mittel – Einrichtung erforderlich | Gering – keine Programmierung, natürliche Sprache |

| Skalierbarkeit | Begrenzung durch Bot-Lizenzen | Cloud-basiert, einfach skalierbar |

Wann ist welches Tool sinnvoll?

- RPA punktet, wenn du mit stabilen, vorhersehbaren Webseiten und strukturierten Daten arbeitest – etwa bei internen Portalen oder Altsystemen.

- KI-Agenten sind ideal, wenn du dynamische, unübersichtliche oder sich häufig ändernde Webseiten auslesen willst oder dein Team keine Programmiererfahrung hat.

RPA für Web-Scraping: Der klassische Weg

Ein Praxisbeispiel: Mit RPA-Tools wie UiPath oder Automation Anywhere würdest du:

- Deine Navigation auf der Webseite aufzeichnen: Browser öffnen, einloggen, Seiten durchklicken, Daten kopieren.

- Der Bot spielt diese Aktionen ab, durchläuft die Seiten und überträgt die Daten in deine Tabelle oder Datenbank.

Typische Herausforderungen:

- Website-Änderungen: Ein neues Banner oder ein umbenannter Button kann den Bot lahmlegen.

- Paginierung: Unendliches Scrollen oder „Mehr laden“-Buttons erfordern zusätzliche Skripte.

- Dynamische Inhalte: Bots müssen gezielt auf das Laden von Inhalten warten.

- Anti-Bot-Maßnahmen: CAPTCHAs und IP-Sperren können RPA ausbremsen.

- Skalierung: Viele Bots parallel zu betreiben, wird schnell teuer und komplex.

RPA eignet sich super für interne, stabile Seiten – für das offene Web kann die Wartung aber schnell aufwendig werden.

KI-Web-Scraper: Die nächste Generation der Prozessautomatisierung

So läuft es mit einem KI-Web-Scraper ab:

- Webseite öffnen, „KI-Felder vorschlagen“ anklicken und die KI scannt die Seite.

- Die KI schlägt eine Tabelle mit extrahierbaren Daten vor – z. B. Produktnamen, Preise, Bewertungen.

- Du passt die Vorschläge an oder übernimmst sie und klickst auf „Scrapen“.

- Der KI-Agent übernimmt automatisch Paginierung, folgt Unterseiten und exportiert die Daten nach Excel, Google Sheets, Airtable oder Notion.

Die Vorteile:

- Kaum Einrichtung: Kein Programmieren, kein manuelles Tagging – einfach beschreiben, was du brauchst.

- Unterseiten & Paginierung: KI erkennt und folgt Links automatisch.

- Intelligente Datenverarbeitung: KI kann Daten beim Scrapen bereinigen, formatieren und sogar kategorisieren.

- Einfache Exporte: Mit einem Klick in dein bevorzugtes Tool exportieren.

Gerade für Nicht-Techniker (und auch für Profis, die Zeit sparen wollen) ist das ein echter Quantensprung – wie der Wechsel vom Tastenhandy zum Smartphone.

Thunderbit im Fokus: KI-Web-Scraper als KI-Agent

Ein Blick auf unser Herzensprojekt: . Thunderbit ist eine Chrome-Erweiterung für KI-Web-Scraping, die sich zu einem vollwertigen KI-Agenten für Web-Automatisierung entwickelt. Unser Ziel: Web-Scraping so einfach machen, dass sogar deine Großmutter es nutzen könnte (und vielleicht sogar Spaß daran hat).

Was macht Thunderbit besonders?

- KI-Felder vorschlagen: Ein Klick, und die KI liest die Seite aus und schlägt die besten Spalten zum Scrapen vor.

- Unterseiten-Scraping: Thunderbit besucht automatisch Unterseiten (z. B. Produktdetailseiten) und ergänzt deine Datentabelle – ohne Zusatzaufwand.

- Paginierungserkennung: Egal ob „Weiter“-Button oder unendliches Scrollen – Thunderbit erkennt es und sammelt weiter.

- Sofortiger Datenexport: Exportiere deine Daten mit einem Klick nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten.

- Kein Programmieren nötig: Alles ist für Business-Anwender konzipiert, nicht nur für Entwickler.

- Cloud- oder Browser-Scraping: Wähle zwischen schnellem Cloud-Scraping (parallel) oder Scraping im eigenen Browser (ideal für eingeloggte Seiten).

- Kostenlose KI-Tools: Extrahiere E-Mails, Telefonnummern oder Bilder mit nur einem Klick von jeder Webseite.

- Geplanter Scraper: Richte wiederkehrende Scrapes mit natürlicher Sprache ein – „jeden Tag um 9 Uhr“ – und Thunderbit erledigt den Rest.

Thunderbit versteht sich als „KI-Webdaten-Assistent“ direkt im Browser. Es geht nicht nur um das reine Scrapen, sondern um die komplette Automatisierung – von der Extraktion bis zum Export, so reibungslos wie möglich. Und das ist erst der Anfang: Die Zukunft gehört KI-Agenten, die nicht nur das Web lesen, sondern auch eigenständig handeln können.

Neugierig? .

Das richtige Tool wählen: Wann RPA, KI-Agent oder beides?

Wie entscheidet man sich zwischen RPA und KI-Agenten (wie Thunderbit) für die Web-Scraping-Automatisierung? Hier eine schnelle Übersicht:

| Entscheidungskriterium | RPA | KI-Agent / KI-Web-Scraper |

|---|---|---|

| Daten sind hochstrukturiert, Seite ist stabil | ✅ | |

| Daten sind unstrukturiert oder Seite ändert sich oft | ✅ | |

| Dynamische Inhalte (unendliches Scrollen, Pop-ups) | ✅ | |

| Team hat IT-/Programmierkenntnisse | ✅ | ✅ |

| Team ist nicht-technisch | ✅ | |

| Strikte Compliance/Audit erforderlich | ✅ | |

| Schnelle Skalierung oder viele Seiten scrapen | ✅ | |

| Einmaliges oder spontanes Scraping | ✅ | |

| Laufende, wiederkehrende Prozesse | ✅ | ✅ |

| Stärken kombinieren | Hybrid möglich | Hybrid möglich |

Tipp: Viele Unternehmen setzen inzwischen auf eine Kombination – RPA für interne, strukturierte Abläufe und KI-Agenten für externe, dynamische Webdaten. Die Zukunft ist hybrid.

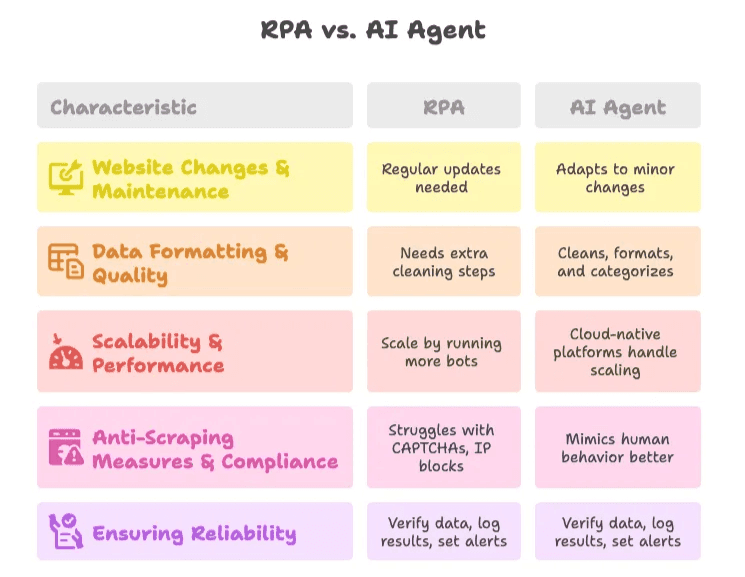

Typische Herausforderungen bei der Web-Scraping-Automatisierung

1. Website-Änderungen & Wartung

- RPA: Regelmäßige Anpassungen nötig, wenn sich Seiten ändern. Modulare Skripte und Monitoring helfen, Probleme früh zu erkennen.

- KI-Agent: Reagiert flexibler auf kleinere Änderungen, aber Ergebnisse sollten regelmäßig überprüft werden.

2. Datenformatierung & Qualität

- RPA: Zusätzliche Schritte für Datenbereinigung nötig oder Integration mit Skripten/Excel.

- KI-Agent: KI kann Daten beim Scrapen bereinigen, formatieren und sogar kategorisieren. Feldspezifische Prompts bringen die besten Ergebnisse.

3. Skalierbarkeit & Performance

- RPA: Skalierung durch mehr Bots, aber auf Infrastruktur- und Kosten achten.

- KI-Agent: Cloud-Plattformen wie Thunderbit übernehmen das Skalieren für dich.

4. Anti-Scraping-Maßnahmen & Compliance

- RPA: Kann an CAPTCHAs und IP-Sperren scheitern. Nur auf Seiten scrapen, für die du eine Erlaubnis hast.

- KI-Agent: Einige KI-Agenten können menschliches Verhalten besser nachahmen, aber immer die Nutzungsbedingungen und Datenschutzgesetze beachten.

5. Zuverlässigkeit sicherstellen

- Best Practice: Ergebnisse immer überprüfen, Protokolle führen und bei Auffälligkeiten Benachrichtigungen einrichten. Für kritische Prozesse regelmäßig manuell kontrollieren.

Die Zukunft der Prozessautomatisierung: KI-Agenten übernehmen das Steuer

Jetzt wird’s spannend: Die Entwicklung geht von Automatisierung hin zu Autonomie. KI-Agenten befolgen nicht mehr nur Anweisungen, sondern treffen Entscheidungen, passen sich neuen Situationen an und schlagen sogar selbst Aktionen vor – basierend auf den gesammelten Daten.

- .

- Bis 2028 werden .

- No-Code- und Low-Code-Plattformen machen die Entwicklung von KI-Agenten für alle zugänglich – nicht nur für IT-Profis.

Bei Thunderbit arbeiten wir genau an dieser Zukunft. Unsere Vision: Prozessautomatisierung so intuitiv machen, dass jeder Web-Scraping, Datensammlung und sogar Workflows mit wenigen Klicks und einer einfachen Beschreibung automatisieren kann. Wir scrapen nicht nur Daten – wir bauen die KI-Agenten, die die nächste Automatisierungswelle antreiben werden.

Neugierig, wohin die Reise geht? Mehr dazu im oder in Beiträgen wie und .

Fazit

Prozessautomatisierung bedeutet heute mehr als nur manuelle Arbeit zu ersetzen – sie gibt Teams die Möglichkeit, mehr zu erreichen, schneller zu arbeiten und sich auf das Wesentliche zu konzentrieren. RPA und KI-Agenten haben beide ihre Berechtigung, aber der Trend ist klar: KI-Web-Scraper wie Thunderbit machen Automatisierung intelligenter, robuster und für alle zugänglich.

Wer noch immer Daten per Hand kopiert, sollte den Teelöffel beiseitelegen und die Roboter ranlassen. Und wer wissen will, was KI-Agenten für das eigene Unternehmen leisten können, sollte . Dein zukünftiges Ich (und dein Team) werden es dir danken.

Häufige Fragen

1. Was ist der Unterschied zwischen RPA und KI-Agenten in der Prozessautomatisierung?

RPA (Robotic Process Automation) arbeitet nach festen, regelbasierten Vorgaben und eignet sich für stabile, strukturierte Umgebungen. KI-Agenten hingegen interpretieren den Kontext, passen sich an Veränderungen an und verarbeiten auch unstrukturierte Daten mithilfe von maschinellem Lernen und natürlicher Sprache – ideal für dynamische, komplexe Web-Scraping-Aufgaben.

2. Warum ist Prozessautomatisierung beim Web-Scraping wichtig?

Manuelles Web-Scraping ist langsam, fehleranfällig und nicht skalierbar. Automatisierung spart Zeit, senkt Kosten, erhöht die Genauigkeit und ermöglicht durch kontinuierliche Datenerfassung schnelle, fundierte Entscheidungen – ganz ohne manuelles Eingreifen.

3. Wann sollte ich RPA statt eines KI-Web-Scrapers wie Thunderbit nutzen?

RPA eignet sich besonders für vorhersehbare Webseiten mit strukturierten Daten und wenn eine lückenlose Dokumentation für Compliance erforderlich ist. Wenn dein Team technisch versiert ist und sich die Zielseiten selten ändern, ist RPA eine zuverlässige Wahl.

4. Was unterscheidet Thunderbit von klassischen Scraping-Tools?

Thunderbit nutzt KI, um Felder automatisch zu erkennen, Paginierung zu handhaben, Unterseiten auszulesen und Daten mit einem Klick zu exportieren – ganz ohne Programmierkenntnisse. Es ist für Business-Anwender konzipiert und unterstützt sowohl Browser- als auch Cloud-Scraping, sodass Automatisierung auch für Nicht-Entwickler möglich ist.

5. Können RPA und KI-Agenten gemeinsam eingesetzt werden?

Ja. Viele Unternehmen nutzen RPA für interne, stabile Prozesse und KI-Agenten wie Thunderbit für externe, dynamische Webseiten. Dieser hybride Ansatz vereint die Stärken beider Technologien für eine umfassendere und robustere Automatisierung.

Weitere Lektüre: