Ob Briefmarken oder Sneaker – jeder sammelt irgendwas. Doch wenn du 2025 im Vertrieb, Marketing, E-Commerce oder in der Unternehmenssteuerung unterwegs bist, sammelst du vermutlich vor allem eins: Webdaten. Und das nicht zu knapp – Unternehmen investieren mittlerweile im Schnitt 5 Millionen Dollar pro Jahr in die Erhebung von Webdaten. Web-Scraping ist längst fester Bestandteil vieler Abteilungen, von der Strategie bis zum Kundenservice ().

Mit diesem Boom begegnen dir in jedem Python-Scraping-Tutorial und bei fast jedem Datenprojekt zwei Namen immer wieder: Playwright und Selenium. Beide wurden ursprünglich für automatisierte Browser-Tests entwickelt, sind heute aber die erste Wahl, wenn es darum geht, das Web in strukturierte, nutzbare Daten zu verwandeln. Die Entscheidung zwischen beiden ist aber nicht nur eine technische – es geht darum, das richtige Werkzeug für deine tatsächlichen Anforderungen zu wählen. Und falls du kein Entwickler bist oder einfach schnell Ergebnisse willst, gibt es sogar noch einfachere Wege (Tipp: Du musst dafür keine einzige Zeile Python schreiben). Lass uns das mal genauer anschauen.

Von Test-Tools zu Web-Scraping-Profis: Was sind Playwright und Selenium?

Kurz und knapp: Selenium gibt es schon seit 2004 und ist der Klassiker unter den Browser-Automatisierungstools. Ursprünglich für Softwaretests gebaut, steuert es Browser wie Chrome, Firefox und sogar Internet Explorer (für die ganz Hartgesottenen). Playwright ist seit 2020 am Start, stammt von Microsoft und bringt frischen Wind in die Browser-Automatisierung – quasi der moderne, flinke Nachfolger von Selenium.

Mit beiden Tools kannst du Skripte schreiben (oft in Python), die einen Browser öffnen, Websites aufrufen, Buttons klicken, Formulare ausfüllen und – für uns am wichtigsten – Daten extrahieren. Was als Testautomatisierung begann, ist heute das Rückgrat vieler Web-Scraping-Projekte, von Preisüberwachung bis Lead-Generierung (). Und nicht nur Entwickler nutzen diese Tools: Immer mehr Business-Anwender wagen sich selbst ans Scraping.

Beim Scraping verschieben sich die Prioritäten: Es geht weniger um Testabdeckung, sondern darum, zuverlässig Daten zu bekommen, Blockaden zu vermeiden und nicht das ganze Wochenende mit Python-Fehlersuche zu verbringen. Genau hier zeigen sich die Unterschiede zwischen Playwright und Selenium.

Die wichtigsten Unterschiede: Playwright vs. Selenium beim Web-Scraping

Kommen wir auf den Punkt: Mit Playwright und Selenium lassen sich Websites scrapen – aber sie haben unterschiedliche Stärken.

- Selenium ist der erfahrene Allrounder. Es unterstützt fast jeden Browser und jede Programmiersprache, hat eine riesige Community und eignet sich besonders für ältere, statische Websites mit klaren Strukturen.

- Playwright ist der moderne Herausforderer. Es wurde für dynamische, JavaScript-lastige Seiten entwickelt und bringt viele Funktionen für Logins, Pop-ups, Endlos-Scrollen und mehr direkt mit. Für Python-Nutzer ist es zudem schneller eingerichtet und performanter.

Doch schauen wir uns die Unterschiede im Detail an.

Feature-Vergleich: Playwright vs. Selenium

| Funktion | Selenium | Playwright |

|---|---|---|

| Sprachen | Python, Java, C#, JS, Ruby, weitere | Python, JS/TS, Java, C# |

| Browser-Unterstützung | Chrome, Firefox, Edge, Safari, IE, Opera | Chromium (Chrome/Edge), Firefox, WebKit |

| Einrichtung | Browser-Treiber nötig, manuelle Konfiguration | Ein Befehl installiert alles |

| Geschwindigkeit/Performance | Langsamer, ressourcenintensiver | 40–50 % schneller, asynchron & parallelisiert |

| Umgang mit dynamischen Inhalten | Manuelle Wartezeiten, mehr Code nötig | Automatische Wartezeiten, ideal für JS-Seiten |

| Anti-Bot-Erkennung | Leicht erkennbar, Add-ons nötig | Integrierter Stealth-Modus, besseres User-Mimicking |

| Debugging-Tools | Basis (Selenium IDE, Screenshots) | Inspector, Videoaufzeichnung, Code-Generator |

| Community | Riesig, ausgereift, viele Tutorials | Schnell wachsend, moderne Doku, aktive Entwickler |

| Python-Scraper-Workflow | Mehr Einrichtung, mehr Boilerplate | Einfacher, weniger Code, einsteigerfreundlich |

Wann eignet sich welches Tool fürs Web-Scraping?

Welches Tool solltest du für dein nächstes Scraping-Projekt wählen? Hier meine Einschätzung nach vielen Jahren Automatisierung und Datenprojekten:

- Selenium ist ideal, wenn:

- Die Zielseite klassisch aufgebaut ist – statisches HTML, wenig JavaScript, keine aufwendigen Pop-ups.

- Du spezielle oder ältere Browser unterstützen musst (z. B. Internet Explorer) oder mit Legacy-Systemen arbeitest.

- Du von der riesigen Community und unzähligen Lösungen profitieren möchtest.

- Du Selenium bereits aus Testprojekten kennst.

- Playwright ist die bessere Wahl, wenn:

- Die Website modern, dynamisch und JavaScript-lastig ist (z. B. E-Commerce, Social Media).

- Du Logins, Tabs, Endlos-Scrollen oder Pop-ups automatisieren musst.

- Du schnell starten willst – mit weniger Einrichtung und weniger Code.

- Du keine Lust mehr auf

time.sleep(5)hast und das Timing lieber dem Tool überlässt.

Faustregel: Wenn du bei Selenium ständig rätselst, warum Inhalte nicht laden, ist es Zeit, Playwright auszuprobieren.

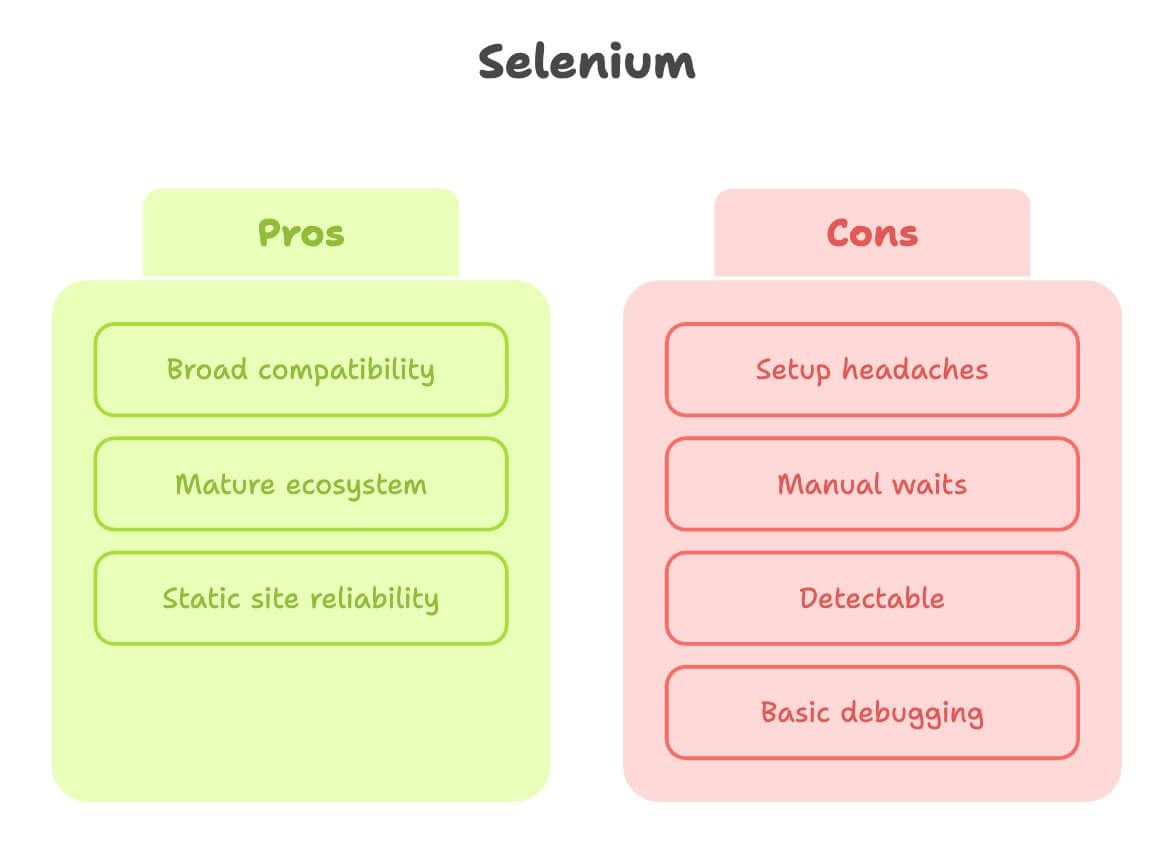

Selenium fürs Web-Scraping: Stärken und Schwächen

Selenium hat sich bewährt und ist für viele Scraping-Aufgaben absolut ausreichend.

Stärken:

- Breite Kompatibilität: Unterstützt fast alle Browser und Sprachen.

- Ausgereiftes Ökosystem: Unzählige Tutorials, Q&A, Plugins.

- Ideal für statische Seiten: Wenn sich die Seite wenig verändert, ist Selenium sehr stabil.

Schwächen:

- Aufwendige Einrichtung: Du musst einen Browser-Treiber (z. B. ChromeDriver) herunterladen, konfigurieren und aktuell halten. Gerade Einsteiger scheitern oft an diesem Schritt ().

- Manuelle Wartezeiten: Bei dynamischen Inhalten sind viele explizite Wartebefehle oder Sleep-Statements nötig.

- Leicht erkennbar: Viele Websites erkennen Selenium und blockieren automatisierte Zugriffe, vor allem auf Servern.

- Einfaches Debugging: Keine Videoaufzeichnung oder interaktiver Inspector integriert.

Kurz gesagt: Selenium ist perfekt für einfache, stabile Seiten – bei modernen, interaktiven Websites wird es schnell mühsam.

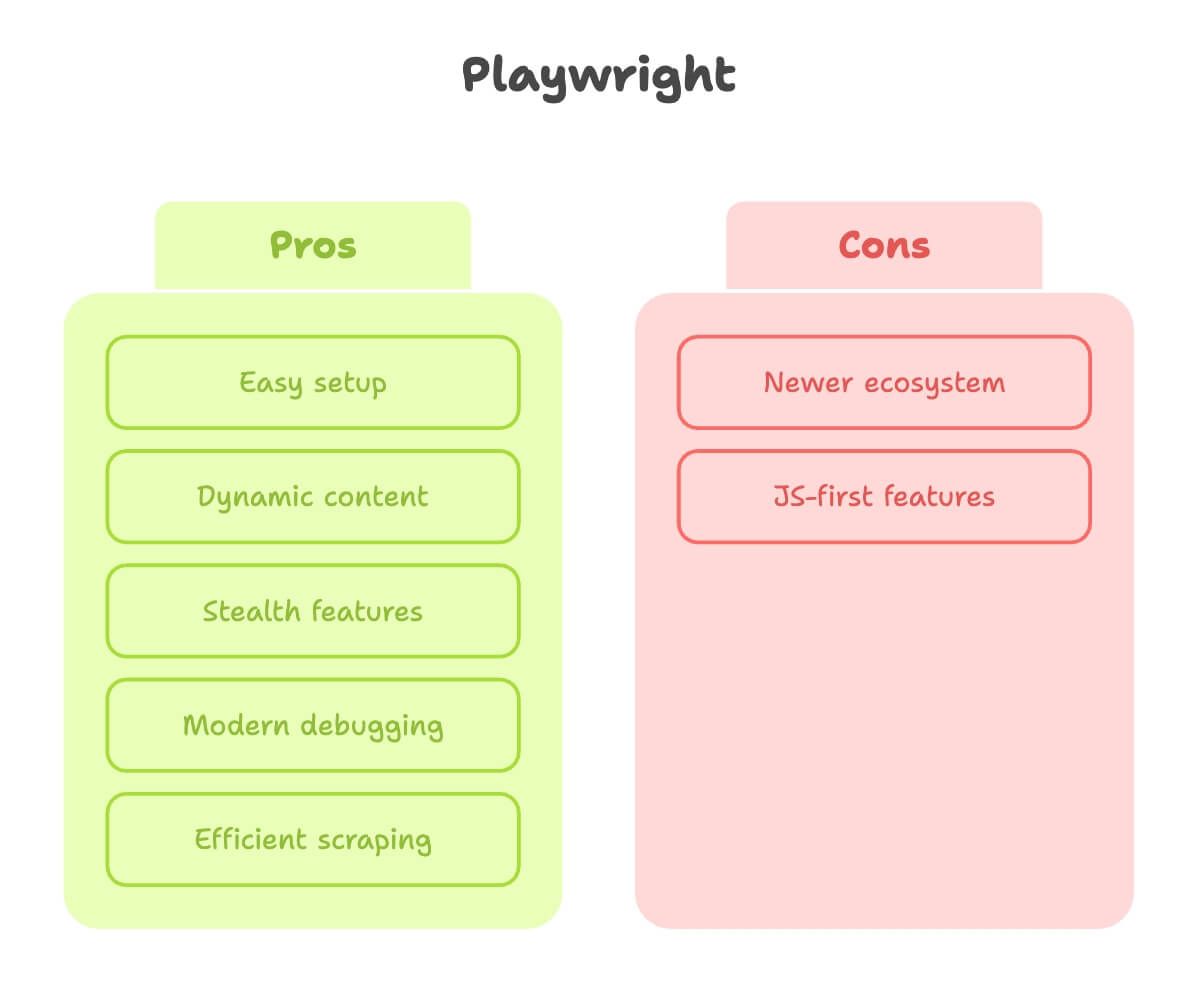

Playwright fürs Web-Scraping: Stärken und Schwächen

Playwright fühlt sich an, als hätten die Entwickler selbst schon viele Scraping-Hürden erlebt.

Stärken:

- Einfache Einrichtung: Ein

pip install, ein Befehl – fertig. Kein Treiber-Chaos. - Dynamische Inhalte: Automatische Wartezeiten, kein Rätselraten, wann die Seite fertig geladen ist ().

- Stealth-Modus: Tarnung als echter Nutzer, Multi-Context für parallele Scrapes (z. B. als mehrere „User“).

- Modernes Debugging: Inspector, Videoaufzeichnung, Code-Generierung aus Klicks.

- Schnell und effizient: Besonders bei vielen Seiten oder parallelen Prozessen.

Schwächen:

- Jüngeres Ökosystem: Noch weniger Tutorials, aber die Lücke schließt sich schnell.

- Manche Features zuerst für JavaScript: Fast alles geht in Python, aber manche Funktionen sind in JS besser dokumentiert.

Fazit: Playwright ist meine erste Wahl für dynamische Seiten oder wenn ich schnell Ergebnisse will – ohne Setup-Frust.

Anti-Bot-Strategien: Welcher Python Scraper kommt durch?

Das größte Problem beim Scraping: geblockt werden. Nicht das Coden ist die Herausforderung, sondern dass die Website dich nicht aussperrt.

- Selenium: Wird leicht erkannt. Websites entdecken das

webdriver-Flag, Headless-User-Agents und andere Hinweise. Es gibt Tricks (wie undetected-chromedriver), aber die erfordern Zusatzaufwand und sind immer einen Schritt hinter der Anti-Bot-Technik (). - Playwright: Bringt Stealth-Features mit, versteckt Automatisierungs-Spuren, unterstützt mehrere Browser-Kontexte und simuliert echte Nutzerinteraktionen. Kein Wundermittel, aber die Blockadegefahr ist geringer.

Wichtig: Kein Tool ist völlig immun gegen Anti-Bot-Maßnahmen. Bei besonders sensiblen Seiten (Sneaker-Drops, Ticketing) brauchst du trotzdem Proxys, IP-Rotation und manchmal sogar Captcha-Lösungen. Playwright macht es nur etwas einfacher.

Entwickler-Erfahrung: Einrichtung, Lernkurve und Fehlersuche

Wie fühlt sich der Einstieg an – besonders für Einsteiger oder alle, die einfach nur schnell Ergebnisse wollen?

- Selenium:

- Einrichtung: Python und Selenium installieren, passenden Browser-Treiber herunterladen, in den PATH eintragen, auf die richtige Version hoffen. (Viele scheitern schon am Treiber.)

- Lernkurve: Viele Ressourcen, aber auch viel veralteter Code und Tutorials.

- Debugging: Meistens mit Print-Ausgaben und Screenshots. Selenium IDE ist vorhanden, aber sehr basic.

- Playwright:

- Einrichtung:

pip install playwright, dannplaywright install. Fertig. - Lernkurve: Moderne Dokumentation, viele Beispiele, intuitive API – Elemente lassen sich nach Text, Rolle oder Platzhalter auswählen.

- Debugging: Inspector für Schritt-für-Schritt-Analyse, Browser-Ansicht und Videoaufzeichnung ().

- Einrichtung:

Wer schnell Ergebnisse sehen und wenig Zeit in Einrichtung und Fehlersuche stecken will, ist mit Playwright klar im Vorteil. Selenium punktet, wenn du die Eigenheiten schon kennst oder maximale Kompatibilität brauchst.

Schritt für Schritt: So baust du einen Python Web-Scraper mit Playwright oder Selenium

Wie sieht der Ablauf konkret aus? Hier die Schritte – ganz ohne Code.

Playwright (Python):

- Playwright und Browser installieren:

pip install playwright+playwright install - Browser starten: Chromium, Firefox oder WebKit (Headless oder sichtbar).

- Seite aufrufen: Mit

page.goto("<https://example.com>") - Auf Inhalte warten: Playwright wartet automatisch auf Elemente.

- Daten extrahieren: Mit intuitiven Selektoren (z. B.

get_by_text,locator("span.price")). - Paginierung/Subseiten: Durch Seiten blättern oder Links klicken – Playwright kann viele Seiten parallel abarbeiten.

- Daten exportieren: In CSV, Excel oder Datenbank speichern.

- Debugging: Inspector oder Videoaufzeichnung nutzen, falls etwas schiefgeht.

Selenium (Python):

- Selenium installieren:

pip install selenium - Browser-Treiber herunterladen: (z. B. ChromeDriver für Chrome), im PATH ablegen.

- Browser starten: Chrome, Firefox oder einen anderen Browser öffnen.

- Seite aufrufen:

driver.get("<https://example.com>") - Auf Inhalte warten: Manuell mit expliziten Waits (

WebDriverWait) oder pertime.sleep. - Daten extrahieren: Mit

find_elementoderfind_elements(CSS/XPath-Selektoren). - Paginierung/Subseiten: Durch URLs blättern oder Buttons klicken – Timing und Navigation musst du selbst steuern.

- Daten exportieren: In CSV, Excel oder Datenbank speichern.

- Debugging: Meistens manuell – Browser beobachten, HTML ausgeben oder Screenshots machen.

Fällt dir was auf? Playwright ist für moderne Seiten einfach ein Stück unkomplizierter.

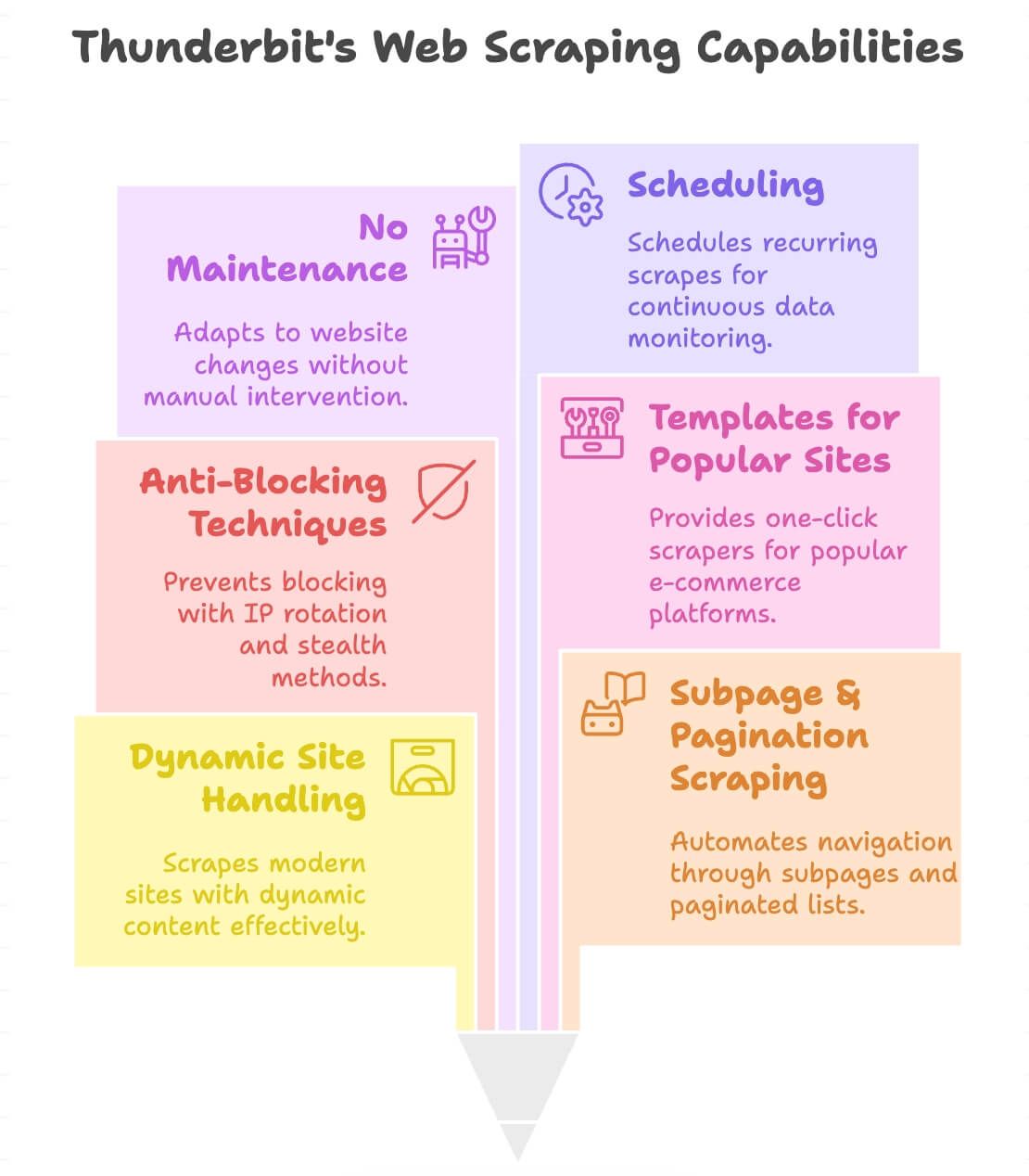

Ohne Programmieren: No-Code Web-Scraping mit Thunderbit KI-Web-Scraper

Nicht jeder will Python-Profi werden, nur um eine Preistabelle oder eine Lead-Liste zu bekommen. Vielleicht arbeitest du im Vertrieb, Marketing, Immobilien oder Operations und willst einfach nur schnell an die Daten. Genau dafür gibt es .

Als Mitgründer von Thunderbit habe ich erlebt, wie viele Business-Anwender einfach nur Ergebnisse wollen – ohne Code. Deshalb haben wir eine entwickelt, mit der du jede Website in zwei Klicks scrapen kannst – ganz ohne Python, Treiber oder Fehlersuche.

So funktioniert Thunderbit

- Öffne die gewünschte Website.

- Klicke auf „KI-Felder vorschlagen“. Thunderbits KI analysiert die Seite und schlägt relevante Datenfelder vor (z. B. Produktname, Preis, Bild, Bewertung).

- Klicke auf „Scrapen“. Du bekommst sofort eine strukturierte Tabelle.

- Exportiere die Daten: Nach Excel, Google Sheets, Airtable, Notion, CSV oder JSON. Fertig.

Keine Selektoren, kein Rätselraten, kein Code. So einfach wie Essen bestellen – und meist schneller als der Lieferdienst.

Was macht Thunderbit besonders?

- Dynamische Seiten: Scrapt moderne E-Commerce-Seiten, Verzeichnisse und sogar Seiten mit Endlos-Scroll oder Pop-ups.

- Subseiten & Paginierung: Klickt automatisch durch Produktseiten oder Listen, um alle Daten zu erfassen.

- Anti-Blocking integriert: Nutzt IP-Rotation und Stealth-Techniken im Hintergrund, damit du seltener geblockt wirst.

- Vorlagen für beliebte Seiten: Ein-Klick-Scraper für Amazon, eBay, Shopify, Zillow und mehr ().

- Kein Wartungsaufwand: Wenn sich eine Website ändert, passt sich Thunderbits KI automatisch an – kein Nachbessern nötig.

- Zeitplanung: Lege wiederkehrende Scrapes an (z. B. tägliche Preisüberwachung).

- Unterstützt 34 Sprachen: Daten aus fast allen Ländern scrapen und direkt übersetzen.

Das Beste: Du brauchst keinerlei Kenntnisse in HTML, CSS oder Python. Wer einen Browser bedienen kann, kann auch Thunderbit nutzen.

Welche Web-Scraping-Lösung passt zu dir?

Hier eine schnelle Entscheidungshilfe:

| Ihr Anwendungsfall | Bestes Tool |

|---|---|

| Statische, einfache Website; Einrichtung kein Problem | Selenium |

| Moderne, dynamische Seite; schnelle Ergebnisse gewünscht | Playwright |

| Unterstützung für alte Browser oder Sprachen nötig | Selenium |

| Einfache Einrichtung, modernes Debugging, wenig Code | Playwright |

| Kein Entwickler; sofort Daten, ohne Code & Setup | Thunderbit |

| Mehrere Seiten, Subseiten oder geplante Scrapes | Thunderbit |

| Direkt-Export nach Excel, Sheets, Notion, Airtable | Thunderbit |

| Keine Lust auf Python-Fehlersuche | Thunderbit |

Wenn du Entwickler bist oder gerne tüftelst, sind Playwright und Selenium starke Werkzeuge. Aber wenn du Daten möglichst schnell in eine Tabelle bekommen willst, spart dir Thunderbit Stunden – manchmal sogar Tage – an Arbeit.

Fazit: Schnelles, zuverlässiges Web-Scraping – so wie du es brauchst

Web-Scraping ist heute unverzichtbar, denn Unternehmen brauchen Daten – und zwar sofort. Playwright und Selenium sind ausgereifte Frameworks mit unterschiedlichen Stärken: Selenium ist der Klassiker für statische Seiten und alte Setups, Playwright die moderne, schnelle Lösung für dynamische, interaktive Websites.

Mein ehrlicher Rat nach vielen Jahren in SaaS, Automatisierung und KI: Wenn du nicht aus Leidenschaft coden willst, verschwende keine Zeit mit Treibern, Selektoren und Anti-Bot-Tricks. Mit dem kommst du in Minuten – nicht Tagen – von „Ich brauche diese Daten“ zu „Hier ist meine Excel-Datei“.

Egal ob Python-Profi oder Business-Anwender: Es gibt für jeden die passende Scraping-Lösung – und für jedes Zeitbudget. Probier die Tools aus, finde deinen Favoriten und denk dran: Das beste Tool ist das, das dir die gewünschten Daten mit minimalem Aufwand liefert.

Und falls du nachts um 2 Uhr mal wieder einen Selenium-Treiber-Fehler debuggen solltest: Thunderbit ist nur zwei Klicks entfernt und sofort einsatzbereit. Viel Erfolg beim Scrapen!

Du willst mehr über No-Code-Scraping, KI-gestützte Datenerfassung und Thunderbit erfahren? Schau in unseren oder starte direkt mit der .

P.S.: Du bist noch unsicher oder möchtest Thunderbit in Aktion sehen? Schau auf unserem vorbei für Demos, Tipps und den einen oder anderen Web-Scraping-Witz (ja, die gibt’s wirklich).

Weiterführende Artikel: