Wer schon mal versucht hat, einen Browser zu automatisieren – sei es, um Produktlisten zu sammeln, einen Checkout-Prozess zu testen oder sich das ständige Copy-Paste zu sparen – ist bestimmt schon über die Frage gestolpert: Playwright oder Puppeteer? Nach etlichen Jahren im SaaS- und Automatisierungsbereich kann ich sagen: Die Wahl zwischen diesen beiden Tools ist wie die Entscheidung zwischen Batman und Iron Man. Beide sind echte Superhelden, haben ihre Eigenheiten und können je nach Einsatz entweder alles retten oder für ordentlich Frust sorgen.

Die Welt der Browser-Automatisierung entwickelt sich rasant. Immer mehr Unternehmen setzen auf Web-Scraping, automatisierte Workflows und smarte Systeme. Und mit KI-gestützten Tools wie können mittlerweile sogar Leute ohne Programmierkenntnisse mitmischen. Aber wie findet man das richtige Tool? Schauen wir uns die echten Unterschiede, Gemeinsamkeiten und moderne No-Code-Alternativen an – ganz ohne Marketing-Geschwafel.

Playwright vs Puppeteer: Was steckt dahinter und warum sind sie wichtig?

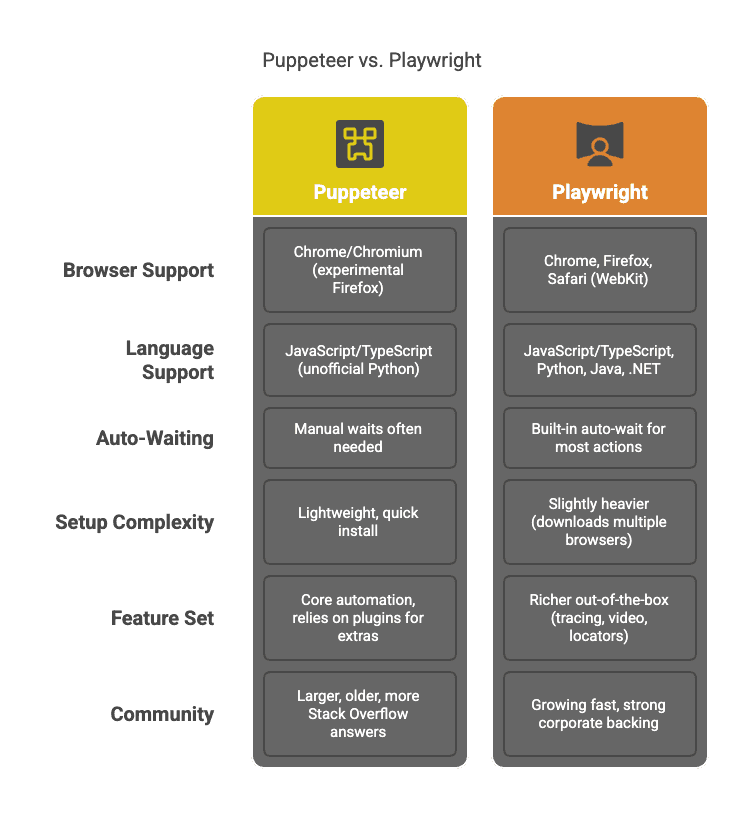

Starten wir mit den Basics. Puppeteer ist eine Open-Source-Bibliothek von Google für Node.js, mit der man Chrome- oder Chromium-Browser fernsteuern kann. Stell dir das wie einen Roboter vor, der klicken, scrollen, tippen und Daten abgreifen kann – wie ein Mensch, nur ausdauernder und ohne Koffein. Seit 2017 ist Puppeteer das Standard-Tool, wenn es um das Scrapen dynamischer, JavaScript-lastiger Webseiten geht ().

Playwright ist Microsofts Antwort auf Puppeteer. Das Tool wurde 2020 von einigen der ursprünglichen Puppeteer-Entwickler veröffentlicht und hebt Browser-Automatisierung auf ein neues Level: Neben Chrome werden auch Firefox und Safari (WebKit) unterstützt, außerdem mehrere Programmiersprachen (). Kurz gesagt: Playwright ist wie der ehrgeizige kleine Bruder von Puppeteer, der alles kann – nur in mehr Browsern und Sprachen.

Warum sind diese Tools so relevant? Moderne Webseiten bestehen aus mehreren Schichten JavaScript, endlosem Scrollen und interaktiven Elementen, die klassische Scraper schnell an ihre Grenzen bringen. Teams aus Vertrieb, Marketing, E-Commerce und Operations brauchen zuverlässige Lösungen, um Daten zu extrahieren, Workflows zu testen und wiederkehrende Aufgaben zu automatisieren. Genau hier spielen Playwright und Puppeteer ihre Stärken aus.

Wichtige Gemeinsamkeiten: Playwright vs Puppeteer für Automatisierung

Trotz aller Konkurrenz haben Playwright und Puppeteer viele Gemeinsamkeiten:

- JavaScript-Basis: Beide sind in erster Linie JavaScript/TypeScript-Bibliotheken (Playwright unterstützt aber noch mehr Sprachen – dazu gleich mehr).

- Browser-Steuerung: Sie ermöglichen es, Browser programmatisch zu bedienen – Seiten öffnen, Buttons klicken, Formulare ausfüllen, Screenshots machen und vieles mehr.

- Umgang mit dynamischen Inhalten: Beide können mit JavaScript-lastigen Webseiten umgehen und eignen sich daher ideal für das Scraping moderner Web-Apps.

- Simulation von Nutzeraktionen: Ob Login, Scrollen oder „Mehr laden“-Klicks – beide Tools können echtes Nutzerverhalten nachahmen.

- Headless oder mit Oberfläche: Unsichtbar auf dem Server (headless) oder sichtbar im Browser (headful) – beides ist möglich.

- Eigene Skripte ausführen: Man kann eigenen JavaScript-Code im Kontext der Seite laufen lassen, um gezielt Daten zu extrahieren.

- Netzwerk-Kontrolle: Anfragen abfangen, Geräte simulieren oder Geolokation emulieren – praktisch für regionalspezifisches oder mobiles Scraping.

Kurz gesagt: Beide Tools sind echte Alleskönner für die Browser-Automatisierung. Wer strukturierte Daten aus dynamischen Webseiten extrahieren möchte und mit Code umgehen kann, ist mit beiden gut bedient.

Die wichtigsten Unterschiede: Playwright vs Puppeteer für Scraping und Testing

Jetzt wird’s interessant. Hier gehen Playwright und Puppeteer getrennte Wege:

Ein paar Highlights im Überblick:

- Browser-Unterstützung: Puppeteer ist auf Chrome/Chromium spezialisiert. Playwright kann mit einem einzigen API-Skript Chrome, Firefox und Safari bedienen (). Wer also in mehreren Browsern testen oder scrapen möchte (z. B. um Erkennung zu vermeiden oder Unterschiede zu prüfen), ist mit Playwright besser beraten.

- Sprachenvielfalt: Puppeteer richtet sich an Node.js-Entwickler. Playwright unterstützt zusätzlich Python, Java und .NET ().

- Automatisches Warten: Playwright nimmt einem das Timing ab und wartet automatisch, bis Elemente bereit sind (). Bei Puppeteer muss man selbst aufpassen und manuell warten – das gibt mehr Kontrolle, aber auch mehr Fehlerquellen.

- Funktionsumfang: Playwright bringt viele Features direkt mit – etwa Netzwerk-Interception, einen eigenen Testrunner oder Tracing. Puppeteer ist schlanker, für komplexe Fälle braucht man aber oft zusätzliche Plugins.

- Community: Puppeteer gibt es schon länger, daher findet man mehr Blogposts und Hilfe im Netz. Die Playwright-Community holt aber schnell auf.

Wann ist Puppeteer die richtige Wahl? Typische Anwendungsfälle

Puppeteer ist besonders praktisch, wenn:

- Nur Chrome/Chromium gebraucht wird: Für viele Scraping- und Automatisierungsaufgaben reicht das völlig aus.

- Schneller, schlanker Einstieg gewünscht ist: Ein

npm installreicht und los geht’s. - Simpel und übersichtlich bevorzugt wird: Die API ist klar und man hat die volle Kontrolle.

- Kleine, einmalige Skripte gebaut werden: Für schnelle Jobs ist Puppeteer ideal.

- Das Team viel Node.js-Erfahrung hat: Wer in JavaScript zu Hause ist, fühlt sich hier wohl.

Typische Szenarien: Preise bei einem Händler abfragen, Login-Prozesse automatisieren oder Chrome-basierte Tests in CI-Pipelines.

Wann ist Playwright die bessere Wahl? Typische Anwendungsfälle

Playwright spielt seine Stärken aus, wenn:

- Cross-Browser-Support gebraucht wird: Mit einem Skript Chrome, Firefox und Safari bedienen ().

- Komplexe Automatisierung gefragt ist: Automatisches Warten, Locator-API und Tracing machen Playwright robust für anspruchsvolle, interaktive Seiten.

- Python, Java oder .NET bevorzugt werden: Playwright bietet hier erstklassige Unterstützung.

- Scraping im großen Stil geplant ist: Playwright kann mehrere Browser-Kontexte effizient verwalten und erleichtert paralleles Scraping und Testing.

- Zukunftssicherheit wichtig ist: Playwright entwickelt sich rasant weiter und wird von Microsoft und dem ursprünglichen Puppeteer-Team unterstützt.

Typische Szenarien: Multi-Step-Scraping mit Logins und Popups, browserübergreifende Web-App-Tests oder der Aufbau skalierbarer Datenpipelines.

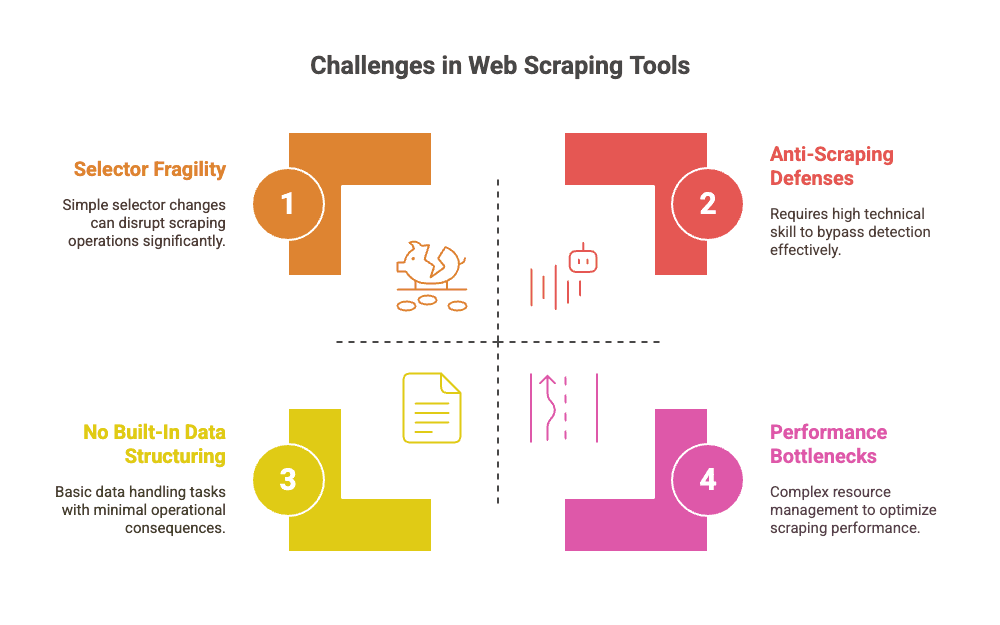

Gemeinsame Schwächen: Die versteckten Kosten von Playwright und Puppeteer

Hier zeigen sich die Schattenseiten der Superhelden. Beide Tools bringen einige Herausforderungen mit – vor allem, wenn das Scraping skaliert:

- Anfällige Selektoren: Webseiten ändern sich ständig. Schon eine kleine Änderung am CSS oder Layout kann das Skript lahmlegen (). Die Wartung wird zum Dauerjob.

- Manueller Pflegeaufwand: Entwickler verbringen viel Zeit damit, Selektoren zu reparieren, Logik anzupassen und neue Anti-Bot-Maßnahmen zu umgehen ().

- Performance-Probleme: Echte Browser zu betreiben ist ressourcenintensiv. Wer tausende Seiten scrapen will, muss sich um Browser-Farmen, Parallelisierung und Speicherlecks kümmern ().

- Keine integrierte Datenstrukturierung: Beide Tools liefern Rohdaten. Das Aufbereiten und Exportieren (z. B. nach CSV/Excel) bleibt Handarbeit.

- Anti-Scraping-Maßnahmen: Von Haus aus sind beide Tools nicht besonders „stealthy“. Für Proxy-Rotation, Captcha-Lösungen oder Tarnung braucht es Plugins oder eigene Logik ().

- Hohe Einstiegshürde für Nicht-Entwickler: Ohne Programmierkenntnisse sind diese Tools schwer zugänglich.

Fazit: Playwright und Puppeteer sind mächtig, aber mit wachsendem Bedarf steigen auch die Wartungs- und Infrastrukturkosten.

Playwright vs Puppeteer für Scraping: Praxisvergleich

Schauen wir uns einen typischen Scraping-Workflow an – zum Beispiel das Extrahieren von Produktdaten aus einem Online-Shop mit mehreren Seiten und Detailansichten.

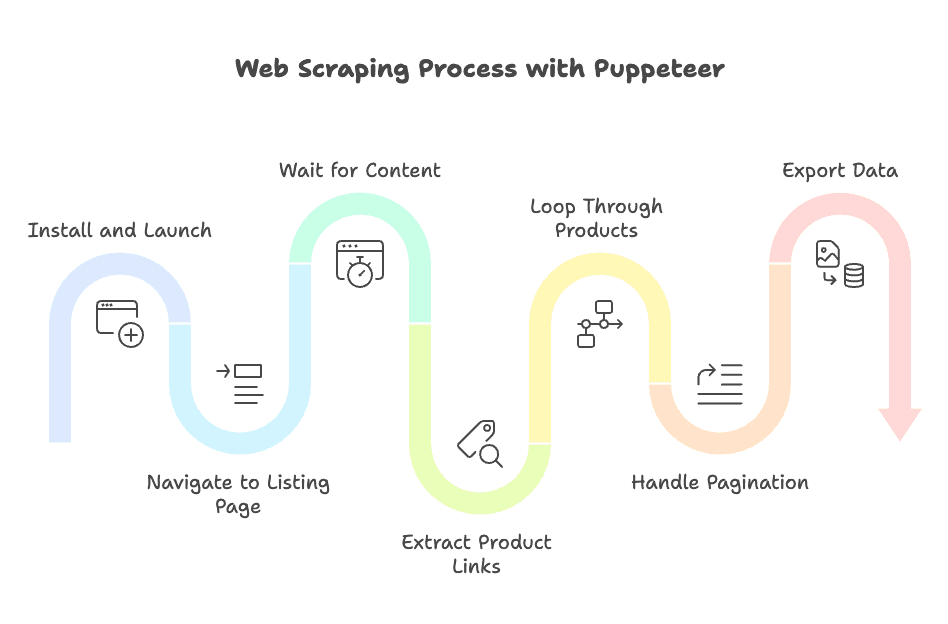

Mit Puppeteer

- Installation und Start:

npm install puppeteer, dann einen Headless-Browser starten. - Zur Übersichtsseite navigieren: Mit

page.goto()die Seite aufrufen. - Auf Inhalte warten: Manuell mit

waitForSelectorprüfen, ob Produkte geladen sind. - Produktlinks extrahieren: Mit

$$evaldie URLs sammeln. - Produkte durchgehen: Für jeden Link eine neue Seite öffnen, auf Selektoren warten, Daten extrahieren, Seite schließen.

- Paginierung abbilden: „Weiter“-Button suchen, klicken und wiederholen.

- Daten exportieren: Eigenes Skript für CSV, JSON oder Datenbank schreiben.

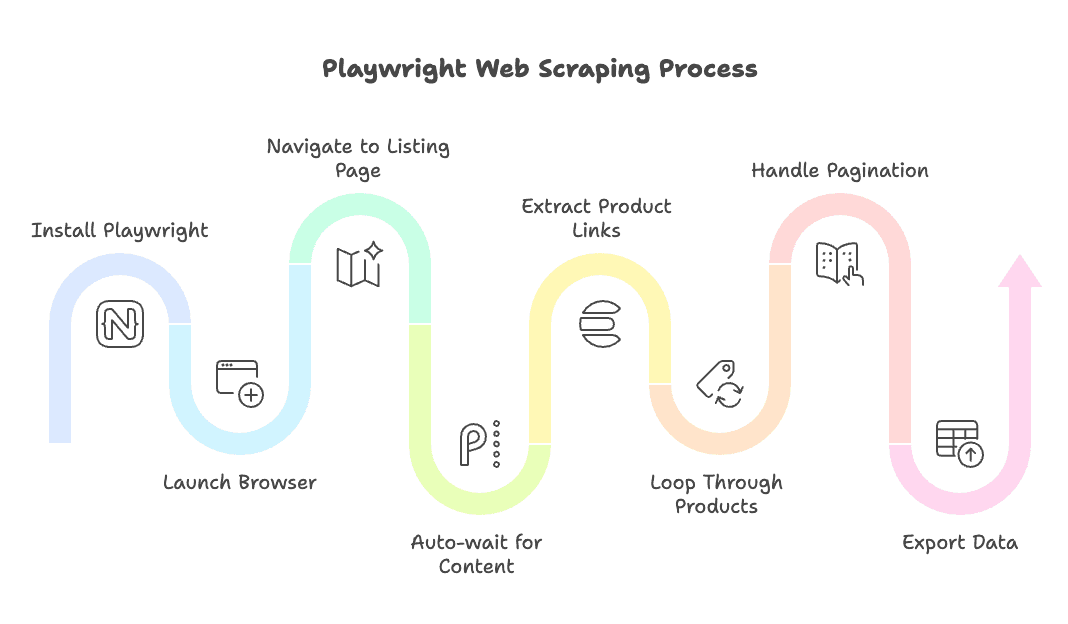

Mit Playwright

- Installation und Start:

npm install playwright, dann den gewünschten Browser starten (Chrome, Firefox oder Safari). - Zur Übersichtsseite navigieren: Mit

page.goto()die Seite aufrufen. - Automatisches Warten: Aktionen wie

page.click()oderpage.textContent()warten automatisch auf die Elemente. - Produktlinks extrahieren: Mit der Locator-API oder

$$eval. - Produkte durchgehen: Neue Seiten öffnen oder wiederverwenden, Daten mit eingebauten Wartezeiten extrahieren.

- Paginierung abbilden: Einfach

page.click('a.next-page')– das automatische Warten übernimmt den Rest. - Daten exportieren: Die Strukturierung und Speicherung bleibt weiterhin eigene Aufgabe.

Fazit: Beide Tools erledigen die Aufgabe, aber Playwrights Auto-Wait und Multi-Browser-Support machen Skripte oft kompakter und weniger fehleranfällig. Puppeteer ist etwas „hands-on“, bietet aber maximale Transparenz für alle, die jeden Schritt selbst steuern möchten.

Der Aufstieg KI-gestützter Scraper: Thunderbit als No-Code-Alternative

Jetzt wird’s spannend. Die häufigste Klage von Business-Anwendern: „Ich will einfach nur die Daten – warum muss ich JavaScript lernen oder jede Woche Skripte pflegen?“

Genau deshalb gibt es . Thunderbit ist eine , mit der wirklich jeder – auch ohne Technikkenntnisse – Webseiten mit wenigen Klicks scrapen kann. Kein Code, keine Selektoren, kein Wartungsaufwand.

Wie funktioniert das?

- KI-Feldvorschläge: Thunderbits KI erkennt automatisch, welche Daten auf der Seite relevant sind – etwa „Produktname“, „Preis“ oder „Bewertung“. Man muss also nicht mehr im HTML nach Selektoren suchen.

- Automatische Unterseiten- und Paginierungs-Erkennung: Wer Detailseiten oder viele Ergebnisseiten scrapen will, kann sich auf die KI verlassen ().

- Export überallhin: Ergebnisse lassen sich mit einem Klick nach Excel, Google Sheets, Airtable oder Notion exportieren.

- Datenstrukturierung und Anreicherung: Thunderbit kann Daten beim Scraping zusammenfassen, kategorisieren oder übersetzen ().

- Massen- und geplantes Scraping: Hunderte URLs auf einmal scrapen oder regelmäßige Jobs planen – ganz ohne Server oder Cronjobs.

Thunderbit richtet sich an Business-Anwender, die Ergebnisse wollen – nicht Code. Und: Für kleine Aufgaben ist es kostenlos testbar.

Thunderbit vs Playwright vs Puppeteer: Funktionsvergleich

Hier ein direkter Vergleich der wichtigsten Aspekte:

| Aspekt | Puppeteer | Playwright | Thunderbit (KI No-Code) |

|---|---|---|---|

| Setup-Zeit | Schnell für Node.js-Entwickler | Schnell, mehrere Sprachen | Sofort (Chrome-Erweiterung) |

| Browser-Support | Chrome/Chromium | Chrome, Firefox, Safari | Chrome-basiert |

| Sprachen | JavaScript/TypeScript | JS, Python, Java, .NET | Kein Code nötig |

| Benutzerfreundlichkeit | Nur für Entwickler | Nur für Entwickler | Für alle (Point & Click) |

| Auto-Wait | Manuelles Warten nötig | Automatisches Warten integriert | KI-gesteuert, keine Wartezeiten sichtbar |

| Unterseiten/Paginierung | Manuelles Skripting | Manuelles Skripting | Automatisch per KI |

| Datenstrukturierung | Manuelles Parsen/Export | Manuelles Parsen/Export | Strukturiert, exportbereit |

| Wartung | Hoch (Selektoren brechen) | Hoch (Selektoren brechen) | Gering (KI passt sich an) |

| Skalierbarkeit | Entwickler-Infrastruktur nötig | Entwickler-Infrastruktur nötig | Integriert, Cloud-gestützt |

| Kosten | Kostenlos (plus Infrastruktur/Entwicklungszeit) | Kostenlos (plus Infrastruktur/Entwicklungszeit) | Freemium (kleine Nutzung gratis) |

Mehr dazu im oder im Beitrag zu .

Dank KI muss man sich bei Thunderbit keine Sorgen mehr um kaputte Selektoren, Wartungsaufwand oder komplexe Skripte machen. Es ist die echte No-Code-Lösung für alle, die schnell an Daten kommen wollen.

Skalierung: Welches Tool passt zu deinem Unternehmen?

Welches Tool ist nun das richtige? Hier meine ehrliche Einschätzung:

- Wenn ihr Entwickler im Team habt, volle Kontrolle braucht und Scraping in eigene Systeme integrieren wollt: Playwright oder Puppeteer sind eine gute Wahl. Playwright ist zukunftssicherer und flexibler, vor allem bei Cross-Browser- oder Python-Anforderungen.

- Wenn ihr nicht-technische Teams befähigen, Wartung minimieren und schnell Ergebnisse wollt: Thunderbit ist ein echter Gamechanger (ja, das Wort passt hier). Perfekt für Vertrieb, Marketing, E-Commerce und Operations, die Daten einfach in Excel oder Google Sheets brauchen.

- Für alle dazwischen: Viele Teams nutzen beides – Thunderbit für schnelle Jobs und Prototypen, Playwright/Puppeteer für produktive Systeme.

Kurzer Entscheidungs-Check:

- Mit Code vertraut? Playwright oder Puppeteer.

- Cross-Browser oder mehrere Sprachen nötig? Playwright.

- No-Code, schneller Start, wenig Wartung? Thunderbit.

- Millionen Seiten pro Monat scrapen? Infrastrukturkosten beachten – Thunderbit ist super für tausende Seiten, bei riesigen Mengen sind Code-Tools oft günstiger (wenn Entwickler verfügbar sind).

- Export in Business-Tools gewünscht? Thunderbit bietet direkte Integrationen zu Sheets, Airtable, Notion und mehr.

Fazit: Die richtige Wahl für Web-Automatisierung treffen

Browser-Automatisierung war noch nie so spannend und zugänglich wie heute. Playwright und Puppeteer sind großartige Tools für Entwickler, die Kontrolle und Flexibilität suchen. Playwright überzeugt mit Multi-Browser- und Multi-Sprachen-Support, Puppeteer mit Einfachheit und einer riesigen Community für Chrome-Jobs.

Doch je komplexer das Web wird und je mehr Business-Anwender ohne Code Daten brauchen, desto mehr verändern KI-Tools wie das Spielfeld. Mit Thunderbit lassen sich Webseiten in zwei Klicks scrapen, Unterseiten und Paginierung werden automatisch erkannt und strukturierte Daten können direkt exportiert werden – ganz ohne Code und Wartungsstress.

Wer keine Lust mehr auf kaputte Skripte hat und einfach nur an die Daten will, sollte die ausprobieren. Und für Entwickler, die gerne tüfteln, bleiben Playwright und Puppeteer die Batman und Iron Man der Browser-Automatisierung.

Am Ende zählt: Das beste Tool ist das, das zu deinem Team, deinen Prozessen und deinem Wartungsbedarf passt. Wähle mit Bedacht – und mögen deine Selektoren nie wieder brechen.

Du willst mehr über Web Scraping, KI-Automatisierung oder den Einstieg mit Thunderbit erfahren? Schau in unseren – dort findest du Anleitungen zu , und .

Und falls du doch mal nachts um zwei an einem kaputten Selektor verzweifelst: Es gibt einen besseren Weg.

FAQ: Playwright vs Puppeteer vs Thunderbit

1. Was ist der Unterschied zwischen Playwright und Puppeteer?

Playwright ist Microsofts Automatisierungsbibliothek für Browser, die Chrome, Firefox und Safari sowie mehrere Sprachen wie Python und Java unterstützt.

Puppeteer ist Googles Tool, das sich auf Chrome/Chromium konzentriert und für Node.js entwickelt wurde. Beide automatisieren Browser für Aufgaben wie Scraping, Testing und UI-Automatisierung.

2. Warum entscheiden sich Entwickler für das eine oder andere?

Puppeteer ist ideal, wenn du eine schlanke Lösung nur für Chrome suchst.

Playwright ist die bessere Wahl, wenn du Cross-Browser-Support, automatisches Warten und mehr integrierte Features brauchst.

3. Was haben beide gemeinsam?

- Browser lassen sich per Code steuern

- Sie kommen mit dynamischen, JavaScript-lastigen Webseiten klar

- Nutzeraktionen wie Klicken und Tippen können simuliert werden

- Headless- oder Headful-Ausführung möglich

- Entwickler und manuelle Wartung der Skripte sind erforderlich

4. Wo liegen die Nachteile von Playwright und Puppeteer?

- Skripte brechen, wenn sich Webseiten ändern

- Hoher Wartungsaufwand (Selektoren, Wartezeiten, Anti-Bot-Maßnahmen)

- Keine integrierten Tools zur Datenstrukturierung oder zum Export

- Für Skalierung ist Entwickler-Infrastruktur nötig

- Nicht für Nicht-Programmierer geeignet

5. Was macht Thunderbit anders?

Thunderbit ist eine KI-basierte Chrome-Erweiterung, die:

- Daten ohne Code extrahiert

- Unterseiten und Paginierung automatisch erkennt

- Felder zum Extrahieren vorschlägt

- Export zu Sheets, Airtable, Notion ermöglicht

- Dank KI den Wartungsaufwand minimiert

6. Welches Tool sollte ich nutzen?

- Playwright für komplexes, browserübergreifendes Scraping oder Testing

- Puppeteer für schnelle, Chrome-basierte Skripte

- Thunderbit für schnelle Ergebnisse ohne Code oder Wartung