Für viele Entwickler startet das Abenteuer Web Scraping oft mit einer simplen Idee – zum Beispiel, Produktdaten von einer Konkurrenzseite abzugreifen. Schnell stößt man auf Tools wie BeautifulSoup, aber der Einstieg wirkt erstmal etwas sperrig. Nach ein paar Versuchen und dem erfolgreichen Ausführen von pip install beautifulsoup4 sowie dem Extrahieren eines simplen HTML-Elements – etwa einer Überschrift – macht es bei den meisten Klick. Genau dieser Moment sorgt bei vielen Python-Einsteigern für Begeisterung und gibt das Selbstvertrauen, beim Web Scraping weiterzumachen.

Gerade wenn du neu im Web Scraping bist, wird dir BeautifulSoup vermutlich als Erstes empfohlen. Kein Wunder: Die Bibliothek ist einfach, leistungsfähig und seit über zehn Jahren der Standard, wenn es um Web Scraping mit Python geht. In diesem Leitfaden zeige ich dir, wie du BeautifulSoup mit pip installierst, wie du die ersten Schritte im Code gehst und warum es bei Entwicklern und Datenanalysten so beliebt ist. Gleichzeitig spreche ich aber auch offen über die Schwächen von BeautifulSoup – und warum immer mehr Teams (vor allem ohne Programmierkenntnisse) auf KI-gestützte Tools wie umsteigen.

Was steckt eigentlich hinter BeautifulSoup und warum ist es immer noch so angesagt?

Ganz einfach: BeautifulSoup ist ein besonders benutzerfreundlicher „HTML-Parser“ für Python. Du gibst ihm einen HTML- oder XML-Text, und bekommst eine übersichtliche Baumstruktur, die du mit Python bequem durchsuchen, navigieren und analysieren kannst. Es ist, als würdest du mit einem Röntgenblick durch Webseiten schauen – plötzlich werden all die verschachtelten Tags und Attribute zu greifbaren Daten.

Warum ist BeautifulSoup nach wie vor so populär?

Trotz neuerer Scraping-Frameworks bleibt BeautifulSoup für die meisten Python-Anfänger die erste Wahl. Tatsächlich wird es monatlich über von PyPI heruntergeladen. Das ist kein Zufall – auf Stack Overflow gibt es mehr als , was für eine riesige Community und viel Unterstützung für Einsteiger spricht.

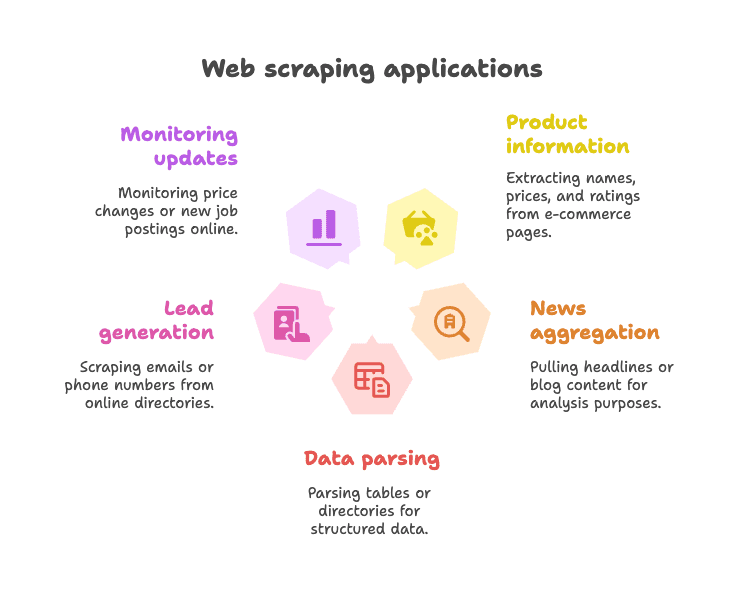

Typische Anwendungsfälle:

- Produktdaten extrahieren von E-Commerce-Seiten (z.B. Name, Preis, Bewertung)

- Nachrichtenüberschriften oder Blog-Inhalte für Analysen oder Aggregation sammeln

- Tabellen oder Verzeichnisse für strukturierte Daten auslesen (z.B. Firmenlisten)

- Lead-Generierung durch das Sammeln von E-Mails oder Telefonnummern aus Verzeichnissen

- Änderungen überwachen (z.B. Preisänderungen oder neue Stellenanzeigen)

BeautifulSoup eignet sich besonders für statische Webseiten – also Seiten, bei denen die gewünschten Daten direkt im HTML stehen. Es ist flexibel, verzeiht auch fehlerhaften Code und zwingt dich nicht in ein starres Framework. Deshalb bleibt es auch 2025 für viele Python-Nutzer das „erste große Tool“ ().

Pip install beautifulsoup: So gelingt der Einstieg am einfachsten

Was ist pip und warum sollte man es nutzen?

Falls du mit Python noch nicht so vertraut bist: pip ist der Paketmanager, mit dem du Bibliotheken aus dem Python Package Index (PyPI) installierst. Im Prinzip wie ein App Store – nur für Python-Code. Mit pip BeautifulSoup zu installieren, ist der schnellste und zuverlässigste Weg.

Profi-Tipp: Das richtige Paket heißt beautifulsoup4 (nicht nur beautifulsoup). Das „4“ steht für die aktuelle Version.

Schritt-für-Schritt: BeautifulSoup installieren

1. Python-Version prüfen

BeautifulSoup benötigt Python 3.7 oder neuer. Prüfe deine Version im Terminal:

1python --versionoder

1python3 --version2. BeautifulSoup4 mit pip installieren

Öffne dein Terminal oder die Eingabeaufforderung und gib ein:

1pip install beautifulsoup4Falls du mehrere Python-Versionen hast, nutze ggf.:

1pip3 install beautifulsoup4Unter Windows geht auch:

1py -m pip install beautifulsoup43. (Optional, aber empfohlen) Parser installieren

BeautifulSoup funktioniert direkt mit dem eingebauten "html.parser" von Python, aber für mehr Geschwindigkeit und Genauigkeit empfiehlt sich die Installation von lxml und html5lib:

1pip install lxml html5lib4. (Optional) Requests installieren

BeautifulSoup lädt keine Webseiten herunter – es analysiert nur HTML. Die meisten nutzen die -Bibliothek, um Seiten zu laden:

1pip install requests5. Installation testen

Probiere es in Python aus:

1from bs4 import BeautifulSoup

2import requests

3html = requests.get("http://example.com").text

4soup = BeautifulSoup(html, "html.parser")

5print(soup.title)Wenn du <title>Example Domain</title> siehst, ist alles bereit.

BeautifulSoup in einer virtuellen Umgebung installieren

Ich empfehle grundsätzlich, für Python-Projekte eine zu nutzen. So bleiben deine Abhängigkeiten sauber und du vermeidest Konflikte.

So richtest du eine virtuelle Umgebung ein:

1python -m venv venv

2# Unter Windows:

3venv\Scripts\activate

4# Unter macOS/Linux:

5source venv/bin/activate

6pip install beautifulsoup4 requests lxml html5libAlles, was du installierst, bleibt jetzt in diesem Projektordner. Keine „Warum fehlt mein Paket?“-Probleme mehr.

Alternative Installationsmethoden (Conda, etc.)

Falls du nutzt, kannst du BeautifulSoup so installieren:

1conda install beautifulsoup4Und für den Parser:

1conda install lxmlAchte darauf, dass deine conda-Umgebung vorher aktiviert ist.

BeautifulSoup Python: Erste Schritte mit Code-Beispielen

Jetzt wird’s praktisch. So nutzt du BeautifulSoup in einem echten Python-Skript.

Beispiel 1: Webseite laden und Titel extrahieren

1from bs4 import BeautifulSoup

2import requests

3url = "https://en.wikipedia.org/wiki/Python_(programming_language)"

4response = requests.get(url)

5soup = BeautifulSoup(response.content, "html.parser")

6# Seitentitel auslesen

7title_text = soup.title.string

8print("Seitentitel:", title_text)Dieses Skript lädt die Wikipedia-Seite zu Python, analysiert das HTML und gibt den Seitentitel aus. Ganz einfach!

Beispiel 2: Alle Links extrahieren

1links = soup.find_all('a')

2for link in links[:10]: # Zeige die ersten 10 Links

3 href = link.get('href')

4 text = link.get_text()

5 print(f"{text}: {href}")Damit erhältst du Text und URL der ersten 10 Links auf der Seite.

Beispiel 3: Überschriften auslesen

1headings = soup.find_all('h2')

2for h in headings:

3 print(h.get_text().strip())So bekommst du alle <h2>-Überschriften.

Beispiel 4: CSS-Selektoren verwenden

1items = soup.select("ul.menu > li")

2for item in items:

3 print(item.get_text())Mit select() kannst du CSS-Selektoren wie gewohnt nutzen.

Beispiel 5: Attribute und verschachtelte Tags auslesen

1first_link = soup.find('a')

2print(first_link['href']) # Direkter Zugriff (Fehler, falls nicht vorhanden)

3print(first_link.get('href')) # Sicherer Zugriff (gibt None zurück, falls nicht vorhanden)Beispiel 6: Gesamten Text extrahieren

1text_content = soup.get_text()

2print(text_content)Damit holst du dir den gesamten Text der Seite – praktisch für schnelle Analysen.

Häufige BeautifulSoup-Aufgaben für Einsteiger

Hier die gängigsten Aufgaben mit BeautifulSoup:

-

Einzelnes Element finden:

soup.find('div', class_='price') -

Alle Elemente finden:

soup.find_all('p', class_='description') -

Textinhalt auslesen:

element.get_text() -

Attributwert auslesen:

element.get('href') -

CSS-Selektoren nutzen:

soup.select('table.data > tr') -

Fehlende Elemente abfangen:

1price = soup.find('span', class_='price') 2if price: 3 print(price.get_text())

Die Syntax ist lesbar, einsteigerfreundlich und verzeiht auch fehlerhaftes HTML ().

Die Grenzen von BeautifulSoup beim modernen Web Scraping

Kommen wir zu den Schattenseiten: BeautifulSoup ist super für statische Seiten und kleine Projekte, aber nicht immer die beste Wahl.

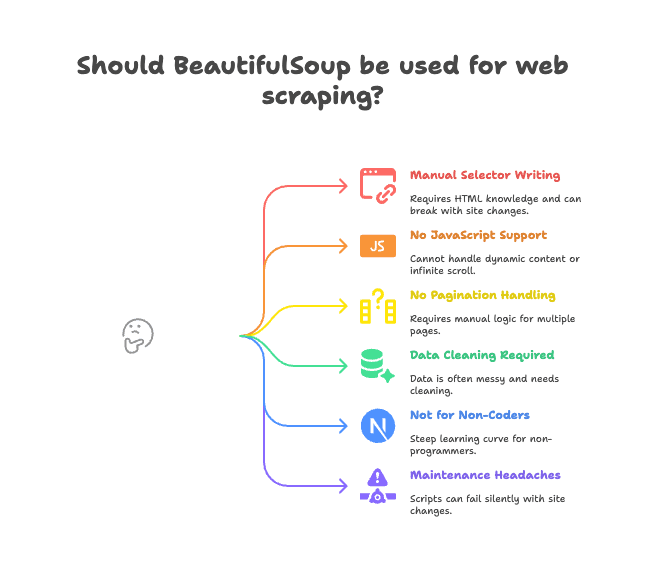

Hier die größten Stolpersteine:

- Manuelles Schreiben von Selektoren: Du musst das HTML lesen und die passenden Tags/Klassen selbst angeben. Ändert sich die Seite, funktioniert dein Skript nicht mehr.

- Keine JavaScript-Unterstützung: BeautifulSoup sieht nur das HTML, das vom Server kommt. Wird der Inhalt per JavaScript nachgeladen (z.B. bei Infinite Scroll), hast du das Nachsehen ().

- Keine eingebaute Paginierung oder Unterseiten-Logik: Möchtest du mehrere Seiten oder Detailseiten scrapen, musst du alles selbst programmieren.

- Datenbereinigung nötig: Die extrahierten Daten sind oft unaufgeräumt – mit Leerzeichen, Sonderzeichen oder uneinheitlichen Formaten.

- Nicht für Nicht-Programmierer: Wer nicht coden kann, hat mit BeautifulSoup einen steilen Lernweg.

- Wartungsaufwand: Ändert sich das Webseiten-Layout, kann dein Skript stillschweigend fehlschlagen oder Daten übersehen.

Gerade für Teams summieren sich diese „Kleinigkeiten“ schnell zu echten Produktivitätsbremsen. Ich habe schon einige Projekte scheitern sehen, weil das Scraping-Skript ständig angepasst werden musste.

Warum immer mehr Teams für Webdaten-Extraktion auf Thunderbit setzen

Was ist die Alternative? Hier kommt ins Spiel. Thunderbit ist keine weitere Python-Bibliothek, sondern eine Chrome-Erweiterung, die als KI-gestützter Webdaten-Assistent funktioniert.

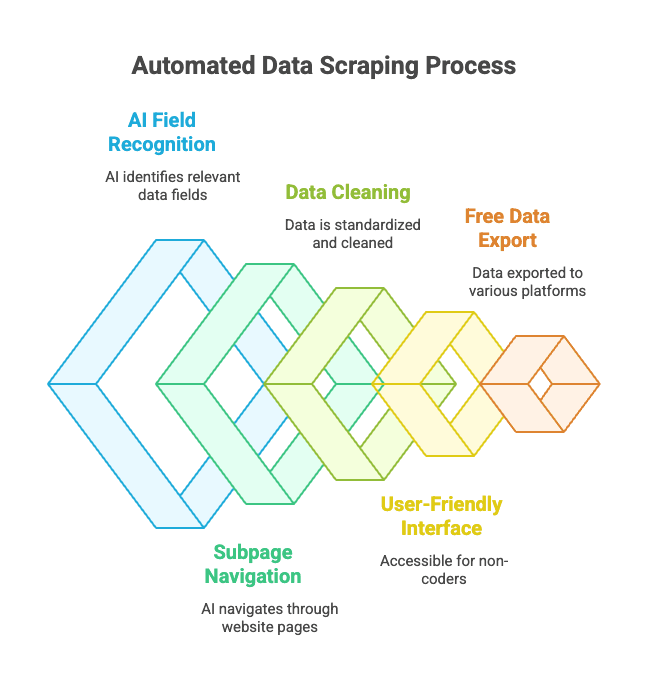

Wie läuft das ab?

- Du öffnest die gewünschte Website.

- Klick auf „KI-Felder vorschlagen“ – Thunderbits KI erkennt automatisch die passenden Spalten (z.B. „Produktname“, „Preis“, „Ort“).

- Du kannst die Spaltennamen und Typen anpassen.

- Klick auf „Scrapen“ – Thunderbit sammelt, bereinigt und strukturiert die Daten für dich.

- Exportiere die Daten mit einem Klick nach Excel, Google Sheets, Notion, Airtable oder in dein Lieblingstool.

Kein Code. Keine Selektoren. Keine Wartungsprobleme.

Die Highlights von Thunderbit:

- KI-gestützte Felderkennung: Die KI erkennt die gewünschten Daten, selbst bei unübersichtlichem HTML.

- Unterseiten- und Paginierungs-Scraping: Thunderbit kann automatisch auf Produktseiten klicken oder „Nächste Seite“-Links folgen.

- Automatische Datenbereinigung: Telefonnummern, E-Mails, Bilder und mehr werden standardisiert.

- Auch für Nicht-Programmierer: Wer einen Browser bedienen kann, kann auch Thunderbit nutzen.

- Kostenloser Datenexport: Exportiere zu Excel, Google Sheets, Airtable, Notion – ohne Bezahlschranke für Basisfunktionen.

- Geplantes Scraping: Lege Zeitpläne fest – Thunderbit sammelt die Daten automatisch.

Gerade für Business-Anwender ist das ein echter Gamechanger: Statt Python-Skripte zu schreiben, klickst du dich einfach zu deinen Daten.

Thunderbit vs. BeautifulSoup: Was passt zu dir?

Hier der direkte Vergleich:

| Funktion | BeautifulSoup (Python-Code) | Thunderbit (No-Code KI) |

|---|---|---|

| Einrichtung | Python, pip, Code nötig | Chrome-Erweiterung, 2 Klicks |

| Zeit bis zu den Daten | Stunden für das erste Skript | Minuten pro Website |

| JavaScript-Unterstützung | Nein (zusätzliche Tools nötig) | Ja (läuft im Browser) |

| Paginierung/Unterseiten | Manuell programmieren | Integriert, per Schalter |

| Datenbereinigung | Manuell im Code | KI-gestützt, automatisch |

| Exportmöglichkeiten | Eigenes CSV/Excel-Skript | Ein Klick zu Sheets, Notion etc. |

| Ideal für | Entwickler, Bastler | Business-Anwender, Nicht-Coder |

| Kosten | Kostenlos (aber zeitintensiv) | Freemium (kleine Jobs gratis) |

Wann BeautifulSoup sinnvoll ist:

- Du bist mit Python vertraut und willst volle Kontrolle.

- Du scrapest statische Seiten oder brauchst individuelle Logik.

- Du integrierst Scraping in einen größeren Python-Workflow.

Wann Thunderbit die bessere Wahl ist:

- Du willst schnelle Ergebnisse ohne Code.

- Du musst dynamische (JavaScript-)Seiten scrapen.

- Du bist im Vertrieb, Marketing, Operations oder willst dich nicht mit Code beschäftigen.

- Du möchtest Daten direkt in deine Business-Tools exportieren.

Selbst als Entwickler greife ich manchmal zu Thunderbit, wenn ich einfach schnell Daten brauche, ohne ein ganzes Python-Projekt aufzusetzen. Es ist wie ein Superkraft-Button im Browser.

Best Practices für die Installation und Nutzung von BeautifulSoup

Wenn du bei BeautifulSoup bleibst, hier meine wichtigsten Tipps für einen reibungslosen Ablauf:

- Immer eine virtuelle Umgebung nutzen: Hält deine Abhängigkeiten sauber und verhindert „bei mir geht’s, bei dir nicht“-Probleme.

- pip und Pakete aktuell halten: Regelmäßig

pip install --upgrade pipundpip list --outdatedausführen. - Empfohlene Parser installieren:

pip install lxml html5libfür bessere Performance und Stabilität. - Modularen Code schreiben: Trenne das Laden und Parsen für einfacheres Debugging.

- robots.txt und Rate-Limits beachten: Webseiten nicht überlasten – mit

time.sleep()Pausen einbauen. - Aussagekräftige, aber stabile Selektoren wählen: Vermeide zu spezifische Pfade, die schnell brechen.

- Parsing an gespeicherten HTML-Dateien testen: Lade eine Seite herunter und teste offline, um unnötige Anfragen zu vermeiden.

- Die Community nutzen: hilft bei fast jedem Problem.

Fehlerbehebung bei der Installation von BeautifulSoup

Probleme? Hier eine schnelle Checkliste:

- „ModuleNotFoundError: No module named bs4“

- Hast du

beautifulsoup4in der richtigen Umgebung installiert? Probierepython -m pip install beautifulsoup4.

- Hast du

- Falsches Paket installiert (

beautifulsoupstattbeautifulsoup4)- Altes Paket deinstallieren:

pip uninstall beautifulsoup - Richtiges installieren:

pip install beautifulsoup4

- Altes Paket deinstallieren:

- Parser-Warnungen oder Unicode-Fehler

- Installiere

lxmlundhtml5libund gib den Parser an:BeautifulSoup(html, "lxml")

- Installiere

- Elemente werden nicht gefunden

- Wird der Inhalt per JavaScript geladen? BeautifulSoup sieht nur das Quell-HTML, nicht das gerenderte DOM.

- pip-Fehler oder Berechtigungsprobleme

- Nutze eine virtuelle Umgebung oder versuche

pip install --user beautifulsoup4 - pip aktualisieren:

pip install --upgrade pip

- Nutze eine virtuelle Umgebung oder versuche

- Conda-Probleme

- Probiere

conda install beautifulsoup4oder nutze pip innerhalb deiner conda-Umgebung.

- Probiere

Immer noch Probleme? und Stack Overflow decken fast alle Fälle ab.

Fazit: Das Wichtigste zur Installation und Nutzung von BeautifulSoup

-

BeautifulSoup ist die beliebteste Python-Bibliothek fürs Web Scraping – einfach, flexibel und ideal für Einsteiger.

-

Installation mit pip:

1pip install beautifulsoup4 lxml html5lib requests -

Virtuelle Umgebung nutzen für eine saubere Installation.

-

BeautifulSoup ist ideal für statische Seiten und kleine Projekte, stößt aber bei JavaScript, Paginierung und Wartung an Grenzen.

-

Thunderbit ist die moderne, KI-gestützte Alternative für Business-Anwender und Nicht-Programmierer – kein Code, kein Aufwand, einfach Daten.

-

Wähle das passende Tool für deinen Bedarf:

- Entwickler und Bastler: BeautifulSoup gibt dir volle Kontrolle.

- Business-Teams: liefert schnelle Ergebnisse.

Teste ruhig beide Ansätze – manchmal ist die beste Lösung die, die dich am schnellsten ans Ziel bringt.

FAQ: Pip install BeautifulSoup und mehr

Frage: Was ist der Unterschied zwischen beautifulsoup und beautifulsoup4?

Antwort: Installiere immer beautifulsoup4 – das ist die aktuelle, unterstützte Version. Das alte Paket beautifulsoup ist veraltet und nicht mit Python 3 kompatibel. Importiert wird trotzdem mit from bs4 import BeautifulSoup ().

Frage: Muss ich lxml oder html5lib mit BeautifulSoup installieren?

Antwort: Nicht zwingend, aber sehr empfehlenswert. Sie machen das Parsen schneller und robuster. Installiere sie mit pip install lxml html5lib ().

Frage: Kann BeautifulSoup JavaScript-lastige Webseiten scrapen?

Antwort: Nein – BeautifulSoup sieht nur das statische HTML. Für JavaScript-Inhalte nutze Browser-Automatisierung wie Selenium oder ein KI-gestütztes Tool wie ().

Frage: Wie deinstalliere ich BeautifulSoup?

Antwort: Führe im Terminal pip uninstall beautifulsoup4 aus ().

Frage: Ist Thunderbit kostenlos nutzbar?

Antwort: Thunderbit bietet ein Freemium-Modell – kleine Jobs sind gratis, für größere Datenmengen oder Zusatzfunktionen gibt es kostenpflichtige Pläne. Du kannst es direkt im Browser kostenlos testen ().

Wenn du wissen willst, wie Thunderbit und BeautifulSoup im direkten Vergleich abschneiden, schau dir unseren an. Und wenn du tiefer ins Web Scraping einsteigen möchtest, findest du bei uns auch Anleitungen zu und .

Viel Erfolg beim Scrapen – egal ob du Python-Profi bist oder deine Daten einfach nur schnell in einer Tabelle brauchst: Es gibt das passende Tool (und eine Community), die dich unterstützt.