Das Internet ist 2026 chaotischer als je zuvor – mittlerweile machen Bots die Hälfte des gesamten Traffics aus. Open-Source-Web-Scraper sind dabei die unsichtbaren Helfer im Hintergrund: Sie sorgen für Preisüberwachung, KI-Training und vieles mehr. Nach Jahren in der SaaS- und Automatisierungswelt weiß ich: Die Wahl des richtigen, selbst gehosteten Crawlers kann deinem Team monatelange Kopfschmerzen (und einige Nachtschichten) ersparen. Egal, ob du nur ein paar Produktseiten abgreifen oder Millionen von URLs für Forschungsprojekte crawlen willst – die Open-Source-Alternativen zu Firecrawl in dieser Liste bieten für jeden Use Case die passende Lösung, unabhängig von Größe, Tech-Stack oder Komplexität.

Aber Vorsicht: Es gibt nicht das eine perfekte Tool für alle. Manche Teams brauchen die Power von Scrapy oder die Archivierungsstärke von Heritrix, andere finden die Wartung von Open-Source-Lösungen zu aufwendig. Deshalb stelle ich dir die 9 besten Open-Source-Alternativen zu Firecrawl für 2026 vor, zeige die jeweiligen Stärken und helfe dir, das richtige Tool für dein Unternehmen zu finden – ohne langes Herumprobieren.

Wie findest du die beste Open-Source-Firecrawl-Alternative für dein Unternehmen?

Bevor du in die Liste einsteigst, lohnt sich ein strategischer Blick. Die Open-Source-Web-Scraper-Landschaft ist so vielfältig wie nie. Deine Wahl sollte sich an diesen Punkten orientieren:

- Benutzerfreundlichkeit: Willst du lieber eine Klick-Oberfläche oder fühlst du dich mit Python, Go oder JavaScript wohl?

- Skalierbarkeit: Reicht ein einzelner Website-Crawl oder müssen Millionen von Seiten über viele Domains hinweg verarbeitet werden?

- Inhaltstyp: Geht es um statisches HTML oder um dynamische Seiten mit viel JavaScript?

- Integration: Wie willst du die Daten weiterverwenden – Export nach Excel, in eine Datenbank oder direkt in eine Analyse-Pipeline?

- Wartung: Hast du Ressourcen für die Pflege eigener Skripte oder soll das Tool sich möglichst automatisch an Webseitenänderungen anpassen?

Hier eine schnelle Übersicht als Entscheidungshilfe:

| Szenario | Bestes Tool |

|---|---|

| No-Code, Offline-Browsing | HTTrack |

| Großflächiges Crawling, viele Domains | Scrapy, Apache Nutch, StormCrawler |

| Dynamische/JS-lastige Seiten | Puppeteer |

| Formular-Automatisierung/Login | MechanicalSoup |

| Statische Seiten/Archivierung | Wget, HTTrack, Heritrix |

| Go-Entwickler, hohe Performance | Colly |

Los geht’s mit den 9 besten Open-Source-Alternativen zu Firecrawl für 2026.

1. Scrapy: Die Top-Wahl für großflächiges Python-Crawling

ist der Platzhirsch unter den Open-Source-Web-Scrapern. Entwickelt in Python, ist es das Framework für alle, die große Datenmengen crawlen müssen – von Millionen Seiten, häufigen Updates bis hin zu komplexer Logik.

Warum Scrapy?

- Enorme Skalierbarkeit: Scrapy verarbeitet tausende Anfragen pro Sekunde und wird von Unternehmen genutzt, die Milliarden Seiten pro Monat auslesen ().

- Modular & erweiterbar: Eigene Spider schreiben, Middleware für Proxies einbinden, Logins abwickeln und Ausgaben in JSON, CSV oder Datenbanken speichern.

- Aktive Community: Viele Plugins, ausführliche Dokus und Hilfe auf Stack Overflow.

- Bewährt im Einsatz: Weltweit im produktiven Einsatz bei E-Commerce, Nachrichtenportalen und Forschungsteams.

Einschränkungen: Für Nicht-Entwickler ist die Lernkurve steil, und die Spider müssen bei Webseitenänderungen gepflegt werden. Wer aber maximale Kontrolle und Skalierbarkeit sucht, kommt an Scrapy kaum vorbei.

2. Apache Nutch: Ideal für Enterprise-Suchmaschinen

ist der Urvater der Open-Source-Crawler und für unternehmensweite, internetgroße Crawls konzipiert. Wer eine eigene Suchmaschine bauen oder Millionen Domains crawlen will, ist hier richtig.

Warum Apache Nutch?

- Hadoop-Skalierung: Dank Hadoop kann Nutch Milliarden Seiten über Server-Cluster hinweg crawlen ( nutzt es für das öffentliche Web).

- Batch-Crawling: Seed-URLs einfügen und loslegen – ideal für geplante, großflächige Jobs.

- Integration: Funktioniert mit Solr, Elasticsearch und Big-Data-Pipelines.

Einschränkungen: Die Einrichtung ist komplex (Hadoop-Cluster, Java-Konfiguration), und der Fokus liegt auf dem reinen Crawling, nicht auf strukturierter Datenausgabe. Für kleine Projekte überdimensioniert, aber für Web-Scale unschlagbar.

3. Heritrix: Beste Wahl für Web-Archivierung & Compliance

ist der Crawler des Internet Archive, speziell für die Archivierung und digitale Langzeitaufbewahrung entwickelt.

Warum Heritrix?

- Archivierungsqualität: Erfasst jede Seite, jedes Asset und jeden Link – ideal für rechtliche Nachweise oder historische Momentaufnahmen.

- WARC-Format: Speichert alles in standardisierten Web-Archive-Dateien, die sich später wieder abspielen oder analysieren lassen.

- Webbasierte Verwaltung: Crawls bequem über eine Browser-Oberfläche steuern.

Einschränkungen: Benötigt viel Speicher und Rechenleistung, führt kein JavaScript aus und liefert Rohdaten statt strukturierter Tabellen. Perfekt für Bibliotheken, Archive oder regulierte Branchen.

4. Colly: High-Performance für Go-Entwickler

ist der Liebling der Go-Community – schnell, ressourcenschonend und hochgradig parallelisiert.

Warum Colly?

- Extrem schnell: Dank Go’s Parallelisierung crawlt Colly tausende Seiten mit minimalem Ressourcenverbrauch ().

- Einfache API: Callbacks für HTML-Elemente, automatisches Cookie- und robots.txt-Handling.

- Ideal für statische Seiten: Perfekt für serverseitig gerenderte Seiten, APIs oder als Teil eines Go-Backends.

Einschränkungen: Keine eingebaute JavaScript-Ausführung (für dynamische Seiten ist z. B. Chromedp nötig), Go-Kenntnisse erforderlich.

5. MechanicalSoup: Für einfache Formular-Automatisierung

ist eine Python-Bibliothek, die die Lücke zwischen einfachen HTTP-Requests und vollständiger Browser-Automatisierung schließt.

Warum MechanicalSoup?

- Formular-Automatisierung: Einfaches Einloggen, Formulare ausfüllen und Sitzungen verwalten – ideal für Daten hinter Logins.

- Leichtgewichtig: Setzt auf Requests und BeautifulSoup, daher schnell und unkompliziert.

- Optimal für interaktive Seiten: Wer Suchformulare ausfüllen oder Daten nach Login extrahieren will, ist hier richtig ().

Einschränkungen: Keine JavaScript-Ausführung, daher nicht für JS-lastige Seiten geeignet. Am besten für statische oder serverseitig gerenderte Seiten mit einfachen Interaktionen.

6. Puppeteer: Für dynamische & JavaScript-lastige Seiten

ist das Schweizer Taschenmesser für moderne, dynamische Webseiten. Die Node.js-Bibliothek steuert einen Headless-Chrome-Browser und bietet volle Kontrolle.

Warum Puppeteer?

- Dynamische Inhalte: Crawlt SPAs, Infinite Scroll und Seiten, die Daten per AJAX laden ().

- Nutzerinteraktion: Klicks, Formulare, Screenshots und sogar CAPTCHAs (mit Plugins) sind möglich.

- Leistungsstarke Automatisierung: Ideal für Tests, Monitoring und alles, was ein echter Nutzer sehen kann.

Einschränkungen: Ressourcenintensiv (startet komplette Chrome-Instanzen), langsamer als reine HTTP-Scraper, und für Skalierung ist starke Hardware oder Cloud nötig.

7. Wget: Für schnelle Downloads per Kommandozeile

ist das klassische Kommandozeilen-Tool für den Download statischer Webseiten und Dateien.

Warum Wget?

- Einfachheit: Ganze Seiten oder Verzeichnisse mit nur einem Befehl herunterladen – ganz ohne Programmierung.

- Geschwindigkeit: In C geschrieben, daher schnell und effizient.

- Ideal für statische Inhalte: Perfekt für Doku-Seiten, Blogs oder Massen-Downloads ().

Einschränkungen: Keine JavaScript-Ausführung oder Formularverarbeitung, lädt rohe Seiten (keine strukturierten Daten). Im Prinzip ein digitaler Staubsauger für statische Seiten.

8. HTTrack: Für Offline-Browsing (No-Code)

ist die benutzerfreundliche Alternative zu Wget und bietet eine grafische Oberfläche zum Spiegeln von Webseiten.

Warum HTTrack?

- Einfache Bedienung: Schritt-für-Schritt-Assistent, auch für Nicht-Techniker geeignet.

- Offline-Browsing: Passt Links an, sodass du die gespiegelte Seite lokal durchstöbern kannst.

- Ideal für Archivierung: Perfekt für Forscher, Marketer oder alle, die eine Website ohne Programmierung sichern möchten ().

Einschränkungen: Keine Unterstützung für dynamische Inhalte, kann bei großen Seiten langsam sein und ist nicht für strukturierte Datenausgabe gedacht.

9. StormCrawler: Für Echtzeit- und verteiltes Crawling

ist der moderne, verteilte Crawler für Teams, die kontinuierlich und in Echtzeit Webdaten im großen Stil benötigen.

Warum StormCrawler?

- Echtzeit-Crawling: Basierend auf Apache Storm, verarbeitet Daten als Streams – ideal für News-Monitoring oder Suchmaschinen ().

- Modular & skalierbar: Parsing, Indexierung und eigene Verarbeitungseinheiten flexibel ergänzbar.

- Im Einsatz bei Common Crawl: Versorgt eines der größten offenen Webarchive mit aktuellen News-Daten.

Einschränkungen: Java-Entwicklung und Storm-Cluster erforderlich, daher eher für erfahrene Teams mit Know-how in verteilten Systemen. Für kleine Projekte zu aufwendig.

Vergleich: Welche Open-Source-Firecrawl-Alternative passt zu deinen Anforderungen?

Hier ein direkter Vergleich aller 9 Tools:

| Tool | Bester Anwendungsfall | Hauptvorteile | Nachteile | Sprache / Setup |

|---|---|---|---|---|

| Scrapy | Großflächiges, häufiges Crawling | Leistungsstark, skalierbar, große Community | Hohe Lernkurve, Python erforderlich | Python-Framework |

| Apache Nutch | Enterprise, Web-Scale Crawling | Hadoop-Skalierung, bewährt im Einsatz | Komplexe Einrichtung, Batch-orientiert | Java/Hadoop |

| Heritrix | Archivierung, Compliance | Vollständige Seitenerfassung, WARC-Ausgabe | Schwergewichtig, kein JS, Rohdaten | Java-App, Web-UI |

| Colly | Go-Entwickler, High-Performance | Schnell, einfache API, Parallelisierung | Kein JS, Go erforderlich | Go-Bibliothek |

| MechanicalSoup | Formular-Automatisierung, Login | Leichtgewichtig, Session-Handling | Kein JS, begrenzte Skalierung | Python-Bibliothek |

| Puppeteer | Dynamische/JS-lastige Seiten | Volle Browserkontrolle, Automatisierung | Ressourcenintensiv, Node.js erforderlich | Node.js-Bibliothek |

| Wget | Statische Seiten, Offline-Zugriff | Einfach, schnell, CLI | Kein JS, Rohseiten | Kommandozeilen-Tool |

| HTTrack | Nicht-Techniker, Archivierung | GUI, einfaches Offline-Browsing | Kein JS, langsam bei großen Seiten | Desktop-App (GUI) |

| StormCrawler | Echtzeit, verteiltes Crawling | Skalierbar, modular, Echtzeit | Java/Storm-Know-how nötig | Java/Storm-Cluster |

Eigenbau oder bestehende Open-Source-Firecrawl-Alternative nutzen?

Ganz ehrlich: Einen eigenen Crawler zu bauen klingt erstmal spannend – bis man sich mit Wartung, Proxies und Anti-Bot-Maßnahmen herumschlägt. Die oben genannten Open-Source-Tools bündeln jahrelange Erfahrung und Community-Wissen. Branchenberichte zeigen: Mit bestehenden Lösungen kommst du schneller und zuverlässiger ans Ziel, ohne das Rad neu zu erfinden ().

- Open-Source nutzen, wenn: Deine Anforderungen schon abgedeckt sind, du Entwicklungszeit sparen und vom Community-Support profitieren willst.

- Selbst bauen, wenn: Du wirklich spezielle Anforderungen hast, tiefes Inhouse-Know-how mitbringst und Webscraping ein Kerngeschäft ist.

Allerdings ist Open-Source nicht „kostenlos“, wenn man Entwicklerzeit, Serverwartung und ständige Updates gegen Anti-Scraping-Maßnahmen einrechnet. Wer die Vorteile eines leistungsstarken Crawlers ohne Programmierung sucht, hat noch eine weitere Option.

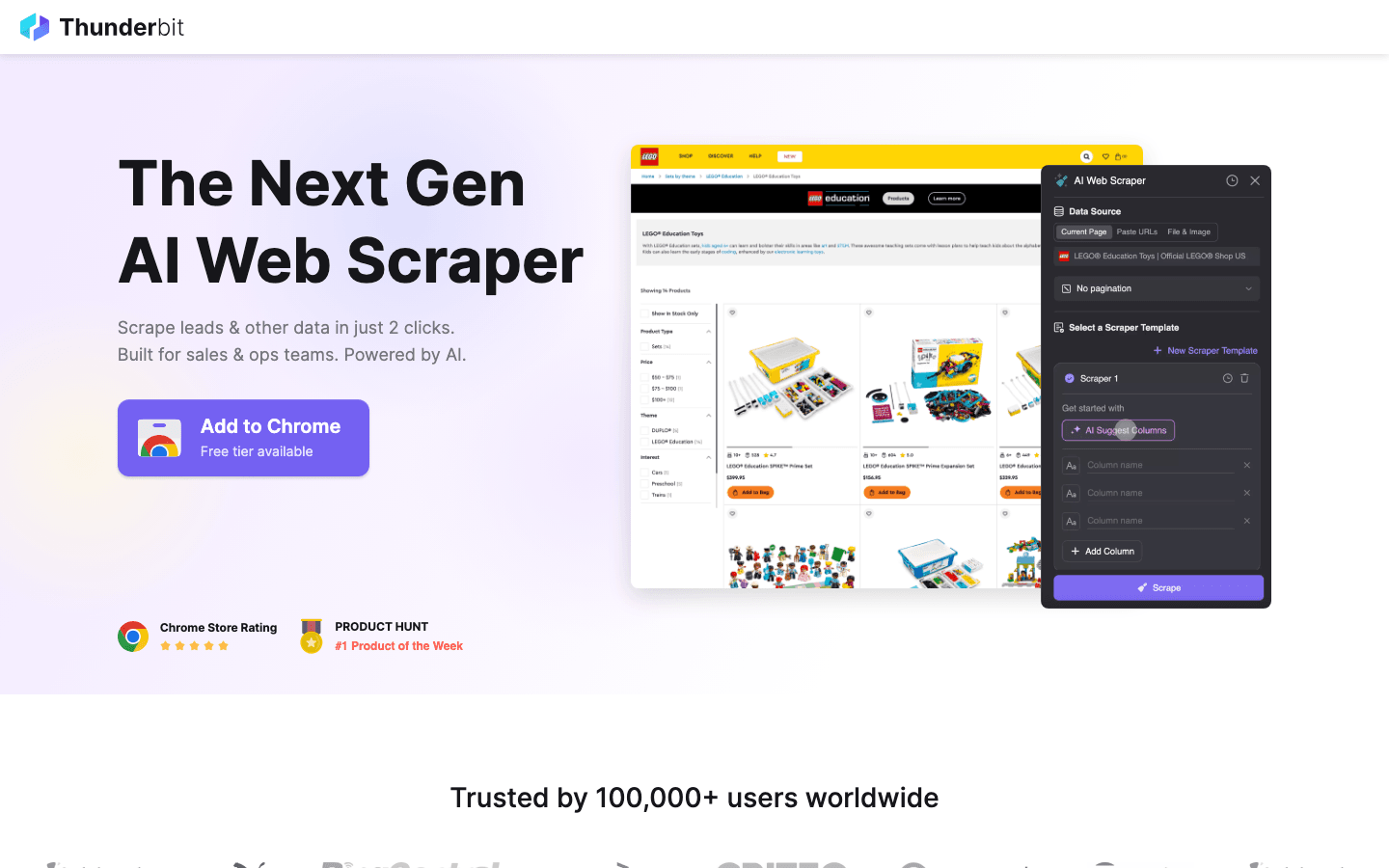

Bonus: Wenn Open-Source zu komplex ist – Thunderbit ausprobieren

Alle oben genannten Tools sind für Entwickler super, haben aber eines gemeinsam: Sie erfordern Programmierkenntnisse, kämpfen mit dynamischen Anti-Bot-Systemen und müssen laufend gewartet werden.

ist meine Empfehlung für alle, die diese Hürden umgehen wollen. Es verbindet leistungsstarkes Scraping mit maximaler Benutzerfreundlichkeit.

Warum Thunderbit statt Open-Source?

- Keine Programmierung nötig: Im Gegensatz zu Scrapy oder Puppeteer ist Thunderbit eine KI-gestützte Chrome-Erweiterung. Mit „AI Suggest Fields“ wird der Web-Scraper automatisch erstellt.

- Automatisiert das Komplizierte: Dynamische Inhalte, Infinite Scroll und Paginierung übernimmt die KI – du sparst dir stundenlanges Skripten.

- Sofortiger Export: Mit zwei Klicks landen die Daten in Excel, Google Sheets oder Notion.

- Keine Wartung: Du musst keine Skripte anpassen, wenn sich das Webseiten-Layout ändert – Thunderbit passt sich automatisch an.

Ob Vertrieb, Marketing oder Forschung: Wer ohne Programmierkenntnisse sofort an Daten kommen will, findet in Thunderbit die perfekte Ergänzung zu den Open-Source-Tools.

Neugierig? und probiere es selbst aus.

Fazit: Der richtige Self-Hosted Web Crawler für 2026

Die Welt der Open-Source-Alternativen zu Firecrawl ist so vielfältig wie nie. Ob du die Skalierbarkeit von Scrapy oder Nutch brauchst oder die Archivierungsqualität von Heritrix – für jeden Business-Case gibt es die passende Lösung. Entscheidend ist, das Tool an deine Anforderungen anzupassen: Nicht überdimensionieren, wenn du nur schnell Daten brauchst, und nicht unterinvestieren, wenn du im großen Stil crawlen willst.

Und falls Open-Source zu technisch oder zeitaufwendig wird, stehen KI-Tools wie Thunderbit bereit, um dich zu unterstützen.

Bereit für den Einstieg? Starte dein nächstes Datenprojekt mit Scrapy oder für einfaches, KI-gestütztes Scraping. Für weitere Tipps rund ums Webscraping schau auf dem vorbei – dort findest du viele Anleitungen und Deep Dives.

Häufige Fragen (FAQ)

1. Was ist der Hauptvorteil von Open-Source-Alternativen zu Firecrawl? Open-Source-Alternativen bieten Flexibilität, sparen Kosten und ermöglichen es dir, den Crawler selbst zu hosten und anzupassen. Du bist nicht an einen Anbieter gebunden und profitierst von Community-Support und regelmäßigen Updates.

2. Welches Tool eignet sich für Nicht-Techniker, die schnelle Ergebnisse brauchen? ist eine gute Open-Source-Lösung für Offline-Browsing. Für strukturierte Datenausgabe (z. B. Excel-Tabellen) empfehlen wir das Bonus-Tool mit KI-Unterstützung.

3. Wie gehe ich mit dynamischen, JavaScript-lastigen Webseiten um? ist hier die beste Wahl – es steuert einen echten Browser und kann alles auslesen, was ein Nutzer sieht, inklusive SPAs und AJAX-Inhalten.

4. Wann sollte ich einen Heavyweight-Crawler wie Apache Nutch oder StormCrawler einsetzen? Wenn du Millionen Seiten über viele Domains crawlen oder Echtzeit- und verteiltes Crawling (z. B. für Suchmaschinen oder News-Monitoring) brauchst, sind diese Tools für Skalierbarkeit und Zuverlässigkeit gemacht.

5. Ist es besser, einen eigenen Crawler zu bauen oder eine bestehende Open-Source-Lösung zu nutzen? Für die meisten Teams ist die Nutzung und Anpassung eines bestehenden Open-Source-Tools schneller, günstiger und zuverlässiger. Nur bei sehr speziellen Anforderungen und ausreichend Ressourcen lohnt sich ein Eigenbau.

Viel Erfolg beim Crawlen – mögen deine Daten immer frisch, strukturiert und einsatzbereit sein.

Mehr erfahren