In der digitalen Welt von heute gibt es bei Nachrichten kein Durchatmen mehr. Im Sekundentakt tauchen neue Schlagzeilen auf, Meinungen verbreiten sich rasant, und Storys entwickeln sich schneller, als du deinen Browser neu laden kannst. Nach Jahren in der Entwicklung von Automatisierungs- und KI-Lösungen weiß ich: Die richtige Info im richtigen Moment kann über Erfolg oder Misserfolg einer Geschäftsentscheidung, einer Marketingaktion oder sogar über das Image einer Firma entscheiden. Aber mal ehrlich: Wer versucht, diese Flut an Infos per Hand zu bändigen, ist wie jemand, der mit einem Schmetterlingsnetz einem Gewitter hinterherjagt. Genau deshalb ist News Scraping – also das automatisierte Sammeln und Strukturieren von Nachrichten-Daten aus dem Web – heute ein absolutes Muss für alle, die auf Echtzeit-Infos angewiesen sind.

Aber Achtung: Beim News Scraping geht’s nicht nur darum, Überschriften abzugreifen. Es kommt auf Präzision, Tempo und rechtliche Sauberkeit an. Wer hier patzt, hat schnell veraltete, lückenhafte oder sogar illegale Daten auf dem Tisch. Wer’s richtig macht, baut sich ein News-Radar, das immer einen Schritt voraus ist. In diesem Guide zeige ich dir die besten Methoden für News Scraping im Jahr 2025 – basierend auf meinen Erfahrungen bei und aktuellen Branchen-Insights. Egal ob du im Bereich Business Intelligence, PR, Forschung arbeitest oder einfach News-Fan mit einer Vorliebe für Tabellen bist: Hier bekommst du praktische Tipps, bewährte Workflows und ein paar Learnings aus dem Alltag (und vielleicht auch einen kleinen Lacher – denn auch News-Scraper brauchen Humor).

Was steckt hinter News Scraping und warum ist es so wichtig?

Im Kern heißt News Scraping, dass Nachrichtenartikel, Überschriften, Autoren, Veröffentlichungsdaten und weitere Metadaten automatisiert von News-Websites eingesammelt werden. So wird aus dem wilden Nachrichtenstrom eine geordnete, nutzbare Infoquelle. Im Gegensatz zu klassischem Web-Scraping, das oft auf statische Produktseiten oder Verzeichnisse abzielt, steht beim News Scraping die Aktualität und ständige Erneuerung im Fokus – quasi wie dein persönlicher News-Ticker.

Warum ist das so relevant? Über , und Unternehmen nutzen Newsfeeds als strategische Infoquelle. Ob Marktbeobachtung, Konkurrenzanalyse, Stimmungsanalysen oder Krisenmanagement – wer die richtigen News parat hat, ist klar im Vorteil.

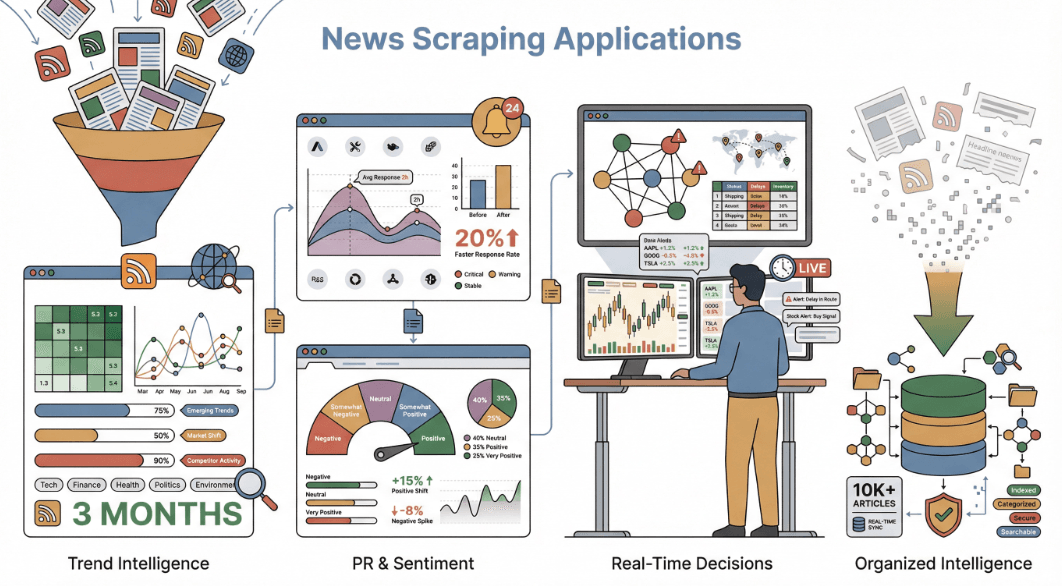

So nutzen Unternehmen News Scraping:

- Markt- & Trendanalyse: Trends frühzeitig erkennen – oft Monate bevor sie in offiziellen Reports auftauchen. Wer News aus vielen Quellen bündelt, sieht Branchenveränderungen bis zu drei Monate früher als Firmen, die nur auf interne Daten setzen.

- Wettbewerbs- & PR-Monitoring: Erwähnungen der eigenen Marke (oder der Konkurrenz) in Echtzeit verfolgen. Unternehmen, die News-Stimmungen beobachten, konnten ihre .

- Stimmungsanalyse & Forschung: Tausende Artikel auf Tonalität, Tendenzen oder Narrative analysieren – wie beim , den Ökonomen nutzen.

- Echtzeit-Entscheidungen: News-Daten in Handelsalgorithmen, Lieferketten-Alerts oder Management-Dashboards einbinden, um sofort reagieren zu können.

Kurz gesagt: News Scraping macht aus der täglichen Nachrichtenflut strukturierte Erkenntnisse – und das ist heute Gold wert.

News Scraping oder News APIs: Was ist besser?

Vielleicht fragst du dich: „Warum nicht einfach eine News API nutzen? Sind die nicht genau dafür da?“ Die Frage kommt oft – und ist berechtigt.

News APIs (wie NewsAPI.org oder Google News API) liefern strukturierte Feeds mit Überschriften, Zusammenfassungen und Metadaten aus vielen Quellen. Sie sind praktisch für schnelle Integrationen und breite Abdeckung, besonders wenn du nur Basisdaten wie Titel, Datum und Quelle brauchst. Aber APIs haben klare Grenzen:

- Wenige Datenfelder: Meist gibt’s nur Überschrift, Quelle, Datum und vielleicht eine Kurzfassung. Wer den kompletten Artikeltext, Autoreninfos, Kommentare oder verwandte Links will, schaut oft in die Röhre.

- Lücken in der Abdeckung: APIs decken nicht alle Seiten ab – vor allem nicht Nischen-, lokale oder kostenpflichtige Angebote.

- Keine Anpassung: Du bist an das Schema und den Update-Rhythmus des Anbieters gebunden.

- Kosten & Limits: Gute APIs sind oft teuer oder haben strenge Nutzungslimits.

News Scraping dagegen gibt dir die volle Kontrolle. Du kannst alles extrahieren, was auf der Seite sichtbar ist – Kommentare, Tags, eingebettete Medien, verwandte Artikel und mehr. Du bist nicht an Vorgaben oder Update-Zyklen Dritter gebunden. Und wenn du ein umfassendes News-Wissensnetzwerk aufbauen willst – inklusive aller unstrukturierten Details, die News wertvoll machen – führt am Scraping kein Weg vorbei.

Hier ein schneller Vergleich:

| Datenfeld | News API | News Scraping |

|---|---|---|

| Überschrift/Titel | Ja | Ja |

| Artikel-URL | Ja | Ja |

| Quellname | Ja | Ja |

| Veröffentlichungsdatum/-zeit | Ja | Ja |

| Autorenname | Manchmal | Ja |

| Vollständiger Artikeltext | Manchmal (kostenpflichtig) | Ja |

| Hauptbild-URL | Oft | Ja |

| Tags/Kategorie | Vielleicht | Ja |

| Kommentare/Diskussion | Nein | Ja |

| Verwandte Artikel-Links | Nein | Ja |

| Social Engagement | Nein | Ja (falls sichtbar) |

| Datenkonsistenz | Hoch | Variabel (normalisieren) |

Mit Scraping bekommst du die volle Bandbreite an News-Inhalten – perfekt für Analysen, Stimmungsmodelle oder eigene Dashboards.

Mehr dazu findest du im .

News Scraping clever timen: IP-Sperren vermeiden & Datenqualität sichern

Eine der größten Herausforderungen beim News Scraping: Wie oft sollte man scrapen – und wie verhindert man IP-Sperren?

Bei News zählt Aktualität. Wer zu langsam ist, verpasst wichtige Meldungen. Wer zu aggressiv ist, riskiert eine schnelle IP-Blockade. Die Kunst liegt im richtigen Timing – und das braucht Planung.

Best Practices fürs Timing beim News Scraping:

- An die Update-Frequenz der Seite anpassen: Aktualisiert sich die Quelle stündlich, dann auch stündlich scrapen. Bei Tageszeitungen reicht ein täglicher Rhythmus. Bei sehr schnellen Seiten (z. B. CNN, Reuters, Google News) kann alle 30 Minuten oder noch öfter sinnvoll sein ().

- Anfragen drosseln: Nicht den Server überlasten. Pausen zwischen den Anfragen einbauen und nicht hunderte Seiten in kurzer Zeit abfragen.

- robots.txt beachten: Immer checken, was die Seite erlaubt – vor allem Crawl-Delay und gesperrte Bereiche.

- Fehler überwachen: Wenn plötzlich leere Daten oder CAPTCHAs auftauchen, ist das ein Zeichen für zu schnelles Scraping.

Bei Thunderbit gibt’s dafür die Funktion Geplanter Scraper. Du gibst einfach das gewünschte Intervall in natürlicher Sprache ein („alle 4 Stunden an Werktagen“), und Thunderbit erledigt den Rest – verteilt die Anfragen, läuft in der Cloud und hält deine Datenpipeline am Laufen, ohne Sperren zu riskieren. Thunderbits Cloud-Scraping kann bis zu 50 Seiten gleichzeitig verarbeiten und verteilt die Last so, dass dein Scraping wie normales Nutzerverhalten aussieht.

Mehr zu Timing und Anti-Blockier-Strategien findest du im .

Daten aus dynamischen News-Seiten extrahieren: So klappt’s zuverlässig

Moderne Newsportale sind selten simpel. Sie setzen auf Endlos-Scrollen, „Mehr laden“-Buttons, AJAX-Kommentare und ständig wechselnde Layouts. Das macht das Scraping… sagen wir mal: spannend.

Typische Herausforderungen:

- Endlos-Scrollen & Paginierung: Viele Newsfeeds laden beim Scrollen oder Klicken auf „Weiter“ neue Artikel nach. Ein einfacher Scraper verpasst so bis zu 90 % der Inhalte.

- Dynamische Elemente: Kommentare, Bilder oder verwandte Links erscheinen oft erst nach einer Verzögerung oder Nutzeraktion.

- Häufige Layout-Änderungen: News-Seiten ändern ihr HTML regelmäßig – und bringen so starre Scraper aus dem Takt.

So löst Thunderbit diese Probleme:

- Automatische Paginierung & Endlos-Scrollen: Thunderbits KI erkennt und verarbeitet mehrseitige Navigation und unendliches Scrollen, sodass du alle Artikel bekommst – nicht nur die ersten zehn.

- KI-Feldextraktion: Statt auf fehleranfällige Selektoren zu setzen, „liest“ Thunderbit die Seite per KI und findet Felder wie Überschrift, Autor und Datum – selbst nach einem Redesign.

- Subpage-Scraping: Du willst den kompletten Artikeltext? Thunderbit besucht automatisch jeden Artikellink aus der Übersicht und extrahiert Details von der Unterseite – alles in einem Datensatz.

- Browser-Modus für dynamische Inhalte: Thunderbit kann im Browser laufen, JavaScript ausführen und warten, bis alle Inhalte geladen sind – ideal für AJAX-lastige Seiten.

Ein Beispiel: Beim Scraping von Google News mit Thunderbit bekommst du jede Überschrift, Quelle und Zeitstempel – auch wenn neue Artikel dynamisch nachgeladen werden. Und falls sich das Layout ändert, reicht ein Klick auf „KI Felder verbessern“ und Thunderbit passt sich an.

Wer tiefer einsteigen will, findet mehr im .

Rechtlich sicher und datenschutzkonform: News Scraping mit Verantwortung

Jetzt wird’s ernst: News Scraping bewegt sich rechtlich und ethisch oft in einer Grauzone. Es ist wichtig, die Spielregeln zu kennen und einzuhalten. So bleibst du auf der sicheren Seite:

- robots.txt und Nutzungsbedingungen respektieren: Immer checken, was die Seite erlaubt. Gesperrte Bereiche sind tabu.

- Keine Paywalls oder privaten Inhalte umgehen: Nur öffentlich zugängliche Daten extrahieren. Paywalls zu umgehen ist ein absolutes No-Go.

- Nur für interne Analysen nutzen: Scraping für interne Auswertungen oder Dashboards ist meist unproblematischer als das Veröffentlichen kompletter Artikel.

- Server nicht überlasten: Sei ein fairer Web-Nutzer. Anfragen drosseln und keine Belastung für die Seite verursachen.

- Personenbezogene Daten verantwortungsvoll behandeln: Wer Autoren oder Nutzerkommentare extrahiert, muss Datenschutzgesetze wie die DSGVO beachten.

Thunderbit hilft dir, rechtskonform zu bleiben. Es scrapt als dein Browser (mit deinen Logins und Berechtigungen), umgeht keine Sicherheitsmechanismen und speichert deine Daten lokal. Alle Exporte sind kostenlos und bleiben bei dir – du hast die volle Kontrolle.

Mehr zu rechtlichen Aspekten findest du im .

Thunderbits besondere Stärken beim News Scraping

Ich geb’s zu, ich bin voreingenommen – aber Thunderbit wurde gebaut, damit News Scraping für alle easy und stark ist, nicht nur für Entwickler. Das macht uns besonders:

- KI-gestützte Felderkennung: Mit einem Klick auf „KI Felder vorschlagen“ liest Thunderbit die Seite und schlägt passende Spalten vor (Überschrift, Autor, Datum, Inhalt, Bild usw.) – ganz ohne Programmierung.

- Subpage- & Multi-Page-Scraping: Automatisch Links zu Artikelseiten folgen und vollständige Inhalte, Kommentare oder verwandte Links extrahieren.

- Dynamische Inhalte meistern: Endlos-Scrollen, AJAX, Layout-Änderungen – Thunderbits KI passt sich an, sodass dein Scraper nicht bei jedem Update ausfällt.

- Cloud- & Browser-Modus: Wähle zwischen schnellem Cloud-Scraping für öffentliche Seiten oder Browser-Modus für Login-geschützte oder JavaScript-lastige Seiten.

- Kostenloser, flexibler Export: Exportiere nach Excel, Google Sheets, Airtable, Notion oder als JSON – ohne Paywall, ohne Limits.

- No-Code-Bedienung: Wer einen Browser bedienen kann, kann auch Thunderbit nutzen. Kein XPath, keine Skripte – einfach klicken und loslegen.

- Faire Preise: Kostenlos für kleine Projekte, kostenpflichtige Pläne ab 15 $/Monat – deutlich günstiger als viele Enterprise-Tools.

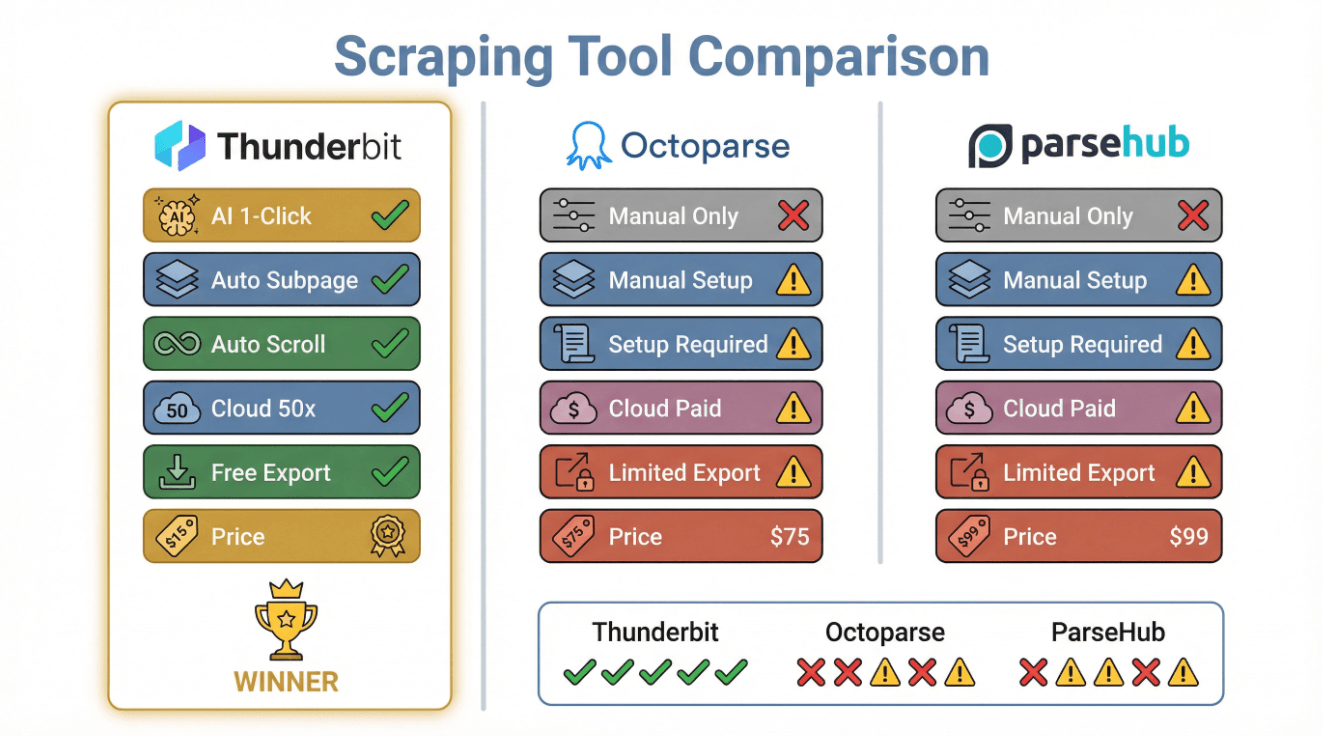

Hier ein schneller Funktionsvergleich:

| Funktion | Thunderbit | Octoparse | ParseHub |

|---|---|---|---|

| KI-Felderkennung | Ja (1-Klick) | Nein (manuell) | Nein (manuell) |

| Subpage-Scraping | Ja (automatisch) | Ja (manuell) | Ja (manuell) |

| Endlos-Scrollen | Ja (automatisch) | Ja (Setup nötig) | Ja (Setup nötig) |

| Cloud-Scraping | Ja (50 gleichzeitig) | Ja (kostenpflichtig) | Ja (kostenpflichtig) |

| Kostenloser Export | Ja (alle Pläne) | Eingeschränkt | Eingeschränkt |

| No-Code-Setup | Ja | Ja | Ja |

| Preisgestaltung | Kostenlos/ab 15 $/Monat | ab 75 $/Monat | ab 99 $/Monat |

Mehr dazu findest du in der .

Best Practices für präzises und aktuelles News Scraping

Hier die wichtigsten Punkte als Checkliste für jedes News Scraping-Projekt:

- Zuverlässige Quellen wählen: Setz auf seriöse, regelmäßig aktualisierte Newsportale oder Aggregatoren (z. B. Google News, BBC, CNN, Reuters, TechCrunch).

- Scraping-Frequenz anpassen: Passe den Zeitplan an die Update-Rate der Seite an – stündlich für Breaking News, täglich für langsamere Feeds.

- Dynamische Inhalte meistern: Nutze Tools (wie Thunderbit), die mit Endlos-Scrollen, AJAX und Layout-Änderungen umgehen können.

- Daten bereinigen & validieren: Doppelte Artikel entfernen, fehlende Felder prüfen und Formate vereinheitlichen.

- Rechtliche Vorgaben beachten: Immer robots.txt, Nutzungsbedingungen und Paywalls prüfen.

- Überwachen & anpassen: Alerts für fehlgeschlagene Scrapes einrichten und regelmäßig die Ergebnisse kontrollieren.

- Integration & Automatisierung: Exportiere die Daten in deine Lieblingstools (Sheets, Notion, Airtable) und richte Dashboards oder Benachrichtigungen ein.

Hier eine Schnellübersicht:

| Schritt | Best Practice |

|---|---|

| Quellenauswahl | Seriös, relevant, vielfältig |

| Zeitplanung | An Update-Rate anpassen, Anfragen drosseln |

| Dynamik meistern | KI/Automatisierung für Scrollen, Paginierung, AJAX |

| Datenqualität | Duplikate entfernen, validieren, normalisieren |

| Compliance | robots.txt, TOS, Datenschutzgesetze |

| Überwachung | Alerts, manuelle Checks, Anpassung bei Änderungen |

| Export & Nutzung | Automatisierung zu Sheets, Notion, Dashboards, Alerts |

Schritt-für-Schritt: So baust du einen effizienten News Scraping-Workflow

Jetzt wird’s praktisch. So richte ich einen News Scraping-Workflow mit ein – komplett ohne Programmieren.

Schritt 1: Zielquellen auswählen

- Seiten auswählen: Starte mit großen Portalen (BBC, CNN, Reuters), branchenspezifischen Seiten (TechCrunch, Medical News Today) und Aggregatoren (Google News).

- Zugänglichkeit prüfen: Stell sicher, dass die Inhalte öffentlich zugänglich sind (keine Paywalls).

- Sprache/Region beachten: Thunderbit unterstützt 34 Sprachen – nutze das für internationale Quellen.

- URLs sammeln: Startseiten, Rubrikenseiten oder Suchergebnisse (z. B. Google News zu „KI-Regulierung“).

Schritt 2: Thunderbit für News Scraping konfigurieren

- .

- Zielseite in Chrome öffnen.

- „KI Felder vorschlagen“ klicken: Thunderbit schlägt Spalten wie Titel, URL, Quelle, Veröffentlichungszeit, Autor, Bild usw. vor.

- Überprüfen & anpassen: Felder nach Bedarf ergänzen oder umbenennen (z. B. „Kategorie“ für Rubriken).

- Als Vorlage speichern: Für wiederholte Nutzung auf ähnlichen Seiten.

Schritt 3: Scraping-Aufgaben planen & überwachen

- Zeitplan festlegen: Nutze den Thunderbit-Planer („jeden Tag um 7 Uhr“ oder „stündlich während der Geschäftszeiten“).

- Manuellen Testlauf durchführen: Prüfe, ob die gewünschten Daten erfasst werden.

- Fehler überwachen: Ergebnisse regelmäßig kontrollieren; bei fehlenden Daten „KI Felder vorschlagen“ erneut ausführen oder Zeitplan anpassen.

- Subpages einbinden: Für vollständige Artikeltexte Subpage-Scraping aktivieren, damit Thunderbit jeden Artikellink besucht und weitere Felder extrahiert.

Schritt 4: News-Daten exportieren & nutzen

- Export in dein Lieblingstool: Google Sheets, Airtable, Notion, Excel oder als JSON.

- Dashboards automatisieren: Verbinde deine Tabelle mit Google Data Studio, Tableau oder Power BI für Live-News-Analysen.

- Benachrichtigungen einrichten: Mit Zapier oder IFTTT Alerts für neue Schlagzeilen oder Keywords auslösen.

- Workflow optimieren: Felder, Quellen oder Zeitplan nach Bedarf anpassen – Thunderbit macht Änderungen easy.

Mehr dazu im .

Fazit: Die wichtigsten Learnings für erfolgreiches News Scraping

Kurz und knapp: In einer Welt, in der News im Sekundentakt entstehen, ist automatisiertes News Scraping dein Schlüssel zu Information, Wettbewerbsfähigkeit und proaktivem Handeln. Die Best Practices sind simpel, aber effektiv: Die richtigen Quellen wählen, Scraping clever timen, dynamische Inhalte meistern, rechtlich sauber bleiben und die Ergebnisse immer im Blick behalten.

Thunderbit macht das nicht nur möglich, sondern für alle zugänglich – ohne Programmierung, ohne Stress, mit präzisen, aktuellen News-Daten für Analysen, Dashboards oder Alerts. Egal ob Analyst, PR-Profi, Forscher oder News-Fan: In wenigen Minuten baust du dein eigenes Echtzeit-News-Radar.

Wer keine Lust mehr hat, Schlagzeilen von Hand zu sammeln, sollte Thunderbit ausprobieren. Dein zukünftiges Ich (und dein Posteingang) werden es dir danken.

Mehr Tipps? Im findest du ausführliche Anleitungen, Tutorials und alles rund um KI-gestütztes Web Scraping.

FAQs

1. Warum sollte ich News scrapen statt eine News API zu nutzen?

Mit News Scraping bekommst du individuellere und umfassendere Daten – inklusive Kommentare, Autoreninfos, verwandte Links und vollständige Artikeltexte, die APIs meist nicht liefern. Perfekt für eigene News-Datensätze, Stimmungsmodelle oder Wissensgraphen.

2. Wie verhindere ich IP-Sperren beim News Scraping?

Nutze Planungs-Tools (wie Thunderbits Geplanter Scraper), um Anfragen zu verteilen, die Update-Frequenz der Seite zu berücksichtigen und robots.txt zu respektieren. Vermeide zu schnelle Abfragen und achte auf Fehler oder CAPTCHAs.

3. Wie gehe ich mit dynamischen News-Seiten (Endlos-Scrollen, AJAX) um?

Wähle einen Scraper (wie Thunderbit), der automatische Paginierung, Endlos-Scrollen und KI-gestützte Felderkennung unterstützt. So bekommst du auch dynamisch geladene Artikel.

4. Ist News Scraping legal?

Das Scrapen öffentlich zugänglicher Nachrichten für interne Analysen ist meist erlaubt, aber prüfe immer robots.txt und die Nutzungsbedingungen. Niemals Paywalls oder private Inhalte umgehen und Urheber- sowie Datenschutz beachten.

5. Was macht Thunderbit besonders für News Scraping?

Thunderbit kombiniert KI-Felderkennung, Subpage-Scraping, dynamische Inhaltsverarbeitung und kostenlosen Export zu Excel, Sheets, Airtable und Notion – alles ohne Programmieraufwand. Ideal für Business-Anwender, die aktuelle, präzise News-Daten ohne Technikstress brauchen.

Bereit für deine eigene News-Datenpipeline? und erleben, wie einfach News Scraping sein kann.

Mehr erfahren