Im Jahr 2025 sind Webdaten längst nicht mehr nur ein nettes Extra – sie sind das Herzstück moderner Geschäftsstrategien. Egal ob große E-Commerce-Unternehmen, die in Echtzeit die Preise der Konkurrenz checken, oder Vertriebsteams, die ihre Leadlisten automatisch auffüllen: Öffentliche Webdaten sind für viele Firmen so wertvoll wie digitales Gold. Die Zahlen sprechen für sich: Fast , und über . Auch wenn Python oft im Rampenlicht steht, bleibt – vor allem, wenn es auf Zuverlässigkeit und Integration ankommt.

Nach vielen Jahren in der SaaS- und Automatisierungswelt habe ich erlebt, wie Java Web-Scraper ganze Geschäftsprozesse auf ein neues Level heben können. Gleichzeitig habe ich Teams gesehen, die sich in zu viel Code verlieren oder an dynamischen Webseiten und Anti-Bot-Maßnahmen scheitern. Deshalb gibt’s hier einen praxisnahen, Schritt-für-Schritt-Guide, wie du Java Web Scraping 2025 richtig angehst – inklusive Tipps, wie du klassischen Code mit modernen KI-Tools wie kombinierst. Egal ob Entwickler, Operations-Manager oder Business-Anwender: Mit diesem Guide kommst du ans Ziel – ganz ohne Drama.

Was ist Java Web Scraping? Einfach erklärt

Kurz gesagt: Java Web Scraping heißt, mit Java-Code automatisch Infos von Webseiten zu holen. Stell dir vor, du hast einen digitalen Assistenten, der tausende Webseiten blitzschnell durchforstet und die gewünschten Daten fehlerfrei in eine Tabelle packt – rund um die Uhr, ohne Pause.

So läuft’s ab:

- Anfrage an eine Webseite schicken (wie beim normalen Surfen).

- HTML-Inhalt laden (also den Quellcode der Seite).

- HTML parsen und in eine für das Programm verständliche Struktur bringen.

- Gezielt Daten rausziehen (z. B. Produktnamen, Preise, E-Mails).

- Ergebnisse speichern – zum Beispiel als CSV, Excel, in einer Datenbank oder direkt in Google Sheets.

Du musst kein Hardcore-Entwickler sein, um die Basics zu verstehen. Mit den richtigen Tools und etwas Anleitung können auch Fachabteilungen Webdaten automatisiert sammeln und aus unübersichtlichen Webseiten echte Schätze ziehen.

Warum Java Web Scraping 2025 für Unternehmen ein Muss ist

Web Scraping ist längst kein Nischenthema mehr, sondern ein echter Gamechanger fürs Business. Hier ein paar Beispiele, wie Unternehmen Java Web Scraping nutzen und was sie davon haben:

| Web Scraping-Anwendungsfall | Geschäftlicher Nutzen (ROI) | Beispielbranchen |

|---|---|---|

| Wettbewerbsfähige Preisüberwachung | Echtzeit-Preisanalysen; Umsatzsteigerung von 20 % und mehr durch schnelle Reaktion auf Marktveränderungen | E-Commerce, Einzelhandel |

| Leadgenerierung & Vertriebsinfos | Automatisierte, aktuelle Leadlisten; 70 % weniger manueller Rechercheaufwand | B2B-Vertrieb, Marketing, Recruiting |

| Marktforschung & Trendanalyse | Früherkennung von Trends; 5–15 % mehr Umsatz und 10–20 % höherer Marketing-ROI | Konsumgüter, Marketingagenturen |

| Finanz- & Investmentdaten | Alternative Daten für den Handel; $5 Mrd.+ Markt für webgescrapte „Alt-Daten“ | Finanzen, Hedgefonds, Fintech |

| Prozessautomatisierung & Monitoring | Routinemäßige Datensammlung automatisiert; 73 % Kostenersparnis und 85 % schnellere Umsetzung | Immobilien, Logistik, Behörden |

()

Warum Java? Weil es für Skalierbarkeit, Stabilität und Integration gebaut wurde. Viele Unternehmensdatenpipelines laufen sowieso auf Java – ein Web-Scraper fügt sich da nahtlos ein. Dank Multithreading und robuster Fehlerbehandlung ist Java perfekt für große Datenmengen – zum Beispiel, wenn du täglich tausende Seiten scrapen willst.

Wie funktioniert Java Web Scraping? Die Basics und Stärken

So läuft ein typischer Java Web-Scraper ab:

- HTTP-Anfragen: Mit Libraries wie JSoup oder Apache HttpClient werden Webseiten abgerufen. Du kannst Header setzen, Proxys nutzen und Browser simulieren, um Blockaden zu umgehen.

- HTML-Parsing: Tools wie JSoup verwandeln das HTML in eine DOM-Struktur, sodass du gezielt per CSS-Selektoren Daten findest.

- Datenextraktion: Du legst Regeln fest (z. B. „alle

<span class='price'>-Elemente auslesen“), um die Infos zu holen, die du brauchst. - Datenspeicherung: Ergebnisse werden als CSV, Excel, JSON oder direkt in eine Datenbank geschrieben.

Was macht Java beim Web Scraping besonders?

- Multithreading: Java kann viele Seiten gleichzeitig abarbeiten – ideal für große Crawls. Anders als bei Python gibt’s hier keine GIL-Bremse.

- Performance: Als kompilierte Sprache packt Java auch speicherintensive Aufgaben locker.

- Enterprise-Integration: Java-Scraper lassen sich direkt in bestehende Systeme wie CRM, ERP oder Datenbanken einbinden.

- Fehlerbehandlung: Dank strikter Typisierung und Exception-Handling sind Java-Scraper besonders robust und wartbar.

Wer auf stabile, skalierbare Datenpipelines setzt, kommt an Java kaum vorbei.

Die wichtigsten Java Web Scraping-Bibliotheken und Frameworks

Es gibt viele Java-Bibliotheken fürs Web Scraping, aber drei sind besonders wichtig: JSoup, HtmlUnit und Selenium. Hier ein Überblick:

| Bibliothek | JavaScript-Unterstützung? | Benutzerfreundlichkeit | Performance | Einsatzgebiet |

|---|---|---|---|---|

| JSoup | ❌ (Kein JS) | Sehr einfach | Hoch | Statische Seiten, schnelle Aufgaben, leichtgewichtig |

| HtmlUnit | ⚠️ Teilweise | Mittel | Mittel | Einfaches JS, Formulare, Headless-Scraping |

| Selenium | ✅ Ja (vollständig) | Mittel/Komplex | Geringer (pro Seite) | JS-lastige Seiten, interaktive/dynamische Seiten |

()

JSoup: Der Standard für einfaches HTML-Parsing

ist meine erste Wahl für die meisten Scraping-Jobs. Es ist schlank, super einfach zu bedienen und perfekt für statische Seiten, bei denen die Daten direkt im HTML stehen.

Beispiel:

1Document doc = Jsoup.connect("https://www.scrapingcourse.com/ecommerce/").get();

2String bannerTitle = doc.select("div.site-title").text();

3System.out.println("Banner: " + bannerTitle);So simpel kann’s sein. Für Blogposts, Produktlisten oder Verzeichnisse ohne JavaScript ist JSoup top.

HtmlUnit: Browser-Simulation für komplexere Aufgaben

ist ein Headless-Browser in Java. Er kann mit einfachem JavaScript umgehen, Formulare ausfüllen und Buttons klicken – alles ohne sichtbaren Browser.

Wann nutzen? Wenn du dich einloggen oder mit einfachen dynamischen Inhalten arbeiten musst, aber nicht den Overhead von Selenium willst.

Beispiel:

1WebClient webClient = new WebClient();

2HtmlPage page = webClient.getPage("https://example.com/login");

3// ... Formular ausfüllen und absenden ...Selenium: Für JavaScript-lastige und interaktive Seiten

ist der Alleskönner. Es steuert einen echten Browser (z. B. Chrome oder Firefox) und kann so jede Seite wie ein Mensch bedienen – auch wenn sie komplett auf JavaScript basiert.

Wann nutzen? Für moderne Web-Apps, Seiten mit Endlos-Scroll oder wenn Interaktionen wie Klicken und Warten nötig sind.

Beispiel:

1WebDriver driver = new ChromeDriver();

2driver.get("https://www.scrapingcourse.com/ecommerce/");

3List<WebElement> products = driver.findElements(By.cssSelector("li.product"));

4// ... Daten extrahieren ...

5driver.quit();Java Web Scraping mit Thunderbit beschleunigen: Visuelle Automatisierung trifft Code

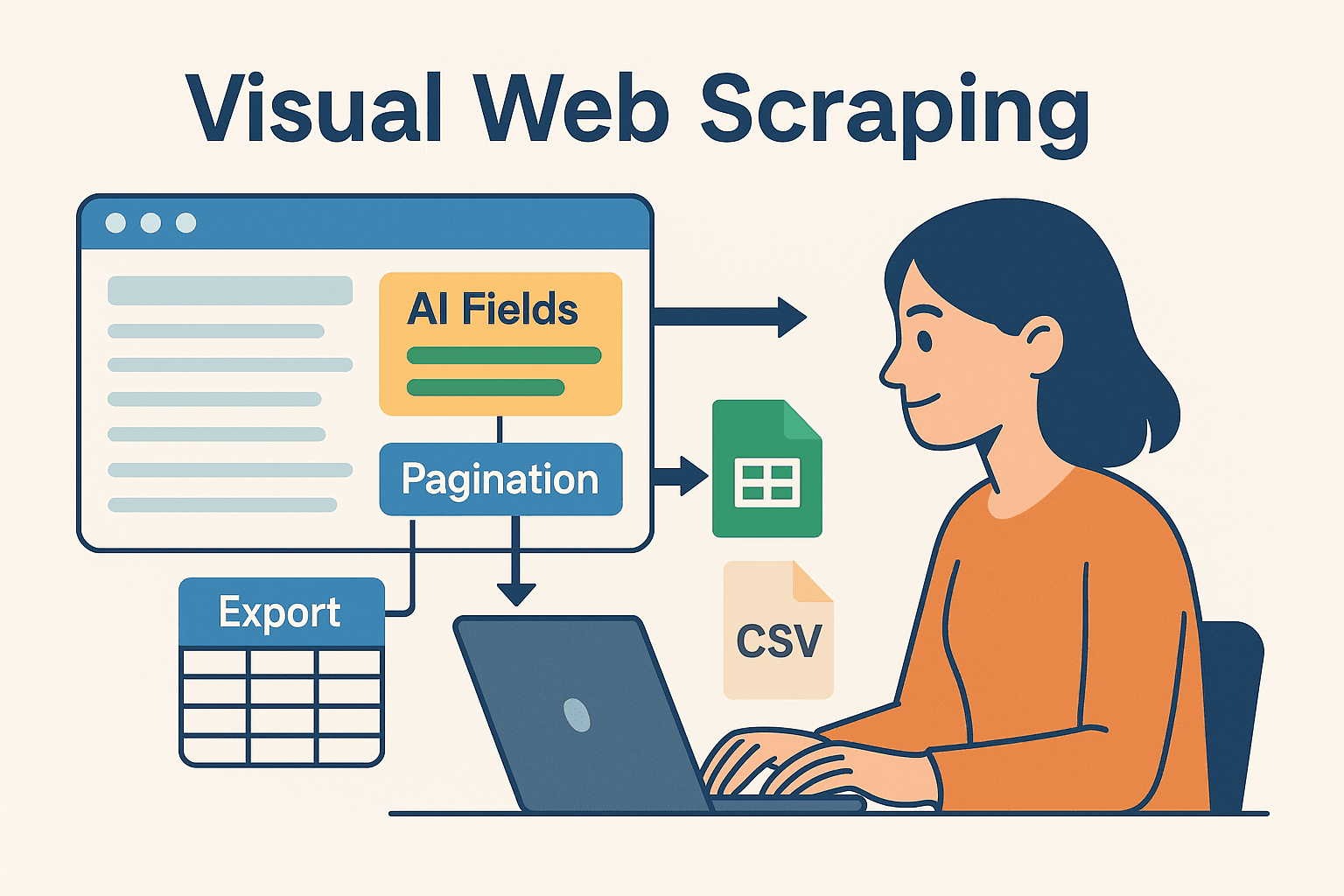

Jetzt wird’s richtig spannend – vor allem für Teams, die nicht den ganzen Tag im Code stecken wollen. ist ein KI-gestützter, No-Code Web-Scraper, mit dem du Scraping-Aufgaben direkt im Browser visuell definierst und die Daten sofort nach Excel, Google Sheets, Airtable oder Notion exportieren kannst.

Warum Thunderbit mit Java kombinieren?

- KI-Feldvorschläge: Thunderbit erkennt automatisch relevante Felder auf der Seite – du musst keine HTML-Selektoren mehr suchen.

- Unterseiten-Scraping: Für Detaildaten kann Thunderbit automatisch jede Unterseite besuchen und dein Dataset erweitern.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, LinkedIn) gibt’s fertige Templates – ein Klick reicht.

- Einfache Exporte: Nach dem Scraping kannst du die Daten in Sekunden exportieren – bereit für die Weiterverarbeitung in Java.

Thunderbit spart enorm viel Zeit beim Prototyping, bei schwierigen Seiten oder wenn Fachabteilungen selbst Daten sammeln wollen. Für Entwickler ist es ideal, um wiederkehrende oder fehleranfällige Aufgaben auszulagern und sich auf die eigentliche Logik zu konzentrieren.

Thunderbit und Java für komplexe Projekte kombinieren

So sieht ein bewährter Workflow aus:

- Prototyping mit Thunderbit: Mit der Chrome-Erweiterung Scraping visuell einrichten. Die KI schlägt Felder vor, übernimmt Paginierung und exportiert die Daten nach Google Sheets oder CSV.

- Weiterverarbeitung in Java: Java-Code liest die exportierten Daten (aus Sheets, CSV oder Airtable) und übernimmt Analyse, Nachbearbeitung oder Integration in Unternehmenssysteme.

- Automatisieren & Planen: Mit Thunderbits integriertem Scheduler bleiben deine Daten aktuell, und die Java-Pipeline verarbeitet automatisch die neuesten Exporte.

Mit diesem hybriden Ansatz profitierst du von der Geschwindigkeit und Flexibilität von KI-gestütztem No-Code-Scraping und der Power von Java für die Weiterverarbeitung.

Schritt-für-Schritt-Anleitung: Deinen ersten Java Web-Scraper bauen

Jetzt wird’s praktisch. So baust du einen einfachen Java Web-Scraper von Grund auf.

Java-Umgebung einrichten

- Java (JDK) installieren: Am besten Java 17 oder 21 nehmen.

- Maven einrichten: Damit verwaltest du Abhängigkeiten easy.

- IDE wählen: IntelliJ IDEA, Eclipse oder VSCode sind super.

- JSoup in die

pom.xmlaufnehmen:1<dependency> 2 <groupId>org.jsoup</groupId> 3 <artifactId>jsoup</artifactId> 4 <version>1.16.1</version> 5</dependency>

Scraper schreiben und ausführen

Wir holen uns Produktnamen und Preise von einer Demo-E-Commerce-Seite.

1import org.jsoup.Jsoup;

2import org.jsoup.nodes.Document;

3import org.jsoup.select.Elements;

4import org.jsoup.nodes.Element;

5public class ProductScraper {

6 public static void main(String[] args) {

7 String url = "https://www.scrapingcourse.com/ecommerce/";

8 try {

9 Document doc = Jsoup.connect(url)

10 .userAgent("Mozilla/5.0")

11 .get();

12 Elements productElements = doc.select("li.product");

13 for (Element productEl : productElements) {

14 String name = productEl.selectFirst("h2").text();

15 String price = productEl.selectFirst("span.price").text();

16 System.out.println(name + " -> " + price);

17 }

18 } catch (Exception e) {

19 e.printStackTrace();

20 }

21 }

22}Tipp: Immer einen User-Agent setzen, damit du wie ein echter Browser wirkst. Viele Seiten blocken den Standard-Java-User-Agent.

Daten exportieren und weiterverwenden

- CSV-Export: Mit

FileWriteroder einer Library wie OpenCSV Ergebnisse als CSV speichern. - Excel-Export: Für .xls/.xlsx-Dateien Apache POI nutzen.

- Datenbank-Anbindung: Mit JDBC Daten direkt in die Datenbank schreiben.

- Google Sheets: Daten aus Thunderbit exportieren und mit der Google Sheets API in Java weiterverarbeiten.

Typische Herausforderungen beim Java Web Scraping meistern

Web Scraping läuft nicht immer reibungslos. Hier die häufigsten Stolpersteine – und wie du sie umgehst:

- IP-Blockaden & Rate-Limits: Anfragen verlangsamen (

Thread.sleep()), Proxys rotieren und Pausen zufällig gestalten. Bei großen Mengen Proxy-Dienste nutzen. - CAPTCHAs & Bot-Erkennung: Mit Selenium menschliches Verhalten simulieren oder Anti-Bot-APIs einsetzen. Thunderbits Cloud-Scraping kann viele Hürden umgehen.

- Dynamische Inhalte: Liefert JSoup leere Ergebnisse, werden die Daten meist per JavaScript nachgeladen. Dann zu Selenium oder HtmlUnit wechseln oder die API der Seite analysieren.

- Strukturänderungen der Website: Flexibel mit Selektoren arbeiten und Scraper regelmäßig überwachen. Thunderbits KI passt sich Layout-Änderungen schnell an – einfach „KI-Felder vorschlagen“ erneut ausführen.

- Session-Handling: Für eingeloggtes Scraping Cookies und Sessions korrekt verwalten. Selenium und Thunderbit (bei eingeloggtem Chrome) unterstützen authentifizierte Seiten.

Profi-Tipps für effizientes Java Web Scraping

Bereit für den nächsten Schritt? Hier ein paar Experten-Tipps:

- Multithreading: Mit

ExecutorServicemehrere Seiten parallel scrapen – aber nicht übertreiben, sonst droht eine Sperre! - Zeitplanung: Mit Quartz Scheduler in Java oder Thunderbits Cloud-Scheduler (per natürlicher Sprache, z. B. „jeden Montag um 9 Uhr“).

- Cloud-Scaling: Für große Projekte Headless-Browser in der Cloud laufen lassen oder Aufgaben auf mehrere Maschinen verteilen.

- Hybride Workflows: Thunderbit für schwierige, wartungsintensive Seiten nutzen, Java-Code für den Rest. Ergebnisse im Data Warehouse zusammenführen.

- Monitoring & Logging: Mit Java-Logging-Frameworks Scraper-Status überwachen, Fehler frühzeitig erkennen und bei Problemen Benachrichtigungen auslösen.

Fazit & wichtigste Erkenntnisse

Webdaten sind das neue Gold – und Java bleibt eines der besten Werkzeuge, um sie effizient und zuverlässig zu heben. Der Ablauf ist simpel: Daten holen, parsen, extrahieren und ausgeben. Mit JSoup, HtmlUnit und Selenium meisterst du alles von einfachen Verzeichnissen bis zu komplexen JavaScript-Seiten.

Aber du musst nicht alles selbst coden. Tools wie bringen KI und visuelle Automatisierung ins Spiel, sodass du Scraping-Projekte schneller aufsetzen, anpassen und skalieren kannst. Mein Tipp: Kombiniere Code und No-Code! Thunderbit sorgt für schnellen Start und einfache Wartung, Java übernimmt die Power-Logik im Hintergrund.

Du willst sehen, wie Thunderbit deinen Workflow beschleunigt? und probiere das Scraping in wenigen Minuten aus. Mehr Tipps, Tutorials und Insights findest du im .

Viel Erfolg beim Scraping – und mögen deine Daten immer strukturiert, aktuell und einsatzbereit sein.

Häufige Fragen (FAQ)

1. Ist Java 2025 noch relevant fürs Web Scraping?

Klar! Python ist zwar beliebt für schnelle Skripte, aber Java bleibt die erste Wahl für große, stabile und langlaufende Scraping-Projekte – vor allem, wenn Integration und Multithreading gefragt sind.

2. Wann sollte ich JSoup, HtmlUnit oder Selenium nutzen?

JSoup für statische Seiten, HtmlUnit für einfache dynamische Inhalte oder Formulare, Selenium für JavaScript-lastige oder interaktive Seiten. Wähle das Tool passend zur Komplexität der Website.

3. Wie kann ich Blockaden beim Scraping vermeiden?

Anfragen drosseln, Proxys rotieren, realistische User-Agents setzen und menschliches Verhalten nachahmen. Bei schwierigen Seiten Thunderbits Cloud-Scraping oder Anti-Bot-APIs nutzen.

4. Können Thunderbit und Java zusammenarbeiten?

Definitiv. Mit Thunderbit Scrapes visuell planen und terminieren, Daten exportieren und dann mit Java weiterverarbeiten oder integrieren. Eine starke Kombi für Business-User und Entwickler.

5. Wie starte ich am schnellsten mit Java Web Scraping?

Java und Maven einrichten, JSoup hinzufügen und eine einfache Seite scrapen. Für komplexere Aufgaben oder schnelles Prototyping Thunderbit installieren und die KI die Arbeit machen lassen – die Ergebnisse dann in den Java-Workflow übernehmen.

Du willst mehr Tipps, Codebeispiele oder Automatisierungstricks? Schau im vorbei oder abonniere unseren für praxisnahe Tutorials und aktuelle Web Scraping-Trends.

Mehr erfahren