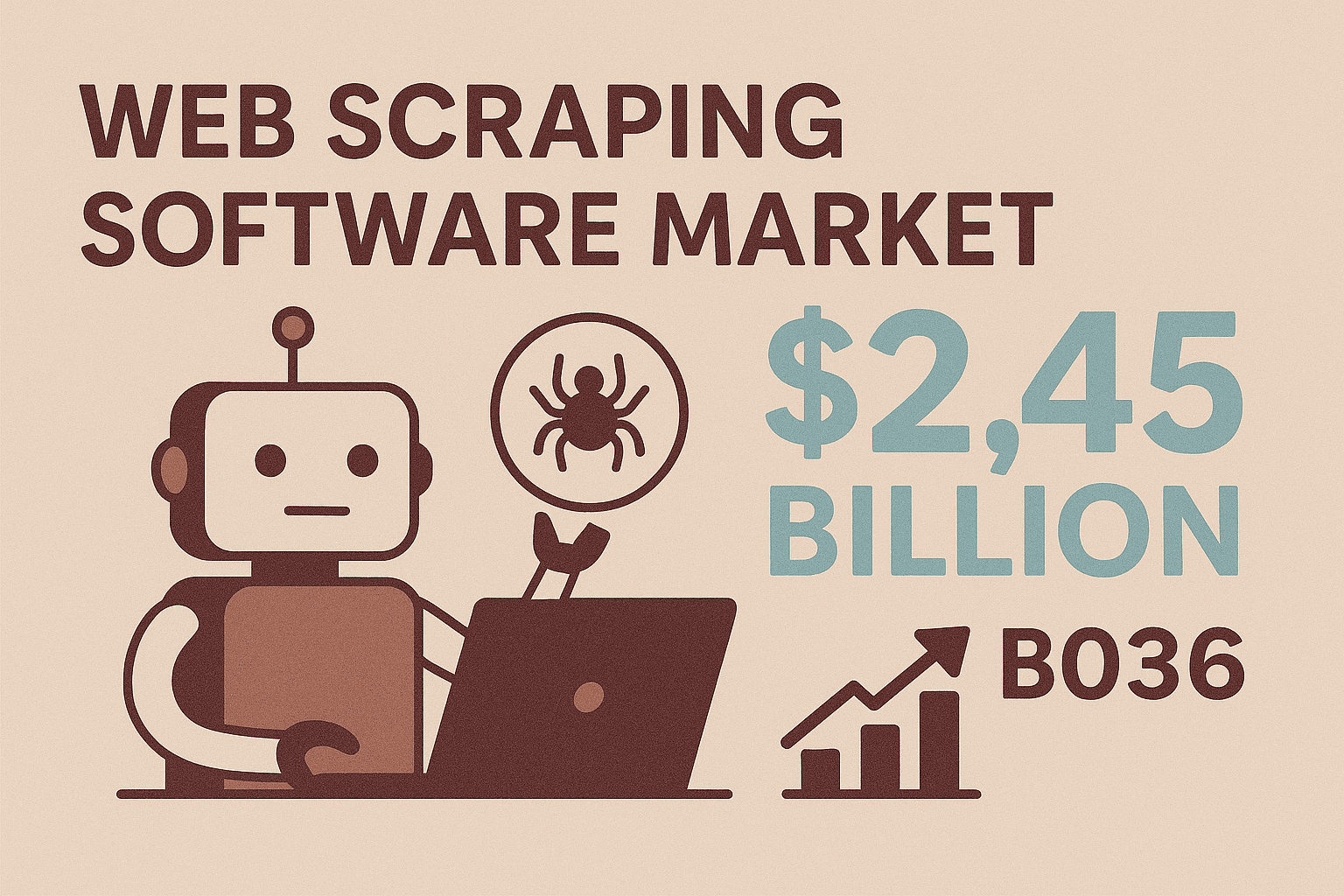

Es gibt kaum etwas Befriedigenderes, als wenn ein Skript blitzschnell durch eine Website surft und dabei Daten einsammelt, während du entspannt deinen Kaffee schlürfst. Die Zeiten, in denen „Screen Scraping“ bedeutete, stundenlang Copy-Paste zu machen oder die IT um einen weiteren Export zu bitten, sind endgültig vorbei. Heute läuft alles über Java Screen Scraping – von der Lead-Generierung im Vertrieb bis zur Preisüberwachung in Echtzeit. Und das Beste: Dafür musst du längst kein Hardcore-Entwickler mehr sein. Angesichts der Prognose, dass der Markt für Web-Scraper bis 2036 auf , ist klar: Unternehmen weltweit suchen nach automatisierten, flexiblen Wegen, um das offene Web in wertvolle Daten zu verwandeln.

Egal, ob du im Vertrieb, Business Development oder in der Entwicklung arbeitest und strukturierte Daten von Websites brauchst – besonders, wenn keine API existiert – Java Screen Scraping ist eine Fähigkeit, die sich wirklich lohnt. In diesem Guide zeige ich dir die Basics, wie du mit beliebten Java-Bibliotheken loslegst, typische Hürden meisterst und wie No-Code-Tools wie deinen Workflow aufs nächste Level bringen. Egal, ob du deinen eigenen Scraper programmieren willst oder lieber KI die Arbeit machen lässt – hier findest du praktische Tipps und erprobte Strategien, um effizienter zu scrapen.

Java Screen Scraping: Was steckt dahinter und warum ist es so wichtig?

Starten wir mit den Grundlagen. Java Screen Scraping heißt, dass du mit Java-Code automatisiert Infos von Webseiten abgreifst – also den Prozess des Lesens und Auslesens von Webinhalten automatisierst. Im Gegensatz zu APIs, die Daten meist schon schön strukturiert liefern (wenn es sie überhaupt gibt), arbeitet Screen Scraping direkt mit der Benutzeroberfläche einer Website – so, wie es ein Mensch im Browser tun würde.

Warum ist das so relevant? Weil die meisten Websites – vor allem im E-Commerce, Immobilienbereich oder in Nischen-B2B-Verzeichnissen – keine öffentlichen APIs oder Exportfunktionen anbieten. Screen Scraping ist dein Schlüssel, um an diese „eingeschlossenen“ Daten zu kommen. Mit Java hast du ein flexibles Werkzeug: Du kannst eigene Regeln schreiben, Logins automatisieren, Buttons klicken und sogar komplexe, dynamische Inhalte auslesen. Deshalb ist Java Screen Scraping oft die erste Wahl, wenn Standard-Tools nicht reichen oder du individuelle Extraktionslogik für dein Unternehmen brauchst.

Und der Bedarf wächst ständig. Unternehmen, die moderne Scraping-Tools (vor allem KI-gestützte Lösungen) nutzen, berichten von bei der Datenerfassung – mit Genauigkeiten von bis zu 99 %. Das heißt: Weniger monotone Handarbeit, mehr Zeit für die wirklich wichtigen Aufgaben.

Typische Business-Anwendungen für Java Screen Scraping

Wo spielt Java Screen Scraping im Geschäftsalltag seine Stärken aus? Hier ein paar der wichtigsten Einsatzbereiche:

| Anwendung | Business-Nutzen | Beispiel-Szenario |

|---|---|---|

| Lead-Generierung | Automatisierte Erfassung von Kontaktdaten, Vertriebs-Pipeline erweitern, Zeit sparen | LinkedIn oder Online-Verzeichnisse nach Namen, Titeln, E-Mails, Telefonnummern durchsuchen |

| Preisüberwachung | Wettbewerberpreise in Echtzeit verfolgen, dynamische Preisgestaltung ermöglichen, Analysten entlasten | E-Commerce-Seiten täglich nach Preisen und Lagerbeständen durchsuchen |

| Produktdaten-Extraktion | Angebote aus verschiedenen Quellen bündeln, Kataloge aktuell halten | Produktnamen, Spezifikationen, Bilder, Bewertungen von Lieferanten- oder Wettbewerbsseiten sammeln |

| Marktforschung | Große, aktuelle Datensätze für Analysen gewinnen | Hunderte Produktbewertungen oder Immobilienanzeigen für Trendanalysen scrapen |

| Wettbewerbsanalyse | Trends erkennen, neue Features beobachten, Stimmungen analysieren | Produktseiten, Kundenrezensionen oder News der Konkurrenz aggregieren |

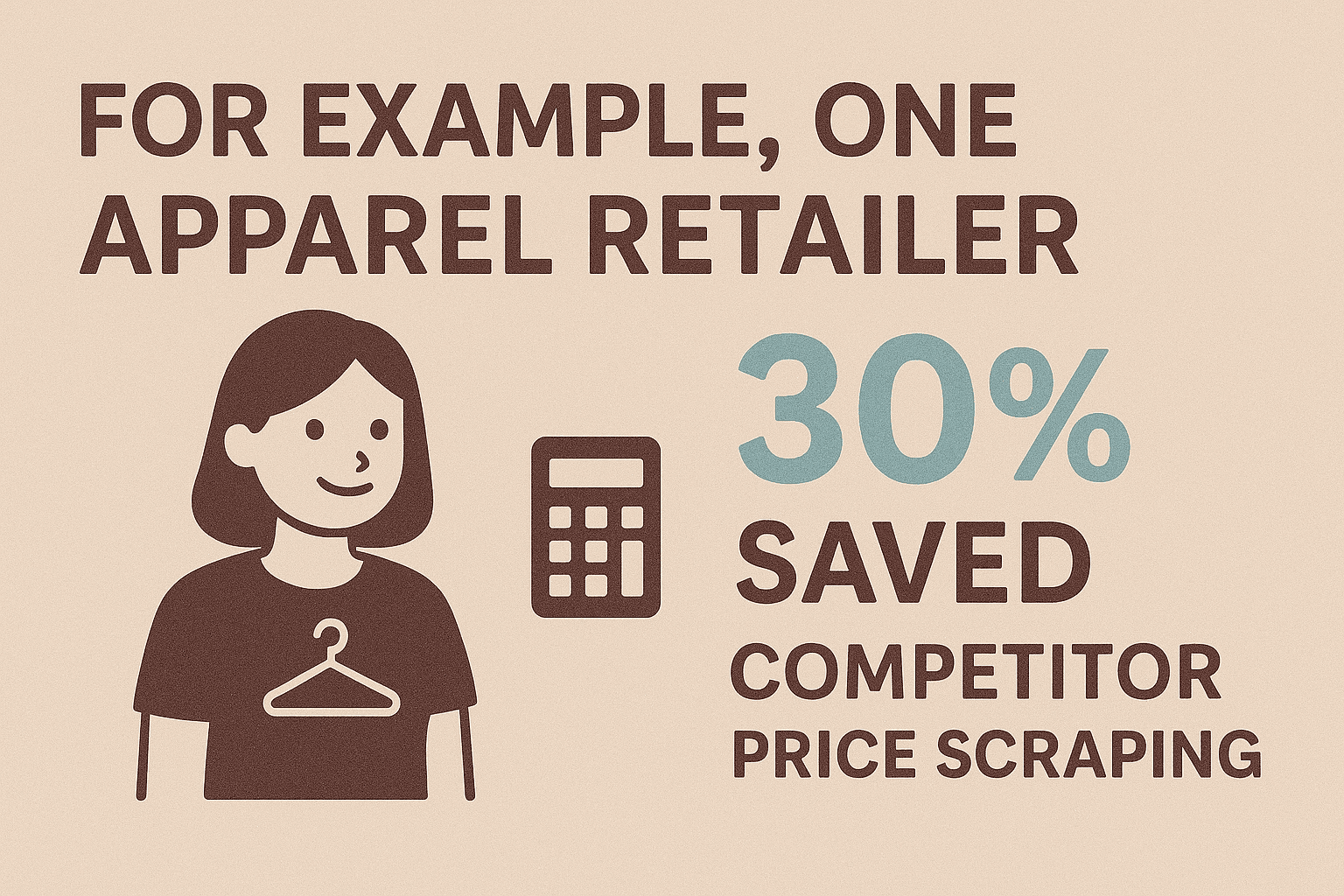

Ein Beispiel: Ein Modehändler, der die Preisüberwachung automatisiert hat, und bekam wertvolle Echtzeit-Einblicke. Vertriebsteams nutzen Scraping, um Lead-Listen zu erstellen, die sonst Wochen dauern würden. Und mit über ist Scraping für E-Commerce-Betreiber ein Muss, um wettbewerbsfähig zu bleiben.

Fazit: Wenn du Webdaten brauchst und keine API vorhanden ist, ist Screen Scraping oft die einzige praktikable Lösung.

Einstieg: Die wichtigsten Tools und Bibliotheken für Java Screen Scraping

Im Java-Ökosystem gibt es viele Bibliotheken, die Screen Scraping auch für Nicht-Profis zugänglich machen. Hier die beliebtesten Optionen:

1. Selenium WebDriver

- Was es kann: Steuert einen echten Browser (z. B. Chrome, Firefox), um mit dynamischen, JavaScript-lastigen Seiten zu interagieren.

- Ideal für: Seiten mit Logins, Klicks oder wenn Nutzerverhalten simuliert werden muss.

- Stärken: Kann alles auslesen, was ein Mensch sieht; ideal für komplexe Abläufe.

- Schwächen: Etwas langsamer und braucht mehr Ressourcen; benötigt Browser-Treiber.

Beispielcode:

1WebDriver driver = new ChromeDriver();

2driver.get("https://example.com/page");

3String title = driver.getTitle();

4System.out.println("Page title: " + title);

5driver.close();2. Jsoup

- Was es kann: Lädt und parst statisches HTML mit einer einfachen, jQuery-ähnlichen API.

- Ideal für: Schnelles Scraping von statischen Seiten, Blogs, News oder Produktlisten.

- Stärken: Schlank, schnell, einfach zu bedienen, kommt auch mit fehlerhaftem HTML klar.

- Schwächen: Kann kein JavaScript ausführen oder AJAX-Inhalte laden.

Beispielcode:

1Document doc = Jsoup.connect("https://example.com/products").get();

2Elements names = doc.select(".product-name");

3for (Element name : names) {

4 System.out.println(name.text());

5}3. HtmlUnit

- Was es kann: Simuliert einen Headless-Browser in Java, kann teilweise JavaScript ausführen.

- Ideal für: Mäßig dynamische Seiten, wenn browserähnliches Verhalten ohne Selenium-Overhead gewünscht ist.

- Stärken: Kein externer Browser nötig; unterstützt HTTP, Cookies und einfache Skripte.

- Schwächen: Nicht so robust wie Selenium bei modernen JS-Frameworks.

Beispielcode:

1WebClient webClient = new WebClient(BrowserVersion.CHROME);

2HtmlPage page = webClient.getPage("https://example.com");

3DomElement button = page.getElementById("next-btn");

4page = button.click();

5String content = page.asText();4. Weitere Tools

- WebMagic, Gecco: High-Level-Frameworks für großflächiges Crawling und Extraktion.

- Htmleasy: Extrem einfach, ideal für schnelle Prototypen, wenn Komplexität keine Rolle spielt.

Vergleich der Java Screen Scraping Bibliotheken

| Bibliothek | Unterstützung dynamischer Inhalte | Bedienkomfort | Idealer Anwendungsfall |

|---|---|---|---|

| Selenium | Ja | Mittel | JS-lastige Seiten, Logins, interaktive Workflows |

| Jsoup | Nein | Einfach | Statische Seiten, schnelles Prototyping |

| HtmlUnit | Teilweise | Mittel | Leichtgewichtiges Headless-Scraping, einfache JS |

| Htmleasy | Nein | Sehr einfach | Einfache, statische Seiten, schnelle Datenerfassung |

| WebMagic/Gecco | Nein (JS) | Mittel | Großflächiges Crawling, Multi-Page-Extraktion |

Schnellstart-Checkliste:

- Wähle die passende Bibliothek (Selenium für dynamische, Jsoup für statische Seiten).

- Richte dein Java-Projekt ein (Abhängigkeiten via Maven/Gradle).

- Inspiziere das HTML der Zielseite mit den DevTools deines Browsers.

- Schreibe einen Test-Scraper, der ein einfaches Element ausliest.

- Entwickle deine Extraktionslogik weiter und denke an Paginierung.

- Exportiere die Daten (z. B. als CSV, JSON oder direkt in eine Datenbank).

Schritt für Schritt: Deinen ersten Java Screen Scraper bauen

Hier ein einfaches Beispiel: Produktnamen und Preise von einer Demo-E-Commerce-Seite mit Jsoup extrahieren.

Schritt 1: Projekt einrichten

Füge Jsoup zu deiner Maven pom.xml hinzu:

1<dependency>

2 <groupId>org.jsoup</groupId>

3 <artifactId>jsoup</artifactId>

4 <version>1.16.1</version>

5</dependency>Schritt 2: Webseite abrufen

1String url = "https://www.scrapingcourse.com/ecommerce/";

2Document doc = Jsoup.connect(url).get();Schritt 3: Daten parsen und extrahieren

1Elements productElements = doc.select("li.product");

2for (Element productEl : productElements) {

3 String name = productEl.selectFirst(".woocommerce-loop-product__title").text();

4 String price = productEl.selectFirst(".price").text();

5 System.out.println(name + " -> " + price);

6}Schritt 4: Paginierung berücksichtigen

1Element nextLink = doc.selectFirst("a.next");

2while (nextLink != null) {

3 String nextUrl = nextLink.absUrl("href");

4 doc = Jsoup.connect(nextUrl).get();

5 // Extraktionslogik wiederholen

6 nextLink = doc.selectFirst("a.next");

7}Schritt 5: Daten exportieren (CSV-Beispiel)

1FileWriter csvWriter = new FileWriter("products.csv");

2csvWriter.append("Product Name,Price\n");

3for (Element productEl : productElements) {

4 String name = ...;

5 String price = ...;

6 csvWriter.append("\"" + name + "\",\"" + price + "\"\n");

7}

8csvWriter.flush();

9csvWriter.close();Oder als JSON:

1List<Product> products = new ArrayList<>();

2// Produkte in der Schleife befüllen

3Gson gson = new Gson();

4String jsonOutput = gson.toJson(products);

5Files.write(Paths.get("products.json"), jsonOutput.getBytes());Datenexport: JSON, CSV und mehr

- CSV: Perfekt für Tabellenkalkulationen, schnelle Analysen oder den Austausch mit anderen Teams.

- JSON: Super für die Weiterverarbeitung in Programmen, APIs oder für verschachtelte Daten.

- Excel: Mit Apache POI kannst du native

.xlsx-Dateien erzeugen. - Datenbank: Über JDBC direkt in eine Datenbank schreiben, wenn du dauerhafte Speicherung brauchst.

Wähle das Format, das am besten zu deinem Workflow passt. Für die meisten Business-Anwendungen sind CSV oder Excel optimal.

Herausforderungen meistern: Typische Probleme beim Java Screen Scraping und Lösungen

Screen Scraping läuft nicht immer reibungslos. Hier die häufigsten Stolpersteine – und wie du sie umgehst:

1. Dynamische Inhalte (JavaScript/AJAX)

- Problem: Daten werden erst nach dem Laden der Seite angezeigt; Jsoup sieht sie nicht.

- Lösung: Nutze Selenium WebDriver, um einen echten Browser zu steuern, oder analysiere die AJAX-Requests und ahme sie in Java nach.

2. Anti-Bot-Maßnahmen

- Problem: Websites blockieren oder drosseln automatisierte Anfragen.

- Lösung: Halte dich an Crawl-Raten, variiere User-Agents, rotiere IPs und simuliere menschliches Verhalten. Bei großem Umfang helfen Proxy-Services oder Stealth-Plugins für Selenium.

3. Änderungen an der Website-Struktur

- Problem: Änderungen im HTML brechen deine Selektoren.

- Lösung: Halte Selektoren zentral im Code, nutze robuste CSS-Klassen oder Datenattribute und logge Fehler für schnelles Debugging. Sei bereit, deinen Scraper bei Bedarf anzupassen.

4. Datenqualität und -bereinigung

- Problem: Uneinheitliche Formate, fehlende Werte oder unstrukturierter Text.

- Lösung: Nutze die String- und Regex-Funktionen von Java, um Daten direkt beim Scraping zu bereinigen. Vereinheitliche Formate (z. B. Telefonnummern, Preise) und gehe mit fehlenden Werten elegant um.

5. Performance und Skalierung

- Problem: Das Scrapen tausender Seiten dauert zu lange.

- Lösung: Nutze die Parallelisierungsmöglichkeiten von Java (ExecutorService, Threadpools), um Anfragen gleichzeitig zu verarbeiten – aber überlaste die Zielseite nicht. Schreibe Ergebnisse direkt in Dateien, um Speicherprobleme zu vermeiden.

Weitere Best Practices findest du im .

Warum Thunderbit die perfekte Ergänzung für Java Screen Scraping ist

Jetzt kommt der entscheidende Punkt: Wartung. Das Schreiben und Aktualisieren von Java-Scrapern kann viel Zeit kosten – vor allem, wenn sich Websites ändern oder neue Anti-Bot-Hürden auftauchen. Genau hier kommt ins Spiel.

Thunderbit ist eine KI-gestützte, No-Code Web-Scraper Chrome-Erweiterung, entwickelt für Business-Anwender, Vertriebsteams, Marketer und alle, die Webdaten automatisiert erfassen möchten – ganz ohne Programmierkenntnisse. Warum ist das auch für Java-Entwickler und Nicht-Programmierer ein echter Gamechanger?

- KI-gestützte Felderkennung: Mit „AI Suggest Fields“ analysiert Thunderbit die Seite und schlägt automatisch die besten Spalten zum Extrahieren vor (z. B. Produktnamen, Preise, E-Mails).

- 2-Klick-Scraping: Ein Klick, um die Daten zu finden, ein weiterer zum Extrahieren. Keine Selektoren, keine Skripte nötig.

- Unterseiten-Scraping: Thunderbit folgt Links (z. B. zu Produktdetailseiten) und reichert deine Tabelle mit weiteren Infos an – ganz ohne manuelles Coden.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, Shopify) gibt es fertige Templates für strukturiertes Scraping auf Knopfdruck.

- Datentyp-Erkennung: Erkennt E-Mails, Telefonnummern, Daten, Bilder und mehr – und exportiert saubere, einsatzbereite Daten.

- No-Code für alle: Jeder im Team kann Thunderbit nutzen – Entwickler werden für wichtigere Aufgaben frei.

- Wartungsfrei: Ändert sich eine Seite, reicht ein Klick auf „AI Suggest Fields“ – Thunderbits KI passt sich automatisch an.

Thunderbit ist ideal für schnelle Projekte, Prototypen oder als Ergänzung zu deinem Java-Workflow, wenn du zügig Daten brauchst und nicht stundenlang coden oder debuggen willst.

Thunderbit und Java kombinieren: So entsteht eine durchgängige Datenpipeline

Die wahre Stärke zeigt sich, wenn du Thunderbits Benutzerfreundlichkeit mit der Power von Java verbindest. So baust du eine robuste End-to-End-Datenpipeline:

- Mit Thunderbit scrapen: Extrahiere die gewünschten Daten mit Thunderbit. Plane regelmäßige Scrapes oder nutze Vorlagen für gängige Websites.

- Daten exportieren: Exportiere die Ergebnisse als CSV, Excel, , Airtable oder Notion – Formate, die Java problemlos einlesen kann.

- Mit Java weiterverarbeiten: Schreibe eine Java-Anwendung, die die exportierten Daten (z. B. via Google Sheets API oder CSV-Import) einliest, bereinigt, anreichert und in deine Systeme (CRM, Datenbank, Analytics) integriert.

- Workflow automatisieren: Lass Thunderbit zu festgelegten Zeiten laufen und starte dein Java-Skript nach jedem Scrape. So läuft deine Datenpipeline vollautomatisch.

Beispiel: Dein Vertriebsteam braucht jeden Montag eine aktuelle Lead-Liste aus einem Branchenverzeichnis. Thunderbit scrapt die Seite und exportiert die Daten nach Google Sheets. Deine Java-App liest die Tabelle, entfernt Dubletten und überträgt neue Kontakte ins CRM. Ändert sich das Layout der Seite, passt du einfach die Thunderbit-Konfiguration an – ohne Java-Code neu zu schreiben.

Mit diesem hybriden Ansatz nutzt du das Beste aus beiden Welten: Thunderbit übernimmt das flexible Web-Scraping, Java sorgt für die Integration und Weiterverarbeitung.

Profi-Tipps: Java Screen Scraping skalieren und automatisieren

Wenn dein Scraping-Bedarf wächst, solltest du auf Skalierung und Automatisierung setzen:

- Parallelisierung: Nutze Java-Threadpools, um mehrere Seiten gleichzeitig zu scrapen – aber begrenze die Anzahl, um Blockierungen zu vermeiden.

- Zeitplanung: Automatisiere Scrapes mit der Quartz-Bibliothek von Java oder nutze Thunderbits integrierten Scheduler (einfach Zeitplan in Klartext beschreiben).

- Fehlerbehandlung: Implementiere Wiederholungen, Timeouts und Benachrichtigungen (z. B. per E-Mail oder Slack) für fehlgeschlagene Durchläufe.

- Cloud-Scraping: Thunderbits Cloud-Modus kann bis zu 50 Seiten gleichzeitig scrapen – ideal für große Jobs, ohne deinen Rechner zu belasten.

- Wartung: Dokumentiere deine Scraper, zentralisiere Selektoren und logge Auffälligkeiten für schnelles Troubleshooting. Mit Thunderbit sind Updates meist nur ein Klick auf „AI Suggest Fields“ entfernt.

Für wirklich große Projekte (Millionen von Seiten) empfehlen sich verteilte Frameworks wie Apache Nutch oder cloudbasierte Scraping-APIs – aber für die meisten Business-Anwendungen reicht die Kombination aus Thunderbit und Java völlig aus.

Fazit & wichtigste Erkenntnisse

Java Screen Scraping ist ein mächtiges Werkzeug, um Webdaten zu erschließen – egal, ob du Lead-Listen erstellst, Wettbewerber beobachtest oder Marktforschung betreibst. Das solltest du mitnehmen:

- Java bietet Flexibilität und Kontrolle für individuelle, komplexe Scraping-Aufgaben – besonders bei Logins, dynamischen Inhalten oder spezifischer Business-Logik.

- Thunderbit bringt KI-gestützte No-Code-Effizienz ins Web Scraping und macht es für jeden zugänglich – die Einrichtung dauert nur Minuten statt Stunden.

- Die Kombination beider Ansätze ermöglicht schnelle, robuste Datenpipelines: Mit Thunderbit scrapen, mit Java weiterverarbeiten und integrieren.

- Automatisiere und skaliere mit Parallelisierung, Zeitplanung und Cloud-Scraping – ohne Wartungsaufwand.

- Die Zukunft ist hybrid: Je smarter KI-Tools wie Thunderbit werden, desto mehr verschmelzen Code- und No-Code-Lösungen für maximale Effizienz.

Bereit, deine Datenerfassung aufs nächste Level zu bringen? , bau deinen ersten Java-Scraper und erlebe, wie viel Zeit (und Nerven) du sparen kannst. Weitere Tipps und Deep Dives findest du im .

Häufige Fragen (FAQ)

1. Was ist Java Screen Scraping und wie unterscheidet es sich von Web Scraping?

Java Screen Scraping meint das Extrahieren von Daten direkt aus der Benutzeroberfläche einer Website mit Java-Code – besonders, wenn keine API verfügbar ist. Es ist eine Form von Web Scraping, bei der der Fokus darauf liegt, Daten so zu erfassen, wie sie ein Nutzer im Browser sieht, statt aus strukturierten Backend-Quellen.

2. Wann sollte ich Java für Screen Scraping statt eines No-Code-Tools nutzen?

Java empfiehlt sich, wenn du individuelle Logik brauchst, komplexe Logins abbilden, mit dynamischen Inhalten interagieren oder Scraping eng mit deinen Business-Systemen verzahnen willst. No-Code-Tools wie Thunderbit sind ideal für schnelle Aufgaben, Prototypen oder um Nicht-Entwicklern das Scraping zu ermöglichen.

3. Was sind die häufigsten Herausforderungen beim Java Screen Scraping und wie löse ich sie?

Typische Probleme sind dynamische Inhalte (lösen mit Selenium), Anti-Bot-Maßnahmen (Delays, Proxies, realistische Header), Änderungen an der Seitenstruktur (Selektoren zentralisieren) und Datenbereinigung (Java-String- und Regex-Tools nutzen). Für große Projekte: Parallelisierung und robuste Fehlerbehandlung einsetzen.

4. Wie ergänzt Thunderbit das Java Screen Scraping?

Thunderbits KI-gestützte Chrome-Erweiterung macht es einfach, Daten von jeder Website zu extrahieren – ganz ohne Code. Perfekt für schnelle Aufgaben, Prototypen oder als Ergänzung zum Java-Workflow, wenn du Zeit sparen oder Wartungsaufwand vermeiden willst. Du kannst die Daten in Formate exportieren, die Java weiterverarbeiten kann – für eine nahtlose Pipeline.

5. Kann ich mit Thunderbit und Java eine komplette Datenpipeline automatisieren?

Definitiv! Plane wiederkehrende Scrapes mit Thunderbit, exportiere die Ergebnisse nach Google Sheets oder CSV und nutze eine Java-App, um die Daten abzurufen, zu verarbeiten und zu integrieren. Dieser hybride Ansatz vereint die Geschwindigkeit und Flexibilität von Thunderbit mit der Power und Anpassbarkeit von Java.