Das Internet im Jahr 2025 gleicht einem echten Dschungel – mehr als die Hälfte des gesamten Traffics stammt mittlerweile nicht mehr von echten Menschen. Richtig gelesen: Über 50 % des Webverkehrs wird heute von Bots und Crawlern erzeugt (). Und nur ein kleiner Teil davon sind die „guten“ Bots, die du wirklich auf deiner Seite haben willst: Suchmaschinen, Social-Media-Previewer und Analyse-Tools. Der Rest? Nicht immer zu deinem Vorteil unterwegs. Nach Jahren in der Entwicklung von Automatisierungs- und KI-Lösungen bei weiß ich aus erster Hand, wie entscheidend der richtige (oder falsche) Crawler für SEO, Statistiken, Bandbreite oder sogar die Sicherheit deiner Seite sein kann.

Egal, ob du ein Unternehmen leitest, eine Website betreust oder einfach deine digitale Infrastruktur schützen willst – zu wissen, wer an deine Server-Tür klopft, ist wichtiger denn je. Deshalb habe ich diesen Guide für 2025 zusammengestellt: Die wichtigsten Crawler, ihre Aufgaben, wie du sie erkennst und wie du deine Seite für die guten Bots offenhältst, während du die schädlichen draußen lässt.

Was macht einen Crawler „bekannt“? User-Agent, IPs und Verifizierung

Starten wir mit den Basics: Was ist eigentlich ein „bekannter“ Crawler? Kurz gesagt: Ein Bot, der sich mit einer klaren User-Agent-Kennung (wie Googlebot/2.1 oder bingbot/2.0) ausweist und idealerweise von veröffentlichten IP-Bereichen oder ASN-Blöcken aus arbeitet, die du überprüfen kannst (). Die großen Anbieter – Google, Microsoft, Baidu, Yandex, DuckDuckGo – veröffentlichen Dokumentationen zu ihren Bots und stellen oft Tools oder JSON-Dateien mit offiziellen IPs bereit (, , ).

Aber Vorsicht: Sich nur auf den User-Agent zu verlassen, ist riskant. Viele schädliche Bots geben sich als Googlebot oder Bingbot aus, um deine Schutzmechanismen zu umgehen (). Deshalb gilt: Doppelte Verifizierung ist der Goldstandard – prüfe sowohl User-Agent als auch IP-Adresse (oder ASN), zum Beispiel per Reverse-DNS oder anhand veröffentlichter Listen. Mit Tools wie kannst du diesen Prozess automatisieren: Logs auslesen, User-Agents abgleichen, IPs gegenprüfen – so bekommst du eine aktuelle, verlässliche Übersicht aller Crawler auf deiner Seite.

Wie du diese Crawler-Liste praktisch nutzt

Was bringt dir eine Liste bekannter Crawler? Hier meine Tipps für den Alltag:

- Allowlisting: Stelle sicher, dass gewünschte Bots (Suchmaschinen, Social-Media-Previewer) nie versehentlich durch Firewall, CDN oder WAF blockiert werden. Nutze offizielle IPs und User-Agents für präzises Allowlisting.

- Analytics-Filter: Filtere Bot-Traffic aus deinen Statistiken, damit du echte Besucherzahlen siehst – und nicht nur Googlebot und AhrefsBot, die deine Seite durchforsten ().

- Bot-Management: Lege Crawl-Delay- oder Drosselungsregeln für aggressive SEO-Tools fest und blockiere oder fordere unbekannte oder schädliche Bots heraus.

- Automatisierte Log-Analyse: Nutze KI-Tools (wie Thunderbit), um Crawler-Aktivitäten in deinen Logs zu extrahieren, zu klassifizieren und zu kennzeichnen. So erkennst du Trends, entlarvst Fakes und hältst deine Regeln aktuell.

Eine aktuelle Crawler-Liste ist keine einmalige Sache. Neue Bots tauchen auf, alte ändern ihr Verhalten, Angreifer werden immer raffinierter. Automatisierte Updates – etwa durch Scraping offizieller Dokumentationen oder GitHub-Repos mit Thunderbit – sparen Zeit und Nerven.

1. Thunderbit: KI-gestützte Crawler-Erkennung und Datenmanagement

ist viel mehr als ein KI-Web-Scraper – es ist dein smarter Datenassistent, wenn du Crawler-Traffic verstehen und steuern willst. Das macht Thunderbit besonders:

- Semantische Vorverarbeitung: Bevor Daten extrahiert werden, wandelt Thunderbit Webseiten und Logs in strukturierte Inhalte im Markdown-Stil um. Diese semantische Vorverarbeitung ermöglicht es der KI, Kontext, Felder und Logik wirklich zu erfassen – ein klarer Vorteil bei komplexen, dynamischen oder JavaScript-lastigen Seiten (wie dem Facebook Marketplace oder langen Kommentarspalten), wo klassische Web-Scraper oft scheitern.

- Doppelte Verifizierung: Thunderbit sammelt offizielle Crawler-IP-Dokumente und ASN-Listen und gleicht sie mit deinen Server-Logs ab. Das Ergebnis: Eine „vertrauenswürdige Crawler-Allowlist“, auf die du dich verlassen kannst – ohne mühsames manuelles Abgleichen.

- Automatisierte Log-Extraktion: Gib Thunderbit deine Roh-Logs, und du bekommst strukturierte Tabellen (Excel, Sheets, Airtable), in denen häufige Besucher, verdächtige Pfade und bekannte Bots markiert sind. Die Ergebnisse kannst du direkt an deine WAF oder dein CDN weiterleiten, um automatisiert zu blockieren, zu drosseln oder CAPTCHAs auszulösen.

- Compliance und Audit: Thunderbits semantische Extraktion sorgt für eine klare Nachvollziehbarkeit – wer hat wann worauf zugegriffen und wie wurde reagiert? Das ist ein großer Pluspunkt für DSGVO, CCPA und andere Compliance-Anforderungen.

Teams konnten mit Thunderbit ihren Aufwand für Crawler-Management um bis zu 80 % reduzieren – und endlich klar erkennen, welche Bots nützlich sind, welche schaden und welche nur vortäuschen.

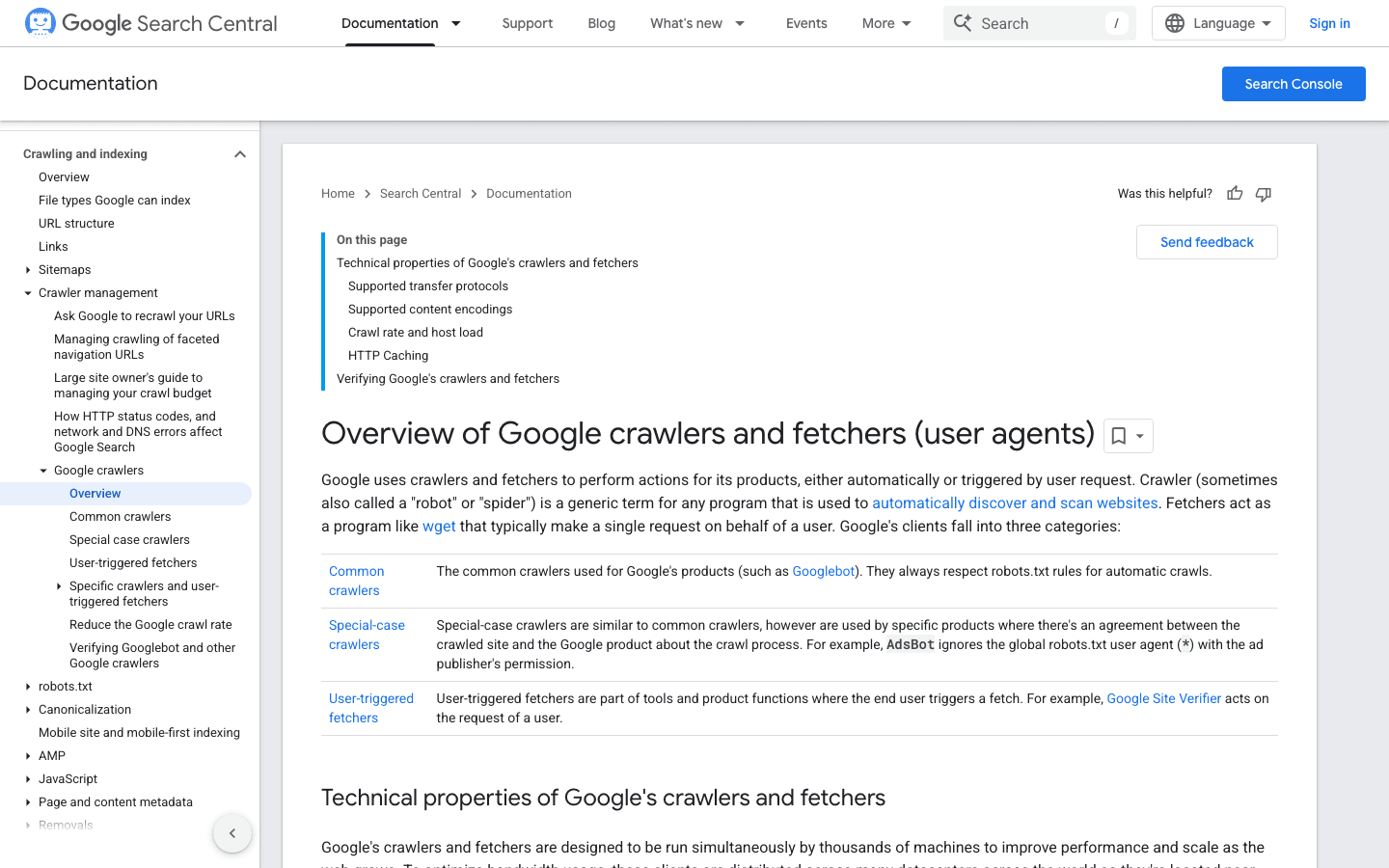

2. Googlebot: Der Standard unter den Suchmaschinen-Crawlern

ist der Maßstab für Web-Scraper. Er sorgt dafür, dass deine Seite bei Google gefunden wird – blockierst du ihn, ist deine Website praktisch unsichtbar.

- User-Agent:

Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html) - Verifizierung: Nutze oder die .

- Management-Tipps: Googlebot immer zulassen. Steuere das Crawling über robots.txt (nicht blockieren!) und passe die Crawl-Rate bei Bedarf in der Google Search Console an.

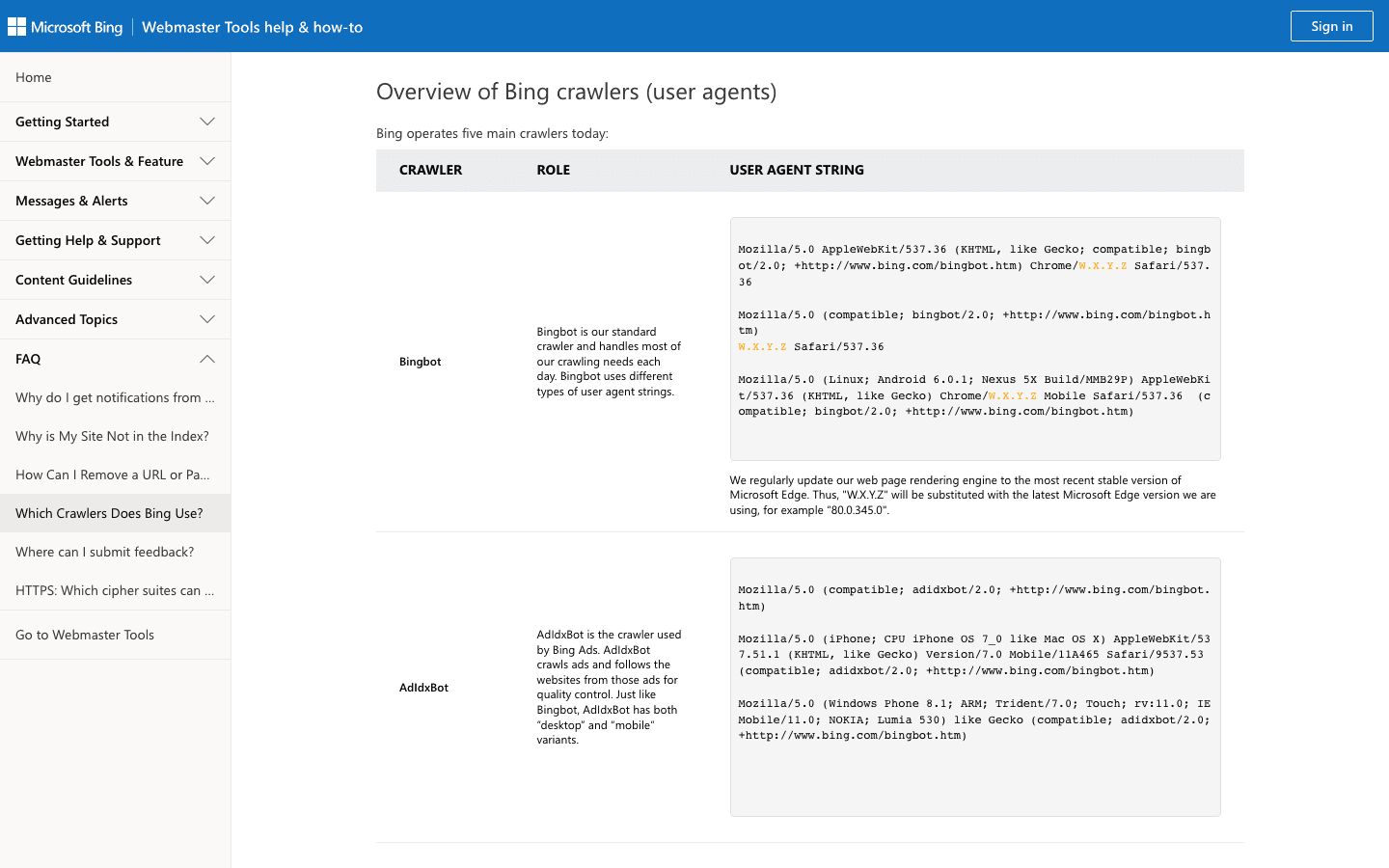

3. Bingbot: Microsofts Web-Explorer

ist für Bing- und Yahoo-Suchergebnisse zuständig und für viele Seiten die zweitwichtigste Suchmaschine.

- User-Agent:

Mozilla/5.0 (compatible; bingbot/2.0; +http://www.bing.com/bingbot.htm) - Verifizierung: Nutze und die .

- Management-Tipps: Bingbot zulassen, Crawl-Rate in den Bing Webmaster Tools steuern und robots.txt für Feineinstellungen nutzen.

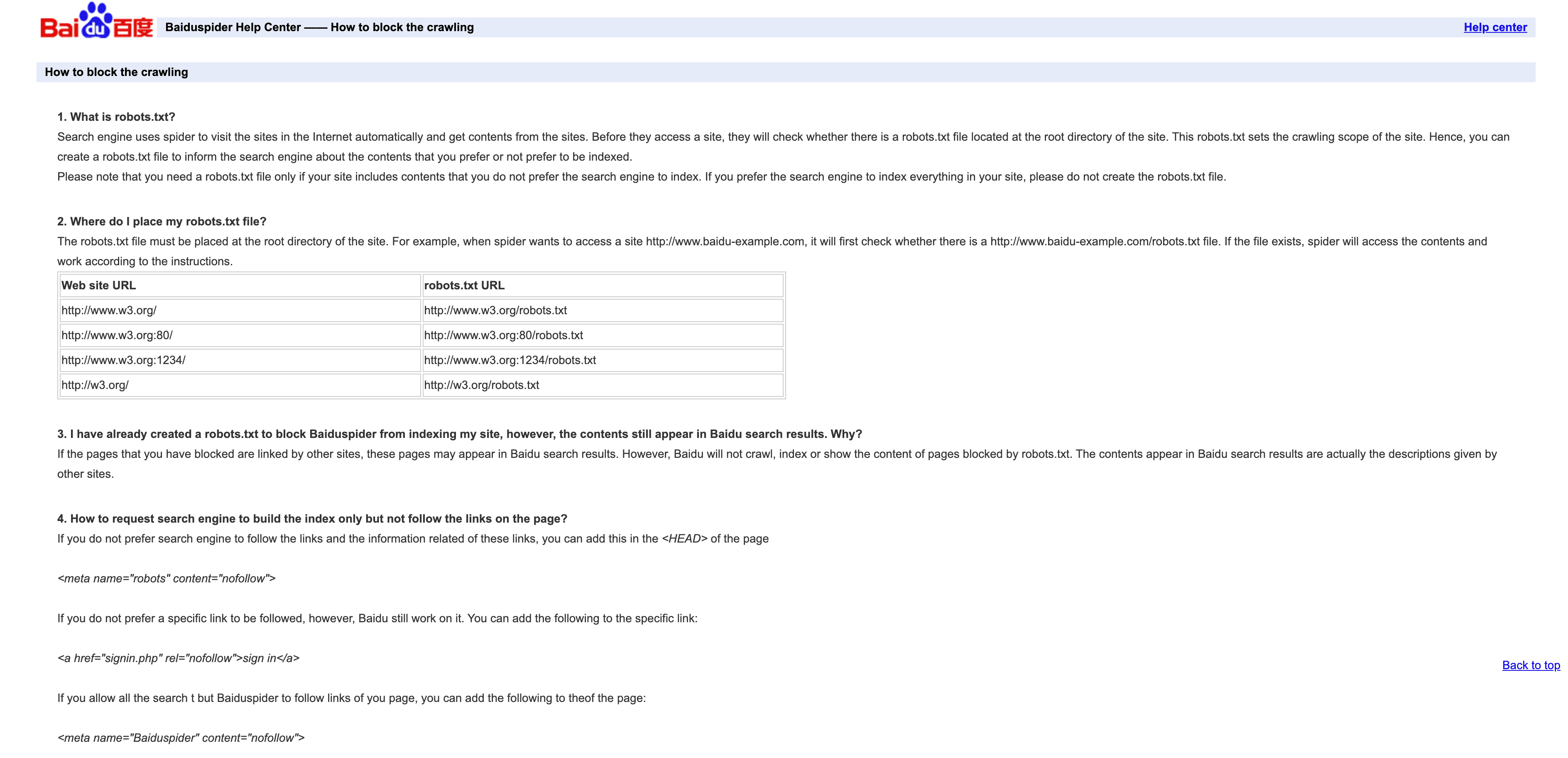

4. Baiduspider: Chinas führender Suchmaschinen-Crawler

ist das Tor zu Suchanfragen aus China.

- User-Agent:

Mozilla/5.0 (compatible; Baiduspider/2.0; +http://www.baidu.com/search/spider.html) - Verifizierung: Keine offizielle IP-Liste; prüfe auf

.baidu.comim Reverse-DNS, aber beachte die Einschränkungen. - Management-Tipps: Zulassen, wenn du chinesische Nutzer ansprechen willst. Regeln per robots.txt setzen, aber Baiduspider ignoriert diese manchmal. Wenn du kein Interesse an chinesischem SEO hast, drossle oder blockiere den Bot, um Bandbreite zu sparen.

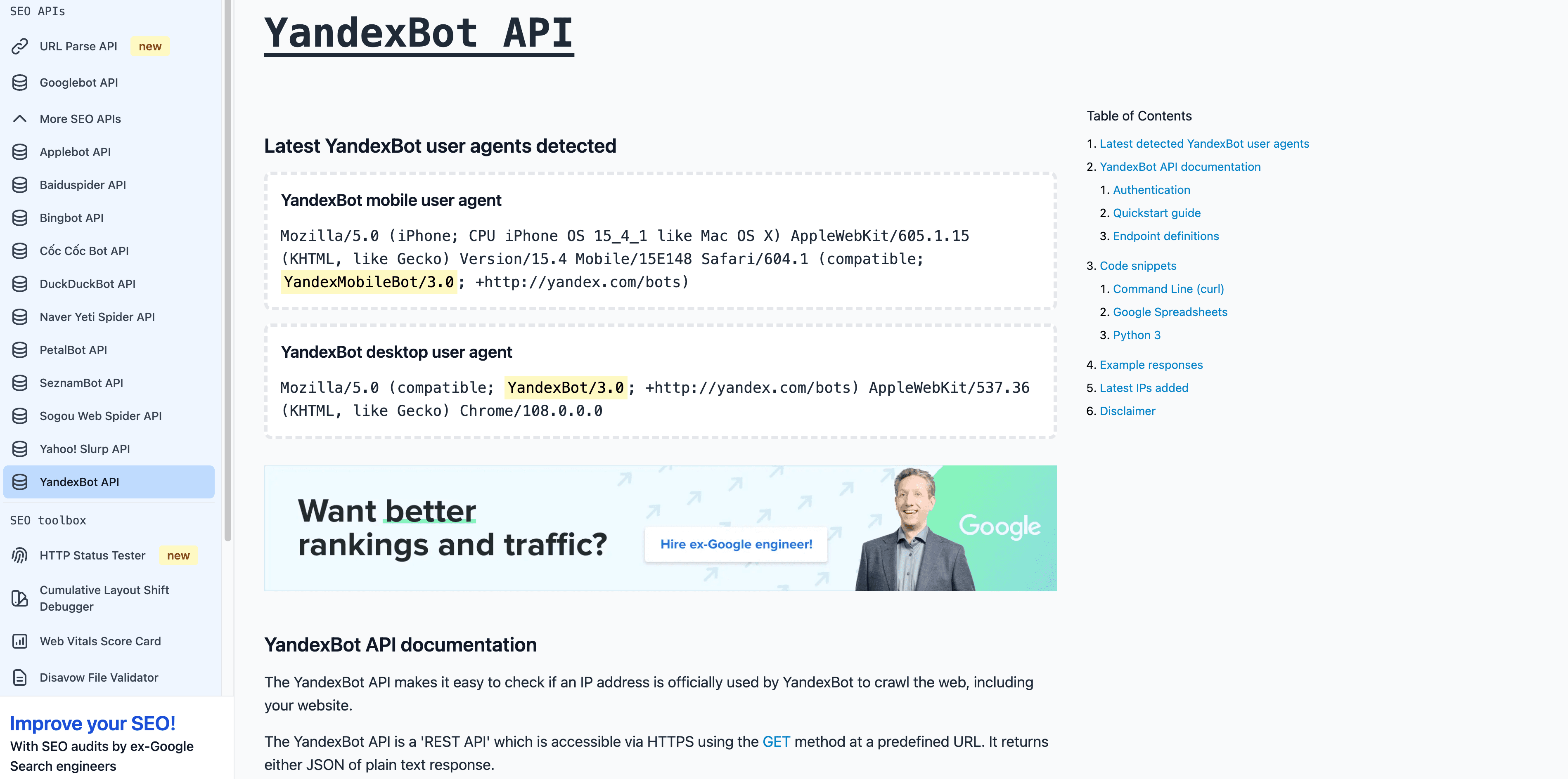

5. YandexBot: Russlands Suchmaschinen-Crawler

ist für den russischen und GUS-Markt unverzichtbar.

- User-Agent:

Mozilla/5.0 (compatible; YandexBot/3.0; +http://yandex.com/bots) - Verifizierung: Reverse-DNS sollte auf

.yandex.ru,.yandex.netoder.yandex.comenden. - Management-Tipps: Zulassen, wenn du russischsprachige Nutzer ansprechen willst. Crawl-Steuerung über Yandex Webmaster.

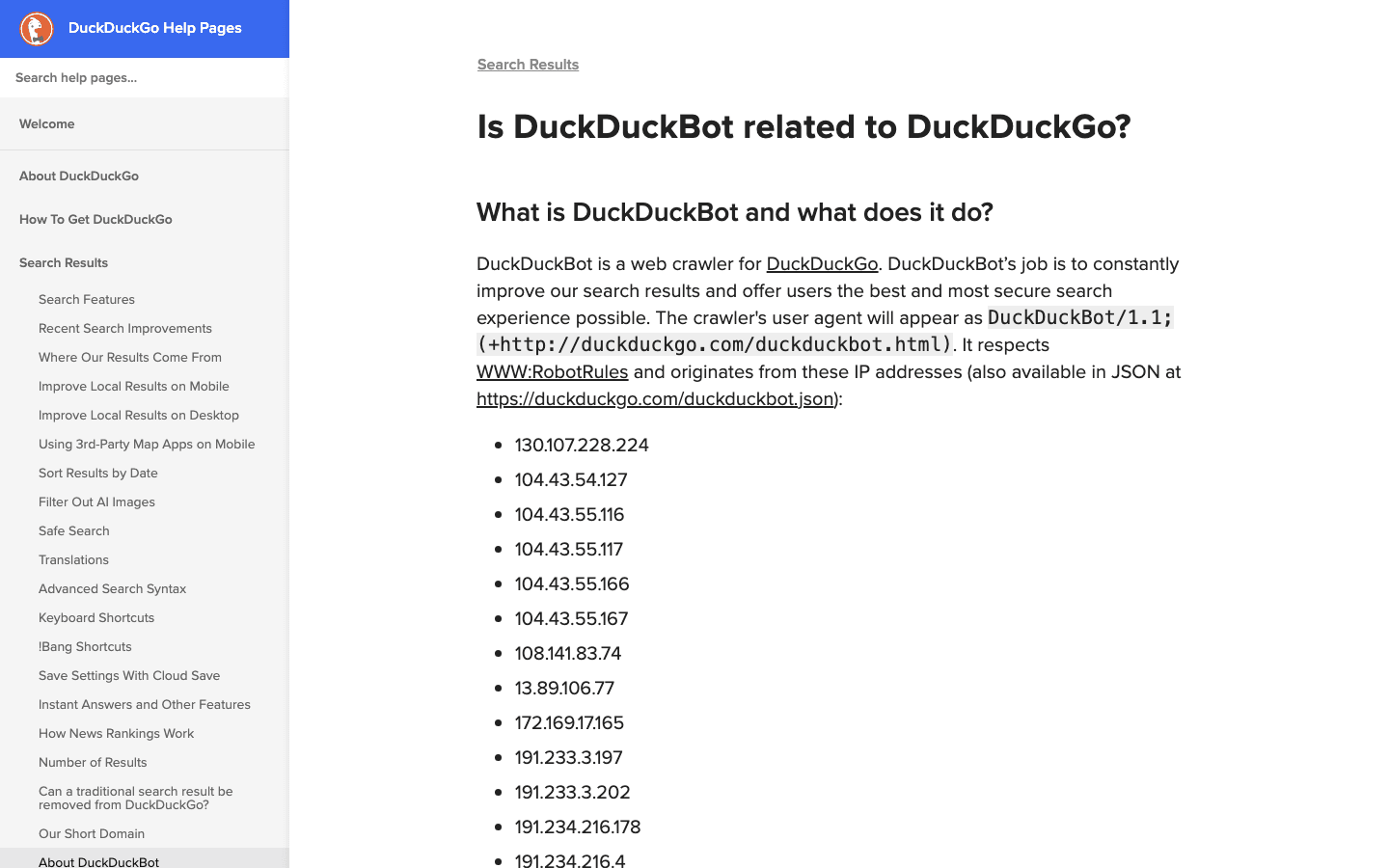

6. DuckDuckBot: Such-Crawler mit Datenschutzfokus

ist der Crawler von DuckDuckGo, der datenschutzorientierten Suchmaschine.

- User-Agent:

DuckDuckBot/1.1; (+http://duckduckgo.com/duckduckbot.html) - Verifizierung: .

- Management-Tipps: Zulassen, außer du hast keinerlei Interesse an datenschutzbewussten Nutzern. Geringe Crawllast, einfach zu verwalten.

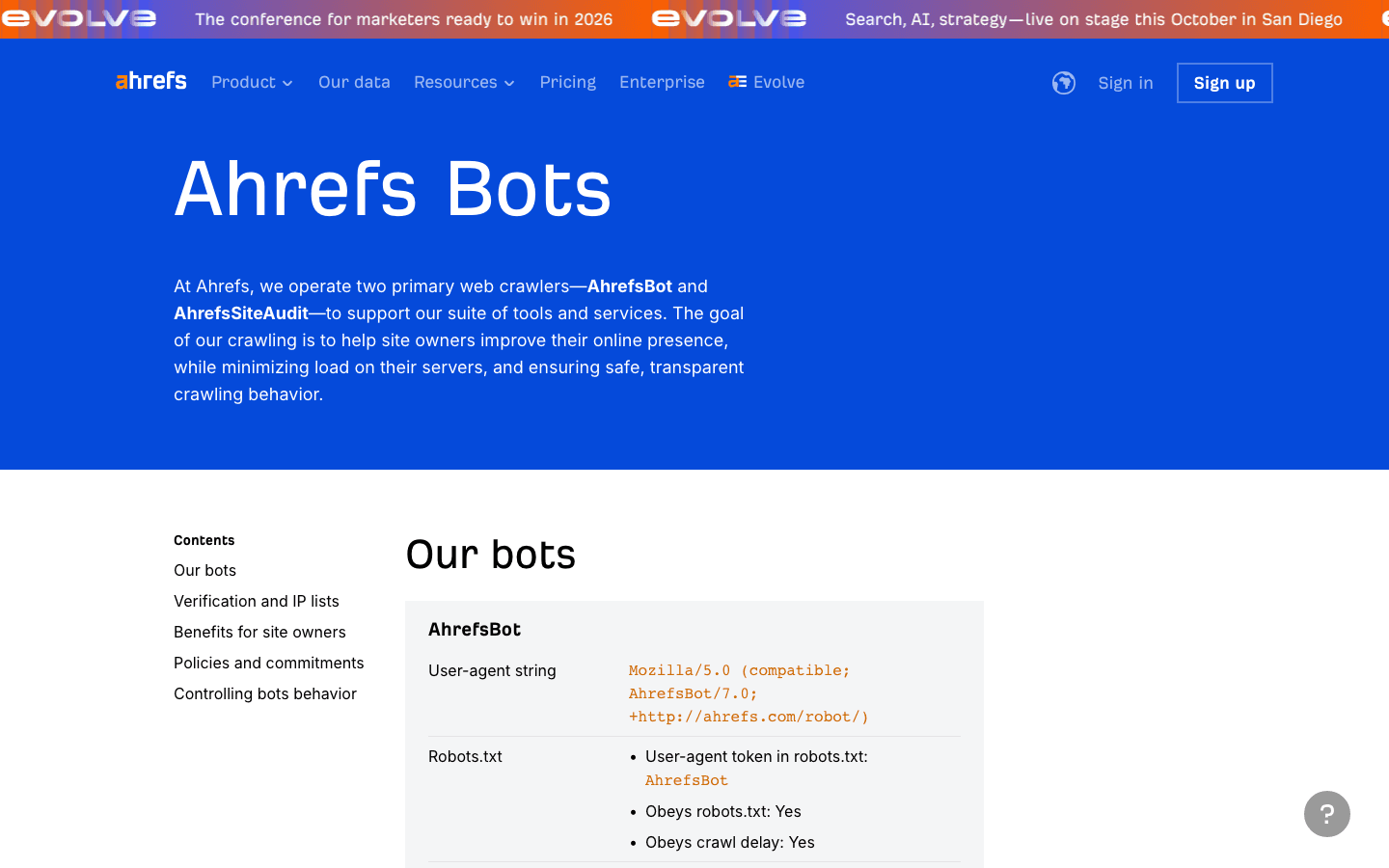

7. AhrefsBot: SEO- und Backlink-Analyse

ist ein führender SEO-Tool-Crawler – ideal für Backlink-Analysen, kann aber viel Bandbreite beanspruchen.

- User-Agent:

Mozilla/5.0 (compatible; AhrefsBot/7.0; +http://ahrefs.com/robot/) - Verifizierung: Keine öffentliche IP-Liste; Verifizierung per User-Agent und Reverse-DNS.

- Management-Tipps: Zulassen, wenn du Ahrefs nutzt. Crawl-Delay oder Blockierung per robots.txt. .

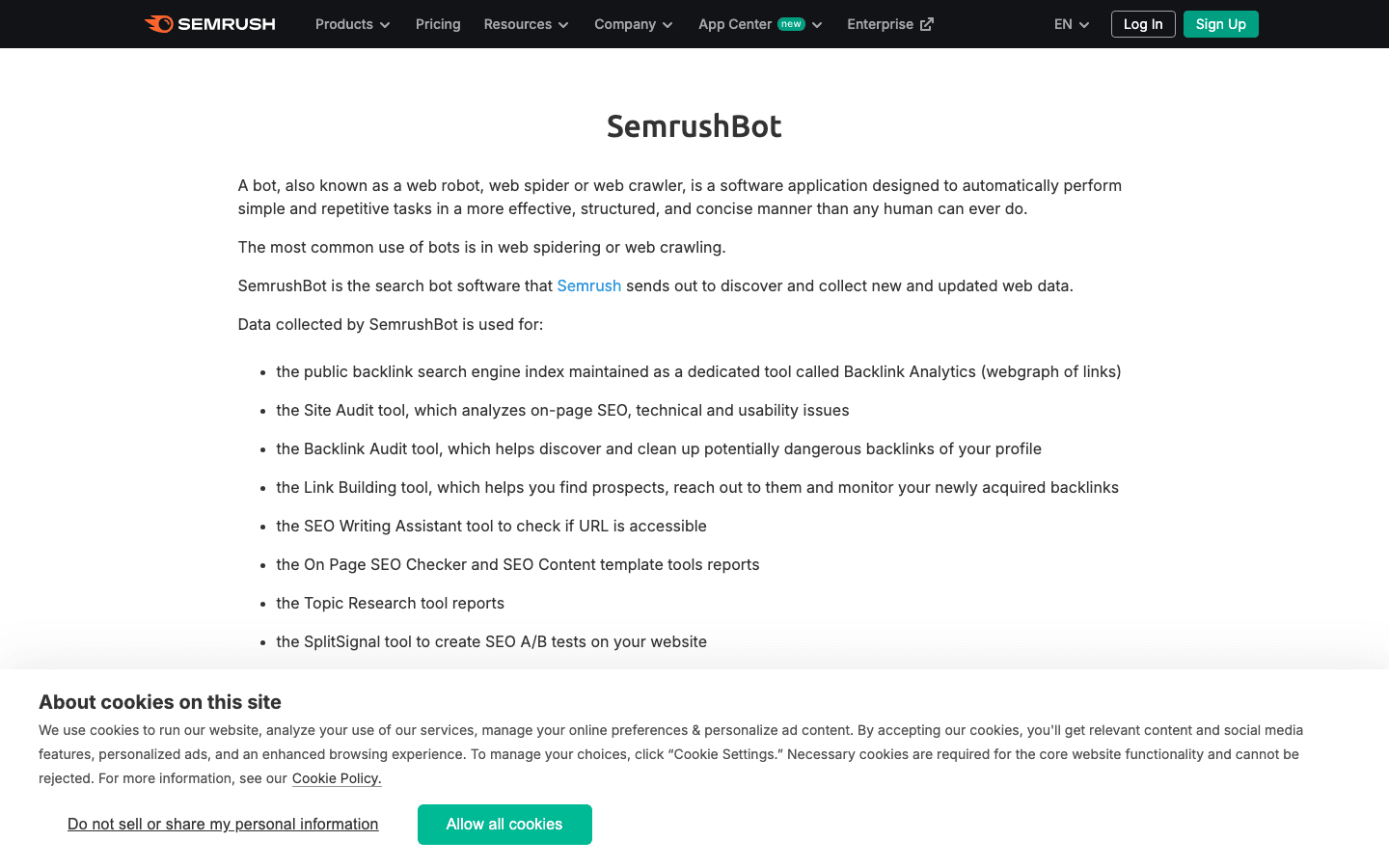

8. SemrushBot: Wettbewerbsanalyse für SEO

ist ein weiterer bedeutender SEO-Crawler.

- User-Agent:

Mozilla/5.0 (compatible; SemrushBot/1.0; +http://www.semrush.com/bot.html)(plus Varianten wieSemrushBot-BA,SemrushBot-SIusw.) - Verifizierung: Über User-Agent; keine öffentliche IP-Liste.

- Management-Tipps: Zulassen, wenn du Semrush nutzt, sonst per robots.txt oder Serverregeln drosseln oder blockieren.

9. FacebookExternalHit: Social-Media-Preview-Bot

holt Open-Graph-Daten für Facebook- und Instagram-Linkvorschauen.

- User-Agent:

facebookexternalhit/1.1 (+http://www.facebook.com/externalhit_uatext.php) - Verifizierung: Über User-Agent; IPs gehören zu Facebooks ASN.

- Management-Tipps: Zulassen für ansprechende Social-Previews. Blockieren bedeutet keine Vorschaubilder oder Zusammenfassungen auf Facebook/Instagram.

10. Twitterbot: X (Twitter) Link-Preview-Crawler

holt Twitter Card-Daten für X (Twitter).

- User-Agent:

Twitterbot/1.0 - Verifizierung: Über User-Agent; Twitter ASN (AS13414).

- Management-Tipps: Zulassen für Twitter-Previews. Nutze Twitter Card-Meta-Tags für optimale Darstellung.

Vergleichstabelle: Crawler im Überblick

| Crawler | Zweck | User-Agent-Beispiel | Verifizierungsmethode | Business Impact | Management-Tipps |

|---|---|---|---|---|---|

| Thunderbit | KI-Log-/Crawler-Analyse | N/A (Tool, kein Bot) | N/A | Datenmanagement, Bot-Klassifizierung | Für Log-Extraktion, Allowlist-Building nutzen |

| Googlebot | Google-Suche-Indexierung | Googlebot/2.1 | DNS & IP-Liste | Kritisch für SEO | Immer zulassen, über Search Console steuern |

| Bingbot | Bing/Yahoo-Suche | bingbot/2.0 | DNS & IP-Liste | Wichtig für Bing/Yahoo-SEO | Zulassen, über Bing Webmaster Tools steuern |

| Baiduspider | Baidu-Suche (China) | Baiduspider/2.0 | Reverse DNS, UA-String | Wichtig für China-SEO | Zulassen bei China-Zielgruppe, Bandbreite überwachen |

| YandexBot | Yandex-Suche (Russland) | YandexBot/3.0 | Reverse DNS auf .yandex.ru | Wichtig für Russland/Osteuropa | Zulassen bei RU/CIS-Zielgruppe, Yandex-Tools nutzen |

| DuckDuckBot | DuckDuckGo-Suche | DuckDuckBot/1.1 | Offizielle IP-Liste | Datenschutzorientiertes Publikum | Zulassen, geringe Auswirkung |

| AhrefsBot | SEO-/Backlink-Analyse | AhrefsBot/7.0 | UA-String, Reverse DNS | SEO-Tool, kann Bandbreite beanspruchen | Zulassen/drosseln/blockieren via robots.txt |

| SemrushBot | SEO-/Wettbewerbsanalyse | SemrushBot/1.0 (plus Varianten) | UA-String | SEO-Tool, kann aggressiv sein | Zulassen/drosseln/blockieren via robots.txt |

| FacebookExternalHit | Social-Link-Previews | facebookexternalhit/1.1 | UA-String, Facebook ASN | Social-Media-Engagement | Für Previews zulassen, OG-Tags nutzen |

| Twitterbot | Twitter-Link-Previews | Twitterbot/1.0 | UA-String, Twitter ASN | Twitter-Engagement | Für Previews zulassen, Twitter Card-Tags nutzen |

Crawler-Liste verwalten: Best Practices für 2025

- Regelmäßig aktualisieren: Die Crawler-Landschaft ändert sich schnell. Plane vierteljährliche Checks ein und nutze Tools wie Thunderbit, um offizielle Listen zu scrapen und zu vergleichen ().

- Verifizieren, nicht blind vertrauen: Prüfe immer User-Agent und IP/ASN. Lass keine Fakes durch, die deine Statistiken verfälschen oder Daten abgreifen ().

- Gute Bots auf die Allowlist setzen: Such- und Social-Crawler dürfen nie durch Anti-Bot-Regeln oder Firewalls blockiert werden.

- Aggressive Bots drosseln oder blockieren: Nutze robots.txt, Crawl-Delay oder Serverregeln für SEO-Tools, die zu viele Anfragen stellen.

- Log-Analyse automatisieren: Setze KI-gestützte Tools (wie Thunderbit) ein, um Crawler-Aktivitäten zu extrahieren, zu klassifizieren und zu kennzeichnen – das spart Zeit und deckt Trends auf.

- SEO, Analytics und Sicherheit ausbalancieren: Blockiere nicht die Bots, die dein Geschäft voranbringen, aber lass schädliche Bots nicht gewähren.

Fazit: Deine Crawler-Liste aktuell und nutzbar halten

Im Jahr 2025 ist das Management deiner Crawler-Liste keine reine IT-Aufgabe mehr – es ist geschäftskritisch und betrifft SEO, Analytics, Sicherheit und Compliance. Da Bots inzwischen den Großteil des Web-Traffics ausmachen, musst du wissen, wer deine Seite besucht, warum und wie du darauf reagierst. Halte deine Liste aktuell, automatisiere wo möglich und nutze Tools wie , um immer einen Schritt voraus zu sein. Das Web wird immer geschäftiger – und eine smarte, umsetzbare Crawler-Strategie ist dein bester Schutz (und Vorteil) in der Welt der Bots.

FAQs

1. Warum ist es wichtig, eine aktuelle Crawler-Liste zu pflegen?

Weil Bots inzwischen mehr als die Hälfte des Web-Traffics ausmachen und nur ein kleiner Teil davon nützlich ist. Eine aktuelle Liste stellt sicher, dass du die guten Bots (für SEO und Social-Previews) zulässt und die schädlichen blockierst oder drosselst – so schützt du deine Statistiken, Bandbreite und Datensicherheit.

2. Wie erkenne ich, ob ein Crawler echt oder gefälscht ist?

Verlass dich nicht nur auf den User-Agent – prüfe immer die IP-Adresse oder das ASN anhand offizieller Listen oder per Reverse-DNS. Tools wie Thunderbit automatisieren diesen Abgleich und vergleichen Logs mit veröffentlichten Bot-IPs und User-Agents.

3. Was tun, wenn ein unbekannter Bot meine Seite crawlt?

Untersuche User-Agent und IP. Wenn der Bot nicht auf deiner Allowlist steht und keiner bekannten Signatur entspricht, solltest du ihn drosseln, herausfordern oder blockieren. Nutze KI-Tools, um neue Crawler zu klassifizieren und zu überwachen.

4. Wie unterstützt Thunderbit beim Crawler-Management?

Thunderbit nutzt KI, um Crawler-Aktivitäten aus Logs zu extrahieren, zu strukturieren und zu klassifizieren. So kannst du Allowlists erstellen, Fakes erkennen und Richtlinien automatisiert durchsetzen. Die semantische Vorverarbeitung ist besonders robust bei komplexen oder dynamischen Seiten.

5. Was passiert, wenn ich einen wichtigen Crawler wie Googlebot oder Bingbot blockiere?

Wenn du Suchmaschinen-Crawler blockierst, verschwindet deine Seite aus den Suchergebnissen – dein organischer Traffic bricht ein. Prüfe daher immer Firewall, robots.txt und Anti-Bot-Regeln, damit du die wichtigsten Bots nicht versehentlich aussperrst.

Mehr erfahren: