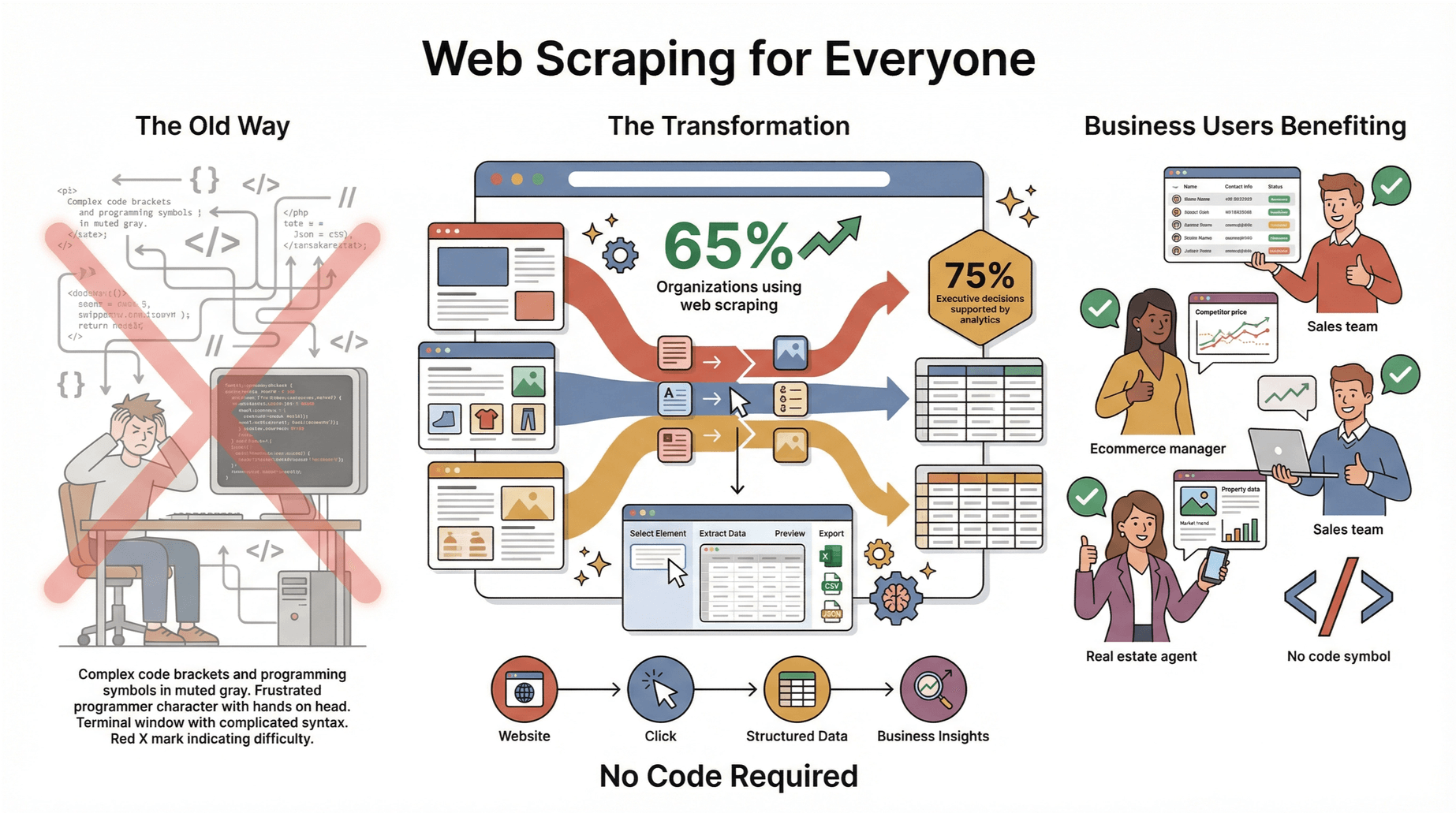

Web Scraping klang früher wie ein Geheimcode für Nerds oder echte IT-Profis – fast so, als bräuchte man einen geheimen Handschlag, um dazuzugehören. Aber 2025 ist das längst vorbei: Web Scraping ist zu einer echten Alltags-Skill geworden, die jeder nutzen kann, um smartere Entscheidungen zu treffen, Zeit zu sparen oder sich das ewige Copy-Paste zu ersparen. Ich habe selbst gesehen, wie Vertriebler, E-Commerce-Manager und sogar Makler mit Web-Scraping-Tools Lead-Listen bauen, Wettbewerber beobachten und wertvolle Insights gewinnen – und das alles ohne eine Zeile Code.

Die Zahlen sprechen Bände: setzen Web Scraping inzwischen für alles Mögliche ein – von KI-Projekten bis zum Tagesgeschäft. Und werden dieses Jahr durch Analysen und Automatisierung unterstützt. Das Beste daran? Mit Tools wie ist Web Scraping heute auch für absolute Anfänger easy zugänglich. Wenn du das Internet zu deiner persönlichen Datenquelle machen willst – ohne Stress – ist dieser Guide genau das Richtige für dich.

Web Scraping für Einsteiger: Die Basics, locker erklärt

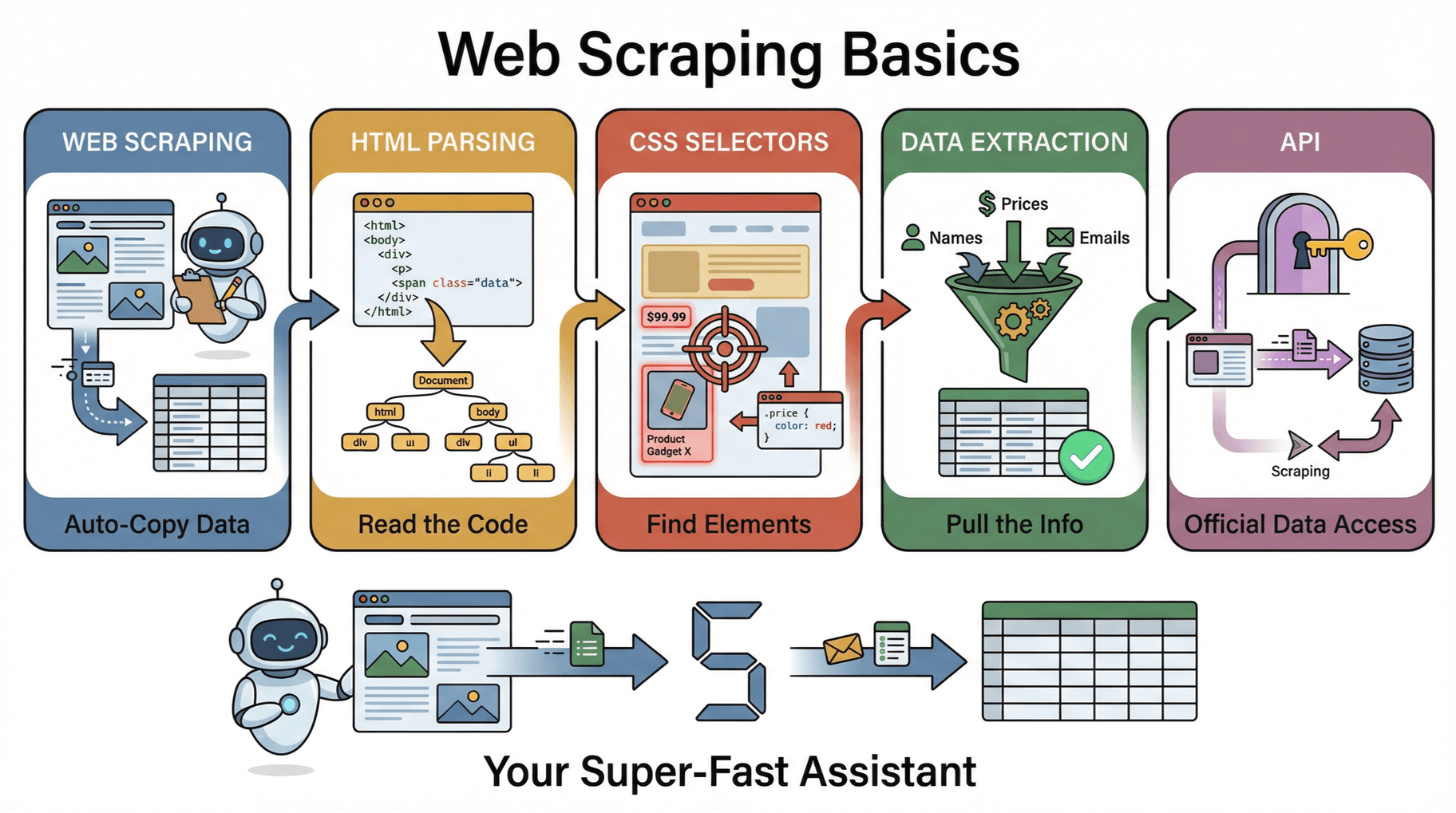

Lass uns mit den Grundlagen starten. Wenn du neu beim Web Scraping bist, tauchen ein paar Begriffe auf, die erstmal technisch klingen, aber eigentlich ganz easy sind, wenn man sie einmal versteht.

-

Web Scraping: Stell dir vor, du hast ein Tool, das automatisch Infos von Webseiten einsammelt und sie ordentlich in einer Tabelle oder Datenbank ablegt. Statt stundenlang zu kopieren und einzufügen, macht ein Web-Scraper das für dich in Minuten ().

-

HTML-Parsing: Jede Webseite besteht aus HTML – das ist der Code, der deinem Browser sagt, was angezeigt werden soll. Parsing heißt, diesen Code zu lesen und in eine Art Landkarte (DOM) umzuwandeln, damit der Scraper gezielt die Infos findet ().

-

CSS-Selektoren: Die funktionieren wie Adressen, um bestimmte Elemente auf einer Seite zu finden. Willst du zum Beispiel alle Preise auf einer Produktseite abgreifen, zeigt ein CSS-Selektor dem Scraper genau, wo er suchen muss (z. B. „alle Texte mit der Klasse ‚price‘“).

-

Datenextraktion: Das ist das Ziel – die gewünschten Infos (Namen, Preise, E-Mails usw.) rausziehen und in ein brauchbares Format bringen.

-

API (Application Programming Interface): Manche Seiten bieten eine offizielle Schnittstelle (API) an, um Daten strukturiert abzurufen. Gibt’s eine API, ist das meist einfacher und stabiler als HTML zu scrapen. Aber weil nicht jede Seite eine API hat, ist Web Scraping so beliebt ().

Kurz gesagt: Web Scraping ist wie ein Turbo-Assistent, der für dich Webseiten abklappert, die Infos findet und sie sauber in eine Tabelle packt – ganz ohne Handarbeit.

Warum Web Scraping für Einsteiger so praktisch ist

Warum solltest du Web Scraping lernen, auch wenn du kein Techie bist? Weil es dir mega viel Zeit spart und dir einen echten Vorsprung verschafft. Hier ein paar typische Beispiele:

| Anwendungsfall | Geschäftlicher Nutzen |

|---|---|

| Lead-Generierung (Vertrieb) | Erstelle in Minuten statt Stunden Listen mit potenziellen Kunden aus Verzeichnissen oder LinkedIn. |

| Preisüberwachung (E-Commerce) | Überwache automatisch die Preise und Lagerbestände der Konkurrenz – und passe deine Preise an. |

| Kundenbewertungen (Marketing) | Sammle Bewertungen von verschiedenen Plattformen, um die Kundenzufriedenheit zu analysieren und Produkte zu verbessern. |

| Marktforschung | Behalte Branchennews, Stellenanzeigen oder Wettbewerber-Updates im Blick, um strategische Einblicke zu gewinnen. |

Ein britischer Händler konnte zum Beispiel , weil er die Preise der Konkurrenz gescrapt und blitzschnell reagiert hat. Und sind 19-mal profitabler und verstehen ihre Kunden um 52 % besser.

Fazit: Web Scraping nimmt dir langweilige Aufgaben ab, liefert bessere Entscheidungsgrundlagen und gibt dir mehr Zeit für das, was dein Business wirklich nach vorne bringt.

Typische Anfängerfehler beim Web Scraping vermeiden

Gerade am Anfang stolpert man oft über die gleichen Sachen. Hier die häufigsten Fehler – und wie du sie locker umgehst:

-

Kein klares Ziel: Ohne Plan wird’s chaotisch und du verschwendest Zeit. Überleg dir immer vorher, welche Daten du brauchst und warum ().

-

Zu viel auf einmal scrapen: Es ist verlockend, gleich tausende Seiten zu scrapen – das endet aber oft im Frust. Starte klein: Eine Seite, sauber extrahieren, dann langsam steigern.

-

Doppelte oder unstrukturierte Daten: Anfänger landen oft bei doppelten Einträgen oder wild gemischten Formaten (z. B. „1.299 $“ und „1299 USD“). Prüfe auf Duplikate und sorge für einheitliche Daten ().

-

Paginierung oder Unterseiten vergessen: Nur die erste Seite einer Liste zu scrapen und den Rest zu übersehen, ist ein typischer Anfängerfehler. Achte darauf, dass dein Tool „Weiter“-Buttons und Links zu Detailseiten erkennt.

-

Website-Regeln ignorieren: Wer robots.txt oder die Nutzungsbedingungen ignoriert, riskiert eine Sperrung – oder Schlimmeres. Respektiere immer die Regeln der Seite ().

Tipp: Nutze Tools wie , die viele dieser Probleme automatisch für dich lösen. Das spart Zeit und Nerven.

Web Scraping ohne Programmieren: So easy geht’s mit Thunderbit

Ich habe viele Web Scraping Tools getestet, aber empfehle ich besonders gern an alle, die keine IT-Profis sind. Warum? Weil es auf Ergebnisse ausgelegt ist – ohne Technik-Kauderwelsch.

Das macht Thunderbit besonders:

-

KI-Scraping mit 2 Klicks: Einfach die öffnen, „KI-Felder vorschlagen“ anklicken und Thunderbits KI schlägt automatisch die wichtigsten Spalten vor (z. B. „Produktname“, „Preis“, „Bewertung“). Ein Klick auf „Scrapen“ – fertig. Kein Code, keine Selektoren, kein Stress ().

-

Unterseiten automatisch scrapen: Du brauchst mehr Details? Thunderbit besucht automatisch alle verlinkten Unterseiten (z. B. Produktdetails) und ergänzt die Daten mit nur einem Klick ().

-

Automatische Paginierung: Thunderbit erkennt „Weiter“-Buttons und endloses Scrollen – so entgeht dir kein Ergebnis ().

-

Sofort-Vorlagen: Für beliebte Seiten wie Amazon, Zillow oder LinkedIn gibt’s fertige Templates – auswählen, Daten exportieren, fertig ().

-

Kostenloser Datenexport: Exportiere deine Ergebnisse nach Excel, Google Sheets, Airtable oder Notion – ohne Zusatzkosten oder Limits ().

-

KI-Datenaufbereitung: Thunderbit kann deine Daten schon beim Scrapen beschriften, formatieren, übersetzen und sogar zusammenfassen – so ist deine Tabelle direkt einsatzbereit ().

-

Cloud- oder Browser-Scraping: Scrape in der Cloud (bis zu 50 Seiten gleichzeitig) für maximale Geschwindigkeit oder im Browser für Seiten mit Login.

Es ist, als hättest du einen KI-Assistenten, der nie müde wird, nie meckert und deine Daten immer top aufbereitet.

Schritt-für-Schritt: Dein erstes Web Scraping Projekt mit Thunderbit

Bereit für die Praxis? So nutzt du Thunderbit für deinen ersten Daten-Export – ganz ohne Programmierkenntnisse:

-

Thunderbit installieren: Hol dir die und registriere dich kostenlos (du bekommst 6 Seiten pro Monat gratis, mit Test-Boost sogar 10).

-

Zielseite öffnen: Geh auf die Webseite, die du scrapen willst (z. B. Immobilienangebote, Produktlisten oder ein Branchenverzeichnis).

-

Thunderbit öffnen: Klick auf das Thunderbit-Icon in deiner Browserleiste. Das Thunderbit-Panel erscheint.

-

„KI-Felder vorschlagen“ anklicken: Thunderbits KI scannt die Seite und schlägt die besten Spalten vor. Du kannst Felder bearbeiten oder weitere hinzufügen.

-

„Scrapen“ klicken: Thunderbit extrahiert die Daten – und übernimmt die Paginierung, falls es mehrere Seiten gibt.

-

(Optional) Unterseiten scrapen: Für mehr Details pro Eintrag klick auf „Unterseiten scrapen“. Thunderbit besucht alle verlinkten Seiten und sammelt zusätzliche Infos.

-

Daten exportieren: Klick auf „Exportieren“ und wähle Excel, Google Sheets, Airtable oder Notion. Deine Daten sind sofort einsatzbereit.

-

Ergebnisse prüfen: Kontrolliere deine Tabelle, ob alles passt. Falls Daten fehlen oder unstrukturiert sind, passe die Felder an und starte den Scrape erneut.

Das war’s – du hast gerade eine Webseite gescrapt, ohne eine einzige Zeile Code zu schreiben.

Tipps bei Problemen: Falls Daten fehlen oder eine Seite einen Login verlangt, wechsle zwischen Cloud- und Browser-Modus oder prüfe, ob sich das Layout geändert hat. Die und der Support helfen dir schnell weiter.

Rechtliche & ethische Basics beim Web Scraping für Einsteiger

Bevor du loslegst und wild drauflosscrapest, solltest du die Spielregeln kennen. Web Scraping ist für öffentliche Daten grundsätzlich erlaubt, aber es gibt wichtige Grenzen:

-

robots.txt und Nutzungsbedingungen checken: Rund verbieten Scraping ausdrücklich. Prüfe immer die robots.txt (einfach /robots.txt an die URL anhängen) und lies die Nutzungsbedingungen. Ist Scraping untersagt, such nach einer offiziellen API oder frag nach Erlaubnis.

-

Keine persönlichen oder sensiblen Daten scrapen: Sammle keine persönlichen Infos (E-Mails, Telefonnummern usw.), es sei denn, sie sind öffentlich und du hast einen legitimen Grund. Datenschutzgesetze wie DSGVO und CCPA sind ernst zu nehmen.

-

Keine urheberrechtlich geschützten Inhalte veröffentlichen: Scraping ist für Analysen oder interne Zwecke okay, aber veröffentliche keine fremden Artikel oder Bilder ohne Erlaubnis.

-

Rücksichtsvoll scrapen: Überlaste Webseiten nicht mit zu vielen Anfragen. Baue Pausen ein und scrape möglichst außerhalb der Stoßzeiten.

-

Daten sicher aufbewahren: Wenn du sensible Geschäftsdaten sammelst, speichere sie sicher und teile sie nicht öffentlich.

Checkliste für ethisches Scraping:

- [ ] robots.txt und Nutzungsbedingungen prüfen

- [ ] Keine persönlichen/privaten Daten sammeln

- [ ] Keine urheberrechtlich geschützten Inhalte veröffentlichen

- [ ] Anfragen drosseln

- [ ] APIs nutzen, wenn verfügbar

- [ ] Daten sicher speichern

Wenn du diese Regeln beachtest, bist du rechtlich auf der sicheren Seite – und sorgst dafür, dass das Web für alle nutzbar bleibt ().

Web Scraping für Einsteiger: Schritt für Schritt wachsen

Mein wichtigster Tipp: Starte mit einem kleinen, überschaubaren Projekt und steigere dich dann. So könnte dein Weg aussehen:

-

Eine einzelne Seite scrapen: Probier’s mit einer Produkt- oder Kontaktliste. Lerne das Tool und das Datenformat kennen.

-

Paginierung meistern: Wenn du sicher bist, scrape alle Seiten einer Liste (Thunderbit übernimmt das „Weiter“-Klicken für dich).

-

Unterseiten scrapen: Extrahiere Details von verlinkten Seiten (z. B. Produktdetails oder Maklerprofile).

-

Verschiedene Datentypen testen: Probier das Scrapen von Text, Bildern oder sogar PDFs. Thunderbit kann all das ().

-

Automatisieren mit Zeitplänen: Wenn du bereit bist, richte geplante Scrapes ein, um deine Daten immer aktuell zu halten.

Jeder kleine Erfolg macht dich sicherer und bringt dich weiter. Feiere deine Fortschritte – die ersten 100 gescrapten Zeilen sind ein echter Meilenstein!

Gescrapte Daten organisieren und aufbereiten

Saubere Daten sind Gold wert. So behältst du den Überblick und kannst direkt loslegen:

-

Konsistente Feldnamen verwenden: Nutze klare, einheitliche Namen wie „Preis“ oder „E-Mail“. Thunderbits KI-Vorschläge helfen dabei.

-

Formate vereinheitlichen: Achte darauf, dass Zahlen, Daten und Texte überall gleich formatiert sind. Thunderbit kann beim Scrapen sogar automatisch formatieren und übersetzen ().

-

Duplikate entfernen: Nutze Excel oder Google Sheets, um doppelte Zeilen zu löschen.

-

Daten laufend prüfen: Kontrolliere deine Daten während und nach dem Scraping, um Fehler frühzeitig zu erkennen.

-

Daten dokumentieren: Notiere Quelle, Datum und alle vorgenommenen Änderungen. So behalten du und dein Team später den Überblick.

Eine gut organisierte Tabelle spart dir viel Zeit bei der Analyse oder beim Teilen – und du musst nicht erst stundenlang aufräumen.

Skalieren: Wann und wie du größere Web Scraping Projekte angehst

Wenn du die Basics draufhast, willst du vielleicht mehr. Woran du das merkst – und wie du ohne Stress skalierst:

Woran du bereit bist:

- Du hast schon einige erfolgreiche Scrapes gemacht und willst mehr.

- Du möchtest Daten regelmäßig überwachen (z. B. tägliche Preischecks).

- Du scrapest Seiten mit vielen Unterseiten oder komplexen Strukturen.

So skalierst du entspannt:

- Cloud-Scraping nutzen: Mit Thunderbits Cloud-Modus kannst du bis zu 50 Seiten gleichzeitig scrapen – perfekt für große Projekte ().

- Regelmäßige Scrapes planen: Automatisiere wiederkehrende Aufgaben, damit die Daten zu dir kommen – nicht umgekehrt.

- Logins & dynamische Inhalte meistern: Nutze den Browser-Modus für Seiten mit Login oder komplexem Aufbau.

- Ergebnisse überwachen & anpassen: Prüfe regelmäßig deine Daten und passe dein Setup an, falls sich die Seite ändert.

Skalieren heißt: Schritt für Schritt auf deinem Wissen aufbauen.

Zusammenfassung: Die wichtigsten Web Scraping Tipps für Einsteiger

Kurz und knapp:

- Einfach starten: Ziel festlegen, eine Seite scrapen, dann langsam steigern.

- Einsteigerfreundliche Tools nutzen: Thunderbit macht Web Scraping schnell, einfach und präzise – ohne Programmieren.

- Fehler vermeiden: Plane im Voraus, halte deine Daten sauber und beachte die Regeln der Webseiten.

- Daten organisieren: Klare Feldnamen, einheitliche Formate und dokumentierte Abläufe helfen dir weiter.

- Clever skalieren: Automatisiere, plane und überwache deine Projekte, wenn du sicherer wirst.

Web Scraping ist längst nicht mehr nur was für IT-Profis. Mit der richtigen Herangehensweise und den passenden Tools kann jeder die Power von Webdaten nutzen – und bessere, schnellere Entscheidungen treffen.

Bereit, es auszuprobieren? und starte noch heute dein erstes Projekt. Für mehr Tipps, Anleitungen und Inspiration schau im vorbei.

Häufige Fragen (FAQ)

1. Ist Web Scraping für Einsteiger legal?

Web Scraping ist für öffentliche Daten in der Regel erlaubt, solange du die robots.txt, Nutzungsbedingungen und Datenschutzgesetze der jeweiligen Seite beachtest. Verzichte auf das Scrapen persönlicher oder urheberrechtlich geschützter Inhalte und nutze offizielle APIs, wenn sie angeboten werden ().

2. Muss ich programmieren können, um mit Web Scraping zu starten?

Nein! Tools wie sind extra für Nicht-Techniker gemacht. Du kannst Daten mit wenigen Klicks extrahieren – ganz ohne Programmierkenntnisse.

3. Was sind die häufigsten Fehler von Einsteigern beim Web Scraping?

Die größten Fehler sind: kein klares Ziel, zu viel auf einmal scrapen, Paginierung oder Unterseiten übersehen, unstrukturierte Daten und das Ignorieren von Webseitenregeln. Starte klein und nutze einsteigerfreundliche Tools, um diese Fallen zu vermeiden.

4. Wie halte ich meine gescrapten Daten sauber und organisiert?

Verwende konsistente Feldnamen, einheitliche Formate, prüfe auf Duplikate und kontrolliere deine Daten regelmäßig. Thunderbits KI hilft dir beim Beschriften, Formatieren und Exportieren nach Excel oder Google Sheets.

5. Wie kann ich meine Web Scraping Projekte ausbauen, wenn ich sicherer werde?

Wenn du dich wohlfühlst, nutze Thunderbits Cloud-Scraping, Unterseiten-Extraktion und Zeitplan-Funktionen, um größere oder komplexere Aufgaben zu meistern. Überwache deine Ergebnisse und passe sie bei Bedarf an.

Viel Erfolg beim Scrapen – auf dass deine Tabellen immer sauber und deine Daten stets aktuell sind!

Mehr erfahren