Web-Crawler sind die unsichtbaren Arbeitstiere des Internets. Immer wenn du nach einem neuen Rezept googelst, Sneaker-Preise vergleichst oder Hotels für deinen nächsten Trip suchst, war ziemlich sicher schon ein Web-Crawler vor dir da und hat die Infos im Hintergrund eingesammelt und sortiert. Glaub es oder nicht: wird heute von Bots und Crawlern erzeugt – nicht von Menschen. Während du schläfst, sind diese digitalen Späher rund um die Uhr unterwegs und sorgen dafür, dass die Welt der Informationen nur einen Klick entfernt ist.

Aber was steckt eigentlich hinter dem Begriff Web-Crawler? Warum sind sie für Unternehmen, Forschende und alle, die auf aktuelle Daten angewiesen sind, so unverzichtbar? Und wie haben moderne Tools wie das Web-Crawling für alle zugänglich gemacht – nicht nur für Programmierer oder große Tech-Konzerne? Ich entwickle seit Jahren Automatisierungs- und KI-Tools und habe miterlebt, wie Web-Crawler sich von mysteriösen „Spidern“ zu echten Business-Gamechangern entwickelt haben. Lass uns gemeinsam die Welt der Web-Crawler entzaubern: Was sind sie, wie funktionieren sie und warum sind sie 2025 das Rückgrat für smarten Datenzugang?

Web-Crawler: Die Datensammler des Internets

Was macht einen Web-Crawler eigentlich aus? Im Kern sind Web-Crawler (auch Spider oder Bot genannt) automatisierte Programme, die systematisch das Internet durchforsten, eine Webseite nach der anderen besuchen und dabei Informationen einsammeln. Stell sie dir wie die fleißigsten Recherche-Praktikanten der Welt vor – sie schlafen nie, meckern nie und können Millionen von Seiten an einem Tag abklappern.

Ein Web-Crawler startet mit einer Liste von Webadressen (den sogenannten „Seeds“), besucht jede davon und folgt dann den gefundenen Links, um neue Seiten zu entdecken. Während er das Netz erkundet, kopiert er Inhalte, indexiert Daten und erstellt eine Karte der sich ständig verändernden Online-Landschaft (). So wissen Suchmaschinen wie Google, was es im Netz gibt, und Preisvergleichsseiten oder Marktforschungstools halten ihre Daten aktuell.

Kurz gesagt: Web-Crawler sind die Scouts, die das Internet durchsuchbar, vergleichbar und nutzbar machen.

Die vielen Gesichter von Web-Crawlern: Typen und Hauptfunktionen

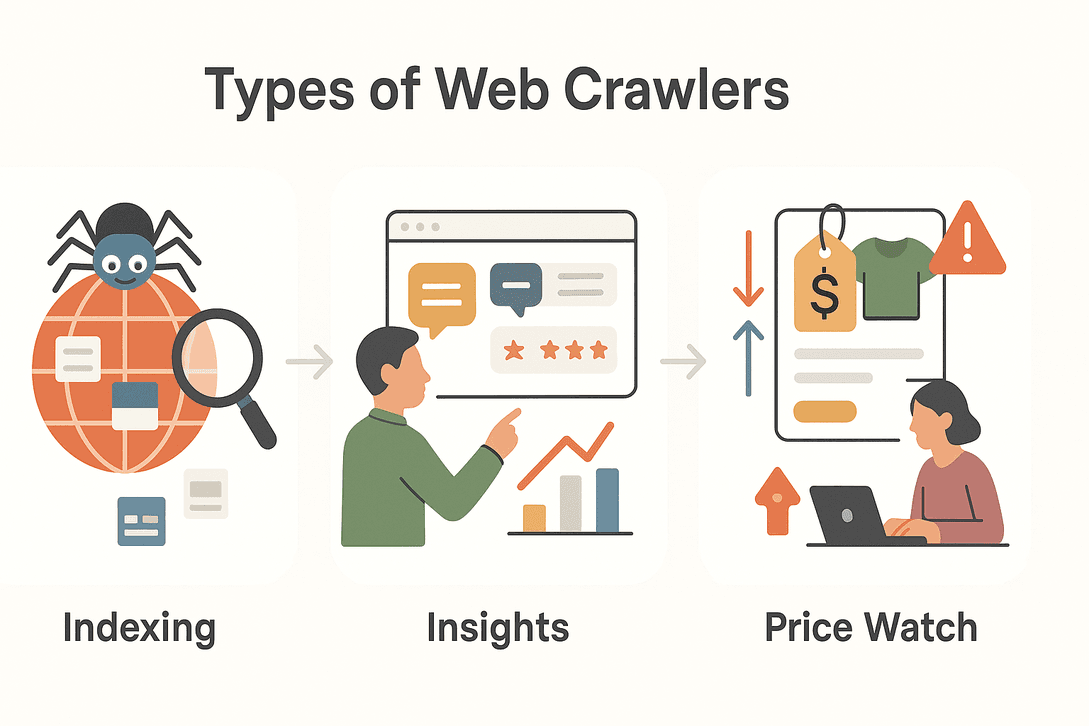

Nicht jeder Web-Crawler macht das Gleiche. Je nach Ziel gibt es verschiedene Arten von Crawlern, die jeweils auf bestimmte Aufgaben spezialisiert sind. Hier ein Überblick über die wichtigsten Typen:

Nicht jeder Web-Crawler macht das Gleiche. Je nach Ziel gibt es verschiedene Arten von Crawlern, die jeweils auf bestimmte Aufgaben spezialisiert sind. Hier ein Überblick über die wichtigsten Typen:

| Typ | Hauptfunktion | Typischer Anwendungsfall |

|---|---|---|

| Suchmaschinen-Crawler | Indexieren das Web für Suchergebnisse | Googlebot, Bingbot durchsuchen neue Websites |

| Data-Mining-Crawler | Sammeln große Datensätze für Analysen | Marktforschung, wissenschaftliche Studien |

| Preisüberwachungs-Crawler | Beobachten Produktpreise und Verfügbarkeiten | E-Commerce-Preisvergleich, dynamische Preisgestaltung |

| Content-Aggregations-Crawler | Sammeln Artikel, News oder Beiträge zur Bündelung | Nachrichtenportale, Content-Kuration |

| Lead-Generierungs-Crawler | Extrahieren Kontakt- und Firmendaten | Vertrieb, B2B-Verzeichnisse |

Schauen wir uns ein paar dieser Typen genauer an:

Suchmaschinen-Crawler

Wenn du eine Frage bei Google eintippst, verlässt du dich auf die Arbeit von Suchmaschinen-Crawlern. Diese Bots sind rund um die Uhr unterwegs, entdecken neue Seiten, aktualisieren bestehende und indexieren Inhalte, damit sie in den Suchergebnissen auftauchen. Ohne Crawler wären Suchmaschinen blind – sie wüssten nicht, was neu ist, was sich geändert hat oder was überhaupt existiert ().

Data-Mining- und Marktforschungs-Crawler

Unternehmen und Forschende nutzen Crawler, um riesige Datenmengen für Analysen zu sammeln. Du willst wissen, wie oft eine Konkurrenzmarke online erwähnt wird? Oder die Stimmung zu einem neuen Produktstart verfolgen? Data-Mining-Crawler durchforsten Foren, Bewertungen, Social Media und mehr und verwandeln das chaotische Web in strukturierte Erkenntnisse ().

Preisüberwachungs- und Produkt-Tracking-Crawler

Im schnellen E-Commerce ändern sich Preise und Produktdetails ständig. Preisüberwachungs-Crawler behalten die Konkurrenz im Blick, melden Preisänderungen, Lagerbestände oder neue Produkte. So können Unternehmen ihre Preise dynamisch anpassen und wettbewerbsfähig bleiben ().

Warum Web-Crawler für den modernen Datenzugang unverzichtbar sind

Mal ehrlich: Das Internet ist viel zu groß, um es von Hand zu durchforsten. Es gibt – und jede Minute kommen Tausende dazu. Web-Crawler machen es möglich, dass wir:

- Datensammlung skalieren: Millionen von Seiten in wenigen Stunden besuchen, statt in Monaten.

- Immer aktuell bleiben: Laufend Änderungen, neue Inhalte oder Breaking News erfassen.

- Dynamische, Echtzeit-Informationen nutzen: Sofort auf Marktveränderungen, Preisänderungen oder Trends reagieren.

- Datenbasierte Entscheidungen treffen: Von Suchmaschinen über Marktforschung bis zu Risikomanagement und Finanzmodellen alles ermöglichen ().

In einer Welt, in der , sorgen Web-Crawler dafür, dass der Datenfluss nie abreißt.

Typische Einsatzbereiche von Web-Crawlern in verschiedenen Branchen

Web-Crawler sind längst nicht mehr nur für Tech-Giganten oder Suchmaschinen relevant. So setzen verschiedene Branchen sie ein:

| Branche | Anwendungsfall | Vorteil |

|---|---|---|

| Vertrieb | Lead-Generierung | Zielgerichtete Kontaktlisten aus Verzeichnissen erstellen |

| E-Commerce | Preisüberwachung | Konkurrenzpreise, Lagerbestände und Produktänderungen verfolgen |

| Marketing | Content-Aggregation | News, Artikel und Social-Media-Erwähnungen bündeln |

| Immobilien | Immobilienanzeigen aggregieren | Angebote aus verschiedenen Quellen zusammenführen |

| Reisen | Flug- und Hotelvergleich | Preise, Verfügbarkeiten und Konditionen überwachen |

| Finanzen | Risikobeobachtung | Nachrichten, Meldungen und Stimmungen für Investments verfolgen |

Praxisbeispiel:

Ein Immobilienmakler nutzt Crawler, um Objektdetails, Fotos und Ausstattungen von verschiedenen Portalen zu sammeln und seinen Kunden einen aktuellen Marktüberblick zu bieten ().

Ein E-Commerce-Team setzt Crawler ein, um die SKUs und Preise der Konkurrenz zu überwachen und die eigene Strategie in Echtzeit anzupassen ().

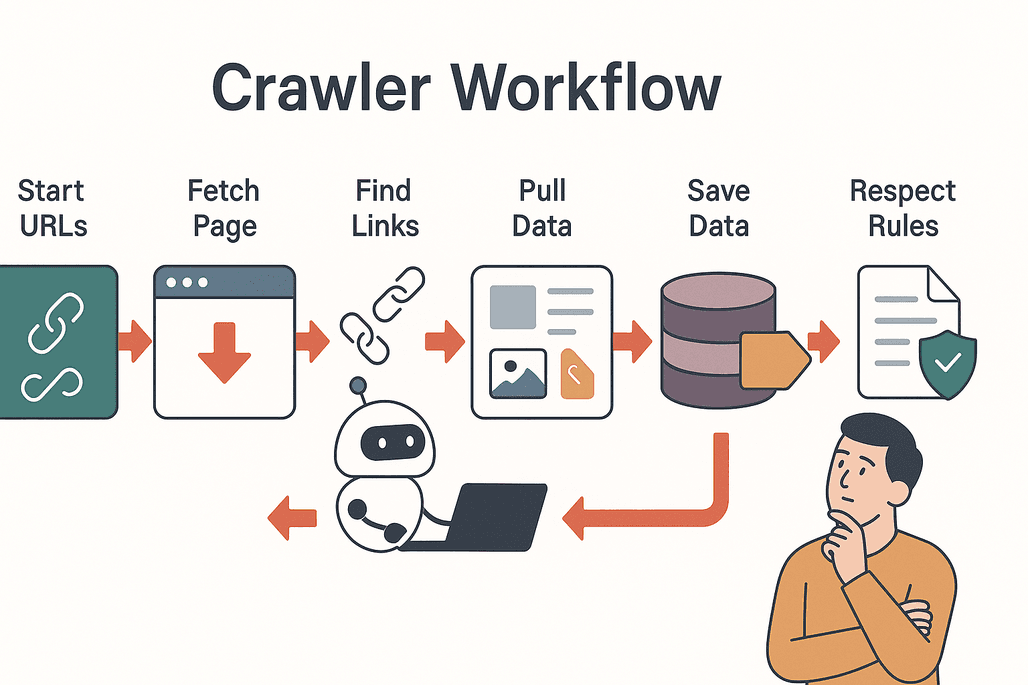

Wie Web-Crawler arbeiten: Schritt-für-Schritt erklärt

So läuft ein typischer Web-Crawler-Prozess ab:

So läuft ein typischer Web-Crawler-Prozess ab:

- Start mit Seeds: Der Crawler beginnt mit einer Liste von Start-URLs.

- Besuchen und Abrufen: Jede Seite wird besucht und der Inhalt heruntergeladen.

- Links extrahieren: Alle Links auf der Seite werden gesammelt.

- Links folgen: Neue, noch nicht besuchte Links werden in die Warteschlange aufgenommen.

- Daten extrahieren: Relevante Informationen (Texte, Bilder, Preise etc.) werden kopiert und strukturiert.

- Ergebnisse speichern: Die Daten werden in einer Datenbank abgelegt oder für Analysen exportiert.

- Regeln beachten: Der Crawler prüft die

robots.txt-Datei der Website und respektiert gesperrte Bereiche ().

Best Practices:

- Rücksichtsvoll crawlen (Server nicht überlasten).

- Datenschutz und rechtliche Vorgaben einhalten.

- Doppelte Inhalte und unnötige Anfragen vermeiden.

Herausforderungen und Stolpersteine beim Einsatz von Web-Crawlern

Web-Crawling läuft nicht immer reibungslos. Typische Herausforderungen sind:

- Serverbelastung: Zu viele Anfragen können eine Website verlangsamen oder lahmlegen.

- Doppelte Inhalte: Crawler können auf denselben Seiten hängenbleiben oder in Endlosschleifen geraten.

- Datenschutz und Recht: Nicht alle Daten dürfen einfach gesammelt werden – immer die Nutzungsbedingungen und Datenschutzgesetze prüfen.

- Technische Hürden: Manche Seiten setzen CAPTCHAs, dynamische Inhalte oder Anti-Bot-Maßnahmen ein ().

Tipps für den Erfolg:

- Crawl-Rate anpassen und respektvoll agieren.

- Änderungen an Webseitenstrukturen beobachten.

- Über aktuelle Datenschutzbestimmungen informiert bleiben.

Thunderbit: Web-Crawler für alle zugänglich machen

Jetzt wird’s spannend: Früher musste man für einen Web-Crawler programmieren, Einstellungen konfigurieren und viel Zeit ins Troubleshooting stecken. Mit ist das Vergangenheit.

Thunderbit ist ein KI-basierter Web-Scraper als Chrome-Erweiterung, speziell für Business-Anwender – ganz ohne Programmierkenntnisse. Das macht Thunderbit besonders:

- Anweisungen in natürlicher Sprache: Einfach beschreiben, welche Daten du brauchst („Alle Produktnamen und Preise von dieser Seite holen“) – die KI erledigt den Rest.

- KI-gestützte Feldvorschläge: Mit „KI-Felder vorschlagen“ liest Thunderbit die Seite aus und empfiehlt passende Spalten.

- Subseiten-Scraping: Mehr Details nötig? Thunderbit besucht automatisch Unterseiten (z. B. Produktdetails oder LinkedIn-Profile) und erweitert deinen Datensatz.

- Sofort-Vorlagen: Für beliebte Seiten (Amazon, Zillow, Shopify etc.) gibt es fertige Templates für den 1-Klick-Export.

- Einfache Exporte: Daten direkt nach Excel, Google Sheets, Airtable oder Notion senden – ohne Umwege.

- Kostenloser Datenexport: Ergebnisse als CSV oder JSON gratis herunterladen.

Thunderbit wird von geschätzt – von Vertriebsteams über E-Commerce bis zu Immobilienprofis.

Thunderbit vs. klassische Web-Crawler

So schlägt sich Thunderbit im Vergleich zur klassischen Methode:

| Funktion | Thunderbit | Klassische Crawler |

|---|---|---|

| Einrichtungszeit | 2 Klicks (KI übernimmt Setup) | Stunden/Tage (manuelle Konfiguration, Programmierung) |

| Technisches Know-how | Nicht nötig (einfache Spracheingabe) | Hoch (Programmierung, Selektoren, Scripting) |

| Flexibilität | Funktioniert auf jeder Seite, passt sich an | Bricht bei Layout-Änderungen |

| Subseiten-Scraping | Integriert, keine Extra-Einrichtung | Manuelles Scripting erforderlich |

| Exportoptionen | Excel, Sheets, Airtable, Notion, CSV, JSON | Meist nur CSV/JSON |

| Wartung | KI passt sich automatisch an | Häufig manuelle Anpassungen nötig |

Mit Thunderbit brauchst du weder Entwicklerwissen noch stundenlanges Feintuning. Einfach Seite öffnen, klicken und die KI erledigt den Rest ().

So startest du mit Web-Crawlern dank Thunderbit

Neugierig geworden? So einfach geht’s mit Thunderbit:

- .

- Die gewünschte Website öffnen.

- Thunderbit-Icon anklicken und „KI-Felder vorschlagen“ wählen. Die KI schlägt passende Spalten vor.

- Felder bei Bedarf anpassen und auf „Scrapen“ klicken. Thunderbit extrahiert die Daten, auch von Unterseiten.

- Ergebnisse exportieren – nach Excel, Google Sheets, Airtable, Notion oder als CSV/JSON herunterladen.

Das war’s – keine Templates, kein Programmieren, kein Kopfzerbrechen. Egal ob Preisüberwachung, Lead-Listen oder News-Aggregation: Mit Thunderbit wird Web-Crawling so einfach wie Essen bestellen.

Fazit: Web-Crawler sind der Schlüssel zu intelligentem Datenzugang

Web-Crawler sind die unsichtbaren Motoren unserer digitalen Welt. Sie machen Informationen für alle zugänglich, durchsuchbar und nutzbar. Von Suchmaschinen über Vertrieb bis E-Commerce und Immobilien – Crawler sind heute unverzichtbar für alle, die auf aktuelle, zuverlässige Daten angewiesen sind.

Dank moderner KI-Tools wie braucht es dafür keine Programmierkenntnisse mehr. Mit wenigen Klicks wird das Web zur strukturierten, nutzbaren Datenquelle – für bessere Entscheidungen und neue Chancen.

Willst du sehen, was Web-Crawler für dein Business leisten können? und entdecke die verborgenen Daten des Internets. Noch mehr Tipps und Insights findest du im .

Häufige Fragen

1. Was ist ein Web-Crawler genau?

Ein Web-Crawler ist ein automatisiertes Programm (auch Spider oder Bot genannt), das systematisch das Internet durchforstet, Webseiten besucht, Links folgt und Informationen für Indexierung oder Analyse sammelt.

2. Worin unterscheiden sich Web-Crawler und Web-Scraper?

Web-Crawler sind darauf ausgelegt, große Teile des Internets zu entdecken und zu kartieren, indem sie Links von Seite zu Seite folgen. Web-Scraper hingegen konzentrieren sich darauf, gezielt bestimmte Daten von ausgewählten Seiten zu extrahieren. Viele moderne Tools (wie Thunderbit) vereinen beide Funktionen.

3. Warum sind Web-Crawler für Unternehmen wichtig?

Web-Crawler ermöglichen es Unternehmen, aktuelle Informationen in großem Umfang zu erfassen – sei es zur Preisüberwachung, Content-Aggregation oder Lead-Generierung. Sie unterstützen schnelle, datenbasierte Entscheidungen und sichern die Wettbewerbsfähigkeit.

4. Ist der Einsatz von Web-Crawlern legal?

Web-Crawling ist in der Regel legal, solange es verantwortungsvoll und im Einklang mit den Nutzungsbedingungen und Datenschutzrichtlinien der jeweiligen Website erfolgt. Prüfe immer die robots.txt-Datei und halte dich an Datenschutzgesetze.

5. Wie vereinfacht Thunderbit das Web-Crawling?

Thunderbit nutzt KI, um Einrichtung, Feldauswahl und Datenerfassung zu automatisieren. Mit Anweisungen in natürlicher Sprache und Sofort-Vorlagen kann jeder Daten von Websites extrahieren – ganz ohne Programmierkenntnisse. Die Daten lassen sich direkt nach Excel, Google Sheets, Airtable oder Notion exportieren.

Mehr erfahren