Das Internet ist eine echte Goldmine für Daten – und egal, ob du im Vertrieb, in der Operations oder in einer anderen Abteilung arbeitest, kennst du bestimmt den Druck, aus diesem Datenchaos brauchbare Infos rauszuziehen. Ich habe selbst erlebt, wie Teams immer mehr versuchen, die Datenerfassung zu automatisieren – sei es für Lead-Generierung, Preisbeobachtung oder Marktanalysen. Mal ehrlich: Niemand will den ganzen Tag Daten von Webseiten per Copy & Paste übertragen. Genau hier kommt Web-Scraping ins Spiel – und Python ist dabei das absolute Go-to-Tool.

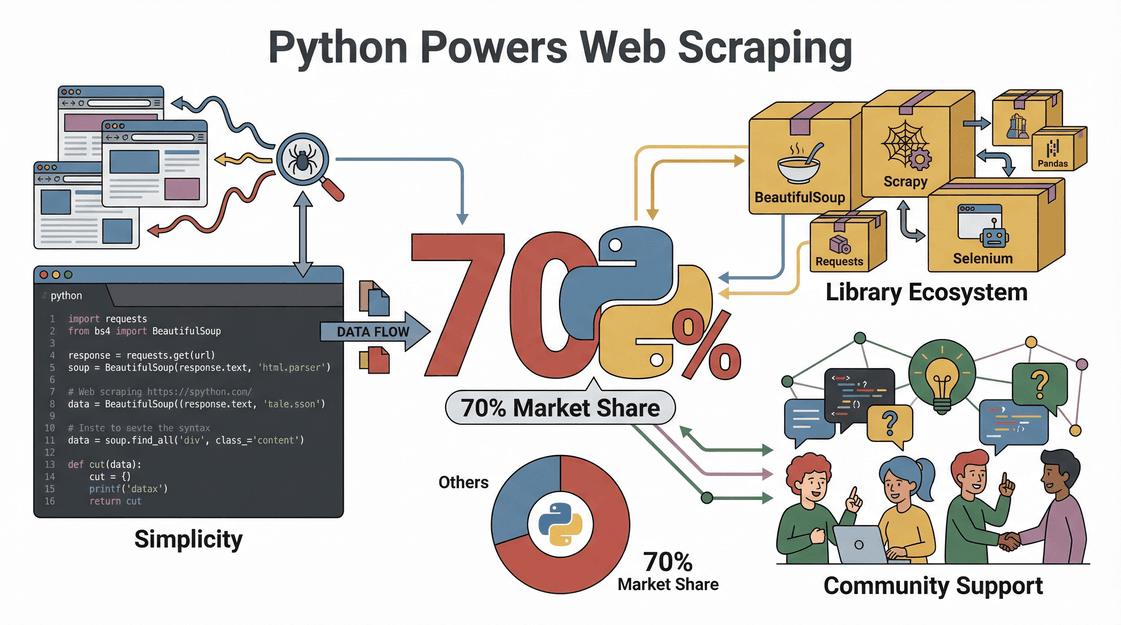

Dass Python beim Web-Scraping so beliebt ist, ist kein Zufall: Fast laufen mit Python – dank der einfachen Syntax, einer riesigen Auswahl an Bibliotheken und einer Community, die für jedes Problem eine Lösung kennt. In diesem Guide zeige ich dir Schritt für Schritt, wie du mit Python Webseiten ausliest – von der Installation bis zum ersten eigenen Skript. Außerdem erfährst du, wie den Prozess noch einfacher macht – vor allem, wenn du lieber klickst statt programmierst.

Was ist Web Scraping und warum Python?

Starten wir mit den Basics. Web-Scraping heißt, dass du Daten automatisiert von Webseiten abziehst – stell dir vor, ein digitaler Assistent kopiert blitzschnell Infos von einer Seite und packt sie in eine Tabelle. Unternehmen nutzen Web-Scraping für alles Mögliche: von .

Warum ist Python also die Sprache der Wahl fürs Web-Scraping?

- Super einfach zu lernen: Die Syntax von Python ist klar und verständlich – auch für Leute ohne Programmiererfahrung.

- Viele Bibliotheken: Mit Libraries wie Requests, BeautifulSoup, Selenium und Scrapy kannst du alles machen – von einfachem HTML-Parsing bis zu komplexen, JavaScript-lastigen Seiten.

- Riesige Community: Bei Problemen findest du fast immer eine Lösung auf Stack Overflow oder GitHub.

- Schnell und flexibel: Python-Skripte lassen sich easy an neue Webseiten oder Datenstrukturen anpassen und skalieren von kleinen Aufgaben bis zu großen Projekten.

Kurz gesagt: Python ist das Schweizer Taschenmesser fürs Web-Scraping – stark, flexibel und auch für Anfänger super geeignet.

Geschäftlicher Nutzen: Wie Web-Scraping mit Python Unternehmen nach vorne bringt

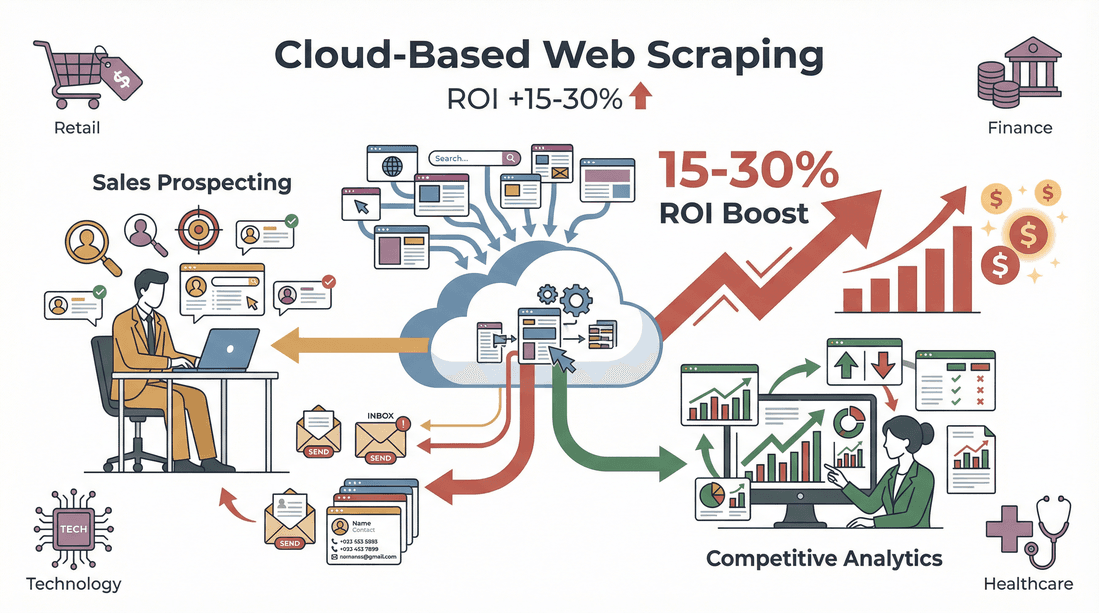

Web-Scraping ist kein reiner Technik-Trick – es ist ein echter Business-Booster. So nutzen Unternehmen Python-basiertes Scraping, um sich Vorteile zu verschaffen:

| Anwendungsfall | Wie hilft Python? | Business-Nutzen |

|---|---|---|

| Lead-Generierung | Kontaktdaten aus Verzeichnissen, LinkedIn etc. extrahieren | CRM mit aktuellen, gezielten Leads füllen |

| Preisbeobachtung | Wettbewerberpreise auf E-Commerce-Seiten verfolgen | Dynamische Preisgestaltung und Wettbewerbsfähigkeit |

| Marktforschung | Bewertungen, Artikel oder Social-Media-Beiträge sammeln | Trends erkennen und datenbasiert entscheiden |

| Immobiliendaten sammeln | Immobilienanzeigen von verschiedenen Portalen auslesen | Zentrale, aktuelle Marktdatenbanken aufbauen |

| Produktkatalog-Management | Produktdaten und Lagerbestände von Lieferanten abrufen | Bestandsaktualisierung automatisieren, Fehler reduzieren |

Und der ROI? Eine zeigt: Automatisiertes Lead-Scraping spart Recruitern 8 Stunden pro Woche. Branchenübergreifend hat bei Vertrieb und Wettbewerbsanalysen gesteigert.

Python-Umgebung fürs Web-Scraping einrichten

Bevor du loslegst, musst du Python installieren. So klappt der Einstieg – auch ohne Programmierkenntnisse:

1. Python installieren

- Python downloaden: Hol dir die aktuelle Version (am besten 3.10 oder neuer) von der .

- Python zum PATH hinzufügen: Unter Windows beim Installieren das Häkchen bei „Add Python to PATH“ setzen – so kannst du Python direkt über die Kommandozeile starten ().

2. Virtuelle Umgebung einrichten

Mit einer virtuellen Umgebung hältst du die Bibliotheken deines Projekts sauber getrennt und vermeidest Versionskonflikte.

1# Unter Windows

2python -m venv venv

3venv\Scripts\activate

4# Unter Mac/Linux

5python3 -m venv venv

6source venv/bin/activate3. Code-Editor auswählen

- VS Code: Kostenlos, schlank und mit vielen Erweiterungen.

- PyCharm: Perfekt für größere Projekte, mit smarten Vorschlägen.

- Jupyter Notebook: Ideal zum Ausprobieren und Visualisieren von Daten.

4. Tipps bei Problemen

- Wenn Python-Befehle nicht erkannt werden, prüfe den PATH.

- Bei Berechtigungsfehlern: Terminal als Administrator öffnen.

- Mac-User: Eventuell musst du Xcode Command Line Tools installieren (

xcode-select --install).

Die richtigen Python-Bibliotheken fürs Web-Scraping auswählen

Die Power von Python steckt in seinen Bibliotheken. Hier ein Überblick über die wichtigsten Tools und wofür sie sich eignen:

| Bibliothek | Einsatzgebiet | Bedienung | Geschwindigkeit | JavaScript-Unterstützung | Skalierbarkeit |

|---|---|---|---|---|---|

| Requests | Webseiten abrufen (HTTP) | Einfach | Schnell | Nein | Gut |

| BeautifulSoup | HTML/XML parsen | Sehr einfach | Mittel | Nein | Gut |

| lxml | Schnelles XML/HTML-Parsing | Mittel | Sehr schnell | Nein | Gut |

| Selenium | Interaktion mit dynamischen Seiten | Mittel | Langsam | Ja (vollständiger Browser) | Mittel |

| Scrapy | Großprojekte, automatisiertes Scraping | Mittel | Sehr schnell | Teilweise/Ja | Exzellent |

- Requests ist super für einfache HTTP-Anfragen.

- BeautifulSoup ist besonders einsteigerfreundlich – perfekt zum Auslesen von HTML-Daten.

- lxml ist extrem schnell bei großen Dokumenten, aber etwas anspruchsvoller für Anfänger.

- Selenium öffnet einen echten Browser und kann so auch JavaScript-lastige Seiten abgreifen.

- Scrapy ist ein komplettes Framework für große, skalierbare Scraper-Projekte.

Für die meisten Einsteiger ist die Kombi aus Requests + BeautifulSoup ideal ().

Schritt für Schritt: So funktioniert Web-Scraping mit Python

Schauen wir uns ein Praxisbeispiel an: Produktdaten von einer (fiktiven) E-Commerce-Seite abgreifen.

1. Webseitenstruktur analysieren

Öffne die Entwicklertools deines Browsers (meist F12 oder Rechtsklick > Untersuchen). Such die HTML-Elemente, die die gewünschten Daten enthalten – zum Beispiel Produkttitel, Preise oder Bewertungen. Dieser Schritt ist entscheidend: Du musst wissen, was du im Code ansteuerst ().

2. HTTP-Anfrage senden

Mit Requests die Seite abrufen.

1import requests

2url = "https://example.com/products"

3response = requests.get(url)

4html = response.text3. HTML mit BeautifulSoup parsen

Die gewünschten Daten extrahieren.

1from bs4 import BeautifulSoup

2soup = BeautifulSoup(html, "html.parser")

3products = soup.find_all("div", class_="product-card")4. Daten extrahieren und bereinigen

Durch die Produkte iterieren und Details erfassen.

1data = []

2for product in products:

3 title = product.find("h2", class_="title").text.strip()

4 price = product.find("span", class_="price").text.strip()

5 rating = product.find("span", class_="rating").text.strip()

6 # Preis für Berechnungen bereinigen

7 price_num = float(price.replace("$", ""))

8 data.append({"title": title, "price": price_num, "rating": rating})5. Daten als CSV/Excel exportieren

Mit Pandas die Ergebnisse speichern.

1import pandas as pd

2df = pd.DataFrame(data)

3df.to_csv("products.csv", index=False)

4df.to_excel("products.xlsx", index=False)()

Fertig – die Daten sind sauber strukturiert und bereit für die Analyse oder den Import ins CRM.

Dynamische Inhalte und Paginierung meistern

Nicht alle Webseiten sind einfach gestrickt. Manche laden Inhalte per JavaScript oder verteilen Ergebnisse auf mehrere Seiten. So gehst du damit um:

Dynamische Inhalte scrapen

Fehlen Daten oder bleibt das Ergebnis leer, lädt die Seite die Inhalte vermutlich dynamisch. Hier hilft Selenium:

1from selenium import webdriver

2driver = webdriver.Chrome()

3driver.get("https://example.com/products")

4html = driver.page_source

5# Wie gehabt mit BeautifulSoup weiterarbeiten()

Paginierung handhaben

Um mehrere Seiten auszulesen, einfach über die Seitenzahlen oder „Weiter“-Buttons iterieren.

1for page in range(1, 6):

2 url = f"https://example.com/products?page={page}"

3 response = requests.get(url)

4 # Wie gehabt parsen und extrahieren()

Für große Projekte kann Scrapy das Crawlen über Hunderte Seiten automatisieren ().

Export und Nutzung der gesammelten Daten

Sobald du deine Daten hast, kannst du sie weiterverarbeiten:

- Export als CSV/Excel: Wie oben gezeigt, geht das mit Pandas super easy.

- Daten bereinigen und normalisieren: Duplikate entfernen, Tippfehler ausbessern, Formate vereinheitlichen ().

- In Workflows integrieren: CSV in Salesforce, HubSpot oder dein Analyse-Tool importieren – oder mit Python-Skripten automatisieren.

Thunderbit: Python Web-Scraping für Business-Teams einfach gemacht

Ganz ehrlich: Python ist mächtig, aber nicht immer der schnellste Weg, wenn du nicht programmieren willst. Deshalb haben wir entwickelt – eine für Business-User, die Ergebnisse ohne Aufwand wollen.

Das macht Thunderbit zum Gamechanger für Vertriebs- und Operationsteams:

- KI-Felderkennung: Mit „KI-Felder vorschlagen“ scannt Thunderbit die Seite, schlägt passende Spalten (z. B. Name, Preis, E-Mail) vor und richtet die Extraktion automatisch ein – ganz ohne manuelles Mapping.

- Unterseiten-Scraping: Thunderbit besucht automatisch jede Unterseite (z. B. Produktdetails oder LinkedIn-Profile) und ergänzt deine Tabelle mit weiteren Infos.

- Paginierung & dynamische Inhalte: Listen mit mehreren Seiten oder unendlichem Scrollen werden problemlos verarbeitet – ganz ohne Code.

- Sofort-Vorlagen: Für bekannte Seiten (Amazon, Zillow, Shopify usw.) einfach Vorlage auswählen und loslegen.

- Kostenloser Datenexport: Exportiere direkt nach Excel, Google Sheets, Airtable oder Notion – ohne Umwege.

- Kein Wartungsaufwand: Thunderbits KI passt sich automatisch an Webseitenänderungen an – du musst keine fehlerhaften Skripte mehr reparieren.

Ich habe gesehen, wie Nutzer in weniger als fünf Minuten von „Ich brauche diese Daten, weiß aber nicht wie“ zu „Hier ist meine fertige Tabelle“ kommen. Und ja, es gibt eine zum risikofreien Ausprobieren.

Thunderbit und Python kombinieren: Das perfekte Toolkit für die Datensammlung

Power-User und Datenanalysten müssen sich nicht entscheiden – Thunderbit und Python lassen sich super kombinieren. So mache ich es:

- Mit Thunderbit extrahieren: Strukturierte Daten schnell von komplexen oder unbekannten Seiten erfassen und als CSV/Excel exportieren.

- Mit Python weiterverarbeiten: Die exportierten Daten in Pandas laden, bereinigen, analysieren oder automatisieren.

- Workflows automatisieren: Regelmäßige Scrapes mit Thunderbit planen und anschließend Python-Skripte starten, um die Daten weiterzuverarbeiten oder hochzuladen.

Mit diesem Mix bleibst du flexibel, sparst Zeit und musst das Rad nicht jedes Mal neu erfinden.

Rechtliche und ethische Aspekte beim Web-Scraping

Jetzt zum sensiblen Thema: Ist Web-Scraping legal? Die kurze Antwort: Ja – solange du dich an die Regeln hältst.

- robots.txt und Nutzungsbedingungen beachten: Manche Seiten verbieten Scraping ausdrücklich – immer vorher checken ().

- Keine persönlichen oder urheberrechtlich geschützten Daten scrapen: Bleib bei öffentlich zugänglichen, sachlichen Infos.

- Anfragen drosseln: Server nicht überlasten – Pausen einbauen und Limits respektieren ().

- Datenschutzgesetze einhalten: Bei E-Mails oder personenbezogenen Daten unbedingt DSGVO, CCPA & Co. beachten ().

Thunderbit hilft dir dabei, compliant zu bleiben, indem nur sichtbare und im Browser zugängliche Daten extrahiert werden und Limits einfach eingehalten werden können.

Troubleshooting & Best Practices für Python Web-Scraping

Auch die besten Scraper stoßen mal auf Probleme. Hier meine Checkliste für typische Fehlerquellen:

- Blockierte Anfragen: User Agents rotieren, Proxies nutzen oder Anfragen verlangsamen ().

- Parsing-Fehler: HTML-Selektoren prüfen – Webseiten ändern ihr Layout oft.

- Fehlende Daten: Prüfen, ob Inhalte dynamisch geladen werden (ggf. Selenium einsetzen).

- Captcha oder Login-Schranken: Manche Seiten blockieren Bots aktiv – ggf. Alternativen oder manuelle Extraktion erwägen.

Best Practices:

- Scraper immer erst mit kleinen Datenmengen testen.

- Fehler protokollieren und Ausnahmen sauber behandeln.

- Webseitenregeln respektieren und keine sensiblen Daten scrapen.

- Code dokumentieren und modular halten – so sind Updates leichter.

- Regelmäßige Wartung einplanen – Webseiten ändern sich, deine Scraper sollten es auch ().

Fazit & wichtigste Erkenntnisse

Web-Scraping mit Python ist ein echter Wettbewerbsvorteil für moderne Unternehmen – aus unübersichtlichen Webseiten werden strukturierte, nutzbare Daten. Das solltest du mitnehmen:

- Python ist die Top-Wahl fürs Web-Scraping – dank einfacher Bedienung, starker Bibliotheken und einer aktiven Community.

- Der Workflow ist klar: Seite analysieren, abrufen, HTML parsen, Daten extrahieren und bereinigen, dann als CSV/Excel exportieren.

- Thunderbit macht Scraping für alle zugänglich – mit automatischer Felderkennung, Unterseiten-Extraktion und Datenexport in wenigen Klicks.

- Thunderbit und Python kombinieren bringt das Beste aus beiden Welten: schnelle Extraktion und leistungsstarke Datenverarbeitung.

- Legal und fair bleiben: Webseitenregeln beachten, keine persönlichen Daten scrapen und fair bleiben.

Bereit für den Einstieg? Probier deinen ersten Python-Scraper – oder, wenn du den Code überspringen willst, und erlebe, wie einfach Datensammlung sein kann. Noch mehr Tipps und Anleitungen findest du im .

FAQs

1. Was ist Web-Scraping und warum ist Python dafür so beliebt?

Web-Scraping ist die automatisierte Extraktion von Daten aus Webseiten. Python ist so populär, weil die Sprache leicht verständlich ist, starke Bibliotheken wie Requests und BeautifulSoup bietet und eine riesige Community Einsteiger wie Profis unterstützt ().

2. Welche Python-Bibliotheken sollte ich fürs Web-Scraping nutzen?

Für die meisten Projekte empfiehlt sich Requests (zum Abrufen der Seiten) und BeautifulSoup (zum Parsen von HTML). Für dynamische oder JavaScript-lastige Seiten eignet sich Selenium. Für große oder komplexe Projekte ist Scrapy eine gute Wahl ().

3. Wie unterscheidet sich Thunderbit vom Python Web-Scraping?

Thunderbit ist eine KI-gestützte Chrome-Erweiterung, mit der du Daten in nur zwei Klicks extrahierst – ganz ohne Programmierkenntnisse. Ideal für Business-User, die schnell Ergebnisse wollen, während Python mehr Flexibilität für individuelle oder große Projekte bietet ().

4. Ist Web-Scraping legal?

Web-Scraping ist in der Regel legal, solange du dich auf öffentliche Daten beschränkst, robots.txt und Nutzungsbedingungen respektierst und keine persönlichen oder urheberrechtlich geschützten Infos extrahierst. Prüfe immer die Regeln der jeweiligen Seite ().

5. Wie kann ich Thunderbit und Python für fortgeschrittene Workflows kombinieren?

Nutze Thunderbit, um strukturierte Daten schnell zu extrahieren und als CSV oder Excel zu exportieren. Anschließend kannst du mit Python (z. B. mit Pandas) die Daten bereinigen, analysieren oder weiter automatisieren – so profitierst du von beiden Ansätzen.

Bereit, das Web zur besten Datenquelle für dein Unternehmen zu machen? Probier Python und Thunderbit aus – und lass die Daten für dich arbeiten.

Mehr erfahren