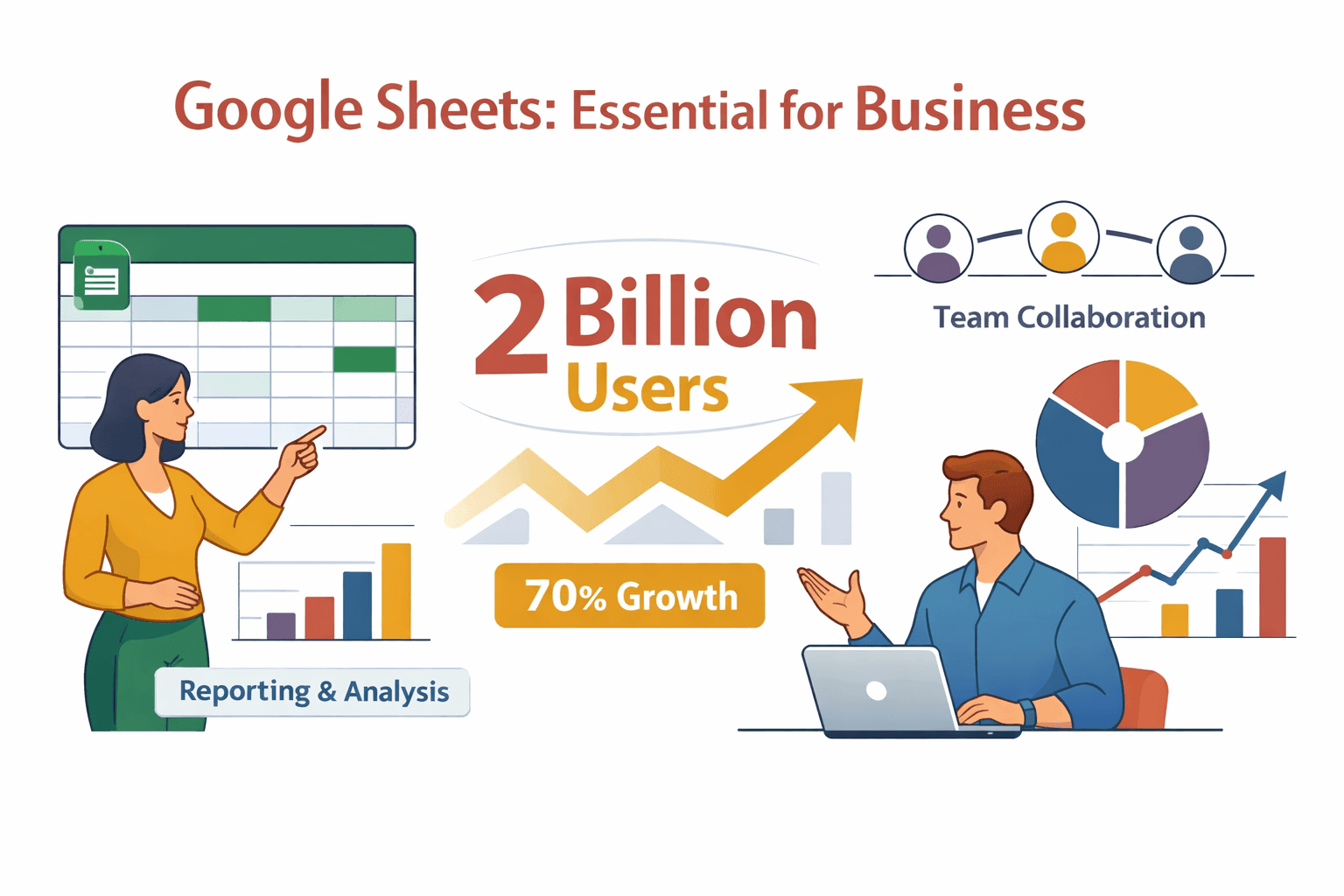

Früher war das Übertragen von daten von einer website in google sheets wirklich eine nervige Angelegenheit – selbst für die entspanntesten Leute im Büro. Ich habe Vertriebsteams gesehen, die stundenlang Leads per Copy & Paste eingefügt haben, E-Commerce-Manager, die mit veralteten Preislisten kämpfen, und Operations-Teams, die in endlosen Tabellen festhängen. Dabei ist google sheets längst das Herzstück für Berichte und Zusammenarbeit im Unternehmen – mit und einem . Trotzdem tippen die meisten Teams ihre daten immer noch per Hand ein – obwohl .

Wenn du es satt hast, deine Nachmittage mit Copy & Paste von websitedaten in google sheets zu verbringen – oder einfach die langweiligen Aufgaben automatisieren willst – dann ist dieser Guide genau das Richtige für dich. Ich zeige dir, wie du mit , unserem KI-Web-Scraper, websitedaten mit nur ein paar Klicks direkt in google sheets bekommst. Egal ob Vertrieb, E-Commerce oder einfach Fan von aufgeräumten Tabellen – lass uns deinen Workflow gemeinsam smarter machen.

Was bedeutet es, websitedaten in google sheets zu importieren?

Websitedaten in google sheets zu importieren heißt, Infos aus dem Netz – wie Produktlisten, Kontaktdaten, Preise, Bilder oder ganze Tabellen – direkt in deine Tabelle zu holen, um sie auszuwerten, Berichte zu erstellen oder mit dem Team zu teilen.

Warum ist das so wichtig? Google sheets ist viel mehr als nur ein Ort für Zahlen – es ist ein dynamischer, kollaborativer Workspace. Stell dir vor, dein Vertriebsteam zieht aktuelle Leads aus einem Verzeichnis, dein Operations-Team checkt in Echtzeit die Preise der Konkurrenz und das Marketing sammelt Bewertungen – alles in einer immer aktuellen, gemeinsam nutzbaren Tabelle. Keine Diskussionen mehr, wer die neueste Version hat, und keine nächtlichen Copy-Paste-Marathons.

Typische Anwendungsfälle, bei denen das ein echter Gamechanger ist:

- Leadgenerierung: Kontaktdaten aus Verzeichnissen oder Eventseiten extrahieren und direkt ins CRM via google sheets übertragen.

- Preisüberwachung: Konkurrenzpreise oder Verfügbarkeiten verfolgen und die eigene Preisstrategie flexibel anpassen.

- Marktforschung: Bewertungen, News oder Produktspezifikationen für Trendanalysen sammeln.

- Immobilien: Angebote von verschiedenen Portalen zentral zusammenführen.

Websitedaten in google sheets zu bündeln bedeutet: schnellere Berichte, bessere Zusammenarbeit und – ehrlich gesagt – viel weniger Fleißarbeit.

Warum websitedaten in google sheets importieren? Die wichtigsten Vorteile

Kommen wir zum Punkt: Warum wollen so viele Teams websitedaten in google sheets importieren? Hier die größten Pluspunkte:

- Zeitersparnis: Automatisierte Importe sparen .

- Mehr Genauigkeit: Manuelle Eingaben sind fehleranfällig – . Automatisierung sorgt für saubere daten.

- Echtzeit-Updates: Geplantes Scraping hält deine Sheets immer aktuell – du arbeitest nie mit veralteten Infos.

- Bessere Zusammenarbeit: Google sheets ist für Teamwork gemacht. Wenn die daten automatisch fließen, sind alle auf dem gleichen Stand.

So profitieren verschiedene Teams:

So profitieren verschiedene Teams:

| Team | Beispiel-Anwendung | Hauptvorteil |

|---|---|---|

| Vertrieb | Leads aus Webverzeichnissen importieren | Schnellere Ansprache, weniger Handarbeit |

| E-Commerce | Konkurrenzpreise überwachen | Dynamische Preisgestaltung, schnelle Reaktion |

| Marketing | Bewertungen oder Inhalte sammeln | Zielgenauere Kampagnen |

| Operations | Bestände oder Lieferantendaten verfolgen | Entscheidungen in Echtzeit |

| Immobilien | Immobilienangebote sammeln | Zentrale Marktübersicht |

Mit automatisierten Web-zu-Google-Sheets-Workflows sparst du nicht nur Zeit – du legst auch die Basis für smarte, schnelle und kollaborative Geschäftsprozesse.

Gängige Methoden, um websitedaten in google sheets zu importieren

Bevor es Thunderbit gab, habe ich alle möglichen Wege ausprobiert, um websitedaten in google sheets zu bekommen. Hier ein Überblick über die gängigen Methoden:

- Manuelles Copy-Paste: Website öffnen, daten markieren, kopieren und in Sheets einfügen. Einfach, aber langsam und fehleranfällig.

- Google Sheets-Funktionen (IMPORTHTML, IMPORTXML): Mit diesen Formeln lassen sich Tabellen oder Listen von öffentlichen Webseiten importieren. Für einfache, statische Seiten super – bei komplexen oder dynamischen Seiten stoßen sie schnell an ihre Grenzen ().

- Apps Script: Mit eigenem JavaScript websitedaten abrufen und verarbeiten. Sehr mächtig, aber erfordert Programmierkenntnisse und Pflege.

- Drittanbieter-Add-ons: Es gibt Add-ons für Sheets, die Web-Scraping versprechen, aber viele sind eingeschränkt, tun sich mit komplexen Layouts schwer oder benötigen viel Einrichtung.

Hier der direkte Vergleich:

| Methode | Bedienkomfort | Komplexe Seiten | Wartung | Geschwindigkeit | Automatisierung | Kosten |

|---|---|---|---|---|---|---|

| Manuelles Copy-Paste | Einfach | Nein | Hoch | Langsam | Keine | Kostenlos |

| IMPORTHTML/IMPORTXML | Mittel | Nein | Mittel | Schnell | Eingeschränkt | Kostenlos |

| Apps Script | Schwierig | Ja (mit Aufwand) | Hoch | Schnell | Ja | Kostenlos |

| Add-ons | Mittel | Manchmal | Mittel | Schnell | Manchmal | Oft kostenpflichtig |

| Thunderbit | Am einfachsten | Ja | Niedrig | Schnell | Ja | Kostenloser Tarif |

Mit Thunderbits KI-gestütztem Ansatz musst du weder programmieren noch Vorlagen bauen oder dich um Website-Änderungen kümmern.

So importierst du websitedaten mit Thunderbit in google sheets

Jetzt zum Praxisteil – so einfach holst du websitedaten mit in google sheets. Genau diesen Workflow hätte ich mir früher gewünscht.

Schritt 1: Thunderbit Chrome-Erweiterung installieren

Geh auf die und klick auf „Zu Chrome hinzufügen“. Thunderbit läuft in jedem Chromium-basierten Browser (Chrome, Edge, Brave usw.). Keine besonderen Anforderungen – wer google sheets nutzen kann, kann auch Thunderbit nutzen.

Nach der Installation erscheint das Thunderbit-Icon in deiner Browserleiste. Draufklicken, kostenlos registrieren (es gibt einen Free-Tarif) – und los geht’s.

Schritt 2: Zielwebsite öffnen

Öffne die Website, von der du daten extrahieren möchtest. Das kann eine Produktliste, ein Lead-Verzeichnis oder eine Tabelle mit Immobilienangeboten sein. Im E-Commerce zum Beispiel eine Produktseite der Konkurrenz, im Vertrieb ein Branchenverzeichnis.

Schritt 3: „KI-Felder vorschlagen“ nutzen

Klick auf das Thunderbit-Icon. Jetzt kommt der Clou: Mit „KI-Felder vorschlagen“ analysiert Thunderbits KI die Seite und schlägt automatisch passende Spalten vor – etwa „Produktname“, „Preis“, „Bild“, „Kontakt-E-Mail“ oder was sonst relevant ist.

Du kannst die Felder prüfen, umbenennen oder weitere hinzufügen. Kein Gefummel mit Selektoren, kein Code – die KI übernimmt die Arbeit.

Schritt 4: daten extrahieren und nach google sheets exportieren

Klick auf „Scrapen“. Thunderbit sammelt die daten, strukturiert sie als Tabelle und zeigt eine Vorschau. Wenn alles passt, auf „Exportieren“ klicken und „google sheets“ auswählen. Thunderbit erstellt ein neues Sheet (oder du wählst ein bestehendes) und überträgt die daten direkt – inklusive Bilder, Links, E-Mails usw.

Du kannst auch nach Excel, Airtable oder Notion exportieren, wenn du möchtest. Alle Exporte sind .

Schritt 5: Automatische datenaktualisierung mit geplantem Scraping

Du willst, dass dein google sheet sich automatisch aktualisiert? Mit Thunderbits geplantem Scraping kannst du wiederkehrende Jobs einrichten – stündlich, täglich oder wöchentlich. Einfach den Zeitplan in Klartext beschreiben, und Thunderbit hält dein Sheet immer aktuell.

Das ist besonders praktisch für Preisüberwachung, Bestandsmanagement oder überall dort, wo aktuelle daten entscheidend sind.

Tipp bei Problemen: Wenn du auf Login-Seiten oder dynamische Inhalte stößt, nutze den Browser-Modus von Thunderbit. Damit lassen sich auch Seiten scrapen, die eine Anmeldung erfordern oder daten per JavaScript nachladen.

Warum Thunderbit statt klassischer datenextraktionstools?

Oft werde ich gefragt: „Warum nicht einfach IMPORTXML oder ein Sheets-Add-on?“ Hier die ehrliche Antwort:

- KI-gestützte Felderkennung: Thunderbits KI versteht die Seite und schlägt die passenden Felder vor – keine Vorlagen, kein XPath nötig.

- Komplexe Layouts kein Problem: Egal ob unübersichtliches Verzeichnis, Produktgitter oder Tabelle mit Bildern und Links – Thunderbit passt sich automatisch an.

- No-Code-Setup: Jeder kann es nutzen – keine Technikkenntnisse erforderlich.

- Wenig Wartung: Skripte und Formeln gehen bei Website-Änderungen oft kaputt. Thunderbits KI passt sich in Echtzeit an.

- Flexible Exporte: Mit einem Klick nach google sheets, Excel, Airtable oder Notion exportieren.

Hier der Vergleich im Überblick:

| Funktion | Thunderbit | IMPORTXML/HTML | Add-ons |

|---|---|---|---|

| No-Code-Setup | Ja | Nein | Teilweise |

| Dynamische Seiten | Ja | Nein | Selten |

| Felderkennung | KI-basiert | Manuell (XPath) | Vorlagenbasiert |

| Wartung | Gering | Hoch | Mittel |

| Exportoptionen | Sheets, Excel etc. | Nur Sheets | Unterschiedlich |

| Kosten | Kostenloser Tarif | Kostenlos | Oft kostenpflichtig |

Thunderbit ist für Business-User gemacht, die Ergebnisse wollen – ohne Programmieren, ohne Stress, ohne kaputte Skripte.

Mehr als nur Text: Welche Datentypen kann Thunderbit in google sheets importieren?

Was ich an Thunderbit besonders mag, ist die Vielseitigkeit. Es geht nicht nur um Text – das kannst du in google sheets importieren:

- Text: Produktnamen, Beschreibungen, Adressen usw.

- Zahlen: Preise, Bewertungen, Lagerbestände.

- Daten: Verfügbarkeitsdaten, Veranstaltungstermine.

- Links (URLs): Produktseiten, Profil-Links.

- E-Mails: Kontaktdaten für Leads oder Support.

- Telefonnummern: Automatisch im E.164-Format formatiert.

- Bilder: Produktfotos, Profilbilder – erscheinen als Links in Sheets oder als eingebettete Bilder in Notion/Airtable.

- Single/Multi Select: Kategorien, Tags oder Labels.

Beispiel: Du scrapest eine Immobilienseite? Thunderbit kann Adresse, Preis, Anzahl der Zimmer, E-Mail des Maklers, Telefonnummer und sogar das Immobilienbild auf einmal extrahieren – alles bereit für google sheets.

Formatierungstipp: In google sheets erscheinen Bilder als Links (zum Anklicken), beim Export nach Notion oder Airtable lädt Thunderbit die Bilder direkt in deinen Workspace hoch.

Workflow-Booster: Thunderbit mit google sheets-Automatisierung kombinieren

Thunderbit bringt deine daten nicht nur in Sheets – es eröffnet dir neue Automatisierungsmöglichkeiten:

- Geplantes Scraping: Halte deine Sheets mit wiederkehrenden Importen immer aktuell.

- Formeln & Filter: Nutze die integrierten Sheets-Formeln (

=FILTER(),=VLOOKUP(),=QUERY()) zur Analyse, Bereinigung und Anreicherung deiner daten. - Add-ons & Plugins: Kombiniere Thunderbit mit Google Apps Script, Supermetrics oder Zapier für fortgeschrittene Workflows – z. B. Leads automatisch per E-Mail versenden, Dashboards aktualisieren oder mit dem CRM synchronisieren.

- Bedingte Formatierung: Preisänderungen hervorheben, fehlende Infos markieren oder Leads farblich priorisieren.

Beispiel-Workflow: Täglich mit Thunderbit Konkurrenzpreise scrapen und per Formel in Sheets alle Produkte markieren, bei denen dein Preis nicht der günstigste ist. Sofortige Preisinformation – ganz ohne Handarbeit.

Best Practices: So holst du das Maximum aus Thunderbit & google sheets

Damit du das Beste aus Thunderbit und google sheets rausholst, hier meine Tipps:

- Aussagekräftige Feldnamen wählen: Nutze sprechende Spaltennamen („Produktname“, „Preis“, „Kontakt-E-Mail“) für die spätere Auswertung.

- daten bereinigen: Mit Sheets-Formeln Duplikate entfernen, Formatierungen anpassen oder daten aufteilen.

- Zeitpläne sinnvoll wählen: Für häufig aktualisierte daten geplantes Scraping nutzen, für Einzelprojekte reicht der manuelle Import.

- Sheets organisieren: Nutze Tabs für verschiedene datenquellen, füge Zeitstempel hinzu und dokumentiere deinen Workflow für Kollegen.

- Große daten aufteilen: Bei umfangreichen Scrapes den Job in kleinere Pakete (z. B. 500 Zeilen) splitten, um google sheets-Limits zu vermeiden.

Tipps & Tricks: So läuft der Import in google sheets reibungslos

Auch mit KI kann Web Scraping manchmal haken. So bleibst du auf Kurs:

- Login-Pflichtige Seiten: Nutze Thunderbits Browser-Modus und logg dich vorher ein.

- Dynamische Inhalte: Wenn daten erst nach dem Laden erscheinen, warte ein paar Sekunden oder nutze den Browser-Modus.

- Export-Fehler: Prüfe die Verbindung zu deinem Google-Konto und die Berechtigungen für das Ziel-Sheet.

- datenformatierung: Nutze die Tools von google sheets, um Formatierungen zu bereinigen oder daten aufzuteilen.

- Hilfe benötigt? Schau in die oder kontaktiere den Support – wir helfen gerne weiter.

Fazit: Mit Thunderbit das volle Potenzial von google sheets ausschöpfen

Websitedaten in google sheets zu importieren muss keine lästige Aufgabe sein. Mit Thunderbit profitierst du von:

- KI-gestützter, codefreier Extraktion von jeder website – auch bei komplexen Seiten.

- 2-Klick-Workflow: „KI-Felder vorschlagen“, „Scrapen“ und direkt nach Sheets exportieren.

- Unterstützung aller Datentypen: Text, Bilder, Links, E-Mails, Telefonnummern und mehr.

- Geplantes Scraping für stets aktuelle daten und Echtzeit-Reporting.

- Kostenlose Exporte nach google sheets, Excel, Airtable oder Notion.

Das ist der schnellste und einfachste Weg, das Web in nutzbare, kollaborative daten zu verwandeln – ganz ohne mühsame Handarbeit oder fehleranfällige Skripte. Bereit für den Test? und dein nächster datenimport wird zum Kinderspiel.

Weitere Tipps, Anleitungen und Automatisierungstricks findest du im . Viel Spaß beim Scrapen – und mögen deine Sheets immer aktuell sein.

Häufige Fragen

1. Kann Thunderbit Bilder und Links in google sheets importieren?

Klar! Thunderbit kann Bilder, Links, E-Mails, Telefonnummern und mehr extrahieren. In google sheets erscheinen Bilder als anklickbare Links, in Notion oder Airtable als eingebettete Bilder.

2. Wie geht Thunderbit mit Websites um, die einen Login erfordern?

Nutze den Browser-Modus von Thunderbit, während du eingeloggt bist. Die KI sieht die Seite so wie du und kann auch daten hinter Login-Walls extrahieren.

3. Ist Thunderbit für Exporte nach google sheets kostenlos?

Thunderbit bietet einen kostenlosen Tarif, mit dem du bis zu 6 Seiten (oder 10 mit Test-Boost) nach google sheets, Excel, Airtable oder Notion exportieren kannst.

4. Was passiert, wenn sich das Layout der website ändert? Bricht mein Workflow dann?

Thunderbits KI passt sich automatisch an Layout-Änderungen an – du musst keine Vorlagen neu bauen oder Skripte reparieren.

5. Kann ich wiederkehrende Importe in google sheets automatisieren?

Absolut. Mit Thunderbits geplantem Scraping kannst du automatische Importe stündlich, täglich oder wöchentlich einrichten – deine Sheets sind immer aktuell.

Bereit loszulegen? und erleben, wie einfach der Import von websitedaten in google sheets sein kann.

Mehr erfahren